תמונה מאת המחבר

למודיעין העל יש פוטנציאל להיות ההתקדמות הטכנולוגית המשמעותית ביותר בהיסטוריה האנושית. זה יכול לעזור לנו להתמודד עם כמה מהאתגרים הדחופים ביותר איתם מתמודדת האנושות. אמנם זה יכול להביא לעידן חדש של התקדמות, אבל הוא גם טומן בחובו סיכונים מסוימים שיש לטפל בהם בזהירות. אינטליגנציה-על יכולה לבטל את כוחה של האנושות או אפילו להוביל להכחדה אנושית אם לא תטופל כראוי או מיושר כהלכה.

בעוד שמודיעין-על נראה רחוק, מומחים רבים מאמינים שזה עשוי להפוך למציאות בשנים הקרובות. כדי לנהל את הסיכונים הפוטנציאליים, עלינו ליצור גופים שלטון חדשים ולטפל בנושא הקריטי של יישור מודיעין-על. המשמעות היא להבטיח שמערכות בינה מלאכותית שתעלה בקרוב על האינטליגנציה האנושית תישארנה מיושרת עם המטרות והכוונות האנושיות.

בבלוג זה נלמד על Superalignmnet ונלמד על הגישה של OpenAI לפתרון האתגרים הטכניים המרכזיים של יישור מודיעין על.

Superalignment מתייחס להבטחה שמערכות אינטליגנציה סופר מלאכותית (AI), העולה על האינטליגנציה האנושית בכל התחומים, פועלות על פי ערכים ומטרות אנושיות. זהו מושג חיוני בתחום הבטיחות והממשל של AI, שמטרתו לטפל בסיכונים הכרוכים בפיתוח ופריסה של AI מתקדם ביותר.

As AI systems get more intelligent, it may become more challenging for humans to understand how they make decisions. It can cause problems if the AI acts in ways that go against human values. It’s essential to address this issue to prevent any harmful consequences.

Superalignment מבטיח שמערכות בינה מלאכותית סופר אינטליגנטיות פועלות בדרכים שמתאימות לערכים ולכוונות האנושיות. זה דורש ציון מדויק של העדפות אנושיות, תכנון מערכות בינה מלאכותית שיוכלו להבין אותן, ויצירת מנגנונים כדי להבטיח שמערכות הבינה המלאכותית חותרות אחר מטרות אלו.

Superalignment plays a crucial role in addressing the potential risks associated with superintelligence. Let’s delve into the reasons why we need Superalignment:

- תרחישי בינה מלאכותית של נוכלים: Superalignment מבטיח שמערכות בינה מלאכותיות סופר אינטליגנטיות יתיישרו עם הכוונה האנושית, מה שמפחית את הסיכונים להתנהגות בלתי מבוקרת ולנזק אפשרי.

- שמירה על ערכי האדם: על ידי התאמת מערכות בינה מלאכותית לערכים אנושיים, Superalignment מונעת קונפליקטים שבהם בינה מלאכותית סופר אינטליגנטית עשויה לתעדף יעדים שאינם עולים בקנה אחד עם הנורמות והעקרונות החברתיים.

- הימנעות מהשלכות לא רצויות: מחקר Superalignment מזהה ומצמצם תוצאות שליליות לא רצויות שעלולות לנבוע ממערכות בינה מלאכותית מתקדמות, תוך מזעור השפעות שליליות אפשריות.

- הבטחת אוטונומיה אנושית: Superalignment מתמקדת בתכנון מערכות בינה מלאכותית ככלים יקרי ערך שמגדילים את היכולות האנושיות, משמרים את האוטונומיה שלנו ומונעים הסתמכות יתר על קבלת החלטות בינה מלאכותית.

- בניית עתיד AI מועיל: מחקר Superalignment שואף ליצור עתיד שבו מערכות בינה מלאכותית סופר אינטליגנטיות תורמות באופן חיובי לרווחת האדם, ומתמודדות עם אתגרים גלובליים תוך מזעור סיכונים.

OpenAI is building a human-level automated alignment researcher that will use vast amounts of compute to scale the efforts, and iteratively align superintelligence – היכרות עם Superalignment (openai.com).

כדי ליישר את חוקר היישור האוטומטי הראשון, OpenAI יצטרך:

- פתח שיטת אימון ניתנת להרחבה: OpenAI יכול להשתמש במערכות בינה מלאכותיות כדי לעזור להעריך מערכות בינה מלאכותיות אחרות במשימות קשות שקשה לבני אדם להעריך.

- אמת את המודל שהתקבל: OpenAI יהפוך את החיפוש לאוטומטי אחר התנהגות בעייתית וחלק פנימי בעייתי.

- בדיקות יריבות: בדוק את מערכת הבינה המלאכותית על ידי אימון מכוון של מודלים שאינם מיושרים, וודא שהשיטות בהן נעשה שימוש יכולות לזהות אפילו את חוסר ההתאמה החמור ביותר בצינור.

קְבוּצָה

OpenAI מקימה צוות כדי להתמודד עם האתגר של יישור מודיעין על. הם יקצו 20% ממשאבי המחשוב שלהם במהלך ארבע השנים הקרובות. את הצוות יובילו איליה סוצקבר ויאן לייקה, והוא כולל חברים מצוותי יישור קודמים ומחלקות נוספות בחברה.

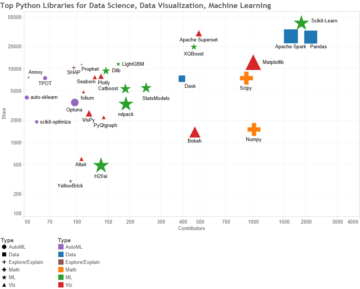

OpenAI מחפשת כעת חוקרים ומהנדסים יוצאי דופן שיתרמו למשימתה. הבעיה של יישור אינטליגנציה על קשורה בעיקר ללמידת מכונה. מומחים בתחום למידת מכונה, גם אם הם לא עובדים כרגע על יישור, ימלאו תפקיד מכריע במציאת פתרון.

שערים

OpenAI שמה לה למטרה להתמודד עם האתגרים הטכניים של יישור מודיעין-על בתוך ארבע שנים. למרות שמדובר ביעד שאפתני וההצלחה אינה מובטחת, OpenAI נשארת אופטימית שמאמץ ממוקד ונחוש יכול להוביל לפתרון בעיה זו.

כדי לפתור את הבעיה, עליהם להציג ראיות וטיעונים משכנעים לקהילת למידת המכונה והבטיחות. רמה גבוהה של אמון בפתרונות המוצעים היא חיונית. אם הפתרונות אינם אמינים, הקהילה עדיין יכולה להשתמש בממצאים כדי לתכנן בהתאם.

OpenAI’s Superalignment initiative holds great promise in addressing the challenges of superintelligence alignment. With promising ideas emerging from preliminary experiments, the team has access to increasingly useful progress metrics and can leverage existing AI models to study these problems empirically.

It’s important to note that the Superalignment team’s efforts are complemented by OpenAI’s ongoing work to improve the safety of current models, including the widely used ChatGPT. OpenAI remains committed to understanding and mitigating various risks associated with AI, such as misuse, economic disruption, disinformation, bias and discrimination, addiction, and overreliance.

OpenAI שואפת לסלול את הדרך לעתיד AI בטוח ומועיל יותר באמצעות מחקר ייעודי, שיתוף פעולה וגישה יזומה.

עביד עלי אוואן (@1abidaliawan) הוא איש מקצוע מוסמך של מדען נתונים שאוהב לבנות מודלים של למידת מכונה. נכון לעכשיו, הוא מתמקד ביצירת תוכן וכתיבת בלוגים טכניים על למידת מכונה וטכנולוגיות מדעי נתונים. עביד הוא בעל תואר שני בניהול טכנולוגיה ותואר ראשון בהנדסת טלקומוניקציה. החזון שלו הוא לבנות מוצר בינה מלאכותית באמצעות רשת עצבית גרפית עבור תלמידים הנאבקים במחלות נפש.

- הפצת תוכן ויחסי ציבור מופעל על ידי SEO. קבל הגברה היום.

- PlatoData.Network Vertical Generative Ai. העצים את עצמך. גישה כאן.

- PlatoAiStream. Web3 Intelligence. הידע מוגבר. גישה כאן.

- PlatoESG. רכב / רכבים חשמליים, פחמן, קלינטק, אנרגיה, סביבה, שמש, ניהול פסולת. גישה כאן.

- BlockOffsets. מודרניזציה של בעלות על קיזוז סביבתי. גישה כאן.

- מקור: https://www.kdnuggets.com/2023/07/superalignment-important.html?utm_source=rss&utm_medium=rss&utm_campaign=what-is-superalignment-why-it-is-important

- :יש ל

- :הוא

- :לֹא

- :איפה

- a

- אודות

- גישה

- פי

- לפיכך

- במדויק

- לפעול

- מעשים

- התמכרות

- כתובת

- פְּנִיָה

- מתקדם

- קידום

- שְׁלִילִי

- נגד

- AI

- מערכות AI

- מכוון

- מטרות

- ליישר

- מיושר

- יישור

- תעשיות

- להקצות

- גם

- למרות

- שאפתן

- כמויות

- an

- ו

- כל

- גישה

- כראוי

- ARE

- טיעונים

- לְהִתְעוֹרֵר

- מלאכותי

- בינה מלאכותית

- בינה מלאכותית (AI)

- AS

- לְהַעֲרִיך

- המשויך

- אוטומטי

- אוטומטי

- BE

- להיות

- תאמינו

- מועיל

- הטיה

- בלוג

- בלוגים

- גופים

- להביא

- לִבנוֹת

- בִּניָן

- by

- CAN

- יכולות

- לגרום

- בזהירות

- מסוים

- מוסמך

- לאתגר

- האתגרים

- אתגר

- ChatGPT

- שיתוף פעולה

- COM

- מְחוּיָב

- קהילה

- חברה

- לחשב

- מחשוב

- מושג

- אמון

- השלכות

- תוכן

- יצירת תוכן

- לתרום

- ליבה

- יכול

- לִיצוֹר

- יוצרים

- יצירה

- קריטי

- מכריע

- נוֹכְחִי

- כיום

- נתונים

- מדע נתונים

- מדען נתונים

- קבלת החלטות

- החלטות

- מוקדש

- תואר

- מחלקות

- פריסה

- תכנון

- נחוש

- מתפתח

- קשה

- אפליה

- מֵידָע מַטעֶה

- התפוררות

- תחומים

- כַּלְכָּלִי

- תופעות

- מאמץ

- מַאֲמָצִים

- מתעורר

- הנדסה

- מהנדסים

- לְהַבטִיחַ

- מבטיח

- הבטחתי

- תקופה

- חיוני

- Ether (ETH)

- להעריך

- אֲפִילוּ

- עדות

- יוצא דופן

- קיימים

- ניסויים

- מומחים

- מומחים מאמינים

- הכחדה

- מתמודד

- רחוק

- מעטים

- שדה

- מציאת

- ממצאים

- ראשון

- מרוכז

- מתמקד

- התמקדות

- בעד

- ארבע

- החל מ-

- עתיד

- לקבל

- גלוֹבָּלִי

- Go

- מטרה

- שערים

- ממשל

- שלטון

- גרף

- גרף רשת עצבית

- גדול

- מובטח

- קשה

- לפגוע

- מזיק

- יש

- he

- לעזור

- גָבוֹהַ

- מאוד

- שֶׁלוֹ

- היסטוריה

- מחזיק

- איך

- HTTPS

- בן אנוש

- האינטליגנציה האנושית

- אנושיות

- בני אדם

- רעיונות

- מזהה

- לזהות

- if

- מחלה

- חשוב

- לשפר

- in

- כולל

- כולל

- יותר ויותר

- הטמון

- יוזמה

- מוֹדִיעִין

- אינטליגנטי

- כוונה

- כוונות

- אל תוך

- סוגיה

- IT

- שֶׁלָה

- יאן

- KDnuggets

- עוֹפֶרֶת

- לִלמוֹד

- למידה

- הוביל

- רמה

- תנופה

- אוהב

- מכונה

- למידת מכונה

- לעשות

- לנהל

- ניהול

- רב

- אב

- מאי..

- אומר

- מנגנוני

- להרשם/להתחבר

- נפשי

- מחלת נפש

- שיטה

- שיטות

- מדדים

- מזעור

- משימה

- מקלה

- מודל

- מודלים

- יותר

- רוב

- צריך

- צורך

- רשת

- עצביים

- רשת עצבית

- חדש

- הבא

- נורמות

- מטרה

- יעדים

- of

- כבוי

- on

- מתמשך

- OpenAI

- אופטימי

- or

- אחר

- שלנו

- תוצאות

- יותר

- לסלול

- צינור

- תכנית

- אפלטון

- מודיעין אפלטון

- אפלטון נתונים

- לְשַׂחֵק

- משחק

- תנוחות

- פוטנציאל

- העדפות

- להציג

- מִשׁמֶרֶת

- דחוף

- למנוע

- מניעה

- מונע

- קודם

- בראש ובראשונה

- עקרונות

- תיעדוף

- פרואקטיבי

- בעיה

- בעיות

- המוצר

- מקצועי

- התקדמות

- הבטחה

- מבטיח

- מוּצָע

- לרדוף

- מציאות

- סיבות

- הפחתה

- מתייחס

- קָשׁוּר

- להשאר

- שְׂרִידִים

- דורש

- מחקר

- חוקר

- חוקרים

- משאבים

- וכתוצאה מכך

- סיכונים

- תפקיד

- s

- בטוח יותר

- בְּטִיחוּת

- להרחבה

- סולם

- תרחישים

- מדע

- מַדְעָן

- חיפוש

- מחפשים

- נראה

- סט

- קשה

- משמעותי

- חברתי

- פִּתָרוֹן

- פתרונות

- לפתור

- פותר

- כמה

- בקרוב

- עוד

- נאבק

- סטודנטים

- לימוד

- הצלחה

- כזה

- סוּפֶּר

- התבונה העל

- לעלות

- מערכת

- מערכות

- לְהִתְמוֹדֵד

- משימות

- נבחרת

- צוותי

- טכני

- טכנולוגי

- טכנולוגיות

- טכנולוגיה

- טֵלֵקוֹמוּנִיקַציָה

- מבחן

- בדיקות

- זֶה

- השמיים

- שֶׁלָהֶם

- אותם

- אלה

- הֵם

- זֶה

- דרך

- ל

- כלים

- הדרכה

- להבין

- הבנה

- us

- להשתמש

- מְשׁוּמָשׁ

- באמצעות

- בעל ערך

- ערכים

- שונים

- Vast

- לאמת

- חזון

- דֶרֶך..

- דרכים

- we

- מה

- מה

- אשר

- בזמן

- מי

- למה

- באופן נרחב

- יצטרך

- עם

- בתוך

- תיק עבודות

- עובד

- כתיבה

- שנים

- זפירנט