מבוא

דמיינו את עצמכם עומדים בספרייה אפלולית, נאבקים לפענח מסמך מורכב תוך כדי ג'אגלינג בין עשרות טקסטים אחרים. זה היה העולם של רובוטריקים לפני שהעיתון "תשומת לב היא כל מה שאתה צריך" חשף את זרקור המהפכני שלו - מנגנון הקשב.

תוכן העניינים

מגבלות של RNNs

מודלים עוקבים מסורתיים, כמו רשתות עצביות חוזרות (RNN), שפה מעובדת מילה אחר מילה, מה שמוביל למספר מגבלות:

- תלות לטווח קצר: RNNs התקשו לתפוס קשרים בין מילים רחוקות, ולעתים קרובות פירשו לא נכון את המשמעות של משפטים כמו "האיש שביקר אתמול בגן החיות", שם הנושא והפועל רחוקים זה מזה.

- מקביליות מוגבלת: עיבוד מידע ברצף הוא איטי מטבעו, ומונע הדרכה יעילה וניצול משאבי חישוב, במיוחד עבור רצפים ארוכים.

- התמקדו בהקשר המקומי: RNNs מתחשבים בעיקר בשכנים מיידיים, וייתכן שחסר מידע חיוני מחלקים אחרים של המשפט.

מגבלות אלו פגעו ביכולתם של רובוטריקים לבצע משימות מורכבות כמו תרגום מכונה והבנת שפה טבעית. ואז הגיע ה מנגנון הקשב, זרקור מהפכני שמאיר את הקשרים הנסתרים בין מילים, ומשנה את ההבנה שלנו בעיבוד שפה. אבל מה בדיוק פתרה תשומת הלב, ואיך היא שינתה את המשחק עבור רובוטריקים?

בואו נתמקד בשלושה תחומים מרכזיים:

תלות לטווח ארוך

- בעיה: דוגמניות מסורתיות נתקלו לעתים קרובות במשפטים כמו "האישה שגרה על הגבעה ראתה אמש כוכב נופל". הם התקשו לחבר בין "אישה" ל"כוכב נופל" בגלל המרחק שלהם, מה שהוביל לפרשנויות מוטעות.

- מנגנון תשומת לב: דמיינו את הדגם מאיר קרן בהירה על פני המשפט, מחבר "אישה" ישירות ל"כוכב נופל" ומבין את המשפט בכללותו. היכולת הזו ללכוד מערכות יחסים ללא קשר למרחק היא חיונית למשימות כמו תרגום מכונה וסיכום.

גם לקרוא: סקירה כללית על זיכרון לטווח קצר (LSTM)

כוח עיבוד מקביל

- בעיה: מודלים מסורתיים עיבדו מידע ברצף, כמו קריאת ספר עמוד אחר עמוד. זה היה איטי ולא יעיל, במיוחד עבור טקסטים ארוכים.

- מנגנון תשומת לב: תארו לעצמכם זרקורים מרובים סורקים את הספרייה בו זמנית, מנתחים חלקים שונים של הטקסט במקביל. זה מאיץ באופן דרמטי את עבודת המודל, ומאפשר לו לטפל בכמויות אדירות של נתונים ביעילות. כוח עיבוד מקביל זה חיוני לאימון מודלים מורכבים וביצוע תחזיות בזמן אמת.

מודעות להקשר גלובלי

- בעיה: מודלים מסורתיים התמקדו לעתים קרובות במילים בודדות, וחסרו את ההקשר הרחב יותר של המשפט. זה הוביל לאי הבנות במקרים כמו סרקזם או כפל משמעויות.

- מנגנון תשומת לב: דמיינו את אור הזרקורים שוטף את כל הספרייה, קולט כל ספר ומבין איך הם קשורים זה לזה. מודעות להקשר גלובלית זו מאפשרת למודל לשקול את מכלול הטקסט בעת פירוש כל מילה, מה שמוביל להבנה עשירה וניואנסית יותר.

מבלבל מילים פוליסמיות

- בעיה: מילים כמו "בנק" או "תפוח" יכולות להיות שמות עצם, פעלים או אפילו חברות, מה שיוצר אי בהירות שמודלים מסורתיים התקשו לפתור.

- מנגנון תשומת לב: תארו לעצמכם את הדגם מאיר זרקורים על כל המופעים של המילה "בנק" במשפט, ואז מנתח את ההקשר שמסביב ואת היחסים עם מילים אחרות. על ידי התחשבות במבנה הדקדוקי, שמות עצם קרובים ואפילו משפטי עבר, מנגנון הקשב יכול להסיק את המשמעות המיועדת. היכולת הזו לבלבל מילים פוליסמיות היא חיונית למשימות כמו תרגום מכונה, סיכום טקסט ומערכות דיאלוג.

ארבעת ההיבטים הללו - תלות ארוכת טווח, כוח עיבוד מקביל, מודעות להקשר גלובלי וביעור - מציגים את הכוח הטרנספורמטיבי של מנגנוני הקשב. הם הניעו את רובוטריקים לחזית עיבוד השפה הטבעית, ואיפשרו להם להתמודד עם משימות מורכבות בדיוק ויעילות יוצאי דופן.

ככל שה-NLP ובמיוחד LLMs ממשיכים להתפתח, מנגנוני הקשב ללא ספק ישחקו תפקיד קריטי עוד יותר. הם הגשר בין הרצף הליניארי של המילים לבין השטיח העשיר של השפה האנושית, ובסופו של דבר, המפתח לפתיחת הפוטנציאל האמיתי של המופלאים הלשוניים הללו. מאמר זה מתעמק בסוגים השונים של מנגנוני הקשב והפונקציונליות שלהם.

1. תשומת לב עצמית: הכוכב המנחה של הרובוטריק

תארו לעצמכם מלהטט במספר ספרים וצריך להתייחס לקטעים ספציפיים בכל אחד מהם בזמן כתיבת תקציר. תשומת לב עצמית או תשומת לב מדורגת של נקודות פועלות כמו עוזר אינטליגנטי, ועוזרת לדוגמניות לעשות את אותו הדבר עם נתונים עוקבים כמו משפטים או סדרות זמן. זה מאפשר לכל אלמנט ברצף לטפל בכל אלמנט אחר, וללכוד ביעילות תלות ארוכת טווח ומערכות יחסים מורכבות.

להלן מבט מקרוב על ההיבטים הטכניים העיקריים שלו:

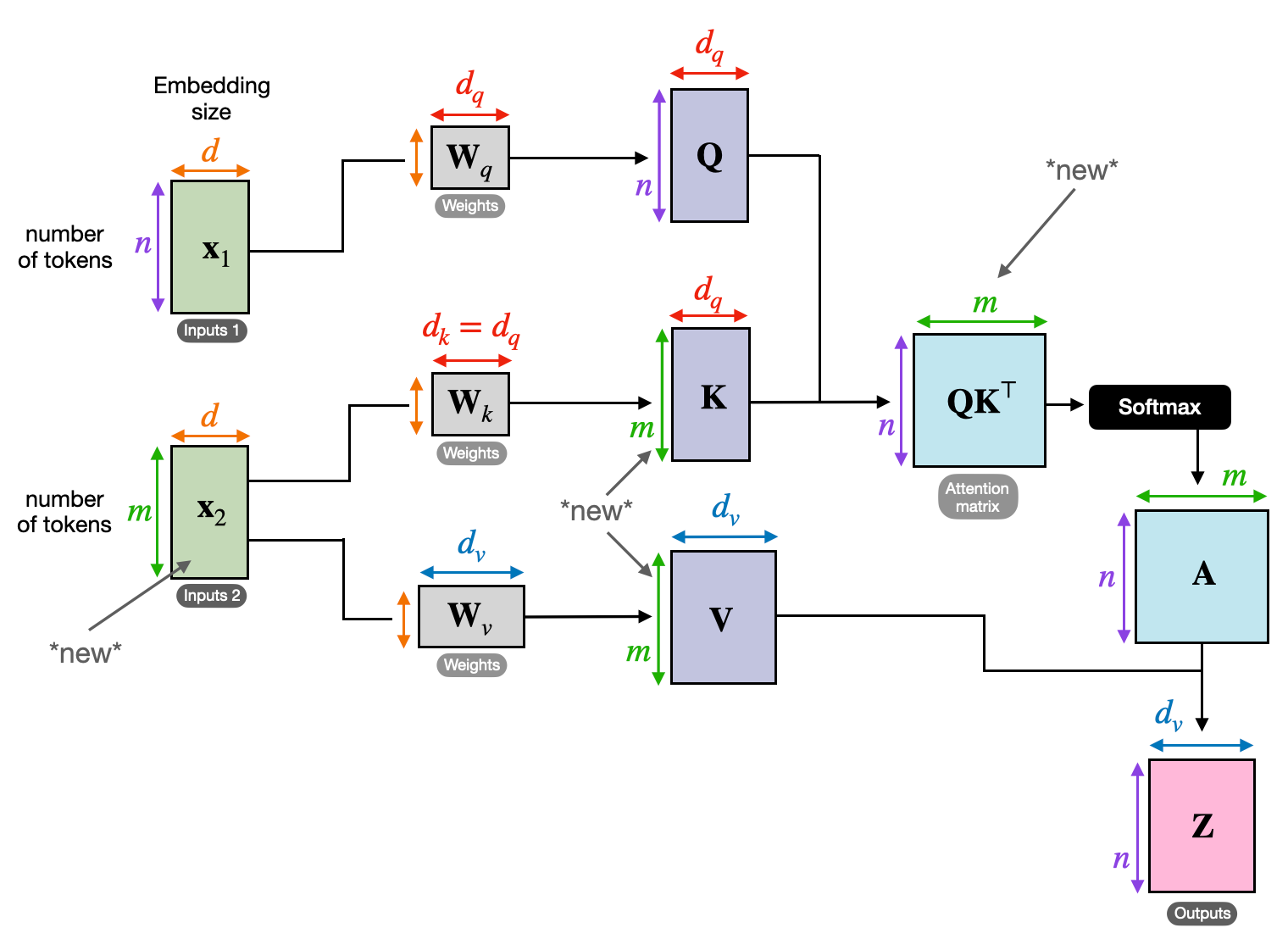

ייצוג וקטור

כל אלמנט (מילה, נקודת נתונים) הופך לווקטור בעל מימד גבוה, המקודד את תוכן המידע שלו. מרחב וקטור זה משמש כבסיס לאינטראקציה בין אלמנטים.

שינוי QKV

שלוש מטריצות מפתח מוגדרות:

- שאילתה (ש): מייצג את ה"שאלה" שכל אלמנט מציב בפני האחרים. Q לוכדת את צרכי המידע של האלמנט הנוכחי ומנחה את החיפוש שלו אחר מידע רלוונטי בתוך הרצף.

- מפתח (K): מחזיק את ה"מפתח" למידע של כל אלמנט. K מקודד את המהות של התוכן של כל אלמנט, ומאפשר לאלמנטים אחרים לזהות רלוונטיות פוטנציאלית בהתבסס על הצרכים שלהם.

- ערך (V): מאחסן את התוכן האמיתי שכל רכיב רוצה לשתף. V מכיל את המידע המפורט שאלמנטים אחרים יכולים לגשת ולמנף על סמך ציוני הקשב שלהם.

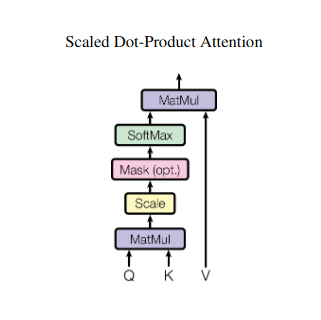

חישוב ציון תשומת לב

התאימות בין כל זוג אלמנטים נמדדת באמצעות מכפלת נקודות בין וקטור ה-Q וה-K שלהם. ציונים גבוהים יותר מצביעים על רלוונטיות פוטנציאלית חזקה יותר בין האלמנטים.

משקלי תשומת לב מותאמים

כדי להבטיח חשיבות יחסית, ציוני התאימות הללו מנורמלים באמצעות פונקציית softmax. כתוצאה מכך משקולות קשב, הנעות בין 0 ל-1, המייצגות את החשיבות המשוקללת של כל רכיב עבור ההקשר של האלמנט הנוכחי.

צבירת הקשר משוקלל

משקלי תשומת לב מוחלים על מטריצת V, ובעצם מדגישים את המידע החשוב מכל אלמנט בהתבסס על הרלוונטיות שלו לאלמנט הנוכחי. סכום משוקלל זה יוצר ייצוג הקשרי לאלמנט הנוכחי, המשלב תובנות שנאספו מכל שאר האלמנטים ברצף.

ייצוג אלמנט משופר

עם הייצוג המועשר שלו, האלמנט מחזיק כעת בהבנה עמוקה יותר של התוכן שלו, כמו גם של יחסיו עם אלמנטים אחרים ברצף. ייצוג שעבר שינוי זה מהווה את הבסיס לעיבוד שלאחר מכן בתוך המודל.

תהליך רב-שלבי זה מאפשר תשומת לב עצמית ל:

- לכיד תלות ארוכת טווח: קשרים בין אלמנטים מרוחקים מתגלים בקלות, גם אם מופרדים על ידי מספר אלמנטים מתערבים.

- מודל אינטראקציות מורכבות: תלות וקורלציות עדינות בתוך הרצף מובאות לאור, מה שמוביל להבנה עשירה יותר של מבנה הנתונים והדינמיקה.

- הפוך כל אלמנט להקשר: המודל מנתח כל אלמנט לא בנפרד אלא במסגרת הרחבה יותר של הרצף, מה שמוביל לתחזיות או ייצוגים מדויקים וניואנסים יותר.

תשומת לב עצמית חוללה מהפכה באופן שבו מודלים מעבדים נתונים עוקבים, פתחו אפשרויות חדשות בתחומים מגוונים כמו תרגום מכונה, יצירת שפה טבעית, חיזוי סדרות זמן ועוד. היכולת שלו לחשוף את היחסים הנסתרים בתוך רצפים מספקת כלי רב עוצמה לחשיפת תובנות ולהשגת ביצועים מעולים במגוון רחב של משימות.

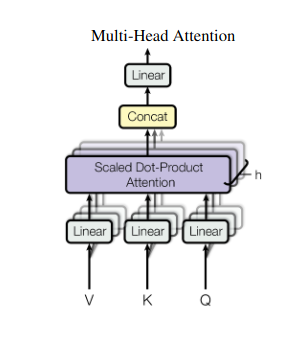

2. קשב רב ראשים: ראייה דרך עדשות שונות

תשומת לב עצמית מספקת ראייה הוליסטית, אך לפעמים התמקדות בהיבטים ספציפיים של הנתונים היא חיונית. כאן נכנסת לתמונה תשומת לב מרובה ראשים. תאר לעצמך שיש לך מספר עוזרים, כל אחד מצויד בעדשה אחרת:

- "ראשים" מרובים נוצרים, כל אחד מטפל ברצף הקלט באמצעות מטריצות Q, K ו-V משלו.

- כל ראש לומד להתמקד בהיבטים שונים של הנתונים, כמו תלות ארוכת טווח, קשרים תחביריים או אינטראקציות מילוליות מקומיות.

- לאחר מכן, התפוקות מכל ראש משורשרות ומוקרנות לייצוג סופי, לוכדות את הטבע הרב-גוני של הקלט.

זה מאפשר למודל לשקול בו זמנית נקודות מבט שונות, מה שמוביל להבנה עשירה וניואנסית יותר של הנתונים.

3. תשומת לב צולבת: בניית גשרים בין רצפים

היכולת להבין קשרים בין פיסות מידע שונות היא חיונית עבור משימות NLP רבות. תארו לעצמכם כתיבת ביקורת ספר – לא הייתם רק מסכמים את הטקסט מילה במילה, אלא מציירים תובנות וקשרים על פני פרקים. להיכנס תשומת לב צולבת, מנגנון חזק שבונה גשרים בין רצפים, ומעצים מודלים למנף מידע משני מקורות נפרדים.

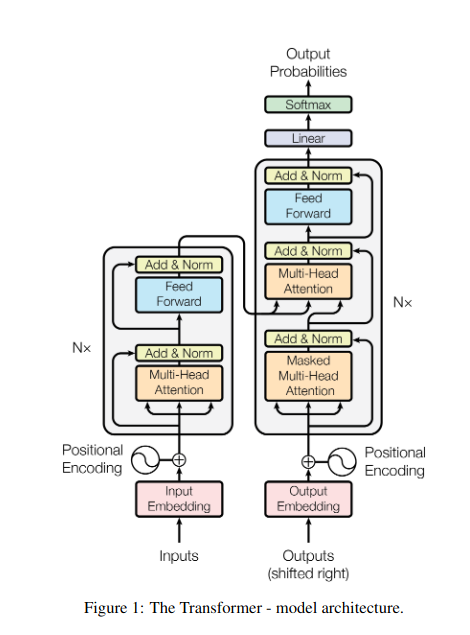

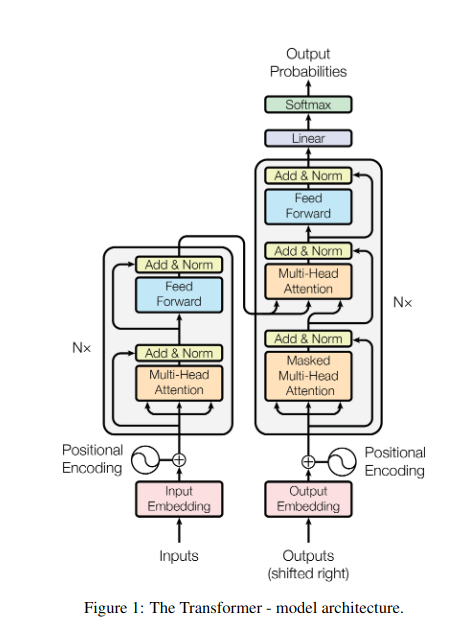

- בארכיטקטורות מקודדים-מפענחים כמו רובוטריקים, ה קוֹדַאִי מעבד את רצף הקלט (הספר) ומייצר ייצוג נסתר.

- השמיים מפענח משתמש בתשומת לב צולבת כדי לטפל בייצוג הנסתר של המקודד בכל שלב תוך יצירת רצף הפלט (הסקירה).

- מטריצת ה-Q של המפענח מקיימת אינטראקציה עם מטריצות ה-K וה-V של המקודד, ומאפשרת לו להתמקד בחלקים רלוונטיים של הספר בזמן כתיבת כל משפט בביקורת.

מנגנון זה אינו יסולא בפז עבור משימות כמו תרגום מכונה, סיכום ותשובות לשאלות, כאשר הבנת הקשרים בין רצפי קלט ופלט היא חיונית.

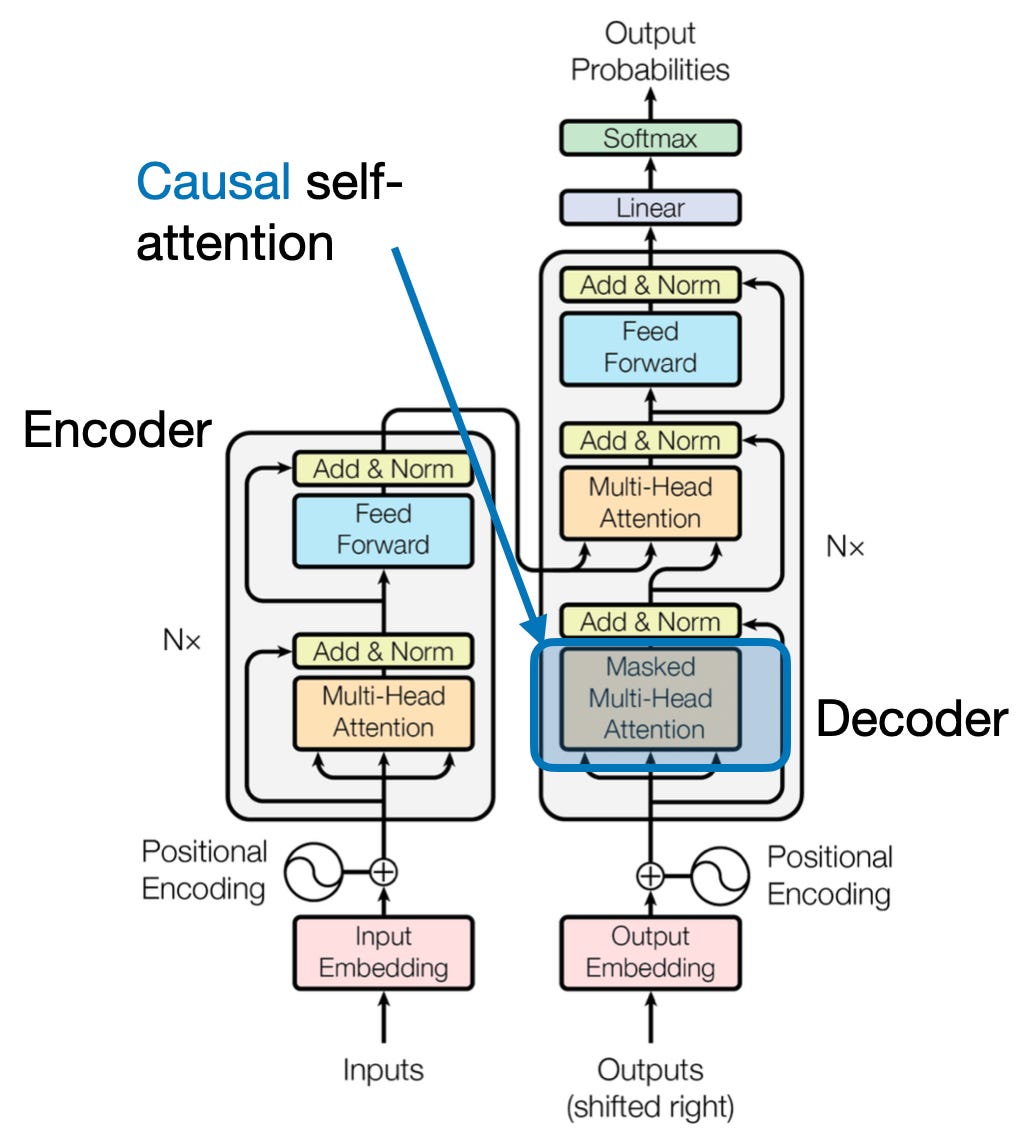

4. תשומת לב סיבתית: שימור זרימת הזמן

דמיינו שאתם מנבאים את המילה הבאה במשפט מבלי להציץ קדימה. מנגנוני קשב מסורתיים נאבקים במשימות הדורשות שימור הסדר הזמני של המידע, כגון הפקת טקסט וחיזוי סדרות זמן. הם בקלות "מציצים קדימה" ברצף, מה שמוביל לתחזיות לא מדויקות. תשומת לב סיבתית מטפלת במגבלה זו על ידי הבטחת תחזיות תלויות אך ורק במידע שעובד בעבר.

ככה זה עובד

- מנגנון מיסוך: מסכה ספציפית מוחלת על משקלי הקשב, וחוסמת למעשה את הגישה של המודל לאלמנטים עתידיים ברצף. לדוגמה, כאשר מנבא את המילה השנייה ב"האישה ש...", המודל יכול לשקול רק את "ה" ולא "מי" או מילים עוקבות.

- עיבוד אוטומטי: המידע זורם באופן ליניארי, כאשר הייצוג של כל אלמנט בנוי אך ורק מאלמנטים המופיעים לפניו. המודל מעבד את הרצף מילה אחר מילה, ומייצר תחזיות המבוססות על ההקשר שנקבע עד לאותה נקודה.

תשומת לב סיבתית חיונית למשימות כמו יצירת טקסט וחיזוי סדרות זמן, שבהן שמירה על הסדר הזמני של הנתונים חיונית לתחזיות מדויקות.

5. תשומת לב גלובלית מול מקומית: יצירת האיזון

מנגנוני הקשב עומדים בפני פשרות מרכזיות: לכידת תלות ארוכת טווח לעומת שמירה על חישוב יעיל. זה מתבטא בשתי גישות עיקריות: תשומת לב עולמית ו תשומת לב מקומית. דמיינו לקרוא ספר שלם לעומת התמקדות בפרק ספציפי. תשומת לב גלובלית מעבדת את כל הרצף בבת אחת, בעוד תשומת לב מקומית מתמקדת בחלון קטן יותר:

- תשומת לב עולמית לוכד תלות ארוכת טווח והקשר כולל אבל יכול להיות יקר מבחינה חישובית עבור רצפים ארוכים.

- תשומת לב מקומית יעיל יותר אך עלול להחמיץ מערכות יחסים רחוקות.

הבחירה בין תשומת לב עולמית למקומית תלויה במספר גורמים:

- דרישות המשימה: משימות כמו תרגום מכונה דורשות לכידת מערכות יחסים רחוקות, העדפת תשומת לב גלובלית, בעוד שניתוח סנטימנטים עשוי להעדיף את המיקוד של תשומת הלב המקומית.

- אורך רצף: רצפים ארוכים יותר הופכים את הקשב העולמי ליקר מבחינה חישובית, ומחייבים גישות מקומיות או היברידיות.

- קיבולת דגם: אילוצי משאבים עשויים לחייב תשומת לב מקומית אפילו עבור משימות הדורשות הקשר גלובלי.

כדי להשיג את האיזון האופטימלי, מודלים יכולים להשתמש ב:

- מיתוג דינמי: השתמש בתשומת לב גלובלית למרכיבי מפתח ובתשומת לב מקומית לאחרים, תוך הסתגלות על סמך חשיבות ומרחק.

- גישות היברידיות: משלבים את שני המנגנונים באותה שכבה, תוך מינוף נקודות החוזק שלהם.

גם לקרוא: ניתוח סוגי רשתות עצביות בלמידה עמוקה

סיכום

בסופו של דבר, הגישה האידיאלית נמצאת על ספקטרום בין תשומת לב גלובלית למקומית. הבנת פשרות אלו ואימוץ אסטרטגיות מתאימות מאפשרות למודלים לנצל ביעילות מידע רלוונטי על פני סולמות שונים, מה שמוביל להבנה עשירה ומדויקת יותר של הרצף.

הפניות

- Raschka, S. (2023). "הבנה וקידוד של תשומת לב עצמית, תשומת לב מרובה ראשים, תשומת לב צולבת ותשומת לב סיבתית בלימודי תואר שני."

- Vaswani, A., et al. (2017). "תשומת לב היא כל מה שאתה צריך."

- Radford, A., et al. (2019). "מודלים של שפות הם לומדים ריבוי משימות ללא פיקוח."

מוצרים מקושרים

- הפצת תוכן ויחסי ציבור מופעל על ידי SEO. קבל הגברה היום.

- PlatoData.Network Vertical Generative Ai. העצים את עצמך. גישה כאן.

- PlatoAiStream. Web3 Intelligence. הידע מוגבר. גישה כאן.

- PlatoESG. פחמן, קלינטק, אנרגיה, סביבה, שמש, ניהול פסולת. גישה כאן.

- PlatoHealth. מודיעין ביוטכנולוגיה וניסויים קליניים. גישה כאן.

- מקור: https://www.analyticsvidhya.com/blog/2024/01/different-types-of-attention-mechanisms/

- :יש ל

- :הוא

- :לֹא

- :איפה

- $ למעלה

- 1

- 2017

- 2019

- 2023

- 302

- 320

- 321

- 7

- a

- יכולת

- גישה

- דיוק

- מדויק

- להשיג

- השגתי

- לרוחב

- מעשים

- ממשי

- כתובות

- אימוץ

- קדימה

- AL

- תעשיות

- מאפשר

- מאפשר

- am

- דו משמעות

- כמויות

- an

- אנליזה

- ניתוחים

- ניתוח

- ו

- מענה

- בנפרד

- לכאורה

- יישומית

- גישה

- גישות

- ARE

- אזורים

- מאמר

- AS

- היבטים

- עוזר

- עוזרים

- At

- השתתף

- משתתף

- תשומת לב

- מודעות

- איזון

- מבוסס

- בסיס

- BE

- קרן

- להיות

- לפני

- בֵּין

- מעבר

- חסימה

- ספר

- ספרים

- שניהם

- לְגַשֵׁר

- גשרים

- בָּהִיר

- רחב

- מובא

- בִּניָן

- בונה

- נבנה

- אבל

- by

- הגיע

- CAN

- ללכוד

- לוכדת

- לכידה

- מקרים

- שינוי

- הפרק

- פרקים

- בחירה

- קרוב יותר

- סִמוּל

- לשלב

- מגיע

- חברות

- תאימות

- מורכב

- חישוב

- חישובית

- לְחַבֵּר

- מקשר

- חיבורי

- לשקול

- בהתחשב

- אילוצים

- מכיל

- תוכן

- הקשר

- להמשיך

- ליבה

- קורלציות

- נוצר

- יוצר

- יוצרים

- קריטי

- מכריע

- נוֹכְחִי

- נתונים

- מדע נתונים

- לפענח

- עמוק

- עמוק יותר

- מוגדר

- מתעמק

- לסמוך

- תלות

- תלות

- תלות

- תלוי

- מְפוֹרָט

- דיאלוג

- DID

- אחר

- ישירות

- מרחק

- רחוק

- מובהק

- שונה

- do

- מסמך

- נקודה

- לְהַכפִּיל

- עשרות

- באופן דרמטי

- לצייר

- ראוי

- דינמיקה

- E&T

- כל אחד

- יעילות

- יְעִילוּת

- יעיל

- יעילות

- אלמנט

- אלמנטים

- העצמה

- מאפשר

- מה שמאפשר

- הַצפָּנָה

- מועשר

- לְהַבטִיחַ

- הבטחתי

- זן

- שלם

- שְׁלֵמוּת

- מְצוּיָד

- במיוחד

- מַהוּת

- חיוני

- למעשה

- נוסד

- אֲפִילוּ

- כל

- להתפתח

- בדיוק

- יקר

- לנצל

- תמצית

- פָּנִים

- גורמים

- רחוק

- טובה

- שדה

- שדות

- סופי

- תזרים

- זורם

- להתמקד

- מרוכז

- מתמקד

- התמקדות

- בעד

- בחזית

- צורות

- קרן

- ארבע

- מסגרת

- החל מ-

- פונקציה

- פונקציות

- עתיד

- מִשְׂחָק

- מייצר

- יצירת

- דור

- גלוֹבָּלִי

- הקשר גלובלי

- לתפוס

- לגדול

- מדריך

- מנחה

- לטפל

- יש

- יש

- ראש

- עזרה

- מוּסתָר

- גָבוֹהַ

- גבוה יותר

- הדגשה

- מחזיק

- הוליסטית

- איך

- HTTPS

- בן אנוש

- היברידי

- i

- אידאל

- לזהות

- if

- תמונה

- מיידי

- חשיבות

- חשוב

- in

- לֹא מְדוּיָק

- שילוב

- להצביע

- בנפרד

- לֹא יָעִיל

- מידע

- מטבע הדברים

- קלט

- תובנות

- למשל

- אינטליגנטי

- התכוון

- אינטראקציה

- יחסי גומלין

- אינטראקטיבי

- מתערב

- אל תוך

- לֹא יְסוּלֵא בְּפָּז

- בדידות

- IT

- שֶׁלָה

- jpg

- רק

- מפתח

- אזורי מפתח

- שפה

- אחרון

- שכבה

- מוביל

- לִלמוֹד

- למדו וצמחו

- לומדים

- למידה

- הוביל

- Lens

- עדשות

- תנופה

- מינוף

- סִפְרִיָה

- שקרים

- אוֹר

- כמו

- הגבלה

- מגבלות

- מקומי

- ארוך

- עוד

- נראה

- אהבה

- מכונה

- למידת מכונה

- מכונת תרגום

- שמירה

- לעשות

- עשייה

- איש

- רב

- מסכה

- מַטרִיצָה

- max-width

- משמעות

- משמעויות

- נמדד

- מנגנון

- מנגנוני

- זכרון

- יכול

- עלמה

- חסר

- מודל

- מודלים

- יותר

- יותר יעיל

- רב פנים

- מספר

- טבעי

- שפה טבעית

- דור שפה טבעית

- עיבוד שפה טבעית

- הבנת שפה טבעית

- טבע

- צורך

- צורך

- צרכי

- השכנים

- רשתות

- עצביים

- רשתות עצביות

- חדש

- הבא

- לילה

- NLP

- שמות עצם

- עַכשָׁיו

- ניואנס

- of

- לעתים קרובות

- on

- פעם

- רק

- אופטימלי

- or

- להזמין

- אחר

- אחרים

- שלנו

- הַחוּצָה

- תפוקה

- פלטים

- מקיף

- סקירה

- שֶׁלוֹ

- עמוד

- זוג

- מאמר

- מקביל

- חלקים

- קטעים

- עבר

- דפוסי

- לבצע

- ביצועים

- נקודות מבט

- חתיכות

- אפלטון

- מודיעין אפלטון

- אפלטון נתונים

- לְשַׂחֵק

- נקודה

- תנוחות

- בעל

- אפשרויות

- חָזָק

- פוטנציאל

- פוטנציאל

- כּוֹחַ

- חזק

- ניבוי

- התחזיות

- מִשׁמֶרֶת

- מניעה

- קוֹדֶם

- בראש ובראשונה

- יְסוֹדִי

- תהליך

- מעובד

- תהליכים

- תהליך

- כוח עיבוד

- המוצר

- מוקרן

- מונע

- מספק

- שאלה

- רכס

- טִוּוּחַ

- במקום

- חומר עיוני

- לְלֹא קוֹשִׁי

- קריאה

- זמן אמת

- הפניה

- ללא קשר

- מערכות יחסים

- קרוב משפחה

- הרלוונטיות

- רלוונטי

- ראוי לציון

- נציגות

- המייצג

- מייצג

- לדרוש

- לפתור

- משאב

- משאבים

- אלה

- תוצאות

- סקירה

- מהפכני

- חוללה מהפכה

- עשיר

- תפקיד

- s

- אותו

- סרקזם

- ראה

- מאזניים

- סריקה

- מדע

- ציון

- ציונים

- חיפוש

- שְׁנִיָה

- ראות

- משפט

- רגש

- רצף

- סדרה

- משמש

- כמה

- שיתוף

- מבריק

- יְרִי

- קצר

- ראווה

- בו זמנית

- להאט

- קטן יותר

- אך ורק

- לפתור

- לפעמים

- מקורות

- מֶרחָב

- ספציפי

- במיוחד

- ספֵּקטרוּם

- מהירויות

- זַרקוֹר

- מעמד

- כוכב

- שלב

- חנויות

- אסטרטגיות

- חוזק

- חזק יותר

- מִבְנֶה

- מַאֲבָק

- נאבק

- נושא

- לאחר מכן

- כזה

- מַתְאִים

- סכום

- לסכם

- סיכום

- מעולה

- הסובב

- מערכות

- לְהִתְמוֹדֵד

- נטילת

- שטיחים

- משימות

- טכני

- טווח

- טֶקסט

- דור טקסט

- זֶה

- השמיים

- העולם

- שֶׁלָהֶם

- אותם

- אז

- אלה

- הֵם

- זֶה

- שְׁלוֹשָׁה

- דרך

- זמן

- סדרת זמן

- ל

- כלי

- מסורתי

- הדרכה

- טרנספורמטיבית

- טרנספורמציה

- שנאי

- רוֹבּוֹטרִיקִים

- הפיכה

- תרגום

- נָכוֹן

- שתיים

- סוגים

- בסופו של דבר

- להבין

- הבנה

- בְּלִי סָפֵק

- נעילה

- לַחשׂוֹף

- חשף

- להשתמש

- שימושים

- באמצעות

- שונים

- Vast

- נגד

- לצפיה

- ביקר

- חיוני

- vs

- רוצה

- רוצה

- היה

- טוֹב

- מה

- מתי

- בזמן

- מי

- כל

- רָחָב

- טווח רחב

- יצטרך

- חלון

- עם

- בתוך

- לְלֹא

- אשה

- Word

- מילים

- תיק עבודות

- עוֹלָם

- כתיבה

- אתמול

- אתה

- זפירנט

- גן חיות