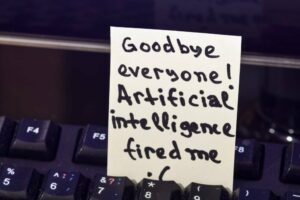

Boffins של אוניברסיטת שיקגו פרסמה השבוע את Nightshade 1.0, כלי שנבנה כדי להעניש יצרנים חסרי מצפון של מודלים של למידת מכונה המאמנים את המערכות שלהם על נתונים מבלי לקבל אישור קודם.

לילית הוא כלי הרעלת נתונים פוגעני, מלווה לכלי הגנה בסגנון הגנתי הנקרא זיגוג, אשר הקופה מכוסה בפברואר בשנה שעברה.

Nightshade מרעיל קבצי תמונה כדי לגרום לבעיות עיכול לדגמים שבולעים נתונים ללא רשות. זה נועד לגרום לאותם מודלים מוכווני תמונה לכבד את רצונותיהם של יוצרי תוכן לגבי השימוש בעבודתם.

"Nightshade מחושב כאופטימיזציה מרובת אובייקטים שממזערת שינויים גלויים בתמונה המקורית," אמר הצוות האחראי על הפרויקט.

"לדוגמה, עיניים אנושיות עשויות לראות תמונה מוצללת של פרה בשדה ירוק כמעט ללא שינוי, אבל דגם בינה מלאכותית עשוי לראות ארנק עור גדול מונח בדשא. "

Nightshade פותח על ידי הדוקטורנטים של אוניברסיטת שיקגו שון שאן, וונקסין דינג וג'וזפין פאסאנטי, והפרופסורים הת'ר ג'נג ובן ג'או, שחלקם גם עזרו עם גלייז.

מתואר ב עבודת מחקר באוקטובר 2023, Nightshade הוא התקפת הרעלה ספציפית להנחיות. הרעלת תמונה כרוכה בבחירת תווית (למשל חתול) שמתארת את מה שמתואר בפועל על מנת לטשטש את גבולות המושג הזה כאשר התמונה נבלעת לאימון דוגמניות.

אז משתמש של דוגמנית מאומנת על תמונות מורעלות ב-Nightshade עשוי לשלוח בקשה לחתול ולקבל הודעה על תמונה של כלב או דג. תגובות בלתי צפויות מהסוג הזה הופכות מודלים של טקסט לתמונה פחות שימושיים משמעותית, מה שאומר שליוצרי מודלים יש תמריץ להבטיח שהם מתאמנים רק על נתונים שהוצעו באופן חופשי.

"Nightshade יכול לספק כלי רב עוצמה לבעלי תוכן כדי להגן על הקניין הרוחני שלהם מפני מאמני דגמים שמתעלמים או מתעלמים מהודעות זכויות יוצרים, הנחיות לא לגרד/סרוק ורשימות ביטול", מצהירים המחברים במאמרם.

אי התחשבות ברצונות של יוצרי ובעלי יצירות אמנות הוביל לתביעה משפטית הוגש בשנה שעברה, חלק מדחיפה רחבה יותר נגד איסוף חסר רשות של נתונים לטובת עסקים בינה מלאכותית. טענת ההפרה, שהועלתה בשם מספר אמנים נגד Stability AI, Deviant Art ו-Midjourney, טוענת כי מודל Stable Diffusion בו השתמשו החברות הנתבעות משלב את עבודת האמנים ללא רשות. התיק, שתוקן בנובמבר 2023 כך שיכלול נאשם חדש, Runway AI, ממשיך להתדיינות.

המחברים מזהירים כי ל-Nightshade יש כמה מגבלות. באופן ספציפי, תמונות שעובדו עם התוכנה עשויות להיות שונות בעדינות מהמקור, במיוחד יצירות אמנות המשתמשות בצבעים שטוחים ורקעים חלקים. כמו כן, הם מבחינים שניתן לפתח טכניקות לביטול Nightshade, אם כי הם מאמינים שהם יכולים להתאים את התוכנה שלהם כדי לעמוד בקצב צעדי הנגד.

מתיו גוזדיאל, עוזר פרופסור למדעי המחשב באוניברסיטת אלברטה, אמר במדיה חברתית פוסט, "זו עבודה מגניבה ובזמן! אבל אני חושש שזה מוגזם כפתרון. זה עובד רק עם מודלים מבוססי CLIP ולפי המחברים, ידרוש 8 מיליון תמונות 'מורעלות' כדי להשפיע משמעותית על יצירת תמונות דומות עבור דגמי LAION."

ל-Glaze, שהגיעה ל-1.0 ביוני האחרון, יש גרסת אינטרנט, והוא כעת על שלה שחרור 1.1.1, משנה תמונות כדי למנוע מדוגמניות שהוכשרו על התמונות הללו לשכפל את הסגנון החזותי של האמן.

חיקוי סגנון - זמין באמצעות שירותי טקסט לתמונה סגורים כמו Midjourney ודרך מודלים של קוד פתוח כמו Stable Diffusion - אפשרי פשוט על ידי הנחיה למודל טקסט לתמונה לייצר תמונה בסגנון של אמן ספציפי.

הצוות מאמין שצריכה להיות לאמנים דרך למנוע את הלכידה והשחזור של הסגנונות החזותיים שלהם.

"חיקוי סגנון מייצר מספר תוצאות מזיקות שאולי אינן ברורות במבט ראשון", קובעים הבופינים. "עבור אמנים שהסגנונות שלהם מועתקים בכוונה, לא רק שהם רואים הפסד בעמלות ובהכנסה בסיסית, אלא שגם עותקים סינתטיים באיכות נמוכה הפזורים ברשת מדללים את המותג והמוניטין שלהם. והכי חשוב, אמנים מקשרים את הסגנונות שלהם עם עצם הזהות שלהם".

הם משווים חיקוי סגנון לגניבת זהות ואומרים שזה מונע מאמנים שואפים ליצור יצירה חדשה.

הצוות ממליץ לאמנים להשתמש גם ב-Nightshade וגם ב-Glaze. כיום יש להוריד ולהתקין את שני הכלים בנפרד, אך גרסה משולבת נמצאת בפיתוח. ®

- הפצת תוכן ויחסי ציבור מופעל על ידי SEO. קבל הגברה היום.

- PlatoData.Network Vertical Generative Ai. העצים את עצמך. גישה כאן.

- PlatoAiStream. Web3 Intelligence. הידע מוגבר. גישה כאן.

- PlatoESG. פחמן, קלינטק, אנרגיה, סביבה, שמש, ניהול פסולת. גישה כאן.

- PlatoHealth. מודיעין ביוטכנולוגיה וניסויים קליניים. גישה כאן.

- מקור: https://go.theregister.com/feed/www.theregister.com/2024/01/20/nightshade_ai_images/

- :יש ל

- :הוא

- :לֹא

- 1

- 2023

- 8

- a

- אודות

- למעשה

- להסתגל

- נגד

- AI

- אלברטה

- טוען

- גם

- an

- ו

- ARE

- אמנות

- אמן

- אמנים

- יצירות אמנות

- AS

- שאפתן

- עוזר

- עמית

- At

- לתקוף

- מחברים

- זמין

- רקע

- בסיסי

- הכנסה בסיסית

- BE

- היה

- בשם

- להיות

- תאמינו

- בן

- תועלת

- לטשטש

- שניהם

- גבולות

- מותג

- רחב

- נבנה

- עסקים

- אבל

- by

- נקרא

- CAN

- ללכוד

- מקרה

- חָתוּל

- זהירות

- שינויים

- שיקגו

- לטעון

- סגור

- CO

- משולב

- עמלות

- חבר

- המחשב

- מדעי מחשב

- מושג

- לשקול

- תוכן

- יוצרי תוכן

- בעלי תוכן

- קריר

- עותקים

- זכויות יוצרים

- לִיצוֹר

- יוצרים

- cs

- נתונים

- הגנתי

- מתאר

- מפותח

- אחר

- שידור

- הנחיות

- do

- עושה

- כֶּלֶב

- e

- כל אחד

- לְהַבטִיחַ

- Ether (ETH)

- דוגמה

- עיניים

- כשלון

- פבואר

- שדה

- קבצים

- חברות

- ראשון

- דג

- דירה

- בעד

- בחופשיות

- החל מ-

- יצירת

- מקבל

- לתת

- מבט

- דשא

- ירוק

- מזיק

- קְצִיר

- יש

- עזר

- HTML

- HTTPS

- בן אנוש

- i

- זהות

- גניבת זהות

- להתעלם

- תמונה

- תמונות

- פְּגִיעָה

- חשוב

- in

- תמריץ

- לכלול

- הַכנָסָה

- משלבת

- הפרה

- אִינטֶלֶקְטוּאַלִי

- קניין רוחני

- התכוון

- בכוונה

- כרוך

- IT

- שֶׁלָה

- jpg

- יוני

- שמור

- תווית

- גָדוֹל

- במידה רבה

- אחרון

- שנה שעברה

- תביעה משפטית

- למידה

- הוביל

- פחות

- כמו

- מגבלות

- רשימות

- את

- נמוך

- מכונה

- למידת מכונה

- עשוי

- לעשות

- קובעים

- מאי..

- אומר

- מדיה

- מסע אמצע

- יכול

- מִילִיוֹן

- ממזער

- שימוש לרעה

- מודל

- מודלים

- רוב

- צריך

- חדש

- הודעה

- נוֹבֶמבֶּר

- עַכשָׁיו

- מספר

- להתבונן

- ברור

- אוֹקְטוֹבֶּר

- of

- מתקפה

- מוצע

- on

- באינטרנט

- רק

- קוד פתוח

- אופטימיזציה

- or

- להזמין

- מְקוֹרִי

- תוצאות

- בעלי

- שלום

- מאמר

- חלק

- במיוחד

- עבור

- רשות

- ללא רשות

- לקטוף

- אפלטון

- מודיעין אפלטון

- אפלטון נתונים

- רעל

- אפשרי

- חזק

- כַּיוֹם

- למנוע

- מעובד

- לייצר

- ייצור

- פרופסור

- פּרוֹיֶקט

- רכוש

- להגן

- .

- לספק

- ארנק

- איכות

- הגיע

- לקבל

- ממליצה

- שוחרר

- שעתוק

- מוניטין

- לדרוש

- כבוד

- תגובות

- אחראי

- מסלול המראה

- s

- אמר

- לומר

- פזור

- מדע

- לִרְאוֹת

- שירותים

- כמה

- שון

- צריך

- משמעותי

- באופן משמעותי

- דומה

- בפשטות

- להחליק

- חֶברָתִי

- מדיה חברתית

- תוכנה

- פִּתָרוֹן

- כמה

- ספציפי

- במיוחד

- יציבות

- יציב

- מדינה

- סטודנטים

- סגנון

- סגנונות

- להגיש

- סינטטי

- מערכות

- נבחרת

- טכניקות

- זֶה

- השמיים

- גְנֵבָה

- שֶׁלָהֶם

- הֵם

- זֶה

- השבוע

- אלה

- אם כי?

- דרך

- אקטואלי

- ל

- כלי

- כלים

- רכבת

- מְאוּמָן

- הדרכה

- שתיים

- אוניברסיטה

- אוניברסיטת שיקגו

- בלתי צפוי

- להשתמש

- מְשׁוּמָשׁ

- מועיל

- משתמש

- שימושים

- גרסה

- מאוד

- נראה

- חזותי

- היה

- דֶרֶך..

- אינטרנט

- שבוע

- מה

- מתי

- אשר

- מי

- מִי

- של מי

- משאלות

- עם

- לְלֹא

- תיק עבודות

- עובד

- לדאוג

- היה

- שנה

- זפירנט

- זאו