Contenuto sponsorizzato

ChatGPT e strumenti simili basati su modelli linguistici di grandi dimensioni (LLM) sono sorprendenti. Ma non sono strumenti universali.

È proprio come scegliere altri strumenti per costruire e creare. Devi scegliere quello giusto per il lavoro. Non proveresti a stringere un bullone con un martello o a girare un hamburger con una frusta. Il processo sarebbe scomodo e si tradurrebbe in un fallimento disordinato.

I modelli linguistici come gli LLM costituiscono solo una parte del più ampio toolkit di apprendimento automatico, che comprende sia l’intelligenza artificiale generativa che l’intelligenza artificiale predittiva. Selezionare il tipo corretto di modello di machine learning è fondamentale per allinearlo ai requisiti della tua attività.

Esaminiamo più a fondo il motivo per cui i LLM sono più adatti per aiutarti a redigere testi o fare brainstorming su idee regalo piuttosto che per affrontare le attività di modellazione predittiva più critiche della tua azienda. C'è ancora un ruolo vitale per i modelli “tradizionali” di machine learning che hanno preceduto gli LLM e hanno ripetutamente dimostrato il loro valore nelle aziende. Esploreremo anche un approccio pionieristico per l'utilizzo combinato di questi strumenti: uno sviluppo entusiasmante che noi di Pecan chiamiamo GenAI predittiva.

Gli LLM sono progettati per parole, non numeri

Nell'apprendimento automatico, vengono utilizzati diversi metodi matematici per analizzare i cosiddetti "dati di addestramento", un set di dati iniziale che rappresenta il problema che un analista di dati o un data scientist spera di risolvere.

L'importanza dei dati di addestramento non può essere sopravvalutata. Contiene al suo interno i modelli e le relazioni che un modello di machine learning “impara” a prevedere i risultati quando successivamente gli verranno forniti dati nuovi e invisibili.

Allora, cos'è nello specifico un LLM? I Large Language Models, o LLM, rientrano nell’ambito dell’apprendimento automatico. Provengono dal deep learning e la loro struttura è sviluppata appositamente per l'elaborazione del linguaggio naturale.

Potresti dire che sono costruiti su fondamenta di parole. Il loro obiettivo è semplicemente prevedere quale parola sarà la successiva in una sequenza di parole. Ad esempio, la funzionalità di correzione automatica degli iPhone in iOS 17 ora utilizza un LLM per prevedere meglio quale parola molto probabilmente intendi digitare successivamente.

Ora, immagina di essere un modello di machine learning. (Abbi pazienza, sappiamo che è una forzatura.) Sei stato addestrato a prevedere le parole. Hai letto e studiato milioni di parole da una vasta gamma di fonti su tutti i tipi di argomenti. I tuoi mentori (ovvero gli sviluppatori) ti hanno aiutato a apprendere i modi migliori per prevedere le parole e creare nuovo testo che soddisfi la richiesta dell'utente.

Ma ecco una svolta. Un utente ora ti fornisce un enorme foglio di calcolo di dati sui clienti e sulle transazioni, con milioni di righe di numeri, e ti chiede di prevedere i numeri relativi a questi dati esistenti.

Come pensi che andrebbero a finire le tue previsioni? Innanzitutto, probabilmente saresti infastidito dal fatto che questo compito non corrisponde a ciò per cui hai lavorato così duramente per imparare. (Fortunatamente, per quanto ne sappiamo, i LLM non hanno ancora sentimenti.) Ancora più importante, ti viene chiesto di svolgere un compito che non corrisponde a ciò che hai imparato a fare. E probabilmente non ti esibirai così bene.

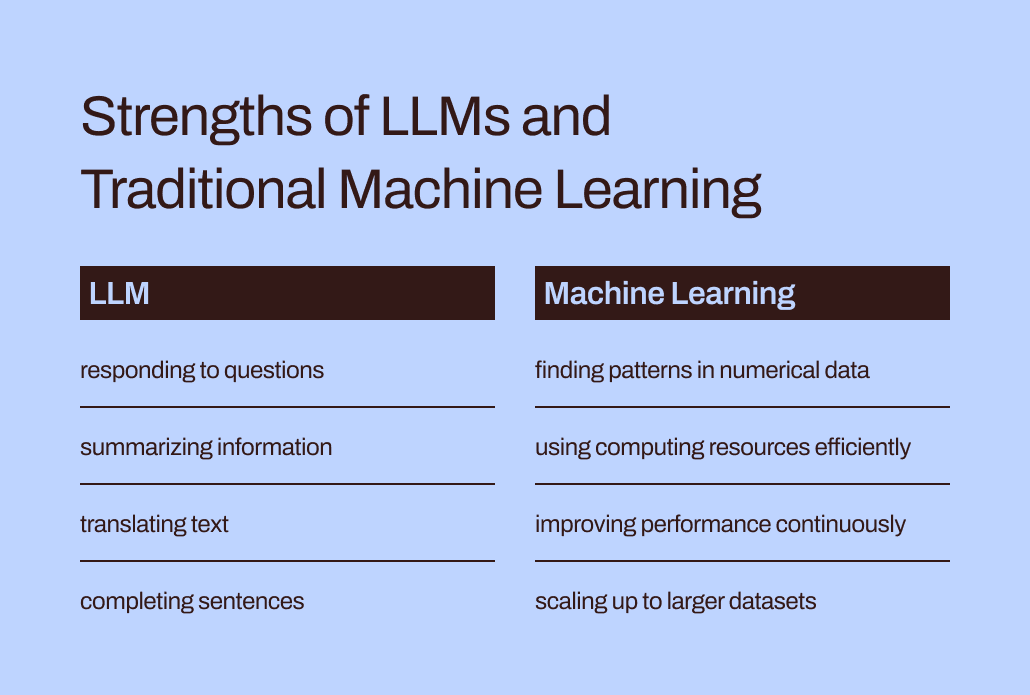

Il divario tra formazione e attività aiuta a spiegare perché gli LLM non sono adatti per attività predittive che coinvolgono dati numerici e tabulari, il formato di dati principale raccolto dalla maggior parte delle aziende. Invece, un modello di machine learning appositamente realizzato e messo a punto per la gestione di questo tipo di dati è più efficace. È stato letteralmente addestrato per questo.

Le sfide di efficienza e ottimizzazione degli LLM

Oltre ad adattarsi meglio ai dati numerici, i metodi tradizionali di machine learning sono molto più efficienti e più facili da ottimizzare per ottenere prestazioni migliori rispetto agli LLM.

Torniamo alla tua esperienza impersonando un LLM. Leggere tutte quelle parole e studiarne lo stile e la sequenza sembra un sacco di lavoro, giusto? Ci vorrebbe un grande sforzo per interiorizzare tutte queste informazioni.

Allo stesso modo, la complessa formazione degli LLM può portare a modelli con miliardi di parametri. Questa complessità consente a questi modelli di comprendere e rispondere alle complesse sfumature del linguaggio umano. Tuttavia, la formazione intensiva comporta elevate richieste computazionali quando gli LLM generano risposte. Gli algoritmi di apprendimento automatico “tradizionali” orientati numericamente, come gli alberi decisionali o le reti neurali, avranno probabilmente bisogno di molte meno risorse di calcolo. E questo non è un caso di “più grande è meglio”. Anche se gli LLM potessero gestire dati numerici, questa differenza significherebbe che i metodi tradizionali di apprendimento automatico sarebbero comunque più veloci, più efficienti, più sostenibili dal punto di vista ambientale e più convenienti.

Inoltre, hai mai chiesto a ChatGPT come sapeva fornire una risposta particolare? La sua risposta sarà probabilmente un po’ vaga:

Genero risposte basate su una combinazione di dati concessi in licenza, dati creati da formatori umani e dati disponibili pubblicamente. La mia formazione ha coinvolto anche set di dati su larga scala ottenuti da una varietà di fonti, inclusi libri, siti Web e altri testi, per sviluppare una comprensione ad ampio raggio del linguaggio umano. Il processo di formazione prevede l'esecuzione di calcoli su migliaia di GPU per settimane o mesi, ma i dettagli e le tempistiche esatte sono di proprietà di OpenAI.

Quanta della “conoscenza” riflessa in quella risposta proveniva dai formatori umani rispetto ai dati pubblici rispetto ai libri? Anche lo stesso ChatGPT non è sicuro: "Le proporzioni relative di queste fonti sono sconosciute e non ho una visibilità dettagliata su quali documenti specifici facessero parte del mio set di formazione."

È un po' snervante che ChatGPT fornisca risposte così sicure alle tue domande ma non sia in grado di tracciare le sue risposte a fonti specifiche. Anche l'interpretabilità e la spiegabilità limitate dei LLM pongono sfide nell'ottimizzarli per particolari esigenze aziendali. Può essere difficile comprendere la logica dietro le loro informazioni o previsioni. A complicare ulteriormente le cose, alcune aziende devono far fronte a requisiti normativi che significano che devono essere in grado di spiegare i fattori che influenzano le previsioni di un modello. Nel complesso, queste sfide dimostrano che i modelli tradizionali di machine learning, generalmente più interpretabili e spiegabili, sono probabilmente più adatti ai casi d’uso aziendali.

Il posto giusto per gli LLM nel toolkit predittivo delle aziende

Quindi, dovremmo semplicemente lasciare gli LLM ai loro compiti legati alle parole e dimenticarcene per casi d'uso predittivi? Dopo tutto, potrebbe sembrare che non siano più in grado di prevedere l'abbandono dei clienti o il valore della vita del cliente.

Il punto è questo: anche se dire "modelli tradizionali di machine learning" fa sì che tali tecniche sembrino ampiamente comprese e facili da usare, sappiamo dalla nostra esperienza in Pecan che le aziende stanno ancora in gran parte lottando per adottare anche queste forme più familiari di intelligenza artificiale.

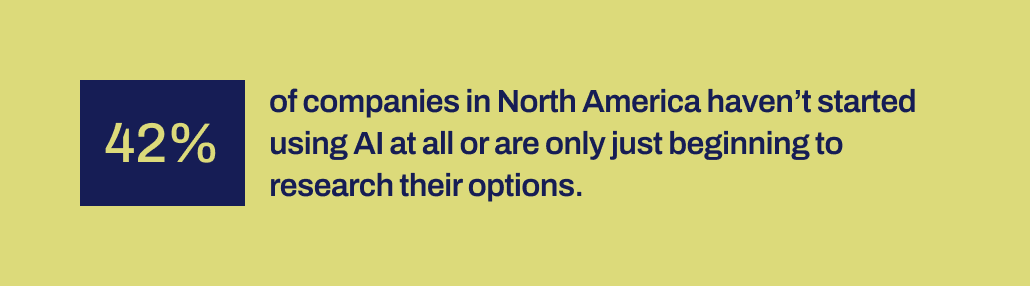

Una recente ricerca di Workday rivela che il 42% delle aziende del Nord America non ha ancora iniziato a utilizzare l’intelligenza artificiale o è solo nella fase iniziale di esplorare le proprie opzioni. Ed è passato più di un decennio da quando gli strumenti di machine learning sono diventati più accessibili alle aziende. Hanno avuto il tempo e sono disponibili vari strumenti.

Per qualche ragione, le implementazioni di intelligenza artificiale di successo sono state sorprendentemente rare, nonostante il grande interesse attorno alla scienza dei dati e all’intelligenza artificiale e al loro riconosciuto potenziale di impatto aziendale significativo. Manca qualche meccanismo importante per contribuire a colmare il divario tra le promesse fatte dall’intelligenza artificiale e la capacità di implementarla in modo produttivo.

Ed è proprio qui che crediamo che i LLM possano ora svolgere un ruolo di ponte vitale. Gli LLM possono aiutare gli utenti aziendali a superare il divario tra l'identificazione di un problema aziendale da risolvere e lo sviluppo di un modello predittivo.

Con gli LLM ora in scena, i team aziendali e di dati che non hanno la capacità o la capacità di codificare manualmente i modelli di machine learning possono ora tradurre meglio le loro esigenze in modelli. Possono “usare le loro parole”, come amano dire i genitori, per avviare il processo di modellazione.

Fondere LLM con tecniche di machine learning create per eccellere sui dati aziendali

Questa funzionalità è ora arrivata in Predictive GenAI di Pecan, che sta fondendo i punti di forza degli LLM con la nostra piattaforma di apprendimento automatico già altamente raffinata e automatizzata. La nostra chat predittiva basata su LLM raccoglie input da un utente aziendale per guidare la definizione e lo sviluppo di una domanda predittiva: il problema specifico che l'utente desidera risolvere con un modello.

Quindi, utilizzando GenAI, la nostra piattaforma genera un notebook predittivo per rendere ancora più semplice il passo successivo verso la modellazione. Ancora una volta, attingendo alle funzionalità LLM, il notebook contiene query SQL precompilate per selezionare i dati di training per il modello predittivo. Le funzionalità automatizzate di preparazione dei dati, ingegneria delle funzionalità, creazione di modelli e implementazione di Pecan possono eseguire il resto del processo in tempi record, più velocemente di qualsiasi altra soluzione di modellazione predittiva.

In breve, Predictive GenAI di Pecan utilizza le impareggiabili competenze linguistiche degli LLM per rendere la nostra piattaforma di modellazione predittiva migliore della categoria molto più accessibile e amichevole per gli utenti aziendali. Siamo entusiasti di vedere come questo approccio aiuterà molte più aziende ad avere successo con l’intelligenza artificiale.

Quindi, mentre i LLM da solo non sono adatti a gestire tutte le tue esigenze predittive, possono svolgere un ruolo importante nel portare avanti i tuoi progetti di intelligenza artificiale. Interpretando il tuo caso d'uso e offrendoti un vantaggio con il codice SQL generato automaticamente, Predictive GenAI di Pecan è all'avanguardia nell'unificazione di queste tecnologie. Puoi dai un'occhiata adesso con una prova gratuita.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://www.kdnuggets.com/2024/01/pecan-llms-used-alone-cant-address-companys-predictive-needs?utm_source=rss&utm_medium=rss&utm_campaign=why-llms-used-alone-cant-address-your-companys-predictive-needs

- :ha

- :È

- :non

- :Dove

- 15%

- 17

- a

- capacità

- capace

- Chi siamo

- accessibile

- riconosciuto

- aggiunta

- indirizzo

- adottare

- Dopo shavasana, sedersi in silenzio; saluti;

- ancora

- AI

- aka

- Algoritmi

- allineare

- Tutti

- consente

- da solo

- già

- anche

- stupefacente

- America

- an

- analista

- analizzare

- ed

- rispondere

- risposte

- in qualsiasi

- approccio

- SONO

- in giro

- arrivato

- AS

- assistere

- At

- Automatizzata

- apprendimento automatico automatizzato

- automaticamente

- disponibile

- precedente

- basato

- BE

- Orso

- è diventato

- stato

- Inizio

- dietro

- essendo

- CREDIAMO

- MIGLIORE

- Meglio

- fra

- miliardi

- Po

- Bolt

- Libri

- entrambi

- brainstorm

- BRIDGE

- bridging

- più ampia

- Costruzione

- costruito

- affari

- impatto sul business

- aziende

- ma

- by

- chiamata

- è venuto

- Materiale

- funzionalità

- capacità

- Ultra-Grande

- trasportare

- Custodie

- casi

- certo

- sfide

- abisso

- chiacchierare

- ChatGPT

- la scelta

- codice

- raccogliere

- viene

- Aziende

- Società

- complesso

- complessità

- computazionale

- calcoli

- informatica

- fiducioso

- costituire

- contiene

- correggere

- costo effettivo

- potuto

- artigianale

- creare

- creato

- Creazione

- critico

- Cross

- cruciale

- cliente

- dati

- analista dati

- Preparazione dei dati

- scienza dei dati

- scienziato di dati

- dataset

- decennio

- decisione

- deep

- apprendimento profondo

- più profondo

- definizione

- richieste

- deployment

- progettato

- Nonostante

- dettagliati

- dettagli

- sviluppare

- sviluppato

- sviluppatori

- in via di sviluppo

- Mercato

- differenza

- diverso

- DIG

- do

- documenti

- non

- don

- Dont

- bozza

- disegno

- Presto

- più facile

- facile

- Efficace

- efficienza

- efficiente

- sforzo

- o

- che comprende

- Ingegneria

- l'ambiente

- Etere (ETH)

- Anche

- EVER

- esempio

- Excel

- eccitato

- coinvolgenti

- esistente

- esperienza

- Spiegare

- Spiegabilità

- esplora

- Esplorare

- Fattori

- Fallimento

- Autunno

- familiare

- lontano

- più veloce

- caratteristica

- sentimenti

- meno

- Nome

- in forma

- si adatta

- Capovolgere

- Nel

- formato

- forme

- per fortuna

- Avanti

- Fondazione

- Gratis

- amichevole

- da

- ulteriormente

- fusione

- divario

- genio

- generalmente

- generare

- generato

- genera

- generativo

- AI generativa

- regalo

- dato

- dà

- Dare

- Go

- scopo

- GPU

- guida

- ha avuto

- martello

- maniglia

- Manovrabilità

- Hard

- Avere

- porto

- capo

- robusto

- Aiuto

- aiutato

- aiutare

- aiuta

- vivamente

- detiene

- spera

- Come

- Tuttavia

- HTTPS

- umano

- i

- idee

- identificazione

- if

- immagine

- Impact

- realizzare

- implementazioni

- importante

- importante

- in

- Compreso

- influenzare

- informazioni

- inizialmente

- avviato

- ingresso

- invece

- intendono

- ai miglioramenti

- coinvolto

- comporta

- coinvolgendo

- iOS

- IT

- SUO

- stessa

- Lavoro

- ad appena

- KDnuggets

- Sapere

- conosciuto

- Lingua

- grandi

- larga scala

- maggiormente

- dopo

- principale

- IMPARARE

- imparato

- apprendimento

- Lasciare

- Autorizzato

- tutta la vita

- piace

- probabile

- Limitato

- lotto

- macchina

- machine learning

- Tecniche di apprendimento automatico

- fatto

- make

- FA

- molti

- massiccio

- partita

- matematico

- significare

- meccanismo

- mentori

- metodi

- forza

- milioni

- mancante

- miscela

- modello

- modellismo

- modelli

- mese

- Scopri di più

- più efficiente

- maggior parte

- in movimento

- molti

- devono obbligatoriamente:

- my

- Naturale

- Linguaggio naturale

- Elaborazione del linguaggio naturale

- Bisogno

- esigenze

- reti

- Neurale

- reti neurali

- New

- GENERAZIONE

- Nord

- America del Nord

- taccuino

- adesso

- ombreggiatura

- numeri

- ottenuto

- of

- on

- ONE

- esclusivamente

- OpenAI

- ottimizzazione

- OTTIMIZZA

- ottimizzazione

- Opzioni

- or

- Altro

- nostro

- su

- risultati

- ancora

- sopravvalutato

- parametri

- genitori

- parte

- particolare

- modelli

- eseguire

- performance

- scegliere

- immagine

- pionieristico

- posto

- piattaforma

- Platone

- Platone Data Intelligence

- PlatoneDati

- Giocare

- potenziale

- potente

- precisamente

- predire

- previsione

- Previsioni

- predittiva

- preparazione

- primario

- probabilmente

- Problema

- processi

- lavorazione

- progetti

- promette

- proprio

- comprovata

- fornire

- la percezione

- pubblicamente

- query

- domanda

- Domande

- gamma

- RARO

- fondamento logico

- Leggi

- Lettura

- ragione

- record

- raffinato

- riflette

- normativo

- relazionato

- Relazioni

- parente

- RIPETUTAMENTE

- che rappresenta

- richiesta

- Requisiti

- riparazioni

- Risorse

- Rispondere

- risposta

- risposte

- REST

- colpevole

- risultante

- Rivela

- destra

- Ruolo

- running

- s

- dire

- detto

- Scienze

- Scienziato

- vedere

- sembrare

- select

- Selezione

- Sequenza

- set

- Corti

- dovrebbero

- mostrare attraverso le sue creazioni

- significato

- significativa

- simile

- semplicemente

- da

- abilità

- So

- soluzione

- RISOLVERE

- alcuni

- Suono

- suoni

- fonti

- specifico

- in particolare

- Foglio di calcolo

- SQL

- tappe

- inizia a

- iniziato

- step

- Ancora

- punti di forza

- La struttura

- Lottando

- studiato

- Studiando

- style

- avere successo

- di successo

- tale

- sicuro

- sostenibile

- T

- Affronto

- Fai

- Task

- task

- le squadre

- tecniche

- Tecnologie

- testo

- di

- che

- I

- loro

- Li

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- cosa

- cose

- think

- questo

- quelli

- migliaia

- serrare

- tempo

- a

- insieme

- tonnellata

- toolkit

- strumenti

- Argomenti

- verso

- tracciare

- tradizionale

- allenato

- Training

- delle transazioni

- tradurre

- Alberi

- prova

- TURNO

- twist

- Digitare

- ombrello

- per

- capire

- e una comprensione reciproca

- inteso

- unendo

- Sconosciuto

- ineguagliabile

- us

- uso

- caso d'uso

- utilizzato

- Utente

- utenti

- usa

- utilizzando

- APPREZZIAMO

- varietà

- vario

- Fisso

- visibilità

- importantissima

- vs

- vuole

- Modo..

- modi

- we

- siti web

- Settimane

- WELL

- sono stati

- Che

- Che cosa è l'

- quando

- quale

- while

- perché

- ampiamente

- volere

- con

- entro

- Word

- parole

- Lavora

- lavorato

- valore

- sarebbe

- ancora

- Tu

- Trasferimento da aeroporto a Sharm

- zefiro