Oggi è la Giornata mondiale del backup, il nostro promemoria annuale dell'importanza di eseguire diligentemente il backup dei dati per prevenirne la perdita. Ma il fatto è che la velocità con cui i livelli di dati esplodono in termini di dimensioni supera di gran lunga ciò che i sistemi di backup dei dati legacy possono raggiungere. Il modo in cui abbiamo eseguito il backup negli ultimi 20 anni è interrotto, soprattutto su larga scala. Poiché la quantità di dati continua ad aumentare, sia nel numero di file che nella quantità di dati generati, i sistemi di backup che scansionano i file system non sono più fattibili, in particolare quando entriamo nel regno di miliardi di file e petabyte o più di dati.

Global DataSphere di IDC, che prevede la quantità di dati che verranno creati ogni anno, prevede che i dati cresceranno a un tasso di crescita annuale composto (CAGR) del 21.2% per raggiungere oltre 221,000 exabyte (un exabyte è 1,000 petabyte) entro il 2026.

Mantenere i set di dati su larga scala sicuri e resilienti è una sfida significativa per le organizzazioni e le soluzioni di backup tradizionali non sono attrezzate per affrontare questa sfida. Inoltre, le aziende diventano sempre più vulnerabili a corruzione, malware, cancellazioni accidentali di file e altro con la crescita dei dati. La perdita di dati importanti può essere devastante e comportare perdite finanziarie, interruzioni personali e aziendali o persino problemi legali.

Altre conseguenze possono includere danni alla reputazione e il costo dell'implementazione di nuove misure di sicurezza. Il ransomware costerà alle sue vittime quasi $265 miliardi ogni anno entro il 2031, con un nuovo attacco a un consumatore o a un'azienda ogni due secondi mentre gli autori di ransomware perfezionano in modo aggressivo i loro payload di malware e le relative attività di estorsione.

Il backup dei dati legacy non è più praticabile

Il backup tradizionale funziona scansionando un file system per trovare e creare copie di file nuovi e modificati. Tuttavia, la scansione richiede più tempo con l'aumentare del numero di file, tanto che sta diventando impossibile completare le scansioni entro un lasso di tempo ragionevole. Di solito funzionano di notte quando i sistemi sono probabilmente meno volatili.

Inoltre, i backup sono impostati per essere eseguiti a intervalli, il che significa che qualsiasi modifica prima della scansione successiva andrà persa in caso di errore del sistema. Il backup tradizionale non soddisfa l'obiettivo di zero perdite di dati e il ripristino dei dati in repository di dimensioni petabyte richiede molto tempo. E il processo di recupero non è quello che dovrebbe essere: è noioso e lento.

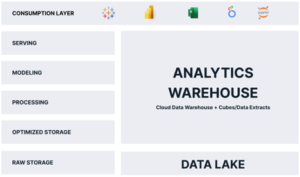

Anche "incrementale per sempre con backup completi sintetici" potrebbe non essere in grado di elaborare i dati modificati entro la finestra di backup necessaria. Sebbene il cloud sia ora comunemente utilizzato per il backup dei dati, l'approccio di trasferire petabyte di dati nel cloud e archiviare tali dati nel cloud non è né pratico né conveniente, riferisce IDC.

Raggiungere la resilienza dei dati su larga scala è sempre più critico al giorno d'oggi data-driven mondo. Le organizzazioni devono tornare indietro senza problemi, ridurre il rischio di perdita di dati e ridurre al minimo l'impatto di tempi di inattività, interruzioni, violazioni dei dati e disastri naturali. Per troppo tempo, i leader aziendali hanno dovuto accettare un livello di perdita di dati, come definito dagli obiettivi del punto di ripristino (RPO), e alcuni tempi di inattività, come definito dagli obiettivi del tempo di ripristino (RTO).

Un nuovo approccio radicale: spostare l'attenzione dai backup riusciti ai ripristini riusciti

Molti dei concetti e delle pratiche generali per la protezione dei dati, e in particolare per il backup e il ripristino, non sono cambiati da quando sono stati sviluppati nell'era client/server. Ma con i significativi progressi tecnologici e la costante ondata di attacchi informatici che agiscono da catalizzatore, l'orizzonte del backup sta per cambiare. Il backup tradizionale è progettato per essere indipendente dal file system come entità separata. Un approccio completamente nuovo rende il file system e il backup un tutt'uno: il backup risiede in linea e all'interno del percorso dei dati. Di conseguenza, ogni modifica nel file system viene registrata mentre si verifica, gli utenti finali possono recuperare i dati persi senza l'assistenza dell'IT e trovare i file è facile, indipendentemente da quando potrebbero essere esistiti e nell'intero continuum temporale.

Questo modello ridefinirà lo storage aziendale facendo convergere lo storage e la resilienza dei dati in un unico sistema in modo che ogni modifica nel percorso dei dati venga acquisita. Aumenta la resilienza dei dati e fornisce una solida prima linea di difesa contro il blocco informatico del ransomware, consentendo alle organizzazioni di recuperare i dati compromessi in modo semplice e rapido. Gli utenti o gli amministratori IT possono letteralmente tornare indietro in qualsiasi momento per recuperare i file necessari, anche in caso di attacco informatico in cui i file sono stati crittografati.

Pensa a come potresti trattare una casa in montagna e proteggerla da un incendio. Potresti prendere precauzioni come rimuovere gli alberi intorno alla casa, garantire tagliafuoco, pulire tetti e grondaie dalle foglie morte e altre misure preventive. Oppure potresti passivamente non agire e aspettare solo che la casa bruci, sperando che l'assicurazione sia adeguata per recuperare la perdita. Il primo approccio è proattivo: evitare il disastro in primo luogo. Il secondo è reattivo: è successa una cosa brutta e ora spenderemo molto tempo, impegno e denaro e speriamo di poter recuperare dove eravamo prima dell'evento.

Questo esempio illustra la differenza tra ripristino da uno stato di continuità (disponibilità continua dei dati) e discontinuità (un disastro che si verifica). Una strategia proattiva sfrutta l'accesso continuo ai dati in linea, eliminando i costi e l'impatto aziendale dei dati persi e consente i seguenti vantaggi:

- La capacità di annullare gli attacchi ransomware e fornire la prima linea di difesa contro le perdite aziendali e una forte protezione contro i criminali che tengono in ostaggio un'azienda e i suoi dati in, al massimo, minuti anziché giorni, settimane o più.

- La protezione continua dei dati consente di ottenere la continuità del servizio su larga scala con la possibilità di rimuovere istantaneamente il file system in modo che appaia com'era nel momento selezionato prima del danneggiamento dei dati, del guasto hardware o dell'evento dannoso. Offre sicurezza e resilienza dei dati su larga scala con un ripristino dei dati estremamente rapido e zero perdite di dati ottenute unendo il file system e tessuto dati.

- Il ripristino accelerato dei dati consente agli utenti di trovare e recuperare in modo interattivo ciò di cui hanno bisogno: un processo di ricerca e ripristino dei dati "fai da te" che elimina la necessità dell'intervento dell'IT.

La disponibilità continua dei dati si concentra sul ripristino piuttosto che sul backup. Aiuta le organizzazioni a sfruttare enormi quantità di dati per la resilienza e a superare gli ostacoli del backup legacy che sta diventando sempre più obsoleto. Non essere tenuto in ostaggio da un approccio di backup vecchio di decenni, sperando che non accada un disastro. Adotta una strategia proattiva che si basa sull'accesso continuo ai dati in linea per eliminare il costo e l'impatto aziendale dei dati persi e il rischio di minacce informatiche.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- Platoblockchain. Web3 Metaverse Intelligence. Conoscenza amplificata. Accedi qui.

- Fonte: https://www.dataversity.net/dont-be-held-hostage-by-legacy-data-backup/

- :È

- $ SU

- 000

- 1

- 2%

- 20 anni

- a

- capacità

- capace

- WRI

- Accetta

- accesso

- compiuto

- Raggiungere

- operanti in

- Action

- attività

- aggiunta

- avanzamenti

- contro

- consente

- Sebbene il

- quantità

- importi

- ed

- annuale

- Annualmente

- apparire

- approccio

- SONO

- in giro

- AS

- Assistenza

- assist

- At

- attacco

- attacchi

- disponibilità

- precedente

- sostegno

- di riserva

- backup

- Vasca

- BE

- diventare

- diventando

- prima

- essendo

- vantaggi

- fra

- miliardi

- violazioni

- pause

- Rotto

- bruciare

- affari

- impatto sul business

- by

- CAGR

- Materiale

- Catalizzatore

- Challenge

- il cambiamento

- Pulizia

- Chiudi

- Cloud

- comunemente

- Aziende

- completamento di una

- Compound

- Compromissione

- concetti

- Conseguenze

- costante

- Consumer

- continua

- continuo

- Continuum

- convergenti

- copie

- Aziende

- Corruzione

- Costo

- costo effettivo

- potuto

- creare

- creato

- criminali

- critico

- Cyber

- Attacchi informatici

- Attacco informatico

- dati

- l'accesso ai dati

- Violazioni dei dati

- Perdita di dati

- protezione dati

- la sicurezza dei dati

- set di dati

- VERSITÀ DEI DATI

- giorno

- Giorni

- morto

- decenni

- Difesa

- definito

- fornisce un monitoraggio

- progettato

- devastante

- sviluppato

- differenza

- disastro

- disastri

- interruzioni

- Dont

- giù

- i tempi di inattività

- facilmente

- sforzo

- eliminato

- elimina

- eliminando

- Abilita

- consentendo

- crittografato

- assicurando

- entrare

- Impresa

- Intero

- entità

- attrezzato

- epoca

- particolarmente

- Anche

- Evento

- Ogni

- esempio

- estensivo

- estorsione

- estremamente

- Fallimento

- FAST

- fattibile

- Compila il

- File

- finanziario

- Trovate

- ricerca

- Antincendio

- Nome

- Focus

- si concentra

- i seguenti

- Nel

- per sempre

- TELAIO

- fresco

- da

- pieno

- Inoltre

- Generale

- generato

- globali

- Go

- Crescere

- cresce

- Crescita

- accadere

- successo

- accade

- Hardware

- Sfruttamento

- Avere

- Eroe

- possesso

- speranza

- sperando

- orizzonte

- Casa

- Come

- Tuttavia

- HTTPS

- Impact

- Implementazione

- importanza

- importante

- impossibile

- in

- includere

- Aumento

- Aumenta

- sempre più

- studente indipendente

- assicurazione

- intervento

- sicurezza

- IT

- SUO

- jpg

- larga scala

- capi

- Eredità

- Legale

- Aspetti legali

- Livello

- livelli

- leveraggi

- piace

- probabile

- linea

- Lunghi

- più a lungo

- a

- spento

- perdite

- lotto

- FA

- il malware

- si intende

- analisi

- Soddisfare

- forza

- verbale

- soldi

- monumentale

- Scopri di più

- maggior parte

- Naturale

- necessaria

- Bisogno

- di applicazione

- Nessuno dei due

- New

- GENERAZIONE

- notte

- numero

- obiettivo

- Obiettivi d'Esame

- obsoleto

- ostacoli

- of

- Vecchio

- on

- ONE

- organizzazioni

- Altro

- interruzioni

- particolare

- particolarmente

- passato

- sentiero

- cronologia

- posto

- Platone

- Platone Data Intelligence

- PlatoneDati

- punto

- possibile

- Pratico

- pratiche

- predice

- prevenire

- Proactive

- processi

- protegge

- protezione

- fornire

- fornisce

- radicale

- ransomware

- Attacchi ransomware

- tasso

- piuttosto

- raggiungere

- ragionevole

- registrato

- Recuperare

- recupero

- recupero

- ridurre

- raffinare

- Indipendentemente

- relazionato

- rimozione

- elasticità

- elastico

- colpevole

- Rischio

- Rotolo

- Correre

- stesso

- Scala

- scansione

- scansione

- senza soluzione di continuità

- Cerca

- Secondo

- secondo

- sicuro

- problemi di

- selezionato

- servizio

- set

- Set

- MUTEVOLE

- dovrebbero

- significativa

- da

- Taglia

- rallentare

- So

- Soluzioni

- alcuni

- spendere

- primavera

- Regione / Stato

- conservazione

- Strategia

- Scioperi

- forte

- di successo

- ondata

- sintetico

- sistema

- SISTEMI DI TRATTAMENTO

- Fai

- prende

- Tecnologia

- che

- Il

- loro

- cosa

- minacce

- tempo

- a

- pure

- tradizionale

- Trasferimento

- trattare

- Alberi

- Rilassarsi

- utenti

- generalmente

- vittime

- volatile

- Vulnerabile

- aspettare

- Modo..

- Settimane

- Che

- quale

- volere

- con

- entro

- senza

- lavori

- mondo

- anni

- zefiro

- zero