Le organizzazioni di tutto il mondo, sia profit che no profit, stanno cercando di sfruttare l’analisi dei dati per migliorare le prestazioni aziendali. Risultati da a Sondaggio McKinsey indicano che le organizzazioni basate sui dati hanno 23 volte più probabilità di acquisire clienti, sei volte più probabilità di fidelizzarli e 19 volte più redditizie [1]. Una ricerca del MIT ha scoperto che le aziende digitalmente mature sono il 26% più redditizie rispetto alle loro concorrenti [2]. Ma molte aziende, nonostante siano ricche di dati, hanno difficoltà a implementare l’analisi dei dati a causa delle priorità contrastanti tra esigenze aziendali, capacità disponibili e risorse. Ricerca di Gartner ha scoperto che oltre l'85% dei progetti di dati e analisi falliscono [3] e a relazione congiunta da IBM e Carnegie Melon mostra che il 90% dei dati in un'organizzazione non viene mai utilizzato con successo per alcuno scopo strategico [4].

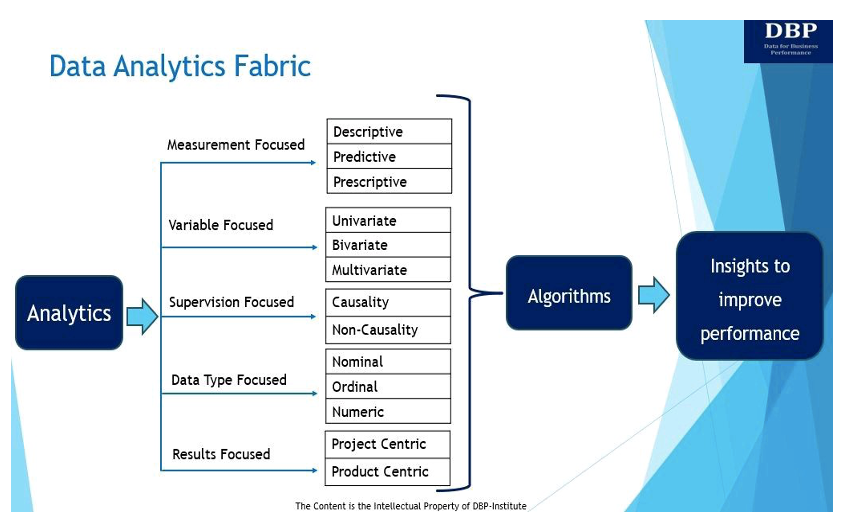

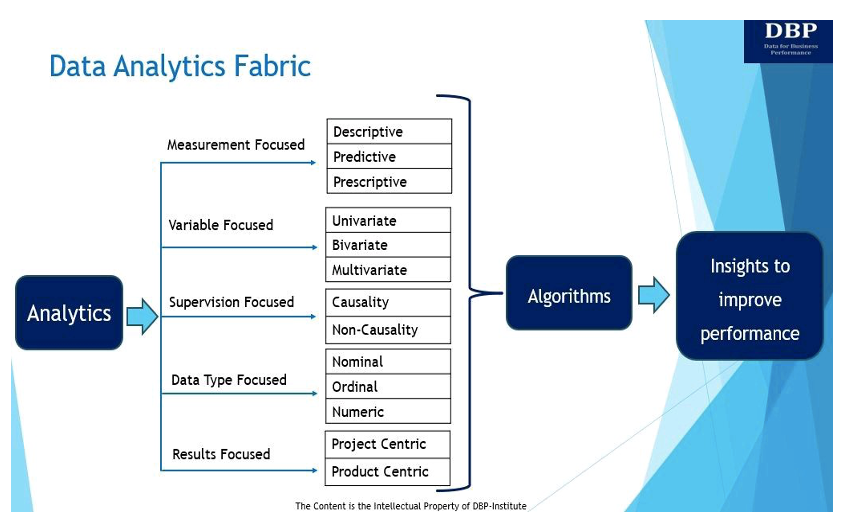

In questo contesto, introduciamo il concetto di "data analytics fabric (DAF)", come un ecosistema o una struttura che consente all'analisi dei dati di funzionare in modo efficace in base a (a) esigenze o obiettivi aziendali, (b) capacità disponibili come persone/competenze , processi, cultura, tecnologie, intuizioni, competenze decisionali e altro ancora, e (c) risorse (ovvero, componenti di cui un'azienda ha bisogno per gestire l'attività).

Il nostro obiettivo principale nell’introdurre il tessuto di analisi dei dati è rispondere a questa domanda fondamentale: “Cosa è necessario per costruire in modo efficace un sistema decisionale a partire da Science Data algoritmi per misurare e migliorare le performance aziendali?” Il tessuto dell'analisi dei dati e le sue cinque manifestazioni principali sono mostrati e discussi di seguito.

1. Focalizzati sulla misurazione

Fondamentalmente, l’analisi riguarda l’utilizzo dei dati per ricavare informazioni, misurare e migliorare le prestazioni aziendali [5]. Esistono tre tipi principali di analisi per misurare e migliorare le prestazioni aziendali:

- Analisi descrittiva pone la domanda: "Cosa è successo?" L'analisi descrittiva viene utilizzata per analizzare i dati storici per identificare modelli, tendenze e relazioni utilizzando tecniche di analisi dei dati esplorative, associative e inferenziali. Le tecniche di analisi esplorativa dei dati analizzano e riepilogano i set di dati. L’analisi descrittiva associativa spiega la relazione tra le variabili. L'analisi inferenziale descrittiva dei dati viene utilizzata per dedurre o concludere tendenze su una popolazione più ampia sulla base del set di dati campione.

- Analisi predittiva cerca di rispondere alla domanda: "Cosa accadrà?" Fondamentalmente, l’analisi predittiva è il processo di utilizzo dei dati per prevedere tendenze ed eventi futuri. L'analisi predittiva può essere condotta manualmente (comunemente nota come analisi predittiva guidata dall'analista) o utilizzando algoritmi di apprendimento automatico (nota anche come analisi predittiva basata sui dati). In ogni caso, i dati storici vengono utilizzati per fare previsioni future.

- Analisi prescrittiva aiuta a rispondere alla domanda: “Come possiamo realizzarlo?” Fondamentalmente, l’analisi prescrittiva consiglia la migliore linea d’azione per andare avanti utilizzando tecniche di ottimizzazione e simulazione. In genere, l'analisi predittiva e l'analisi prescrittiva vanno insieme perché l'analisi predittiva aiuta a trovare risultati potenziali, mentre l'analisi prescrittiva esamina tali risultati e trova più opzioni.

2. Focalizzazione sulle variabili

I dati possono anche essere analizzati in base al numero di variabili disponibili. A questo proposito, in base al numero di variabili, le tecniche di analisi dei dati possono essere univariate, bivariate o multivariate.

- Analisi invariate: L'analisi univariata prevede l'analisi del modello presente in una singola variabile utilizzando misure di centralità (media, mediana, moda e così via) e variazione (deviazione standard, errore standard, varianza e così via).

- Analisi bivariata: Esistono due variabili in cui l'analisi è correlata alla causa e alla relazione tra le due variabili. Queste due variabili potrebbero essere dipendenti o indipendenti l’una dall’altra. La tecnica di correlazione è la tecnica di analisi bivariata più utilizzata.

- Analisi multivariata: Questa tecnica viene utilizzata per analizzare più di due variabili. In un contesto multivariato, in genere operiamo nell'arena dell'analisi predittiva e la maggior parte dei noti algoritmi di machine learning (ML) come la regressione lineare, la regressione logistica, gli alberi di regressione, le macchine a vettori di supporto e le reti neurali vengono generalmente applicati a un contesto multivariato. collocamento.

3. Focalizzata sulla supervisione

Il terzo tipo di struttura di analisi dei dati si occupa dell'addestramento dei dati di input o dei dati delle variabili indipendenti etichettati per un particolare output (ovvero la variabile dipendente). Fondamentalmente, la variabile indipendente è quella controllata dallo sperimentatore. La variabile dipendente è la variabile che cambia in risposta alla variabile indipendente. Il DAF incentrato sulla supervisione potrebbe essere di due tipi.

- Causalità: I dati etichettati, generati automaticamente o manualmente, sono essenziali per l’apprendimento supervisionato. I dati etichettati consentono di definire chiaramente una variabile dipendente, quindi è questione dell'algoritmo di analisi predittiva costruire uno strumento AI/ML che creerebbe una relazione tra l'etichetta (variabile dipendente) e l'insieme di variabili indipendenti. Poiché abbiamo una netta demarcazione tra la nozione di variabile dipendente e quella di insieme di variabili indipendenti, ci permettiamo di introdurre il termine “causalità” per spiegare meglio la relazione.

- Non causalità: Quando indichiamo “incentrato sulla supervisione” come nostra dimensione, intendiamo anche “l’assenza di supervisione” e questo porta in discussione i modelli non causali. I modelli non causali meritano una menzione perché non richiedono dati etichettati. La tecnica di base qui è il clustering e i metodi più popolari sono k-Means e Hierarchical Clustering.

4. Incentrato sul tipo di dati

Questa dimensione o manifestazione del tessuto di analisi dei dati si concentra sui tre diversi tipi di variabili di dati relative sia alle variabili indipendenti che a quelle dipendenti utilizzate nelle tecniche di analisi dei dati per ricavare approfondimenti.

- Dati nominali viene utilizzato per etichettare o classificare i dati. Non si tratta di un valore numerico e quindi non sono possibili calcoli statistici con dati nominali. Esempi di dati nominali sono il sesso, la descrizione del prodotto, l'indirizzo del cliente e simili.

- Dati ordinali o classificati è l'ordine dei valori, ma le differenze tra ciascuno di essi non sono realmente note. Esempi comuni qui sono la classificazione delle aziende in base alla capitalizzazione di mercato, ai termini di pagamento dei fornitori, ai punteggi di soddisfazione del cliente, alla priorità di consegna e così via.

- Dati numerici non ha bisogno di presentazioni e ha valore numerico. Queste variabili sono i tipi di dati più fondamentali che possono essere utilizzati per modellare tutti i tipi di algoritmi.

5. Focalizzazione sui risultati

Questo tipo di tessuto di analisi dei dati esamina i modi in cui il valore aziendale può essere fornito dalle informazioni derivate dall'analisi. Esistono due modi in cui il valore aziendale può essere guidato dall'analisi e ciò avviene attraverso prodotti o progetti. Anche se i prodotti potrebbero dover affrontare ulteriori implicazioni relative all'esperienza dell'utente e all'ingegneria del software, l'esercizio di modellazione svolto per derivare il modello sarà simile sia nel progetto che nel prodotto.

- A prodotto di analisi dei dati è un asset di dati riutilizzabile per soddisfare le esigenze aziendali a lungo termine. Raccoglie dati da fonti di dati pertinenti, garantisce la qualità dei dati, li elabora e li rende accessibili a chiunque ne abbia bisogno. I prodotti sono generalmente progettati per i personaggi e hanno più fasi del ciclo di vita o iterazioni in cui viene realizzato il valore del prodotto.

- A progetto di analisi dei dati è progettato per soddisfare un'esigenza aziendale particolare o unica e ha una base di utenti o uno scopo definiti o ristretti. Fondamentalmente, un progetto è uno sforzo temporaneo inteso a fornire la soluzione per un ambito definito, nel rispetto del budget e dei tempi.

L’economia mondiale si trasformerà radicalmente nei prossimi anni poiché le organizzazioni utilizzeranno sempre più dati e analisi per ricavare informazioni e prendere decisioni per misurare e migliorare le prestazioni aziendali. McKinsey ha scoperto che le aziende che sono guidate dagli insight riportano aumenti dell’EBITDA (utili prima di interessi, tasse, svalutazioni e ammortamenti) fino al 25% [5]. Tuttavia, molte organizzazioni non riescono a sfruttare con successo dati e analisi per migliorare i risultati aziendali. Ma non esiste un modo o un approccio standard per fornire l’analisi dei dati. La distribuzione o l'implementazione di soluzioni di analisi dei dati dipende dagli obiettivi, dalle capacità e dalle risorse aziendali. Il DAF e le sue cinque manifestazioni qui discusse possono consentire l'implementazione efficace dell'analisi in base alle esigenze aziendali, alle capacità disponibili e alle risorse.

Riferimenti

- mckinsey.com/capabilities/growth-marketing-and-sales/our-insights/five-facts-how-customer-analytics-boosts-corporate-performance

- ide.mit.edu/insights/digitally-mature-firms-are-26-more-profitable-than-thero-peers/

- gartner.com/en/newsroom/press-releases/2018-02-13-gartner-says-nearly-half-of-cios-are-planning-to-deploy-artificial-intelligence

- forbes.com/sites/forbestechcouncil/2023/04/04/three-key-misconceptions-of-data-quality/?sh=58570fc66f98

- Southekal, Prashanth, “Best practice di analisi”, Technics, 2020

- mckinsey.com/capabilities/growth-marketing-and-sales/our-insights/insights-to-impact-creating-and-sustaining-data-driven-commercial-growth

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Automobilistico/VE, Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Grafico Prime. Migliora il tuo gioco di trading con ChartPrime. Accedi qui.

- BlockOffset. Modernizzare la proprietà della compensazione ambientale. Accedi qui.

- Fonte: https://www.dataversity.net/introducing-the-data-analytics-fabric-concept/

- :ha

- :È

- :non

- $ SU

- 1

- 19

- 23

- a

- WRI

- accessibile

- acquisire

- Action

- aggiuntivo

- indirizzo

- AI / ML

- algoritmo

- Algoritmi

- Tutti

- consentire

- consente

- anche

- ammortamento

- an

- .

- analitica

- analizzare

- analizzato

- l'analisi

- ed

- rispondere

- in qualsiasi

- chiunque

- applicato

- approccio

- SONO

- Arena

- in giro

- AS

- attività

- At

- automaticamente

- disponibile

- b

- fondale

- base

- basato

- basic

- fondamentalmente

- BE

- perché

- stato

- prima

- essendo

- sotto

- MIGLIORE

- fra

- entrambi

- Porta

- budget limitato.

- costruire

- affari

- le prestazioni di business

- ma

- by

- Materiale

- funzionalità

- capitalizzazione

- categorizzazione

- Causare

- Centralità

- Modifiche

- chiaramente

- il clustering

- raccoglie

- COM

- arrivo

- Uncommon

- comunemente

- Aziende

- componenti

- concetto

- concludere

- condotto

- Conflitto

- controlli

- Nucleo

- Correlazione

- potuto

- corso

- Cultura

- cliente

- Soddisfazione del cliente

- Clienti

- dati

- analisi dei dati

- Dati Analytics

- qualità dei dati

- set di dati

- set di dati

- data-driven

- VERSITÀ DEI DATI

- Offerte

- Decision Making

- decisioni

- definire

- definito

- consegnare

- consegnato

- consegna

- dipendente

- dipende

- schierato

- deployment

- ammortamento

- derivato

- descrizione

- meritare

- progettato

- Nonostante

- deviazione

- differenze

- diverso

- digitalmente

- Dimensioni

- discusso

- discussione

- distinto

- do

- effettua

- fatto

- drammaticamente

- spinto

- dovuto

- e

- ogni

- Guadagni

- EBITDA

- economia

- ecosistema

- in maniera efficace

- o

- enable

- Abilita

- sforzarsi

- Ingegneria

- assicura

- errore

- essential

- eventi

- Esempi

- Esercitare

- esperienza

- Spiegare

- Spiega

- Analisi dei dati esplorativi

- tessuto

- fatto

- FAIL

- Trovate

- I risultati

- trova

- Aziende

- cinque

- si concentra

- Nel

- Forbes

- Previsione

- Avanti

- essere trovato

- da

- function

- fondamentale

- futuro

- Gartner

- Sesso

- generato

- Go

- scopo

- accadere

- successo

- Avere

- aiuta

- quindi

- qui

- storico

- Tuttavia

- HTTPS

- i

- IBM

- identificare

- realizzare

- implementazione

- competenze

- migliorata

- miglioramento

- in

- Aumenta

- sempre più

- studente indipendente

- indicare

- ingresso

- intuizioni

- destinato

- interesse

- introdurre

- l'introduzione di

- Introduzione

- coinvolgere

- comporta

- IT

- iterazioni

- SUO

- Le

- conosciuto

- Discografica

- etichettatura

- superiore, se assunto singolarmente.

- apprendimento

- leveraging

- ciclo di vita

- piace

- probabile

- a lungo termine

- cerca

- SEMBRA

- macchina

- machine learning

- macchine

- Principale

- make

- FA

- manualmente

- molti

- Rappresentanza

- Capitalizzazione di mercato

- Importanza

- alunni

- max-width

- Maggio..

- McKinsey

- significare

- misurare

- analisi

- menzione

- metodi

- CON

- ML

- Moda

- modello

- modellismo

- modelli

- Scopri di più

- maggior parte

- Più popolare

- in movimento

- multiplo

- Bisogno

- esigenze

- reti

- Neurale

- reti neurali

- mai

- no

- Senza scopo di lucro

- Nozione

- numero

- Obiettivi d'Esame

- of

- on

- ONE

- operare

- ottimizzazione

- Opzioni

- or

- minimo

- organizzazione

- organizzazioni

- Altro

- nostro

- noi stessi

- risultati

- produzione

- ancora

- particolare

- Cartamodello

- modelli

- Pagamento

- performance

- Platone

- Platone Data Intelligence

- PlatoneDati

- Popolare

- popolazione

- possibile

- potenziale

- Previsioni

- predittiva

- Analisi predittiva

- Predictive Analytics

- presenti

- primario

- priorità

- processi

- i processi

- Prodotto

- Prodotti

- Profitto

- redditizio

- progetto

- progetti

- scopo

- qualità

- domanda

- ramificazioni

- classificato

- Posizione

- realizzato

- veramente

- raccomanda

- considerare

- regressione

- relazionato

- rapporto

- Relazioni

- pertinente

- rapporto

- richiedere

- necessario

- Risorse

- risposta

- conservare

- riutilizzabile

- soddisfazione

- portata

- punteggi

- servire

- set

- Set

- regolazione

- mostrato

- Spettacoli

- simile

- simulazione

- singolo

- SIX

- So

- Software

- Ingegneria del software

- soluzione

- Soluzioni

- Fonte

- fonti

- tappe

- Standard

- statistiche

- Strategico

- La struttura

- Lotta

- di successo

- Con successo

- tale

- riassumere

- apprendimento supervisionato

- supervisione

- supporto

- sistema

- Tasse

- tecniche

- Tecnologie

- temporaneo

- termine

- condizioni

- di

- che

- Il

- il mondo

- loro

- poi

- Là.

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- Terza

- questo

- quelli

- tre

- Attraverso

- tempo

- volte

- a

- insieme

- Training

- Trasformare

- Alberi

- tendenze

- seconda

- Digitare

- Tipi di

- tipicamente

- unico

- uso

- utilizzato

- Utente

- Esperienza da Utente

- utilizzando

- APPREZZIAMO

- Valori

- variabile

- venditore

- Modo..

- modi

- we

- noto

- quando

- se

- quale

- while

- OMS

- volere

- con

- entro

- mondo

- Il mondo di

- sarebbe

- anni

- zefiro