Immagine dell'editore

La scienza dei dati è un campo vario e in crescita e il tuo lavoro come scienziato dei dati può coprire molti compiti e obiettivi. Imparare quali algoritmi funzionano meglio in diversi scenari ti aiuterà a soddisfare queste esigenze disparate.

È praticamente impossibile essere esperti in ogni tipo di modello di machine learning, ma dovresti comprendere quelli più comuni. Ecco sette algoritmi ML essenziali che ogni data scientist dovrebbe conoscere.

Molte aziende preferiscono utilizzare modelli di apprendimento supervisionato per la loro accuratezza e le semplici applicazioni nel mondo reale. Mentre l’apprendimento non supervisionato è in crescita, le tecniche supervisionate sono un ottimo punto di partenza per un data scientist.

1. Regressione lineare

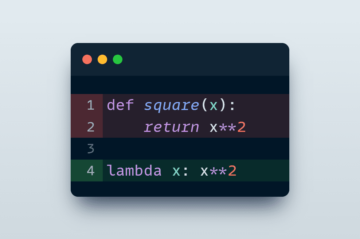

La regressione lineare è la modello fondamentale per la previsione dei valori basato su variabili continue. Presuppone che esista una relazione lineare tra due variabili e la utilizza per tracciare i risultati in base a un determinato input.

Dato il giusto set di dati, questi modelli sono facili da addestrare e implementare e relativamente affidabili. Tuttavia, le relazioni nel mondo reale spesso non sono lineari, quindi hanno una rilevanza limitata in molte applicazioni aziendali. Inoltre, non gestisce bene i valori anomali, quindi non è l'ideale per set di dati grandi e vari.

2. Regressione logistica

Un algoritmo di machine learning simile ma distinto che dovresti conoscere è la regressione logistica. Nonostante la somiglianza nel nome con la regressione lineare, è un algoritmo di classificazione, non una stima. Mentre la regressione lineare prevede un valore continuo, la regressione logistica prevede la probabilità che i dati rientrino in una determinata categoria.

La regressione logistica è comune nella previsione dell'abbandono dei clienti, nella previsione del tempo e nella proiezione dei tassi di successo dei prodotti. Come la regressione lineare, è facile da implementare e addestrare ma è incline all'adattamento eccessivo e a difficoltà con relazioni complesse.

3. Alberi decisionali

Gli alberi decisionali sono un modello fondamentale che è possibile utilizzare per la classificazione e la regressione. Suddividono i dati in gruppi omogenei e continuano a segmentarli in ulteriori categorie.

Poiché gli alberi decisionali funzionano come diagrammi di flusso, sono ideali per processi decisionali complessi o per il rilevamento di anomalie. Nonostante la loro relativa semplicità, però, possono impiegare del tempo per allenarsi.

4. Ingenuo Bayes

Naive Bayes è un altro algoritmo di classificazione semplice ma efficace. Questi modelli operano sul Teorema di Bayes, che determina la probabilità condizionata — la probabilità di un risultato basato su eventi simili avvenuti in passato.

Questi modelli sono popolari nella classificazione basata su testo e immagini. Potrebbero essere troppo semplicistici per l'analisi predittiva del mondo reale, ma sono eccellenti in queste applicazioni e gestiscono bene set di dati di grandi dimensioni.

I data scientist dovrebbero anche comprendere i modelli di apprendimento non supervisionato di base. Questi sono alcuni dei più popolari di questa categoria meno comune ma comunque importante.

5. Cluster di mezzi K

Il clustering K-means è uno degli algoritmi di machine learning non supervisionati più popolari. Questi modelli classificano i dati raggruppandoli in cluster in base alle loro somiglianze.

Il clustering K-means è ideale per la segmentazione della clientela. Ciò lo rende prezioso per le aziende che desiderano perfezionare il marketing o accelerare l’onboarding riducendo i costi e i tassi di abbandono nel processo. È utile anche per il rilevamento di anomalie. Tuttavia, è essenziale standardizzare i dati prima di fornirli a questi algoritmi.

6. Foresta casuale

Come puoi intuire dal nome, le foreste casuali sono costituite da più alberi decisionali. L'addestramento di ciascun albero su dati randomizzati e il raggruppamento dei risultati consente a questi modelli di produrre risultati più affidabili.

Le foreste casuali sono più resistenti all’overfitting rispetto agli alberi decisionali e sono più precise nelle applicazioni del mondo reale. Questa affidabilità, tuttavia, ha un costo, poiché possono anche essere lenti e richiedere più risorse di elaborazione.

7. Scomposizione dei valori singolari

I modelli di decomposizione dei valori singolari (SVD) suddividono set di dati complessi in bit più facili da comprendere separandoli nelle loro parti fondamentali e rimuovendo le informazioni ridondanti.

La compressione delle immagini e la rimozione del rumore sono alcune delle applicazioni più popolari per SVD. Considerando come le dimensioni dei file continuano a crescere, questi casi d'uso diventeranno sempre più preziosi nel tempo. Tuttavia, la creazione e l’applicazione di questi modelli può essere complessa e dispendiosa in termini di tempo.

Questi sette algoritmi di apprendimento automatico non sono un elenco esaustivo di ciò che potresti utilizzare come scienziato dei dati. Tuttavia, sono alcuni dei tipi di modello più fondamentali. Comprenderli ti aiuterà a dare il via alla tua carriera nella scienza dei dati e renderà più facile comprendere altri algoritmi più complessi che si basano su queste basi.

aprile Miller è caporedattore di tecnologia di consumo presso Rehack Rivista. Ha una comprovata esperienza nella creazione di contenuti di qualità che indirizzano il traffico verso le pubblicazioni con cui lavoro.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

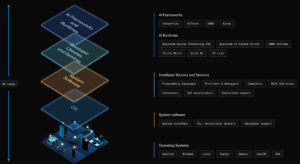

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://www.kdnuggets.com/7-machine-learning-algorithms-you-cant-miss?utm_source=rss&utm_medium=rss&utm_campaign=7-machine-learning-algorithms-you-cant-miss

- :ha

- :È

- :non

- 7

- a

- precisione

- preciso

- algoritmo

- Algoritmi

- anche

- an

- analitica

- ed

- rilevamento anomalie

- Un altro

- applicazioni

- AMMISSIONE

- SONO

- AS

- assume

- At

- basato

- basic

- Nozioni di base

- BE

- diventare

- prima

- MIGLIORE

- fra

- Rompere

- costruire

- Costruzione

- affari

- Applicazioni aziendali

- aziende

- ma

- by

- Materiale

- Career

- casi

- categoria

- Categoria

- Grafici

- classificazione

- classificare

- il clustering

- viene

- Uncommon

- Aziende

- complesso

- comprendere

- informatica

- considerando

- Consumer

- tecnologia di consumo

- contenuto

- continuo

- Costo

- Costi

- coprire

- Creazione

- cliente

- dati

- scienza dei dati

- scienziato di dati

- set di dati

- set di dati

- decisione

- Decision Making

- Nonostante

- rivelazione

- determina

- disparato

- distinto

- non

- unità

- ogni

- più facile

- facile

- editore

- Efficace

- essential

- Etere (ETH)

- Ogni

- eccellente

- esperto

- Caduta

- alimentazione

- campo

- flusso

- Nel

- da

- fondamentale

- ulteriormente

- dato

- Obiettivi

- Gruppo

- Crescita

- maniglia

- Avere

- Aiuto

- qui

- Come

- Tuttavia

- HTML

- HTTPS

- i

- ideale

- Immagine

- Classificazione delle immagini

- realizzare

- importante

- impossibile

- in

- sempre più

- informazioni

- ingresso

- ai miglioramenti

- Investopedia

- IT

- KDnuggets

- mantenere

- Genere

- Sapere

- grandi

- apprendimento

- meno

- Consente di

- piace

- probabilità

- Limitato

- Lista

- macchina

- machine learning

- rivista

- make

- FA

- gestire

- gestione

- molti

- Marketing

- Maggio..

- Soddisfare

- forza

- perdere

- ML

- Algoritmi ML

- modello

- modelli

- Scopri di più

- maggior parte

- Più popolare

- multiplo

- Nome

- esigenze

- Rumore

- of

- di frequente

- on

- Procedura di Onboarding

- ONE

- quelli

- operare

- or

- Altro

- Risultato

- risultati

- ancora

- Ricambi

- passato

- posto

- Platone

- Platone Data Intelligence

- PlatoneDati

- Popolare

- previsione

- predittiva

- Predictive Analytics

- predice

- preferire

- probabilità

- processi

- produrre

- Prodotto

- pubblicazioni

- qualità

- casuale

- Randomizzato

- mondo reale

- record

- raffinare

- regressione

- rapporto

- Relazioni

- parente

- relativamente

- rilevanza

- problemi di

- affidabile

- rimozione

- rimozione

- richiedere

- resistente

- Risorse

- Risultati

- destra

- Scenari

- Scienze

- Scienziato

- scienziati

- segmentazione

- separazione

- set

- Set

- Sette

- lei

- dovrebbero

- simile

- somiglianze

- Un'espansione

- semplicità

- singolare

- Dimensioni

- rallentare

- So

- alcuni

- velocità

- dividere

- inizia a

- Ancora

- lineare

- Lotte

- il successo

- apprendimento supervisionato

- T

- Fai

- task

- tecniche

- Tecnologia

- di

- che

- Il

- loro

- Li

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- questo

- quelli

- anche se?

- così

- tempo

- richiede tempo

- a

- pure

- pista

- traffico

- Treni

- Training

- albero

- Alberi

- seconda

- Tipi di

- capire

- e una comprensione reciproca

- apprendimento senza supervisione

- uso

- usa

- Prezioso

- APPREZZIAMO

- variando

- potenzialmente

- volere

- Tempo

- WELL

- Che

- mentre

- quale

- while

- volere

- con

- Lavora

- ancora

- Tu

- Trasferimento da aeroporto a Sharm

- zefiro