Immagine dell'editore

Siamo nel 2023, il che significa che la maggior parte delle aziende nella maggior parte dei settori sta raccogliendo informazioni e guidando decisioni più intelligenti con l'aiuto dei big data. Questo non è una sorpresa di questi tempi: la capacità di raccogliere, classificare e analizzare grandi insiemi di dati è immensamente utile quando si tratta di prendere decisioni aziendali basate sui dati.

E, poiché un numero crescente di organizzazioni abbraccia la digitalizzazione, la capacità di cogliere e fare affidamento sull'utilità dell'analisi dei dati continuerà a crescere.

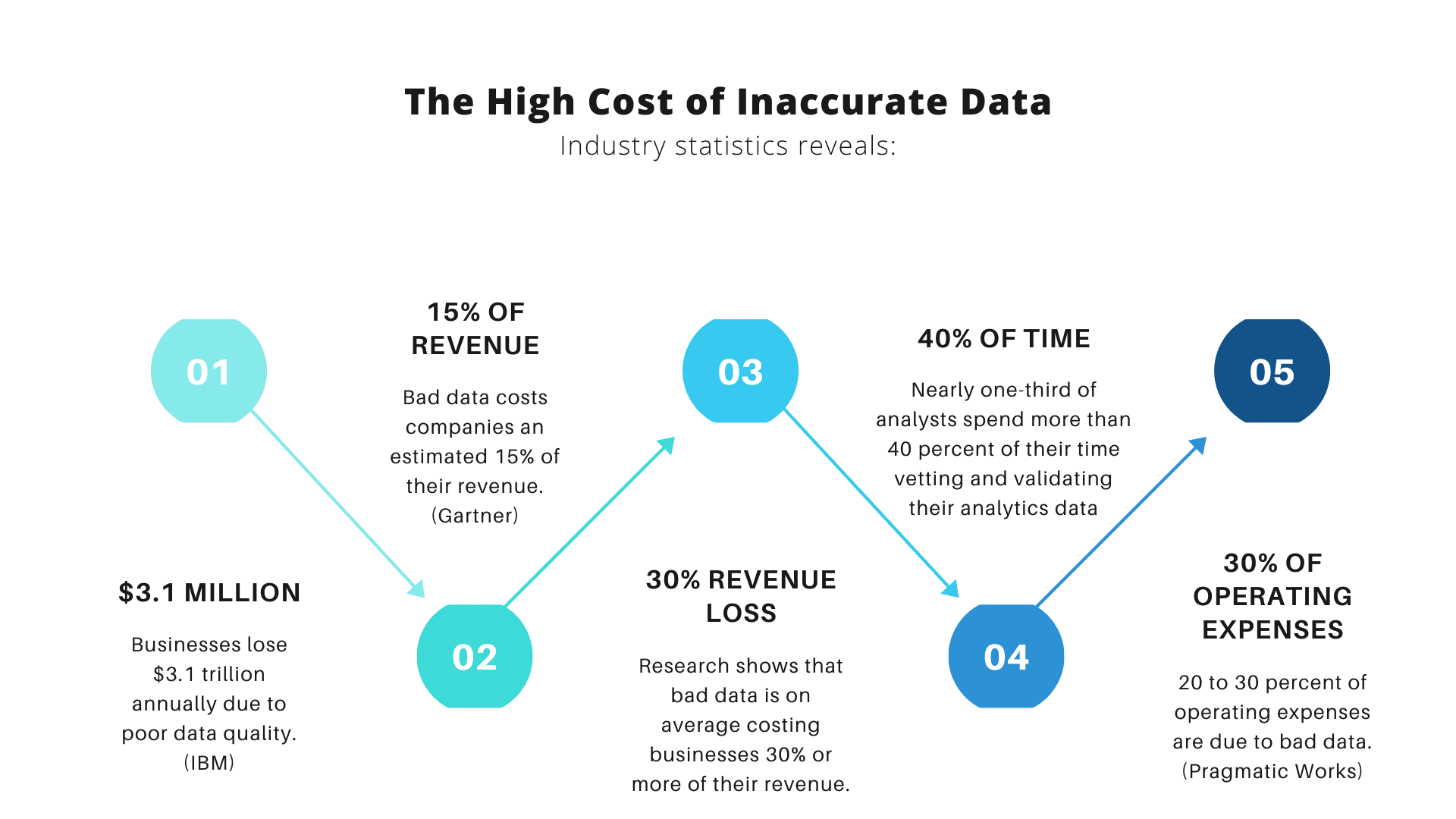

Ecco la cosa sui big data, però: man mano che più organizzazioni fanno affidamento su di essi, maggiore è la possibilità che più di loro utilizzino i big data in modo errato. Perché? Perché i big data e le informazioni che offrono sono utili solo se le organizzazioni analizzano accuratamente i propri dati.

Immagine da scala dati

A tal fine, assicuriamoci di evitare alcuni errori comuni che spesso influiscono sull'accuratezza dell'analisi dei dati. Continua a leggere per conoscere questi problemi e come evitarli.

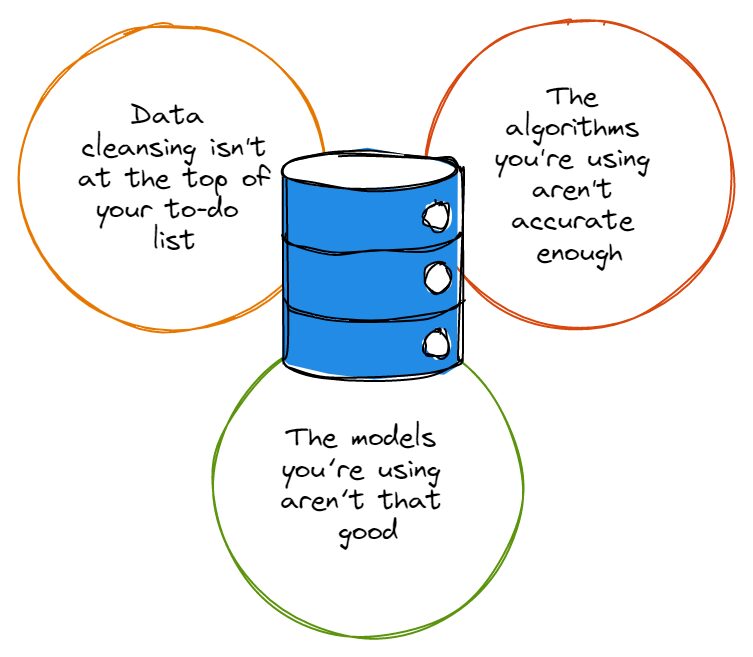

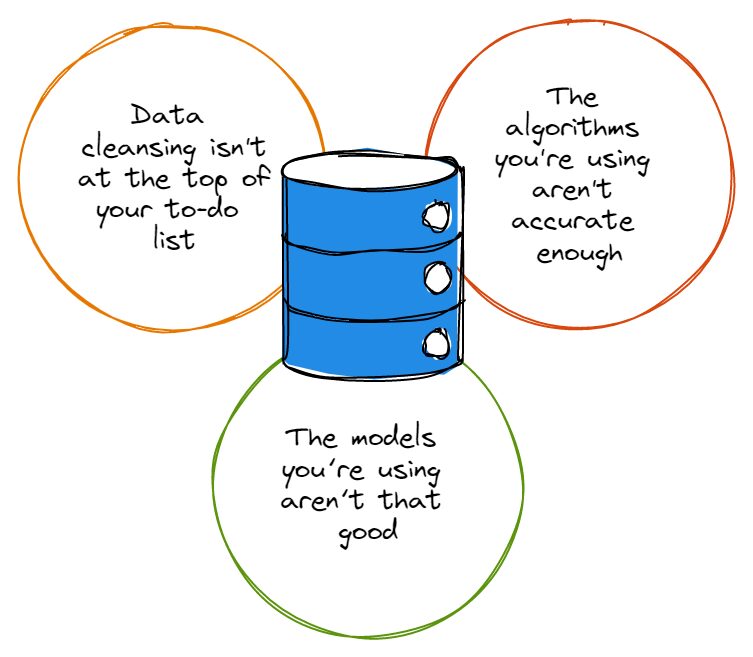

Prima di puntare il dito, dobbiamo ammettere che la maggior parte degli insiemi di dati ha una buona dose di errori e questi errori non fanno alcun favore a nessuno quando arriva il momento di analizzare i dati. Che si tratti di errori di battitura, strane convenzioni di denominazione o ridondanze, gli errori nei set di dati confondono l'accuratezza dell'analisi dei dati.

Quindi, prima che tu sia troppo entusiasta di immergerti in profondità nella tana del coniglio dell'analisi dei dati, devi prima assicurarti che la pulizia dei dati sia in cima all'elenco delle cose da fare e che tu stia sempre pulendo correttamente i tuoi set di dati. Potresti dire "ehi, la pulizia dei dati richiede troppo tempo perché me ne preoccupi", a cui annuiamo in segno di simpatia.

Fortunatamente per te, puoi investire in soluzioni come l'analisi aumentata. Ciò sfrutta gli algoritmi di apprendimento automatico per accelerare la velocità con cui esegui l'analisi dei dati (e migliora anche l'accuratezza dell'analisi).

In conclusione: indipendentemente dalla soluzione utilizzata per automatizzare e migliorare la pulizia dei dati, è comunque necessario eseguire la pulizia effettiva: in caso contrario, non si avranno mai le basi adeguate su cui basare un'analisi accurata dei dati.

Come nel caso dei set di dati, la maggior parte degli algoritmi non è perfetta al cento per cento; la maggior parte di loro ha la sua giusta dose di difetti e semplicemente non funziona come vorresti ogni volta che li usi. Gli algoritmi con una serie di imperfezioni possono persino ignorare i dati essenziali per la tua analisi, oppure possono concentrarsi sul tipo sbagliato di dati che in realtà non sono così importanti.

Non è un segreto che i più grandi nomi della tecnologia lo siano esaminando costantemente i loro algoritmi e modificandoli il più vicino possibile alla perfezione, ed è perché così pochi algoritmi sono effettivamente impeccabili. Più accurato è il tuo algoritmo, maggiore è la garanzia che i tuoi programmi stiano raggiungendo i loro obiettivi e facendo ciò di cui hai bisogno.

Inoltre, se la tua organizzazione impiega anche solo un paio di data scientist, dovrebbe assicurarsi che tali data scientist aggiornino regolarmente gli algoritmi che i loro programmi di analisi dei dati - potrebbe anche valere la pena stabilire un programma che ritenga i team responsabili del mantenimento e aggiornare i loro algoritmi di analisi dei dati seguendo un programma concordato.

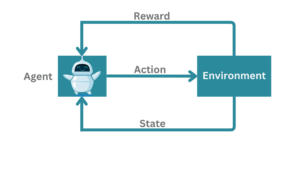

Ancora meglio di così potrebbe essere stabilire una strategia che sfrutta algoritmi basati su AI/ML, che dovrebbero essere in grado di aggiornarsi automaticamente.

Per lo più comprensibilmente, molti leader aziendali che non sono direttamente coinvolti con i loro team di analisi dei dati non si rendono conto che algoritmi e modelli non sono le stesse cose. Nel caso in cui TU non fossi a conoscenza, ricorda che gli algoritmi sono i metodi che utilizziamo per analizzare i dati; i modelli sono i calcoli che vengono creati sfruttando l'output di un algoritmo.

Gli algoritmi possono analizzare i dati per tutto il giorno, ma se il loro output non passa attraverso modelli progettati per controllare l'analisi successiva, non avrai informazioni utilizzabili o utili.

Pensala in questo modo: se hai algoritmi fantasiosi che sgretolano i dati ma non hai alcuna intuizione da mostrare per questo, non prenderai decisioni basate sui dati meglio di quanto lo fossi prima di avere quegli algoritmi; sarebbe come voler integrare la ricerca sugli utenti nella roadmap del prodotto, ma ignorando il fatto che, ad esempio, il settore delle ricerche di mercato generato $ 76.4 miliardi delle entrate nel 2021, con un aumento del 100% dal 2008.

Le tue intenzioni possono essere ammirevoli, ma devi utilizzare gli strumenti e le conoscenze moderni a tua disposizione per raccogliere tali intuizioni o integrare la ricerca degli utenti nella tua tabella di marcia al meglio delle tue capacità.

È un peccato che i modelli subottimali siano un modo infallibile per rovinare l'output dei tuoi algoritmi, non importa quanto siano sofisticati quegli algoritmi. È quindi essenziale che i dirigenti aziendali ei leader tecnici coinvolgano più da vicino i loro esperti di analisi dei dati per creare modelli che non siano né troppo complicati né troppo semplici.

Inoltre, a seconda della quantità di dati con cui lavorano, i leader aziendali possono scegliere di passare attraverso alcuni modelli diversi prima di stabilirsi su quello che meglio si adatta al volume e al tipo di dati che devono gestire.

Alla fine della giornata, se vuoi assicurarti che l'analisi dei tuoi dati non sia costantemente sbagliata, devi anche ricordarti di mai cadere vittima di pregiudizi. Il pregiudizio è purtroppo uno dei maggiori ostacoli da superare quando si tratta di mantenere l'accuratezza dell'analisi dei dati.

Indipendentemente dal fatto che influenzino il tipo di dati raccolti o influenzino il modo in cui i leader aziendali interpretano i dati, i pregiudizi sono vari e spesso difficili da definire: i dirigenti devono fare del loro meglio per identificare i propri pregiudizi e rinunciarvi per trarre vantaggio da accurata analisi dei dati.

I dati sono potenti: se gestiti correttamente, possono garantire ai leader aziendali e alle loro organizzazioni informazioni estremamente utili che possono trasformare il modo in cui sviluppano e distribuiscono i loro prodotti ai clienti. Assicurati solo di fare tutto ciò che è in tuo potere per assicurarti che le tue analisi dei dati siano accurate e non soffrano degli errori facilmente evitabili che abbiamo delineato in questo articolo.

Nahla Davis è uno sviluppatore di software e scrittore di tecnologia. Prima di dedicare il suo lavoro a tempo pieno alla scrittura tecnica, è riuscita, tra le altre cose intriganti, a servire come programmatore capo presso un'organizzazione di branding esperienziale Inc. 5,000 i cui clienti includono Samsung, Time Warner, Netflix e Sony.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- Platoblockchain. Web3 Metaverse Intelligence. Conoscenza amplificata. Accedi qui.

- Fonte: https://www.kdnuggets.com/2023/03/3-mistakes-could-affecting-accuracy-data-analytics.html?utm_source=rss&utm_medium=rss&utm_campaign=3-mistakes-that-could-be-affecting-the-accuracy-of-your-data-analytics

- :È

- 000

- 2021

- 2023

- a

- abilità

- capacità

- capace

- WRI

- accelerare

- realizzare

- precisione

- preciso

- con precisione

- effettivamente

- ammirevole

- ammettere

- influenzare

- che interessano

- algoritmo

- Algoritmi

- Tutti

- sempre

- tra

- .

- analitica

- analizzare

- l'analisi

- ed

- chiunque

- SONO

- articolo

- AS

- At

- aumentata

- automatizzare

- automaticamente

- disponibile

- evitando

- base

- BE

- perché

- diventa

- prima

- essendo

- beneficio

- MIGLIORE

- Meglio

- pregiudizio

- Big

- Big Data

- maggiore

- Maggiore

- Parte inferiore

- marchio

- costruire

- Mazzo

- affari

- aziende

- by

- Materiale

- Custodie

- possibilità

- dai un'occhiata

- Scegli

- clienti

- Chiudi

- strettamente

- Codecademy

- Raccolta

- Venire

- Uncommon

- complicato

- calcoli

- continua

- convenzioni

- potuto

- Coppia

- creare

- creato

- crisi

- Clienti

- dati

- analisi dei dati

- Dati Analytics

- set di dati

- data-driven

- giorno

- Giorni

- decisioni

- deep

- consegnare

- Dipendente

- progettato

- sviluppare

- Costruttori

- diverso

- difficile

- digitalizzazione

- direttamente

- fare

- giù

- guida

- facilmente

- o

- abbraccio

- impegnarsi

- impegnato

- garantire

- errori

- essential

- stabilire

- stabilire

- Anche

- Ogni

- qualunque cosa

- esempio

- eccitato

- dirigenti

- empirico

- esperti

- fiera

- Autunno

- favori

- pochi

- Nome

- difetti

- Focus

- i seguenti

- Nel

- Fondazione

- da

- pieno

- ottenere

- Go

- Obiettivi

- andando

- concedere

- afferrala

- maggiore

- maggiore

- Crescere

- Crescita

- di garanzia

- maniglia

- Avere

- teste

- Aiuto

- detiene

- Come

- HTML

- http

- HTTPS

- ostacoli

- identificare

- immensamente

- importante

- competenze

- migliora

- in

- Inc.

- includere

- in modo non corretto

- Aumento

- industrie

- industria

- influenzare

- intuizioni

- intenzioni

- Investire

- sicurezza

- IT

- jpg

- KDnuggets

- Genere

- conoscenze

- portare

- capi

- IMPARARE

- apprendimento

- leveraggi

- leveraging

- piace

- linea

- Lista

- Lunghi

- lotto

- macchina

- machine learning

- make

- Fare

- gestito

- Rappresentanza

- ricerche di mercato

- Importanza

- si intende

- metodi

- errori

- modelli

- moderno

- Scopri di più

- maggior parte

- nomi

- di denominazione

- Bisogno

- Nessuno dei due

- Netflix

- numero

- of

- Offerte

- on

- ONE

- minimo

- organizzazione

- organizzazioni

- Altro

- delineato

- produzione

- Superare

- per cento

- perfetta

- eseguire

- RICERCA PEW

- Platone

- Platone Data Intelligence

- PlatoneDati

- possibile

- energia

- potente

- Prodotto

- Prodotti

- Programmatore

- Programmi

- corretto

- propriamente

- Coniglio

- tasso

- RE

- Leggi

- rendersi conto

- regolarmente

- ricorda

- che rappresenta

- riparazioni

- Le vendite

- tabella di marcia

- s

- stesso

- Samsung

- programma

- scienziati

- Segreto

- servire

- Set

- risolvere

- Condividi

- dovrebbero

- mostrare attraverso le sue creazioni

- Un'espansione

- semplicemente

- da

- più intelligente

- So

- Software

- soluzione

- Soluzioni

- alcuni

- Sony

- sofisticato

- Ancora

- Strategia

- successivo

- tale

- sofferenza

- sorpresa

- le squadre

- Tech

- Consulenza

- che

- Il

- loro

- Li

- si

- perciò

- Strumenti Bowman per analizzare le seguenti finiture:

- cosa

- cose

- Attraverso

- tempo

- richiede tempo

- a

- pure

- strumenti

- top

- Trasformare

- tweaking

- Comprensibilmente

- sfortunato

- Aggiornanento

- Aggiornamenti

- aggiornamento

- utilizzabile

- uso

- Utente

- Ve

- Vittima

- volume

- volendo

- Ammonitore

- Modo..

- Che

- se

- quale

- OMS

- volere

- con

- Lavora

- lavoro

- utile

- scrittore

- scrittura

- Wrong

- Trasferimento da aeroporto a Sharm

- zefiro