Jay Dawani adalah salah satu pendiri dan CEO di Lab Lemuria, sebuah startup yang mengembangkan platform komputasi terakselerasi yang dirancang khusus untuk aplikasi AI. Platform ini mendobrak hambatan perangkat keras untuk menjadikan pengembangan AI lebih cepat, lebih murah, lebih berkelanjutan, dan dapat diakses oleh lebih dari beberapa perusahaan.

Sebelum mendirikan Lemurian, Jay mendirikan dua perusahaan lain di bidang AI. Dia juga penulis “Matematika untuk Pembelajaran Mendalam. "

Seorang ahli di bidang kecerdasan buatan, robotika, dan matematika, Jay pernah menjabat sebagai CTO BlocPlay, sebuah perusahaan publik yang membangun platform game berbasis blockchain, dan menjabat sebagai Direktur AI di GEC, di mana ia memimpin pengembangan beberapa proyek klien yang mencakup berbagai bidang. mulai dari ritel, perdagangan algoritmik, pelipatan protein, robot untuk eksplorasi ruang angkasa, sistem rekomendasi, dan banyak lagi. Di waktu luangnya, ia juga pernah menjadi penasihat di NASA Frontier Development Lab, Spacebit dan SiaClassic.

Terakhir kali kami menampilkan Lemurian Labs, Anda berfokus pada robotika dan edge AI. Sekarang Anda fokus pada pusat data dan infrastruktur cloud. Hal apa yang membuat Anda ingin melakukan pivot?

Memang benar, kami melakukan transisi dari berfokus pada membangun kinerja tinggi, latensi rendah, sistem-on-chip untuk aplikasi robotika otonom yang dapat mempercepat keseluruhan siklus rencana-tindakan menjadi membangun akselerator khusus domain untuk AI yang berfokus pada aplikasi skala pusat data. . Tapi itu bukan sekadar poros biasa; itu adalah panggilan yang jelas dan kami merasa memiliki tanggung jawab untuk menjawabnya.

Pada tahun 2018, kami berupaya melatih model parameter senilai $2.1 miliar, namun kami mengabaikan upaya tersebut karena biayanya sangat tinggi sehingga kami tidak dapat membenarkannya. Jadi bayangkan betapa terkejutnya saya bahwa GPT3, yang dirilis OpenAI sebagai ChatGPT pada November 2022, adalah model parameter senilai $175 miliar. Model ini 80X lebih besar dibandingkan model yang kami kerjakan 4 tahun sebelumnya, dan hal ini menarik sekaligus menakutkan.

Biaya pelatihan model seperti itu sangat mencengangkan. Berdasarkan tren penskalaan saat ini, biaya pelatihan model AI frontier diperkirakan akan melebihi satu miliar dolar dalam waktu dekat. Meskipun kemampuan model ini luar biasa, biayanya sangat tinggi. Berdasarkan kondisi ini, hanya segelintir perusahaan dengan sumber daya yang baik dan memiliki pusat data sendiri yang mampu melatih, menerapkan, dan menyempurnakan model-model ini. Hal ini bukan semata-mata karena komputasi itu mahal dan haus daya, namun juga karena tumpukan perangkat lunak yang kita andalkan tidak dibuat untuk dunia ini.

Karena keterbatasan geografis dan energi, hanya ada sedikit tempat untuk membangun pusat data. Untuk memenuhi kebutuhan komputasi AI, kita harus mampu membuat mesin skala zetta tanpa memerlukan 20 reaktor nuklir untuk menggerakkannya. Kita memerlukan solusi yang lebih praktis, terukur, dan ekonomis. Kami melihat sekeliling dan tidak melihat siapa pun yang bisa menyelesaikan masalah ini. Jadi, kami mulai melihat masalah secara holistik sebagai sistem dari sistem dan memikirkan solusi dari prinsip pertama. Kami bertanya pada diri sendiri, bagaimana kami merancang keseluruhan tumpukan, dari perangkat lunak hingga perangkat keras, jika kami harus melayani 10 miliar kueri LLM secara ekonomis setiap hari. Kami telah menargetkan mesin zettascale dengan daya kurang dari 200 MW pada tahun 2028.

Triknya adalah dengan melihatnya dari sudut pandang penskalaan yang tidak sepadan – bagian-bagian sistem yang berbeda mengikuti aturan penskalaan yang berbeda, sehingga pada titik tertentu segala sesuatunya akan berhenti berjalan, mulai rusak, atau pertukaran manfaat biaya tidak lagi masuk akal. Jika hal ini terjadi, satu-satunya pilihan adalah mendesain ulang sistem. Penilaian dan solusi kami meliputi beban kerja, sistem bilangan, model pemrograman, compiler, runtime dan perangkat keras secara holistik.

Syukurlah, investor kami yang ada dan seluruh pasar melihat visi tersebut, dan kami mengumpulkan dana awal sebesar $9 juta untuk mengembangkan format angka kami – PAL, untuk mengeksplorasi ruang desain dan menyatukan arsitektur untuk akselerator khusus domain kami, dan merancang arsitektur kami kompiler dan waktu proses. Dalam simulasi, kami mampu mencapai perolehan throughput 20X lipat dengan jejak energi yang lebih kecil dibandingkan GPU modern, dan diproyeksikan mampu memberikan manfaat 8X lipat dalam performa sistem dibandingkan total biaya kepemilikan pada teknologi transistor yang sama.

Tentu saja, masih banyak pekerjaan yang harus kita lakukan, namun kami sangat gembira dengan prospek untuk dapat mendefinisikan kembali ekonomi pusat data untuk memastikan masa depan di mana AI tersedia secara melimpah bagi semua orang.

Kedengarannya menarik dan angka-angka tersebut terdengar mengesankan. Namun Anda telah menyebutkan sistem angka, perangkat keras, kompiler, dan waktu proses sebagai semua hal yang menjadi fokus Anda – sepertinya banyak hal yang harus dilakukan oleh perusahaan mana pun sekaligus. Tampaknya ini merupakan proposisi yang sangat berisiko. Bukankah startup seharusnya lebih fokus?

Kedengarannya seperti banyak upaya yang berbeda, namun sebenarnya merupakan satu upaya dengan banyak bagian yang saling berhubungan. Menyelesaikan salah satu komponen secara terpisah hanya akan menghambat potensi inovasi karena akan mengabaikan inefisiensi dan hambatan yang bersifat sistemis. Jensen Huang mengatakan yang terbaik, “Untuk menjadi perusahaan komputasi yang dipercepat, Anda harus menjadi perusahaan yang lengkap”, dan saya sepenuhnya setuju. Mereka adalah pemimpin pasar saat ini karena suatu alasan. Namun saya akan menantang anggapan bahwa kita tidak fokus. Fokus kami terletak pada cara kami memikirkan masalah secara holistik dan cara terbaik menyelesaikannya bagi pelanggan kami.

Untuk melakukan hal tersebut diperlukan pendekatan multidisiplin seperti yang kami lakukan. Setiap bagian dari pekerjaan kami memberi informasi dan mendukung bagian lain, sehingga memungkinkan kami menciptakan solusi yang lebih dari sekadar gabungan bagian-bagiannya. Bayangkan jika Anda harus membuat mobil balap. Anda tidak akan sembarangan memilih sasis, menambahkan ban balap, dan menggunakan mesin paling bertenaga yang bisa Anda temukan dan membalapnya, bukan? Anda akan memikirkan tentang aerodinamis bodi mobil untuk mengurangi hambatan dan meningkatkan downforce, mengoptimalkan distribusi bobot untuk penanganan yang baik, mendesain mesin secara khusus untuk performa maksimal, mendapatkan sistem pendingin untuk mencegah panas berlebih, spesifikasi roll cage untuk menjaga keselamatan pengemudi. , dll. Masing-masing elemen ini membangun dan menginformasikan elemen lainnya.

Meskipun demikian, berisiko untuk mencoba dan melakukan semuanya sekaligus bagi perusahaan mana pun di industri mana pun. Untuk mengelola risiko, kami mengambil pendekatan bertahap, yang memungkinkan kami memvalidasi teknologi kami dengan pelanggan dan menyesuaikan strategi sesuai kebutuhan. Kami telah membuktikan bahwa format angka kami berfungsi dan memiliki area kinerja daya yang lebih baik daripada jenis floating point yang setara, sekaligus memiliki properti numerik yang lebih baik yang memudahkan kuantisasi jaringan saraf ke lebar bit yang lebih kecil. Kami telah merancang arsitektur yang kami yakini, dan cocok untuk pelatihan dan inferensi. Namun yang lebih penting dari semua itu adalah membuat perangkat lunaknya benar, dan itu adalah fokus utama kami. Kita perlu memastikan bahwa kita membuat keputusan yang tepat dalam tumpukan perangkat lunak kita dalam kondisi dunia satu atau dua tahun atau lebih dari sekarang.

Membangun perusahaan perangkat keras itu sulit, mahal, dan memakan waktu lama. Fokus pada perangkat lunak pada awalnya terdengar seperti bisnis yang sangat layak, dan berpotensi lebih menarik bagi investor dalam kondisi saat ini. Mengapa Anda juga melakukan bisnis perangkat keras mengingat begitu banyak perusahaan yang memiliki pendanaan besar menutup usahanya, kesulitan untuk mendapatkan adopsi dari pelanggan, dan pemain besar sedang membangun perangkat keras mereka sendiri?

Anda benar sekali bahwa bisnis perangkat lunak pada umumnya mampu meningkatkan modal jauh lebih mudah dibandingkan perusahaan perangkat keras, dan perangkat keras itu sangat sulit. Fokus kami saat ini adalah pada perangkat lunak karena di situlah kami melihat masalah yang lebih besar. Biar saya perjelas, masalahnya bukan pada apakah saya bisa menjalankan kernel pada CPU atau GPU dengan kinerja tinggi; itu masalah yang sudah lama terpecahkan. Permasalahan saat ini adalah bagaimana kita mempermudah pengembang untuk mendapatkan kinerja lebih, secara produktif dari beberapa ribu cluster node yang terdiri dari komputasi heterogen tanpa meminta mereka merombak alur kerja mereka.

Masalah itulah yang saat ini kami fokuskan untuk diselesaikan dengan tumpukan perangkat lunak yang memberi pengembang kekuatan super dan membuka kemampuan penuh komputer skala gudang, sehingga kami dapat melatih dan menerapkan model AI secara lebih ekonomis.

Terkait investasi, ya, VC lebih selektif dalam menentukan jenis perusahaan yang mereka dukung, namun hal ini juga berarti VC sedang mencari perusahaan yang berpotensi menawarkan produk-produk inovatif yang memiliki jalur jelas menuju komersialisasi dan memiliki dampak yang signifikan. Kami telah belajar dari tantangan dan kesalahan pihak lain dan secara aktif merancang model bisnis dan peta jalan kami untuk mengatasi risiko. Penting juga untuk diingat bahwa apa yang membuat startup sukses bukanlah seberapa mudahnya mereka mengumpulkan dana dari VC, namun lebih berkaitan dengan kecerdikan, kegigihan, dan fokus mereka pada pelanggan.

Dan sebelum Anda bertanya, kami masih mengerjakan perangkat keras, tetapi saat ini terutama dalam simulasi. Kami tidak bermaksud untuk merekamnya untuk sementara waktu. Tapi kita bisa menyimpan percakapan itu untuk lain waktu.

Hal ini tentu menarik dan pendekatan bertahap Anda sangat berbeda dibandingkan dengan apa yang telah kita lihat dilakukan oleh perusahaan perangkat keras lainnya. Saya memahami masalah yang Anda katakan akan diatasi oleh tumpukan perangkat lunak Anda, tetapi bagaimana perangkat lunak Anda membedakannya dari berbagai upaya di pasar?

Sebagian besar perusahaan yang Anda maksud berfokus untuk mempermudah pemrograman GPU dengan memperkenalkan model pemrograman berbasis ubin atau pemetaan tugas untuk mendapatkan kinerja lebih dari GPU, atau membangun bahasa pemrograman baru untuk mendapatkan kernel berkinerja tinggi yang dijadwalkan pada berbagai perangkat. platform dengan dukungan untuk perakitan in-line. Itu adalah masalah penting yang mereka atasi, namun kami melihat masalah yang kami selesaikan hampir bersifat ortogonal.

Mari kita berpikir sejenak tentang irama transisi perangkat keras dan perangkat lunak. Arsitektur inti tunggal memperoleh kinerja dari kecepatan clock dan kepadatan transistor, tetapi pada akhirnya kecepatan clock mencapai titik tertinggi. Paralelisme yang menggunakan banyak inti menghindari hal ini dan memberikan percepatan yang cukup besar. Perangkat lunak membutuhkan waktu sekitar satu dekade untuk mengejar ketertinggalannya, karena model pemrograman, compiler, dan runtime harus dipikirkan ulang untuk membantu pengembang mengambil manfaat dari paradigma ini. Kemudian, GPU mulai menjadi akselerator serba guna, lagi-lagi dengan model pemrograman yang berbeda. Sekali lagi, dibutuhkan waktu hampir satu dekade bagi pengembang untuk mendapatkan nilai di sini.

Sekali lagi, perangkat keras mencapai puncaknya – hukum Moore, kendala energi dan termal, kemacetan memori, dan keragaman beban kerja ditambah kebutuhan komputasi yang lebih banyak secara eksponensial mendorong kita untuk membangun arsitektur komputer yang semakin heterogen untuk kinerja, efisiensi, dan total biaya yang lebih baik. Pergeseran perangkat keras ini tentu saja akan menciptakan tantangan bagi perangkat lunak karena kita tidak memiliki compiler dan runtime yang tepat untuk mendukung evolusi komputasi berikutnya. Namun saat ini, kita tidak perlu menunggu 10 tahun lagi agar perangkat lunak dapat mengekstraksi nilai arsitektur heterogen atau cluster besar, terutama ketika 80% dari arsitektur tersebut tidak dimanfaatkan.

Apa yang kami fokuskan adalah membangun model pemrograman yang sadar heterogenitas dengan paralelisme berbasis tugas, menangani kinerja portabel dengan optimalisasi lintas prosesor, kompilasi sadar konteks, dan alokasi sumber daya dinamis. Dan bagi kami, tidak masalah apakah itu CPU, GPU, TPU, SPU (arsitektur Lemurian) atau gabungan dari semuanya. Saya tahu kedengarannya seperti kata-kata mewah, tapi apa yang sebenarnya dikatakan adalah bahwa kami telah memungkinkan untuk memprogram segala jenis prosesor dengan satu pendekatan, dan kami dapat mem-porting kode dari satu jenis prosesor ke prosesor lainnya dengan minimal. upaya tanpa perlu mengorbankan kinerja, dan menjadwalkan pekerjaan secara adaptif dan dinamis di seluruh node.

Jika apa yang Anda katakan itu benar, Anda mungkin akan mendefinisikan ulang komputasi sepenuhnya. Mari kita bicara tentang pendanaan. Anda mengumpulkan dana awal sebesar $9 juta tahun lalu yang menandakan dukungan investor yang kuat dan keyakinan terhadap visi Anda. Apa yang telah kamu lakukan sejak itu?

Selama setahun terakhir, dengan dukungan dana awal, kami telah mencapai kemajuan yang signifikan. Dengan tim kami yang kini beranggotakan 20 orang, kami dengan cermat mengatasi tantangan, berinteraksi dengan pelanggan, dan menyempurnakan pendekatan kami.

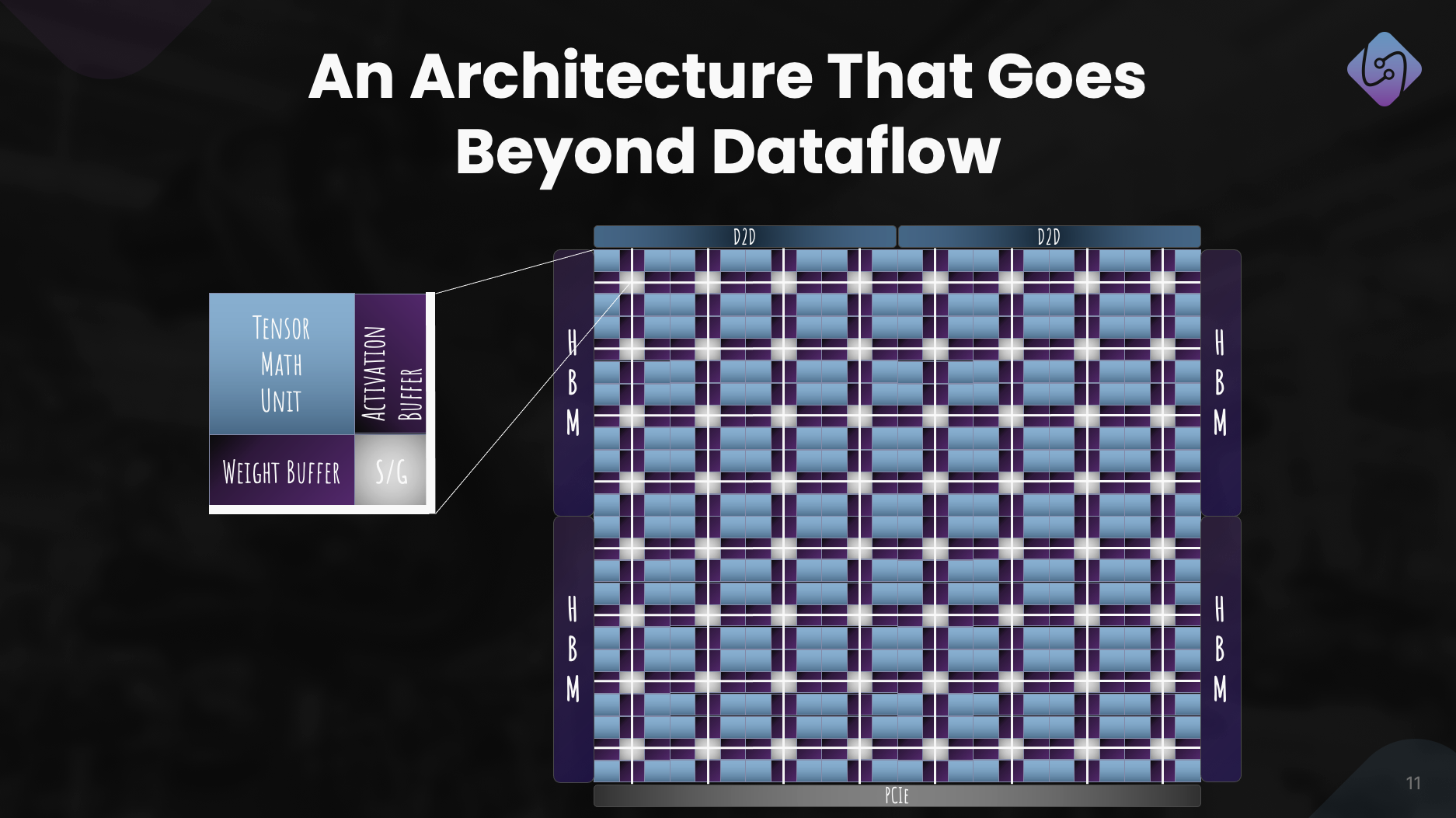

Kami fokus pada peningkatan PAL untuk pelatihan dan inferensi, menjelajahi arsitektur komputer untuk akselerator kami, dan mengembangkan simulator untuk metrik kinerja. Secara bersamaan, kami menata ulang tumpukan perangkat lunak kami untuk aplikasi pusat data, dengan menekankan komputasi heterogen.

Upaya ini menghasilkan arsitektur yang terdefinisi dengan baik, yang menunjukkan kemanjuran PAL dalam AI dalam skala besar. Selain kemajuan teknologi, kami juga melakukan kolaborasi dan penjangkauan untuk mendemokratisasi akses. Upaya ini memposisikan Lemurian Labs untuk mengatasi tantangan langsung pelanggan, bersiap untuk merilis silikon produksi kami.

Apa rencana jangka menengah Lemurian Labs terkait pengembangan tumpukan perangkat lunak, kolaborasi, dan peningkatan arsitektur akselerator?

Sasaran langsung kami adalah menciptakan rangkaian perangkat lunak yang menargetkan CPU, GPU, dan akselerator AI kami dengan kinerja portabel, yang akan tersedia bagi mitra awal pada akhir tahun. Saat ini kami sedang berdiskusi dengan sebagian besar perusahaan semikonduktor, penyedia layanan cloud, hyperscaler, dan perusahaan AI terkemuka untuk memberi mereka akses ke compiler dan runtime kami. Secara paralel, kami terus mengerjakan dan meningkatkan arsitektur akselerator kami untuk sistem perangkat keras dan perangkat lunak yang benar-benar dirancang bersama. Dan tentu saja, kami baru saja mulai meningkatkan seri A kami dengan minat yang sangat kuat dari komunitas investor, yang akan memungkinkan kami mengembangkan tim dan memenuhi target pengiriman produk perangkat lunak di akhir tahun.

Sebagai penutup, bagaimana Anda melihat Lemurian Labs berkontribusi dalam mengubah lanskap pengembangan, aksesibilitas, dan kesetaraan AI di tahun-tahun mendatang?

Kami tidak bermaksud mendefinisikan ulang komputasi hanya untuk keuntungan komersial atau kesenangan. Sebagai orang Lemurian, kekuatan pendorong kami adalah kami percaya pada potensi transformatif AI dan bahwa lebih dari beberapa perusahaan harus memiliki sumber daya untuk menentukan masa depan teknologi ini dan cara kami menggunakannya. Kami juga merasa tidak dapat menerima bahwa infrastruktur pusat data untuk AI akan mengkonsumsi sebanyak 20% energi dunia pada tahun 2030. Kami semua bersatu karena kami yakin ada jalan ke depan yang lebih baik bagi masyarakat jika kami dapat mewujudkannya. AI lebih mudah diakses dengan menurunkan biaya terkait secara signifikan, mempercepat laju inovasi AI, dan memperluas dampaknya. Dengan mengatasi tantangan infrastruktur perangkat keras saat ini, kami berupaya membuka jalan untuk memberdayakan satu miliar orang dengan kemampuan AI, dan memastikan distribusi yang adil dari teknologi canggih ini. Kami berharap komitmen kami terhadap solusi yang berfokus pada produk, kolaborasi, dan inovasi berkelanjutan menempatkan kami sebagai kekuatan pendorong dalam membentuk masa depan pengembangan AI menjadi masa depan yang positif.

Baca Juga:

Bagikan postingan ini melalui:

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://semiwiki.com/ceo-interviews/341485-ceo-interview-jay-dawani-of-lemurian-labs-2/

- :memiliki

- :adalah

- :bukan

- :Di mana

- $ 9 juta

- $NAIK

- 1

- 10

- 20

- 2018

- 2022

- 2028

- 2030

- 20x

- 300

- 4

- a

- Sanggup

- Tentang Kami

- benar

- mempercepat

- dipercepat

- akselerator

- akselerator

- diterima

- mengakses

- aksesibilitas

- dapat diakses

- Mencapai

- di seluruh

- aktif

- menambahkan

- alamat

- dialamatkan

- menangani

- menyesuaikan

- Adopsi

- maju

- Teknologi Terkini

- kemajuan

- penasihat

- lagi

- di depan

- AI

- Model AI

- algoritmik

- perdagangan algoritmik

- Semua

- alokasi

- Membiarkan

- hampir

- juga

- Amazon

- an

- dan

- Lain

- menjawab

- Apa pun

- siapapun

- menarik

- aplikasi

- pendekatan

- sewenang-wenang

- arsitektur

- arsitektur

- ADALAH

- daerah

- sekitar

- buatan

- kecerdasan buatan

- AS

- meminta

- meminta

- Majelis

- penilaian

- terkait

- mencengangkan

- At

- penulis

- otonom

- tersedia

- kembali

- hambatan

- berdasarkan

- BE

- karena

- menjadi

- menjadi

- sebelum

- makhluk

- keyakinan

- Percaya

- manfaat

- TERBAIK

- Lebih baik

- Luar

- lebih besar

- Milyar

- berbasis blockchain

- papan

- tubuh

- kedua

- kemacetan

- Melanggar

- istirahat

- memperluas

- membangun

- Bangunan

- membangun

- dibangun di

- jumlah besar

- bisnis

- model bisnis

- bisnis

- tapi

- by

- Irama

- panggilan

- datang

- CAN

- Bisa Dapatkan

- kemampuan

- kemampuan

- modal

- gulat

- pusat

- ceo

- Wawancara CEO

- Pasti

- menantang

- tantangan

- mengubah

- casis

- ChatGPT

- murah

- jelas

- klien

- Iklim

- Clock

- penutupan

- awan

- infrastruktur cloud

- Co-founder

- kode

- kolaborasi

- Kolaborasi

- kedatangan

- komersial

- komersialisasi

- komitmen

- masyarakat

- Perusahaan

- perusahaan

- dibandingkan

- menarik

- penyusun

- sama sekali

- komponen

- menghitung

- komputer

- komputer

- komputasi

- yakin

- kendala

- memakan

- terus

- kontinu

- berkontribusi

- bertemu

- Percakapan

- percakapan

- sistem pendingin

- benar

- Biaya

- bisa

- Tentu saja

- penutup

- CPU

- membuat

- Cross

- CTO

- terbaru

- Sekarang

- adat

- desain khusus

- pelanggan

- pelanggan

- data

- Data Center

- Datacenter

- hari

- dasawarsa

- keputusan

- mendalam

- menetapkan

- menyampaikan

- pengiriman

- tuntutan

- mendemokrasikan

- kepadatan

- menyebarkan

- Mendesain

- dirancang

- mengembangkan

- dikembangkan

- pengembang

- berkembang

- Pengembangan

- MELAKUKAN

- berbeda

- membedakan

- Kepala

- Jauh

- distribusi

- Keragaman

- do

- tidak

- Tidak

- melakukan

- dolar

- domain

- dilakukan

- Dont

- pintu

- secara dramatis

- gambar

- pengemudi

- penggerak

- Menjatuhkan

- dinamis

- dinamis

- setiap

- Terdahulu

- Awal

- mudah

- mudah

- secara ekonomis

- Ekonomi

- Tepi

- kemanjuran

- efisiensi

- usaha

- upaya

- elemen

- menekankan

- memberdayakan

- aktif

- memungkinkan

- meliputi

- akhir

- energi

- bertunangan

- Mesin

- mempertinggi

- meningkatkan

- memastikan

- memastikan

- Seluruh

- adil

- keadilan

- Setara

- terutama

- dll

- akhirnya

- semua orang

- evolusi

- melebihi

- gembira

- menarik

- ada

- mengharapkan

- mahal

- ahli

- eksplorasi

- menyelidiki

- Dieksplorasi

- eksponensial

- ekstrak

- luar biasa

- fakta

- indah

- jauh

- lebih cepat

- fitur

- merasa

- kesalahan

- beberapa

- Menemukan

- Pertama

- mengambang

- Fokus

- terfokus

- berfokus

- mengikuti

- Tapak

- Untuk

- kekuatan

- format

- Depan

- Didirikan di

- pembinaan

- dari

- perbatasan

- didorong

- penuh

- Tumpukan Penuh

- sepenuhnya

- kesenangan

- pendanaan

- masa depan

- Masa depan AI

- Mendapatkan

- diperoleh

- game

- platform game

- persneling

- Umum

- umumnya

- geografis

- mendapatkan

- mendapatkan

- Memberikan

- diberikan

- memberikan

- tujuan

- akan

- baik

- mendapat

- GPU

- GPU

- groundbreaking

- Tumbuh

- memiliki

- segenggam

- Penanganan

- terjadi

- Terjadi

- Perangkat keras

- Memiliki

- memiliki

- he

- membantu

- di sini

- High

- menghalangi

- -nya

- Memukul

- memukul

- berharap

- Seterpercayaapakah Olymp Trade? Kesimpulan

- How To

- HTTPS

- huang

- Lapar

- i

- if

- membayangkan

- Segera

- Dampak

- penting

- impresif

- memperbaiki

- perbaikan

- in

- makin

- industri

- ketidakefisienan

- menginformasikan

- Infrastruktur

- Innovation

- Intelijen

- berniat

- saling berhubungan

- bunga

- Wawancara

- memperkenalkan

- investasi

- investor

- Investor

- isolasi

- IT

- NYA

- jensen huang

- jpg

- hanya

- Menjaga

- Jenis

- Tahu

- laboratorium

- Labs

- pemandangan

- Bahasa

- besar

- lebih besar

- Terakhir

- Tahun lalu

- Latensi

- Hukum

- pemimpin

- terkemuka

- belajar

- paling sedikit

- Dipimpin

- membiarkan

- 'like'

- ll

- lm

- Panjang

- lama

- lagi

- melihat

- tampak

- mencari

- Lot

- Rendah

- penurunan

- mesin

- Mesin

- terbuat

- membuat

- MEMBUAT

- Membuat

- mengelola

- banyak

- Pasar

- Pemimpin pasar

- matematika

- hal

- max-width

- maksimum

- Mungkin..

- me

- cara

- Pelajari

- Anggota

- Memori

- tersebut

- hanya

- jala

- dengan cermat

- Metrik

- juta

- minimal

- kesalahan

- model

- model

- modern

- saat

- lebih

- paling

- banyak

- multidisiplin

- my

- NASA

- Perlu

- dibutuhkan

- membutuhkan

- jaringan

- saraf

- jaringan saraf

- New

- berikutnya

- tidak

- simpul

- node

- mencatat

- Gagasan

- November

- sekarang

- nuklir

- jumlah

- nomor

- of

- menawarkan

- on

- sekali

- ONE

- hanya

- OpenAI

- optimisasi

- Optimize

- pilihan

- or

- urutan

- biasa

- Lainnya

- Lainnya

- kami

- diri

- di luar

- penjangkauan

- lebih

- Pemeriksaan

- sendiri

- kepemilikan

- Perdamaian

- pola pikir

- Paralel

- parameter

- bagian

- rekan

- bagian

- lalu

- path

- mengaspal

- Konsultan Ahli

- prestasi

- Bertahap

- memilih

- Poros

- Tempat

- rencana

- Platform

- Platform

- plato

- Kecerdasan Data Plato

- Data Plato

- plus

- Titik

- Sudut pandang

- portabel

- posisi

- posisi

- positif

- mungkin

- Pos

- potensi

- berpotensi

- kekuasaan

- kuat

- Praktis

- cukup

- mencegah

- terutama

- prinsip-prinsip

- Masalah

- masalah

- pengolahan

- Prosesor

- Produk

- Produksi

- Produk

- program

- Pemrograman

- bahasa pemrograman

- memprojeksikan

- properties

- dalil

- prospek

- Protein

- terbukti

- disediakan

- penyedia

- publik

- murni

- tujuan

- Mendorong

- query

- Ras

- balap

- menaikkan

- menonjol

- pemeliharaan

- jarang

- Baca

- benar-benar

- alasan

- Rekomendasi

- mendefinisikan kembali

- mendesain ulang

- menurunkan

- merujuk

- halus

- mengenai

- konsep ulang

- melepaskan

- dirilis

- mengandalkan

- membutuhkan

- sumber

- Sumber

- tanggung jawab

- ISTIRAHAT

- mengakibatkan

- Hasil

- eceran

- benar

- risiko

- berisiko

- peta jalan

- robotika

- robot

- Menggulung

- kira-kira

- bulat

- aturan

- berjalan

- mengorbankan

- aman

- Tersebut

- sama

- Save

- mengatakan

- mengatakan

- terukur

- Skala

- skala

- menjadwalkan

- dijadwalkan

- melihat

- benih

- Pendanaan awal

- Putaran Benih

- Mencari

- tampaknya

- terlihat

- selektif

- semikonduktor

- rasa

- Seri

- Seri A

- melayani

- yang telah dilayani

- layanan

- penyedia jasa

- set

- beberapa

- membentuk

- bergeser

- harus

- menampilkan

- Pemandangan

- penting

- menandakan

- Silikon

- simulasi

- simulasi

- simulator

- serentak

- sejak

- tunggal

- cukup besar

- Meluncur

- lebih kecil

- So

- Masyarakat

- Perangkat lunak

- larutan

- Solusi

- MEMECAHKAN

- dipecahkan

- Memecahkan

- beberapa

- Suara

- suara

- Space

- eksplorasi ruang angkasa

- spasial

- tertentu

- Secara khusus

- kecepatan

- kecepatan

- tumpukan

- Tumpukan

- mengejutkan

- awal

- mulai

- startup

- Startups

- Masih

- berhenti

- Penyelarasan

- langkah

- kuat

- Berjuang

- sukses

- seperti itu

- cocok

- jumlah

- mendukung

- Mendukung

- Seharusnya

- mengherankan

- berkelanjutan

- sistem

- sistemik

- sistem

- disesuaikan

- Mengambil

- Dibutuhkan

- pengambilan

- Berbicara

- tape

- target

- target

- tim

- tech

- Teknologi

- dari

- bahwa

- Grafik

- Masa depan

- Pemandangan

- Dunia

- mereka

- Mereka

- kemudian

- Sana.

- panas

- Ini

- mereka

- hal

- berpikir

- ini

- itu

- meskipun?

- ribu

- Melalui

- keluaran

- waktu

- ban

- untuk

- hari ini

- bersama

- terlalu

- mengambil

- Total

- sulit

- terhadap

- jalur

- Trading

- Pelatihan VE

- Pelatihan

- lintasan

- transformatif

- transisi

- transisi

- Tren

- trik

- benar

- benar-benar

- mencoba

- dua

- jenis

- bawah

- memahami

- satuan

- membuka kunci

- atas

- us

- menggunakan

- menggunakan

- MENGESAHKAN

- nilai

- berbagai

- VC

- Pendanaan VC

- VCs

- sangat

- melalui

- giat

- View

- penglihatan

- menunggu

- ingin

- Gudang

- adalah

- we

- berat

- BAIK

- terdefinisi dengan baik

- pergi

- adalah

- Apa

- ketika

- apakah

- yang

- sementara

- mengapa

- akan

- dengan

- tanpa

- kata

- Kerja

- alur kerja

- kerja

- bekerja

- dunia

- dunia

- akan

- tahun

- tahun

- iya nih

- kamu

- Anda

- zephyrnet.dll