Meta telah merilis model pembelajaran mesin terbuka lainnya, kali ini disesuaikan untuk menghasilkan kode sumber perangkat lunak.

Kode Lama adalah keluarga model bahasa besar – oleh karena itu kadang-kadang menggunakan huruf kapital “LLaMA” – berdasarkan model Llama 2 dirilis di Juli. Ini telah disesuaikan dan dilatih untuk mengeluarkan dan mendiskusikan kode sumber sebagai respons terhadap perintah teks, bukan prosa seperti nenek moyangnya.

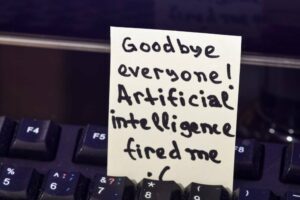

Seperti halnya semua teknologi mutakhir, Code Llama memiliki risiko

“Code Llama memiliki potensi untuk digunakan sebagai alat produktivitas dan pendidikan untuk membantu pemrogram menulis perangkat lunak yang lebih kuat dan terdokumentasi dengan baik,” klaim Meta dalam sebuah pengumuman Kamis.

Jika Anda meminta Code Llama untuk menulis fungsi yang menghasilkan deret Fibonacci, model tersebut akan menghasilkan kode dan bahasa alami yang menjelaskan sumbernya, kata Meta. Dan model AI dapat melakukannya dalam Python, C++, Java, PHP, TypeScript (Javascript), C#, Bash, dan bahasa lainnya.

Namun pengguna diarahkan untuk menggunakan Kode Llama dalam bahasa Inggris karena model tersebut belum melalui pengujian keamanan dalam bahasa lain dan mungkin akan mengatakan sesuatu yang buruk jika ditanyakan dalam bahasa lain. keluar dari ruang lingkup bahasa.

“Seperti semua teknologi mutakhir, Code Llama juga memiliki risiko,” Meta menjelaskan, sambil mencatat bahwa selama pengujian tim merahnya untuk meminta pembuatan kode berbahaya, Code Llama merespons dengan jawaban yang lebih aman dibandingkan ChatGPT (GPT3.5 Turbo).

Menurut Meta, Code Llama mengungguli LLM sumber terbuka, LLM khusus kode, dan induknya sendiri Llama 2 dalam dua tolok ukur – Evaluasi Manusia dan Sebagian Besar Pemrograman Python Dasar (MBPP) – dan menyamai kinerja ChatGPT OpenAI.

Code Llama hadir dalam tiga ukuran – parameter 7B, 13B, dan 34B – dan setiap varian dilatih dengan 500B token kode dan data terkait kode. Satu token kira-kira terdiri dari empat karakter dalam bahasa Inggris. Versi terbesar dari Codex OpenAI, ketika dirilis, memiliki 12B parameter.

Dua model Code Llama terkecil, kata Meta, telah dilatih untuk mengisi sumber yang hilang sehingga memungkinkan mereka digunakan untuk penyelesaian kode tanpa penyesuaian lebih lanjut. Versi 34B dikatakan memberikan hasil terbaik, namun versi yang lebih kecil merespons lebih cepat, menjadikannya lebih baik untuk tugas-tugas seperti penyelesaian kode yang latensinya terlihat.

Ada juga dua varian: Kode Llama – Python, dan Kode Llama – Instruct. Yang pertama berasal dari penyempurnaan Kode Llama dengan tambahan 100 miliar token kode Python. Yang terakhir ini telah disesuaikan untuk mematuhi pola masukan dan keluaran, sehingga lebih cocok untuk pembuatan kode.

Keandalan, siapa saja?

LLM sering menyediakan salah jawaban ke perintah pemrograman, meskipun tetap digunakan oleh banyak pengembang untuk mengingat pola hafalan dan parameter API, atau menghindari kueri penelusuran dan pemeriksaan dokumentasi.

Salah satu nilai jual Code Llama adalah dapat menangani input dan output rangkaian kode yang terdiri hingga 100,000 token. Artinya, Anda dapat meminta model dengan banyak baris kode dan Anda mungkin mendapatkan respons yang panjang lebar.

“Selain sebagai prasyarat untuk menghasilkan program yang lebih panjang, memiliki urutan masukan yang lebih panjang akan membuka kasus penggunaan baru yang menarik untuk kode LLM,” jelas Meta. “Misalnya, pengguna dapat memberikan model dengan lebih banyak konteks dari basis kode mereka untuk membuat generasi yang dihasilkan lebih relevan. Hal ini juga membantu dalam men-debug skenario dalam basis kode yang lebih besar, di mana tetap mengetahui semua kode yang terkait dengan masalah tertentu dapat menjadi tantangan bagi pengembang.”

Pengguna dapat memberikan model dengan lebih banyak konteks dari basis kode mereka untuk membuat generasi yang dihasilkan lebih relevan

Code Llama bergabung dengan bidang model pemahaman kode yang berkembang yang awalnya diunggulkan oleh Codex OpenAI dan GitHub yang terkait. terbebani litigasi Layanan saran pemrograman Copilot (2021). Model pemrograman positif yang diikuti termasuk DeepMind kode alfa (2022), GPT-4 OpenAI (2023), Amazon Pembisik Kode (2023), dan Google's Bard (2023), disetel pada bulan April untuk menghasilkan Kode sumber.

Selain itu, ada berbagai LLM open source (atau semacam terbuka) seperti Kode Bintang dan XGen, untuk menyebutkan dua.

Meta telah merilis Code Llama dengan nama yang sama izin komunitas seperti Llama 2, mengutip keyakinan perusahaan besar tersebut pada “pendekatan terbuka terhadap AI” sebagai cara terbaik untuk mengembangkan alat yang inovatif, aman, dan bertanggung jawab.

Namun seperti yang banyak dicatat pada Llama 2, izin komunitaslah yang berlaku bukan lisensi sumber terbuka. “Pendekatan terbuka” Meta terhadap AI tertutup bagi persaingan – lisensinya secara eksplisit melarang penggunaan perangkat lunak “untuk meningkatkan model bahasa besar lainnya.”

Dan meskipun lisensi komunitas Meta mengizinkan penggunaan komersial berbagai llama, lisensi ini membatasi layanan dengan “lebih dari 700 juta pengguna aktif bulanan.”

Sebaliknya pilih grup layanan besar – YouTube, WeChat, TikTok, LinkedIn, Telegram, Snapchat, dan Douyin, di antara platform media sosial yang belum dijalankan oleh Meta, dan mungkin perusahaan yang menjalankan platform berbasis sistem operasi seperti Apple, Google, dan Microsoft – “harus meminta lisensi dari Meta, yang dapat diberikan Meta kepada Anda atas kebijakannya sendiri…” ®

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Otomotif / EV, Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- ChartPrime. Tingkatkan Game Trading Anda dengan ChartPrime. Akses Di Sini.

- BlockOffset. Modernisasi Kepemilikan Offset Lingkungan. Akses Di Sini.

- Sumber: https://go.theregister.com/feed/www.theregister.com/2023/08/25/meta_lets_code_llama_run/

- :memiliki

- :adalah

- :bukan

- :Di mana

- $NAIK

- 000

- 100

- 2021

- 2022

- 2023

- 700

- a

- aktif

- tambahan

- alamat

- mengikuti

- AI

- Semua

- memungkinkan

- sudah

- juga

- Amazon

- antara

- an

- dan

- Lain

- jawaban

- Apa pun

- siapapun

- api

- Apple

- pendekatan

- April

- ADALAH

- AS

- terkait

- At

- menghindari

- berdasarkan

- menampar

- dasar

- BE

- menjadi

- makhluk

- keyakinan

- Benchmark

- TERBAIK

- Lebih baik

- kedua

- tapi

- by

- C + +

- CAN

- Kapitalisasi

- kasus

- menantang

- karakter

- ChatGPT

- Cek

- diklaim

- tertutup

- CO

- kode

- Basis kode

- datang

- komersial

- masyarakat

- Perusahaan

- kompetisi

- penyelesaian

- konteks

- penciptaan

- pemotongan

- data

- DeepMind

- mengembangkan

- pengembang

- MELAKUKAN

- membahas

- do

- dokumentasi

- douyin

- menarik

- selama

- setiap

- Tepi

- edukasi

- Inggris

- Eter (ETH)

- contoh

- menarik

- menjelaskan

- menjelaskan

- Menjelaskan

- tambahan

- keluarga

- lebih cepat

- FB

- fibonacci

- bidang

- mengisi

- akhir

- diikuti

- Untuk

- Bekas

- empat

- dari

- fungsi

- lebih lanjut

- menghasilkan

- menghasilkan

- generasi

- Generasi

- mendapatkan

- GitHub

- memberikan

- lebih besar

- Pertumbuhan

- memiliki

- menangani

- Memiliki

- memiliki

- membantu

- membantu

- karenanya

- Namun

- HTTPS

- if

- memperbaiki

- in

- Di lain

- memasukkan

- mulanya

- inovatif

- memasukkan

- sebagai gantinya

- isu

- IT

- NYA

- Jawa

- JavaScript

- Bergabung

- jpg

- Juli

- hanya

- bahasa

- Bahasa

- besar

- lebih besar

- terbesar

- Latensi

- pengetahuan

- Lets

- Lisensi

- 'like'

- baris

- baris

- Llama

- lagi

- mesin

- Mesin belajar

- membuat

- Membuat

- banyak

- Mungkin..

- Media

- meta

- Microsoft

- mungkin

- juta

- hilang

- model

- model

- bulanan

- lebih

- kebanyakan

- harus

- nama

- Alam

- Bahasa Alami

- New

- terkenal

- mencatat

- sesekali

- of

- sering

- on

- ONE

- Buka

- open source

- OpenAI

- operasi

- or

- Lainnya

- Mengungguli

- keluaran

- sendiri

- parameter

- pola

- prestasi

- PHP

- Platform

- plato

- Kecerdasan Data Plato

- Data Plato

- poin

- potensi

- menghasilkan

- produktifitas

- nenek moyang

- Programmer

- Pemrograman

- program

- memberikan

- menempatkan

- Ular sanca

- query

- agak

- RE

- Merah

- terkait

- dirilis

- relevan

- permintaan

- Menanggapi

- tanggapan

- tanggung jawab

- Hasil

- kerusuhan

- risiko

- kuat

- kira-kira

- Run

- berjalan

- s

- aman

- lebih aman

- Safety/keselamatan

- Tersebut

- sama

- mengatakan

- mengatakan

- skenario

- Pencarian

- Penjualan

- Urutan

- layanan

- Layanan

- ukuran

- lebih kecil

- Snapchat

- So

- Sosial

- media sosial

- media sosial platform

- Perangkat lunak

- sesuatu

- sumber

- kode sumber

- T

- tugas

- tim

- Teknologi

- Telegram

- istilah

- pengujian

- dari

- bahwa

- Grafik

- Sumber

- mereka

- Mereka

- Sana.

- mereka

- ini

- meskipun?

- tiga

- Melalui

- Kamis

- Tiktok

- waktu

- untuk

- token

- Token

- alat

- alat

- puncak

- terlatih

- dua

- Naskah

- bawah

- membuka kunci

- menggunakan

- bekas

- Pengguna

- menggunakan

- Varian

- berbagai

- versi

- adalah

- Cara..

- ketika

- yang

- sementara

- sangat

- Wikipedia

- akan

- dengan

- tanpa

- menulis

- namun

- kamu

- Youtube

- zephyrnet.dll