Dihasilkan dengan Midjourney

Perusahaan di setiap industri dan penjuru dunia bergegas untuk mengintegrasikan kekuatan model bahasa besar (LLM) seperti ChatGPT OpenAI, Claude Anthropic, dan Jurassic AI12Lab untuk meningkatkan kinerja dalam berbagai aplikasi bisnis, seperti riset pasar, layanan pelanggan , dan pembuatan konten.

Namun, membangun aplikasi LLM pada skala perusahaan memerlukan perangkat dan pemahaman yang berbeda dari membangun aplikasi pembelajaran mesin (ML) tradisional. Pemimpin dan eksekutif bisnis yang ingin mempertahankan suara merek dan kualitas layanan yang andal perlu mengembangkan pemahaman yang lebih dalam tentang cara kerja LLM dan pro dan kontra dari berbagai alat dalam tumpukan aplikasi LLM.

Pada artikel ini, kami akan memberi Anda pengantar penting tentang strategi & alat tingkat tinggi yang Anda perlukan untuk membuat dan menjalankan aplikasi LLM untuk bisnis Anda.

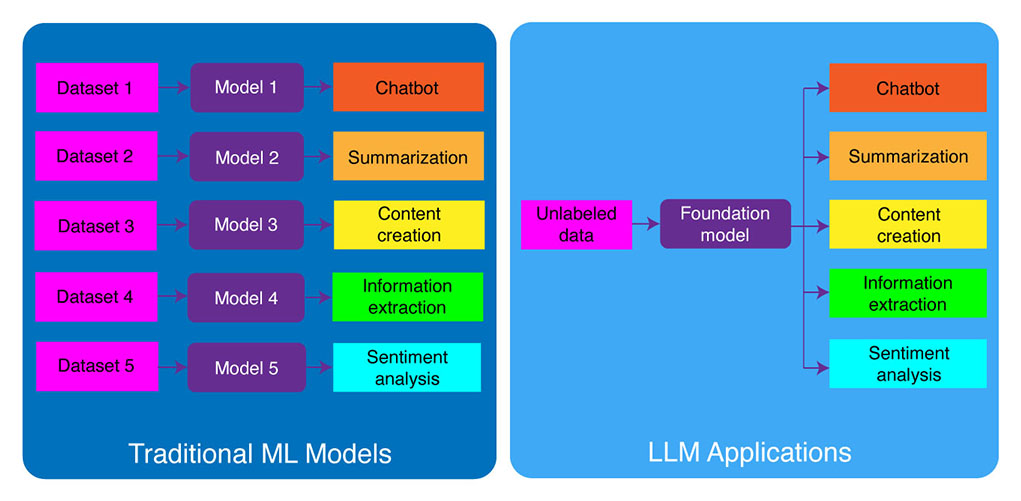

Pengembangan ML Tradisional vs. Aplikasi LLM

Model pembelajaran mesin tradisional bersifat khusus untuk tugas, artinya Anda perlu membuat model terpisah untuk setiap tugas yang berbeda. Misalnya, jika Anda ingin menganalisis sentimen pelanggan, Anda perlu membuat satu model, dan jika Anda ingin membuat chatbot dukungan pelanggan, Anda perlu membuat model lain.

Proses membangun dan melatih model ML khusus tugas ini memakan waktu dan membutuhkan banyak data. Jenis kumpulan data yang diperlukan untuk melatih model ML yang berbeda ini juga akan bervariasi bergantung pada tugasnya. Untuk melatih model untuk menganalisis sentimen pelanggan, Anda memerlukan kumpulan data ulasan pelanggan yang telah diberi label dengan sentimen yang sesuai (positif, negatif, netral). Untuk melatih model membangun chatbot dukungan pelanggan, Anda memerlukan kumpulan data percakapan antara pelanggan dan dukungan teknis.

Model bahasa besar telah mengubah ini. LLM dilatih sebelumnya pada kumpulan data teks dan kode yang sangat besar, yang memungkinkan mereka untuk bekerja dengan baik pada berbagai tugas di luar kotak, termasuk:

- Peringkasan teks

- Pembuatan konten

- Terjemahan

- Ekstraksi informasi

- Menjawab pertanyaan

- Analisis sentimen

- Dukungan pelanggan

- Dukungan penjualan

Proses pengembangan aplikasi LLM dapat dipecah menjadi empat langkah penting:

- Pilih model foundation yang sesuai. Ini adalah komponen utama, yang menentukan kinerja aplikasi LLM Anda.

- Sesuaikan modelnya, jika perlu. Anda mungkin perlu menyempurnakan model atau menambahnya dengan basis pengetahuan tambahan untuk memenuhi kebutuhan spesifik Anda.

- Siapkan infrastruktur ML. Ini termasuk perangkat keras dan perangkat lunak yang diperlukan untuk menjalankan aplikasi Anda (mis., semikonduktor, chip, hosting awan, inferensi, dan penerapan).

- Tingkatkan aplikasi Anda dengan alat tambahan. Alat ini dapat membantu meningkatkan efisiensi, kinerja, dan keamanan aplikasi Anda.

Sekarang, mari kita lihat tumpukan teknologi yang sesuai.

Jika konten pendidikan yang mendalam ini bermanfaat bagi Anda, berlangganan milis AI kami untuk diperingatkan ketika kami merilis materi baru.

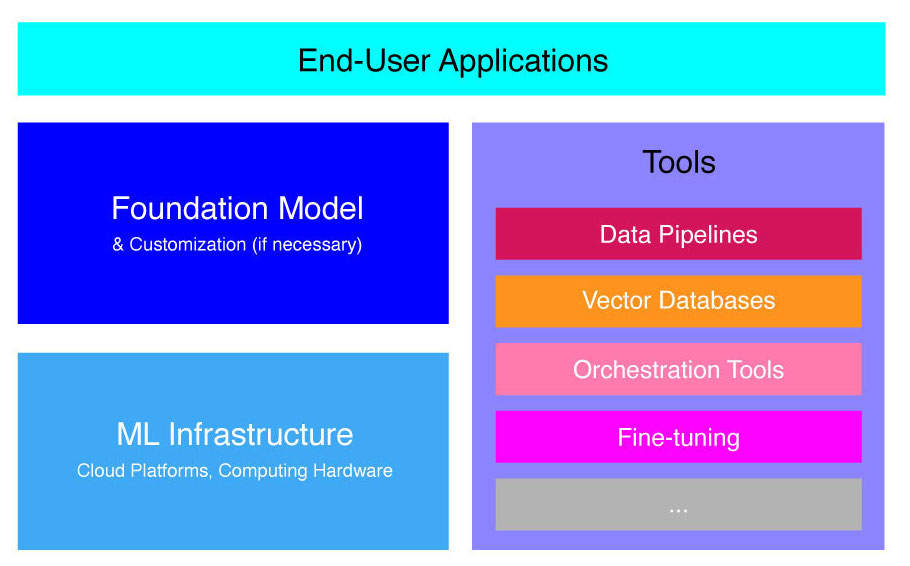

Tumpukan Aplikasi LLM Tingkat Tinggi

Aplikasi LLM dibangun di atas beberapa komponen utama, termasuk:

- Model pondasi, yang mungkin memerlukan penyesuaian dalam kasus penggunaan tertentu.

- infrastruktur ML untuk sumber daya komputasi yang memadai melalui platform cloud atau perangkat keras perusahaan sendiri.

- Alat tambahan, seperti pipeline data, database vektor, alat orkestrasi, platform ML penyempurnaan, alat pemantauan kinerja model, dll.

Kami akan memandu Anda secara singkat melalui komponen-komponen ini sehingga Anda dapat lebih memahami toolkit yang diperlukan untuk membuat dan menerapkan aplikasi LLM.

Apa Itu Model Fondasi?

Menggunakan satu LLM terlatih dapat menghemat banyak waktu dan sumber daya. Namun, melatih model seperti itu dari bawah ke atas adalah proses yang tepat waktu dan mahal yang berada di luar kemampuan sebagian besar perusahaan kecuali beberapa elit pemimpin teknologi.

Beberapa perusahaan dan tim peneliti telah melatih model ini dan mengizinkan perusahaan lain untuk menggunakannya. Contoh terkemuka termasuk ChatGPT, Claude, Llama, Jurassic, dan T5. Model yang menghadap publik ini disebut model pondasi. Beberapa di antaranya adalah hak milik dan dapat diakses melalui panggilan API dengan biaya tertentu. Yang lainnya bersumber terbuka dan dapat digunakan secara gratis. Model-model ini dilatih sebelumnya pada kumpulan data besar dari data tekstual tanpa label, memungkinkan mereka untuk melakukan berbagai tugas, mulai dari membuat salinan iklan kreatif hingga berkomunikasi dengan pelanggan Anda dalam bahasa asli mereka atas nama perusahaan.

Ada dua jenis utama model pondasi: berpemilik dan open-source.

Model eksklusif dimiliki oleh satu perusahaan atau organisasi dan biasanya hanya tersedia dengan biaya tertentu. Beberapa contoh model berpemilik yang paling populer termasuk model GPT oleh OpenAI, model Claude oleh Anthropic, dan model Jurassic oleh AI21 Labs.

Model sumber terbuka biasanya tersedia secara gratis bagi siapa saja yang ingin menggunakannya. Namun, beberapa model open source memiliki batasan penggunaannya, seperti: (1) hanya tersedia untuk tujuan penelitian, (2) hanya tersedia untuk penggunaan komersial oleh perusahaan dengan ukuran tertentu. Komunitas sumber terbuka mengklaim bahwa menempatkan batasan seperti itu tidak memungkinkan model memenuhi syarat sebagai "sumber terbuka". Namun, contoh paling menonjol dari model bahasa yang dapat digunakan secara gratis, termasuk model Llama oleh Meta, model Falcon oleh Technology Innovation Institute di Abu Dhabi, dan model StableLM oleh Stability AI. Baca lebih lanjut tentang model sumber terbuka dan risiko terkait di sini.

Sekarang mari kita bahas beberapa faktor yang perlu dipertimbangkan saat memilih model pondasi untuk aplikasi LLM Anda.

Pilih Model Fondasi

Memilih model fondasi terbaik untuk aplikasi LLM Anda bisa menjadi proses yang menantang, tetapi pada dasarnya kami dapat membaginya menjadi tiga langkah:

- Pilih antara model berpemilik dan sumber terbuka. Model berpemilik biasanya lebih besar dan lebih mampu daripada model sumber terbuka, tetapi bisa lebih mahal untuk digunakan dan kurang fleksibel. Selain itu, kodenya tidak transparan, sehingga sulit untuk men-debug atau memecahkan masalah dengan kinerja model berpemilik. Model open-source, di sisi lain, biasanya mendapat lebih sedikit pembaruan dan lebih sedikit dukungan dari pengembang.

- Pilih ukuran modelnya. Model yang lebih besar biasanya lebih baik dalam melakukan tugas yang membutuhkan banyak pengetahuan, seperti menjawab pertanyaan atau membuat teks kreatif. Namun, model yang lebih besar juga lebih mahal secara komputasi untuk digunakan. Anda dapat memulai dengan bereksperimen dengan model yang lebih besar, lalu beralih ke model yang lebih kecil selama performa model memuaskan untuk kasus penggunaan Anda.

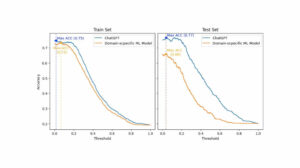

- Pilih model tertentu. Anda dapat memulai dengan meninjau tolok ukur umum untuk memilih model yang akan diuji. Kemudian, lanjutkan dengan menguji berbagai model untuk tugas khusus aplikasi Anda. Untuk pembandingan khusus, pertimbangkan untuk menghitung skor BLEU dan ROUGE, metrik yang membantu menghitung jumlah koreksi yang diperlukan untuk teks yang dihasilkan AI sebelum merilis output untuk aplikasi human-in-the-loop.

Untuk pemahaman yang lebih baik tentang perbedaan antara berbagai model bahasa, lihat ikhtisar kami tentang bahasa paling kuat (LLM) dan model bahasa visual (VLM).

Setelah Anda memilih model dasar untuk aplikasi Anda, Anda dapat mempertimbangkan apakah Anda perlu menyesuaikan model untuk kinerja yang lebih baik lagi.

Sesuaikan Model Fondasi

Dalam beberapa kasus, Anda mungkin ingin menyesuaikan model bahasa dasar untuk kinerja yang lebih baik dalam kasus penggunaan khusus Anda. Misalnya, Anda mungkin ingin mengoptimalkan untuk:

- Domain. Jika Anda beroperasi di domain tertentu, seperti hukum, keuangan, atau perawatan kesehatan, Anda mungkin ingin memperkaya kosa kata model di domain ini sehingga dapat memahami dan menanggapi pertanyaan pengguna akhir dengan lebih baik.

- tugas. Misalnya, jika Anda ingin model menghasilkan kampanye pemasaran, Anda dapat memberikannya contoh spesifik tentang konten pemasaran bermerek. Ini akan membantu model mempelajari pola dan gaya yang sesuai untuk perusahaan dan audiens Anda.

- Nada suara. Jika Anda memerlukan model untuk menggunakan nada suara tertentu, Anda dapat menyesuaikan model pada kumpulan data yang menyertakan contoh sampel linguistik target Anda.

Ada tiga cara yang mungkin untuk menyesuaikan model bahasa dasar:

- Mencari setelan: menyediakan model dengan kumpulan data berlabel khusus domain sekitar 100-500 catatan. Bobot model diperbarui, yang seharusnya menghasilkan kinerja yang lebih baik pada tugas yang diwakili oleh kumpulan data ini.

- Adaptasi domain: menyediakan model dengan kumpulan data tak berlabel khusus domain yang berisi sekumpulan besar data dari domain terkait. Bobot model juga diperbarui dalam kasus ini.

- Pencarian informasi: menambah model dasar dengan pengetahuan domain tertutup. Model tidak dilatih ulang, dan bobot model tetap sama. Namun, model diperbolehkan untuk mengambil informasi dari database vektor yang berisi data yang relevan.

Dua pendekatan pertama membutuhkan sumber daya komputasi yang signifikan untuk melatih ulang model, yang biasanya hanya layak untuk perusahaan besar dengan bakat teknis yang sesuai untuk mengelola kustomisasi. Perusahaan yang lebih kecil biasanya menggunakan pendekatan yang lebih umum untuk menambah model dengan pengetahuan domain melalui database vektor, yang akan kami jelaskan nanti di artikel ini di bagian alat LLM.

Siapkan Infrastruktur ML

Komponen infrastruktur ML lanskap LLMOps mencakup platform cloud, perangkat keras komputasi, dan sumber daya lain yang diperlukan untuk menerapkan dan menjalankan LLM. Komponen ini sangat relevan jika Anda memilih untuk menggunakan model sumber terbuka atau menyesuaikan model untuk aplikasi Anda. Dalam hal ini, Anda mungkin memerlukan sumber daya komputasi yang signifikan untuk menyempurnakan model, jika perlu, dan menjalankannya.

Ada sejumlah platform cloud yang menawarkan layanan untuk menerapkan LLM, termasuk Google Cloud Platform, Amazon Web Services, dan Microsoft Azure. Platform ini menyediakan sejumlah fitur yang memudahkan penyebaran dan menjalankan LLM, termasuk:

- Model terlatih yang dapat disesuaikan untuk aplikasi khusus Anda

- Infrastruktur terkelola yang menangani perangkat keras dan perangkat lunak yang mendasarinya

- Alat dan layanan untuk memantau dan men-debug LLM Anda

Jumlah sumber daya komputasi yang Anda perlukan akan bergantung pada ukuran dan kompleksitas model Anda, tugas yang ingin Anda lakukan, dan skala aktivitas bisnis, tempat Anda ingin menerapkan model ini.

Perbesar Dengan Alat

Alat berdekatan LLM tambahan dapat digunakan untuk lebih meningkatkan kinerja aplikasi LLM Anda.

Pipa Data

Jika Anda perlu menggunakan data Anda dalam produk LLM Anda, pipeline prapemrosesan data akan menjadi pilar penting tumpukan teknologi baru Anda, seperti tumpukan AI perusahaan tradisional. Alat ini mencakup konektor untuk menyerap data dari sumber mana pun, lapisan transformasi data, dan konektor hilir. Penyedia pipa data terkemuka, seperti Databricks dan Snowflake, dan pemain baru, seperti Tidak Terstruktur, memudahkan pengembang untuk menunjukkan kumpulan data bahasa alami yang besar dan sangat heterogen (misalnya, ribuan PDF, presentasi PowerPoint, log obrolan, HTML tergores, dll.) ke satu titik akses atau bahkan ke dalam satu dokumen yang dapat digunakan lebih lanjut oleh aplikasi LLM.

Database Vektor

Model bahasa besar terbatas untuk memproses beberapa ribu kata sekaligus, sehingga mereka tidak dapat secara efektif memproses dokumen besar sendiri. Untuk memanfaatkan kekuatan dokumen besar, bisnis perlu menggunakan database vektor.

Database vektor adalah sistem penyimpanan yang mengubah dokumen besar yang mereka terima melalui jalur pipa data menjadi vektor yang dapat dikelola, atau penyematan. Aplikasi LLM kemudian dapat menanyakan basis data ini untuk menentukan vektor yang tepat, hanya mengekstrak informasi nugget yang diperlukan.

Beberapa database vektor paling menonjol yang tersedia saat ini adalah Pinecone, Chroma, dan Weaviate.

Alat Orkestrasi

Saat pengguna mengirimkan kueri ke aplikasi LLM Anda, seperti pertanyaan untuk layanan pelanggan, aplikasi perlu membuat serangkaian petunjuk sebelum mengirimkan kueri ini ke model bahasa. Permintaan terakhir ke model bahasa biasanya terdiri dari template cepat yang dikodekan keras oleh pengembang, contoh keluaran valid yang disebut contoh beberapa tembakan, informasi apa pun yang diperlukan diambil dari API eksternal, dan sekumpulan dokumen relevan yang diambil dari database vektor . Alat orkestrasi dari perusahaan seperti LangChain atau LlamaIndex dapat membantu merampingkan proses ini dengan menyediakan kerangka kerja yang siap digunakan untuk mengelola dan menjalankan permintaan.

Mencari setelan

Model bahasa besar yang dilatih pada kumpulan data besar dapat menghasilkan teks yang benar secara tata bahasa dan fasih. Namun, mereka mungkin kurang presisi di bidang tertentu, seperti kedokteran atau hukum. Menyempurnakan model ini pada kumpulan data khusus domain memungkinkan mereka menginternalisasi fitur unik dari area tersebut, meningkatkan kemampuannya untuk menghasilkan teks yang relevan.

Menyempurnakan LLM bisa menjadi proses intensif biaya untuk perusahaan kecil. Namun, solusi dari perusahaan seperti Weights & Biases dan OctoML dapat membantu penyetelan halus yang efisien dan efisien. Solusi ini menyediakan platform bagi perusahaan untuk menyempurnakan LLM tanpa harus berinvestasi dalam infrastruktur mereka sendiri.

Peralatan lainnya

Ada banyak alat lain yang berguna untuk membangun dan menjalankan aplikasi LLM. Misalnya, Anda mungkin memerlukan alat pelabelan jika ingin menyempurnakan model dengan sampel data spesifik Anda. Anda mungkin juga ingin menerapkan alat khusus untuk memantau kinerja aplikasi Anda, karena perubahan kecil pada model dasar atau permintaan dari pelanggan dapat berdampak signifikan pada kinerja permintaan. Terakhir, ada alat yang memantau keamanan model untuk membantu Anda menghindari promosi konten kebencian, rekomendasi berbahaya, atau bias. Kebutuhan dan pentingnya berbagai alat ini akan bergantung pada kasus penggunaan khusus Anda.

Apa Selanjutnya dalam Pengembangan Aplikasi LLM?

Empat langkah untuk pengembangan produk LLM yang kita diskusikan di sini, merupakan fondasi penting dari strategi AI generatif perusahaan mana pun yang memanfaatkan model bahasa besar. Mereka penting untuk dipahami oleh para pemimpin bisnis non-teknis, bahkan jika Anda memiliki tim teknis yang mengimplementasikan detailnya. Kami akan menerbitkan tutorial yang lebih mendetail di masa mendatang tentang cara memanfaatkan berbagai alat AI generatif di pasar. Untuk saat ini, Anda bisa Berlangganan newsletter kami untuk mendapatkan update terbaru.

Nikmati artikel ini? Daftar untuk mendapatkan lebih banyak pembaruan AI perusahaan.

Kami akan memberi tahu Anda ketika kami merilis lebih banyak artikel ringkasan seperti ini.

terkait

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Otomotif / EV, Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- BlockOffset. Modernisasi Kepemilikan Offset Lingkungan. Akses Di Sini.

- Sumber: https://www.topbots.com/llm-product-development-technology-stack/

- :adalah

- :bukan

- :Di mana

- $NAIK

- 1

- a

- kemampuan

- Tentang Kami

- abu dhabi

- mengakses

- diakses

- kegiatan

- Ad

- Tambahan

- Selain itu

- berdekatan

- AI

- Strategi AI

- mengizinkan

- diizinkan

- memungkinkan

- juga

- Amazon

- Amazon Web Services

- jumlah

- an

- menganalisa

- dan

- Lain

- Antropik

- Apa pun

- siapapun

- api

- Lebah

- Aplikasi

- Pengembangan Aplikasi

- aplikasi

- pendekatan

- pendekatan

- sesuai

- ADALAH

- daerah

- artikel

- artikel

- AS

- terkait

- At

- para penonton

- tersedia

- menghindari

- Biru langit

- mendasarkan

- Pada dasarnya

- BE

- menjadi

- sebelum

- nama

- makhluk

- benchmarking

- Benchmark

- TERBAIK

- Lebih baik

- antara

- Luar

- bias

- mendorong

- Kotak

- merek

- bermerek

- Istirahat

- secara singkat

- Rusak

- membangun

- Bangunan

- dibangun di

- bisnis

- Aplikasi Bisnis

- Pemimpin bisnis

- bisnis

- tapi

- by

- menghitung

- bernama

- Panggilan

- Kampanye

- CAN

- kemampuan

- mampu

- yang

- kasus

- kasus

- tertentu

- menantang

- berubah

- Perubahan

- ChatBot

- ChatGPT

- memeriksa

- Keripik

- Pilih

- memilih

- terpilih

- klaim

- awan

- Cloud Hosting

- Platform Cloud

- kode

- komersial

- Umum

- berkomunikasi

- masyarakat

- Perusahaan

- perusahaan

- Perusahaan

- kompleksitas

- komponen

- komponen

- tersusun

- komputasi

- Kekurangan

- Mempertimbangkan

- membangun

- mengandung

- Konten

- percakapan

- salinan

- Sudut

- benar

- Koreksi

- Sesuai

- mahal

- Kreatif

- Sekarang

- adat

- pelanggan

- Layanan Pelanggan

- Customer Support

- pelanggan

- kustomisasi

- menyesuaikan

- Berbahaya

- data

- Basis Data

- database

- batu bata data

- kumpulan data

- lebih dalam

- mendefinisikan

- Tergantung

- menyebarkan

- penggelaran

- penyebaran

- rinci

- terperinci

- rincian

- mengembangkan

- Pengembang

- pengembang

- berkembang

- Pengembangan

- Dhabi

- perbedaan

- berbeda

- sulit

- membahas

- dibahas

- dokumen

- dokumen

- Tidak

- domain

- domain

- turun

- e

- setiap

- Mudah

- edukasi

- efektif

- efisiensi

- efisien

- elite

- memungkinkan

- mempertinggi

- meningkatkan

- memperkaya

- Enterprise

- terutama

- penting

- dll

- Eter (ETH)

- Bahkan

- Setiap

- contoh

- contoh

- Kecuali

- mengeksekusi

- eksekutif

- mahal

- luar

- faktor

- elang

- layak

- Fitur

- biaya

- beberapa

- sedikit

- terakhir

- Akhirnya

- keuangan

- Pertama

- fleksibel

- Untuk

- Prinsip Dasar

- empat

- kerangka

- Gratis

- dari

- lebih lanjut

- masa depan

- Umum

- menghasilkan

- menghasilkan

- generasi

- generatif

- AI generatif

- mendapatkan

- Memberikan

- bumi

- Go

- akan

- Google Cloud

- Google Cloud Platform

- Tanah

- tangan

- Perangkat keras

- memanfaatkan

- Memiliki

- memiliki

- kesehatan

- membantu

- di sini

- tingkat tinggi

- sangat

- tuan

- Seterpercayaapakah Olymp Trade? Kesimpulan

- How To

- Namun

- HTML

- HTTPS

- i

- if

- Dampak

- mengimplementasikan

- pentingnya

- penting

- memperbaiki

- in

- secara mendalam

- memasukkan

- termasuk

- Termasuk

- industri

- informasi

- Infrastruktur

- Innovation

- Lembaga

- mengintegrasikan

- ke

- Pengantar

- Menginvestasikan

- IT

- jpg

- hanya

- kunci

- Jenis

- Tahu

- pengetahuan

- pelabelan

- Labs

- Kekurangan

- pemandangan

- bahasa

- besar

- lebih besar

- kemudian

- Terbaru

- Latest Update

- Hukum

- lapisan

- pemimpin

- terkemuka

- BELAJAR

- pengetahuan

- Informasi

- kurang

- Leverage

- memanfaatkan

- 'like'

- keterbatasan

- Terbatas

- Llama

- Panjang

- melihat

- Lot

- mesin

- Mesin belajar

- Utama

- membuat

- MEMBUAT

- mengelola

- pelaksana

- banyak

- Pasar

- riset pasar

- Marketing

- Kampanye pemasaran

- pasar

- besar-besaran

- bahan

- max-width

- Mungkin..

- makna

- obat

- Pelajari

- meta

- Metrik

- Microsoft

- Microsoft Azure

- mungkin

- minor

- ML

- model

- model

- Memantau

- pemantauan

- lebih

- paling

- Paling Populer

- asli

- Alam

- Bahasa Alami

- perlu

- Perlu

- dibutuhkan

- kebutuhan

- negatif

- Netral

- New

- Teknologi Baru

- Buletin

- berikutnya

- non-teknis

- sekarang

- jumlah

- of

- menawarkan

- on

- ONE

- yang

- hanya

- open source

- OpenAI

- beroperasi

- Optimize

- or

- teknik mengatur musik

- organisasi

- Lainnya

- Lainnya

- kami

- di luar

- keluaran

- ikhtisar

- sendiri

- dimiliki

- pola

- melakukan

- prestasi

- melakukan

- Pilar

- pipa saluran

- Platform

- Platform

- plato

- Kecerdasan Data Plato

- Data Plato

- pemain

- Titik

- Populer

- positif

- mungkin

- kekuasaan

- kuat

- Ketelitian

- Presentasi

- masalah

- proses

- pengolahan

- menghasilkan

- Produk

- pengembangan produk

- menonjol

- mempromosikan

- hak milik

- PROS

- memberikan

- penyedia

- menyediakan

- menyediakan

- menerbitkan

- tujuan

- Puting

- memenuhi syarat

- kualitas

- query

- pertanyaan

- Pertanyaan

- jarak

- Baca

- menerima

- rekomendasi

- arsip

- melepaskan

- melepaskan

- relevan

- dapat diandalkan

- diwakili

- permintaan

- permintaan

- membutuhkan

- membutuhkan

- penelitian

- Sumber

- Menanggapi

- pembatasan

- mengakibatkan

- meninjau

- Review

- benar

- risiko

- Run

- berjalan

- Safety/keselamatan

- sama

- Save

- Skala

- Bagian

- keamanan

- Semikonduktor

- sentimen

- terpisah

- Seri

- layanan

- Layanan

- set

- beberapa

- harus

- menandatangani

- penting

- signifikan

- tunggal

- Ukuran

- kecil

- lebih kecil

- So

- Perangkat lunak

- Solusi

- beberapa

- sumber

- tertentu

- Stabilitas

- tumpukan

- awal

- tinggal

- Tangga

- Masih

- penyimpanan

- Penyelarasan

- mempersingkat

- efisien

- gaya

- seperti itu

- cukup

- RINGKASAN

- mendukung

- sistem

- Mengambil

- Dibutuhkan

- Bakat

- target

- tugas

- tugas

- tim

- tim

- tech

- Teknis

- dukungan teknis

- Teknologi

- inovasi teknologi

- Template

- pengujian

- dari

- bahwa

- Grafik

- Masa depan

- mereka

- Mereka

- kemudian

- Sana.

- Ini

- mereka

- ini

- itu

- ribuan

- tiga

- Melalui

- waktu

- membuang-buang waktu

- untuk

- NADA

- Nada suara

- toolkit

- alat

- puncak

- TOPBOT

- tradisional

- Pelatihan VE

- terlatih

- Pelatihan

- Mengubah

- Transformasi

- jelas

- tutorial

- dua

- jenis

- khas

- pokok

- memahami

- pemahaman

- unik

- fitur unik

- diperbarui

- Pembaruan

- menggunakan

- gunakan case

- bekas

- Pengguna

- biasanya

- berbagai

- melalui

- Suara

- vs

- ingin

- ingin

- ingin

- cara

- we

- jaringan

- layanan web

- BAIK

- adalah

- ketika

- apakah

- yang

- SIAPA

- lebar

- Rentang luas

- akan

- dengan

- tanpa

- kata

- Kerja

- akan

- kamu

- Anda

- zephyrnet.dll