Kezdjük látni, hogy a generatív mesterséges intelligencia (AI) technológiai halmazának nagyon korai szakaszai jelennek meg. Új startupok százai rohannak a piacra, hogy alapmodelleket fejlesszenek, mesterséges intelligencián alapuló alkalmazásokat készítsenek, valamint infrastruktúrát/szerszámokat állítsanak elő.

Sok felkapott technológiai trend túlzásba esik, még mielőtt a piac utolérné. A generatív mesterséges intelligencia fellendülését azonban a valódi piacokon valós nyereség és a valódi vállalatok valódi vonzása kísérte. Az olyan modellek, mint a Stable Diffusion és a ChatGPT, történelmi rekordokat állítanak fel a felhasználók növekedésében, és számos alkalmazás évesített bevétele kevesebb, mint egy évvel az indulás után elérte a 100 millió dollárt. Az egymás melletti összehasonlítások AI modelleket mutatnak be felülmúlja az embert egyes feladatokban több nagyságrenddel.

Tehát elég korai adat áll rendelkezésre ahhoz, hogy hatalmas átalakulás zajlik le. Amit nem tudunk, és ami most kritikus kérdéssé vált, az a következő: Hol fog felhalmozódni az érték ezen a piacon?

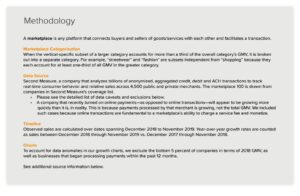

Az elmúlt év során több tucat startup alapítóval és üzemeltetővel találkoztunk nagyvállalatoknál, akik közvetlenül foglalkoznak generatív AI-val. ezt megfigyeltük infrastruktúra-szállítók Valószínűleg a piac eddigi legnagyobb nyertesei, megragadva a veremben folyó dollárok többségét. Alkalmazási cégek nagyon gyorsan növekszik a felső vonal bevétele, de gyakran küzdenek a megtartással, a termékdifferenciálással és a bruttó árréssel. És a legtöbb modellszolgáltatók, bár felelősek e piac létezéséért, még nem értek el nagy kereskedelmi méreteket.

Más szóval, a legtöbb értéket létrehozó – azaz generatív mesterséges intelligencia-modelleket kiképző és új alkalmazásokban való alkalmazást végző – vállalatok nem ragadták meg a legtöbbet. Sokkal nehezebb megjósolni, hogy mi fog történni. De úgy gondoljuk, hogy a legfontosabb, hogy megértsük, hogy a verem mely részei igazán megkülönböztethetők és védhetőek. Ez jelentős hatással lesz a piac szerkezetére (azaz a horizontális vs. vertikális vállalati fejlődésre) és a hosszú távú érték mozgatórugóira (pl. árrések és megtartás). Eddig nehezen találtunk szerkezeti védhetőséget bárhol a veremben, az inkumbensek hagyományos vizesárkjain kívül.

Hihetetlenül nagy lendülettel foglalkozunk a generatív AI-val kapcsolatban, és úgy gondoljuk, hogy ennek hatalmas hatása lesz a szoftveriparban és azon túl is. Ennek a bejegyzésnek a célja, hogy feltérképezze a piac dinamikáját, és választ adjon a generatív AI üzleti modellekkel kapcsolatos tágabb kérdésekre.

Magas szintű technológiai halom: infrastruktúra, modellek és alkalmazások

Ahhoz, hogy megértsük, hogyan formálódik a generatív mesterséges intelligencia piac, először is meg kell határoznunk, hogyan néz ki a halom ma. Íme az előzetes véleményünk.

A köteg három rétegre osztható:

- Alkalmazási területek amelyek generatív mesterséges intelligencia modelleket integrálnak egy felhasználóbarát termékbe, akár saját modellfolyamatokat futtatnak („végpontok közötti alkalmazások”), akár harmadik fél API-jára támaszkodnak.

- Modellek amelyek az AI-termékeket működtetik, amelyeket akár szabadalmaztatott API-kként, akár nyílt forráskódú ellenőrzőpontokként tettek elérhetővé (amelyek viszont tárhelymegoldást igényelnek)

- Infrastruktúra szállítók (azaz felhőplatformok és hardvergyártók), amelyek képzési és következtetési munkaterheléseket futtatnak a generatív AI modellekhez

Fontos megjegyezni: ez nem egy piaci térkép, hanem egy keret a piac elemzéséhez. Minden kategóriában felsoroltunk néhány példát a jól ismert szállítókról. Nem tettünk kísérletet arra, hogy átfogóak legyünk, vagy felsoroljuk az összes kiadott csodálatos generatív AI-alkalmazást. Itt nem megyünk mélyre az MLops vagy az LLMops eszközökkel kapcsolatban, amelyek még nem nagyon szabványosítottak, és egy későbbi bejegyzésben lesz szó róla.

A generatív mesterséges intelligencia-alkalmazások első hulláma kezdi elérni a méreteket, de küzdenek a megtartással és a differenciálódással

A korábbi technológiai ciklusokban a hagyományos bölcsesség az volt, hogy egy nagy, független vállalat felépítéséhez a végfelhasználónak kell lennie – akár egyéni fogyasztókat, akár B2B vásárlókat jelent. Csábító azt hinni, hogy a generatív AI legnagyobb vállalatai is végfelhasználói alkalmazások lesznek. Egyelőre nem világos, hogy ez a helyzet.

Az biztos, hogy a generatív mesterségesintelligencia-alkalmazások növekedése megdöbbentő volt, a puszta újdonságok és a használati esetek sokasága által. Valójában legalább három termékkategóriáról tudunk, amelyek évesített bevétele már meghaladta a 100 millió dollárt: a képalkotás, a szövegírás és a kódírás.

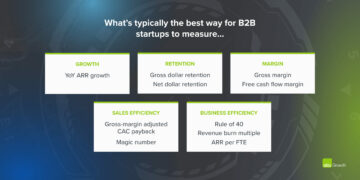

A növekedés azonban önmagában nem elegendő a tartós szoftvercégek felépítéséhez. Lényeges, hogy a növekedésnek nyereségesnek kell lennie – abban az értelemben, hogy a felhasználók és az ügyfelek a regisztráció után nyereséget termelnek (magas bruttó haszon), és hosszú ideig kitartanak (magas megtartás). Erős technikai különbségtétel hiányában a B2B és B2C alkalmazások hálózati hatások, adatok megtartása vagy egyre összetettebb munkafolyamatok felépítése révén hosszú távú vásárlói értéket teremtenek.

A generatív AI-ban ezek a feltételezések nem feltétlenül igazak. Azon alkalmazásgyártó cégeknél, amelyekkel beszéltünk, a bruttó haszonkulcsok széles skálája létezik – néhány esetben akár 90%, de gyakrabban 50-60%, amelyet nagyrészt a modellkövetkeztetés költségei határoznak meg. A csatorna felső részének növekedése elképesztő volt, de nem világos, hogy a jelenlegi ügyfélszerzési stratégiák méretezhetőek lesznek-e – már most azt látjuk, hogy a fizetett akvizíció hatékonysága és megtartása csökkenni kezd. Sok alkalmazás is viszonylag megkülönböztethetetlen, mivel hasonló mögöttes mesterséges intelligencia-modellekre támaszkodnak, és nem fedeztek fel olyan nyilvánvaló hálózati hatásokat vagy adat-/munkafolyamatokat, amelyeket a versenytársak nehezen tudnának megkettőzni.

Tehát még nem nyilvánvaló, hogy a végfelhasználói alkalmazások értékesítése az egyetlen, sőt a legjobb út a fenntartható, generatív AI-üzletág felépítéséhez. A haszonkulcsoknak javulniuk kell a verseny és a nyelvi modellek hatékonyságának növekedésével (erről lentebb olvashat bővebben). A megtartásnak növekednie kell, ahogy az AI-turisták elhagyják a piacot. És erős érv szól amellett, hogy a vertikálisan integrált alkalmazások előnyt jelentenek a megkülönböztetésben. De van még mit bizonyítani.

A jövőre nézve a generatív AI-alkalmazásokat gyártó cégek előtt álló nagy kérdések közé tartozik:

- Függőleges integráció („modell + alkalmazás”). Az AI-modellek szolgáltatásként történő felhasználása lehetővé teszi az alkalmazásfejlesztők számára, hogy egy kis csapattal gyorsan iteráljanak, és a technológia fejlődésével modellszolgáltatókat cseréljenek. A másik oldalon egyes fejlesztők azzal érvelnek, hogy a termék is a modellt, és hogy a nulláról való képzés az egyetlen módja a védhetőség megteremtésének – azaz a védett termékadatok folyamatos újraképzésével. Ennek azonban sokkal magasabb tőkeigénye és kevésbé fürge termékcsapat az ára.

- Építési funkciók és alkalmazások. A generatív mesterséges intelligencia termékeknek számos különböző formája van: asztali alkalmazások, mobilalkalmazások, Figma/Photoshop beépülő modulok, Chrome-bővítmények, sőt Discord-botok is. Könnyű integrálni az AI-termékeket, ahol a felhasználók már dolgoznak, mivel a felhasználói felület általában csak egy szövegdoboz. Ezek közül melyik válik önálló vállalattá – és melyeket veszik át az inkumbensek, például a Microsoft vagy a Google, amelyek már beépítik a mesterséges intelligenciát termékvonalaikba?

- Menedzsment a hype cikluson keresztül. Egyelőre nem világos, hogy a lemorzsolódás a generatív mesterségesintelligencia-termékek jelenlegi tétele, vagy egy korai piac műterméke. Vagy ha a generatív mesterséges intelligencia iránti érdeklődés megnövekszik, ahogy a hírverés alábbhagy. Ezek a kérdések fontos vonatkozásúak az alkalmazáscégek számára, beleértve azt is, hogy mikor kell lenyomni a gázpedált az adománygyűjtés során; milyen agresszíven kell befektetni az ügyfélszerzésbe; mely felhasználói szegmenseket kell előnyben részesíteni; és mikor kell termékpiaci alkalmasnak nyilvánítani.

A modellszolgáltatók feltalálták a generatív mesterséges intelligenciát, de még nem értek el nagy kereskedelmi méreteket

Amit most generatív AI-nak nevezünk, az nem létezne az olyan zseniális kutató- és mérnöki munka nélkül, amelyet olyan helyeken végeznek, mint a Google, az OpenAI és a Stabilitás. Az új modellarchitektúrák és a képzési csővezetékek méretezésére tett hősies erőfeszítések révén mindannyian profitálunk a jelenlegi nagy nyelvi modellek (LLM) és képgeneráló modellek elképesztő képességeiből.

Az ezekhez a cégekhez kapcsolódó bevétel azonban még mindig viszonylag kicsi a használathoz és a nyüzsgéshez képest. A képgenerálás során a Stable Diffusion robbanásszerű közösségi növekedést mutatott, amelyet a felhasználói felületek, a hosztolt ajánlatok és a finomhangolási módszerek ökoszisztémája támogat. A Stabilitás azonban üzleti tevékenységük alapelveként ingyenesen adja át főbb ellenőrző pontjaikat. A természetes nyelvi modellekben az OpenAI dominál a GPT-3/3.5-tel és a ChatGPT-vel. De viszonylag Kevés OpenAI-ra épített gyilkos alkalmazás létezik eddig, és az árak már megvannak egyszer leesett.

Lehet, hogy ez csak átmeneti jelenség. A Stabilitás egy új cég, amely még nem a bevételszerzésre összpontosított. Az OpenAI hatalmas üzletté válhat, amely az összes NLP kategória bevételének jelentős részét szerzi, ahogy egyre több gyilkos alkalmazás készül – különösen, ha integrálása a Microsoft termékportfóliójába simán megy. Tekintettel ezeknek a modelleknek a hatalmas használatára, a nagy bevételek sem maradhatnak el.

De vannak ellensúlyozó erők is. A nyílt forráskódúként kiadott modelleket bárki tárolhatja, beleértve azokat a külső cégeket is, amelyek nem viselik a nagyszabású modellképzéssel járó költségeket (akár több tíz- vagy százmillió dollárt). És nem világos, hogy a zárt forráskódú modellek a végtelenségig megőrzik-e előnyüket. Kezdjük például azt látni, hogy az olyan vállalatok által épített LLM-ek, mint az Anthropic, a Cohere és a Character.ai, közelebb kerülnek az OpenAI teljesítményszintjéhez, hasonló adatkészleteken (azaz az interneten) és hasonló modellarchitektúrával oktatva. A stabil diffúzió példája arra utal if A nyílt forráskódú modellek elérik a teljesítmény és a közösségi támogatás megfelelő szintjét, akkor a védett alternatívák nehezen vehetik fel a versenyt.

A modellszolgáltatók számára eddig talán az a legvilágosabb következtetés, hogy a kereskedelmi forgalomba hozatal valószínűleg a tárhelyszolgáltatáshoz kötődik. A szabadalmaztatott API-k iránti kereslet (például az OpenAI-tól) gyorsan növekszik. A nyílt forráskódú modellek tárhelyszolgáltatásai (pl. Hugging Face és Replicate) a modellek egyszerű megosztásához és integrálásához hasznos csomópontokká válnak – és még közvetett hálózati hatásuk is van a modellgyártók és a fogyasztók között. Van egy erős hipotézis is, amely szerint a vállalati ügyfelekkel kötött finomhangolási és tárhely-szerződések révén lehetséges a bevételszerzés.

Ezen túlmenően azonban számos nagy kérdés áll a modellszolgáltatók előtt:

- Kommodizálás. Az a közhiedelem, hogy az AI-modellek teljesítménye idővel konvergál. Az alkalmazásfejlesztőkkel beszélgetve egyértelmű, hogy ez még nem történt meg, mind a szöveges, mind a képi modellekben erős vezetők vannak. Előnyeik nem az egyedi modellarchitektúrákon alapulnak, hanem a magas tőkekövetelményen, a védett termékinterakciós adatokon és a szűkös mesterségesintelligencia-tehetségen. Ez tartós előnyként fog szolgálni?

- Érettségi kockázat. A modellszolgáltatókra támaszkodva nagyszerű lehetőség az alkalmazáscégek számára az induláshoz, sőt még vállalkozásuk bővítéséhez is. De ösztönzést kapnak arra, hogy saját modelleket építsenek és/vagy tároljanak, amint elérik a méreteket. És sok modellszolgáltató erősen torz ügyféleloszlással rendelkezik, és néhány alkalmazás teszi ki a bevételek nagy részét. Mi történik, ha/amikor ezek az ügyfelek házon belüli AI-fejlesztésre váltanak?

- Fontos a pénz? A generatív mesterséges intelligencia ígérete olyan nagy – és potenciálisan olyan káros is –, hogy sok modellszolgáltató közhasznú társasággá (B-alakulat) szerveződött, korlátozott nyereségrészesedést bocsátott ki, vagy más módon kifejezetten beépítette a közjót küldetésébe. Ez egyáltalán nem akadályozta az adománygyűjtési erőfeszítéseiket. De ésszerű vitát kell folytatni arról, hogy a legtöbb modellszolgáltató valóban akar hogy megragadják az értéket, és ha kell.

Az infrastruktúra-szállítók mindenhez hozzányúlnak, és learatják a jutalmakat

A generatív AI-ban szinte minden átmegy egy felhőalapú GPU-n (vagy TPU-n) egy bizonyos ponton. Legyen szó modellszolgáltatókról/kutatólaboratóriumokról, amelyek képzési terhelést folytatnak, tárhelyszolgáltató cégeknek, amelyek következtetéseket/finomhangolást végeznek, vagy alkalmazásokat gyártó cégeknek, amelyek a kettő kombinációját végzik – papucsok a generatív mesterséges intelligencia éltető elemei. Nagyon hosszú idő óta először fordul elő, hogy a legrombolóbb számítástechnika terén elért haladás masszívan számításokhoz kötött.

Ennek eredményeként a generatív mesterséges intelligencia piacán a pénz nagy része végül az infrastrukturális vállalatokhoz áramlik. Néhányat tenni nagyon durva számok körülötte: Becsléseink szerint az alkalmazásvállalatok átlagosan bevételük 20-40%-át költik következtetésekre és ügyfelenkénti finomhangolásra. Ezt általában közvetlenül a felhőszolgáltatóknak fizetik ki számítási példányokért, vagy harmadik fél modellszolgáltatóknak – akik viszont bevételük felét felhőinfrastruktúrára költik. Tehát ésszerű azt feltételezni, hogy a 10-20%-a összes bevétel a generatív AI-ban ma a felhőszolgáltatókhoz kerül.

Ráadásul a saját modelljüket oktató startupok több milliárd dollárnyi kockázati tőkét gyűjtöttek össze – ennek nagy részét (a korai körökben akár 80-90%-át is) jellemzően szintén a felhőszolgáltatóknál költik el. Sok állami technológiai vállalat évente százmilliókat költ modellképzésre, akár külső felhőszolgáltatókkal, akár közvetlenül hardvergyártókkal.

Ez az, amit technikailag „sok pénznek” neveznénk – különösen egy kialakuló piacon. A legtöbbet a Nagy 3 felhők: Amazon Web Services (AWS), Google Cloud Platform (GCP) és Microsoft Azure. Ezek a felhőszolgáltatók együttesen többet költeni, mint $ 100 milliárd évente capexben, hogy biztosítsák a legátfogóbb, legmegbízhatóbb és legköltséghatékonyabb platformokat. Különösen a generatív mesterséges intelligencia esetében a kínálati korlátokból is profitálnak, mivel kedvezményes hozzáférésük van a szűkös hardverekhez (például Nvidia A100 és H100 GPU-khoz).

Érdekes módon azonban kezdünk látni, hogy hiteles verseny alakul ki. Az olyan kihívók, mint az Oracle, nagy beruházási ráfordításokkal és értékesítési ösztönzőkkel léptek előre. Néhány startup pedig, mint például a Coreweave és a Lambda Labs, gyorsan növekedett a kifejezetten nagy modellfejlesztőket célzó megoldásokkal. Versenyeznek a költségek, a rendelkezésre állás és a személyre szabott támogatás terén. Ezenkívül részletesebb erőforrás-absztrakciókat (azaz konténereket) tesznek közzé, míg a nagy felhők a GPU virtualizációs korlátai miatt csak VM-példányokat kínálnak.

A színfalak mögött, az AI-terhelések túlnyomó többségének futtatása, talán a generatív AI eddigi legnagyobb nyertese: az Nvidia. A cég 3.8 dollárt jelentett milliárd az adatközponti GPU bevételből a 2023-as pénzügyi év harmadik negyedévében, beleértve a generatív mesterséges intelligencia felhasználási esetek jelentős részét. Erős árkot építettek az üzlet köré a GPU-architektúrába való több évtizedes befektetéssel, egy robusztus szoftver-ökoszisztémával és az akadémiai közösségben való széles körű felhasználással. Egy friss elemzés azt találta, hogy az Nvidia GPU-kra 90-szer többet hivatkoznak a kutatási cikkek, mint a legjobb mesterséges intelligenciachipeket együttvéve..

Más hardver opciók is léteznek, beleértve a Google Tensor Processing Unit-okat (TPU-k); AMD Instinct GPU-k; AWS Inferentia és Trainium chipek; és mesterséges intelligenciagyorsítók olyan induló vállalkozásoktól, mint a Cerebras, a Sambanova és a Graphcore. Az Intel a játék késői szakaszában szintén belép a piacra csúcskategóriás Habana chipjeivel és Ponte Vecchio GPU-ival. De eddig ezek közül az új chipek közül csak kevés szerzett jelentős piaci részesedést. A két figyelendő kivétel a Google, amelynek TPU-i a Stable Diffusion közösségben és néhány nagy GCP-ügyletben nyertek teret, valamint a TSMC, amelyről úgy gondolják, hogy gyárt. minden az itt felsorolt chipek közül, beleértve az Nvidia GPU-kat (az Intel saját fabjai és TSMC keverékét használja a chipek gyártásához).

Más szóval, az infrastruktúra egy jövedelmező, tartós és látszólag védhető réteg a veremben. Az infravállalatok számára megválaszolandó nagy kérdések a következők:

- Az állapot nélküli munkaterhelések megtartása. Az Nvidia GPU-k bárhol is bérelnek, ugyanazok. A legtöbb mesterséges intelligencia munkaterhelés állapot nélküli, abban az értelemben, hogy a modellkövetkeztetéshez nincs szükség csatolt adatbázisokra vagy tárhelyre (kivéve maguknak a modellsúlyoknak). Ez azt jelenti, hogy az AI-munkaterhelések jobban hordozhatók felhőkön keresztül, mint a hagyományos alkalmazások munkaterhelései. Ebben az összefüggésben hogyan tudnak a felhőszolgáltatók ragaszkodni, és megakadályozni, hogy az ügyfelek a legolcsóbb megoldásra ugorjanak?

- Túlélni a chiphiány végét. A felhőszolgáltatók és magának az Nvidiának az árképzését a legkívánatosabb GPU-k szűkös mennyisége támogatja. Az egyik szolgáltató azt mondta nekünk, hogy az A100-as listaára valóban megvan <p></p> megjelenése óta, ami rendkívül szokatlan a számítási hardverek számára. Ha ez a kínálati korlát végül megszűnik a megnövekedett termelés és/vagy új hardverplatformok bevezetése révén, milyen hatással lesz ez a felhőszolgáltatókra?

- Áttörhet egy kihívó felhő? Erősen hiszünk ebben függőleges felhők speciálisabb ajánlatokkal veszi át a piaci részesedést a Big 3-tól. A mesterséges intelligencia terén eddig a kihívók jelentős vonzerőt hoztak létre a mérsékelt technikai differenciálás és az Nvidia támogatása révén – akik számára az inkumbens felhőszolgáltatók a legnagyobb ügyfelek és a feltörekvő versenytársak is. A hosszú távú kérdés az, hogy ez elég lesz-e a Big 3 méretbeli előnyeinek leküzdéséhez?

Szóval… hol fog gyarapodni az érték?

Persze, még nem tudjuk. De a generatív mesterséges intelligencia korai adatai alapján, kombinálva ezzel korábbi AI/ML cégekkel szerzett tapasztalataink, intuíciónk a következő.

Ma úgy tűnik, hogy a generatív mesterséges intelligencia nem tartalmaz rendszerszintű árkot. Elsőrendű közelítésként az alkalmazásokból hiányzik az erős termékdifferenciálás, mivel hasonló modelleket használnak; a modellek hosszú távú differenciálódása nem egyértelmű, mivel hasonló architektúrájú, hasonló adatkészletekre képezték ki őket; a felhőszolgáltatók nem rendelkeznek mély technikai különbségtétellel, mivel ugyanazokat a GPU-kat futtatják; és még a hardvercégek is ugyanazokon a gyártókon gyártják a chipeiket.

Léteznek természetesen a szabványos árkok: méretarok ("Nekem több pénzem van vagy tudok gyűjteni, mint neked!"), ellátási láncárok ("Nekem megvannak a GPU-k, neked nincs!"), ökoszisztémaárok (" Mindenki használja már a szoftveremet!”), algoritmikus árkok („Okosabbak vagyunk, mint te!”), terjesztési árkok („Már van értékesítési csapatom és több ügyfelem, mint neked!”) és adatfolyam-árok („Én” többet jártam az internetet, mint te!”). De ezek a vizesárkok egyike sem tartós hosszú távon. És még túl korai megmondani, hogy erős, közvetlen hálózati hatások érvényesülnek-e a verem bármely rétegében.

A rendelkezésre álló adatok alapján egyszerűen nem világos, hogy lesz-e hosszú távú, győztes dinamika a generatív AI-ban.

Ez furcsa. De számunkra ez jó hír. Ennek a piacnak a potenciális méretét nehéz megragadni – valahol a kettő között minden szoftver és a minden emberi törekvés — tehát sok-sok játékosra és egészséges versenyre számítunk a stack minden szintjén. Azt is elvárjuk, hogy mind a horizontális, mind a vertikális vállalatok sikeresek legyenek, a végpiacok és a végfelhasználók által diktált legjobb megközelítéssel. Például, ha a végtermékben az elsődleges különbségtétel maga a mesterséges intelligencia, akkor valószínű, hogy a vertikálisozás (vagyis a felhasználónak szánt alkalmazás szoros összekapcsolása az otthoni modellel) nyer. Míg ha az AI egy nagyobb, hosszú farkú funkciókészlet része, akkor valószínűbb, hogy vízszintessé válik. Természetesen az idő múlásával tradicionálisabb árkok építését is látnunk kell – és még az is előfordulhat, hogy új típusú vizesárkok honosodnak meg.

Bárhogy is legyen, egy dologban biztosak vagyunk, hogy a generatív AI megváltoztatja a játékot. Mindannyian valós időben tanuljuk a szabályokat, óriási érték fog feloldódni, és ennek eredményeként a technológiai környezet sokkal-sokkal másképp fog kinézni. És itt vagyunk érte!

A bejegyzésben szereplő összes kép a Midjourney segítségével készült.

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- Platoblockchain. Web3 metaverzum intelligencia. Felerősített tudás. Hozzáférés itt.

- Forrás: https://a16z.com/2023/01/19/who-owns-the-generative-ai-platform/

- 100 millió $

- $3

- 1

- a

- A100

- Rólunk

- egyetemi

- gyorsítók

- hozzáférés

- elért

- beszerzés

- át

- tulajdonképpen

- Örökbefogadás

- előlegek

- Előny

- előnyei

- Után

- megállapodások

- előre

- AI

- AI platform

- ai használati esetek

- AI / ML

- algoritmikus

- Minden termék

- lehetővé teszi, hogy

- kizárólag

- már

- alternatívák

- elképesztő

- amazon

- Az Amazon Web Services

- Amazon Web Services (AWS)

- AMD

- összeg

- elemez

- és a

- évesített

- válasz

- bárki

- API-k

- app

- megjelenik

- Alkalmazás

- alkalmazások

- Alkalmazása

- megközelítés

- alkalmazások

- építészet

- érvel

- érv

- körül

- mesterséges

- mesterséges intelligencia

- Mesterséges intelligencia (AI)

- társult

- elérhetőség

- elérhető

- átlagos

- AWS

- AWS Inferentia

- Égszínkék

- B2B

- B2C

- alapján

- Viselik

- mert

- válik

- előtt

- mögött

- hit

- Hisz

- úgy

- hívők

- lent

- haszon

- BEST

- között

- Túl

- Nagy

- Legnagyobb

- Billió

- milliárd

- bumm

- botok

- köteles

- Doboz

- szünet

- ragyogó

- tágabb

- épít

- Épület

- épült

- Bullish

- üzleti

- vállalkozások

- vásárlók

- hívás

- képességek

- tőke

- elfog

- Rögzítése

- eset

- esetek

- kategóriák

- Kategória

- Központ

- bizonyos

- kihívó

- Változások

- karakter

- ChatGPT

- legolcsóbb

- csip

- játékpénz

- króm

- idézett

- világos

- közelebb

- felhő

- felhő infrastruktúra

- Felhő platform

- kód

- együttesen

- kombináció

- kombinált

- hogyan

- kereskedelmi

- kereskedelmi

- Közös

- közösség

- Companies

- vállalat

- képest

- versenyez

- verseny

- versenytársak

- bonyolult

- átfogó

- Kiszámít

- számítástechnika

- korlátok

- Fogyasztók

- Konténerek

- kontextus

- folyamatosan

- hagyományos

- konvergálni

- szövegírás

- Mag

- Corporations

- Költség

- kiadások

- tanfolyam

- teremt

- készítette

- létrehozása

- hihető

- kritikai

- Jelenlegi

- vevő

- Ügyfelek

- ciklusok

- dátum

- Adatközpont

- adatbázisok

- adatkészletek

- üzlet

- Ajánlatok

- évtizedek

- mély

- Kereslet

- asztali

- Fejleszt

- fejlesztők

- Fejlesztés

- fejlesztőkkel

- különböző

- különböző formák

- differenciált

- Diffusion

- közvetlen

- közvetlenül

- viszály

- felfedezett

- vita

- bomlasztó

- terjesztés

- disztribúció

- megosztott

- Ennek

- dollár

- uralja

- ne

- tucat

- hajtás

- hajtott

- illesztőprogramok

- vezetés

- dinamikus

- dinamika

- minden

- Korábban

- Korai

- bevételt hozó

- könnyen

- ökoszisztéma

- él

- hatások

- hatékonyság

- erőfeszítések

- bármelyik

- csiszolókő

- Mérnöki

- elég

- biztosítására

- Vállalkozás

- vállalati ügyfelek

- különösen

- becslés

- Még

- végül is

- minden

- példa

- példák

- vár

- tapasztalat

- kiterjesztések

- külső

- Arc

- néző

- Esik

- Funkció

- Jellemzők

- kevés

- Találjon

- megtalálása

- vezetéknév

- első

- Fiscal

- megfelelő

- Flip

- Folyó

- flow

- összpontosított

- következő

- erők

- formák

- talált

- Alapítvány

- alapítók

- Keretrendszer

- Ingyenes

- ból ből

- Jótékonysági

- jövő

- Nyereség

- játék

- GAS

- általában

- generál

- generáció

- nemző

- Generatív AI

- kap

- adott

- ad

- cél

- Goes

- megy

- jó

- A Google Cloud

- Google Cloud Platform

- GPU

- GPU

- fogás

- nagy

- bruttó

- Nő

- Növekvő

- felnőtt

- Növekedés

- fél

- történik

- történt

- megtörténik

- Kemény

- hardver

- káros

- egészséges

- itt

- Magas

- <p></p>

- nagyon

- történeti

- Találat

- tart

- holding

- Vízszintes

- vendéglátó

- házigazdája

- tárhely

- FORRÓ

- Hogyan

- HTTPS

- hatalmas

- emberi

- Több száz

- több száz millió

- hype

- kép

- képalkotás

- képek

- Hatás

- következményei

- fontos

- javul

- in

- Más

- Ösztönző

- Ösztönzők

- tartalmaz

- Beleértve

- Bejegyzett

- amely magában foglalja

- Növelje

- <p></p>

- Növeli

- egyre inkább

- hihetetlenül

- háruló

- független

- egyéni

- ipar

- Infrastruktúra

- velejáró

- integrálni

- integrált

- integráció

- Intel

- Intelligencia

- kölcsönhatás

- kamat

- interfészek

- Internet

- intuíció

- Feltalált

- befektet

- beruházás

- Kiadott

- IT

- maga

- Kulcs

- Ismer

- Labs

- hiány

- táj

- nyelv

- nagy

- nagyarányú

- nagymértékben

- nagyobb

- keresztnév

- Tavaly

- Késő

- indít

- réteg

- tojók

- vezetők

- tanulás

- Szabadság

- szint

- szintek

- Valószínű

- határértékek

- vonalak

- Lista

- Listázott

- Hosszú

- hosszú idő

- hosszú lejáratú

- néz

- MEGJELENÉS

- Sok

- Elő/Utó

- jövedelmező

- készült

- fenntartása

- fontos

- Többség

- csinál

- Gyártók

- sok

- térkép

- margók

- piacára

- piaci térkép

- Piaci struktúra

- piacok

- tömeges

- masszívan

- max-width

- jelentőségteljes

- eszközök

- mód

- microsoft

- Microsoft Azure

- Mid Journey

- millió

- Több millió

- Küldetés

- MLOps

- Mobil

- mobil-alkalmazásokat

- modell

- modellek

- bevételszerzési

- bevételt

- pénz

- több

- a legtöbb

- többszörös

- születő

- Természetes

- Természetes nyelv

- szükségszerűen

- Szükség

- hálózat

- Új

- új hardver

- hír

- következő

- fürge

- NLP

- regény

- újdonság

- szám

- számok

- Nvidia

- Nyilvánvaló

- ajánlat

- Ajánlat

- ONE

- nyitva

- nyílt forráskódú

- OpenAI

- üzemeltetők

- opció

- Opciók

- jóslat

- rendelés

- Szervezett

- Más

- másképp

- kívül

- Overcome

- saját

- tulajdonosa

- fizetett

- papírok

- rész

- különös

- alkatrészek

- bérletek

- ösvény

- teljesítmény

- talán

- Személyre

- jelenség

- csővezeték

- Hely

- Helyek

- emelvény

- Platformok

- Plató

- Platón adatintelligencia

- PlatoData

- játékos

- rengeteg

- Plugins

- pont

- lehetséges

- állás

- potenciális

- potenciálisan

- hatalom

- előrejelzésére

- megakadályozása

- ár

- Áraink

- elsődleges

- Előzetes

- Fontossági sorrendet

- feldolgozás

- Termelők

- Termékek

- Termelés

- Termékek

- Nyereség

- nyereséges

- nyereség

- Haladás

- ígéret

- szabadalmazott

- Bizonyít

- ellátó

- szolgáltatók

- nyilvános

- tesz

- Negyed

- kérdés

- Kérdések

- gyorsan

- emel

- emelt

- hatótávolság

- gyorsan

- el

- elérte

- igazi

- real-time

- ésszerű

- új

- nyilvántartások

- viszonylag

- felszabaduló

- megbízható

- eltávolított

- Bérlés

- képviselő

- szükség

- követelmények

- kutatás

- forrás

- felelős

- eredményez

- visszatartás

- jövedelem

- bevételek

- Kockázat

- erős

- fordulóban

- szabályok

- futás

- futás

- értékesítés

- Értékesítési ösztönzők

- azonos

- skálázható

- Skála

- Szűkös

- Hiány

- jelenetek

- látás

- szegmensek

- Eladási

- értelemben

- szolgál

- szolgáltatás

- Szolgáltatások

- készlet

- beállítás

- számos

- Alak

- Megosztás

- Megoszt

- kellene

- előadás

- <p></p>

- jelentős

- hasonló

- óta

- Méret

- kicsi

- simán

- So

- eddig

- szoftver

- megoldások

- Megoldások

- néhány

- valahol

- forrás

- specializált

- kifejezetten

- költ

- költött

- Stabilitás

- stabil

- verem

- állapota

- állvány

- önálló

- standard

- kezdet

- kezdődött

- Kezdve

- indítás

- Startups

- bot

- Még mindig

- tárolás

- stratégiák

- erős

- szerkezeti

- struktúra

- Küzdelem

- sikerül

- elegendő

- javasolja,

- kínálat

- támogatás

- Támogatott

- túlfeszültség

- fenntartható

- kapcsoló

- szisztémás

- Vesz

- bevétel

- Tehetség

- beszéd

- célzott

- feladatok

- csapat

- tech

- tech cégek

- Műszaki

- Technológia

- ideiglenes

- feltételek

- A

- azok

- maguk

- dolog

- Harmadik

- harmadik fél

- három

- Keresztül

- Bekötött

- szorosan

- idő

- alkalommal

- nak nek

- Ma

- is

- felső

- érintse

- vontatás

- hagyományos

- kiképzett

- Képzések

- Átalakítás

- borzasztó

- Trends

- igaz

- tsmc

- FORDULAT

- típusok

- jellemzően

- ui

- Végül

- mögöttes

- megért

- egyedi

- egységek

- szokatlan

- us

- Használat

- használ

- használó

- Felhasználók

- érték

- Hatalmas

- gyártók

- vállalkozás

- kockázati tőke

- keresztül

- Megnézem

- Nézz

- hullám

- háló

- webes szolgáltatások

- jól ismert

- Mit

- vajon

- ami

- míg

- WHO

- széles

- Széleskörű

- Wikipedia

- lesz

- nyer

- nyertesei

- bölcsesség

- nélkül

- szavak

- Munka

- munkafolyamatok

- írás

- év

- zephyrnet