A Midjourney-vel generált

A vállalatok a világ minden szegletében és minden iparágban rohannak, hogy integrálják a nagy nyelvi modellek (LLM-ek), mint például az OpenAI ChatGPT, az Anthropic's Claude és az AI12Lab Jurassic teljesítményét, hogy növeljék a teljesítményt az üzleti alkalmazások széles skálájában, például piackutatásban, ügyfélszolgálatban. és tartalomgenerálás.

Az LLM-alkalmazások vállalati léptékű felépítése azonban más eszközkészletet és megértést igényel, mint a hagyományos gépi tanulási (ML) alkalmazások. Azoknak az üzletvezetőknek és vezetőknek, akik meg akarják őrizni a márkahangot és a megbízható szolgáltatásminőséget, mélyebben meg kell érteniük az LLM-ek működését, valamint az LLM-alkalmazáskészletben található különféle eszközök előnyeit és hátrányait.

Ebben a cikkben bemutatjuk azt a magas szintű stratégiát és eszközöket, amelyekre LLM-alkalmazások létrehozásához és futtatásához lesz szüksége vállalkozása számára.

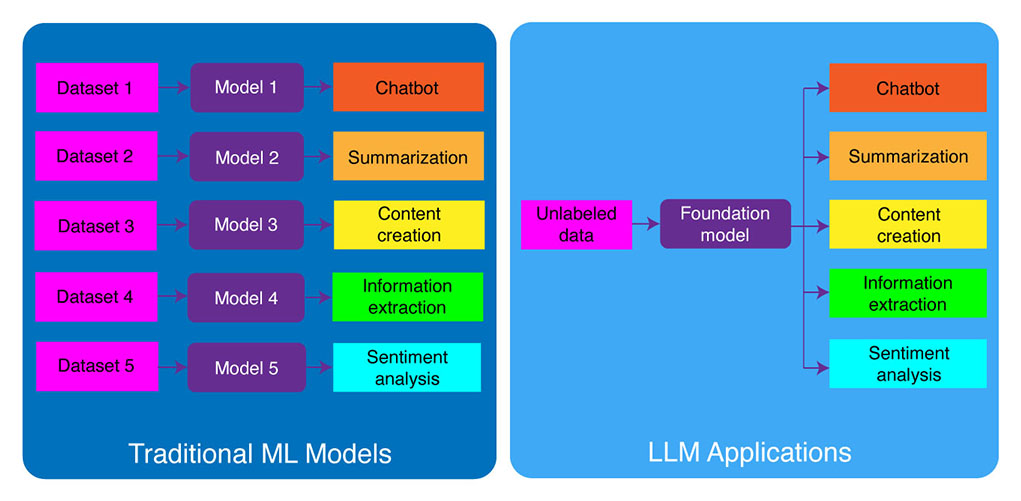

Hagyományos ML fejlesztés vs. LLM alkalmazások

A hagyományos gépi tanulási modellek feladatspecifikusak voltak, ami azt jelenti, hogy minden egyes feladathoz külön modellt kellett készíteni. Például, ha az ügyfelek véleményét szeretné elemezni, akkor létre kell hoznia egy modellt, ha pedig ügyfélszolgálati chatbotot, akkor egy másik modellt.

A feladatspecifikus ML-modellek felépítésének és betanításának ez a folyamata időigényes és sok adatot igényel. A különböző ML-modellek betanításához szükséges adatkészletek típusa is változhat a feladattól függően. Ahhoz, hogy egy modellt betaníthasson az ügyfelek véleményének elemzésére, szükség van egy olyan ügyfélvélemények adathalmazára, amelyeket a megfelelő véleménnyel (pozitív, negatív, semleges) jelöltek meg. Ahhoz, hogy megtanítson egy modellt egy ügyfélszolgálati chatbot felépítéséhez, szüksége lesz az ügyfelek és a műszaki támogatás közötti beszélgetések adatkészletére.

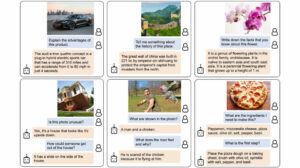

A nagy nyelvi modellek megváltoztatták ezt. Az LLM-ek előképzettek egy hatalmas szöveg- és kódadatkészletre, amely lehetővé teszi számukra, hogy a feladatok széles skáláján jól teljesítsenek, beleértve a következőket:

- Szöveges összefoglaló

- Tartalom létrehozása

- Fordítás

- Információ kinyerése

- Kérdés válasz

- Hangulatelemzés

- Ügyfélszolgálat

- Vevőszolgálat

Az LLM alkalmazások fejlesztésének folyamata négy alapvető lépésre bontható:

- Válassza ki a megfelelő alapozó modellt. Ez egy kulcsfontosságú összetevő, amely meghatározza az Ön LLM-alkalmazásának teljesítményét.

- Szükség esetén testreszabhatja a modellt. Előfordulhat, hogy finomhangolnia kell a modellt, vagy ki kell egészítenie további tudásbázissal, hogy megfeleljen sajátos igényeinek.

- Állítsa be az ML infrastruktúrát. Ez magában foglalja az alkalmazás futtatásához szükséges hardvert és szoftvert (azaz félvezetőket, chipeket, felhőtárhelyet, következtetéseket és telepítést).

- Bővítse alkalmazását további eszközökkel. Ezek az eszközök segíthetnek az alkalmazás hatékonyságának, teljesítményének és biztonságának javításában.

Most pedig vessünk egy pillantást a megfelelő technológiai kötegre.

Ha ez a mélyreható oktatási tartalom hasznos az Ön számára, iratkozz fel AI levelezőlistánkra figyelmeztetni kell, ha új anyagot adunk ki.

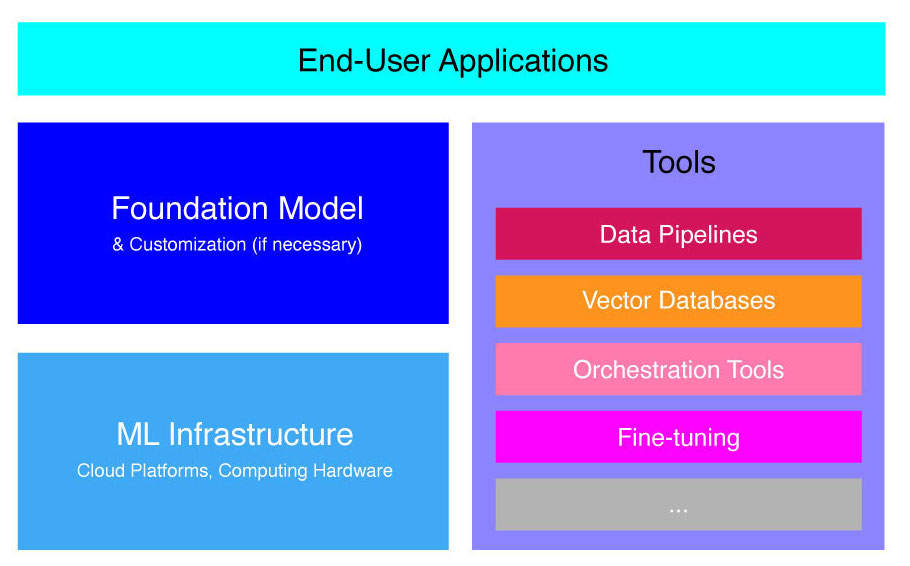

Magas szintű LLM Application Stack

Az LLM alkalmazások számos kulcsfontosságú összetevőre épülnek, többek között:

- Alapozó modell, amely bizonyos használati esetekben testreszabást igényelhet.

- ML infrastruktúra elegendő számítási erőforráshoz felhőplatformokon vagy a vállalat saját hardverén keresztül.

- További eszközök, mint például adatfolyamatok, vektoros adatbázisok, hangszerelési eszközök, finomhangoló ML platformok, modellteljesítmény-figyelő eszközök stb.

Röviden végigvezetjük ezeket az összetevőket, hogy jobban megértse az LLM-alkalmazások felépítéséhez és üzembe helyezéséhez szükséges eszközkészletet.

Mik azok az alapozó modellek?

Egyetlen előre képzett LLM használatával rengeteg időt és erőforrást takaríthat meg. Egy ilyen modell alapoktól való betanítása azonban időszerű és költséges folyamat, amely néhány technológiai vezető kivételével meghaladja a legtöbb vállalat képességeit.

Számos vállalat és kutatócsoport képezte ki ezeket a modelleket, és lehetővé teszi más vállalatok számára is a használatukat. A vezető példák közé tartozik a ChatGPT, a Claude, a Llama, a Jurassic és a T5. Ezeket a nyilvános modelleket alapmodelleknek nevezzük. Némelyikük szabadalmaztatott, és API-hívásokkal térítés ellenében érhető el. Mások nyílt forráskódúak, és ingyenesen használhatók. Ezek a modellek a címkézetlen szöveges adatok hatalmas adathalmazára vannak előképzettek, lehetővé téve számukra a feladatok széles skáláját, a kreatív hirdetésmásolatok létrehozásától egészen az ügyfelekkel való anyanyelvükön történő kommunikációig a vállalat nevében.

Az alapítványi modelleknek két fő típusa van: szabadalmaztatott és nyílt forráskódú.

Szabadalmaztatott modellek egyetlen cég vagy szervezet tulajdonában vannak, és jellemzően csak térítés ellenében érhetők el. A szabadalmaztatott modellek legnépszerűbb példái közé tartozik az OpenAI GPT modellje, az Anthropic Claude modellje és az AI21 Labs Jurassic modellje.

Nyílt forráskódú modellek általában ingyenesen elérhetőek bárki számára, aki használni akarja őket. Egyes nyílt forráskódú modellek azonban korlátozottak a használatukban, például: (1) csak kutatási célokra érhetők el, (2) csak bizonyos méretű vállalatok számára érhetők el kereskedelmi használatra. A nyílt forráskódú közösség azt állítja, hogy az ilyen korlátozások alkalmazása nem teszi lehetővé, hogy egy modell „nyílt forráskódúnak” minősüljön. Ennek ellenére az ingyenesen használható nyelvi modellek legszembetűnőbb példái közé tartoznak a Meta Llama modelljei, az Abu Dhabi Technology Innovation Institute Falcon modelljei és a Stability AI StableLM modelljei. További információ a nyílt forráskódú modellekről és a kapcsolódó kockázatokról itt.

Most beszéljünk meg néhány tényezőt, amelyeket figyelembe kell venni az LLM-alkalmazás alapmodelljének kiválasztásakor.

Válasszon egy alapozó modellt

A legjobb alapmodell kiválasztása LLM-alkalmazásához kihívást jelenthet, de alapvetően három lépésre bonthatjuk:

- Válasszon szabadalmaztatott és nyílt forráskódú modellek közül. A szabadalmaztatott modellek általában nagyobbak és hatékonyabbak, mint a nyílt forráskódú modellek, de használatuk drágább és kevésbé rugalmas lehet. Ezenkívül a kód nem olyan átlátszó, ami megnehezíti a hibakeresést vagy a védett modellek teljesítményével kapcsolatos problémák elhárítását. A nyílt forráskódú modellek viszont általában kevesebb frissítést és kevesebb támogatást kapnak a fejlesztőktől.

- Válassza ki a modell méretét. A nagyobb modellek általában jobban teljesítenek olyan feladatokat, amelyek sok ismeretet igényelnek, például kérdések megválaszolása vagy kreatív szöveg generálása. A nagyobb modellek azonban számítási szempontból költségesebbek is. Kezdje azzal, hogy nagyobb modellekkel kísérletezik, majd léphet a kisebbekre, amíg a modell teljesítménye kielégíti az Ön használati esetét.

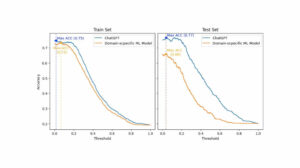

- Válasszon ki egy adott modellt. Kezdje az általános referenciaértékek áttekintésével, hogy kiválaszthassa a tesztelendő modelleket. Ezután folytassa a különböző modellek tesztelésével az alkalmazás-specifikus feladatokhoz. Egyéni teljesítményértékeléshez fontolja meg a számítást BLEU és ROUGE pontszámok, azok a mérőszámok, amelyek segítenek számszerűsíteni a mesterséges intelligencia által generált szöveghez szükséges javítások számát, mielőtt kiadnák a kimenetet a humán alkalmazásokhoz.

A különböző nyelvi modellek közötti különbségek jobb megértéséhez tekintse meg a következőt áttekintésünk a legerősebb nyelvi (LLM) és vizuális nyelvi modellekről (VLM).

Miután kiválasztotta az alkalmazásához szükséges alapmodellt, mérlegelheti, hogy szükség van-e a modell testreszabására a még jobb teljesítmény érdekében.

Testreszabjon egy alapozó modellt

Egyes esetekben érdemes lehet testre szabni egy alapnyelvi modellt a jobb teljesítmény érdekében az adott használati esetben. Például érdemes lehet optimalizálni egy bizonyos:

- Domén. Ha meghatározott területeken, például jogi, pénzügyi vagy egészségügyi területen működik, érdemes lehet bővíteni a modell szókincsét ezen a tartományon, hogy jobban megértse a végfelhasználói lekérdezéseket és válaszoljon rájuk.

- Feladat. Ha például azt szeretné, hogy a modell marketingkampányokat generáljon, megadhat konkrét példákat a márkás marketingtartalomra. Ez segít a modellnek megtanulni azokat a mintákat és stílusokat, amelyek megfelelnek az Ön vállalatának és közönségének.

- Hangnem. Ha a modellnek egy adott hangszín használatára van szüksége, testreszabhatja a modellt egy adatkészleten, amely példákat tartalmaz a célnyelvi mintákra.

Három lehetséges módja van az alapnyelvi modell testreszabásának:

- Finomhangolás: körülbelül 100-500 rekordból álló, tartományspecifikus címkézett adatkészletet biztosít a modellnek. A modell súlyozása frissül, ami jobb teljesítményt fog eredményezni az adatkészlet által képviselt feladatokban.

- Domain adaptáció: egy tartomány-specifikus, címkézetlen adatkészlettel látja el a modellt, amely a megfelelő tartományból származó adatok nagy részét tartalmazza. A modell súlyai ebben az esetben is frissülnek.

- Információ visszakeresés: zárt tartományú tudással bővíti az alapozási modellt. A modellt nem képezik újra, és a modell súlya változatlan marad. A modell azonban képes információkat lekérni egy releváns adatokat tartalmazó vektoradatbázisból.

Az első két megközelítés jelentős számítási erőforrásokat igényel a modell átképzéséhez, ami általában csak a testreszabás kezeléséhez megfelelő műszaki tehetséggel rendelkező nagyvállalatok számára valósítható meg. A kisebb vállalatok általában azt az elterjedtebb megközelítést alkalmazzák, hogy a modellt tartományismerettel egészítik ki egy vektoros adatbázison keresztül, amelyet a cikk későbbi részében az LLM-eszközökről szóló részben részletezünk.

Állítsa be az ML infrastruktúrát

Az LLMOps környezet ML infrastruktúra összetevője magában foglalja a felhőplatformokat, a számítási hardvert és az LLM-ek telepítéséhez és futtatásához szükséges egyéb erőforrásokat. Ez az összetevő különösen fontos, ha úgy dönt, hogy nyílt forráskódú modellt használ, vagy testreszabja a modellt az alkalmazásához. Ebben az esetben jelentős számítási erőforrásokra lehet szüksége a modell szükség szerinti finomhangolásához és futtatásához.

Számos felhőplatform kínál szolgáltatásokat az LLM-ek telepítéséhez, köztük a Google Cloud Platform, az Amazon Web Services és a Microsoft Azure. Ezek a platformok számos olyan funkciót kínálnak, amelyek megkönnyítik az LLM-ek telepítését és futtatását, többek között:

- Előre betanított modellek, amelyek az adott alkalmazáshoz finomhangolhatók

- Felügyelt infrastruktúra, amely gondoskodik a mögöttes hardverről és szoftverről

- Eszközök és szolgáltatások az LLM-ek figyeléséhez és hibakereséséhez

A szükséges számítási erőforrások mennyisége a modell méretétől és összetettségétől, az elvégzendő feladatoktól, valamint az üzleti tevékenység mértékétől függ, ahol a modellt telepíteni kívánja.

Bővítse eszközökkel

További LLM szomszédos eszközök használhatók az LLM-alkalmazás teljesítményének további növelésére.

Adatfolyamok

Ha az adatait az LLM-termékben kell használnia, az adat-előfeldolgozási folyamat az új technológiai stack alapvető pillére lesz, akárcsak a hagyományos vállalati AI-veremben. Ezek az eszközök közé tartoznak a csatlakozási szoftverek bármilyen forrásból származó adatok feldolgozásához, egy adatátalakítási réteg és a későbbi összekötők. A vezető adatfolyam-szolgáltatók, például a Databricks és a Snowflake, valamint az olyan új szereplők, mint az Unstructured, megkönnyítik a fejlesztők számára a természetes nyelvi adatok nagy és rendkívül heterogén korpuszainak (pl. PDF-ek ezrei, PowerPoint prezentációk, csevegési naplók, másolt HTML, stb.) egyetlen hozzáférési pontra, vagy akár egyetlen dokumentumba, amelyet tovább használhatnak az LLM alkalmazások.

vektoros adatbázisok

A nagy nyelvi modellek egyszerre néhány ezer szó feldolgozására korlátozódnak, így nem képesek önállóan hatékonyan feldolgozni a nagy dokumentumokat. A nagy dokumentumok erejének kihasználásához a vállalkozásoknak vektoros adatbázisokat kell használniuk.

A vektoradatbázisok olyan tárolórendszerek, amelyek az adatfolyamokon keresztül fogadott nagy dokumentumokat kezelhető vektorokká vagy beágyazásokká alakítják. Az LLM-alkalmazások ezután lekérdezhetik ezeket az adatbázisokat, hogy pontosan meghatározzák a megfelelő vektorokat, és csak a szükséges információrögöket nyerik ki.

A jelenleg elérhető legjelentősebb vektoros adatbázisok közül néhány a Pinecone, a Chroma és a Weaviate.

Hangszerelési eszközök

Amikor egy felhasználó lekérdezést küld az Ön LLM-alkalmazásához, például egy kérdést az ügyfélszolgálatnak, az alkalmazásnak egy sor promptot kell összeállítania, mielőtt elküldi ezt a lekérdezést a nyelvi modellnek. A nyelvi modellhez intézett végső kérés jellemzően egy, a fejlesztő által keményen kódolt prompt sablonból, az érvényes kimenetek példáiból, amelyeket néhány példányos példának nevezett, a külső API-kból lekért szükséges információkból, valamint a vektoradatbázisból visszakeresett releváns dokumentumokból áll. . Az olyan cégek hangszerelési eszközei, mint a LangChain vagy a LlamaIndex segíthetnek egyszerűsíteni ezt a folyamatot azáltal, hogy használatra kész keretrendszert biztosítanak a promptok kezelésére és végrehajtására.

Finomhangolás

A hatalmas adathalmazokra kiképzett nagy nyelvi modellek nyelvtanilag helyes és gördülékeny szöveget állíthatnak elő. Előfordulhat azonban, hogy bizonyos területeken, például az orvostudományban vagy a jogban, hiányzik a pontosságuk. Ezeknek a modelleknek a tartományspecifikus adatkészleteken történő finomhangolása lehetővé teszi számukra, hogy internalizálják e területek egyedi jellemzőit, javítva a releváns szöveg létrehozásának képességét.

Az LLM finomhangolása költségigényes folyamat lehet a kisvállalatok számára. Az olyan cégek megoldásai azonban, mint a Weights & Biases és az OctoML, segíthetnek az egyszerűsített és hatékony finomhangolásban. Ezek a megoldások platformot biztosítanak a vállalatok számára az LLM-ek finomhangolásához anélkül, hogy saját infrastruktúrájukba kellene fektetniük.

egyéb eszközök

Számos egyéb eszköz is hasznos lehet LLM-alkalmazások létrehozásához és futtatásához. Például szükség lehet címkéző eszközökre, ha finomhangolni szeretné a modellt az adott adatmintákkal. Előfordulhat, hogy speciális eszközöket is telepíthet az alkalmazás teljesítményének nyomon követésére, mivel az alapmodell kisebb módosításai vagy az ügyfelek kérései is jelentősen befolyásolhatják az értesítések teljesítményét. Végül, vannak olyan eszközök, amelyek felügyelik a modellek biztonságát, és segítenek elkerülni a gyűlöletkeltő tartalmakat, a veszélyes ajánlásokat vagy az elfogultságokat. Ezeknek a különféle eszközöknek a szükségessége és fontossága az Ön konkrét felhasználási esetétől függ.

Mi a következő lépés az LLM alkalmazásfejlesztésben?

Az LLM-termékfejlesztés itt tárgyalt négy lépése minden vállalat generatív AI-stratégiájának alapvető alapja, amely nagy nyelvi modelleket hasznosít. Fontosak a nem műszaki üzleti vezetők számára, hogy megértsék őket, még akkor is, ha a részleteket egy technikai csapat végzi. A jövőben részletesebb oktatóanyagokat teszünk közzé arról, hogyan hasznosíthatjuk a generatív AI-eszközök széles skáláját a piacon. Egyelőre megteheti Iratkozzon fel hírlevelünkre hogy megkapja a legújabb frissítéseket.

Tetszett ez a cikk? Regisztráljon további vállalati AI-frissítésekért.

Értesíteni fogunk, ha több ehhez hasonló összefoglaló cikket adunk ki.

Összefüggő

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Autóipar / elektromos járművek, Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- BlockOffsets. A környezetvédelmi ellentételezési tulajdon korszerűsítése. Hozzáférés itt.

- Forrás: https://www.topbots.com/llm-product-development-technology-stack/

- :is

- :nem

- :ahol

- $ UP

- 1

- a

- képesség

- Rólunk

- abu dhabi

- hozzáférés

- igénybe vett

- tevékenység

- Ad

- További

- Ezen kívül

- szomszédos

- AI

- AI stratégia

- lehetővé

- megengedett

- lehetővé teszi, hogy

- Is

- amazon

- Az Amazon Web Services

- összeg

- an

- elemez

- és a

- Másik

- Antropikus

- bármilyen

- bárki

- api

- API-k

- Alkalmazás

- Application Development

- alkalmazások

- megközelítés

- megközelít

- megfelelő

- VANNAK

- területek

- cikkben

- cikkek

- AS

- társult

- At

- közönség

- elérhető

- elkerülése érdekében

- Égszínkék

- bázis

- Alapvetően

- BE

- óta

- előtt

- nevében

- hogy

- benchmarking

- referenciaértékek

- BEST

- Jobb

- között

- Túl

- torzítások

- fellendítésére

- Doboz

- márka

- márkás

- szünet

- tömören

- Törött

- épít

- Épület

- épült

- üzleti

- Üzleti alkalmazások

- Üzleti vezetők

- vállalkozások

- de

- by

- kiszámítása

- hívott

- kéri

- Kampányok

- TUD

- képességek

- képes

- ami

- eset

- esetek

- bizonyos

- kihívást

- megváltozott

- Változások

- chatbot

- ChatGPT

- ellenőrizze

- játékpénz

- A pop-art design, négy időzóna kijelzése egyszerre és méretének arányai azok az érvek, amelyek a NeXtime Time Zones-t kiváló választássá teszik. Válassza a

- választja

- választott

- követelések

- felhő

- Cloud Hosting

- Felhő platform

- kód

- kereskedelmi

- Közös

- kommunikáció

- közösség

- Companies

- vállalat

- Társaságé

- bonyolultság

- összetevő

- alkatrészek

- áll

- számítástechnika

- Hátrányok

- Fontolja

- konstrukció

- tartalmaz

- tartalom

- beszélgetések

- példányban

- Sarok

- kijavítására

- Hiba

- Megfelelő

- drága

- Kreatív

- Jelenleg

- szokás

- vevő

- Vevőszolgálat

- Vevőszolgálat

- Ügyfelek

- testreszabás

- testre

- Veszélyes

- dátum

- adatbázis

- adatbázisok

- Adattárak

- adatkészletek

- mélyebb

- meghatározó

- attól

- telepíteni

- bevezetéséhez

- bevetés

- részlet

- részletes

- részletek

- Fejleszt

- Fejlesztő

- fejlesztők

- fejlesztése

- Fejlesztés

- Dhabi

- különbségek

- különböző

- nehéz

- megvitatni

- tárgyalt

- dokumentum

- dokumentumok

- Nem

- domain

- domainek

- le-

- e

- minden

- könnyű

- nevelési

- hatékonyan

- hatékonyság

- hatékony

- elit

- lehetővé téve

- növelése

- fokozása

- gazdagítják

- Vállalkozás

- különösen

- alapvető

- stb.

- Eter (ETH)

- Még

- Minden

- példa

- példák

- Kivéve

- végrehajtó

- vezetők

- drága

- külső

- tényezők

- sólyom

- megvalósítható

- Jellemzők

- díj

- kevés

- kevesebb

- utolsó

- Végül

- pénzügyi

- vezetéknév

- rugalmas

- A

- Alapítvány

- négy

- keretek

- Ingyenes

- ból ből

- további

- jövő

- általános

- generál

- generáló

- generáció

- nemző

- Generatív AI

- kap

- Ad

- földgolyó

- Go

- megy

- A Google Cloud

- Google Cloud Platform

- Földi

- kéz

- hardver

- hám

- Legyen

- tekintettel

- egészségügyi

- segít

- itt

- magas szinten

- nagyon

- tárhely

- Hogyan

- How To

- azonban

- HTML

- HTTPS

- i

- if

- Hatás

- végrehajtási

- fontosság

- fontos

- javul

- in

- mélyreható

- tartalmaz

- magában foglalja a

- Beleértve

- ipar

- információ

- Infrastruktúra

- Innováció

- Intézet

- integrálni

- bele

- Bevezetés

- befektet

- IT

- jpg

- éppen

- Kulcs

- Kedves

- Ismer

- tudás

- címkézés

- Labs

- hiány

- táj

- nyelv

- nagy

- nagyobb

- a későbbiekben

- legutolsó

- Legújabb frissítések

- Törvény

- réteg

- vezetők

- vezető

- TANUL

- tanulás

- Jogi

- kevesebb

- Tőkeáttétel

- kihasználja

- mint

- korlátozások

- Korlátozott

- Láma

- Hosszú

- néz

- Sok

- gép

- gépi tanulás

- Fő

- csinál

- KÉSZÍT

- kezelése

- kezelése

- sok

- piacára

- piackutatás

- Marketing

- Marketing kampányok

- piactér

- tömeges

- anyag

- max-width

- Lehet..

- jelenti

- orvostudomány

- Találkozik

- meta

- Metrics

- microsoft

- Microsoft Azure

- esetleg

- kisebb

- ML

- modell

- modellek

- monitor

- ellenőrzés

- több

- a legtöbb

- Legnepszerubb

- bennszülött

- Természetes

- Természetes nyelv

- elengedhetetlen

- Szükség

- szükséges

- igények

- negatív

- Semleges

- Új

- Új Tech

- Hírlevél

- következő

- nem műszaki

- Most

- szám

- of

- ajánlat

- on

- ONE

- azok

- csak

- nyílt forráskódú

- OpenAI

- működik

- Optimalizálja

- or

- hangszerelés

- szervezet

- Más

- Egyéb

- mi

- ki

- teljesítmény

- áttekintés

- saját

- tulajdonú

- minták

- teljesít

- teljesítmény

- előadó

- Pillér

- csővezeték

- emelvény

- Platformok

- Plató

- Platón adatintelligencia

- PlatoData

- játékos

- pont

- Népszerű

- pozitív

- lehetséges

- hatalom

- erős

- Pontosság

- Előadások

- problémák

- folyamat

- feldolgozás

- gyárt

- Termékek

- termékfejlesztés

- kiemelkedő

- támogatása

- szabadalmazott

- PROS

- ad

- szolgáltatók

- biztosít

- amely

- közzétesz

- célokra

- elhelyezés

- jogosultak

- világítás

- lekérdezések

- kérdés

- Kérdések

- hatótávolság

- Olvass

- kap

- ajánlások

- nyilvántartások

- engedje

- felszabadító

- megbízható

- képviselők

- kérni

- kéri

- szükség

- megköveteli,

- kutatás

- Tudástár

- Reagálni

- korlátozások

- eredményez

- felülvizsgálata

- Vélemények

- jobb

- kockázatok

- futás

- futás

- Biztonság

- azonos

- Megtakarítás

- Skála

- Rész

- biztonság

- Félvezetők

- érzés

- különálló

- Series of

- szolgáltatás

- Szolgáltatások

- készlet

- számos

- kellene

- <p></p>

- jelentős

- jelentősen

- egyetlen

- Méret

- kicsi

- kisebb

- So

- szoftver

- Megoldások

- néhány

- forrás

- különleges

- Stabilitás

- verem

- kezdet

- tartózkodás

- Lépései

- Még mindig

- tárolás

- Stratégia

- áramvonal

- áramvonalas

- stílusok

- ilyen

- elegendő

- ÖSSZEFOGLALÓ

- támogatás

- Systems

- Vesz

- tart

- Tehetség

- cél

- Feladat

- feladatok

- csapat

- csapat

- tech

- Műszaki

- technikai támogatás

- Technológia

- technológiai innováció

- sablon

- Tesztelés

- mint

- hogy

- A

- A jövő

- azok

- Őket

- akkor

- Ott.

- Ezek

- ők

- ezt

- azok

- ezer

- három

- Keresztül

- idő

- időigényes

- nak nek

- TONE

- Hangnem

- eszköztár

- szerszámok

- felső

- TOPBOTOK

- hagyományos

- Vonat

- kiképzett

- Képzések

- Átalakítás

- Átalakítás

- átlátszó

- oktatóanyagok

- kettő

- típusok

- jellemzően

- mögöttes

- megért

- megértés

- egyedi

- egyedi tulajdonságok

- frissítve

- Frissítés

- használ

- használati eset

- használt

- használó

- rendszerint

- különféle

- keresztül

- Hang

- vs

- akar

- kívánatos

- akar

- módon

- we

- háló

- webes szolgáltatások

- JÓL

- voltak

- amikor

- vajon

- ami

- WHO

- széles

- Széleskörű

- lesz

- val vel

- nélkül

- szavak

- Munka

- lenne

- te

- A te

- zephyrnet