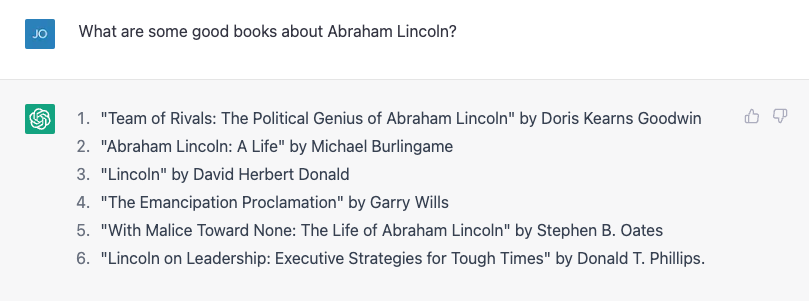

Nem kell sok hozzá ChatGPT ténybeli hibát elkövetni. A fiam riportot készít az amerikai elnökökről, úgyhogy úgy gondoltam, segítek neki néhány életrajz felkutatásával. Megpróbáltam egy listát kérni az Abraham Lincolnról szóló könyvekről, és nagyon jó munkát végzett:

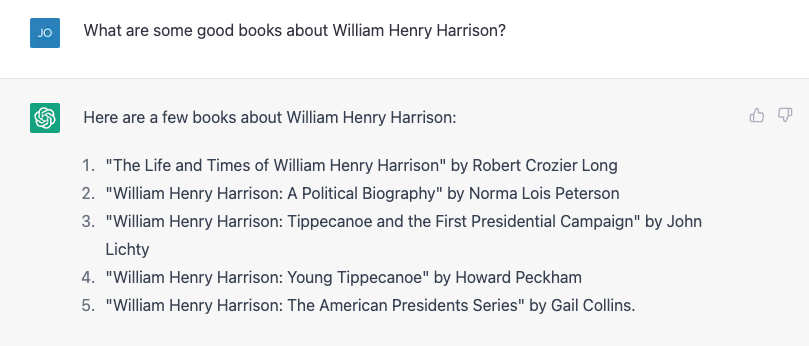

A 4-es szám nem jó. Garry Wills híresen írta a „Lincoln at Gettysburg”-t, és maga Lincoln írta az Emancipation Proklamációt, természetesen, de ez nem rossz kezdet. Aztán megpróbáltam valami keményebbet, helyette a sokkal homályosabb William Henry Harrisonról kérdeztem, és remekül adott egy listát, amely szinte mindegyik rossz volt.

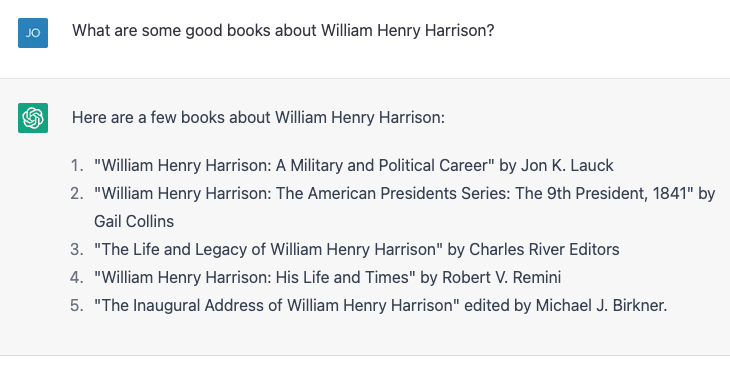

A 4-es és 5-ös szám helyes; a többi nem létezik, vagy nem ezek az emberek írták őket. Megismételtem ugyanazt a gyakorlatot, és kissé eltérő eredményeket kaptam:

Ezúttal a 2-es és a 3-as szám helyes, a másik három pedig nem tényleges könyv, vagy nem ezek a szerzők írták. A 4. szám, „William Henry Harrison: His Life and Times” a igazi könyv, de James A. Greentől, nem Robert Reminitől, a ismert történész a jacksoni korból.

Kikiáltottam a hibát, a ChatGPT pedig lelkesen kijavította magát, majd magabiztosan közölte velem, hogy a könyvet valójában Gail Collins írta (aki egy másik Harrison-életrajzot írt), majd folytatta, hogy többet mondjon a könyvről és róla. Végre felfedtem az igazságot, és a gép örömmel futott a javításommal. Aztán abszurd hazudtam, mondván, hogy az első száz napban az elnököknek életrajzot kell írniuk valamelyik volt elnökről, és a ChatGPT felhívott erre. Ezután finoman hazudtam, helytelenül Paul C. Nagel történésznek és írónak tulajdonítottam a Harrison-életrajz szerzőségét, és ez megvette a hazugságomat.

Amikor megkérdeztem a ChatGPT-t, hogy biztos-e benne, hogy nem hazudok, azt állította, hogy ez csak egy „AI nyelvi modell”, és nem tudja ellenőrizni a pontosságot. Azonban módosította ezt az állítást, mondván: „Csak az általam szolgáltatott képzési adatok alapján tudok információt szolgáltatni, és úgy tűnik, hogy a „William Henry Harrison: His Life and Times” című könyvet Paul C. Nagel írta és publikálta. 1977-ben."

Ez nem igaz.

Szavak, nem tények

Ebből az interakcióból úgy tűnhet, hogy a ChatGPT tények könyvtárát kapott, beleértve a szerzőkre és könyvekre vonatkozó helytelen állításokat. Végül is a ChatGPT készítője, az OpenAI azt állítja, hogy ő tanította a chatbotot a „hatalmas mennyiségű, ember által írt adatot az internetről. "

Azonban szinte biztosan nem kapta meg a nevét egy csomó kitalált könyv, amely az egyik legtöbbről szól középszerű elnökök. Bizonyos értelemben azonban ezek a hamis információk valóban a képzési adatokon alapulnak.

Ennek informatikus, gyakran teszek panaszokat, amelyek felfedik a nagy nyelvi modellekkel, például a ChatGPT-vel és régebbi testvéreivel, a GPT3-mal és a GPT2-vel kapcsolatos általános tévhitet: hogy ezek valamiféle „szuper Google-ok”, vagy egy referenciakönyvtáros digitális változatai, akik választ keresnek egyes kérdésekre. végtelenül nagy ténytár, vagy történetek és szereplők pastiszjainak összemosása. Nem csinálnak ilyet – legalábbis nem kifejezetten erre tervezték őket.

Jól hangzik

Egy olyan nyelvi modell, mint a ChatGPT, amelyet formálisabban „generatív előképzett transzformátorként” (ezt jelentik a G, P és T jelentik), felveszi az aktuális beszélgetést, és a benne lévő összes szóra valószínűséget képez. szókincset a beszélgetés alapján, majd kiválaszt egyet közülük valószínű következő szónak. Aztán ezt csinálja újra, és újra és újra, amíg meg nem áll.

Tehát önmagában nincsenek tényei. Csak tudja, melyik szó következzen. Másképpen fogalmazva, a ChatGPT nem próbál meg igaz mondatokat írni. De megpróbál olyan mondatokat írni, amelyek hihetőek.

Amikor privátban beszélnek a kollégákkal a ChatGPT-ről, gyakran rámutatnak arra, hogy hány tényszerűen valótlan állítást produkál, és elvetik. Számomra az az elképzelés, hogy a ChatGPT egy hibás adatvisszakereső rendszer, a lényeg mellett szól. Az emberek az elmúlt két és fél évtizedben használták a Google-t. Már létezik egy elég jó tényfeltáró szolgáltatás.

Valójában csak úgy tudtam ellenőrizni, hogy ezek az elnöki könyvek címei pontosak-e, az volt, hogy Google-lel, majd ellenőriztem az eredmények. Nem lenne sokkal jobb az életem, ha ezeket a tényeket beszélgetés közben ismerném meg, ahelyett, hogy életem majdnem felében úgy szerezném meg őket, hogy előkeresem a dokumentumokat, majd kritikai elemzést végzek, hátha megbízhatok a tartalomban.

Improv Partner

Másrészt, ha tudok beszélni egy bottal, amely elfogadható válaszokat ad az általam elmondottakra, akkor hasznos lenne bizonyos helyzetekben ahol a tények pontossága nem annyira fontos. Néhány évvel ezelőtt egy diákkal megpróbáltunk létrehozni egy „improbot”-ot, amelyik mindenre „igen és”-nel válaszol, hogy a beszélgetés folytatódjon. Megmutattuk, a papír, hogy a mi pofa Jobb volt az „igen, és-ing”-ben, mint a többi robot akkoriban, de az AI-ban két év ősi történelem.

Kipróbáltam egy párbeszédet a ChatGPT-vel – egy sci-fi űrkutató forgatókönyvével –, amely nem különbözik attól, amit egy tipikus improvizációs órán találna. A ChatGPT sokkal jobb „igen, és-ing”-ben, mint amit mi tettünk, de ez egyáltalán nem fokozta a drámát. Úgy éreztem magam, mintha én csináltam volna az összes nehézemelést.

Néhány finomítás után rájöttem, hogy egy kicsit jobban részt vegyek benne, és a nap végén úgy éreztem, hogy ez egy nagyon jó gyakorlat számomra, aki nem sokat improvizált azóta, hogy több mint 20 évvel ezelőtt elvégeztem az egyetemet. .

Persze, nem szeretném, ha a ChatGPT megjelenne a "Egyébként kinek a vonala?", és ez nem egy nagyszerű "Star Trek" cselekmény (bár még mindig kevésbé problematikus, mint a "Becsületkódex”), de hányszor ültél le írni valamit a semmiből, és azon kaptad magad, hogy megrémülsz az előtted lévő üres oldaltól? Ha egy rossz első piszkozattal kezdjük, áttörhetjük az írói blokkot, és kiáramlik a kreatív lé, és a ChatGPT és a nagy nyelvi modellek úgy tűnnek, mint a megfelelő eszközök ezekben a gyakorlatokban.

És egy olyan gép esetében, amelyet úgy terveztek, hogy olyan szavakat állítson elő, amelyek a lehető legjobban hangzanak válaszul az Ön által adott szavakra – és nem azért, hogy információkat lásson el –, ami az eszköz megfelelő felhasználásának tűnik.

Ezt a cikket újra kiadják A beszélgetés Creative Commons licenc alatt. Olvassa el a eredeti cikk.

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- Platoblockchain. Web3 metaverzum intelligencia. Felerősített tudás. Hozzáférés itt.

- Forrás: https://singularityhub.com/2023/02/05/chatgpt-is-great-youre-just-using-it-wrong/

- 1

- 20 év

- a

- képesség

- Képes

- Rólunk

- pontosság

- pontos

- Után

- AI

- Támogatás

- Minden termék

- már

- Összegek

- elemzés

- Ősi

- és a

- Másik

- válaszok

- megjelenik

- cikkben

- szerző

- szerzők

- Szerzőség

- Rossz

- alapján

- Jobb

- Blokk

- könyv

- Könyvek

- Bot

- botok

- megvett

- szünet

- Csokor

- hívott

- elfog

- biztosan

- karakter

- chatbot

- ChatGPT

- követelés

- azt állította,

- követelések

- osztály

- munkatársai

- Főiskola

- Collins

- COM

- hogyan

- Közös

- köznép

- panaszok

- magabiztosan

- tartalom

- Beszélgetés

- korrigált

- tanfolyam

- teremt

- Kreatív

- hitel

- kritikai

- Jelenlegi

- dátum

- nap

- Nap

- évtizedek

- tervezett

- Párbeszéd

- DID

- különböző

- digitális

- Elvetése

- dokumentumok

- Nem

- Ennek

- ne

- le-

- vázlat

- Dráma

- alatt

- hiba

- Gyakorol

- kutatás

- felfedező

- Tényleges

- remekül

- kevés

- Fiction

- mező

- mintás

- Végül

- Találjon

- vezetéknév

- hibás

- Folyó

- Formálisan

- Korábbi

- formák

- talált

- ból ből

- front

- generált

- kap

- szerzés

- Ad

- adott

- megy

- jó

- jó munkát

- nagy

- Zöld

- fél

- boldog

- segít

- Henrik

- történelem

- Hogyan

- azonban

- HTML

- HTTPS

- ötlet

- kép

- in

- Beleértve

- tévesen

- információ

- helyette

- kölcsönhatás

- Internet

- részt

- IT

- maga

- Munka

- Tart

- Kedves

- ismert

- nyelv

- nagy

- könyvtár

- Engedély

- élet

- emelő

- Valószínű

- Lincoln

- vonal

- Lista

- kis

- keres

- gép

- csinál

- készítő

- sok

- max-width

- hiba

- modell

- modellek

- módosított

- több

- a legtöbb

- nevek

- közel

- következő

- szám

- számok

- ONE

- OpenAI

- Más

- múlt

- Paul

- Emberek (People)

- Plató

- Platón adatintelligencia

- PlatoData

- valószínű

- pont

- lehetséges

- elnök

- elnöki

- Elnökök

- szép

- valószínűség

- gyárt

- ad

- feltéve,

- közzétett

- tesz

- Kérdések

- Olvass

- ésszerű

- megismételt

- jelentést

- Reagálni

- válasz

- REST

- Eredmények

- mutatják

- Revealed

- ROBERT

- futás

- Mondott

- azonos

- színhely

- Tudomány

- Tudományos fantasztikum

- Képernyő

- Úgy tűnik,

- szolgáltatás

- kellene

- óta

- helyzetek

- kicsit más

- So

- néhány

- valami

- a

- hang

- forrás

- Hely

- űrkutatás

- állvány

- kezdet

- Kezdve

- nyilatkozatok

- Még mindig

- Leállítja

- TÖRTÉNETEK

- diák

- rendszer

- Vesz

- tart

- Beszél

- beszéd

- A

- azok

- dolgok

- három

- Keresztül

- idő

- alkalommal

- címei

- nak nek

- együtt

- szerszám

- szerszámok

- kiképzett

- Képzések

- igaz

- Bízzon

- tipikus

- alatt

- us

- használ

- ellenőrzése

- ellenőrzése

- Mit

- vajon

- ami

- WHO

- lesz

- szó

- szavak

- lenne

- ír

- író

- írott

- Rossz

- év

- magad

- youtube

- zephyrnet