स्वचालित बूटस्ट्रैप विधि का उपयोग करके मशीन लर्निंग में प्रदर्शन मेट्रिक्स के लिए आत्मविश्वास अंतराल की गणना कैसे करें

क्या आपके मॉडल का प्रदर्शन माप "बड़े" परीक्षण सेट के कारण बहुत सटीक है, या "छोटे" या असंतुलित परीक्षण सेट के कारण बहुत अनिश्चित है?

By डेविड बी रोसेन (पीएचडी), आईबीएम ग्लोबल फाइनेंसिंग में स्वचालित क्रेडिट अनुमोदन के लिए लीड डेटा वैज्ञानिक

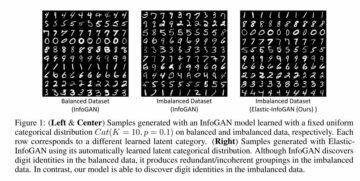

नारंगी रेखा 89.7% को संतुलित सटीकता विश्वास अंतराल की निचली सीमा के रूप में दर्शाती है, हरी रेखा मूल देखी गई संतुलित सटीकता=92.4% (बिंदु अनुमान) के लिए, और लाल 94.7% की ऊपरी सीमा को दर्शाती है। (यह और सभी चित्र लेखक द्वारा हैं जब तक कि अन्यथा उल्लेख न किया गया हो।)

परिचय

यदि आप अपने क्लासिफायरियर के प्रदर्शन को परीक्षण सेट पर सटीकता = 94.8% और एफ1 = 92.3% के रूप में रिपोर्ट करते हैं, तो परीक्षण सेट के आकार और संरचना के बारे में कुछ जाने बिना इसका कोई मतलब नहीं है। उन प्रदर्शन मापों की त्रुटि का मार्जिन परीक्षण सेट के आकार के आधार पर, या, असंतुलित डेटासेट के लिए, मुख्य रूप से कितने स्वतंत्र उदाहरणों पर निर्भर करता है, बहुत भिन्न होगा अल्पसंख्यक इसमें शामिल क्लास (ओवरसैंपलिंग से समान उदाहरणों की अधिक प्रतियां इस उद्देश्य के लिए मदद नहीं करती हैं)।

यदि आप समान मूल का एक अन्य, स्वतंत्र परीक्षण सेट एकत्र करने में सक्षम थे, तो इस डेटासेट पर आपके मॉडल की सटीकता और F1 समान होने की संभावना नहीं है, लेकिन वे संभावित रूप से कितने भिन्न हो सकते हैं? इसी से मिलते-जुलते प्रश्न का उत्तर आंकड़ों में इस प्रकार दिया गया है विश्वास अंतराल माप का.

यदि हमें अंतर्निहित जनसंख्या से कई स्वतंत्र नमूना डेटासेट लेने थे, तो उनमें से 95% डेटासेट के लिए, मीट्रिक का वास्तविक अंतर्निहित जनसंख्या मूल्य 95% विश्वास अंतराल के भीतर होगा जिसे हम उस विशेष नमूना डेटासेट के लिए गणना करेंगे।

इस लेख में हम आपको दिखाएंगे कि बूटस्ट्रैप विधि के साथ एक साथ किसी भी संख्या में मशीन लर्निंग प्रदर्शन मेट्रिक्स के लिए आत्मविश्वास अंतराल की गणना कैसे करें स्वतः यह निर्धारित करता है कि डिफ़ॉल्ट रूप से कितने बूट नमूना डेटासेट उत्पन्न करने हैं।

यदि आप केवल यह देखना चाहते हैं कि विश्वास अंतराल की गणना करने के लिए इस कोड को कैसे लागू किया जाए, तो अनुभाग पर जाएँ "परिणामों की गणना करें!" नीचे की तरफ गिरना।

बूटस्ट्रैप पद्धति

यदि हम डेटा के अंतर्निहित वास्तविक वितरण से अतिरिक्त परीक्षण डेटासेट खींचने में सक्षम थे, तो हम उन डेटासेट में रुचि के प्रदर्शन मीट्रिक का वितरण देख पाएंगे। (उन डेटासेट को चित्रित करते समय हम एक समान या समान उदाहरण को कई बार चित्रित करने से रोकने के लिए कुछ भी नहीं करेंगे, हालांकि ऐसा शायद ही कभी हो सकता है।)

चूँकि हम ऐसा नहीं कर सकते, अगली सबसे अच्छी चीज़ इससे अतिरिक्त डेटासेट निकालना है अनुभवजन्य वितरण इस परीक्षण डेटासेट का, जिसका अर्थ है नए बूटस्ट्रैप नमूना डेटासेट उत्पन्न करने के लिए इसके उदाहरणों से प्रतिस्थापन के साथ नमूनाकरण। प्रतिस्थापन के साथ नमूना लेने का मतलब है कि एक बार जब हम एक विशेष उदाहरण खींचते हैं, तो हम इसे वापस रख देते हैं ताकि हम इसे उसी नमूना डेटासेट के लिए फिर से खींच सकें। इसलिए, ऐसे प्रत्येक डेटासेट में आम तौर पर कुछ उदाहरणों की कई प्रतियां होती हैं, और इसमें वे सभी उदाहरण शामिल नहीं होते हैं जो आधार परीक्षण सेट में हैं।

यदि हमने नमूना लिया बिना प्रतिस्थापन, तो हमें हर बार मूल डेटासेट की एक समान प्रतिलिपि प्राप्त होगी, एक अलग यादृच्छिक क्रम में फेरबदल किया जाएगा, जिसका कोई उपयोग नहीं होगा।

RSI प्रतिशतक आत्मविश्वास अंतराल का अनुमान लगाने के लिए बूटस्ट्रैप पद्धति इस प्रकार है:

- उत्पन्न करें

nboots"बूटस्ट्रैप नमूना" डेटासेट, प्रत्येक का आकार मूल परीक्षण सेट के समान है। प्रत्येक नमूना डेटासेट प्रतिस्थापन के साथ परीक्षण सेट से यादृच्छिक रूप से उदाहरण खींचकर प्राप्त किया जाता है। - प्रत्येक नमूना डेटासेट पर, मीट्रिक की गणना करें और इसे सहेजें।

- 95% विश्वास अंतराल 2.5 द्वारा दिया गया हैth 97.5 तकth के बीच प्रतिशतक

nbootsमीट्रिक के परिकलित मान. अगरnboots=1001 और आपने मानों को एक श्रृंखला/सरणी/सूची में क्रमबद्ध कर दिया X लंबाई 1001, 0th पर्सेंटाइल is X[0] और 100th पर्सेंटाइल is X[1000], इसलिए कॉन्फिडेंस अंतराल द्वारा दिया जाएगा X[25] से X[975]

बेशक आप चरण 2 में प्रत्येक नमूना डेटासेट के लिए जितनी चाहें उतनी मीट्रिक की गणना कर सकते हैं, लेकिन चरण 3 में आपको प्रत्येक मीट्रिक के लिए अलग-अलग प्रतिशत मिलेंगे।

उदाहरण डेटासेट और कॉन्फिडेंस इंटरवल परिणाम

हम उदाहरण के तौर पर इस पूर्व लेख के परिणामों का उपयोग करेंगे: डेटा को फिर से संतुलित किए बिना असंतुलित वर्गीकरण से कैसे निपटें: अपने विषम डेटा की ओवरसैंपलिंग पर विचार करने से पहले, अपने वर्गीकरण निर्णय सीमा को समायोजित करने का प्रयास करें.

उस लेख में हमने इसका उपयोग किया था अत्यधिक-असंतुलित दो-वर्ग कागल क्रेडिट कार्ड धोखाधड़ी पहचान डेटा सेट. हमने एक वर्गीकरण सीमा का उपयोग करना चुना जो डिफ़ॉल्ट 0.5 सीमा से काफी अलग है जो कि पूर्वानुमान () पद्धति का उपयोग करने में निहित है, जिससे डेटा को संतुलित करना अनावश्यक हो जाता है। इस दृष्टिकोण को कभी-कभी कहा जाता है दहलीज चल रही है, जिसमें हमारा क्लासिफायर पूर्वानुमान द्वारा प्रदान की गई अनुमानित वर्ग संभाव्यता के लिए चुनी गई सीमा को लागू करके वर्ग निर्दिष्ट करता है_proba() तरीका।

हम इस लेख (और कोड) के दायरे को बाइनरी वर्गीकरण तक सीमित कर देंगे: वर्ग 0 और 1, परंपरा के अनुसार वर्ग 1 "सकारात्मक" वर्ग है और असंतुलित डेटा के लिए विशेष रूप से अल्पसंख्यक वर्ग है, हालांकि कोड को प्रतिगमन (एकल) के लिए काम करना चाहिए निरंतर लक्ष्य) भी।

एक बूट नमूना डेटासेट तैयार करना

हालाँकि हमारा कॉन्फिडेंस इंटरवल कोड मीट्रिक फ़ंक्शंस में पारित होने के लिए विभिन्न संख्या में डेटा तर्कों को संभाल सकता है, हम स्केलेरन-शैली मेट्रिक्स पर ध्यान केंद्रित करेंगे, जो हमेशा दो डेटा तर्क स्वीकार करते हैं, y_true और y_pred, जहां y_pred या तो बाइनरी क्लास भविष्यवाणियां होंगी (0) या 1), या निरंतर वर्ग-संभावना या निर्णय फ़ंक्शन भविष्यवाणियां, या यहां तक कि निरंतर प्रतिगमन भविष्यवाणियां यदि y_true भी निरंतर है। निम्नलिखित फ़ंक्शन एकल बूट नमूना डेटासेट उत्पन्न करता है। यह किसी भी डेटा_आर्ग को स्वीकार करता है लेकिन हमारे मामले में ये तर्क होंगे ytest(हमारे वास्तविक/सच्चे परीक्षण ने लक्ष्य मान निर्धारित किए हैं पूर्व लेख) और hardpredtst_tuned_thresh (अनुमानित वर्ग)। प्रत्येक उदाहरण के लिए सही या अनुमानित वर्ग को इंगित करने के लिए दोनों में शून्य और एक होते हैं।

कस्टम मीट्रिक विशिष्टता_स्कोर() और उपयोगिता फ़ंक्शन

हम विशिष्टता के लिए एक कस्टम मीट्रिक फ़ंक्शन को परिभाषित करेंगे, जो कि रिकॉल का दूसरा नाम है नकारात्मक वर्ग (कक्षा 0)। इसके अलावा एक calc_metrics फ़ंक्शन जो हमारे डेटा में रुचि के मैट्रिक्स का अनुक्रम लागू करता है, और इसके लिए कुछ उपयोगिता फ़ंक्शन लागू करता है:

यहां हम मेट्रिक्स की अपनी सूची बनाते हैं और उन्हें डेटा पर लागू करते हैं। हमने सटीकता को एक प्रासंगिक मीट्रिक नहीं माना क्योंकि एक गलत नकारात्मक (एक वास्तविक धोखाधड़ी को वैध के रूप में गलत वर्गीकृत करना) एक गलत सकारात्मक (एक धोखाधड़ी के रूप में एक वास्तविक वैध को गलत वर्गीकृत करना) की तुलना में व्यवसाय के लिए बहुत अधिक महंगा है, जबकि सटीकता दोनों प्रकार के गलत वर्गीकरण को मानती है। समान रूप से बुरे हैं और इसलिए उन लोगों को सही ढंग से वर्गीकृत करने का समर्थन करते हैं जिनका वास्तविक वर्ग बहुसंख्यक वर्ग है क्योंकि ये बहुत अधिक बार होते हैं और इसलिए समग्र सटीकता में बहुत अधिक योगदान करते हैं।

met=[ metrics.recall_score, specificity_score, metrics.balanced_accuracy_score ]

calc_metrics(met, ytest, hardpredtst_tuned_thresh)

प्रत्येक बूट नमूना डेटासेट बनाना और उसके लिए मेट्रिक्स की गणना करना

raw_metric_samples() में हम वास्तव में एक-एक करके कई नमूना डेटासेट तैयार करेंगे और प्रत्येक के मेट्रिक्स को सहेजेंगे:

आप raw_metric_samples() को रुचि के मेट्रिक्स (या सिर्फ एक मीट्रिक) के साथ-साथ सही और अनुमानित वर्ग डेटा की एक सूची देते हैं, और यह nboots नमूना डेटासेट प्राप्त करता है और प्रत्येक डेटासेट से गणना किए गए केवल मेट्रिक्स मानों के साथ एक डेटाफ़्रेम लौटाता है। _boot_generator() के माध्यम से यह संभावित रूप से सभी डेटासेट को एक साथ संग्रहीत करने के बजाय जनरेटर अभिव्यक्ति में एक समय में one_boot() को आमंत्रित करता है-विशाल सूची।

7 बूट नमूना डेटासेट पर मेट्रिक्स देखें

हम मीट्रिक फ़ंक्शंस की अपनी सूची बनाते हैं और केवल 7 नमूना डेटासेट के परिणाम प्राप्त करने के लिए raw_metric_samples() को लागू करते हैं। हम यहां समझने के लिए raw_metric_samples() का उपयोग कर रहे हैं - नीचे ci_auto() का उपयोग करके आत्मविश्वास अंतराल प्राप्त करने के लिए यह आवश्यक नहीं है, हालांकि ci_auto() के लिए मेट्रिक्स (या सिर्फ एक मीट्रिक) की एक सूची निर्दिष्ट कर रहा हूं। is ज़रूरी।

np.random.seed(13)

raw_metric_samples(met, ytest, hardpredtst_tuned_thresh, nboots=7).style.format('{:.2%}') #optional #style

उपरोक्त प्रत्येक कॉलम में एक बूट नमूना डेटासेट (संख्या 0 से 6) से गणना की गई मीट्रिक शामिल है, इसलिए गणना की गई मीट्रिक मान यादृच्छिक नमूने के कारण भिन्न होते हैं।

बूट डेटासेट की संख्या, परिकलित डिफ़ॉल्ट के साथ

हमारे कार्यान्वयन में, डिफ़ॉल्ट रूप से बूट डेटासेट की संख्या nboots वांछित आत्मविश्वास स्तर (जैसे 95%) से स्वचालित रूप से गणना की जाएगी ताकि अनुशंसा को पूरा किया जा सके उत्तर, कर्टिस, और शाम वितरण के प्रत्येक टेल में बूट परिणामों की न्यूनतम संख्या होना। (वास्तव में यह अनुशंसा लागू होती है p-मान और इस प्रकार परिकल्पना परीक्षण स्वीकृति क्षेत्र, परंतु विश्वास अंतराल इसे अंगूठे के नियम के रूप में उपयोग करने के लिए पर्याप्त समान हैं।) हालांकि वे लेखक पूंछ में न्यूनतम 10 बूट परिणामों की अनुशंसा करते हैं, डेविडसन और मैकिनॉन 399% आत्मविश्वास के लिए कम से कम 95 जूतों की अनुशंसा करें, जिसके लिए पीछे 11 जूतों की आवश्यकता होती है, इसलिए हम इस अधिक रूढ़िवादी अनुशंसा का उपयोग करते हैं।

We specify alpha which is 1 – confidence level. E.g. 95% confidence becomes 0.95 and alpha=0.05. If you specify an explicit number of boots (perhaps a smaller nboots क्योंकि आप तेज़ परिणाम चाहते हैं) लेकिन यह आपके अनुरोधित अल्फा के लिए पर्याप्त नहीं है, बूट की उस संख्या के लिए सटीक विश्वास अंतराल प्राप्त करने के लिए एक उच्च अल्फा स्वचालित रूप से चुना जाएगा। कम से कम 51 बूटों का उपयोग किया जाएगा क्योंकि कोई भी कम केवल विचित्र-छोटे आत्मविश्वास के स्तर की सटीक गणना कर सकता है (जैसे कि 40% आत्मविश्वास जो 30 से एक अंतराल देता है)th 70 के लिए प्रतिशतकth प्रतिशतक, जिसमें अंतराल के अंदर 40% लेकिन इसके बाहर 60% है) और यह स्पष्ट नहीं है कि न्यूनतम-बूट अनुशंसा ने ऐसे मामले पर भी विचार किया था।

फ़ंक्शन get_alpha_nboots() डिफ़ॉल्ट nboots सेट करता है या उपरोक्त के अनुसार अनुरोधित अल्फा और nboots को संशोधित करता है:

आइए अल्फ़ा के विभिन्न मानों के लिए डिफ़ॉल्ट nboots दिखाएं:

g = get_alpha_nboots pd.DataFrame( [ g(0.40), g(0.20, None), g(0.10), g(), g(alpha=0.02), g(alpha=0.01, nboots=None), g(0.005, nboots=None) ], columns=['alpha', 'default nboots'] ).set_index('alpha')

यदि हम स्पष्ट nboots का अनुरोध करते हैं तो यहां क्या होता है:

req=[(0.01,3000), (0.01,401), (0.01,2)]

out=[get_alpha_nboots(*args) for args in req]

mydf = lambda x: pd.DataFrame(x, columns=['alpha', 'nboots'])

pd.concat([mydf(req),mydf(out)],axis=1, keys=('Requested','Using'))

छोटे nboots मानों ने अल्फा को 0.05 और 0.40 तक बढ़ा दिया, और nboots=2 को न्यूनतम 51 में बदल दिया गया।

बूटस्ट्रैप नमूना डेटासेट का हिस्टोग्राम केवल संतुलित सटीकता के लिए आत्मविश्वास अंतराल दिखा रहा है

फिर से हमें ci_auto() को लागू करके नीचे दिए गए विश्वास अंतराल को प्राप्त करने के लिए ऐसा करने की आवश्यकता नहीं है।

np.random.seed(13)

metric_boot_histogram (metrics.balanced_accuracy_score, ytest, hardpredtst_tuned_thresh)

नारंगी रेखा 89.7% को संतुलित सटीकता विश्वास अंतराल की निचली सीमा के रूप में दर्शाती है, हरी रेखा मूल देखी गई संतुलित सटीकता=92.4% (बिंदु अनुमान) के लिए, और लाल 94.7% की ऊपरी सीमा को दर्शाती है। (इस लेख के शीर्ष पर वही छवि दिखाई देती है।)

मेट्रिक्स की सूची के लिए सभी विश्वास अंतरालों की गणना कैसे करें

यहां मुख्य फ़ंक्शन है जो उपरोक्त को लागू करता है और मीट्रिक परिणामों के प्रतिशत से विश्वास अंतराल की गणना करता है, और परिणामों के आउटपुट डेटाफ्रेम के पहले कॉलम के रूप में बिंदु अनुमान सम्मिलित करता है।

परिणामों की गणना करें!

हमें वास्तव में बस यही करने की ज़रूरत है: मेट्रिक्स की सूची के साथ ci_auto() को निम्नानुसार लागू करें (met उनका विश्वास अंतराल प्राप्त करने के लिए ऊपर निर्दिष्ट किया गया है)। प्रतिशत स्वरूपण वैकल्पिक है:

np.random.seed(13)

ci_auto( met, ytest, hardpredtst_tuned_thresh ).style.format('{:.2%}')

परिणामी आत्मविश्वास अंतराल की चर्चा

यहाँ से भ्रम मैट्रिक्स है मूल लेख. कक्षा 0 नकारात्मक (बहुमत वर्ग) है और कक्षा 1 सकारात्मक (बहुत दुर्लभ वर्ग) है

134/(134+14) की रिकॉल (सच्ची सकारात्मक दर) में सबसे बड़ा आत्मविश्वास अंतराल है क्योंकि यह एक द्विपद अनुपात है जिसमें छोटी गिनती शामिल है।

विशिष्टता (सच्ची नकारात्मक दर) 80,388/(80,388+4,907) है, जिसमें शामिल है बहुत बड़ी संख्या में, इसलिए इसमें केवल [94.11% से 94.40%] का अत्यंत संकीर्ण आत्मविश्वास अंतराल है।

चूंकि संतुलित सटीकता की गणना केवल रिकॉल और विशिष्टता के औसत के रूप में की जाती है, इसलिए इसके विश्वास अंतराल की चौड़ाई उनके बीच मध्यवर्ती होती है।

परीक्षण डेटा में भिन्नता, बनाम ट्रेन डेटा में भिन्नता के कारण मीट्रिक माप की अशुद्धि

यहां हमने परिवर्तनशीलता पर विचार नहीं किया है आदर्श हमारी यादृच्छिकता के आधार पर ट्रेनिंग डेटा (हालाँकि यह कुछ उद्देश्यों के लिए रुचिकर भी हो सकता है, उदाहरण के लिए यदि आपने स्वचालित बार-बार पुन: प्रशिक्षण किया है और जानना चाहते हैं कि भविष्य के मॉडल का प्रदर्शन कितना भिन्न हो सकता है), बल्कि इसके प्रदर्शन के माप में केवल परिवर्तनशीलता है विशेष मॉडल (कुछ विशेष प्रशिक्षण डेटा से निर्मित) हमारी यादृच्छिकता के कारण परीक्षण डेटा.

यदि हमारे पास पर्याप्त स्वतंत्र परीक्षण डेटा होता, तो हम अंतर्निहित आबादी पर इस विशेष मॉडल के प्रदर्शन को बहुत सटीक रूप से माप सकते थे, और हमें पता होगा कि यदि यह मॉडल तैनात किया गया है तो यह कैसा प्रदर्शन करेगा, भले ही हमने मॉडल कैसे बनाया हो और चाहे हम ऐसा कर सकें। एक अलग प्रशिक्षण नमूना डेटासेट के साथ एक बेहतर या बदतर मॉडल प्राप्त करें।

व्यक्तिगत उदाहरणों की स्वतंत्रता

बूटस्ट्रैप विधि मानती है कि आपका प्रत्येक उदाहरण (मामले, अवलोकन) एक अंतर्निहित जनसंख्या से स्वतंत्र रूप से लिया गया है। यदि आपके परीक्षण सेट में पंक्तियों के समूह हैं जो एक-दूसरे से स्वतंत्र नहीं हैं, उदाहरण के लिए एक ही इकाई के बार-बार किए गए अवलोकन जो एक-दूसरे के साथ सहसंबद्ध होने की संभावना रखते हैं, या ऐसे उदाहरण जो आपके परीक्षण में अन्य उदाहरणों से ओवरसैंपल/प्रतिकृति/उत्पन्न होते हैं सेट, परिणाम मान्य नहीं हो सकते हैं। आपको उपयोग करने की आवश्यकता हो सकती है वर्गीकृत किया नमूनाकरण, जहां आप अलग-अलग पंक्तियों के बजाय यादृच्छिक रूप से पूरे समूहों को एक साथ खींचते हैं, जबकि किसी भी समूह को तोड़ने या केवल उसके एक हिस्से का उपयोग करने से बचते हैं।

इसके अलावा, आप यह सुनिश्चित करना चाहते हैं कि आपके पास ऐसे समूह न हों जो प्रशिक्षण और परीक्षण सेट में विभाजित हों, क्योंकि तब परीक्षण सेट आवश्यक रूप से स्वतंत्र नहीं होता है और आपको ओवरफिटिंग का पता नहीं चल सकता है। उदाहरण के लिए यदि आप ओवरसैंपलिंग का उपयोग करते हैं तो आपको आम तौर पर केवल ऐसा ही करना चाहिए बाद इसे परीक्षण सेट से अलग किया गया है, पहले नहीं। और आम तौर पर आप प्रशिक्षण सेट का निरीक्षण करेंगे, लेकिन परीक्षण सेट का नहीं, क्योंकि परीक्षण सेट को उन उदाहरणों का प्रतिनिधि रहना चाहिए जिन्हें मॉडल भविष्य में तैनाती पर देखेगा। और क्रॉस-वैलिडेशन के लिए आप स्किकिट-लर्न का उपयोग करना चाहेंगे model_selection.GroupKFold().

निष्कर्ष

आप यह देखने के लिए हमेशा अपने मूल्यांकन मेट्रिक्स के लिए आत्मविश्वास अंतराल की गणना कर सकते हैं कि आपका परीक्षण डेटा आपको अपने मॉडल के प्रदर्शन को मापने में कितना सक्षम बनाता है। मैं मेट्रिक्स के लिए आत्मविश्वास अंतराल प्रदर्शित करने के लिए एक और लेख की योजना बना रहा हूं जो संभाव्यता पूर्वानुमान (या आत्मविश्वास स्कोर - सांख्यिकीय आत्मविश्वास से कोई संबंध नहीं) का मूल्यांकन करता है, यानी नरम वर्गीकरण, जैसे लॉग लॉस या आरओसी एयूसी, हमारे द्वारा यहां उपयोग किए गए मेट्रिक्स के बजाय जो मूल्यांकन करते हैं मॉडल द्वारा वर्ग का पृथक चयन (कठिन वर्गीकरण)। एक ही कोड दोनों के लिए काम करता है, साथ ही प्रतिगमन (एक सतत लक्ष्य चर की भविष्यवाणी) के लिए भी - आपको बस इसे एक अलग प्रकार की भविष्यवाणी (और प्रतिगमन के मामले में विभिन्न प्रकार के सच्चे लक्ष्य) को पारित करना होगा।

यह ज्यूपिटर नोटबुक जीथब पर उपलब्ध है: BootConfIntAutoV1o_standalone.ipynb

क्या यह लेख जानकारीपूर्ण और/या उपयोगी था? यदि आपके पास इस लेख के बारे में या आत्मविश्वास अंतराल, बूटस्ट्रैप, बूट की संख्या, इस कार्यान्वयन, डेटासेट, मॉडल, थ्रेशोल्ड मूविंग या परिणामों के बारे में कोई टिप्पणी या प्रश्न हैं तो कृपया नीचे एक टिप्पणी पोस्ट करें।

उपरोक्त के अतिरिक्त पूर्व लेख, आपको भी मेरी रुचि हो सकती है पंडों में CSV फ़ाइल पढ़ते समय दिनांक / दिनांक समय कॉलम का स्वतः पता कैसे लगाएं और उनका डेटाटाइप कैसे सेट करें, हालाँकि इसका वर्तमान लेख से सीधा संबंध नहीं है।

जैव: डेविड बी रोसेन (पीएचडी) आईबीएम ग्लोबल फाइनेंसिंग में स्वचालित क्रेडिट अनुमोदन के लिए प्रमुख डेटा वैज्ञानिक हैं। डेविड के लेखन के बारे में और अधिक जानकारी यहां पाएं डाबरू.मीडियम.कॉम.

मूल। अनुमति के साथ पुनर्प्रकाशित।

संबंधित:

| शीर्ष आलेख पिछले 30 दिन | |||||

|---|---|---|---|---|---|

|

|

||||

- "

- &

- 11

- 7

- अतिरिक्त

- सब

- अल्फा

- के बीच में

- तर्क

- लेख

- लेखकों

- स्वत:

- स्वचालित

- BEST

- जूते

- निर्माण

- व्यापार

- मामलों

- वर्गीकरण

- कोड

- स्तंभ

- टिप्पणियाँ

- आत्मविश्वास

- भ्रम

- युगल

- Coursera

- श्रेय

- तिथि

- डेटा विज्ञान

- आँकड़े वाला वैज्ञानिक

- सौदा

- डीआईडी

- अनुमान

- प्रथम

- फोकस

- धोखा

- मुक्त

- पूर्ण

- समारोह

- भविष्य

- जाना

- GitHub

- वैश्विक

- गूगल

- हरा

- समूह

- यहाँ उत्पन्न करें

- कैसे

- How To

- HTTPS

- आईबीएम

- पहचान

- की छवि

- ब्याज

- साक्षात्कार

- IT

- जुपीटर नोटबुक

- नेतृत्व

- सीख रहा हूँ

- स्तर

- लाइन

- सूची

- यंत्र अधिगम

- बहुमत

- निर्माण

- गणित

- मैट्रिक्स

- माप

- मध्यम

- मेट्रिक्स

- अल्पसंख्यक

- आदर्श

- संख्या

- आदेश

- अन्य

- प्रदर्शन

- की योजना बना

- आबादी

- संविभाग

- भविष्यवाणी

- भविष्यवाणियों

- वर्तमान

- परियोजनाओं

- पढ़ना

- प्रतीपगमन

- रिपोर्ट

- परिणाम

- रिटर्न

- विज्ञान

- सेट

- आकार

- छोटा

- So

- विभाजित

- एसक्यूएल

- आँकड़े

- तना

- कहानियों

- लक्ष्य

- तकनीक

- परीक्षण

- पहर

- ऊपर का

- प्रशिक्षण

- व्यवहार करता है

- उपयोगिता

- मूल्य

- अंदर

- काम

- कार्य

- लिख रहे हैं

- X