द्वारा फोटो Google डीपमाइंड

2023 बड़े भाषा मॉडल और ओपन सोर्स का वर्ष था। कई स्टार्टअप और कंपनियों ने चैटजीपीटी और क्लाउड जैसे मालिकाना एलएलएम का मुकाबला करने के लिए अपने मॉडल और वेट को ओपन-सोर्स किया। 2023 के लिए कुछ महत्वपूर्ण कंपनियाँ और मॉडल (खुला स्रोत) थे:

- मेटा (एलएलएएमए, एलएलएएमएवी2)

- टीआईआई (फाल्कन 7बी, 40बी, 180बी)

- मिस्ट्रल (मिस्ट्रल 7बी, मिक्सट्राल8x7बी)

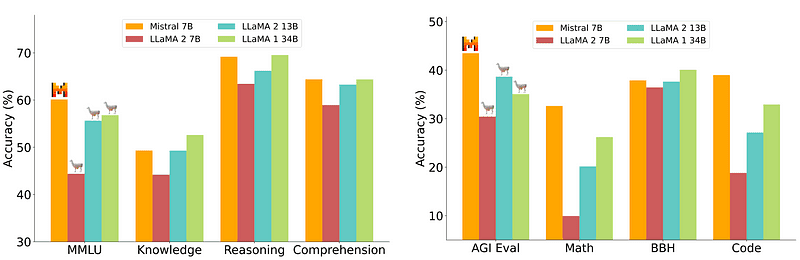

हालाँकि, 7B मॉडल, जिसे तैनात करना अपेक्षाकृत आसान और सस्ता है, 70B जैसे बड़े मॉडल के बराबर नहीं है। सबसे मजबूत ओपन-सोर्स दावेदार मिस्ट्रल 7बी था जो कई बड़े मॉडलों से बेहतर प्रदर्शन करेगा।

मिस्ट्रल-7बी की तुलना मिस्ट्रल.एआई

हालाँकि, ये छोटे मॉडल अभी भी प्राकृतिक संकेतों पर अच्छी प्रतिक्रिया नहीं देते हैं और इन्हें अच्छी त्वरित इंजीनियरिंग की आवश्यकता होती है।

Zephyr 7B, HuggingFace H4 (मददगार, ईमानदार, हानिरहित, Huggy) टीम द्वारा बनाया गया एक मॉडल है जिसका मुख्य लक्ष्य एक छोटा भाषा मॉडल बनाना था जो उपयोगकर्ता के इरादे से जुड़ा हो और बड़े मॉडलों से भी बेहतर प्रदर्शन करता हो।

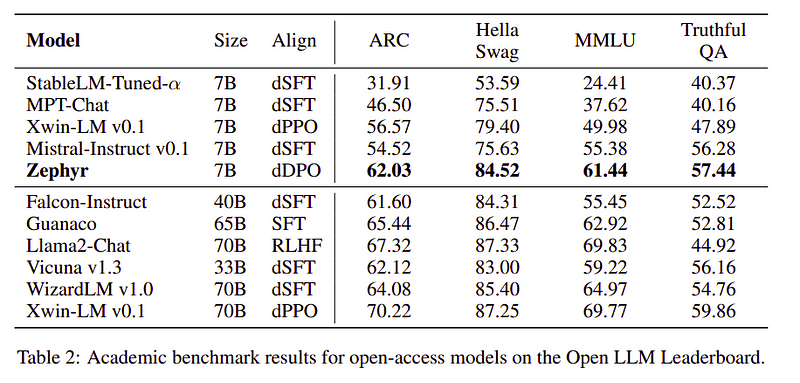

ज़ेफिर मिस्ट्रल-7बी का एक संरेखित संस्करण है जो मुख्य रूप से आसवन की शक्ति से बनाया गया है, और अकादमिक और संवादी बेंचमार्क में 70बी मॉडल के बराबर है।

Zephyr-7B की प्रदर्शन तुलना | स्रोत: ज़ेफायर पेपर

Zephyr-7B की प्रदर्शन तुलना | स्रोत: ज़ेफायर पेपर

मुख्य विशेषताएं

ज़ेफिर के उत्कृष्ट प्रदर्शन के पीछे का कारण ये 4 प्रमुख तकनीकें हैं जिनका उपयोग H4 टीम ने किया है।

- स्व-निर्देश डेटा निर्माण और डीएसएफटी (डिस्टिल्ड सुपरवाइज्ड फाइन-ट्यूनिंग)

- प्रतिक्रिया संग्रह

- डीएसएफटी मॉडल का डीडीपीओ (डिस्टिल्ड डायरेक्ट प्रेफरेंस ऑप्टिमाइजेशन)।

स्व-निर्देश डेटा निर्माण और डीएसएफटी

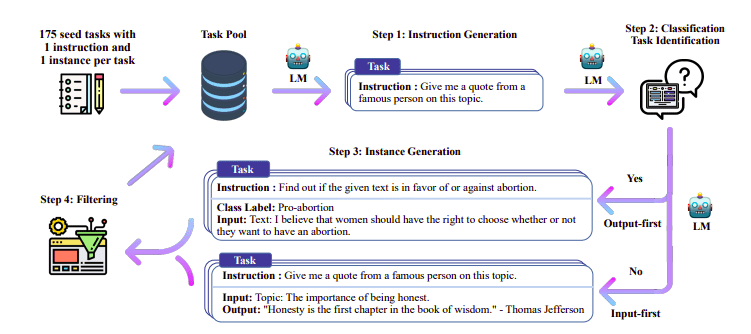

परंपरागत रूप से पर्यवेक्षित फाइन-ट्यूनिंग (एसएफटी) उच्च गुणवत्ता वाले अनुदेश पूर्णता युग्म के माध्यम से एक बड़े भाषा मॉडल पर किया जाता है। इस डेटा का निर्माण महंगा है और इसके लिए मानव पर्यवेक्षण की आवश्यकता होती है (चुंग एट अल., 2022; सान एट अल., 2021)।

यहां दिलचस्प तरीकों में से एक निर्देश और प्रतिक्रियाएं उत्पन्न करने के लिए शिक्षक मॉडल (पहले से प्रशिक्षित एलएलएम) का उपयोग करना है। इस आसवन तकनीक का उपयोग पहली बार अल्पाका (ताओरी एट अल., 2023) में किया गया था, जिससे साबित हुआ कि एक छोटा मॉडल बड़े मॉडल से बेहतर प्रदर्शन कर सकता है। आसुत पर्यवेक्षित फ़ाइन-ट्यूनिंग.

स्व-निर्देश पाइपलाइन | स्रोत: स्व-निर्देश पत्र

H4 टीम ने उच्च गुणवत्ता वाले पर्यवेक्षित (निर्देश, पूर्णता) डेटासेट के निर्माण के लिए ज़ेफायर का उपयोग किया, जिनका उपयोग डीएसएफटी करने के लिए किया गया था। (उत्पन्न निर्देशों/पूर्णताओं पर एक मॉडल को प्रशिक्षित करना आसवन का एक रूप है जिसे डीएसएफटी: डिस्टिल्ड सुपरवाइज्ड फाइन-ट्यूनिंग के रूप में जाना जाता है)।

प्रतिक्रिया संग्रह

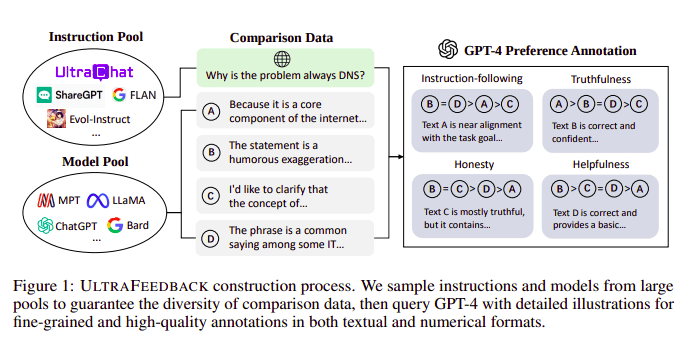

बड़े भाषा मॉडल आमतौर पर किसकी सहायता से संरेखित किए जाते हैं? मानव प्रतिक्रिया से सुदृढीकरण सीखना (आरएलएचएफ). ज़ेफायर इसके बजाय अल्ट्रा फीडबैक के दृष्टिकोण का पालन करते हुए मॉडल के हितों को संरेखित करने के लिए एक बेहतर शिक्षक मॉडल (जैसे जीपीटी -4) से फीडबैक का उपयोग करता है।

अल्ट्राफीडबैक निर्माण प्रक्रिया | स्रोत: अल्ट्राफीडबैक पेपर

जिस तरह से यह काम करता है वह यह है कि एसएफटी से प्रत्येक प्रॉम्प्ट पर्यवेक्षित प्रॉम्प्ट को 4 मॉडल (क्लाउड, एलएलएएमए, फाल्कन इत्यादि) में पास किया जाता है और एकल प्रॉम्प्ट के खिलाफ 4 प्रतिक्रियाओं में से प्रत्येक को जीपीटी -4 की मदद से स्कोर किया जाता है। अब हमारे पास एक इनपुट (x), उच्चतम स्कोरिंग पूर्णता (yw) का एक डेटासेट है, और कम स्कोरिंग पूर्णता (yl) के रूप में दर्शाया गया एक यादृच्छिक संकेत है, यानी हमारे पास (x, yw, yl) का एक त्रिक है।

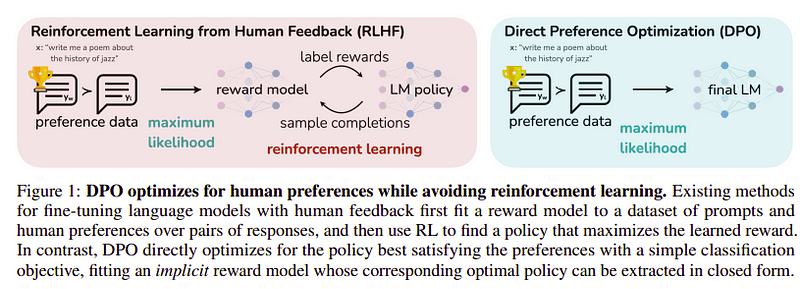

वरीयता अनुकूलन

इस अंतिम चरण का लक्ष्य yw (उच्चतम स्कोरिंग पूर्णता) से yl (कम स्कोरिंग पूर्णता) से मॉडल की प्राथमिकता को अधिकतम करना है। इसका प्रयोग करके किया जाता है DPO (प्रत्यक्ष वरीयता अनुकूलन). डीपीओ का उपयोग करना सादे आरएलएचएफ का उपयोग करने से आसान है और सहज रूप से यह आरएलएचएफ से बेहतर प्रदर्शन करता है। इस मामले में दृष्टिकोण के रूप में जाना जाता है डीडीपीओ क्योंकि यह एक शिक्षक मॉडल की सहायता से उत्पन्न डिस्टिल्ड डेटासेट का उपयोग करता है।

डीपीओ बनाम आरएलएचएफ | स्रोत: ज़ेफायर पेपर

डीपीओ बनाम आरएलएचएफ | स्रोत: ज़ेफायर पेपर

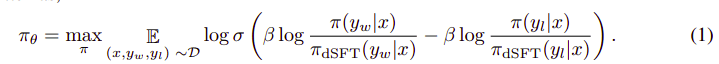

समग्र एल्गोरिथ्म कुछ इस तरह दिखता है:

और इसे निम्नलिखित चरणों में अनुवादित किया जा सकता है:

- डीएसएफटी मॉडल (केवल फॉरवर्ड) से (x, yw) और (x, yl) के लिए संभावना की गणना करें।

- dDPO मॉडल से (x, yw) और (x, yl) की संभाव्यता की गणना करें।

- Eq 1 की गणना करें और अद्यतन करने के लिए बैकप्रोपेगेट करें। दोहराना

ज़ेफायर द्वारा उपयोग किया जाने वाला बेस मॉडल मिस्ट्रल-7बी है जो रिलीज़ के समय अत्याधुनिक खुला स्रोत था। उन्होंने इसका प्रयोग किया TRL फाइन-ट्यूनिंग और संरेखण के लिए लाइब्रेरी। डीप-स्पीड जीरो 3 और फ्लैश-अटेंशन 2 का उपयोग प्रशिक्षण को अनुकूलित और तेज करने और जीपीयू का पूरी तरह से उपयोग करने के लिए किया गया था। मॉडलों को एडमडब्ल्यू ऑप्टिमाइज़र का उपयोग करके प्रशिक्षित किया गया था और कोई वजन घटाने का उपयोग नहीं किया गया था। सभी प्रयोग bfloat16 परिशुद्धता का उपयोग करके 100 A16 पर चलाए गए और आमतौर पर पूरा होने में 2-4 घंटे लगे। आप इसका उल्लेख कर सकते हैं मूल पेपर ज़ेफिर की प्रशिक्षण प्रक्रिया पर गहन जानकारी के लिए।

ज़ेफायर टीम बड़े भाषा मॉडल को प्रशिक्षित करने के लिए सर्वोत्तम तकनीकों को जोड़ती है और इसने केवल 40बी मापदंडों के साथ 7बी मॉडल के प्रदर्शन का मिलान किया और चैट मॉडल के लिए 70बी का मिलान किया।

जेफिर बनाम अन्य एलएलएम की तुलना | स्रोत: ज़ेफायर पेपर

जेफिर बनाम अन्य एलएलएम की तुलना | स्रोत: ज़ेफायर पेपर जेफिर बनाम अन्य एलएलएम की तुलना | स्रोत: ज़ेफायर पेपर

जेफिर बनाम अन्य एलएलएम की तुलना | स्रोत: ज़ेफायर पेपर

ज़ेफायर मॉडल हगिंग फेस पर सार्वजनिक रूप से उपलब्ध हैं और इन्हें किसी अन्य भाषा मॉडल के समान ही उपयोग किया जा सकता है।

import torch

from transformers import pipeline

pipe = pipeline("text-generation",

model="HuggingFaceH4/zephyr-7b-alpha", # can also use the beta model

torch_dtype=torch.bfloat16,

device_map="auto")

# We use the tokenizer's chat template to format each message - see https://huggingface.co/docs/transformers/main/en/chat_templating

messages = [

{

"role": "system",

"content": "You are a friendly chatbot who always responds in the style of a pirate",

},

{"role": "user", "content": "How many helicopters can a human eat in one sitting?"},

]

prompt = pipe.tokenizer.apply_chat_template(messages, tokenize=False, add_generation_prompt=True)

outputs = pipe(prompt, max_new_tokens=256, do_sample=True, temperature=0.7, top_k=50, top_p=0.95)

print(outputs[0]["generated_text"])आउटपुट:

|system|>

You are a friendly chatbot who always responds in the style of a pirate.

|user|>

How many helicopters can a human eat in one sitting?

|assistant|>

Ah, me hearty matey! But yer question be a puzzler! A human cannot eat a helicopter in one sitting, as helicopters are not edible. They be made of metal, plastic, and other materials, not food!

ज़ेफायर-7बी एक छोटा मॉडल है जिसने एलएलएम से छोटे मॉडल में आसवन की शक्ति दिखाई है। परिणामी मॉडल ZEPHYR-7B, MISTRAL-7B पर आधारित, 7B पैरामीटर चैट मॉडल के लिए एक नया अत्याधुनिक सेट करता है और MT-बेंच पर LLAMA2-CHAT-70B से भी बेहतर प्रदर्शन करता है।

संदर्भ

- ज़ेफिर: एलएम संरेखण का प्रत्यक्ष आसवन (https://arxiv.org/abs/2310.16944)

- हगिंगफेस जेफायर ब्लॉग (https://huggingface.co/blog/Isamu136/understanding-zephyr)

- स्वयं निर्देश: https://arxiv.org/abs/2212.10560

- अल्ट्राफीडबैक: https://arxiv.org/abs/2310.01377

अहमद अनीस एक उत्साही मशीन लर्निंग इंजीनियर और शोधकर्ता हैं जो वर्तमान में काम कर रहे हैं redbuffer.ai. अपनी दैनिक नौकरी से परे, अहमद मशीन लर्निंग समुदाय के साथ सक्रिय रूप से जुड़ा हुआ है। वह खुले विज्ञान के लिए समर्पित एक गैर-लाभकारी संस्था कोहेयर फॉर एआई के क्षेत्रीय नेतृत्व के रूप में कार्य करता है, और एक एडब्ल्यूएस समुदाय निर्माता है। अहमद स्टैकओवरफ्लो में सक्रिय योगदानकर्ता है, जहां उसके 2300+ अंक हैं। उन्होंने ओपनएआई द्वारा शेप-ई सहित कई प्रसिद्ध ओपन-सोर्स परियोजनाओं में योगदान दिया है।

- एसईओ संचालित सामग्री और पीआर वितरण। आज ही प्रवर्धित हो जाओ।

- प्लेटोडेटा.नेटवर्क वर्टिकल जेनरेटिव एआई। स्वयं को शक्तिवान बनाएं। यहां पहुंचें।

- प्लेटोआईस्ट्रीम। Web3 इंटेलिजेंस। ज्ञान प्रवर्धित। यहां पहुंचें।

- प्लेटोईएसजी. कार्बन, क्लीनटेक, ऊर्जा, पर्यावरण, सौर, कचरा प्रबंधन। यहां पहुंचें।

- प्लेटोहेल्थ। बायोटेक और क्लिनिकल परीक्षण इंटेलिजेंस। यहां पहुंचें।

- स्रोत: https://www.kdnuggets.com/exploring-the-zephyr-7b-a-comprehensive-guide-to-the-latest-large-language-model?utm_source=rss&utm_medium=rss&utm_campaign=exploring-the-zephyr-7b-a-comprehensive-guide-to-the-latest-large-language-model

- :हैस

- :है

- :नहीं

- :कहाँ

- $यूपी

- 1

- 15% तक

- 16

- 2021

- 2022

- 2023

- 25

- 7

- a

- शैक्षिक

- सक्रिय

- सक्रिय रूप से

- के खिलाफ

- AI

- AL

- कलन विधि

- संरेखित करें

- गठबंधन

- संरेखण

- सब

- पहले ही

- भी

- हमेशा

- an

- और

- कोई

- दृष्टिकोण

- दृष्टिकोण

- हैं

- AS

- At

- स्वत:

- उपलब्ध

- एडब्ल्यूएस

- आधार

- आधारित

- BE

- क्योंकि

- पीछे

- मानक

- BEST

- बीटा

- बेहतर

- परे

- बड़ा

- ब्लॉग

- निर्माता

- लेकिन

- by

- कर सकते हैं

- नही सकता

- मामला

- बातचीत

- chatbot

- ChatGPT

- सस्ता

- संग्रह

- का मुकाबला

- जोड़ती

- समुदाय

- कंपनियों

- तुलनीय

- तुलना

- पूरा

- समापन

- व्यापक

- निर्माण

- निर्माण

- सामग्री

- योगदान

- अंशदाता

- संवादी

- महंगा

- बनाना

- बनाया

- निर्माण

- वर्तमान में

- तिथि

- डेटासेट

- दिन

- समर्पित

- तैनात

- विवरण

- प्रत्यक्ष

- do

- कर

- किया

- e

- ई एंड टी

- से प्रत्येक

- आसान

- खाने

- खाद्य

- संलग्न

- इंजीनियर

- अभियांत्रिकी

- आदि

- ईथर (ईटीएच)

- और भी

- प्रयोगों

- तलाश

- चेहरा

- बाज़

- प्रसिद्ध

- प्रतिक्रिया

- प्रथम

- निम्नलिखित

- के लिए

- प्रपत्र

- प्रारूप

- अनुकूल

- से

- पूरी तरह से

- उत्पन्न

- उत्पन्न

- लक्ष्य

- अच्छा

- GPU

- गाइड

- है

- he

- हेलीकॉप्टर

- हेलीकाप्टरों

- मदद

- सहायक

- यहाँ उत्पन्न करें

- उच्च गुणवत्ता

- उच्चतम

- उसके

- ईमानदार

- घंटे

- कैसे

- तथापि

- HTTPS

- हगिंग फ़ेस

- मानव

- i

- आयात

- महत्वपूर्ण

- in

- में गहराई

- सहित

- निवेश

- बजाय

- निर्देश

- इरादा

- दिलचस्प

- रुचियों

- में

- IT

- काम

- जेपीजी

- केवल

- केडनगेट्स

- कुंजी

- जानने वाला

- भाषा

- बड़ा

- बड़ा

- पिछली बार

- ताज़ा

- नेतृत्व

- सीख रहा हूँ

- पुस्तकालय

- पसंद

- लामा

- लग रहा है

- निम्न

- मशीन

- यंत्र अधिगम

- बनाया गया

- मुख्य

- मुख्यतः

- बहुत

- मिलान किया

- सामग्री

- अधिकतम करने के लिए

- me

- message

- संदेश

- धातु

- आदर्श

- मॉडल

- प्राकृतिक

- नया

- नहीं

- ग़ैर-लाभकारी

- अभी

- of

- on

- ONE

- खुला

- खुला स्रोत

- OpenAI

- इष्टतमीकरण

- ऑप्टिमाइज़ करें

- मूल

- अन्य

- मात करना

- Outperforms

- outputs के

- बकाया

- के ऊपर

- कुल

- जोड़ा

- प्राचल

- पैरामीटर

- पारित कर दिया

- आवेशपूर्ण

- पीडीएफ

- प्रदर्शन

- प्रदर्शन

- प्रदर्शन

- पाइप

- पाइपलाइन

- मैदान

- प्लास्टिक

- प्लेटो

- प्लेटो डेटा इंटेलिजेंस

- प्लेटोडाटा

- अंक

- बिजली

- शुद्धता

- संभावना

- प्रक्रिया

- प्रक्रिया

- परियोजनाओं

- संकेतों

- मालिकाना

- साबित

- प्रश्न

- बिना सोचे समझे

- कारण

- उल्लेख

- क्षेत्रीय

- अपेक्षाकृत

- और

- दोहराना

- की आवश्यकता होती है

- की आवश्यकता होती है

- शोधकर्ता

- प्रतिक्रिया

- प्रतिक्रियाएं

- जिसके परिणामस्वरूप

- भूमिका

- रन

- s

- विज्ञान

- स्कोर

- स्कोरिंग

- देखना

- कार्य करता है

- सेट

- पता चला

- उसी प्रकार

- सरल

- एक

- बैठक

- छोटा

- छोटे

- कुछ

- कुछ हद तक

- स्रोत

- गति

- स्टार्टअप

- राज्य के-the-कला

- कदम

- कदम

- फिर भी

- मजबूत

- अंदाज

- ऐसा

- पर्यवेक्षण

- प्रणाली

- शिक्षक

- टीम

- तकनीक

- तकनीक

- टेम्पलेट

- से

- कि

- RSI

- लेकिन हाल ही

- इन

- वे

- इसका

- पहर

- सेवा मेरे

- ले गया

- मशाल

- रेलगाड़ी

- प्रशिक्षित

- प्रशिक्षण

- ट्रान्सफ़ॉर्मर

- आम तौर पर

- अति

- अपडेट

- उपयोग

- प्रयुक्त

- उपयोगकर्ता

- का उपयोग करता है

- का उपयोग

- उपयोग

- संस्करण

- के माध्यम से

- vs

- था

- मार्ग..

- we

- भार

- कुंआ

- थे

- कौन कौन से

- कौन

- किसका

- साथ में

- काम कर रहे

- कार्य

- होगा

- X

- वर्ष

- इसलिए आप

- हलकी हवा

- जेफिरनेट

- शून्य