क्या आप खराब डेटा गुणवत्ता की लागत जानते हैं? नीचे, मैं डेटा अवलोकन के महत्व का पता लगाता हूं, यह खराब डेटा के जोखिमों को कैसे कम कर सकता है, और इसके आरओआई को मापने के तरीके। खराब डेटा के प्रभाव को समझकर और प्रभावी रणनीतियों को लागू करके, संगठन अपनी डेटा गुणवत्ता पहल के लाभों को अधिकतम कर सकते हैं।

डेटा आधुनिक निर्णय लेने का एक अभिन्न अंग बन गया है, और इसलिए, यह सुनिश्चित करने के लिए डेटा गुणवत्ता सर्वोपरि है कि व्यावसायिक हितधारक सटीक निष्कर्ष निकाल रहे हैं।

लेकिन यहां एक बात है जो हर आधुनिक डेटा लीडर आपको बताएगा: डेटा गुणवत्ता प्रबंधन कठिन है। इसमें समय और प्रयास लगता है। इसके अलावा, आरओआई (निवेश पर रिटर्न) को मापना अक्सर मुश्किल होता है।

ख़राब डेटा कितना बुरा है?

ख़राब डेटा से महत्वपूर्ण वित्तीय हानि हो सकती है. गार्टनर का अनुमान है कि हर साल ख़राब डेटा गुणवत्ता की कीमत संगठनों को औसतन चुकानी पड़ती है 12.9 $ मिलियन। 2022 में, एकता सॉफ्टवेयर राजस्व में $110 मिलियन और बाजार पूंजीकरण में $4.2 बिलियन का नुकसान दर्ज किया गया। कंपनी ने कहा, "एक बड़े ग्राहक से खराब डेटा प्राप्त करने के परिणाम।" इसी तरह, खराब डेटा का कारण बना Equifax, सार्वजनिक रूप से कारोबार करने वाली क्रेडिट रिपोर्टिंग एजेंसी, ऋणदाताओं को गलत क्रेडिट स्कोर भेजने के लिए लाखों ग्राहकों का. हाल ही में, एक डेटा घटना के कारण यू.के. और आयरलैंड के हवाई यातायात में भारी व्यवधान उत्पन्न हुआ। बताया गया है कि 2,000 से अधिक उड़ानें रद्द कर दी गईं, जिससे सैकड़ों हजारों यात्री फंस गए, एयरलाइंस को संचित वित्तीय नुकसान 126.5 मिलियन डॉलर होने का अनुमान है।

ख़राब डेटा के निहितार्थ

डेटा हर आधुनिक व्यवसाय के केंद्र में है। डेटा टीम की मुख्य ज़िम्मेदारी उन डेटा उत्पादों का निर्माण और रखरखाव करना है जो ग्राहकों को आंतरिक और बाह्य रूप से परोसे जाते हैं, साथ ही संगठन को अपने उद्देश्यों को पूरा करने और पूरा करने की अनुमति देते हैं।

जब यह सुनिश्चित करने की बात आती है कि संगठन की डेटा पहल सफलता के लिए तैयार है, तो डेटा टीम से कुछ आधारभूत अपेक्षाओं को निम्नानुसार संक्षेप में प्रस्तुत किया जा सकता है:

- अपटाइम: डेटा एक सेवा है, और इसलिए यह सुनिश्चित करना महत्वपूर्ण है कि जरूरत पड़ने पर यह उपलब्ध हो।

- सुरक्षा: विनियमों का अनुपालन (जैसे जीडीपीआर या एचआईपीएए)। टीम संवेदनशील जानकारी की सुरक्षा और डेटा गोपनीयता बनाए रखने के उपायों और प्रथाओं के कार्यान्वयन के लिए जिम्मेदार है।

- विश्वसनीयता: डेटा और डेटा प्लेटफ़ॉर्म दोनों का। इसका एक हिस्सा अपटाइम के साथ-साथ पारंपरिक अर्थों में डेटा गुणवत्ता और सटीकता से भी कवर होता है।

- स्केल: डेटा प्लेटफ़ॉर्म को बढ़ती डेटा मात्रा, उपयोग के मामलों की संख्या और व्यवसाय की ज़रूरतों को समायोजित करने के लिए स्केलेबिलिटी की अनुमति देनी चाहिए।

- अभिनव: डेटा को नवाचार को बढ़ावा देना चाहिए, और यह एक ऐसा क्षेत्र है जहां यह महत्वपूर्ण है कि डेटा टीम डेटा प्रथाओं के अंदर और बाहर नवाचार लाकर उदाहरण पेश करे।

डेटा अवलोकन के माध्यम से डेटा गुणवत्ता प्राप्त करना

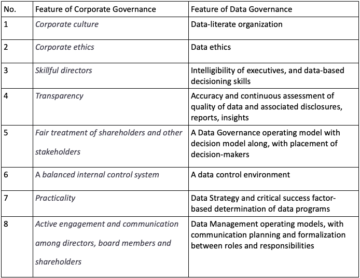

डेटा अवलोकन उसके पूरे जीवनचक्र में डेटा के स्वास्थ्य की सक्रिय रूप से निगरानी करने और उसे बनाए रखने का एक समाधान है। लॉगिंग, ट्रेसिंग और मॉनिटरिंग तकनीकों को लागू करके, संगठन डेटा स्ट्रीम में दृश्यता प्राप्त करते हैं, डेटा गुणवत्ता के मुद्दों को तुरंत पहचानते हैं और उनका निवारण करते हैं, और एनालिटिक्स डैशबोर्ड में व्यवधानों को रोकते हैं। डेटा साक्षरताडेटा की सोर्सिंग, व्याख्या और संचार को शामिल करना, निर्णय निर्माताओं के लिए डेटा को व्यावसायिक मूल्य में प्रभावी ढंग से अनुवाद करने के लिए आवश्यक है। डेटा-संचालित संस्कृति को विकसित करना और सही उपकरणों में निवेश करना डेटा अवलोकन के माध्यम से डेटा गुणवत्ता प्राप्त करने की दिशा में महत्वपूर्ण कदम हैं।

डेटा अवलोकन की आरओआई की मात्रा निर्धारित करना

डेटा अवलोकन की आरओआई को मापने से व्यापारिक नेताओं को इस अभ्यास में निवेश से जुड़े मूल्य और लाभों को समझने में मदद मिलती है। कई मात्रात्मक मेट्रिक्स खराब डेटा की लागत का मूल्यांकन करने के लिए शुरुआती बिंदु के रूप में काम कर सकते हैं, जिसमें प्रति वर्ष घटनाओं की दर या संख्या, पता लगाने का समय और समाधान का समय शामिल है।

इसका प्रभाव डेटा गुणवत्ता के मुद्दे व्यवसाय संचालन के आकार और जटिलता के आधार पर भिन्न हो सकते हैं। क्षति का आकलन करने और डेटा अवलोकन समाधान के लिए एक मजबूत मामला बनाने के लिए, हम पांच प्रमुख मीट्रिक प्रस्तावित करते हैं जिन्हें डेटा व्यवसायी आसानी से लागू कर सकते हैं और निगरानी कर सकते हैं जिनका उपयोग आंतरिक रूप से किसी मामले का समर्थन करने के लिए किया जा सकता है:

- घटनाओं की संख्या और आवृत्ति: जबकि कुछ कंपनियों को दैनिक आधार पर डेटा घटनाओं का अनुभव हो सकता है, अन्य को कई दिन - यदि सप्ताह नहीं - बिना किसी घटना के गुज़रना पड़ सकता है। घटनाओं की गंभीरता कुछ "मामूली" से भिन्न हो सकती है, जैसे कि डैशबोर्ड से जुड़ा पुराना डेटा, जिसे किसी ने भी वर्षों से उपयोग नहीं किया है, डेटा डुप्लिकेशन समस्या के कारण सर्वर ओवरचार्ज हो जाता है और अंततः डाउन हो जाता है (सच्ची कहानी, नेटफ्लिक्स 2016)। हम पाते हैं कि यह अक्सर इससे जुड़ा होता है: डेटा प्लेटफ़ॉर्म का आकार और जटिलता, कंपनी का उद्योग (कुछ उद्योग स्वाभाविक रूप से दूसरों की तुलना में अधिक डेटा परिपक्व होते हैं), डेटा आर्किटेक्चर प्रकार (केंद्रीकृत, विकेन्द्रीकृत, हाइब्रिड), आदि। घटनाओं का दस्तावेजीकरण करने से मदद मिलेगी अगली बार वहाँ क्या देखना है इसका एक बेहतर विचार, बार-बार होने वाली घटनाएँ अक्सर एक अच्छा संकेतक होती हैं कि नीचे की किसी चीज़ पर अधिक ध्यान देने की आवश्यकता है।

- घटना वर्गीकरण: सभी डेटा घटनाएं समान गंभीरता की नहीं हैं; कुछ मामूली हो सकते हैं और आसानी से कम हो सकते हैं, जबकि अन्य के गंभीर परिणाम हो सकते हैं। उचित वृद्धि और प्राथमिकता सुनिश्चित करने के लिए घटनाओं की गंभीरता का दस्तावेजीकरण करना महत्वपूर्ण है। यह वह जगह है जहां डेटा वंशावली महत्वपूर्ण हो सकती है, क्योंकि यह घटना के डाउनस्ट्रीम प्रभाव के आकलन को गंभीरता को बेहतर ढंग से समझने की अनुमति देता है। एक घटना जो सीईओ के पसंदीदा डैशबोर्ड, या उत्पादन डेटाबेस, या एक महत्वपूर्ण डेटा उत्पाद से जुड़ी है, उच्च गंभीरता की होने की संभावना है।

- पता लगाने का औसत समय (MTTD): जब डेटा और डेटा टीम में विश्वास बनाने की बात आती है, तो प्रत्येक डेटा व्यवसायी का दुःस्वप्न तब होता है जब व्यावसायिक हितधारक डेटा गुणवत्ता के मुद्दों का पता लगाने वाले पहले व्यक्ति होते हैं। यह वास्तव में टीम की विश्वसनीयता और कंपनी की वास्तव में डेटा-संचालित बनने की क्षमता को नुकसान पहुंचा सकता है। जैसे ही आप घटनाओं का दस्तावेजीकरण करना शुरू करते हैं और उनकी गंभीरता को वर्गीकृत करते हैं, यह भी ट्रैक करना महत्वपूर्ण है कि उनका पता कैसे लगाया गया और डेटा टीम को उन्हें स्वीकार करने में कितना समय लगा। यह मीट्रिक आपके घटना प्रबंधन की मजबूती का एक अच्छा संकेतक हो सकता है लेकिन इसे कम करने का मतलब यह भी है कि आप उस जोखिम को कम कर देते हैं जिससे घटना अधिक नुकसान पहुंचा सकती है।

- समाधान का औसत समय (MTTR): किसी घटना की सूचना मिलने पर क्या होता है? एमटीटीआर किसी डेटा घटना के बारे में जागरूक होने और उसे हल करने के बीच बिताया गया औसत समय है। समाधान का समय घटना की गंभीरता और डेटा प्लेटफ़ॉर्म की जटिलता से बहुत प्रभावित होता है, यही कारण है कि हम इस ढांचे के उद्देश्य के लिए औसत पर विचार कर रहे हैं।

- उत्पादन का औसत समय (एमटीटीपी) नए डेटा उत्पादों को शिप करने में लगने वाला औसत समय या, दूसरे शब्दों में, डेटा उत्पादों को बाज़ार में लाने का औसत समय है। यह एक विश्लेषक द्वारा डेटा विज्ञान मॉडल के लिए डेटा को "साफ" करने में बिताया गया समय हो सकता है। वास्तव में, के अनुसार फ़ोर्ब्सडेटा तैयार करने में डेटा वैज्ञानिकों का लगभग 80% काम होता है। ऐसी दुनिया में जहां हम डेटा को एक उत्पाद के रूप में मानना चाहते हैं, डेटा की गुणवत्ता में सुधार का बाजार में लगने वाले समय को कम करने पर सीधा प्रभाव पड़ सकता है।

उपरोक्त मात्रात्मक मेट्रिक्स के अलावा, अन्य जो कम आसानी से मात्रात्मक हैं लेकिन उतने ही महत्वपूर्ण हैं, खराब डेटा की लागत को देखते समय विचार करने योग्य हैं।

- भरोसे का क्षरण: डेटा में और डेटा टीम. मेरी राय में, यह खराब डेटा का सबसे खतरनाक परिणाम है, जिसके परिणामस्वरूप डेटा टीम में टर्नओवर या कंपनी की डेटा-संचालित बनने और विकसित डिजिटल परिदृश्य के साथ बने रहने की क्षमता में विश्वास की हानि जैसे बड़े मुद्दे हो सकते हैं। और एक बार भरोसा टूट जाए तो उसे दोबारा हासिल करना बहुत मुश्किल होता है। पिछले अनुभव में, मैंने डेटा उपभोक्ताओं के आसपास काम किया था जो डेटा का उपयोग नहीं करना चाहते थे और बहुत ही अस्थिर स्टॉक-ट्रेडिंग माहौल में "अनुभव" और "आंतरिक भावना" पर भरोसा करना पसंद करते थे बजाय इसके कि यह जानते हुए कि इसके गलत होने की संभावना अधिक है। .

- उत्पादकता में हानि: खराब डेटा के साथ, टीमों को संघर्ष करने और त्रुटियां उत्पन्न होने पर उन्हें सुधारने के लिए मजबूर होना पड़ता है। यह निरंतर अग्निशमन न केवल थका देने वाला है, बल्कि प्रतिकूल भी है। रणनीतिक योजना और विकास पहलों पर जो मूल्यवान समय खर्च किया जा सकता था, वह समस्या निवारण में बर्बाद हो जाता है, संसाधनों को अधिक महत्वपूर्ण कार्यों से हटा दिया जाता है।

- विनियामक और प्रतिष्ठित जोखिम: वित्तीय रिपोर्टिंग में त्रुटियों या व्यक्तिगत डेटा के दुरुपयोग के परिणामस्वरूप महंगा जुर्माना और कानूनी लड़ाई हो सकती है। अनुपालन के मुद्दों से निपटना उत्पादकता पर एक महत्वपूर्ण प्रभाव है, उनके द्वारा लगाए गए वित्तीय बोझ का तो जिक्र ही नहीं।

- ख़राब व्यावसायिक प्रदर्शन: डेटा टीम के भीतर उत्पादकता खोने के अलावा, खराब डेटा समग्र व्यावसायिक प्रदर्शन में बाधा डाल सकता है क्योंकि कंपनी अपने ग्राहकों के सामने डिजिटल तैयारी और विश्वसनीयता के साथ संघर्ष करती है, और बाहरी खतरों के प्रति संवेदनशील हो जाती है।

डेटा गुणवत्ता के मुद्दों के परिणामस्वरूप विभिन्न समस्याएं हो सकती हैं, जिनमें डेटा पर विश्वास की हानि, टीम की उत्पादकता और मनोबल में कमी, नियमों का अनुपालन न करना और निर्णय लेने की गुणवत्ता में कमी शामिल है। विभागों या व्यावसायिक इकाइयों के भीतर गुप्त डेटा से संगठन के डेटा परिदृश्य का समग्र दृष्टिकोण प्राप्त करना चुनौतीपूर्ण हो जाता है। इससे निर्णय लेने की क्षमता अप्रभावी हो सकती है, डेटा संस्कृति में बाधा आ सकती है और जीडीपीआर और एचआईपीएए जैसे नियमों का अनुपालन खतरे में पड़ सकता है। इसके अलावा, डेटा टीमें डेटा समस्याओं के निवारण में अत्यधिक समय खर्च करके निराश हो सकती हैं, जिससे उनकी नौकरी की संतुष्टि पर नकारात्मक प्रभाव पड़ सकता है और संभावित रूप से कर्मचारी मंथन हो सकता है।

1x10x100 नियम

1x10x100 नियम, घटना प्रबंधन में व्यापक रूप से मान्यता प्राप्त सिद्धांत, खराब डेटा गुणवत्ता से जुड़ी बढ़ती लागत पर जोर देता है। इस नियम के अनुसार, प्रवेश के बिंदु पर डेटा गुणवत्ता के मुद्दे को संबोधित करने की लागत मूल लागत का लगभग 1x है। यदि समस्या का पता नहीं चल पाता है और सिस्टम के भीतर फैल जाती है, तो लागत लगभग 10 गुना तक बढ़ जाती है, जिसमें सुधार और उपचार के प्रयास शामिल होते हैं। हालाँकि, यदि खराब डेटा गुणवत्ता अंतिम-उपयोगकर्ता या निर्णय लेने के चरण तक पहुँच जाती है, तो परिचालन संबंधी व्यवधान, खोए हुए अवसर और ग्राहक असंतोष सहित महत्वपूर्ण व्यावसायिक परिणामों के कारण लागत प्रारंभिक व्यय से 100 गुना तक बढ़ सकती है। यह नियम ख़राब डेटा गुणवत्ता के घातीय प्रभाव को रेखांकित करता है, जिससे संगठनों के लिए डेटा अवलोकन में निवेश करना महत्वपूर्ण हो जाता है, जो समस्याओं को, यदि वे उत्पन्न होती हैं, मूल कारण बनाम डाउनस्ट्रीम के करीब रखने में मदद करता है।

निष्कर्ष

डेटा गुणवत्ता के मुद्दे व्यवसायों को महत्वपूर्ण रूप से प्रभावित करते हैं, जिससे संसाधनों की बर्बादी होती है और अवसर चूक जाते हैं। खराब डेटा से जुड़े जोखिमों को रोकने और कम करने के लिए डेटा अवलोकन में निवेश करना आवश्यक है। मात्रात्मक मेट्रिक्स का लाभ उठाकर और गैर-मात्रात्मक कारकों पर विचार करके, संगठन डेटा अवलोकन की आरओआई को माप सकते हैं और निर्णय निर्माताओं को इसका मूल्य प्रदर्शित कर सकते हैं। डेटा विश्वास सुनिश्चित करना, प्रभावी डोमेन निर्णय लेने को बढ़ावा देना, नियमों का अनुपालन करना और एक संतुष्ट डेटा टीम को बढ़ावा देना डेटा गुणवत्ता पहल के लाभों को अधिकतम करने के सभी महत्वपूर्ण पहलू हैं। डेटा अवलोकन को अपनाना एक रणनीतिक निवेश है जो आज की डेटा-संचालित दुनिया में डेटा की सटीकता, विश्वसनीयता और उपयोग की सुरक्षा करता है।

जो संगठन एक समृद्ध अवलोकन अभ्यास का निर्माण करते हैं, उनके अंतर्संबंधित वातावरण में अधिक दृश्यता होती है, जो कम आउटेज, तेजी से समस्या समाधान, उनके ऐप्स की विश्वसनीयता में अधिक आत्मविश्वास - और अंततः, अधिक राजस्व और अधिक खुश ग्राहकों में तब्दील होती है।

- एसईओ संचालित सामग्री और पीआर वितरण। आज ही प्रवर्धित हो जाओ।

- प्लेटोडेटा.नेटवर्क वर्टिकल जेनरेटिव एआई। स्वयं को शक्तिवान बनाएं। यहां पहुंचें।

- प्लेटोआईस्ट्रीम। Web3 इंटेलिजेंस। ज्ञान प्रवर्धित। यहां पहुंचें।

- प्लेटोईएसजी. कार्बन, क्लीनटेक, ऊर्जा, पर्यावरण, सौर, कचरा प्रबंधन। यहां पहुंचें।

- प्लेटोहेल्थ। बायोटेक और क्लिनिकल परीक्षण इंटेलिजेंस। यहां पहुंचें।

- स्रोत: https://www.dataversity.net/putting-a-number-on-bad-data/

- :हैस

- :है

- :नहीं

- :कहाँ

- $यूपी

- 000

- 1

- 100x

- 2016

- 2022

- 9

- a

- क्षमता

- About

- ऊपर

- समायोजित

- अनुसार

- अकौन्टस(लेखा)

- जमा हुआ

- शुद्धता

- सही

- प्राप्त करने

- स्वीकार करना

- Ad

- इसके अलावा

- को संबोधित

- एजेंसी

- युग

- आकाशवाणी

- एयरलाइंस

- सब

- अनुमति देना

- की अनुमति दे

- की अनुमति देता है

- भी

- an

- विश्लेषक

- विश्लेषिकी

- और

- लगभग

- स्थापत्य

- हैं

- क्षेत्र

- उठता

- चारों ओर

- AS

- पहलुओं

- आकलन

- मूल्यांकन

- जुड़े

- At

- ध्यान

- उपलब्ध

- औसत

- जागरूक

- बुरा

- बुरा डेटा

- आधारभूत

- आधार

- लड़ाई

- BE

- बन

- हो जाता है

- बनने

- जा रहा है

- नीचे

- लाभ

- बेहतर

- के बीच

- बड़ा

- बिलियन

- के छात्रों

- लाना

- टूटा

- निर्माण

- इमारत

- बोझ

- व्यापार

- व्यवसाय प्रधान

- व्यापार के संचालन

- व्यापार की उपलब्धि

- व्यवसायों

- लेकिन

- by

- कर सकते हैं

- रद्द

- टोपी

- मामला

- मामलों

- कुश्ती

- कारण

- के कारण होता

- के कारण

- केंद्रीकृत

- चुनौतीपूर्ण

- संयोग

- वर्गीकरण

- वर्गीकृत

- करीब

- CO

- आता है

- संवाद स्थापित

- कंपनियों

- कंपनी

- कंपनी का है

- जटिलता

- अनुपालन

- आत्मविश्वास

- परिणाम

- Consequences

- पर विचार

- स्थिर

- उपभोक्ताओं

- सही

- लागत

- महंगा

- लागत

- सका

- उल्टा

- कवर

- भरोसा

- श्रेय

- महत्वपूर्ण

- निर्णायक मोड़

- महत्वपूर्ण

- संस्कृति

- ग्राहक

- ग्राहक

- दैनिक

- क्षति

- खतरनाक

- डैशबोर्ड

- डैशबोर्ड

- तिथि

- डेटा प्लेटफार्म

- डेटा तैयारी

- गोपनीय आँकड़ा

- आँकड़े की गुणवत्ता

- डेटा विज्ञान

- डेटा पर ही आधारित

- डाटाबेस

- डेटावर्सिटी

- दिन

- व्यवहार

- विकेन्द्रीकृत

- निर्णय

- निर्णय लेने वालों को

- दिखाना

- विभागों

- निर्भर करता है

- पता लगाना

- पता चला

- खोज

- मुश्किल

- डिजिटल

- प्रत्यक्ष

- विघटन

- अवरोधों

- दस्तावेज़

- कुछ दस्तावेज़ीकृत

- डोमेन

- नीचे

- नाली

- ड्राइव

- दो

- आसानी

- प्रभावी

- प्रभावी रूप से

- प्रयास

- प्रयासों

- गले

- पर जोर देती है

- कर्मचारी

- सुनिश्चित

- सुनिश्चित

- प्रविष्टि

- वातावरण

- वातावरण

- Equifax

- त्रुटियाँ

- गहरा हो जाना

- आवश्यक

- अनुमानित

- अनुमान

- आदि

- ईथर (ईटीएच)

- का मूल्यांकन

- कार्यक्रम

- प्रत्येक

- उद्विकासी

- उदाहरण

- अत्यधिक

- उम्मीदों

- अनुभव

- का पता लगाने

- घातीय

- बाहरी

- बाहर से

- तथ्य

- कारकों

- और तेज

- पसंदीदा

- कम

- वित्तीय

- खोज

- अंत

- प्रथम

- पांच

- टिकट

- इस प्रकार है

- के लिए

- फ़ोर्ब्स

- मजबूर

- को बढ़ावा देने

- ढांचा

- आवृत्ति

- से

- सामने

- निराश

- और भी

- लाभ

- गार्टनर

- GDPR

- देना

- Go

- चला जाता है

- अच्छा

- अधिक से अधिक

- बहुत

- बढ़ रहा है

- विकास

- था

- हो जाता

- खुश

- कठिन

- है

- स्वास्थ्य

- दिल

- मदद करता है

- हाई

- बाधा पहुंचाना

- समग्र

- कैसे

- तथापि

- एचटीएमएल

- HTTPS

- विशाल

- सैकड़ों

- चोट

- संकर

- i

- विचार

- पहचान करना

- if

- प्रभाव

- प्रभावित

- लागू करने के

- कार्यान्वयन

- कार्यान्वयन

- निहितार्थ

- महत्वपूर्ण

- लगाया

- में सुधार लाने

- in

- अन्य में

- ग़लत

- घटना

- घटनाएं

- सहित

- बढ़ जाती है

- सूचक

- उद्योगों

- उद्योग

- प्रभावित

- करें-

- स्वाभाविक

- प्रारंभिक

- पहल

- नवोन्मेष

- सहायक

- अभिन्न

- के भीतर

- में

- निवेश करना

- निवेश करना

- निवेश

- शामिल

- आयरलैंड

- मुद्दा

- मुद्दों

- IT

- आईटी इस

- ख़तरे में डालना

- काम

- केवल

- रखना

- कुंजी

- जानना

- ज्ञान

- परिदृश्य

- बड़ा

- नेतृत्व

- नेता

- नेताओं

- प्रमुख

- बाएं

- कानूनी

- उधारदाताओं

- कम

- लाभ

- जीवन चक्र

- पसंद

- संभावित

- जुड़ा हुआ

- लॉगिंग

- देखिए

- देख

- हार

- बंद

- हानि

- खोया

- LP

- बनाए रखना

- बनाता है

- निर्माण

- प्रबंध

- बाजार

- मार्केट कैप

- मार्केट का निरीक्षण

- परिपक्व

- अधिकतम करने के लिए

- अधिकतम

- मई..

- साधन

- माप

- उपायों

- मिलना

- उल्लेख

- मीट्रिक

- मेट्रिक्स

- दस लाख

- नाबालिग

- छेड़छाड़

- चुक गया

- कम करना

- आदर्श

- आधुनिक

- मॉनिटर

- निगरानी

- अधिक

- और भी

- अधिकांश

- my

- जरूरत

- की जरूरत है

- नकारात्मक

- नेटफ्लिक्स

- नया

- अगला

- संख्या

- उद्देश्य

- होते हैं

- घटना

- of

- अक्सर

- on

- एक बार

- ONE

- केवल

- परिचालन

- संचालन

- राय

- अवसर

- or

- आदेश

- संगठन

- संगठनों

- मूल

- अन्य

- अन्य

- की कटौती

- बाहर

- के ऊपर

- कुल

- आला दर्जे का

- भाग

- प्रति

- प्रदर्शन

- स्टाफ़

- व्यक्तिगत डेटा

- की योजना बना

- मंच

- प्लेटो

- प्लेटो डेटा इंटेलिजेंस

- प्लेटोडाटा

- बिन्दु

- की ओर अग्रसर

- गरीब

- संभावित

- अभ्यास

- प्रथाओं

- तैयारी

- को रोकने के

- पिछला

- सिद्धांत

- प्राथमिकता

- एकांत

- मुसीबत

- समस्याओं

- एस्ट्रो मॉल

- उत्पादन

- उत्पादकता

- उत्पाद

- को बढ़ावा देना

- उचित

- प्रस्ताव

- रक्षा करना

- सार्वजनिक रूप से

- उद्देश्य

- गुणवत्ता

- मात्रात्मक

- जल्दी से

- मूल्यांकन करें

- बल्कि

- पहुँचती है

- तत्परता

- वास्तव में

- हाल ही में

- मान्यता प्राप्त

- को कम करने

- घटी

- को कम करने

- हासिल

- नियम

- विश्वसनीयता

- भरोसा करना

- दोहराया गया

- की सूचना दी

- रिपोर्टिंग

- संकल्प

- हल करने

- उपयुक्त संसाधन चुनें

- जिम्मेदारी

- जिम्मेदार

- परिणाम

- वापसी

- राजस्व

- धनी

- सही

- जोखिम

- जोखिम

- मजबूती

- आरओआई

- जड़

- नियम

- सुरक्षा उपायों

- वही

- संतोष

- संतुष्ट

- अनुमापकता

- स्केल

- विज्ञान

- वैज्ञानिकों

- स्कोर

- भेजें

- भावना

- संवेदनशील

- गंभीर

- सेवा

- सेवा की

- सर्वर

- सेवा

- कई

- तीव्रता

- जहाज

- चाहिए

- महत्व

- महत्वपूर्ण

- काफी

- डाल दिए

- उसी प्रकार

- आकार

- बढ़ना

- समाधान

- कुछ

- कुछ

- सोर्सिंग

- खर्च

- खर्च

- ट्रेनिंग

- चक्कर

- हितधारकों

- प्रारंभ

- शुरुआत में

- वर्णित

- कदम

- सामरिक

- सामरिक निवेश

- रणनीतियों

- नदियों

- मजबूत

- संघर्ष

- सफलता

- ऐसा

- समर्थन

- प्रणाली

- लेता है

- कार्य

- टीम

- टीमों

- तकनीक

- कहना

- से

- कि

- RSI

- लेकिन हाल ही

- उन

- वहाँ।

- इसलिये

- वे

- इसका

- हजारों

- धमकी

- यहाँ

- भर

- पहर

- सेवा मेरे

- आज का दि

- ले गया

- उपकरण

- की ओर

- ट्रेसिंग

- ट्रैक

- कारोबार

- परंपरागत

- यातायात

- अनुवाद करना

- यात्रियों

- उपचार

- वास्तव में

- ट्रस्ट

- कारोबार

- टाइप

- यूके

- अंत में

- नीचे

- रेखांकित

- समझना

- समझ

- चल पाता

- इकाइयों

- उपरिकाल

- उपयोग

- प्रयुक्त

- मूल्यवान

- मूल्य

- विभिन्न

- बहुत

- देखें

- देखी

- दृश्यता

- परिवर्तनशील

- संस्करणों

- vs

- चपेट में

- करना चाहते हैं

- बर्बाद

- तरीके

- we

- सप्ताह

- थे

- क्या

- कब

- कौन कौन से

- जब

- कौन

- क्यों

- व्यापक रूप से

- मर्जी

- साथ में

- अंदर

- बिना

- शब्द

- काम

- काम किया

- विश्व

- लायक

- होगा

- WSJ

- वर्ष

- इसलिए आप

- आपका

- जेफिरनेट