J'ai discuté récemment avec Stelios Diamantidis (architecte émérite, responsable de la stratégie, Autonomous Design Solutions) de l'annonce de Synopsys sur le 100th enregistrement client à l'aide de leur solution DSO.ai. Ma préoccupation concernant les articles liés à l'IA est d'éviter le battage médiatique qui entoure l'IA en général et, à l'inverse, le scepticisme en réaction à ce battage médiatique qui incite certains à rejeter toutes les affirmations sur l'IA comme de l'huile de serpent. J'étais heureux d'entendre Stelios rire et être entièrement d'accord. Nous avons eu une discussion très approfondie sur ce que DSO.ai peut faire aujourd'hui, ce que ses clients de référence voient dans la solution (en fonction de ce qu'il peut faire aujourd'hui) et ce qu'il pourrait me dire sur la technologie.

Ce que fait DSO.ai

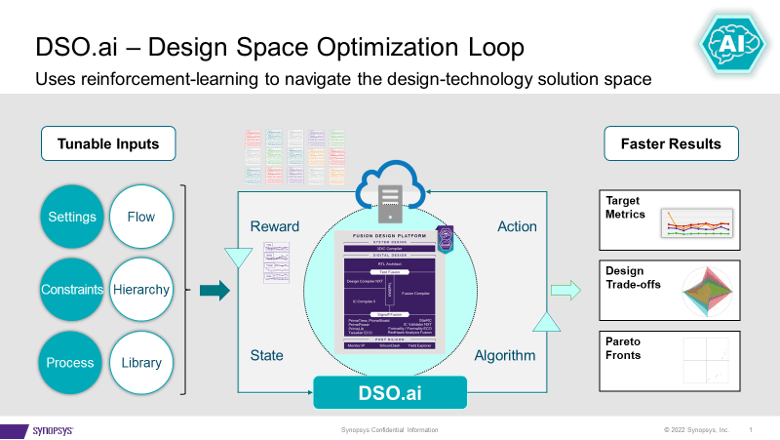

DSO.ai s'associe à Fusion Compiler et IC Compiler II, ce qui, comme Stelios a pris soin de le souligner, signifie qu'il s'agit d'une solution d'optimisation au niveau des blocs ; Les SoC complets ne sont pas encore une cible. Cela correspond aux pratiques de conception actuelles, car Stelios a déclaré qu'un objectif important était de s'intégrer facilement dans les flux existants. L'objectif de cette technologie est de permettre aux ingénieurs d'implémentation, souvent un seul ingénieur, d'améliorer leur productivité tout en explorant un espace de conception plus large pour un meilleur PPA que celui qui aurait pu être découvert autrement.

Synopsys a annoncé la première sortie au cours de l'été 2021 et a maintenant annoncé 100 sorties. Cela témoigne bien de la demande et de l’efficacité d’une solution comme celle-ci. Stelios a ajouté que la valeur devient encore plus évidente pour les applications qui doivent instancier un bloc plusieurs fois. Pensez à un serveur multicœur, un GPU ou un commutateur réseau. Optimisez un bloc une fois, instanciez-le plusieurs fois – cela peut représenter une amélioration significative du PPA.

J'ai demandé si les clients qui font cela travaillent tous à 7 nm et moins. Étonnamment, il existe une utilisation active jusqu’à 40 nm. Un exemple intéressant est un contrôleur flash, une conception qui n'est pas très sensible aux performances mais qui peut fonctionner sur des dizaines, voire des centaines de millions d'unités. Réduire la taille, même de 5 %, peut avoir un impact important sur les marges.

Qu'y a-t-il sous le capot

DSO.ai est basé sur l'apprentissage par renforcement, un sujet brûlant ces jours-ci mais je n'ai promis aucun battage médiatique dans cet article. J’ai demandé à Stelios d’approfondir un peu plus, mais je n’ai pas été surpris lorsqu’il a dit qu’il ne pouvait pas en révéler trop. Ce qu'il pouvait me dire était assez intéressant. Il a souligné que dans des applications plus générales, un cycle à travers un ensemble de formation (une époque) suppose une méthode rapide (de quelques secondes à quelques minutes) pour évaluer les prochaines étapes possibles, par le biais de comparaisons de gradients par exemple.

Mais une conception sérieuse des blocs ne peut pas être optimisée avec des estimations rapides. Chaque essai doit parcourir tout le flux de production, en correspondance avec les processus de fabrication réels. Des flux dont l’exécution peut prendre des heures. Une partie de la stratégie pour un apprentissage par renforcement efficace compte tenu de cette contrainte est le parallélisme. Le reste est de la sauce secrète DSO.ai. Vous pouvez certainement imaginer que si cette sauce secrète peut apporter des améliorations efficaces basées sur une époque donnée, alors le parallélisme accélérera les progrès à travers l’époque suivante.

À cette fin, cette fonctionnalité doit réellement fonctionner dans un cloud pour prendre en charge le parallélisme. Le cloud privé sur site est une option. Microsoft a annoncé qu'il hébergeait DSO.ai sur Azure, et ST rapporte dans le communiqué de presse DSO.ai qu'il a utilisé cette fonctionnalité pour optimiser la mise en œuvre d'un noyau Arm. J'imagine qu'il pourrait y avoir des débats intéressants sur les avantages et les inconvénients de l'exécution d'une optimisation dans un cloud public sur, disons, 1000 XNUMX serveurs si la réduction de zone en vaut la peine.

Commentaires des clients

Synopsys affirme que ses clients (dont ST et SK Hynix dans cette annonce) signalent des augmentations de productivité multipliées par 3, une puissance totale inférieure de 25 % et une réduction significative de la taille de la puce, le tout avec une utilisation réduite des ressources globales. Compte tenu de ce que Stelios a décrit, cela me semble raisonnable. L'outil permet d'explorer plus de points dans l'espace d'état de conception dans un calendrier donné que ce qui serait possible si cette exploration était manuelle. Tant que l'algorithme de recherche (la sauce secrète) est efficace, cela permettrait bien sûr de trouver un meilleur optimal qu'une recherche manuelle.

Bref, ni battage médiatique sur l’IA, ni huile de serpent. DSO.ai suggère que l’IA entre dans le courant dominant en tant qu’extension technique crédible des flux existants. Vous pouvez en apprendre davantage auprès du communiqué de presse et à partir cet article..

Partagez cet article via:

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- Platoblockchain. Intelligence métaverse Web3. Connaissance Amplifiée. Accéder ici.

- La source: https://semiwiki.com/artificial-intelligence/324430-synopsys-design-space-optimization-hits-a-milestone/

- 100

- 2021

- a

- Qui sommes-nous

- accélérer

- à travers

- infection

- ajoutée

- AI

- algorithme

- Tous

- permet

- ainsi que

- annoncé

- NOUVEAUTÉ!

- applications

- Réservé

- BRAS

- autour

- article

- sur notre blog

- autonome

- en évitant

- Azure

- basé

- devient

- ci-dessous

- Améliorée

- Big

- Bit

- Block

- prudent

- Assurément

- prétentions

- le cloud

- comment

- PROBLÈMES DE PEAU

- Inconvénients

- contrôleur

- Core

- pourriez

- cours

- crédible

- Courant

- des clients

- Clients

- cycle

- jours

- débats

- Demande

- décrit

- Conception

- J'ai noté la

- spirituelle

- Fermer

- Distingué

- faire

- down

- chacun

- même

- Efficace

- efficacité

- mettre en relief

- permettre

- ingénieur

- ENGINEERING

- Les ingénieurs

- assez

- époque

- estimations

- Pourtant, la

- exemple

- existant

- exploration

- Explorant

- extension

- RAPIDE

- Trouvez

- Prénom

- s'adapter

- Flash

- flux

- Flux

- de

- plein

- la fusion

- Général

- donné

- objectif

- GPU

- heureux vous

- front

- ici

- Hits

- hébergement

- HOT

- HEURES

- HTTPS

- Hype

- Impact

- la mise en oeuvre

- important

- améliorer

- amélioration

- in

- Y compris

- Augmente

- intéressant

- IT

- plus importantes

- rire

- APPRENTISSAGE

- apprentissage

- Location

- LES PLANTES

- Courant dominant

- Manuel

- fabrication

- de nombreuses

- cartographie

- marges

- largeur maximale

- veux dire

- méthode

- Microsoft

- pourrait

- étape importante

- million

- minutes

- PLUS

- Ni

- réseau et

- next

- évident

- Huile

- ONE

- à mettre en œuvre pour gérer une entreprise rentable. Ce guide est basé sur trois décennies d'expérience

- Optimiser

- optimisé

- optimum

- Option

- autrement

- global

- partie

- performant

- Platon

- Intelligence des données Platon

- PlatonDonnées

- Point

- des notes bonus

- possible

- Post

- power

- pratiques

- Press

- Communiqués de presse

- Privé

- les process

- Vidéo

- productivité

- Progrès

- promis

- AVANTAGES

- public

- cloud public

- but

- Rapide

- réaction

- réal

- raisonnable

- récemment

- Prix Réduit

- réduire

- apprentissage par renforcement

- libérer

- rapport

- Rapports

- Ressources

- REST

- révéler

- Courir

- pour le running

- Saïd

- calendrier

- Rechercher

- secondes

- secret

- sensible

- grave

- set

- Shorts

- significative

- unique

- Taille

- Scepticisme

- sur mesure

- Solutions

- quelques

- Space

- parle

- Région

- Étapes

- de Marketing

- Suggère

- été

- Support

- surpris

- Interrupteur

- Prenez

- Target

- Technologie

- Les

- La Région

- leur

- Avec

- fois

- à

- aujourd'hui

- trop

- outil

- sujet

- Total

- Formation

- procès

- sous

- unités

- utilisé

- Plus-value

- via

- Quoi

- qui

- tout en

- sera

- dans les

- de travail

- vaut

- pourra

- zéphyrnet