Les progrès récents dans le développement des LLM ont popularisé leur utilisation pour diverses tâches de PNL qui étaient auparavant abordées à l'aide d'anciennes méthodes d'apprentissage automatique. Les grands modèles linguistiques sont capables de résoudre une variété de problèmes linguistiques tels que la classification, le résumé, la récupération d'informations, la création de contenu, la réponse à des questions et le maintien d'une conversation, le tout en utilisant un seul modèle. Mais comment savoir s’ils font du bon travail dans toutes ces différentes tâches ?

L'essor des LLM a mis en lumière un problème non résolu : nous ne disposons pas d'une norme fiable pour les évaluer. Ce qui rend l’évaluation plus difficile, c’est qu’ils sont utilisés pour des tâches très diverses et qu’il nous manque une définition claire de ce qui constitue une bonne réponse pour chaque cas d’utilisation.

Cet article traite des approches actuelles d'évaluation des LLM et présente un nouveau classement LLM tirant parti de l'évaluation humaine qui améliore les techniques d'évaluation existantes.

La première et habituelle forme d’évaluation initiale consiste à exécuter le modèle sur plusieurs ensembles de données sélectionnés et à examiner ses performances. HuggingFace a créé un Classement ouvert LLM où les grands modèles en libre accès sont évalués à l'aide de quatre ensembles de données bien connus (Défi de raisonnement AI2 , HellaSwag , MMLU , AQ véridique). Cela correspond à une évaluation automatique et vérifie la capacité du modèle à obtenir des faits pour certaines questions spécifiques.

Ceci est un exemple de question du MMLU jeu de données.

Sujet : collège_médecine

Question : Un effet secondaire attendu de la supplémentation en créatine est le suivant.

- A) faiblesse musculaire

- B) gain de masse corporelle

- C) crampes musculaires

- D) perte d'électrolytes

Réponse: (B)

La notation du modèle en fonction de la réponse à ce type de question est une mesure importante et sert bien à la vérification des faits, mais elle ne teste pas la capacité générative du modèle. C'est probablement le plus gros inconvénient de cette méthode d'évaluation, car la génération de texte libre est l'une des fonctionnalités les plus importantes des LLM.

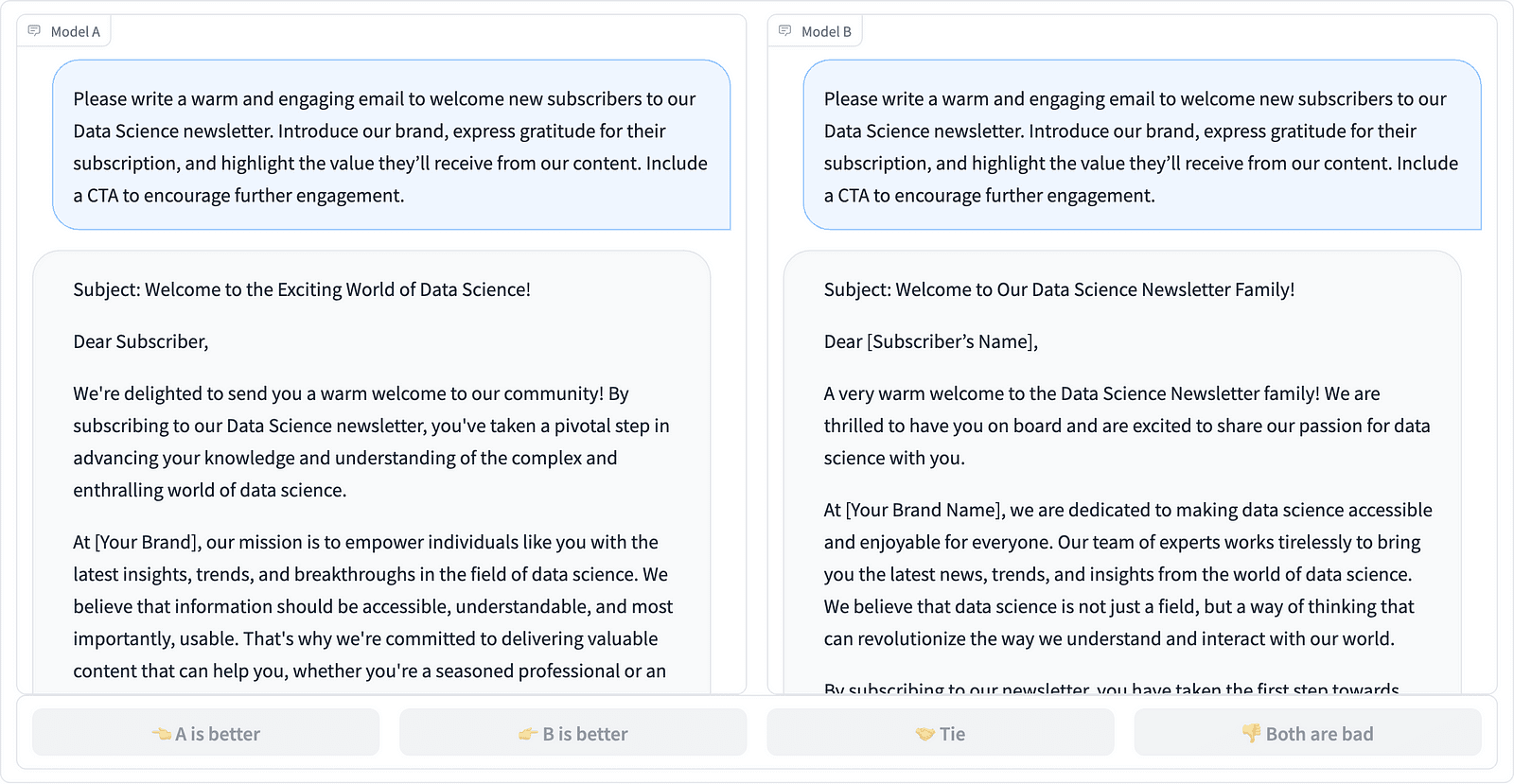

Il semble y avoir un consensus au sein de la communauté selon lequel pour évaluer correctement le modèle, nous avons besoin d'une évaluation humaine. Cela se fait généralement en comparant les réponses de différents modèles.

Comparaison de deux achèvements d'invite dans le projet LMSYS – capture d'écran de l'auteur

Les annotateurs décident quelle réponse est la meilleure, comme le montre l'exemple ci-dessus, et quantifient parfois la différence de qualité des réponses rapides. LMSYS Org a créé un classement qui utilise ce type d'évaluation humaine et compare 17 modèles différents, rapportant le Classement Elo pour chaque modèle.

Étant donné que l'évaluation humaine peut être difficile à mettre à l'échelle, des efforts ont été déployés pour étendre et accélérer le processus d'évaluation, ce qui a abouti à un projet intéressant appelé AlpagaEval. Ici, chaque modèle est comparé à une référence (text-davinci-003 fourni par GPT-4) et l'évaluation humaine est remplacée par le jugement GPT-4. C'est en effet rapide et évolutif, mais pouvons-nous faire confiance au modèle ici pour effectuer la notation ? Nous devons être conscients des biais des modèles. Le projet a en effet montré que GPT-4 pourrait favoriser des réponses plus longues.

Les méthodes d'évaluation LLM continuent d'évoluer à mesure que la communauté de l'IA recherche des approches simples, équitables et évolutives. Le dernier développement vient de l'équipe de Toloka avec un nouveau classement faire progresser davantage les normes d’évaluation actuelles.

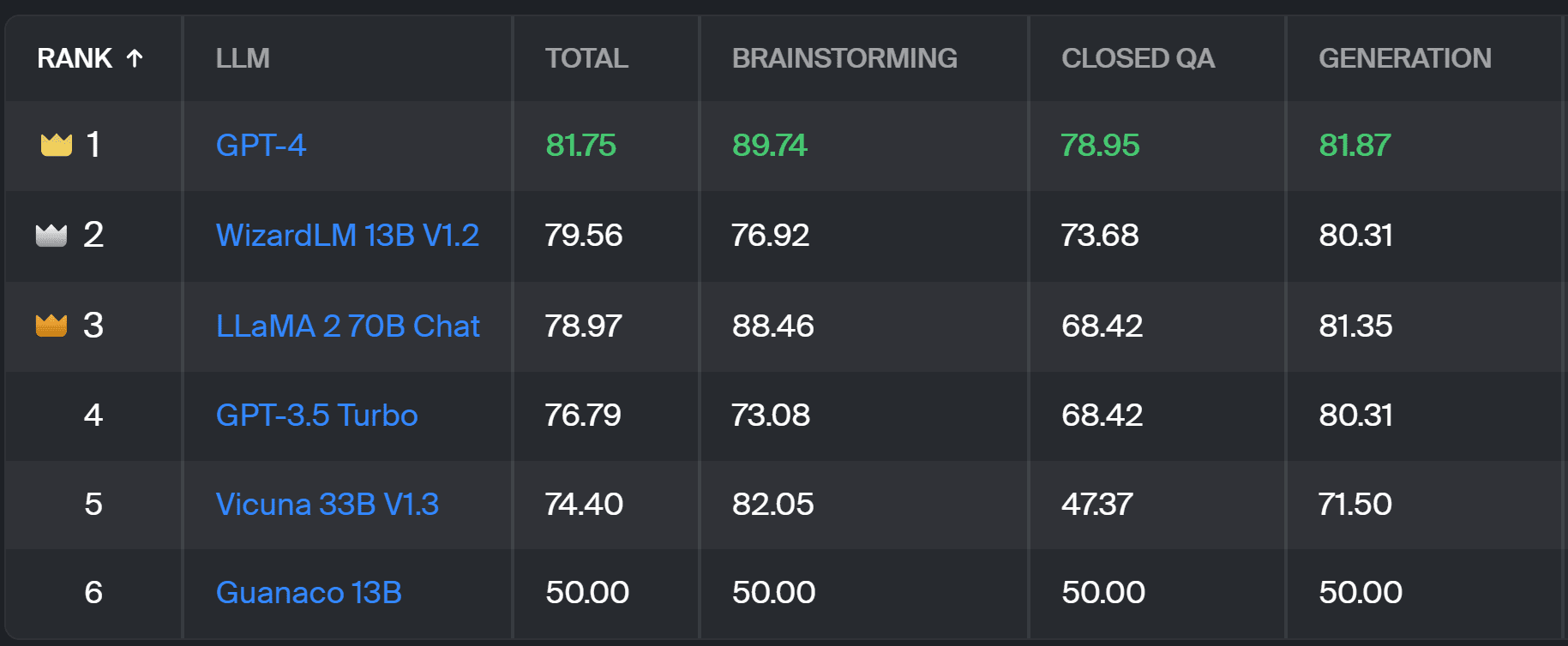

Le nouveau système d’ classement compare les réponses du modèle aux invites des utilisateurs du monde réel qui sont classées par tâches PNL utiles, comme indiqué dans ce document InstructGPT. Il montre également le taux de victoire global de chaque modèle dans toutes les catégories.

Classement Toloka – capture d'écran de l'auteur

L'évaluation utilisée pour ce projet est similaire à celle réalisée dans AlpacaEval. Les scores du classement représentent le taux de victoire du modèle respectif par rapport au Guanaco 13B modèle, qui sert ici de comparaison de base. Le choix de Guanaco 13B est une amélioration de la méthode AlpacaEval, qui utilise comme base de référence le modèle text-davinci-003, bientôt obsolète.

L'évaluation réelle est effectuée par des annotateurs experts humains sur un ensemble d'invites du monde réel. Pour chaque invite, les annotateurs reçoivent deux complétions et il leur est demandé lequel ils préfèrent. Vous pouvez trouver des détails sur la méthodologie ici.

Ce type d'évaluation humaine est plus utile que toute autre méthode d'évaluation automatique et devrait améliorer l'évaluation humaine utilisée pour le Classement LMSYS. L'inconvénient de la méthode LMSYS est que toute personne possédant le lien peuvent participer à l’évaluation, ce qui soulève de sérieuses questions sur la qualité des données ainsi recueillies. Une foule fermée d'annotateurs experts a un meilleur potentiel pour obtenir des résultats fiables, et Toloka applique des techniques de contrôle qualité supplémentaires pour garantir la qualité des données.

Dans cet article, nous avons présenté une nouvelle solution prometteuse pour évaluer les LLM : le Toloka Leaderboard. L'approche est innovante, combine les atouts des méthodes existantes, ajoute une granularité spécifique à la tâche et utilise des techniques d'annotation humaine fiables pour comparer les modèles.

Explorez le tableau et partagez avec nous vos opinions et suggestions d’amélioration.

Magdalena Konkiewicz est Data Evangelist chez Toloka, une entreprise mondiale soutenant le développement rapide et évolutif de l'IA. Elle est titulaire d'une maîtrise en intelligence artificielle de l'Université d'Édimbourg et a travaillé en tant qu'ingénieur PNL, développeur et data scientist pour des entreprises en Europe et en Amérique. Elle a également participé à l'enseignement et au mentorat de Data Scientists et contribue régulièrement à des publications sur la science des données et l'apprentissage automatique.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://www.kdnuggets.com/a-better-way-to-evaluate-llms?utm_source=rss&utm_medium=rss&utm_campaign=a-better-way-to-evaluate-llms

- :possède

- :est

- :ne pas

- :où

- $UP

- 17

- a

- capacité

- Qui sommes-nous

- au dessus de

- à travers

- présenter

- actually

- Supplémentaire

- Ajoute

- avancer

- avances

- AI

- Tous

- aussi

- Amérique

- an

- ainsi que le

- répondre

- réponses

- tous

- s'applique

- une approche

- approches

- SONT

- Arena

- article

- artificiel

- intelligence artificielle

- AS

- At

- Automatique

- conscients

- b

- Baseline

- BE

- car

- était

- Améliorée

- biais

- Le plus grand

- planche

- corps

- Apporté

- entreprises

- mais

- by

- CAN

- capable

- maisons

- catégories

- challenge

- Contrôles

- le choix

- classification

- clair

- fonds à capital fermé

- moissonneuses-batteuses

- vient

- Communautés

- Société

- comparer

- par rapport

- comparant

- Comparaison

- Consensus

- contenu

- création de contenu

- continue

- contribue

- des bactéries

- Conversation

- correspond

- créée

- création

- foule

- organisée

- Courant

- données

- qualité des données

- science des données

- Data Scientist

- ensembles de données

- décider

- définition

- Degré

- détails

- Développeur

- Développement

- différence

- différent

- Désavantage

- plusieurs

- do

- faire

- fait

- Ne pas

- inconvénient

- chacun

- Easy

- Edinburgh

- effet

- efforts

- électrolytes

- ingénieur

- assurer

- Europe

- évaluer

- évalué

- évaluer

- évaluation

- Évangéliste

- évolue

- examiner

- exemple

- existant

- attendu

- expert

- réalités

- juste

- RAPIDE

- favoriser

- Fonctionnalités:

- Trouvez

- Prénom

- Pour

- formulaire

- quatre

- Gratuit

- De

- plus

- Gain

- recueillies

- générateur

- génératif

- obtenez

- GitHub

- donné

- Global

- Bien

- bon travail

- Dur

- Plus fort

- Vous avez

- ici

- très

- détient

- Comment

- HTTPS

- Étreindre

- humain

- important

- améliorer

- amélioration

- améliorations

- améliore

- in

- d'information

- initiale

- technologie innovante

- Intelligence

- intéressant

- introduit

- Introduit

- impliqué

- IT

- SES

- Emploi

- juste

- juste un

- KDnuggetsGenericName

- Savoir

- Peindre

- langue

- gros

- Nouveautés

- apprentissage

- en tirant parti

- lumière

- plus long

- perte

- click

- machine learning

- le maintien

- FAIT DU

- manière

- Masse

- maître

- Mai..

- mentorat

- méthode

- Méthodologie

- méthodes

- métrique

- modèle

- numériques jumeaux (digital twin models)

- PLUS

- (en fait, presque toutes)

- Besoin

- Nouveauté

- nouvelle solution

- nlp

- of

- plus

- on

- ONE

- ouvert

- Avis

- Autre

- décrit

- global

- partie

- effectuer

- performant

- effectué

- Platon

- Intelligence des données Platon

- PlatonDonnées

- défaillances

- préfère

- précédemment

- Probablement

- Problème

- d'ouvrabilité

- processus

- Projet

- prometteur

- instructions

- correctement

- à condition de

- publications

- qualité

- question

- fréquemment posées

- élevage

- Tarif

- monde réel

- régulièrement

- fiable

- remplacé

- Rapports

- représentent

- ceux

- réponse

- réponses

- résulté

- Résultats

- Augmenter

- Courir

- s

- évolutive

- Escaliers intérieurs

- Sciences

- Scientifique

- scientifiques

- scores

- marquant

- recherches

- semble

- vu

- grave

- sert

- set

- plusieurs

- Partager

- elle

- devrait

- montré

- Spectacles

- côté

- similaires

- unique

- sur mesure

- Résoudre

- quelques

- parfois

- groupe de neurones

- vitesse

- Standard

- Normes

- forces

- tel

- Appuyer

- Prenez

- tâches

- Enseignement

- équipe

- techniques

- tester

- texte

- que

- qui

- Les

- leur

- Les

- Là.

- Ces

- l'ont

- this

- à

- La confiance

- deux

- type

- typiquement

- université

- sur

- us

- Utilisation

- utilisé

- cas d'utilisation

- d'utiliser

- Utilisateur

- Usages

- en utilisant

- habituel

- variété

- Façon..

- we

- faiblesse

- WELL

- bien connu

- ont été

- Quoi

- Qu’est ce qu'

- qui

- gagner

- comprenant

- dans les

- travaillé

- you

- Votre

- zéphyrnet