Faits marquants

- La propagation de la pensée (TP) est une nouvelle méthode qui améliore les capacités de raisonnement complexes des grands modèles linguistiques (LLM).

- TP exploite des problèmes analogues et leurs solutions pour améliorer le raisonnement, plutôt que de faire raisonner les LLM à partir de zéro.

- Les expériences réalisées sur diverses tâches montrent que TP surpasse considérablement les méthodes de base, avec des améliorations allant de 12 % à 15 %.

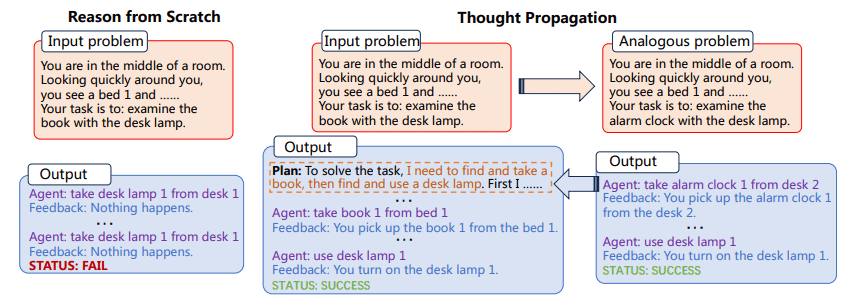

TP invite d'abord les LLM à proposer et à résoudre un ensemble de problèmes analogues liés à celui d'entrée. Ensuite, TP réutilise les résultats de problèmes analogues pour produire directement une nouvelle solution ou dériver un plan d'exécution à forte intensité de connaissances pour modifier la solution initiale obtenue à partir de zéro.

La polyvalence et la puissance de calcul des grands modèles linguistiques (LLM) sont indéniables, mais elles ne sont pas sans limites. L'un des défis les plus importants et les plus constants des LLM est leur approche générale de la résolution de problèmes, consistant à raisonner à partir des premiers principes pour chaque nouvelle tâche rencontrée. Ceci est problématique, car cela permet un haut degré d’adaptabilité, mais augmente également le risque d’erreurs, en particulier dans les tâches qui nécessitent un raisonnement en plusieurs étapes.

Le défi du « raisonnement à partir de zéro » est particulièrement prononcé dans les tâches complexes qui nécessitent plusieurs étapes de logique et d’inférence. Par exemple, si l’on demande à un LLM de trouver le chemin le plus court dans un réseau de points interconnectés, il ne tirera généralement pas parti de ses connaissances antérieures ou de problèmes analogues pour trouver une solution. Au lieu de cela, il tenterait de résoudre le problème de manière isolée, ce qui pourrait conduire à des résultats sous-optimaux, voire à des erreurs pures et simples. Entrer Propagation de la pensée (TP), une méthode conçue pour augmenter les capacités de raisonnement des LLM. TP vise à surmonter les limites inhérentes aux LLM en leur permettant de puiser dans un réservoir de problèmes analogues et de leurs solutions correspondantes. Cette approche innovante améliore non seulement la précision des solutions générées par LLM, mais améliore également considérablement leur capacité à aborder des tâches de raisonnement complexes en plusieurs étapes. En tirant parti de la puissance de l’analogie, TP fournit un cadre qui amplifie les capacités de raisonnement innées des LLM, nous rapprochant ainsi de la réalisation de systèmes artificiels véritablement intelligents.

La propagation de la pensée implique deux étapes principales :

- Premièrement, le LLM est invité à proposer et à résoudre un ensemble de problèmes analogues liés au problème d'entrée.

- Ensuite, les solutions à ces problèmes analogues sont utilisées soit pour produire directement une nouvelle solution, soit pour modifier la solution initiale.

Le processus d'identification de problèmes analogues permet au LLM de réutiliser des stratégies et des solutions de résolution de problèmes, améliorant ainsi ses capacités de raisonnement. TP est compatible avec les méthodes d'invite existantes, fournissant une solution généralisable qui peut être intégrée à diverses tâches sans ingénierie spécifique spécifique à la tâche.

Figure 1: Le processus de propagation de la pensée (Image tirée d'un papier)

De plus, la capacité d’adaptation du TP ne doit pas être sous-estimée. Sa compatibilité avec les méthodes d'invite existantes en fait un outil très polyvalent. Cela signifie que TP ne se limite à aucun type spécifique de domaine de résolution de problèmes. Cela ouvre des perspectives passionnantes pour le réglage et l’optimisation de tâches spécifiques, augmentant ainsi l’utilité et l’efficacité des LLM dans un large spectre d’applications.

La mise en œuvre de la propagation de la pensée peut être intégrée au flux de travail des LLM existants. Par exemple, dans une tâche de raisonnement sur le chemin le plus court, TP pourrait d’abord résoudre un ensemble de problèmes analogues plus simples pour comprendre différents chemins possibles. Il utiliserait ensuite ces informations pour résoudre le problème complexe, augmentant ainsi la probabilité de trouver la solution optimale.

Exemple 1

- Tâche: Raisonnement par le plus court chemin

- Problèmes analogues: Chemin le plus court entre le point A et B, Chemin le plus court entre le point B et C

- Solution finale: Chemin optimal du point A au point C compte tenu des solutions de problèmes analogues

Exemple 2

- Tâche: Écriture créative

- Problèmes analogues: Écrivez une courte histoire sur l'amitié, Écrivez une courte histoire sur la confiance

- Solution finale: Écrivez une nouvelle complexe qui intègre les thèmes de l'amitié et de la confiance

Le processus implique d’abord de résoudre ces problèmes analogues, puis d’utiliser les connaissances acquises pour s’attaquer à la tâche complexe à accomplir. Cette méthode a démontré son efficacité sur plusieurs tâches, démontrant des améliorations substantielles des indicateurs de performance.

Les implications de Thought Propagation vont au-delà de la simple amélioration des mesures existantes. Cette technique d'incitation a le potentiel de modifier la façon dont nous comprenons et déployons les LLM. La méthodologie souligne le passage d’une résolution de problèmes isolée et atomique à une approche plus holistique et interconnectée. Cela nous incite à réfléchir à la manière dont les LLM peuvent apprendre non seulement des données, mais aussi du processus de résolution de problèmes lui-même. En mettant continuellement à jour leur compréhension grâce aux solutions à des problèmes analogues, les LLM équipés de TP sont mieux préparés à relever des défis imprévus, les rendant plus résilients et adaptables dans des environnements en évolution rapide.

La propagation de la pensée est un ajout prometteur à la boîte à outils de méthodes d'incitation visant à améliorer les capacités des LLM. En permettant aux LLM d'exploiter des problèmes analogues et leurs solutions, TP fournit une méthode de raisonnement plus nuancée et plus efficace. Les expériences confirment son efficacité, ce qui en fait une stratégie candidate pour améliorer les performances des LLM dans une variété de tâches. TP pourrait à terme représenter une avancée significative dans la recherche de systèmes d’IA plus performants.

Matthieu Mayo (@mattmayo13) est titulaire d'une maîtrise en informatique et d'un diplôme d'études supérieures en fouille de données. En tant que rédacteur en chef de KDnuggets, Matthew vise à rendre accessibles les concepts complexes de la science des données. Ses intérêts professionnels incluent le traitement du langage naturel, les algorithmes d’apprentissage automatique et l’exploration de l’IA émergente. Il est animé par la mission de démocratiser les connaissances dans la communauté de la science des données. Matthew code depuis l'âge de 6 ans.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://www.kdnuggets.com/thought-propagation-an-analogical-approach-to-complex-reasoning-with-large-language-models?utm_source=rss&utm_medium=rss&utm_campaign=thought-propagation-an-analogical-approach-to-complex-reasoning-with-large-language-models

- :possède

- :est

- :ne pas

- $UP

- 15%

- 8

- a

- capacités

- capacité

- Qui sommes-nous

- accessible

- précision

- à travers

- ajout

- AI

- Systèmes d'IA

- Destinée

- vise

- algorithmes

- Permettre

- permet

- aussi

- amplifie

- an

- ainsi que le

- tous

- applications

- une approche

- SONT

- artificiel

- AS

- At

- tentative

- augmenter

- pistes

- b

- Baseline

- BE

- était

- Améliorée

- jusqu'à XNUMX fois

- Au-delà

- Apporter

- vaste

- mais

- by

- CAN

- candidat

- capacités

- capable

- challenge

- globaux

- plus

- Codage

- Communautés

- compatibilité

- compatible

- complexe

- calcul

- puissance de calcul

- ordinateur

- Informatique

- concepts

- Confirmer

- Considérer

- considérant

- cohérent

- Qui consiste

- continuellement

- Correspondant

- pourriez

- Conception

- données

- data mining

- science des données

- Degré

- Demande

- démocratiser

- démontré

- déployer

- un

- directement

- domaine

- dessiner

- entraîné

- éditeur en chef

- Efficace

- efficacité

- efficacité

- non plus

- l'élévation

- économies émergentes.

- ENGINEERING

- Améliore

- améliorer

- Entrer

- environnements

- équipé

- Erreurs

- notamment

- Pourtant, la

- Chaque

- évolution

- exemple

- passionnant

- exécution

- existant

- expériences

- Explorer

- Trouvez

- trouver

- Prénom

- Pour

- Avant

- Framework

- Relation amicale

- De

- gagné

- Général

- Go

- diplôme

- main

- he

- Haute

- très

- sa

- détient

- holistique

- Comment

- HTTPS

- identifier

- if

- image

- la mise en oeuvre

- implications

- améliorer

- améliorations

- améliore

- l'amélioration de

- in

- comprendre

- Incorporée

- Augmente

- croissant

- inhérent

- initiale

- inné

- technologie innovante

- contribution

- idées.

- plutôt ;

- des services

- Intègre

- Intelligent

- interconnecté

- intérêts

- développement

- implique

- isolé

- seul

- IT

- SES

- lui-même

- jpg

- juste

- KDnuggetsGenericName

- Genre

- spécialisées

- langue

- gros

- conduire

- APPRENTISSAGE

- apprentissage

- Levier

- les leviers

- en tirant parti

- probabilité

- LIMIT

- limites

- limité

- logique

- click

- machine learning

- Entrée

- a prendre une

- FAIT DU

- Fabrication

- maître

- matthew

- Mai..

- veux dire

- seulement

- méthode

- Méthodologie

- méthodes

- Métrique

- Mines

- Mission

- numériques jumeaux (digital twin models)

- PLUS

- (en fait, presque toutes)

- plusieurs

- Nature

- Langage naturel

- Traitement du langage naturel

- réseau et

- Nouveauté

- nouvelle solution

- roman

- obtenu

- of

- Vieux

- on

- ONE

- uniquement

- ouvre

- optimaux

- à mettre en œuvre pour gérer une entreprise rentable. Ce guide est basé sur trois décennies d'expérience

- or

- Surperforme

- carrément

- Overcome

- Papier

- particulièrement

- chemin

- performant

- plan

- Platon

- Intelligence des données Platon

- PlatonDonnées

- Point

- des notes bonus

- possible

- défaillances

- power

- préparé

- principes

- Avant

- Problème

- résolution de problèmes

- d'ouvrabilité

- processus

- traitement

- professionels

- prometteur

- prononcé

- propagation

- proposer

- fournit

- aportando

- allant

- rapidement

- plutôt

- la concrétisation

- raison

- en relation

- rendu

- représentent

- exigent

- résilient

- Résultats

- réutiliser

- s

- Sciences

- gratter

- Rechercher

- set

- décalage

- Shorts

- devrait

- montrer

- mettre en valeur

- significative

- de façon significative

- depuis

- sur mesure

- Solutions

- RÉSOUDRE

- Résoudre

- groupe de neurones

- Spectre

- étapes

- Étapes

- Histoire

- les stratégies

- de Marketing

- Ces

- substantiellement

- Système

- tacle

- Tâche

- tâches

- technique

- que

- qui

- Les

- leur

- Les

- thèmes

- puis

- ainsi

- Ces

- l'ont

- this

- pensée

- Avec

- à

- outil

- Boîte à outils

- vers

- tp

- vraiment

- La confiance

- deux

- typiquement

- En fin de compte

- indéniable

- soulignés

- comprendre

- compréhension

- imprévu

- la mise à jour

- us

- utilisé

- d'utiliser

- en utilisant

- utilitaire

- variété

- divers

- polyvalente

- la versatilité

- était

- we

- qui

- comprenant

- sans

- workflow

- pourra

- écrire

- écriture

- années

- encore

- Rendement

- zéphyrnet