Après des années de développement, Meta pourrait enfin déployer ses accélérateurs d’IA locaux de manière significative cette année.

L’empire Facebook a confirmé cette semaine sa volonté de compléter les déploiements de GPU Nvidia H100 et AMD MI300X avec sa famille de puces Meta Training Inference Accelerator (MTIA). Plus précisément, Meta déploiera un processeur optimisé pour l'inférence, aurait pour nom de code Artemis, basé sur les pièces de première génération du géant de la Silicon Valley taquiné l'année dernière.

"Nous sommes enthousiasmés par les progrès que nous avons réalisés dans nos efforts internes en matière de silicium avec MTIA et sommes sur la bonne voie pour commencer à déployer notre variante d'inférence en production en 2024", a déclaré un porte-parole de Meta. Le registre le jeudi.

"Nous considérons que nos accélérateurs développés en interne sont hautement complémentaires aux GPU disponibles dans le commerce en offrant la combinaison optimale de performances et d'efficacité sur les charges de travail spécifiques aux méta", a poursuivi le représentant. Détails? Non. Le porte-parole nous a dit : « Nous sommes impatients de partager davantage de mises à jour sur nos futurs projets MTIA plus tard cette année. »

Nous considérons que cela signifie que la puce axée sur l'inférence de deuxième génération est largement déployée, après une version de première génération réservée aux laboratoires pour l'inférence, et nous découvrirons peut-être plus tard les pièces destinées principalement à la formation ou à la formation et à l'inférence.

Meta est devenu l'un des meilleurs clients de Nvidia et d'AMD à mesure que son déploiement de charges de travail d'IA s'est développé, augmentant ainsi son besoin et son utilisation de silicium spécialisé pour faire fonctionner son logiciel d'apprentissage automatique aussi rapidement que possible. Ainsi, la décision du géant d’Instagram de développer ses propres processeurs personnalisés n’est pas si surprenante.

En fait, à première vue, la méga-entreprise est relativement en retard par rapport au silicium personnalisé de l’IA en termes de déploiement dans le monde réel. Amazon et Google utilisent depuis quelques années des composants développés en interne pour accélérer les systèmes internes d'apprentissage automatique, tels que les modèles de recommandation et le code ML des clients. Pendant ce temps, Microsoft a dévoilé l’année dernière ses accélérateurs locaux.

Mais au-delà du fait que Meta déploie une puce d'inférence MTIA à grande échelle, le réseau social n'a pas divulgué son architecture précise ni quelles charges de travail il réserve au silicium interne et lesquelles il décharge sur les GPU d'AMD et de Nvidia.

Il est probable que Meta exécutera des modèles établis sur ses ASIC personnalisés afin de libérer des ressources GPU pour des applications plus dynamiques ou évolutives. Nous avons déjà vu Meta emprunter cette voie avec des accélérateurs personnalisés conçus pour décharger des données et calculer des charges de travail vidéo intensives.

En ce qui concerne la conception sous-jacente, les observateurs de l'industrie de SemiAnalysis nous disent que la nouvelle puce est étroitement basée sur l'architecture des pièces de première génération de Meta.

Tremplins

Annoncées début 2023 après trois années de développement, les pièces MTIA v1 de Meta, que nos amis de La prochaine plateforme regardé au printemps dernier, ont été conçus spécifiquement en pensant aux modèles de recommandation d’apprentissage profond.

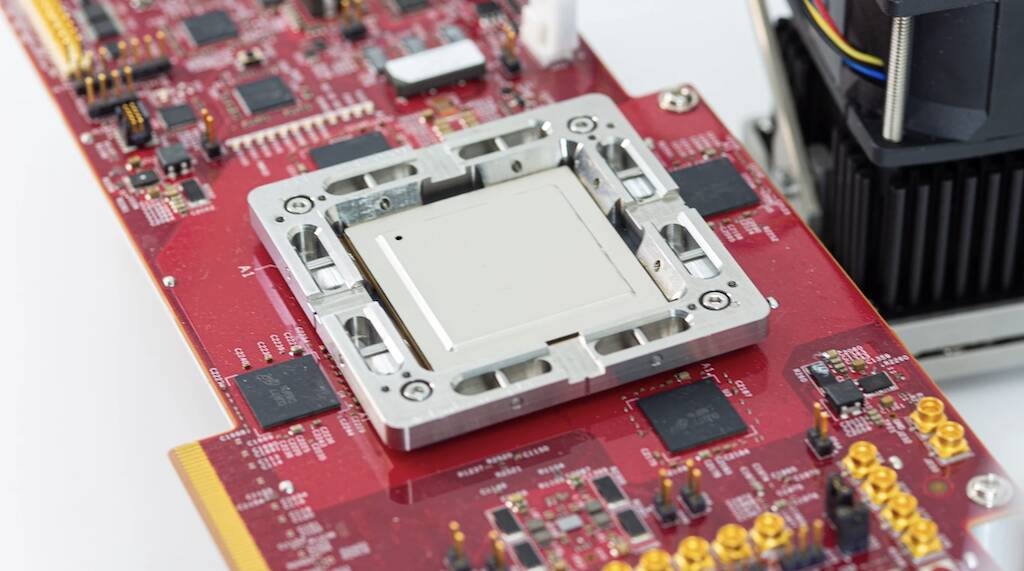

La puce de première génération a été construite autour d'un cluster de processeurs RISC-V et fabriquée à l'aide du processus 7 nm de TSMC. Sous le capot, le composant utilisait une matrice de huit sur huit d'éléments de traitement, chacun équipé de deux cœurs de processeur RV, dont l'un est équipé d'extensions mathématiques vectorielles. Ces cœurs sont alimentés par un généreux 128 Mo de SRAM sur puce et jusqu'à 128 Go de mémoire LPDDR5.

Comme Meta l'a affirmé l'année dernière, la puce fonctionnait à 800 MHz et atteignait 102.4 billions d'opérations par seconde de performance INT8 ou 51.2 téraFLOPS à demi-précision (FP16). En comparaison, le H100 de Nvidia est capable de près de quatre pétaFLOPS de performances FP8 clairsemées. Bien qu'elle soit loin d'être aussi puissante que les GPU Nvidia ou AMD, la puce présentait un avantage majeur : la consommation d'énergie. La puce elle-même avait une puissance thermique nominale de seulement 25 watts.

Selon Semi-analyse, la dernière puce de Meta possède des cœurs améliorés et échange le LPDDR5 contre une mémoire à large bande passante emballée à l'aide de la technologie puce sur plaquette sur substrat (CoWoS) de TSMC.

Une autre différence notable est que la puce de deuxième génération de Meta sera effectivement déployée à grande échelle dans l'infrastructure de son centre de données. Selon le titan de Facebook, même si la pièce de première génération a été utilisée pour exécuter des modèles publicitaires de production, elle n'a jamais quitté le laboratoire.

À la poursuite de l’intelligence artificielle générale

Mis à part les pièces personnalisées, le parent Facebook et Instagram a abandonné milliards de dollars sur les GPU ces dernières années pour accélérer toutes sortes de tâches mal adaptées aux plates-formes CPU conventionnelles. Cependant, la montée en puissance de grands modèles de langage, tels que GPT-4 et Llama 2 de Meta, ont modifié le paysage et entraîné le déploiement de clusters GPU massifs.

À l'échelle où Meta opère, ces tendances ont nécessité des changements drastiques dans son infrastructure, y compris le reconcevoir de plusieurs centres de données pour répondre aux immenses besoins en énergie et en refroidissement associés aux grands déploiements d’IA.

Et les déploiements de Meta ne feront que s'élargir au cours des prochains mois, à mesure que l'entreprise se concentrera du métaverse vers le développant de l’intelligence artificielle générale. On suppose que les travaux effectués sur l’IA aideront à former le métaverse ou quelque chose comme ça.

Selon le PDG Mark Zuckerberg, Meta prévoit de déployer jusqu'à 350,000 100 Nvidia HXNUMX cette année seulement.

L'entreprise a également annoncé son intention de déployer les nouveaux processeurs AMD lancé GPU MI300X dans ses centres de données. Zuckerberg a affirmé que son entreprise terminerait l'année avec une puissance de calcul équivalente à 600,000 100 HXNUMX. Il est donc clair que les puces MTIA de Meta ne remplaceront pas les GPU de si tôt. ®

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://go.theregister.com/feed/www.theregister.com/2024/02/02/meta_ai_chips/

- :possède

- :est

- $UP

- 000

- 102

- 2%

- 2023

- 2024

- 25

- 350

- 4

- 51

- 600

- 800

- a

- Qui sommes-nous

- accélérer

- accélérateur

- accélérateurs

- Selon

- à travers

- actually

- Avantage

- Numérique

- Après

- AI

- Tous

- seul

- aux côtés de

- aussi

- Amazon

- AMD

- an

- ainsi que les

- annoncé

- applications

- architecture

- SONT

- autour

- artificiel

- intelligence générale artificielle

- AS

- Asics

- de côté

- associé

- At

- disponibles

- basé

- BE

- devenez

- était

- before

- LES MEILLEURS

- Au-delà

- biz

- bénéficie d'

- construit

- by

- capable

- CEO

- modifié

- Modifications

- puce

- chips

- revendiqué

- clairement

- étroitement

- Grappe

- CO

- code

- commercialement

- Société

- Comparaison

- complémentaire

- composant

- composants électriques

- calcul

- informatique

- Puissance de calcul

- CONFIRMÉ

- consommation

- a continué

- conventionnel

- SOCIÉTÉ

- Processeur

- Customiser

- des clients

- Clients

- données

- Datacenter

- décision

- livrer

- déployer

- déployer

- déploiement

- déploiements

- Conception

- un

- désir

- détails

- développer

- développé

- Développement

- DID

- différence

- dollars

- fait

- down

- entraîné

- Dynamic

- chacun

- "Early Bird"

- efficace

- efforts

- non plus

- éléments

- Empire

- employés

- fin

- équipé

- Équivalent

- établies

- Ether (ETH)

- évolution

- excité

- extensions

- Visage

- fait

- famille

- RAPIDE

- Fed

- few

- finalement

- Trouvez

- Focus

- Abonnement

- Pour

- formulaire

- Avant

- quatre

- Gratuit

- amis

- de

- avenir

- Général

- intelligence générale

- généreux

- obtenez

- géant

- Go

- aller

- GPU

- GPU

- cultivé

- ait eu

- Half

- Vous avez

- vous aider

- très

- sa

- chez nous

- capuche

- Cependant

- HTTPS

- immense

- amélioré

- in

- Y compris

- croissant

- industrie

- Infrastructure

- Intelligence

- prévu

- intensif

- interne

- intérieurement

- ISN

- IT

- SES

- lui-même

- jpg

- juste

- laboratoire

- paysage d'été

- langue

- gros

- plus importantes

- Nom de famille

- L'année dernière

- En retard

- plus tard

- Nouveautés

- à gauche

- comme

- Probable

- Flamme

- Style

- LES PLANTES

- majeur

- a prendre une

- manière

- de nombreuses

- marque

- Marque zuckerberg

- massif

- math

- Matrice

- Mai..

- signifier

- significative

- En attendant

- Mémoire

- Meta

- Métaverse

- Microsoft

- l'esprit

- mélanger

- ML

- numériques jumeaux (digital twin models)

- mois

- PLUS

- Près

- presque

- Besoin

- réseau et

- n'allons jamais

- Nouveauté

- nouvelle puce

- nouvellement

- next

- ni

- notable

- Nvidia

- of

- on

- ONE

- uniquement

- exploite

- Opérations

- optimaux

- or

- nos

- ande

- plus de

- propre

- emballé

- partie

- les pièces

- fête

- /

- performant

- plans

- Plateformes

- Platon

- Intelligence des données Platon

- PlatonDonnées

- possible

- power

- solide

- précis

- La précision

- qui se déroulent

- processus

- traitement

- Processeur

- processeurs

- Vidéo

- Progrès

- RE

- monde réel

- récent

- relativement

- Exigences

- Resources

- Reuters

- Révélé

- Augmenter

- Roulent

- Roulant

- Itinéraire

- Courir

- s

- Escaliers intérieurs

- Deuxièmement

- sur le lien

- vu

- plusieurs

- partage

- Changements

- Silicium

- Silicon Valley

- So

- Réseaux sociaux

- réseaux sociaux

- Logiciels

- quelques

- quelque chose

- disponible

- clairsemé

- spécialisé

- spécifiquement

- porte-parole

- printemps

- Commencer

- tel

- complément

- Support

- surprenant

- Système

- T

- prise

- tâches

- technologie

- dire

- conditions

- qui

- Les

- Le paysage

- Le métaverse

- thermique

- Ces

- this

- cette semaine

- cette année

- trois

- Jeudi

- Ainsi

- Titan

- à

- dit

- surmonté

- suivre

- métiers

- Formation

- Trends

- Billion

- TSMC

- deux

- sous

- sous-jacent

- Actualités

- us

- utilisé

- d'utiliser

- en utilisant

- v1

- Vallée

- Variante

- Ve

- vecteur

- version

- Vidéo

- était

- Façon..

- we

- semaine

- ont été

- qui

- tout en

- largement

- répandu

- sera

- comprenant

- A gagné

- activités principales

- pourra

- an

- années

- zéphyrnet

- Zuckerberg