Des chercheurs australiens développent des lunettes intelligentes pour les aveugles, en utilisant une technologie appelée « toucher acoustique » pour transformer les images en sons. Les premières expériences suggèrent que cette technologie audio spatiale portable pourrait aider les personnes aveugles ou ayant une vision considérablement réduite à localiser des objets à proximité.

Les récentes améliorations de la réalité augmentée, de la technologie pratique des caméras portables et de la vision par ordinateur basée sur l'apprentissage profond accélèrent le développement des lunettes intelligentes en tant que technologie d'assistance viable et multifonctionnelle pour les personnes aveugles ou malvoyantes. Ces lunettes intelligentes intègrent des caméras, des systèmes GPS, un microphone et des unités de mesure inertielle et de détection de profondeur pour fournir des fonctions telles que la navigation, le contrôle de la reconnaissance vocale ou le rendu d'objets, de texte ou d'environnements sous forme de parole synthétisée par ordinateur.

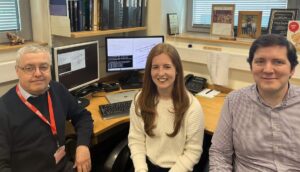

Howe Yuan Zhu et des collègues de l'Université de technologie de Sydney (UTS) Et le Université de Sydney a étudié l'ajout du toucher acoustique aux lunettes intelligentes, une approche qui utilise le balayage de la tête et l'activation d'icônes auditives lorsque les objets apparaissent dans un champ de vision (FOV) défini.

Ecrire dans PLoS ONE, les chercheurs expliquent que le toucher acoustique offre plusieurs avantages par rapport aux approches existantes, notamment une facilité d'intégration avec la technologie des lunettes intelligentes et une utilisation plus intuitive que la parole synthétisée par ordinateur. De tels systèmes peuvent également nécessiter moins de formation pour que les utilisateurs deviennent compétents.

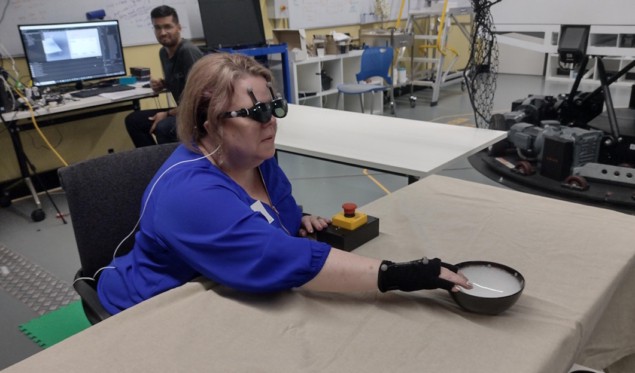

En collaboration avec ARIA Research de Sydney (qui a récemment remporté Entreprise technologique australienne de l’année pour ses innovations pionnières en matière de technologie de vision), l'équipe a créé un dispositif audio fovéal (FAD) pour tester ces hypothèses sur sept volontaires malvoyants ou malvoyants, ainsi que sur sept participants voyants aux yeux bandés. Le FAD comprend un smartphone et des lunettes de réalité augmentée NREAL, auxquelles l'équipe a attaché des marqueurs réfléchissants de capture de mouvement pour permettre le suivi des mouvements de la tête.

Le FAD effectue la reconnaissance des objets et détermine la distance de l'objet à l'aide des caméras stéréo installées sur les lunettes. Il attribue ensuite des icônes auditives appropriées aux objets, comme le son d'un livre qui tourne une page, par exemple. Lorsqu'un porteur pivote la tête, le taux de répétition des icônes auditives change en fonction de la position de l'objet dans le champ de vision auditif.

Les volontaires ont participé à des exercices assis et debout. La tâche assise les obligeait à utiliser diverses méthodes pour rechercher et manipuler des objets du quotidien, notamment un livre, une bouteille, un bol ou une tasse, placés sur une ou plusieurs tables. Cette tâche mesurait leur capacité à détecter un objet, à reconnaître un son et à mémoriser la position de l'objet.

Les chercheurs ont conçu cette tâche pour comparer les performances du FAD avec deux signaux vocaux conventionnels : les instructions verbales du cadran de l'horloge ; et la lecture séquentielle d'icônes auditives provenant de haut-parleurs colocalisés avec chaque élément. Ils ont constaté que pour les participants aveugles ou malvoyants, les performances utilisant le FAD étaient comparables aux deux conditions idéalisées. Le groupe des voyants aux yeux bandés a cependant obtenu de moins bons résultats lors de l'utilisation du FAD.

Un implant cérébral permet à une femme aveugle de voir des formes simples

La tâche d'atteinte debout obligeait les participants à utiliser le FAD pour rechercher et atteindre un élément cible situé parmi plusieurs éléments de distraction. Les participants devaient trouver des objets placés sur trois tables entourés de quatre bouteilles de formes différentes. Cette tâche évaluait principalement les performances fonctionnelles du système et le comportement humain lors de l'utilisation de mouvements de tout le corps pendant la recherche.

"Cette année, nous avons beaucoup exploré l'utilisation du paysage sonore auditif pour prendre en charge diverses tâches complexes", explique Zhu. Monde de la Physique. "Nous avons notamment exploré l’utilisation de différents types de sons spatialisés pour guider les personnes lors de la navigation et accompagner les activités sportives, notamment le tennis de table. L’année prochaine, nous espérons continuer à élargir ces domaines et mener des études dans des contextes réels.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://physicsworld.com/a/acoustic-touch-technology-helps-blind-people-see-using-sound/

- :est

- 90

- a

- capacité

- accélérer

- Selon

- acoustique

- Activation

- d'activités

- ajout

- avantages

- aussi

- parmi

- an

- ainsi que le

- apparaître

- une approche

- approches

- approprié

- SONT

- domaines

- air

- AS

- évalué

- hypothèses

- At

- acoustique

- technologie audio

- augmentée

- Réalité Augmentée

- Australie

- devenez

- était

- comportement

- aveugle

- livre

- tous les deux

- by

- appelé

- appareil photo

- de CAMÉRAS de surveillance

- Modifications

- collègues

- COM

- Société

- comparable

- comparer

- complexe

- comprend

- ordinateur

- Vision par ordinateur

- conditions

- Conduire

- continuer

- des bactéries

- conventionnel

- pourriez

- créée

- Coupe

- profond

- défini

- livrer

- profondeur

- un

- détecter

- détermine

- développement

- Développement

- dispositif

- différent

- instructions

- distance

- pendant

- chacun

- facilité

- permettre

- permet

- de tous les jours

- exemple

- existant

- expansion

- expériences

- Expliquer

- Exploré

- Explorer

- Trouvez

- Pour

- trouvé

- quatre

- De

- fonctionnel

- fonctions

- lunettes

- gps

- Réservation de groupe

- guide

- manipuler

- Vous avez

- front

- fortement

- vous aider

- aide

- d'espérance

- Cependant

- HTTPS

- humain

- icônes

- image

- satellite

- améliorations

- in

- Y compris

- intégrer

- d'information

- initiale

- innovations

- l'intégration

- développement

- intuitif

- aide

- IT

- articles

- SES

- jpg

- laboratoire

- moins

- Faible

- largeur maximale

- Mai..

- mesuré

- mesures

- membre

- méthodes

- microphone

- mixte

- réalité mixte

- PLUS

- mouvement

- mouvement

- mouvements

- plusieurs

- Navigation

- Nouveauté

- next

- aucune

- Nréal

- objet

- objets

- of

- Offres Speciales

- on

- ONE

- or

- plus de

- partie

- participants

- particulier

- Personnes

- performant

- effectué

- effectue

- Physique

- Monde de la physique

- Nous travaillons à vous offrir une solution de transport

- mis

- plateforme

- Platon

- Intelligence des données Platon

- PlatonDonnées

- jouer

- plus

- position

- positionnée

- Méthode

- qui se déroulent

- Tarif

- nous joindre

- atteindre

- monde réel

- Réalité

- récemment

- reconnaissance

- reconnaître

- rendu

- exigent

- conditions

- un article

- chercheurs

- balayage

- Rechercher

- recherche

- sur le lien

- Paramétres

- sept

- plusieurs

- formes

- de façon significative

- étapes

- situé

- smart

- Lunettes intelligentes

- smartphone

- Son

- Spatial

- haut-parleurs

- spécifiquement

- discours

- permanent

- études

- tel

- suggérer

- Support

- Appuyer

- entouré

- sydney

- combustion propre

- Système

- table

- Target

- Tâche

- tâches

- équipe

- Technologie

- raconte

- tennis

- tester

- texte

- que

- qui

- Les

- leur

- Les

- puis

- Ces

- l'ont

- this

- ceux

- trois

- thumbnail

- à

- a

- -nous

- Tracking

- Formation

- oui

- TOUR

- deux

- types

- unités

- université

- utilisé

- utilisateurs

- Usages

- en utilisant

- divers

- viable

- vision

- Voix

- reconnaissance vocale

- bénévole

- était

- we

- portable

- ont été

- quand

- qui

- WHO

- comprenant

- dans les

- femme

- A gagné

- world

- pire

- an

- Yuan

- zéphyrnet