1Département de physique, Université de Waterloo, Waterloo, ON, N2L 3G1, Canada

2Institut d'informatique quantique, Waterloo, ON, N2L 3G1, Canada

3Institut Perimeter de physique théorique, Waterloo, Ontario, N2L 2Y5, Canada

4Xanadu, Toronto, ON, M5G 2C8, Canada

Vous trouvez cet article intéressant ou souhaitez en discuter? Scite ou laisse un commentaire sur SciRate.

Abstract

Le succès généralisé des réseaux de neurones profonds a révélé une surprise dans l’apprentissage automatique classique : des modèles très complexes se généralisent souvent bien tout en surajustant simultanément les données d’entraînement. Ce phénomène de surapprentissage bénin a été étudié pour divers modèles classiques dans le but de mieux comprendre les mécanismes à l’origine de l’apprentissage profond. Caractériser le phénomène dans le contexte de l’apprentissage automatique quantique pourrait également améliorer notre compréhension de la relation entre le surajustement, le surparamétrage et la généralisation. Dans ce travail, nous proposons une caractérisation du surajustement bénin dans les modèles quantiques. Pour ce faire, nous dérivons le comportement d'un modèle classique d'interpolation de caractéristiques de Fourier pour la régression sur des signaux bruités, et montrons comment une classe de modèles quantiques présente des caractéristiques analogues, reliant ainsi la structure des circuits quantiques (tels que les opérations de codage de données et de préparation d'état ) au surparamétrage et au surajustement dans les modèles quantiques. Nous expliquons intuitivement ces caractéristiques en fonction de la capacité du modèle quantique à interpoler des données bruitées avec un comportement localement « pointu » et fournissons un exemple concret de démonstration de surapprentissage bénin.

► Données BibTeX

► Références

Michael A. Nielsen. « Réseaux de neurones et apprentissage profond ». Presse de détermination. (2015). URL : http://neuralnetworksanddeeplearning.com/.

http:///neuralnetworksanddeeplearning.com/

Stuart Geman, Elie Bienenstock et René Doursat. « Les réseaux de neurones et le dilemme biais/variance ». Calcul neuronal. 4, 1–58 (1992).

https: / / doi.org/ 10.1162 / neco.1992.4.1.1

Trevor Hastie, Robert Tibshirani, Jérôme H Friedman et Jérôme H Friedman. « Les éléments de l'apprentissage statistique : exploration de données, inférence et prédiction ». Tome 2. Springer. (2009).

https://doi.org/10.1007/978-0-387-84858-7

Peter L. Bartlett, Andrea Montanari et Alexander Rakhlin. « Deep learning : un point de vue statistique ». Acta Numerica 30, 87-201 (2021).

https: / / doi.org/ 10.1017 / S0962492921000027

Mikhaïl Belkin. « Ajuster sans crainte : phénomènes mathématiques remarquables du deep learning au prisme de l’interpolation ». Acta Numerica 30, 203-248 (2021).

Peter L. Bartlett, Philip M. Long, Gábor Lugosi et Alexander Tsigler. « Surapprentissage bénin en régression linéaire ». Proc. Natl. Acad. Sci. 117, 30063-30070 (2020).

https: / / doi.org/ 10.1073 / pnas.1907378117

Mikhaïl Belkin, Daniel Hsu, Siyuan Ma et Soumik Mandal. "Réconcilier les pratiques modernes d'apprentissage automatique et le compromis classique biais-variance". Proc. Natl. Acad. Sci. 116, 15849-15854 (2019).

https: / / doi.org/ 10.1073 / pnas.1903070116

Mikhaïl Belkin, Alexandre Rakhlin et Alexandre B. Tsybakov. « L'interpolation des données contredit-elle l'optimalité statistique ? Dans Actes de recherche sur l’apprentissage automatique. Tome 89, pages 1611-1619. PMLR (2019). URL : https://proceedings.mlr.press/v89/belkin19a.html.

https:///proceedings.mlr.press/v89/belkin19a.html

Vidya Muthukumar, Kailas Vodrahalli, Vignesh Subramanian et Anant Sahai. "Interpolation inoffensive de données bruitées en régression". Journal IEEE sur certains domaines de la théorie de l'information 1, 67-83 (2020).

https: / / doi.org/ 10.1109 / ISIT.2019.8849614

Vidya Muthukumar, Adhyyan Narang, Vignesh Subramanian, Mikhail Belkin, Daniel Hsu et Anant Sahai. « Classification vs régression dans les régimes surparamétrés : la fonction de perte est-elle importante ? ». J. Mach. Apprendre. Rés. 22, 1–69 (2021). URL : http:///jmlr.org/papers/v22/20-603.html.

http: / / jmlr.org/ papers / v22 / 20-603.html

Yehuda Dar, Vidya Muthukumar et Richard G. Baraniuk. « Un adieu au compromis biais-variance ? un aperçu de la théorie de l’apprentissage automatique surparamétré » (2021). arXiv :2109.02355.

arXiv: 2109.02355

Marcello Benedetti, Erika Lloyd, Stefan Sack et Mattia Fiorentini. « Circuits quantiques paramétrés comme modèles d'apprentissage automatique ». Science quantique. Technologie. 4, 043001 (2019).

https://doi.org/10.1088/2058-9565/ab4eb5

K. Mitarai, M. Negoro, M. Kitagawa et K. Fujii. "Apprentissage des circuits quantiques". Phys. Rév. A 98, 032309 (2018).

https: / / doi.org/ 10.1103 / physreva.98.032309

Maria Schuld, Ville Bergholm, Christian Gogolin, Josh Izaac et Nathan Killoran. "Évaluer les gradients analytiques sur le matériel quantique". Phys. Rév. A 99, 032331 (2019).

https: / / doi.org/ 10.1103 / physreva.99.032331

Maria Schuld et Nathan Killoran. "Apprentissage automatique quantique dans les espaces de Hilbert". Phys. Le révérend Lett. 122, 040504 (2019).

https: / / doi.org/ 10.1103 / physrevlett.122.040504

Vojtěch Havlíček, Antonio D. Córcoles, Kristan Temme, Aram W. Harrow, Abhinav Kandala, Jerry M. Chow et Jay M. Gambetta. "Apprentissage supervisé avec des espaces de fonctionnalités améliorés quantiques". Nature 567, 209-212 (2019).

https://doi.org/10.1038/s41586-019-0980-2

Seth Lloyd et Christian Weedbrook. « Apprentissage contradictoire génératif quantique ». Phys. Le révérend Lett. 121, 040502 (2018).

https: / / doi.org/ 10.1103 / physrevlett.121.040502

Pierre-Luc Dallaire-Demers et Nathan Killoran. « Réseaux contradictoires génératifs quantiques ». Phys. Rév.A 98, 012324 (2018).

https: / / doi.org/ 10.1103 / physreva.98.012324

Amira Abbas, David Sutter, Christa Zoufal, Aurélien Lucchi, Alessio Figalli et Stefan Woerner. « La puissance des réseaux de neurones quantiques ». Nat. Calculer. Sci. 1, 403-409 (2021).

https://doi.org/10.1038/s43588-021-00084-1

Logan G. Wright et Peter L. McMahon. « La capacité des réseaux de neurones quantiques ». En 2020 Conférence sur les Lasers et l'Electro-Optique (CLEO). Pages 1-2. (2020). URL : https:///ieeexplore.ieee.org/document/9193529.

https: / / ieeexplore.ieee.org/ document / 9193529

Sukin Sim, Peter D. Johnson et Alán Aspuru-Guzik. "Expressibilité et capacité d'enchevêtrement des circuits quantiques paramétrés pour les algorithmes hybrides quantiques-classiques". Adv. Technologie quantique. 2, 1900070 (2019).

https: / / doi.org/ 10.1002 / qute.201900070

Thomas Hubregtsen, Josef Pichlmeier, Patrick Stecher et Koen Bertels. « Évaluation des circuits quantiques paramétrés : sur la relation entre précision de classification, expressibilité et capacité d'intrication ». Mach quantique. Intell. 3, 1 (2021).

https: / / doi.org/ 10.1007 / s42484-021-00038-w

Jarrod R McClean, Sergio Boixo, Vadim N Smelyanskiy, Ryan Babbush et Hartmut Neven. «Plateaux arides dans les paysages de formation de réseaux neuronaux quantiques». Nat. Commun. 9, 4812 (2018).

https://doi.org/10.1038/s41467-018-07090-4

Marco Cerezo, Akira Sone, Tyler Volkoff, Lukasz Cincio et Patrick J Coles. «Plateaux stériles dépendant de la fonction de coût dans les circuits quantiques paramétrés peu profonds». Nat. Commun. 12, 1791 (2021).

https: / / doi.org/ 10.1038 / s41467-021-21728-w

Matthias C. Caro, Elies Gil-Fuster, Johannes Jakob Meyer, Jens Eisert et Ryan Sweke. « Limites de généralisation dépendantes du codage pour les circuits quantiques paramétrés ». Quantique 5, 582 (2021).

https://doi.org/10.22331/q-2021-11-17-582

Hsin-Yuan Huang, Michael Broughton, Masoud Mohseni, Ryan Babbush, Sergio Boixo, Hartmut Neven et Jarrod R McClean. "La puissance des données dans l'apprentissage automatique quantique". Nat. Commun. 12, 2631 (2021).

https://doi.org/10.1038/s41467-021-22539-9

Matthias C. Caro, Hsin-Yuan Huang, M. Cerezo, Kunal Sharma, Andrew Sornborger, Lukasz Cincio et Patrick J. Coles. "Généralisation de l'apprentissage automatique quantique à partir de quelques données de formation". Nat. Commun. 13, 4919 (2022).

https://doi.org/10.1038/s41467-022-32550-3

Leonardo Banchi, Jason Pereira et Stefano Pirandola. "Généralisation dans l'apprentissage automatique quantique : un point de vue de l'information quantique". PRX Quantique 2, 040321 (2021).

https: / / doi.org/ 10.1103 / PRXQuantum.2.040321

Francisco Javier Gil Vidal et Dirk Oliver Theis. « Redondance d'entrée pour les circuits quantiques paramétrés ». Devant. Phys. 8, 297 (2020).

https: / / doi.org/ 10.3389 / fphy.2020.00297

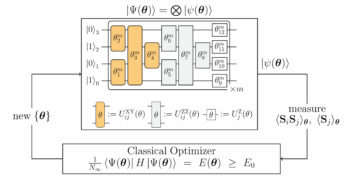

Maria Schuld, Ryan Sweke et Johannes Jakob Meyer. "Effet de l'encodage des données sur le pouvoir expressif des modèles d'apprentissage quantique variationnel". Phys. Rév. A 103, 032430 (2021).

https: / / doi.org/ 10.1103 / physreva.103.032430

David Wierichs, Josh Izaac, Cody Wang et Cédric Yen-Yu Lin. "Règles générales de changement de paramètres pour les gradients quantiques". Quantique 6, 677 (2022).

https://doi.org/10.22331/q-2022-03-30-677

Kendall et Atkinson. "Une introduction à l'analyse numérique". John Wiley et fils. (2008).

Ali Rahimi et Benjamin Recht. "Fonctionnalités aléatoires pour les machines à noyau à grande échelle". Dans Avancées des systèmes de traitement de l'information neuronale. Tome 20. (2007). URL : https:///papers.nips.cc/paper_files/paper/2007/hash/013a006f03dbc5392effeb8f18fda755-Abstract.html.

https://papers.nips.cc/paper_files/paper/2007/hash/013a006f03dbc5392effeb8f18fda755-Abstract.html

Walter Rudin. « Les théorèmes fondamentaux de l'analyse de Fourier ». John Wiley & Fils, Ltd. (1990).

https: / / doi.org/ 10.1002 / 9781118165621.ch1

Song Mei et Andrea Montanari. "L'erreur de généralisation de la régression des caractéristiques aléatoires : asymptotiques précises et courbe de double descente". Commun. Application pure. Mathématiques. 75, 667-766 (2022).

https: / / doi.org/ 10.1002 / cpa.22008

Trevor Hastie, Andrea Montanari, Saharon Rosset et Ryan J. Tibshirani. "Surprises dans l'interpolation des moindres carrés sans crête de grande dimension". Anne. Stat. 50, 949-986 (2022).

https: / / doi.org/ 10.1214 / 21-AOS2133

Tengyuan Liang, Alexander Rakhlin et Xiyu Zhai. "Sur la descente multiple des interpolants de norme minimale et l'isométrie inférieure restreinte des noyaux". Dans Actes de recherche sur l’apprentissage automatique. Volume 125, pages 1 à 29. PMLR (2020). URL : http://proceedings.mlr.press/v125/liang20a.html.

http:///proceedings.mlr.press/v125/liang20a.html

Edward Farhi et Hartmut Neven. "Classification avec des réseaux de neurones quantiques sur des processeurs à court terme" (2018). arXiv:1802.06002.

arXiv: 1802.06002

Maria Schuld, Alex Bocharov, Krysta M. Svore et Nathan Wiebe. "Classificateurs quantiques centrés sur les circuits". Phys. Rév.A 101, 032308 (2020).

https: / / doi.org/ 10.1103 / physreva.101.032308

Adrián Pérez-Salinas, Alba Cervera-Lierta, Elies Gil-Fuster et José I. Latorre. "Re-téléchargement de données pour un classificateur quantique universel". Quantique 4, 226 (2020).

https://doi.org/10.22331/q-2020-02-06-226

Sofiene Jerbi, Lukas J Fiderer, Hendrik Poulsen Nautrup, Jonas M Kübler, Hans J Briegel et Vedran Dunjko. « Apprentissage automatique quantique au-delà des méthodes du noyau ». Nat. Commun. 14, 517 (2023).

https: / / doi.org/ 10.1038 / s41467-023-36159-y

Casper Gyurik, Dyon Vreumingen, van et Vedran Dunjko. « Minimisation des risques structurels pour les classificateurs linéaires quantiques ». Quantique 7, 893 (2023).

https://doi.org/10.22331/q-2023-01-13-893

Marie Schuld. "Les modèles d'apprentissage automatique quantique supervisé sont des méthodes de noyau" (2021). arXiv:2101.11020.

arXiv: 2101.11020

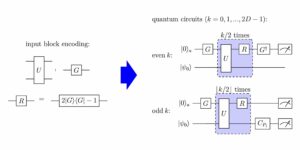

S. Shin, YS Teo et H. Jeong. "Codage exponentiel de données pour l'apprentissage supervisé quantique". Phys. Rév.A 107, 012422 (2023).

https: / / doi.org/ 10.1103 / PhysRevA.107.012422

Sophie Piccard. «Sur les ensembles de distances des ensembles de points d'un espace euclidien.». Mémoires de l'Université de Neuchâtel. Secrétariat de l'Université. (1939).

Dave Wecker, Matthew B. Hastings, Nathan Wiebe, Bryan K. Clark, Chetan Nayak et Matthias Troyer. "Résoudre des modèles électroniques fortement corrélés sur un ordinateur quantique". Phys. Rév.A 92, 062318 (2015).

https: / / doi.org/ 10.1103 / PhysRevA.92.062318

Ian D. Kivlichan, Jarrod McClean, Nathan Wiebe, Craig Gidney, Alán Aspuru-Guzik, Garnet Kin-Lic Chan et Ryan Babbush. "Simulation quantique de la structure électronique avec profondeur linéaire et connectivité". Phys. Rév. Lett. 120, 110501 (2018).

https: / / doi.org/ 10.1103 / PhysRevLett.120.110501

Martín Larocca, Frédéric Sauvage, Faris M. Sbahi, Guillaume Verdon, Patrick J. Coles et M. Cerezo. « Apprentissage automatique quantique invariant par groupe ». PRX Quantique 3, 030341 (2022).

https: / / doi.org/ 10.1103 / PRXQuantum.3.030341

Johannes Jakob Meyer, Marian Mularski, Elies Gil-Fuster, Antonio Anna Mele, Francesco Arzani, Alissa Wilms et Jens Eisert. "Exploiter la symétrie dans l'apprentissage automatique quantique variationnel". PRX Quantique 4, 010328 (2023).

https: / / doi.org/ 10.1103 / PRXQuantum.4.010328

Martin Larocca, Nathan Ju, Diego García-Martín, Patrick J Coles et Marco Cerezo. « Théorie de la surparamétrisation dans les réseaux de neurones quantiques ». Nat. Calculer. Sci. 3, 542-551 (2023).

https://doi.org/10.1038/s43588-023-00467-6

Yuxuan Du, Min-Hsiu Hsieh, Tongliang Liu et Dacheng Tao. « Pouvoir expressif des circuits quantiques paramétrés ». Phys. Rév. Rés. 2, 033125 (2020).

https: / / doi.org/ 10.1103 / physrevresearch.2.033125

Zoë Holmes, Kunal Sharma, M. Cerezo et Patrick J. Coles. "Connecter l'expressibilité de l'ansatz aux magnitudes de gradient et aux plateaux stériles". PRX Quantique 3, 010313 (2022).

https: / / doi.org/ 10.1103 / PRXQuantum.3.010313

Samson Wang, Enrico Fontana, Marco Cerezo, Kunal Sharma, Akira Sone, Lukasz Cincio et Patrick J Coles. «Plateaux stériles induits par le bruit dans les algorithmes quantiques variationnels». Nat. Commun. 12, 6961 (2021).

https://doi.org/10.1038/s41467-021-27045-6

Abdulkadir Canatar, Evan Peters, Cengiz Pehlevan, Stefan M. Wild et Ruslan Shaydulin. "La bande passante permet la généralisation dans les modèles de noyau quantique". Transactions sur la recherche sur l’apprentissage automatique (2023). URL : https:///openreview.net/forum?id=A1N2qp4yAq.

https:///openreview.net/forum?id=A1N2qp4yAq

Hsin-Yuan Huang, Michael Broughton, Jordan Cotler, Sitan Chen, Jerry Li, Masoud Mohseni, Hartmut Neven, Ryan Babbush, Richard Kueng, John Preskill et Jarrod R. McClean. "Avantage quantique dans l'apprentissage par l'expérience". Sciences 376, 1182-1186 (2022).

https:///doi.org/10.1126/science.abn7293

Sitan Chen, Jordan Cotler, Hsin-Yuan Huang et Jerry Li. « Séparations exponentielles entre l'apprentissage avec et sans mémoire quantique ». En 2021, le 62e symposium annuel de l'IEEE sur les fondements de l'informatique (FOCS). Pages 574-585. (2022).

https:///doi.org/10.1109/FOCS52979.2021.00063

Hsin-Yuan Huang, Richard Kueng et John Preskill. "Limites théoriques de l'information sur l'avantage quantique dans l'apprentissage automatique". Phys. Rév. Lett. 126, 190505 (2021).

https: / / doi.org/ 10.1103 / PhysRevLett.126.190505

Ville Bergholm, Josh Izaac, Maria Schuld, Christian Gogolin, M. Sohaib Alam, Shahnawaz Ahmed, Juan Miguel Arrazola, Carsten Blank, Alain Delgado, Soran Jahangiri, Keri McKiernan, Johannes Jakob Meyer, Zeyue Niu, Antal Száva et Nathan Killoran. « Pennylane : Différenciation automatique des calculs hybrides quantiques-classiques » (2018). arXiv : 1811.04968.

arXiv: 1811.04968

Peter L. Bartlett, Philip M. Long, Gábor Lugosi et Alexander Tsigler. « Surapprentissage bénin en régression linéaire ». Proc. Natl. Acad. Sci. 117, 30063-30070 (2020).

https: / / doi.org/ 10.1073 / pnas.1907378117

Vladimir Koltchinski et Karim Lounici. "Inégalités de concentration et limites de moment pour les opérateurs de covariance d'échantillon". Bernoulli 23, 110-133 (2017).

https:///doi.org/10.3150/15-BEJ730

Zbigniew Puchała et Jarosław Adam Miszczak. « Intégration symbolique par rapport à la mesure haar sur le groupe unitaire ». Taureau. Pol. Acad. Sci. 65, 21-27 (2017).

https: / / doi.org/ 10.1515 / bpasts-2017-0003

Daniel A. Roberts et Beni Yoshida. « Chaos et complexité dès la conception ». J. Physique des hautes énergies. 2017, 121 (2017).

https:///doi.org/10.1007/jhep04(2017)121

Wallace C. Babcock. "Interférence d'intermodulation dans la fréquence d'apparition des systèmes radio et contrôle par sélection de canal". Système Bell. technologie. j. 32, 63-73 (1953).

https: / / doi.org/ 10.1002 / j.1538-7305.1953.tb01422.x

M. Atkinson, N. Santoro et J. Urrutia. "Ensembles d'entiers avec sommes et différences distinctes et attributions de fréquence porteuse pour les répéteurs non linéaires". IEEETrans. Commun. 34, 614-617 (1986).

https:///doi.org/10.1109/TCOM.1986.1096587

J. Robinson et A. Bernstein. "Une classe de codes binaires récurrents avec une propagation d'erreur limitée". IEEETrans. Inf. 13, 106-113 (1967).

https: / / doi.org/ 10.1109 / TIT.1967.1053951

R. J. F. Fang et W. A. Sandrin. "Assignation de fréquence porteuse pour répéteurs non linéaires". Revue technique COMSAT 7, 227-245 (1977).

Cité par

[1] Alexey Melnikov, Mohammad Kordzanganeh, Alexander Alodjants et Ray-Kuang Lee, « Apprentissage automatique quantique : de la physique au génie logiciel », Avancées en physique X 8 1, 2165452 (2023).

[2] Mo Kordzanganeh, Pavel Sekatski, Leonid Fedichkin et Alexey Melnikov, « Une famille de circuits quantiques universels à croissance exponentielle », Apprentissage automatique : science et technologie 4 3, 035036 (2023).

[3] Stefano Mangini, « Algorithmes quantiques variationnels pour l'apprentissage automatique : théorie et applications », arXiv: 2306.09984, (2023).

[4] Ben Jaderberg, Antonio A. Gentile, Youssef Achari Berrada, Elvira Shishenina et Vincent E. Elfving, « Laissez les réseaux de neurones quantiques choisir leurs propres fréquences », arXiv: 2309.03279, (2023).

[5] Yuxuan Du, Yibo Yang, Dacheng Tao et Min-Hsiu Hsieh, « Puissance dépendante du problème des réseaux de neurones quantiques sur la classification multiclasse », Lettres d'examen physique 131 14, 140601 (2023).

[6] S. Shin, Y. S. Teo et H. Jeong, « Codage exponentiel de données pour l'apprentissage supervisé quantique », Examen physique A 107 1, 012422 (2023).

[7] Elies Gil-Fuster, Jens Eisert et Carlos Bravo-Prieto, « Comprendre l'apprentissage automatique quantique nécessite également de repenser la généralisation », arXiv: 2306.13461, (2023).

[8] Jason Iaconis et Sonika Johri, « Chargement efficace des images quantiques basé sur un réseau Tensor », arXiv: 2310.05897, (2023).

[9] Alice Barthe et Adrián Pérez-Salinas, « Gradients et profils fréquentiels des modèles de re-upload quantique », arXiv: 2311.10822, (2023).

[10] Tobias Haug et M. S. Kim, « Généralisation avec la géométrie quantique pour l'apprentissage des unitaires », arXiv: 2303.13462, (2023).

[11] Jonas Landman, Slimane Thabet, Constantin Dalyac, Hela Mhiri et Elham Kashefi, « Apprentissage automatique quantique variationnel à approximation classique avec caractéristiques de Fourier aléatoires », arXiv: 2210.13200, (2022).

[12] Berta Casas et Alba Cervera-Lierta, « Séries de Fourier multidimensionnelles avec circuits quantiques », Examen physique A 107 6, 062612 (2023).

[13] Elies Gil-Fuster, Jens Eisert et Vedran Dunjko, « Sur l'expressivité de l'intégration des noyaux quantiques », arXiv: 2309.14419, (2023).

[14] Lucas Slattery, Ruslan Shaydulin, Shouvanik Chakrabarti, Marco Pistoia, Sami Khairy et Stefan M. Wild, « Preuves numériques contre l'avantage avec les noyaux de fidélité quantique sur les données classiques », Examen physique A 107 6, 062417 (2023).

[15] Mo Kordzanganeh, Daria Kosichkina et Alexey Melnikov, « Réseaux hybrides parallèles : une interaction entre les réseaux de neurones quantiques et classiques », arXiv: 2303.03227, (2023).

[16] Aikaterini, Gratsea et Patrick Huembeli, « L'effet des opérateurs de traitement et de mesure sur le pouvoir expressif des modèles quantiques », arXiv: 2211.03101, (2022).

[17] Shun Okumura et Masayuki Ohzeki, « Coefficient de Fourier des circuits quantiques paramétrés et problème du plateau stérile », arXiv: 2309.06740, (2023).

[18] Massimiliano Incudini, Michele Grossi, Antonio Mandarino, Sofia Vallecorsa, Alessandra Di Pierro et David Windridge, « Le noyau de chemin quantique : un noyau tangentiel neuronal quantique généralisé pour l'apprentissage automatique quantique profond », arXiv: 2212.11826, (2022).

[19] Jorja J. Kirk, Matthew D. Jackson, Daniel J. M. King, Philip Intallura et Mekena Metcalf, « Ordre émergent dans les représentations de données classiques sur les modèles de spin d'Ising », arXiv: 2303.01461, (2023).

[20] Francesco Scala, Andrea Ceschini, Massimo Panella et Dario Gerace, « Une approche générale du décrochage dans les réseaux de neurones quantiques », arXiv: 2310.04120, (2023).

[21] Julian Berberich, Daniel Fink, Daniel Pranjić, Christian Tutschku et Christian Holm, « Formation de modèles quantiques robustes et généralisables », arXiv: 2311.11871, (2023).

Les citations ci-dessus proviennent de SAO / NASA ADS (dernière mise à jour réussie 2023-12-21 00:40:54). La liste peut être incomplète car tous les éditeurs ne fournissent pas de données de citation appropriées et complètes.

On Le service cité par Crossref aucune donnée sur la citation des œuvres n'a été trouvée (dernière tentative 2023-12-21 00:40:53).

Cet article est publié dans Quantum sous le Creative Commons Attribution 4.0 International (CC BY 4.0) Licence. Le droit d'auteur reste la propriété des détenteurs d'origine tels que les auteurs ou leurs institutions.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://quantum-journal.org/papers/q-2023-12-20-1210/

- :possède

- :est

- :ne pas

- 1

- 10

- 107

- 11

- 110

- 116

- 12

- 120

- 121

- 125

- 13

- 14

- 15%

- 16

- 17

- 1791

- 19

- 20

- 2008

- 2015

- 2017

- 2018

- 2019

- 2020

- 2021

- 2022

- 2023

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 35%

- 36

- 39

- 40

- 41

- 43

- 46

- 49

- 50

- 51

- 52

- 53

- 54

- 58

- 60

- 65

- 66

- 7

- 75

- 8

- 9

- 98

- a

- Abbas

- capacité

- au dessus de

- RÉSUMÉ

- accès

- Selon

- précision

- Adam

- avances

- Avantage

- contradictoire

- affiliations

- à opposer à

- ahmed

- alex

- Alexandre

- algorithmes

- alice

- Tous

- aussi

- an

- selon une analyse de l’Université de Princeton

- Analytique

- ainsi que

- Andrew

- anna

- annuel

- applications

- une approche

- SONT

- domaines

- AS

- tentative

- auteur

- auteurs

- Automatique

- b

- stérile

- basé

- Essentiel

- BE

- était

- humain

- derrière

- Bell

- bien

- Benjamin

- Améliorée

- jusqu'à XNUMX fois

- Au-delà

- vide

- bornes

- Pause

- Bryan

- taureau

- by

- aptitude

- Compétences

- carlos

- casper

- chan

- Développement

- chen

- Selectionnez

- bouffe

- chrétien

- citant

- classe

- classification

- codes

- commentaire

- Chambre des communes

- complet

- complexe

- complexité

- calculs

- ordinateur

- Informatique

- informatique

- béton

- Congrès

- Connectivité

- contexte

- des bactéries

- droit d'auteur

- corrélée

- Craig

- courbe

- Daniel

- données

- data mining

- Dave

- David

- déc

- profond

- l'apprentissage en profondeur

- réseaux de neurones profonds

- Nous célebrons le

- dépendant

- profondeur

- dériver

- Conception

- Malgré

- détermination

- Diego

- différences

- discuter

- distinct

- do

- double

- e

- Edward

- effet

- efficace

- Electronique

- éléments

- enrobage

- permet

- codage

- énergie

- ENGINEERING

- Erika

- erreur

- Ether (ETH)

- preuve

- exemple

- expositions

- expériences

- Expliquer

- exponentiel

- expressif

- famille

- adieu

- peur

- Fonctionnalité

- Fonctionnalités:

- few

- fidélité

- Pour

- trouvé

- Fondations

- Francisco

- La fréquence

- De

- avant

- fonction

- Général

- génératif

- réseaux accusatoires génératifs

- géométrie

- objectif

- les gradients

- Réservation de groupe

- Matériel

- harvard

- Haute

- titulaires

- Comment

- HTML

- http

- HTTPS

- huang

- Hybride

- hybride quantique-classique

- i

- IEEE

- satellite

- améliorer

- in

- inégalités

- d'information

- Institut

- les établissements privés

- l'intégration

- intéressant

- ingérence

- International

- Introduction

- Jackson

- JavaScript

- jerome

- John

- Johnson

- Jordanie

- Journal

- Jean

- karim

- Kendall

- kim

- King

- église

- grande échelle

- Luxinar SR AOM

- Nom de famille

- APPRENTISSAGE

- apprentissage

- au

- Laisser

- Lee

- laisser

- li

- Licence

- limité

- lin

- lien

- Liste

- chargement

- localement

- Logan

- Location

- perte

- baisser

- Ltd

- click

- machine learning

- Les machines

- Marco

- maria

- Martin

- math

- mathématique

- Matière

- matthew

- matthias

- Mai..

- McClean

- mesurer

- mesures

- mécanismes

- Mémoire

- metcalf

- méthodes

- Meyer

- Michael

- pourrait

- mikhail

- minimisation

- Mines

- modèle

- numériques jumeaux (digital twin models)

- Villas Modernes

- moment

- Mois

- plusieurs

- Nature

- Près

- réseau et

- réseaux

- Neural

- Réseau neuronal

- les réseaux de neurones

- aucune

- événement

- of

- souvent

- oliver

- on

- Ontario

- ouvert

- Opérations

- opérateurs

- or

- de commander

- original

- nos

- vue d'ensemble

- propre

- pages

- Papier

- Parallèle

- chemin

- patrick

- Peter

- phénomène

- Physique

- Platon

- Intelligence des données Platon

- PlatonDonnées

- des notes bonus

- power

- pratique

- précis

- prédiction

- préparation

- Press

- Problème

- PROC

- Procédures

- traitement

- processeurs

- Profils

- propagation

- fournir

- publié

- éditeur

- éditeurs

- Quantum

- avantage quantique

- algorithmes quantiques

- Ordinateur quantique

- l'informatique quantique

- informations quantiques

- apprentissage automatique quantique

- R

- Radio

- aléatoire

- récurrent

- régimes

- régression

- rapport

- relation amoureuse

- reste

- remarquables

- a besoin

- un article

- respect

- limité

- Révélé

- Avis

- Richard

- Analyse

- ROBERT

- robuste

- Ryan

- s

- Scala

- SCI

- Sciences

- Science et technologie

- choisi

- sélection

- Série

- Sets

- peu profond

- Sharma

- montrer

- signaux

- OUI

- De même

- simulation

- simultanément

- Logiciels

- génie logiciel

- chanson

- espaces

- Spin

- carrés

- point de vue

- Région

- statistique

- stefan

- fortement

- structure

- étudié

- succès

- Avec succès

- tel

- convient

- des sommes

- enseignement supervisé

- surprise

- Symposium

- Système

- technologie

- Technique

- Technologie

- terme

- La

- leur

- théorique

- théorie

- ainsi

- Ces

- this

- Avec

- Titre

- à

- toronto

- Formation

- trans

- Transactions

- Trevor

- tyler

- UN

- sous

- compréhension

- Universel

- université

- a actualisé

- URL

- variété

- très

- vincent

- le volume

- vs

- W

- wang

- souhaitez

- était

- we

- WELL

- tout en

- répandu

- Sauvage

- comprenant

- sans

- activités principales

- vos contrats

- Wright

- X

- an

- zéphyrnet