Connaissez-vous les coûts d’une mauvaise qualité des données ? Ci-dessous, j'explore l'importance de l'observabilité des données, comment elle peut atténuer les risques de mauvaises données et les moyens de mesurer son retour sur investissement. En comprenant l’impact des mauvaises données et en mettant en œuvre des stratégies efficaces, les organisations peuvent maximiser les avantages de leurs initiatives en matière de qualité des données.

Les données font désormais partie intégrante de la prise de décision moderne et, par conséquent, la qualité des données est primordiale pour garantir que les parties prenantes de l'entreprise tirent des conclusions précises.

Mais voici le problème que tout responsable moderne des données vous dira : la gestion de la qualité des données est difficile. Cela demande du temps et des efforts. De plus, le ROI (retour sur investissement) est souvent difficile à mesurer.

À quel point les mauvaises données sont-elles mauvaises ?

De mauvaises données peuvent entraîner des pertes financières importantes. Gartner estime que chaque année, une mauvaise qualité des données coûte en moyenne aux organisations 12.9 millions de dollars. En 2022, Logiciel Unity a déclaré une perte de 110 millions de dollars de revenus et de 4.2 milliards de dollars de capitalisation boursière. "Conséquences de l'ingestion de mauvaises données provenant d'un gros client", a déclaré la société. De même, de mauvaises données ont causé Equifax, une agence d'évaluation du crédit cotée en bourse, pour envoyer aux prêteurs des cotes de crédit inexactes sur des millions de clients. Plus récemment, un incident lié aux données a provoqué d’énormes perturbations dans le trafic aérien du Royaume-Uni et de l’Irlande. Il est rapporté que plus de 2,000 126.5 vols ont été annulés, ce qui a laissé des centaines de milliers de voyageurs bloqués. La perte financière accumulée pour les compagnies aériennes est estimée à XNUMX millions de dollars.

Les implications des mauvaises données

Les données sont au cœur de toute entreprise moderne. La principale responsabilité de l’équipe données est de créer et de maintenir des produits de données qui sont servis aux clients en interne et en externe, tout en permettant à l’organisation d’évoluer et d’atteindre ses objectifs.

Lorsqu’il s’agit de garantir que les initiatives de données de l’organisation sont prêtes à réussir, certaines attentes de base d’une équipe de données peuvent être résumées comme suit :

- Uptime: Les données sont un service, et il est donc essentiel de garantir leur disponibilité en cas de besoin.

- Sécurité : Conformité aux réglementations (telles que GDPR ou HIPAA). L'équipe est responsable de la mise en œuvre de mesures et de pratiques pour protéger les informations sensibles et maintenir la confidentialité des données.

- Fiabilité: Tant des données que de la plateforme de données. Une partie de cela concerne la disponibilité, mais aussi la qualité et la précision des données au sens traditionnel du terme.

- Échelle: La plate-forme de données doit permettre une évolutivité permettant de s'adapter aux volumes de données croissants, au nombre de cas d'utilisation et aux besoins de l'entreprise.

- Innovation: Les données doivent stimuler l'innovation, et c'est un domaine dans lequel il est important que l'équipe chargée des données montre l'exemple en apportant l'innovation au sein et en dehors des pratiques de données.

Atteindre la qualité des données grâce à l’observabilité des données

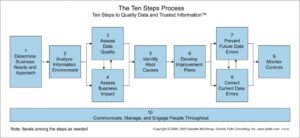

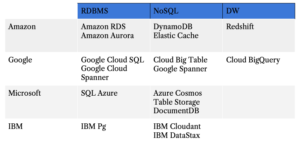

L'observabilité des données est une solution permettant de surveiller et de maintenir de manière proactive la santé des données tout au long de leur cycle de vie. En mettant en œuvre des techniques de journalisation, de traçage et de surveillance, les organisations gagnent en visibilité sur les flux de données, identifient et résolvent rapidement les problèmes de qualité des données et évitent les perturbations des tableaux de bord d'analyse. Littératie des données, impliquant la recherche, l’interprétation et la communication de données, est essentiel pour que les décideurs puissent traduire efficacement les données en valeur commerciale. Cultiver une culture axée sur les données et investir dans les bons outils sont des étapes cruciales pour atteindre la qualité des données grâce à leur observabilité.

Quantifier le retour sur investissement de l'observabilité des données

Mesurer le retour sur investissement de l'observabilité des données aide les dirigeants d'entreprise à comprendre la valeur et les avantages associés à l'investissement dans cette pratique. Plusieurs mesures quantifiables peuvent servir de point de départ pour évaluer le coût des mauvaises données, notamment le taux d'occurrence ou le nombre d'incidents par an, le délai de détection et le délai de résolution.

L'impact de la problèmes de qualité des données peut varier en fonction de la taille et de la complexité des opérations commerciales. Afin d'évaluer les dommages et de constituer un argumentaire solide en faveur d'une solution d'observabilité des données, nous proposons cinq mesures clés que les praticiens des données peuvent facilement mettre en œuvre et surveiller et qui peuvent être utilisées pour soutenir un dossier en interne :

- Nombre et fréquence des incidents : Alors que certaines entreprises peuvent être confrontées quotidiennement à des incidents liés aux données, d’autres peuvent passer des jours, voire des semaines, sans incident. La criticité des incidents peut varier de quelque chose de « mineur », comme des données obsolètes liées à un tableau de bord que personne n'a utilisé depuis des lustres, à un problème de duplication de données provoquant une surcharge et finalement une panne du serveur (histoire vraie, Netflix 2016). Nous constatons que cela est souvent lié à : la taille et la complexité de la plateforme de données, le secteur d'activité de l'entreprise (certains secteurs sont intrinsèquement plus matures en matière de données que d'autres), le type d'architecture de données (centralisée, décentralisée, hybride), etc. Documenter les incidents donnera Une meilleure idée de ce qu'il faut rechercher la prochaine fois qu'il y en a un, des incidents répétés sont souvent un bon indicateur que quelque chose en dessous nécessite une attention plus particulière.

- Classement des incidents : Tous les incidents liés aux données ne sont pas de la même gravité ; certaines peuvent être mineures et faciles à atténuer, tandis que d’autres peuvent avoir des conséquences graves. Il est important de documenter la criticité des incidents pour garantir une escalade et une priorisation appropriées. C’est là que le traçage des données peut s’avérer déterminant, car il permet d’évaluer l’impact en aval de l’incident pour mieux comprendre sa criticité. Un incident lié au tableau de bord préféré du PDG, à une base de données de production ou à un produit de données important est susceptible d’être d’une grande criticité.

- Temps moyen de détection (MTTD) : Lorsqu’il s’agit d’instaurer la confiance dans les données et dans l’équipe chargée des données, le cauchemar de tout praticien des données se produit lorsque les parties prenantes de l’entreprise sont les premières à détecter les problèmes de qualité des données. Cela peut vraiment nuire à la crédibilité de l’équipe et à la capacité de l’entreprise à véritablement s’orienter vers les données. Lorsque vous commencez à documenter les incidents et à classer leur criticité, il est important de suivre également la manière dont ils ont été détectés et le temps qu'il a fallu à l'équipe chargée des données pour les reconnaître. Cette métrique peut être un bon indicateur de la robustesse de votre gestion des incidents, mais également la réduire signifie que vous réduisez le risque que l'incident puisse causer davantage de dégâts.

- Temps moyen de résolution (MTTR) : Que se passe-t-il une fois qu’un incident est signalé ? Le MTTR est le temps moyen passé entre la prise de conscience d'un incident de données et sa résolution. Le temps de résolution est fortement influencé par la criticité de l'incident et la complexité de la plateforme de données, c'est pourquoi nous considérons la moyenne pour les besoins de ce cadre.

- Temps moyen de production (MTTP) est le temps moyen nécessaire pour expédier de nouveaux produits de données ou, en d’autres termes, le délai moyen de commercialisation des produits de données. Cela pourrait être le temps passé par un analyste à « nettoyer » les données pour un modèle de science des données. En fait, selon Forbes, la préparation des données représente environ 80 % du travail des data scientists. Dans un monde où nous souhaitons traiter les données comme un produit, l’amélioration de la qualité des données peut avoir un impact direct sur la réduction des délais de mise sur le marché.

En plus des mesures quantifiables ci-dessus, d’autres, moins facilement quantifiables mais tout aussi importantes, méritent d’être prises en compte lorsque l’on examine le coût des mauvaises données.

- Érosion de la confiance : Dans les données ainsi q'une l’équipe de données. C’est, à mon avis, la conséquence la plus dangereuse des mauvaises données, qui peuvent entraîner des problèmes plus importants comme le roulement de l’équipe chargée des données ou la perte de confiance dans la capacité de l’entreprise à s’orienter vers les données et à suivre l’évolution du paysage numérique. Et une fois la confiance brisée, il est très difficile de la regagner. Dans une expérience précédente, j'ai travaillé avec des consommateurs de données qui préféraient ne pas utiliser de données et préféraient s'appuyer sur « l'expérience » et « l'instinct » dans un environnement de négociation d'actions très volatil plutôt que de les utiliser en sachant qu'elles avaient de fortes chances d'être inexactes. .

- Perte de productivité : Avec de mauvaises données, les équipes sont obligées de lutter et de corriger les erreurs dès qu’elles surviennent. Cette lutte constante contre les incendies est non seulement épuisante mais aussi contre-productive. Le temps précieux qui pourrait être consacré à la planification stratégique et aux initiatives de croissance est gaspillé en dépannage, détournant ainsi les ressources de tâches plus critiques.

- Risque réglementaire et de réputation : Des erreurs dans les rapports financiers ou une mauvaise gestion des données personnelles peuvent entraîner des amendes coûteuses et des batailles juridiques. Faire face aux problèmes de conformité représente une perte importante de productivité, sans parler du fardeau financier qu'ils imposent.

- Mauvaises performances commerciales : En plus de la perte de productivité au sein de l'équipe chargée des données, les mauvaises données peuvent nuire aux performances globales de l'entreprise, car l'entreprise a du mal à se préparer au numérique et à gagner en crédibilité auprès de ses clients, et devient vulnérable aux menaces externes.

Les problèmes de qualité des données peuvent entraîner divers problèmes, notamment une perte de confiance dans les données, une baisse de la productivité et du moral des équipes, le non-respect des réglementations et une diminution de la qualité de la prise de décision. Le cloisonnement des données au sein des départements ou des unités commerciales rend difficile l’obtention d’une vue globale du paysage des données de l’organisation. Cela peut conduire à une prise de décision inefficace, entraver la culture des données et compromettre la conformité aux réglementations telles que le RGPD et la HIPAA. De plus, les équipes chargées des données peuvent devenir frustrées de passer trop de temps à résoudre les problèmes liés aux données, ce qui a un impact négatif sur leur satisfaction au travail et peut conduire à un départ des employés.

La règle 1x10x100

La règle 1x10x100, un principe largement reconnu en matière de gestion des incidents, met l'accent sur les coûts croissants associés à une mauvaise qualité des données. Selon cette règle, le coût de résolution d’un problème de qualité des données au point d’entrée est d’environ 1 fois le coût initial. Si le problème n’est pas détecté et se propage au sein du système, le coût augmente jusqu’à environ 10 fois, ce qui implique des efforts de correction et de remédiation. Cependant, si la mauvaise qualité des données atteint l'utilisateur final ou l'étape de prise de décision, le coût peut monter en flèche jusqu'à 100 fois la dépense initiale en raison de conséquences commerciales importantes, notamment des perturbations opérationnelles, des opportunités perdues et l'insatisfaction des clients. Cette règle souligne l'impact exponentiel d'une mauvaise qualité des données, ce qui rend crucial pour les organisations d'investir dans l'observabilité des données, ce qui permet de maintenir les problèmes, s'ils surviennent, plus près de la cause profonde plutôt qu'en aval.

Conclusion

Les problèmes de qualité des données ont un impact significatif sur les entreprises, entraînant un gaspillage de ressources et des opportunités manquées. Investir dans l’observabilité des données est essentiel pour prévenir et atténuer les risques associés aux mauvaises données. En tirant parti des mesures quantifiables et en prenant en compte les facteurs non quantifiables, les organisations peuvent mesurer le retour sur investissement de l'observabilité des données et démontrer sa valeur aux décideurs. Garantir la confiance des données, promouvoir une prise de décision efficace dans le domaine, se conformer aux réglementations et favoriser une équipe de données satisfaite sont tous des aspects essentiels pour maximiser les avantages des initiatives de qualité des données. Adopter l’observabilité des données est un investissement stratégique qui garantit l’exactitude, la fiabilité et l’utilisation des données dans le monde actuel axé sur les données.

Les organisations qui développent une pratique d’observabilité riche ont plus de visibilité sur leurs environnements imbriqués, ce qui se traduit par moins de pannes, une résolution plus rapide des problèmes, une plus grande confiance dans la fiabilité de leurs applications – et, en fin de compte, plus de revenus et des clients plus satisfaits.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://www.dataversity.net/putting-a-number-on-bad-data/

- :possède

- :est

- :ne pas

- :où

- $UP

- 000

- 1

- 100x

- 2016

- 2022

- 9

- a

- capacité

- Qui sommes-nous

- au dessus de

- accommoder

- Selon

- hybrides

- Accumulé

- précision

- Avec cette connaissance vient le pouvoir de prendre

- la réalisation de

- reconnaître

- Ad

- ajout

- adresser

- agence

- Âge

- Transport Aérien

- Compagnies Aériennes

- Tous

- permettre

- Permettre

- permet

- aussi

- an

- analyste

- analytique

- ainsi q'une

- d'environ

- architecture

- SONT

- Réservé

- survenir

- autour

- AS

- aspects

- Evaluer

- Évaluation de risque climatique

- associé

- At

- précaution

- disponibles

- moyen

- conscients

- Mal

- mauvaises données

- Baseline

- base

- batailles

- BE

- devenez

- devient

- devenir

- va

- ci-dessous

- avantages.

- Améliorée

- jusqu'à XNUMX fois

- plus gros

- Milliards

- tous les deux

- Apporter

- Cassé

- construire

- Développement

- fardeau

- la performance des entreprises

- Des chefs d'entreprise

- opérations commerciales

- performance de l'entreprise

- entreprises

- mais

- by

- CAN

- annulé

- casquette

- maisons

- cas

- Attraper

- Causes

- causé

- causer

- centralisée

- difficile

- Chance

- classification

- Classer

- plus

- CO

- vient

- communicant

- Sociétés

- Société

- De l'entreprise

- complexité

- conformité

- confiance

- conséquence

- Conséquences

- considérant

- constant

- Les consommateurs

- correct

- Prix

- cher

- Costs

- pourriez

- contreproductif

- couvert

- Crédibilité

- crédit

- critique

- criticité

- crucial

- Culture

- des clients

- Clients

- Tous les jours

- des dommages

- dangereux

- tableau de bord

- tableaux de bord

- données

- Plateforme de données

- Préparation des données

- confidentialité des données

- qualité des données

- science des données

- data-driven

- Base de données

- DATAVERSITÉ

- jours

- traitement

- Décentralisé

- La prise de décision

- décideurs

- démontrer

- départements

- Selon

- détecter

- détecté

- Détection

- difficile

- numérique

- Perturbation

- perturbations

- document

- documenter

- domaine

- down

- vidanger

- motivation

- deux

- même

- Efficace

- de manière efficace

- effort

- efforts

- embrassement

- souligne

- Employés

- assurer

- assurer

- entrée

- Environment

- environnements

- Equifax

- Erreurs

- escalade

- essential

- estimé

- estimations

- etc

- Ether (ETH)

- évaluer

- événement

- Chaque

- évolution

- exemple

- excessif

- attentes

- d'experience

- explorez

- exponentiel

- externe

- extérieurement

- fait

- facteurs

- plus rapide

- Favori

- moins

- la traduction de documents financiers

- Trouvez

- extrémités

- Prénom

- cinq

- Vols

- suit

- Pour

- Forbes

- forcé

- favoriser

- Framework

- La fréquence

- de

- avant

- frustré

- En outre

- Gain

- Gartner

- RGPD

- Donner

- Go

- Goes

- Bien

- plus grand

- considérablement

- Croissance

- Croissance

- ait eu

- arrive

- heureux

- Dur

- Vous avez

- Santé

- Cœur

- aide

- Haute

- empêcher

- holistique

- Comment

- Cependant

- HTML

- HTTPS

- majeur

- Des centaines

- Blesser

- Hybride

- i

- idée

- identifier

- if

- Impact

- impactant

- Mettre en oeuvre

- la mise en oeuvre

- la mise en œuvre

- implications

- important

- imposer

- l'amélioration de

- in

- Dans d'autres

- inexacte

- incident

- incidents

- Y compris

- Augmente

- Indicateur

- secteurs

- industrie

- influencé

- d'information

- intrinsèquement

- initiale

- les initiatives

- Innovation

- instrumental

- intégrale

- intérieurement

- développement

- Investir

- sueñortiendo

- un investissement

- impliquant

- Irlande

- aide

- vous aider à faire face aux problèmes qui vous perturbent

- IT

- SES

- Compromettre

- Emploi

- juste

- XNUMX éléments à

- ACTIVITES

- Savoir

- connaissance

- paysage d'été

- gros

- conduire

- leader

- dirigeants

- conduisant

- à gauche

- Légal

- prêteurs

- moins

- en tirant parti

- vos produits

- comme

- Probable

- lié

- enregistrement

- Style

- recherchez-

- pas à perdre

- perte

- pertes

- perdu

- LP

- maintenir

- FAIT DU

- Fabrication

- gestion

- Marché

- Capitalisation boursière

- VEILLE DU MARCHÉ

- mature

- Maximisez

- maximisant

- Mai..

- veux dire

- mesurer

- les mesures

- Découvrez

- mentionner

- métrique

- Métrique

- million

- mineur

- mauvaise manipulation

- manqué

- Réduire les

- modèle

- Villas Modernes

- Surveiller

- Stack monitoring

- PLUS

- Par ailleurs

- (en fait, presque toutes)

- my

- nécessaire

- Besoins

- négativement

- Netflix

- Nouveauté

- next

- nombre

- objectifs

- se produire

- événement

- of

- souvent

- on

- une fois

- ONE

- uniquement

- opérationnel

- Opérations

- Opinion

- Opportunités

- or

- de commander

- organisation

- organisations

- original

- Autre

- Autres

- Les pannes

- au contrôle

- plus de

- global

- PARAMOUNT

- partie

- /

- performant

- personnel

- données à caractère personnel

- et la planification de votre patrimoine

- plateforme

- Platon

- Intelligence des données Platon

- PlatonDonnées

- Point

- en équilibre

- pauvres

- l'éventualité

- pratique

- pratiques

- préparation

- empêcher

- précédent

- principe

- contextualisée

- la confidentialité

- Problème

- d'ouvrabilité

- Produit

- Vidéo

- productivité

- Produits

- la promotion de

- correct

- proposer

- protéger

- publiquement

- but

- qualité

- quantifiable

- vite.

- Tarif

- plutôt

- atteint

- Préparation

- vraiment

- récemment

- reconnu

- réduire

- Prix Réduit

- réduire

- reconquérir

- règlements

- fiabilité

- compter

- répété

- Signalé

- Rapports

- Résolution

- résoudre

- Resources

- responsabilité

- responsables

- résultat

- retourner

- de revenus

- Rich

- bon

- Analyse

- risques

- solidité

- ROI

- racine

- Règle

- garanties

- même

- client

- satisfait

- Évolutivité

- Escaliers intérieurs

- Sciences

- scientifiques

- scores

- envoyer

- sens

- sensible

- grave

- besoin

- servi

- serveur

- service

- plusieurs

- gravité

- navire

- devrait

- importance

- significative

- de façon significative

- en silo

- De même

- Taille

- flèche

- sur mesure

- quelques

- quelque chose

- Approvisionnement

- Dépenses

- dépensé

- Étape

- échelonnement

- parties prenantes

- Commencer

- Commencez

- A déclaré

- Étapes

- Stratégique

- INVESTISSEMENT STRATÉGIQUE

- les stratégies

- flux

- STRONG

- Luttes

- succès

- tel

- Support

- combustion propre

- prend

- tâches

- équipe

- équipes

- techniques

- dire

- que

- qui

- Les

- leur

- Les

- Là.

- donc

- l'ont

- this

- milliers

- des menaces

- Avec

- tout au long de

- fiable

- à

- aujourd'hui

- a

- les outils

- vers

- Traçant

- suivre

- échangés

- traditionnel

- circulation

- traduire

- voyageurs

- traiter

- vraiment

- La confiance

- chiffre d'affaires

- type

- Royaume-Uni

- En fin de compte

- dessous

- soulignés

- comprendre

- compréhension

- non détecté

- unités

- Stabilité

- utilisé

- d'utiliser

- Précieux

- Plus-value

- divers

- très

- Voir

- vu

- définition

- volatile

- volumes

- vs

- Vulnérable

- souhaitez

- gaspillé

- façons

- we

- Semaines

- ont été

- Quoi

- quand

- qui

- tout en

- WHO

- why

- largement

- sera

- comprenant

- dans les

- sans

- des mots

- Activités principales

- travaillé

- world

- vaut

- pourra

- WSJ

- an

- you

- Votre

- zéphyrnet