La croissance rapide de l’IA générative apporte de nouvelles innovations prometteuses et soulève en même temps de nouveaux défis. Ces défis incluent certains qui étaient courants avant l’IA générative, comme les biais et l’explicabilité, et de nouveaux uniques aux modèles de fondation (FM), y compris les hallucinations et la toxicité. Chez AWS, nous nous engageons à développer l’IA générative de manière responsable, adopter une approche centrée sur les personnes qui donne la priorité à l’éducation, à la science et à nos clients, pour intégrer une IA responsable tout au long du cycle de vie de l’IA de bout en bout.

Au cours de l'année écoulée, nous avons introduit de nouvelles fonctionnalités dans nos applications et modèles d'IA générative, telles que l'analyse de sécurité intégrée dans Chuchoteur de code Amazon, formation pour détecter et bloquer les contenus nuisibles dans Titan d'Amazonie, et la protection de la confidentialité des données dans Socle amazonien. Notre investissement dans une IA générative sûre, transparente et responsable comprend une collaboration avec la communauté mondiale et les décideurs politiques, alors que nous encourageons et soutenons à la fois le Engagements volontaires de la Maison Blanche en matière d’IA ainsi que Sommet sur la sécurité de l'IA au Royaume-Uni. Et nous continuons à travailler main dans la main avec nos clients pour opérationnaliser une IA responsable avec des outils spécialement conçus comme Amazon SageMaker Clarifier, Gouvernance du ML avec Amazon SageMakeret plus encore.

Présentation d’une nouvelle innovation en matière d’IA responsable

À mesure que l’IA générative s’adapte à de nouvelles industries, organisations et cas d’utilisation, cette croissance doit s’accompagner d’un investissement soutenu dans le développement responsable de la FM. Les clients souhaitent que leurs FM soient construits dans un souci de sûreté, d’équité et de sécurité, afin qu’ils puissent à leur tour déployer l’IA de manière responsable. Cette année, chez AWS re:Invent, nous sommes ravis d'annoncer de nouvelles fonctionnalités visant à favoriser l'innovation responsable en matière d'IA générative à travers un large éventail de fonctionnalités avec de nouveaux outils intégrés, des protections client, des ressources pour améliorer la transparence et des outils pour lutter contre la désinformation. Notre objectif est de fournir aux clients les informations dont ils ont besoin pour évaluer les FM par rapport aux principales considérations d'IA responsable, telles que la toxicité et la robustesse, et d'introduire des garde-fous pour appliquer des mesures de protection basées sur les cas d'utilisation des clients et les politiques d'IA responsable. Dans le même temps, nos clients souhaitent être mieux informés sur la sûreté, l’équité, la sécurité et d’autres propriétés des services d’IA et des FM, lorsqu’ils les utilisent au sein de leur propre organisation. Nous sommes ravis d'annoncer davantage de ressources pour aider les clients à mieux comprendre nos services AWS AI et à offrir la transparence qu'ils demandent.

Mise en œuvre de mesures de protection : garde-corps pour Amazon Bedrock

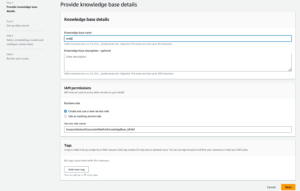

La sécurité est une priorité lorsqu’il s’agit d’introduire l’IA générative à grande échelle. Les organisations souhaitent promouvoir des interactions sécurisées entre leurs clients et les applications d'IA générative qui évitent les propos nuisibles ou offensants et s'alignent sur les politiques de l'entreprise. Le moyen le plus simple d’y parvenir est de mettre en place des mesures de protection cohérentes dans l’ensemble de l’organisation afin que chacun puisse innover en toute sécurité. Hier, nous avons annoncé l'aperçu de Garde-corps pour le substrat rocheux amazonien— une nouvelle fonctionnalité qui facilite la mise en œuvre de protections spécifiques aux applications basées sur des cas d'utilisation clients et des politiques d'IA responsables.

Les garde-fous assurent la cohérence dans la manière dont les FM sur Amazon Bedrock réagissent au contenu indésirable et nuisible dans les applications. Les clients peuvent appliquer des garde-fous aux grands modèles linguistiques sur Amazon Bedrock ainsi qu'aux modèles affinés et en combinaison avec Agents pour le substrat rocheux d’Amazonie. Guardrails vous permet de spécifier les sujets à éviter, et le service détecte et empêche automatiquement les requêtes et les réponses qui entrent dans des catégories restreintes. Les clients peuvent également configurer des seuils de filtrage de contenu dans différentes catégories, notamment les discours de haine, les insultes, le langage sexualisé et la violence, afin de filtrer les contenus préjudiciables au niveau souhaité. Par exemple, une application de banque en ligne peut être mise en place pour éviter de fournir des conseils en investissement et limiter les contenus inappropriés (tels que les discours de haine, les insultes et la violence). Dans un avenir proche, les clients pourront également supprimer les informations personnelles identifiables (PII) dans les entrées des utilisateurs et les réponses des FM, définir des filtres de grossièretés et fournir une liste de mots personnalisés à bloquer dans les interactions entre les utilisateurs et les FM, améliorant ainsi la conformité et davantage. protéger les utilisateurs. Avec Guardrails, vous pouvez innover plus rapidement grâce à l’IA générative tout en maintenant des protections et des sauvegardes cohérentes avec les politiques de l’entreprise.

Identifier le meilleur FM pour un cas d'utilisation spécifique : évaluation de modèle dans Amazon Bedrock

Aujourd’hui, les organisations disposent d’un large éventail d’options FM pour alimenter leurs applications d’IA générative. Pour trouver le bon équilibre entre précision et performances pour leur cas d’utilisation, les organisations doivent comparer efficacement les modèles et trouver la meilleure option en fonction des principales mesures d’IA responsable et de qualité qui sont importantes pour elles. Pour évaluer des modèles, les organisations doivent d'abord passer des jours à identifier des références, à mettre en place des outils d'évaluation et à exécuter des évaluations, ce qui nécessite une expertise approfondie en science des données. De plus, ces tests ne sont pas utiles pour évaluer des critères subjectifs (par exemple, la voix de la marque, la pertinence et le style) qui nécessitent du jugement au travers de flux de travail fastidieux et chronophages d'évaluation humaine. Le temps, l'expertise et les ressources nécessaires à ces évaluations (pour chaque nouveau cas d'utilisation) rendent difficile pour les organisations d'évaluer les modèles par rapport aux dimensions responsables de l'IA et de faire un choix éclairé sur le modèle qui offrira l'expérience la plus précise et la plus sûre à leurs clients.

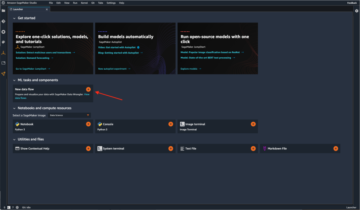

Désormais disponible en avant-première, Évaluation du modèle sur Amazon Bedrock aide les clients à évaluer, comparer et sélectionner les meilleurs FM pour leur cas d'utilisation spécifique sur la base de mesures personnalisées, telles que la précision et la sécurité, à l'aide d'évaluations automatiques ou humaines. Dans la console Amazon Bedrock, les clients choisissent les FM qu'ils souhaitent comparer pour une tâche donnée, comme la réponse à des questions ou la synthèse de contenu. Pour les évaluations automatiques, les clients sélectionnent des critères d'évaluation prédéfinis (par exemple, précision, robustesse et toxicité) et téléchargent leur propre ensemble de données de test ou sélectionnent parmi les ensembles de données intégrés et accessibles au public. Pour les critères subjectifs ou les contenus nuancés nécessitant du jugement, les clients peuvent facilement mettre en place des flux de travail d'évaluation humains en quelques clics seulement. Ces flux de travail exploitent l'équipe de travail interne d'un client ou utilisent une main-d'œuvre gérée fournie par AWS pour évaluer les réponses du modèle. Lors des évaluations humaines, les clients définissent des mesures spécifiques au cas d'utilisation (par exemple, pertinence, style et voix de la marque). Une fois que les clients ont terminé le processus de configuration, Amazon Bedrock exécute des évaluations et génère un rapport, afin que les clients puissent facilement comprendre les performances du modèle selon les critères clés de sécurité et de précision et sélectionner le meilleur modèle pour leur cas d'utilisation.

Cette capacité à évaluer les modèles ne se limite pas à Amazon Bedrock ; les clients peuvent également utiliser l'évaluation de modèles dans Amazon SageMaker Clarify pour évaluer, comparer et sélectionner facilement la meilleure option FM pour des indicateurs clés de qualité et de responsabilité tels que l'exactitude, la robustesse et la toxicité. tous les FM.

Combattre la désinformation : le filigrane dans Amazon Titan

Aujourd'hui, nous avons annoncé Générateur d'images Amazon Titan en avant-première, ce qui permet aux clients de produire et d'améliorer rapidement des images de haute qualité à grande échelle. Nous avons pris en compte l'IA responsable à chaque étape du processus de développement du modèle, y compris la sélection des données de formation, la création de capacités de filtrage pour détecter et supprimer les entrées utilisateur et les sorties de modèle inappropriées, et l'amélioration de la diversité démographique des sorties de notre modèle. Toutes les images générées par Amazon Titan contiennent par défaut un filigrane invisible, conçu pour aider à réduire la propagation de la désinformation en fournissant un mécanisme discret pour identifier les images générées par l'IA. AWS est l'un des premiers fournisseurs de modèles à diffuser largement des filigranes invisibles intégrés aux sorties d'images et conçus pour résister aux modifications.

Bâtir la confiance : soutenir nos modèles et applications avec indemnisation

Renforcer la confiance des clients est au cœur d'AWS. Nous sommes en voyage avec nos clients depuis notre création et, avec la croissance de l'IA générative, nous restons déterminés à construire ensemble une technologie innovante. Pour permettre aux clients d’exploiter la puissance de notre IA générative, ils doivent savoir qu’ils sont protégés. AWS offre une couverture d'indemnisation des droits d'auteur pour les sorties des services d'IA générative d'Amazon suivants : Amazon Titan Text Express, Amazon Titan Text Lite, Amazon Titan Embeddings, Amazon Titan Multimodal Embeddings, Amazon CodeWhisperer Professional, AWS HealthScribe, Amazon Lexet une Amazon Personnaliser. Cela signifie que les clients qui utilisent les services de manière responsable sont protégés contre les réclamations de tiers alléguant une violation du droit d'auteur par les résultats générés par ces services (voir la section 50.10 du Conditions de service). De plus, notre indemnisation IP standard pour l'utilisation des services protège les clients contre les réclamations de tiers alléguant une violation de la propriété intellectuelle par les services et les données utilisées pour les former. En d'autres termes, si vous utilisez un service d'IA générative d'Amazon répertorié ci-dessus et que quelqu'un vous poursuit pour violation de propriété intellectuelle, AWS défendra ce procès, ce qui comprend la couverture de tout jugement contre vous ou des frais de règlement.

Nous soutenons nos services d’IA générative et travaillons à les améliorer continuellement. Alors qu'AWS lance de nouveaux services et que l'IA générative continue d'évoluer, AWS continuera de se concentrer sans relâche sur l'obtention et le maintien de la confiance des clients.

Amélioration de la transparence : AWS AI Service Card pour Amazon Titan Text

We introduit les cartes de service AWS AI à re:Invent 2022 en tant que ressource de transparence pour aider les clients à mieux comprendre nos services AWS AI. Les cartes de service IA sont une forme de documentation sur l'IA responsable qui offre aux clients un endroit unique pour trouver des informations sur les cas d'utilisation et les limitations prévus, les choix de conception d'IA responsables et les meilleures pratiques de déploiement et d'optimisation des performances pour nos services d'IA. Ils font partie d'un processus de développement complet que nous entreprenons pour construire nos services de manière responsable qui aborde l'équité, l'explicabilité, la véracité et la robustesse, la gouvernance, la transparence, la confidentialité et la sécurité, la sûreté et la contrôlabilité.

Chez re:Invent cette année, nous annonçons un nouvelle carte de service AI pour Amazon Titan Text accroître la transparence des modèles de fondation. Nous lançons également quatre nouvelles cartes de service AI, notamment : Amazon Comprendre Détecter les informations personnelles, Amazon Transcribe Détection de la toxicité, Vivacité du visage d'Amazon Rekognitionet une AWS HealthScribe. Vous pouvez explorer chacune de ces cartes sur le Site Web AWS. À mesure que l’IA générative continue de croître et d’évoluer, la transparence sur la manière dont la technologie est développée, testée et utilisée sera un élément essentiel pour gagner la confiance des organisations et de leurs clients. Chez AWS, nous nous engageons à continuer de proposer des ressources de transparence telles que les cartes de service AI à la communauté au sens large, ainsi qu'à itérer et à recueillir des commentaires sur les meilleures façons d'aller de l'avant.

Investir dans l’IA responsable tout au long du cycle de vie de l’IA générative

Nous sommes enthousiasmés par les nouvelles innovations annoncées cette semaine lors de re:Invent, qui offrent à nos clients davantage d'outils, de ressources et de protections intégrées pour créer et utiliser l'IA générative en toute sécurité. De l’évaluation des modèles aux garde-fous en passant par le filigrane, les clients peuvent désormais intégrer l’IA générative à leur organisation plus rapidement, tout en atténuant les risques. De nouvelles protections pour les clients, comme la couverture d'indemnisation IP, et de nouvelles ressources pour améliorer la transparence, comme des cartes de service IA supplémentaires, sont également des exemples clés de notre engagement à instaurer la confiance entre les entreprises technologiques, les décideurs politiques, les groupes communautaires, les scientifiques, etc. Nous continuons à réaliser des investissements significatifs dans l’IA responsable tout au long du cycle de vie d’un modèle de base, afin d’aider nos clients à faire évoluer l’IA de manière sûre, sécurisée et responsable.

À propos des auteurs

Pierre Hallinan dirige des initiatives dans la science et la pratique de l'IA responsable chez AWS AI, aux côtés d'une équipe d'experts en IA responsable. Il possède une expertise approfondie en IA (PhD, Harvard) et en entrepreneuriat (Blindsight, vendu à Amazon). Ses activités bénévoles ont notamment été professeur consultant à la Stanford University School of Medicine et président de la Chambre de commerce américaine à Madagascar. Quand c'est possible, il part à la montagne avec ses enfants : ski, escalade, randonnée et rafting

Pierre Hallinan dirige des initiatives dans la science et la pratique de l'IA responsable chez AWS AI, aux côtés d'une équipe d'experts en IA responsable. Il possède une expertise approfondie en IA (PhD, Harvard) et en entrepreneuriat (Blindsight, vendu à Amazon). Ses activités bénévoles ont notamment été professeur consultant à la Stanford University School of Medicine et président de la Chambre de commerce américaine à Madagascar. Quand c'est possible, il part à la montagne avec ses enfants : ski, escalade, randonnée et rafting

Vasi Philomine est actuellement vice-président de l'IA générative chez AWS. Il dirige les efforts d'IA générative, notamment Amazon Bedrock, Amazon Titan et Amazon CodeWhisperer.

Vasi Philomine est actuellement vice-président de l'IA générative chez AWS. Il dirige les efforts d'IA générative, notamment Amazon Bedrock, Amazon Titan et Amazon CodeWhisperer.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://aws.amazon.com/blogs/machine-learning/announcing-new-tools-and-capabilities-to-enable-responsible-ai-innovation/

- :possède

- :est

- :ne pas

- $UP

- 10

- 100

- 125

- 2022

- 50

- a

- capacité

- Capable

- A Propos

- au dessus de

- accompagné

- précision

- Avec cette connaissance vient le pouvoir de prendre

- à travers

- d'activités

- ajout

- Supplémentaire

- adresses

- conseils

- à opposer à

- AI

- Services d'IA

- objectif

- aligner

- même

- Tous

- aux côtés de

- aussi

- Amazon

- Chuchoteur de code Amazon

- Amazon Sage Maker

- Amazon Web Services

- Américaine

- parmi

- an

- ainsi que

- Annoncer

- annoncé

- Annoncer

- Une autre

- tous

- Application

- applications

- Appliquer

- une approche

- SONT

- autour

- AS

- demandant

- évaluations

- At

- Automatique

- automatiquement

- disponibles

- éviter

- évité

- AWS

- AWS re: Invent

- Balance

- Services bancaires

- basé

- BE

- était

- before

- derrière

- repères

- LES MEILLEURS

- les meilleures pratiques

- Améliorée

- jusqu'à XNUMX fois

- biais

- Block

- tous les deux

- brand

- apporter

- Apportez le

- vaste

- plus large

- construire

- construire la confiance

- Développement

- construit

- intégré

- by

- CAN

- capacités

- aptitude

- carte

- Cartes

- maisons

- cas

- catégories

- globaux

- Chambre

- Enfants

- le choix

- choix

- Selectionnez

- prétentions

- Escalade

- collaboration

- lutter contre la

- combinaison

- vient

- Commerce

- engagement

- engagé

- Commun

- Communautés

- Sociétés

- Société

- comparer

- conformité

- composant

- comprendre

- complet

- considérations

- considéré

- cohérent

- Console

- consulting

- contiennent

- contenu

- continuellement

- continuer

- continue

- continue

- droit d'auteur

- Violation du droit d'auteur

- Core

- Costs

- couverture

- couvrant

- critères

- Lecture

- Customiser

- des clients

- Clients

- données

- confidentialité des données

- science des données

- ensembles de données

- jours

- profond

- expertise approfondie

- Réglage par défaut

- Vous permet de définir

- livrer

- démographique

- déployer

- déploiement

- Conception

- un

- voulu

- détecter

- développé

- Développement

- difficile

- dimensions

- désinformation

- Diversité

- do

- Documentation

- motivation

- pendant

- e

- chacun

- gagner

- Revenus

- plus facile

- même

- Easy

- Éducation

- efficacement

- efforts

- non plus

- responsabilise

- permettre

- encouragés

- end-to-end

- de renforcer

- Tout

- esprit d'entreprise

- Ether (ETH)

- évaluer

- évaluer

- évaluation

- évaluations

- Chaque

- tout le monde

- évolue

- exemple

- exemples

- excité

- d'experience

- nous a permis de concevoir

- de santé

- Explicabilité

- explorez

- express

- Visage

- justice

- Automne

- plus rapide

- Réactions

- few

- une fonction filtre

- filtration

- filtres

- Trouvez

- finition

- Prénom

- Focus

- Abonnement

- Pour

- formulaire

- Avant

- Accueillir

- Fondation

- quatre

- De

- plus

- En outre

- avenir

- recueillir

- généré

- génère

- génératif

- IA générative

- donné

- donne

- Global

- gouvernance

- Groupes

- Croître

- Croissance

- nuisible

- harnais

- harvard

- haine

- discours de haine

- Vous avez

- he

- vous aider

- aide

- de haute qualité

- randonnée

- sa

- Villa

- Comment

- HTTPS

- humain

- identifier

- identifier

- if

- image

- satellite

- Mettre en oeuvre

- important

- améliorer

- l'amélioration de

- in

- début

- comprendre

- inclus

- inclut

- Y compris

- Améliore

- secteurs

- d'information

- Actualités

- violation

- les initiatives

- innovons

- Innovation

- innovations

- technologie innovante

- technologie innovante

- entrées

- intégrer

- des services

- prévu

- interactions

- développement

- introduire

- introduit

- Découvrez le tout nouveau

- un investissement

- Investissements

- invisible

- IP

- IT

- chemin

- jpg

- juste

- ACTIVITES

- Savoir

- langue

- gros

- lance

- lancement

- procès

- Conduit

- Allons-y

- Niveau

- Levier

- vos produits

- comme

- LIMIT

- limites

- limité

- Liste

- Listé

- le maintien

- a prendre une

- FAIT DU

- gérés

- significative

- veux dire

- mécanisme

- médecine

- Métrique

- l'esprit

- atténuer

- modèle

- numériques jumeaux (digital twin models)

- PLUS

- (en fait, presque toutes)

- must

- Près

- Besoin

- Nouveauté

- maintenant

- of

- de rabais

- offensive

- Offres Speciales

- on

- une fois

- et, finalement,

- en ligne

- services bancaires en ligne

- à mettre en œuvre pour gérer une entreprise rentable. Ce guide est basé sur trois décennies d'expérience

- Option

- Options

- or

- organisation

- organisations

- Autre

- nos

- ande

- sorties

- propre

- partie

- passé

- performant

- effectué

- Personnellement

- phd

- pii

- Place

- Platon

- Intelligence des données Platon

- PlatonDonnées

- politiques

- créateurs de politiques

- possible

- power

- pratique

- pratiques

- président

- empêche

- Aperçu

- priorise

- priorité

- la confidentialité

- Confidentialité et sécurité

- processus

- produire

- IMPIÉTÉ

- professionels

- Professeur

- prometteur

- promouvoir

- propriétés

- protégé

- L'utilisation de sélénite dans un espace est un excellent moyen de neutraliser l'énergie instable ou négative.

- protège

- fournir

- à condition de

- fournisseurs

- aportando

- publiquement

- mettre

- qualité

- requêtes

- soulève

- gamme

- Nos tests de diagnostic produisent des résultats rapides et précis sans nécessiter d'équipement de laboratoire complexe et coûteux,

- rapidement

- RE

- réduire

- libérer

- pertinence

- rester

- supprimez

- rapport

- conditions

- a besoin

- résistant

- ressource

- Resources

- Réagir

- réponses

- responsabilité

- responsables

- de manière responsable

- limité

- bon

- Analyse

- solidité

- pour le running

- fonctionne

- des

- garanties

- en toute sécurité

- Sécurité

- sagemaker

- même

- Escaliers intérieurs

- échelle ai

- Balance

- balayage

- L'école

- Sciences

- scientifiques

- Section

- sécurisé

- sécurité

- sur le lien

- Sélectionner

- sélection

- service

- Services

- service

- set

- mise

- règlement

- installation

- depuis

- unique

- So

- vendu

- quelques

- Quelqu'un

- groupe de neurones

- discours

- passer

- propagation

- Étape

- Utilisation d'un

- Standard

- permanent

- Stanford

- Stanford University

- grève

- Catégorie

- tel

- Sues

- Appareils

- toit

- prise

- Tâche

- équipe

- Technologie

- entreprises technologiques

- examiné

- Essais

- tests

- texte

- qui

- La

- les informations

- au Royaume-Uni

- leur

- Les

- Ces

- l'ont

- des tiers.

- this

- cette semaine

- cette année

- ceux

- Avec

- fiable

- Titan

- à

- ensemble

- les outils

- Les sujets

- Train

- Formation

- Transparence

- communication

- La confiance

- TOUR

- Uk

- comprendre

- entreprendre

- expérience unique et authentique

- université

- utilisé

- cas d'utilisation

- d'utiliser

- Utilisateur

- utilisateurs

- en utilisant

- vital

- Voix

- volontaire

- bénévole

- vp

- souhaitez

- filigrane

- tatouage

- filigranes

- Façon..

- façons

- we

- web

- services Web

- Site Web

- semaine

- WELL

- ont été

- Quoi

- quand

- qui

- tout en

- WHO

- la totalité

- large

- Large gamme

- largement

- sera

- comprenant

- dans les

- des mots

- activités principales

- workflows

- Nos inspecteurs

- an

- hier

- you

- zéphyrnet