Image par l'éditeur

Nous sommes en 2023, ce qui signifie que la plupart des entreprises de la plupart des secteurs collectent des informations et prennent des décisions plus intelligentes à l'aide du Big Data. Cela n'est pas vraiment une surprise de nos jours - la capacité de collecter, de catégoriser et d'analyser de grands ensembles de données est extrêmement utile lorsqu'il s'agit de prendre des décisions commerciales basées sur les données.

Et, alors qu'un nombre croissant d'organisations adoptent la numérisation, la capacité à saisir et à s'appuyer sur l'utilité de l'analyse des données ne fera que croître.

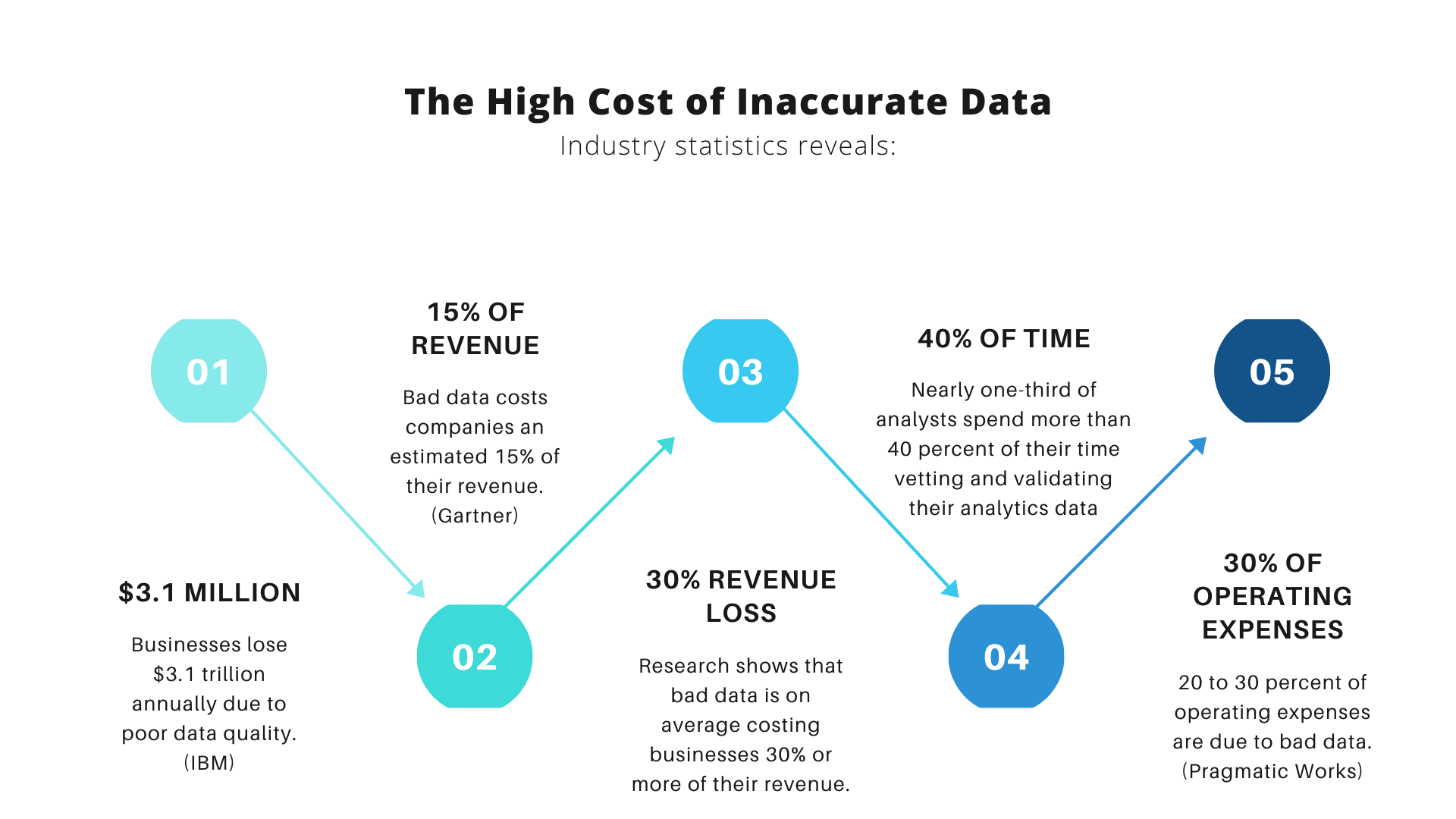

Voici cependant le problème avec le Big Data : plus les organisations en dépendent, plus il y a de chances qu'un plus grand nombre d'entre elles utilisent le Big Data de manière incorrecte. Pourquoi? Parce que les mégadonnées et les informations qu'elles offrent ne sont utiles que si les organisations analysent leurs données avec précision.

Image de échelle de données

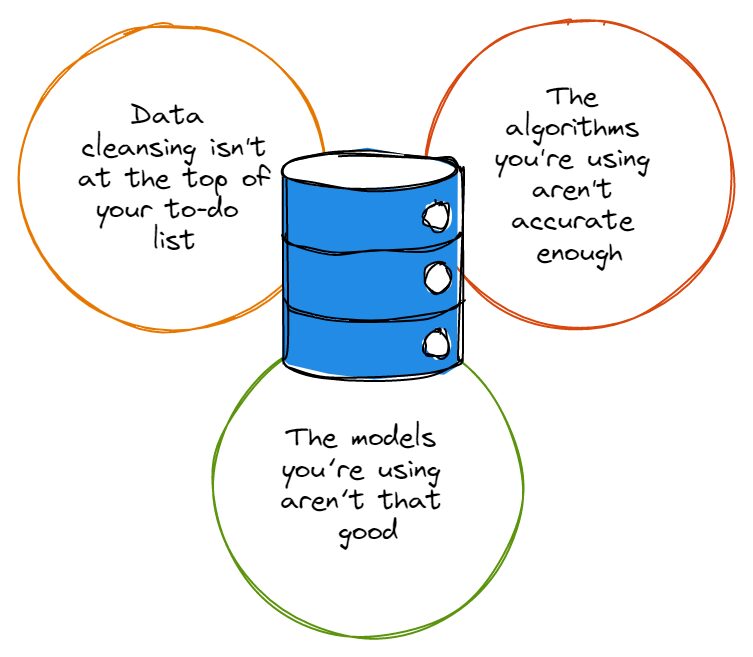

À cette fin, assurons-nous d'éviter certaines erreurs courantes qui affectent souvent la précision de l'analyse des données. Lisez la suite pour en savoir plus sur ces problèmes et comment vous pouvez les éviter.

Avant de pointer du doigt, nous devons admettre que la plupart des ensembles de données ont leur juste part d'erreurs, et ces erreurs ne rendent service à personne quand vient le temps d'analyser les données. Qu'il s'agisse de fautes de frappe, de conventions de dénomination étranges ou de redondances, les erreurs dans les ensembles de données brouillent la précision de l'analyse des données.

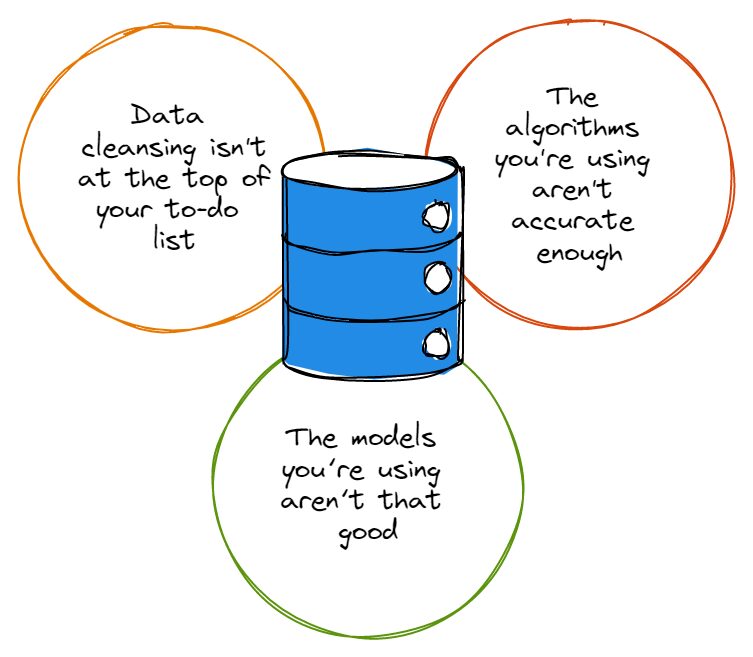

Donc, avant que vous ne soyez trop excité à l'idée de plonger profondément dans le terrier du lapin de l'analyse de données, vous devez d'abord vous assurer que le nettoyage des données figure en tête de votre liste de tâches et que vous nettoyez toujours correctement vos ensembles de données. Vous vous dites peut-être : « hé, le nettoyage des données prend trop de temps pour que je m'en soucie », ce à quoi nous hochons la tête en signe de sympathie.

Heureusement pour vous, vous pouvez investir dans des solutions telles que l'analyse augmentée. Cela tire parti des algorithmes d'apprentissage automatique pour accélérer la vitesse à laquelle vous effectuez votre analyse de données (et cela améliore également la précision de votre analyse).

L'essentiel : quelle que soit la solution que vous utilisez pour automatiser et améliorer le nettoyage de vos données, vous devez toujours effectuer le nettoyage proprement dit. Si vous ne le faites pas, vous n'aurez jamais la base appropriée sur laquelle baser une analyse précise des données.

Comme c'est le cas avec les ensembles de données, la plupart des algorithmes ne sont pas parfaits à cent pour cent ; la plupart d'entre eux ont leur juste part de défauts et ne fonctionnent tout simplement pas comme vous le souhaiteriez à chaque fois que vous les utilisez. Les algorithmes avec un tas d'imperfections peuvent même ignorer les données qui sont essentielles à votre analyse, ou ils peuvent se concentrer sur le mauvais type de données qui ne sont pas vraiment importantes.

Ce n'est un secret pour personne que les plus grands noms de la technologie sont scrutant constamment leurs algorithmes et les peaufiner aussi près que possible de la perfection, et c'est parce que si peu d'algorithmes sont réellement parfaits. Plus votre algorithme est précis, plus la garantie que vos programmes atteignent leurs objectifs et font ce que vous attendez d'eux est grande.

De plus, si votre organisation ne compte que quelques spécialistes des données, elle doit s'assurer que ces spécialistes des données mettent régulièrement à jour les algorithmes de leurs programmes d'analyse de données - il peut même être utile d'établir un calendrier qui tient les équipes responsables de la maintenance. et mettre à jour leurs algorithmes d'analyse de données selon un calendrier convenu.

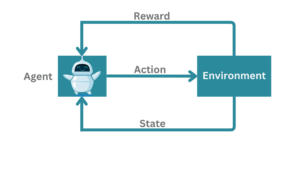

Mieux encore, il peut être d'établir une stratégie qui tire parti des algorithmes basés sur l'IA/ML, qui devraient pouvoir se mettre à jour automatiquement.

Il est généralement compréhensible que de nombreux chefs d'entreprise qui ne sont pas directement en contact avec leurs équipes d'analyse de données ne se rendent pas compte que les algorithmes et les modèles ce ne sont pas les mêmes choses. Au cas où VOUS ne le sauriez pas non plus, rappelez-vous que les algorithmes sont les méthodes que nous utilisons pour analyser les données ; les modèles sont les calculs créés en exploitant la sortie d'un algorithme.

Les algorithmes peuvent analyser des données toute la journée, mais si leur sortie ne passe pas par des modèles conçus pour vérifier l'analyse ultérieure, vous n'aurez aucune information utilisable ou utile.

Pensez-y comme ceci : si vous avez des algorithmes fantaisistes qui traitent des données mais que vous n'avez aucune idée à montrer, vous n'allez pas prendre de meilleures décisions basées sur les données qu'avant d'avoir ces algorithmes ; ce serait comme vouloir intégrer la recherche d'utilisateurs dans la feuille de route de votre produit, mais ignorer le fait que, par exemple, l'industrie des études de marché généré 76.4 milliards de dollars de chiffre d'affaires en 2021, soit une augmentation de 100 % depuis 2008.

Vos intentions peuvent être admirables, mais vous devez utiliser les outils et les connaissances modernes à votre disposition pour glaner ces informations ou intégrer cette recherche d'utilisateurs dans votre feuille de route au mieux de vos capacités.

Il est regrettable que les modèles sous-optimaux soient un moyen infaillible de gâcher la sortie de vos algorithmes, aussi sophistiqués soient-ils. Il est donc essentiel que les dirigeants d'entreprise et les responsables techniques associent plus étroitement leurs experts en analyse de données afin de créer des modèles ni trop compliqués ni trop simples.

Et, selon la quantité de données avec lesquelles ils travaillent, les chefs d'entreprise peuvent choisir de passer par plusieurs modèles différents avant de choisir celui qui convient le mieux au volume et au type de données qu'ils doivent gérer.

En fin de compte, si vous voulez vous assurer que votre analyse de données n'est pas systématiquement erronée, vous devez également vous rappeler de ne jamais être victime de préjugés. Le biais est malheureusement l'un des plus grands obstacles à surmonter lorsqu'il s'agit de maintenir l'exactitude des analyses de données.

Qu'ils influencent le type de données collectées ou qu'ils aient un impact sur la façon dont les chefs d'entreprise interprètent les données, les préjugés sont variés et souvent difficiles à cerner. Les dirigeants doivent faire de leur mieux pour identifier leurs préjugés et les abandonner afin de bénéficier de analyse précise des données.

Les données sont puissantes : lorsqu'elles sont utilisées correctement, elles peuvent fournir aux chefs d'entreprise et à leurs organisations des informations extrêmement utiles qui peuvent transformer la façon dont ils développent et fournissent leurs produits à leurs clients. Assurez-vous simplement que vous faites tout ce qui est en votre pouvoir pour vous assurer que vos analyses de données sont exactes et ne souffrent pas des erreurs facilement évitables que nous avons décrites dans cet article.

Nahla Davies est un développeur de logiciels et un rédacteur technique. Avant de consacrer son travail à plein temps à la rédaction technique, elle a réussi – entre autres choses intrigantes – à servir de programmeuse principale dans une organisation de marque expérientielle Inc. 5,000 XNUMX dont les clients incluent Samsung, Time Warner, Netflix et Sony.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- Platoblockchain. Intelligence métaverse Web3. Connaissance Amplifiée. Accéder ici.

- La source: https://www.kdnuggets.com/2023/03/3-mistakes-could-affecting-accuracy-data-analytics.html?utm_source=rss&utm_medium=rss&utm_campaign=3-mistakes-that-could-be-affecting-the-accuracy-of-your-data-analytics

- :est

- 000

- 2021

- 2023

- a

- capacités

- capacité

- Capable

- A Propos

- accélérer

- accomplissant

- précision

- Avec cette connaissance vient le pouvoir de prendre

- avec précision

- actually

- admirable

- admettre

- affecter

- affectant

- algorithme

- algorithmes

- Tous

- toujours

- parmi

- selon une analyse de l’Université de Princeton

- analytique

- il analyse

- l'analyse

- ainsi que

- chacun.e

- SONT

- article

- AS

- At

- augmentée

- automatiser

- automatiquement

- disponibles

- en évitant

- base

- BE

- car

- devient

- before

- va

- profiter

- LES MEILLEURS

- Améliorée

- biais

- Big

- Big Data

- plus gros

- Le plus grand

- Bas et Leggings

- l'image de marque

- construire

- Bouquet

- la performance des entreprises

- entreprises

- by

- CAN

- maisons

- Chance

- vérifier

- Selectionnez

- CLIENTS

- Fermer

- étroitement

- Codecademy

- Collecte

- comment

- Commun

- compliqué

- calculs

- continuer

- Conventions

- pourriez

- Couples

- engendrent

- créée

- crise

- Clients

- données

- l'analyse des données

- Analyse de Donnée

- ensembles de données

- data-driven

- journée

- jours

- décisions

- profond

- livrer

- Selon

- un

- développer

- Développeur

- différent

- difficile

- numérisation

- directement

- faire

- down

- conduite

- même

- non plus

- embrasser

- s'engager

- engagé

- assurer

- Erreurs

- essential

- établir

- établissement

- Pourtant, la

- Chaque

- peut

- exemple

- excité

- cadres

- expérimental

- de santé

- juste

- Automne

- faveurs

- few

- Prénom

- défauts

- Focus

- Abonnement

- Pour

- Fondation

- De

- plein

- obtenez

- Go

- Objectifs

- aller

- subvention

- saisir

- plus grand

- plus

- Croître

- Croissance

- guarantir

- manipuler

- Vous avez

- têtes

- vous aider

- détient

- Comment

- HTML

- http

- HTTPS

- Haies

- identifier

- immensément

- important

- améliorer

- améliore

- in

- Inc

- comprendre

- à tort

- Améliore

- secteurs

- industrie

- influençant

- idées.

- intentions

- Investir

- vous aider à faire face aux problèmes qui vous perturbent

- IT

- jpg

- KDnuggetsGenericName

- Genre

- spécialisées

- conduire

- dirigeants

- APPRENTISSAGE

- apprentissage

- les leviers

- en tirant parti

- comme

- Gamme

- Liste

- Location

- Lot

- click

- machine learning

- a prendre une

- Fabrication

- gérés

- Marché

- Étude de marché

- Matière

- veux dire

- méthodes

- erreurs

- numériques jumeaux (digital twin models)

- Villas Modernes

- PLUS

- (en fait, presque toutes)

- noms

- nommage

- Besoin

- Ni

- Netflix

- nombre

- of

- Offres Speciales

- on

- ONE

- de commander

- organisation

- organisations

- Autre

- décrit

- sortie

- Overcome

- pour cent

- parfaite

- effectuer

- RECHERCHE PEW

- Platon

- Intelligence des données Platon

- PlatonDonnées

- possible

- power

- solide

- Produit

- Produits

- Programmeur

- Programmes

- correct

- correctement

- Lapin

- Tarif

- RE

- Lire

- réaliser

- régulièrement

- rappeler

- représentation

- un article

- de revenus

- feuille de route

- s

- même

- Samsung

- calendrier

- scientifiques

- secret

- besoin

- Sets

- régler

- Partager

- devrait

- montrer

- étapes

- simplement

- depuis

- plus intelligents

- So

- Logiciels

- sur mesure

- Solutions

- quelques

- Sony

- sophistiqué

- Encore

- de Marketing

- ultérieur

- tel

- souffrent

- surprise

- équipes

- technologie

- Technique

- qui

- La

- leur

- Les

- se

- donc

- Ces

- chose

- des choses

- Avec

- fiable

- long

- à

- trop

- les outils

- top

- Transformer

- peaufinage

- Bien entendu

- malheureux

- Mises à jour

- Actualités

- la mise à jour

- utilisable

- utilisé

- Utilisateur

- Ve

- Victime

- le volume

- vouloir

- Warner

- Façon..

- Quoi

- que

- qui

- WHO

- sera

- comprenant

- activités principales

- de travail

- digne d'intérêt

- écrivain

- écriture

- faux

- Votre

- zéphyrnet