Intel Corporationin tutkijat julkaisivat teknisen paperin nimeltä "Tehokas LLM-johtopäätösratkaisu Intel GPU:lla".

Tiivistelmä:

"Transformer-pohjaisia suuria kielimalleja (LLM) on käytetty laajasti monilla aloilla, ja LLM-päättelyn tehokkuudesta tulee kuuma puheenaihe todellisissa sovelluksissa. LLM:t on kuitenkin yleensä monimutkaisesti suunniteltu mallirakenteessa, jossa on valtavia operaatioita, ja ne tekevät päätelmiä autoregressiivisessä tilassa, mikä tekee järjestelmän suunnittelusta erittäin tehokkaan haastavan.

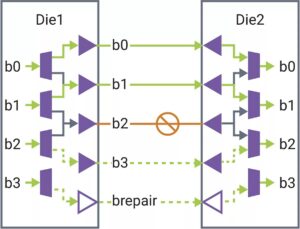

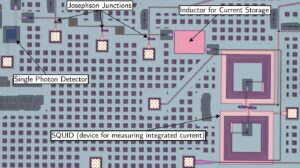

Tässä artikkelissa ehdotamme tehokasta LLM-päätelmäratkaisua alhaisella latenssilla ja suurella suorituskyvyllä. Ensinnäkin yksinkertaistamme LLM-dekooderikerrosta yhdistämällä tiedonsiirron ja elementtikohtaiset toiminnot muistin käyttötaajuuden ja järjestelmän latenssin pienentämiseksi. Ehdotamme myös segmentin KV-välimuistikäytäntöä, joka pitää pyyntö- ja vastaustunnisteiden avaimen/arvon erillisessä fyysisessä muistissa tehokkaan laitteen muistin hallinnan varmistamiseksi, mikä auttaa suurentamaan ajonaikaista eräkokoa ja parantamaan järjestelmän suorituskykyä. Mukautettu Scaled-Dot-Product-Attention-ydin on suunniteltu vastaamaan fuusiokäytäntöämme, joka perustuu segmentin KV-välimuistiratkaisuun. Toteutamme LLM-johtopäätösratkaisumme Intel GPU:ssa ja julkaisemme sen julkisesti. Tavalliseen HuggingFace-toteutukseen verrattuna ehdotettu ratkaisu saavuttaa jopa 7x pienemmän tunnuksen latenssin ja 27x suuremman suorituskyvyn joillakin suosituilla LLM:illä Intelin GPU:ssa."

Etsi tekninen paperi täällä. Julkaistu joulukuussa 2023 (esipainos).

Wu, Hui, Yi Gan, Feng Yuan, Jing Ma, Wei Zhu, Yutao Xu, Hong Zhu, Yuhua Zhu, Xiaoli Liu ja Jinghui Gu. "Tehokas LLM-johtopäätösratkaisu Intelin GPU:lla." arXiv preprint arXiv:2401.05391 (2023).

Aiheeseen liittyvä lukeminen

LLM-päätelmä suorittimista (Intel)

Intelin tutkijat julkaisivat teknisen paperin nimeltä "Efficient LLM Inference on CPUs".

AI Races To The Edge

Päätelmiä ja koulutusta siirretään pienempiin laitteisiin, kun tekoäly leviää uusiin sovelluksiin.

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- PlatonHealth. Biotekniikan ja kliinisten kokeiden älykkyys. Pääsy tästä.

- Lähde: https://semiengineering.com/llm-inference-on-gpus-intel/

- :On

- $ YLÖS

- 2023

- a

- pääsy

- päästään

- AI

- Myös

- an

- ja

- sovellukset

- OVAT

- AS

- At

- perustua

- tulee

- ollut

- ovat

- by

- kätkö

- haastava

- verrattuna

- YHTIÖ

- räätälöityjä

- tiedot

- joulukuu

- Malli

- suunniteltu

- laite

- Laitteet

- Tehokas

- tehokkuus

- tehokas

- suurentaa

- Fields

- varten

- Taajuus

- kiinnityslämpötila

- fuusio

- GPU

- GPU

- Olla

- auttaa

- tätä

- Korkea

- korkeampi

- Hong

- KUUMA

- Kuitenkin

- HTTPS

- HalaaKasvot

- toteuttaa

- täytäntöönpano

- parantaa

- in

- Intel

- IT

- jpg

- Pitää

- Kieli

- suuri

- Viive

- kerros

- llm

- Matala

- alentaa

- Tekeminen

- johto

- monet

- massiivinen

- ottelu

- Muisti

- tila

- malli

- mallit

- liike

- Uusi

- of

- on

- avata

- Operations

- meidän

- Paperi

- suorittaa

- fyysinen

- Platon

- Platonin tietotieto

- PlatonData

- politiikka

- Suosittu

- ehdottaa

- ehdotettu

- julkisesti

- julkaista

- julkaistu

- työntää

- kilpailuista

- todellinen

- vähentää

- pyyntö

- Tutkijat

- vastaus

- segmentti

- erillinen

- yksinkertaistaa

- Koko

- pienempiä

- ratkaisu

- jonkin verran

- levitteet

- standardi

- rakenne

- järjestelmä

- Tehtävä

- Tekninen

- -

- tätä

- suoritusteho

- nimeltään

- että

- symbolinen

- tokens

- aihe

- koulutus

- käytetty

- yleensä

- oli

- we

- laajalti

- with

- yuan

- zephyrnet