Purduen yliopiston tutkijat julkaisivat teknisen paperin nimeltä "WWW: What, When, Where to Compute-in-Memory".

Tiivistelmä:

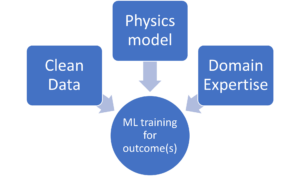

"Compute-in-memory (CiM) on noussut houkuttelevaksi ratkaisuksi, joka vähentää korkeita tiedonsiirtokustannuksia von Neumannin koneissa. CiM voi suorittaa massiivisesti rinnakkaisia yleismatriisin kertolaskutoimintoja (GEMM) muistissa, joka on hallitseva laskenta koneoppimisen (ML) päättelyssä. Muistin uudelleenkäyttö laskemista varten herättää kuitenkin keskeisiä kysymyksiä: 1) Minkä tyyppistä CiM:ää käytetään: Koska analogisia ja digitaalisia CiM:itä on paljon, niiden soveltuvuus on määritettävä järjestelmän näkökulmasta. 2) Milloin CiM:ää käytetään: ML-päätelmä sisältää työkuormia, joissa on erilaisia muisti- ja laskentavaatimuksia, mikä tekee vaikeaksi tunnistaa, milloin CiM on edullisempi kuin tavalliset prosessointiytimet. 3) Mihin CiM integroidaan: Jokaisella muistitasolla on erilainen kaistanleveys ja kapasiteetti, mikä vaikuttaa CiM-integraation tiedonsiirto- ja paikallisetuihin.

Tässä artikkelissa tutkimme vastauksia näihin kysymyksiin, jotka koskevat CiM-integraatiota ML-päätelmien kiihdytykseen. Käytämme Timeloop-Accelergya CiM-prototyyppien varhaiseen järjestelmätason arviointiin, mukaan lukien sekä analogiset että digitaaliset primitiivit. Integroimme CiM:n eri välimuistitasoihin Nvidia A100:n kaltaisessa perusarkkitehtuurissa ja räätälöimme tietovirran erilaisiin ML-työkuormiin. Kokeilumme osoittavat, että CiM-arkkitehtuurit parantavat energiatehokkuutta ja saavuttavat jopa 0.12x alhaisemman energian kuin vakiintunut perusviiva INT-8-tarkkuudella ja jopa 4x suorituskyvyn kasvua painon lomittelulla ja päällekkäisyydellä. Ehdotettu työ tarjoaa näkemyksiä siitä, minkä tyyppistä CiM:ää tulee käyttää ja milloin ja missä se integroidaan optimaalisesti välimuistihierarkiaan GEMM-kiihdytystä varten.

Etsi tekninen paperi täällä. Julkaistu joulukuussa 2023 (esipainos).

Sharma, Tanvi, Mustafa Ali, Indranil Chakraborty ja Kaushik Roy. "WWW: Mitä, milloin, missä laskea muistiin." arXiv preprint arXiv:2312.15896 (2023).

Aiheeseen liittyvä lukeminen

Tekoälyn energiatehokkuuden lisääminen Compute In Memoryn avulla

Kuinka käsitellä zetta-mittakaavaisia työkuormia ja pysyä kiinteän tehobudjetin sisällä.

Muistin laskennan mallinnus biologisella tehokkuudella

Generatiivinen tekoäly pakottaa sirujen valmistajat käyttämään laskentaresursseja älykkäämmin.

SRAM AI:ssa: Muistin tulevaisuus

Miksi SRAMia pidetään tärkeänä elementtinä uusissa ja perinteisissä laskenta-arkkitehtuureissa.

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- PlatonHealth. Biotekniikan ja kliinisten kokeiden älykkyys. Pääsy tästä.

- Lähde: https://semiengineering.com/cim-integration-for-ml-inference-acceleration/

- :on

- :On

- :missä

- $ YLÖS

- 1

- 2023

- a

- kiihtyvyys

- saavuttamisessa

- AI

- lievittää

- an

- ja

- vastauksia

- arkkitehtuuri

- AS

- At

- kaistanleveys

- Lähtötilanne

- suotuisa

- Hyödyt

- sekä

- talousarvio

- by

- kätkö

- CAN

- Koko

- pakottava

- laskeminen

- Laskea

- kustannukset

- kriittinen

- tiedot

- joulukuu

- määritetään

- eri

- vaikea

- digitaalinen

- hallitseva

- kukin

- Varhainen

- tehokkuus

- elementti

- syntyi

- energia

- energiatehokkuuden

- vakiintunut

- arviointi

- kokeiluja

- tutkia

- kiinteä

- varten

- Joukot

- alkaen

- tulevaisuutta

- voitto

- general

- tietty

- tätä

- hierarkia

- Korkea

- Kuitenkin

- HTTPS

- tunnistaa

- parantaa

- in

- sisältää

- Mukaan lukien

- oivalluksia

- yhdistää

- integraatio

- tulee

- IT

- jpg

- avain

- oppiminen

- Taso

- tasot

- alentaa

- kone

- koneoppiminen

- Koneet

- Tekeminen

- massiivisesti

- Matriisi

- Muisti

- ML

- lisää

- liike

- paljous

- tarvitaan

- Uusi

- Nvidia

- of

- on

- avata

- Operations

- meidän

- Paperi

- Parallel

- suorittaa

- suorituskyky

- näkökulma

- Platon

- Platonin tietotieto

- PlatonData

- aiheuttaa

- teho

- Tarkkuus

- prosessi

- käsittely

- ehdotettu

- prototyyppejä

- tarjoaa

- julkaistu

- kysymykset

- suhteen

- vaatimukset

- Tutkijat

- Esittelymateriaalit

- roy

- näyttää

- ratkaisu

- standardi

- pysyä

- sopivuus

- järjestelmät

- Tekninen

- kuin

- että

- -

- Tulevaisuus

- heidän

- Nämä

- tätä

- nimeltään

- että

- perinteinen

- tyyppi

- yliopisto

- käyttää

- lajike

- eri

- katsottu

- of

- oli

- we

- paino

- Mitä

- kun

- with

- sisällä

- Referenssit

- zephyrnet