esittely

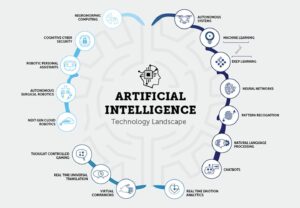

Tekoälyn (AI) alan kasvaessa ja kehittyessä on yhä tärkeämpää, että aloittelevat tekoälykehittäjät pysyvät ajan tasalla uusimmasta tutkimuksesta ja edistysaskeleista. Yksi parhaista tavoista tehdä tämä on lukea GenAI-kehittäjien tekoälypaperit, jotka tarjoavat arvokkaita näkemyksiä huippuluokan tekniikoista ja algoritmeista. Tämä artikkeli tutkii 15 tärkeää tekoälypaperia GenAI-kehittäjille. Nämä paperit kattavat erilaisia aiheita luonnollisen kielen käsittelystä tietokonenäköön. Ne parantavat ymmärrystäsi tekoälystä ja lisäävät mahdollisuuksiasi saada ensimmäinen työpaikkasi tällä jännittävällä alalla.

Tekoälypaperien merkitys GenAI-kehittäjille

GenAI-kehittäjien tekoälypaperit antavat tutkijoille ja asiantuntijoille mahdollisuuden jakaa havaintojaan, menetelmiään ja läpimurtojaan laajemmalle yhteisölle. Lukemalla näitä artikkeleita pääset käsiksi tekoälyn uusimpiin edistysaskeliin, joten voit pysyä kehityksen kärjessä ja tehdä tietoisia päätöksiä työssäsi. Lisäksi GenAI-kehittäjien tekoälypaperit tarjoavat usein yksityiskohtaisia selityksiä algoritmeista ja tekniikoista, mikä antaa sinulle syvemmän käsityksen niiden toiminnasta ja siitä, kuinka niitä voidaan soveltaa todellisiin ongelmiin.

Tekoälypaperien lukeminen GenAI-kehittäjille tarjoaa useita etuja aloitteleville tekoälykehittäjille. Ensinnäkin se auttaa sinua pysymään ajan tasalla alan uusimmista tutkimuksista ja trendeistä. Tämä tieto on ratkaisevan tärkeää tekoälyyn liittyviin töihin haettaessa, sillä työnantajat etsivät usein hakijoita, jotka tuntevat viimeisimmät edistysaskeleet. Lisäksi tekoälypapereita lukemalla voit laajentaa tietämystäsi ja saada syvempää ymmärrystä tekoälykonsepteista ja menetelmistä. Tätä tietoa voidaan soveltaa projekteissasi ja tutkimuksessasi, jolloin sinusta tulee pätevä ja taitavampi tekoälykehittäjä.

Sisällysluettelo

Yleiskatsaus: Essential AI Papers GenAI-kehittäjille linkkien kanssa

Paperi 1: Transformers: Huomio on kaikki mitä tarvitset

Linkki: Lue tästä

Paperin yhteenveto

Artikkelissa esitellään Transformer, uusi hermoverkkoarkkitehtuuri sekvenssin siirtotehtäviin, kuten konekäännös. Toisin kuin perinteiset mallit, jotka perustuvat toistuviin tai konvoluutiohermoverkkoihin, Transformer luottaa yksinomaan huomiomekanismeihin, mikä eliminoi toistumisen ja konvoluutioiden tarpeen. Kirjoittajat väittävät, että tämä arkkitehtuuri tarjoaa erinomaisen suorituskyvyn käännöslaadun, paremman rinnakkaisettavuuden ja lyhyemmän harjoitusajan suhteen.

Tärkeimmät näkemykset AI-papereista GenAI-kehittäjille

- Huomiomekanismi

Transformer on rakennettu kokonaan huomiomekanismeihin, mikä mahdollistaa sen kaapata maailmanlaajuiset riippuvuudet tulo- ja lähtösekvenssien välillä. Tämä lähestymistapa mahdollistaa sen, että malli ottaa huomioon suhteita ilman, että sekvenssien elementtien välinen etäisyys rajoittaa sitä.

- parallelization

Yksi Transformer-arkkitehtuurin suuri etu on sen lisääntynyt rinnakkaisettavuus. Perinteiset toistuvat mallit kärsivät peräkkäislaskennasta, mikä tekee rinnakkaisuista haastavaa. Transformerin suunnittelu mahdollistaa tehokkaamman rinnakkaiskäsittelyn harjoittelun aikana, mikä vähentää harjoitusaikoja.

- Ylivoimainen laatu ja tehokkuus

Artikkelissa esitetään kokeellisia tuloksia konekäännöstehtävistä, jotka osoittavat, että Transformer saavuttaa ylivertaisen käännöslaadun olemassa oleviin malleihin verrattuna. Se ylittää aikaisemmat huippuluokan tulokset, mukaan lukien kokonaisuusmallit, huomattavasti. Lisäksi Transformer saavuttaa nämä tulokset huomattavasti lyhyemmällä harjoitusajalla.

- Käännössuorituskyky

WMT 2014 englannista saksaksi -käännöstehtävässä ehdotettu malli saavuttaa BLEU-pistemäärän 28.4, mikä ylittää nykyiset parhaat tulokset yli 2 BLEU:lla. Englannista ranskaksi -tehtävässä malli asettaa uuden yhden mallin huippuluokan BLEU-pistemäärän 41.8, kun on harjoitettu vain 3.5 päivää kahdeksalla GPU:lla.

- Yleistys muihin tehtäviinKirjoittajat osoittavat, että Transformer-arkkitehtuuri yleistyy hyvin konekääntämisen ulkopuolisiin tehtäviin. He soveltavat mallia menestyksekkäästi englanninkielisen valitsijaryhmän jäsentämiseen, mikä osoittaa sen mukautuvuuden erilaisiin sekvenssitransduktioongelmiin.

Paperi 2: BERT: Syvien kaksisuuntaisten muuntajien esikoulutus kielen ymmärtämiseen

Linkki: Lue tästä

Paperin yhteenveto

Kielimallin esikoulutus on osoittautunut tehokkaaksi erilaisten luonnollisen kielen käsittelytehtävien parantamisessa. Artikkelissa erotetaan ominaisuuspohjaiset ja hienosäätömenetelmät esikoulutettujen kieliesitysten soveltamiseen. BERT otetaan käyttöön, jotta voidaan puuttua hienosäätömenetelmien rajoituksiin, erityisesti standardikielimallien yksisuuntaisuusrajoitteeseen. Paperissa ehdotetaan "Masked Language Model" (MLM) esikoulutustavoitetta, joka on saanut inspiraationsa Cloze-tehtävästä, mahdollistamaan kaksisuuntaiset esitykset. "Seuraavan lauseen ennustus" -tehtävää käytetään myös tekstipariesitysten esiopettamiseen yhdessä.

Tärkeimmät näkemykset AI-papereista GenAI-kehittäjille

- Kaksisuuntaisen esikoulutuksen tärkeys

Paperi korostaa kaksisuuntaisen esikoulutuksen merkitystä kielten esityksille. Toisin kuin aikaisemmissa malleissa, BERT hyödyntää peitettyjä kielimalleja mahdollistaakseen syvät kaksisuuntaiset esitykset, ohittaen aikaisemmissa teoksissa käytetyt yksisuuntaiset kielimallit.

- Tehtäväkohtaisten arkkitehtuurien vähentäminen

BERT osoittaa, että esikoulutetut esitykset vähentävät voimakkaasti suunniteltujen tehtäväkohtaisten arkkitehtuurien tarvetta. Siitä tulee ensimmäinen hienosäätöön perustuva esitysmalli, joka saavuttaa huippuluokan suorituskyvyn useissa eri lausetason ja token-tason tehtävissä, ylittäen tehtäväkohtaiset arkkitehtuurit.

- Huippumodernit edistysaskeleet

BERT saavuttaa uusia huippuluokan tuloksia 1.1 luonnollisen kielen käsittelytehtävässä, mikä osoittaa sen monipuolisuuden. Huomattavia parannuksia ovat GLUE-pisteiden merkittävä kasvu, MultiNLI-tarkkuus ja parannukset SQuAD v2.0- ja vXNUMX-kysymyksiin vastaamiseen.

Voit myös lukea: BERT:n hienosäätö masketulla kielimallinnusella

Paperi 3: GPT: Kielimallit ovat harvoja oppijoita

Linkki: Lue tästä

Paperin yhteenveto

Artikkelissa käsitellään luonnollisen kielen käsittelyn (NLP) tehtävissä saavutettuja parannuksia skaalatamalla kielimalleja keskittyen GPT-3 (Generative Pre-trained Transformer 3), autoregressiivinen kielimalli, jossa on 175 miljardia parametria. Kirjoittajat korostavat sitä viime aikoina NLP mallit osoittavat huomattavia etuja esikoulutuksen ja hienosäädön avulla. Ne vaativat usein tehtäväkohtaisia tietojoukkoja, joissa on tuhansia esimerkkejä hienosäätöä varten. Sitä vastoin ihmiset voivat suorittaa uusia kielitehtäviä muutamalla esimerkillä tai yksinkertaisilla ohjeilla.

Tärkeimmät näkemykset AI-papereista GenAI-kehittäjille

- Skaalaus parantaa muutaman otoksen suorituskykyä

Kirjoittajat osoittavat, että kielimallien skaalaaminen parantaa merkittävästi tehtäväagnostista, muutaman laukauksen suorituskykyä. GPT-3 suurella parametrikoolla saavuttaa toisinaan kilpailukykyä uusimmilla hienosäätömenetelmillä ilman tehtäväkohtaista hienosäätöä tai gradienttipäivityksiä.

- Laaja sovellettavuus

GPT-3:lla on vahva suorituskyky erilaisissa NLP-tehtävissä, mukaan lukien kääntäminen, kysymyksiin vastaaminen, sulkemistehtävät ja tehtävät, jotka edellyttävät nopeaa päättelyä tai verkkoalueen mukauttamista. - Haasteet ja rajoitukset

Vaikka GPT-3:lla on huomattavia muutaman otoksen oppimiskykyjä, kirjoittajat tunnistavat tietojoukkoja, joissa se kamppailee, ja korostavat metodologisia ongelmia, jotka liittyvät koulutukseen suurissa verkkokorjauksissa. - Ihmisen kaltainen artikkelisukupolvi

GPT-3 voi tuottaa uutisartikkeleita, joita arvioijien on vaikea erottaa ihmisten kirjoittamista artikkeleista. - Yhteiskunnalliset vaikutukset ja laajemmat näkökohdat

Paperi käsittelee GPT-3:n kykyjen laajempia yhteiskunnallisia vaikutuksia, erityisesti ihmisen kaltaisen tekstin luomisessa. Sen suorituksen vaikutuksia eri tehtäviin tarkastellaan käytännön sovelluksissa ja mahdollisissa haasteissa. - Nykyisten NLP-lähestymistapojen rajoitukset

Kirjoittajat korostavat nykyisten NLP-lähestymistapojen rajoituksia, erityisesti niiden riippuvuutta tehtäväkohtaisista hienosäätötietosarjoista, jotka asettavat haasteita, kuten vaatimuksen suurille merkittyjä tietojoukkoja varten ja riskin ylisovituksesta kapeaan tehtäväjakaumaan. Lisäksi huolenaiheena on näiden mallien yleistyskyky koulutusjakauman rajojen ulkopuolella.

Paperi 4: CNN:t: ImageNet Classification with Deep Convolutional Neural Networks

Linkki: Lue tästä

Paperin yhteenveto

Artikkelissa kuvataan suuren, syvän konvoluutiohermoverkon (CNN) kehittämistä ja koulutusta kuvien luokittelua varten ImageNet Large Scale Visual Recognition Challenge (ILSVRC) -tietosarjoissa. Mallilla saavutetaan merkittäviä parannuksia luokittelutarkkuudessa verrattuna aikaisempiin huipputekniikan menetelmiin.

Tärkeimmät näkemykset AI-papereista GenAI-kehittäjille

- Malli arkkitehtuuri

Tutkimuksessa käytetty hermoverkko on syvä CNN, jossa on 60 miljoonaa parametria ja 650,000 1000 neuronia. Se koostuu viidestä konvoluutiokerroksesta, joista osa seuraa max-pooling-kerroksia, ja kolmesta täysin yhdistetystä kerroksesta, joissa on lopullinen XNUMX-suuntainen softmax-luokitus.

- Harjoittelutiedot

Malli on koulutettu ImageNet ILSVRC-1.2 -kilpailun 2010 miljoonan korkearesoluutioisen kuvan suurelle tietojoukolle. Koulutusprosessiin kuuluu kuvien luokittelu 1000 eri luokkaan.

- Suorituskyky

Malli saavuttaa testitiedoissa top-1 ja top-5 virheprosentit 37.5 % ja 17.0 %. Nämä virhetasot ovat huomattavasti paremmat kuin aikaisempi huipputekniikka, mikä osoittaa ehdotetun lähestymistavan tehokkuuden.

- Parannuksia yliasennukseen

Paperi esittelee useita tekniikoita ylisovitusongelmien ratkaisemiseksi, mukaan lukien tyydyttymättömät neuronit, tehokas GPU-toteutus nopeampaa harjoittelua varten ja säännöstelymenetelmä, jota kutsutaan "dropoutiksi" täysin yhdistetyissä kerroksissa. - Laskennallinen tehokkuus

Huolimatta suurten CNN-verkkojen koulutuksen laskentavaatimuksista, paperi toteaa, että nykyiset GPU:t ja optimoidut toteutukset mahdollistavat tällaisten mallien harjoittamisen korkearesoluutioisilla kuvilla.

- Avustukset

Paperi korostaa tutkimuksen panosta, mukaan lukien yhden suurimmista konvoluutiohermoverkkojen kouluttamisesta ImageNet-tietosarjoista ja huippuluokan tulosten saavuttamisesta ILSVRC-kilpailuissa.

Voit myös lukea: Kattava opetusohjelma konvoluutiohermoverkkojen oppimiseen

Paperi 5: GAT:t: Graph Attention Networks

Linkki: Lue tästä

Paperin yhteenveto

Paperi esittelee huomioon perustuvan arkkitehtuurin solmujen luokitteluun graafirakenteisissa tiedoissa, esitellen sen tehokkuutta, monipuolisuutta ja kilpailukykyistä suorituskykyä eri vertailuarvoissa. Huomiomekanismien sisällyttäminen osoittautuu tehokkaaksi työkaluksi mielivaltaisesti strukturoitujen kaavioiden käsittelyyn.

Tärkeimmät näkemykset AI-papereista GenAI-kehittäjille

- Graph Attention Networks (GAT)GAT:t hyödyntävät naamioituja itseään huomioivia kerroksia puuttuakseen aikaisempien menetelmien rajoituksiin, jotka perustuvat kuvaajakonvoluutioihin. Arkkitehtuuri sallii solmujen osallistua naapurustojensa ominaisuuksiin ja määrittää implisiittisesti eri painot eri solmuille turvautumatta kalliisiin matriisioperaatioihin tai a priori graafisen rakenteen tuntemukseen.

- Spektripohjaisten haasteiden käsitteleminen

GAT:t vastaavat samanaikaisesti useisiin haasteisiin spektripohjaisissa graafisen hermoverkoissa. Graph Attention Network (GAT) -haasteet sisältävät spatiaalisesti lokalisoidut suodattimet, intensiiviset laskennat ja ei-spatiaalisesti lokalisoidut suodattimet. Lisäksi GAT:t riippuvat laplalaisen ominaisperustasta, mikä edistää niiden soveltuvuutta induktiivisiin ja transduktiivisiin ongelmiin.

- Suorituskyky vertailuarvojen välillä

GAT-mallit saavuttavat tai vastaavat huippuluokan tuloksia neljällä vakiintuneella kaaviovertailulla: Cora-, Citeseer- ja Pubmed-viittausverkoston tietojoukoilla sekä proteiini-proteiini-vuorovaikutustietojoukolla. Nämä vertailuarvot kattavat sekä transduktiivisen että induktiivisen oppimisen skenaariot ja osoittavat GAT:iden monipuolisuuden.

- Vertailu aiempiin lähestymistapoihin

Paperi tarjoaa kattavan yleiskatsauksen aikaisemmista lähestymistavoista, mukaan lukien rekursiiviset neuroverkot, Graafiset neuroverkot (GNN:t), spektri- ja ei-spektrimenetelmät sekä huomiomekanismit. GAT:t sisältävät huomiomekanismeja, jotka mahdollistavat tehokkaan rinnakkaisuuden solmu-naapuri-parien välillä ja soveltamisen eriasteisiin solmuihin.

- Tehokkuus ja sovellettavuusGAT:t tarjoavat rinnakkaisevan, tehokkaan toiminnan, jota voidaan soveltaa eriasteisiin graafin solmuihin määrittämällä mielivaltaisia painotuksia naapureille. Malli soveltuu suoraan induktiivisiin oppimisongelmiin, joten se soveltuu tehtäviin, joissa sen on yleistettävä täysin näkymättömiin kaavioihin.

- Suhde aikaisempiin malleihin

Kirjoittajat huomauttavat, että GAT:t voidaan muotoilla uudelleen tietyksi MoNetin esiintymäksi, jakaa yhtäläisyyksiä relaatioverkostojen kanssa ja muodostaa yhteyden teoksiin, jotka käyttävät naapuruston huomiotoimintoja. Ehdotettua huomiomallia verrataan vastaaviin lähestymistapoihin, kuten Duan et al. (2017) ja Denil et ai. (2017).

Paperi 6: ViT: Kuvan arvo on 16 × 16 sanaa: muuntajat kuvantunnistukseen mittakaavassa

Linkki: Lue tästä

Paperin yhteenveto

Paperi tunnustaa konvoluutioarkkitehtuurien hallitsevan aseman tietokonenäössä huolimatta Transformer-arkkitehtuurien menestyksestä luonnollisen kielen käsittelyssä. Muuntajien tehokkuuden ja NLP:n skaalautuvuuden inspiroimana kirjoittajat käyttivät vakiomuuntajaa suoraan kuviin minimaalisilla muutoksilla.

He esittelevät Näön muuntaja (ViT), jossa kuvat on jaettu patcheihin, ja näiden korjaustiedostojen lineaaristen upotusten sekvenssi toimii syötteenä Transformerille. Malli koulutetaan kuvien luokittelutehtäviin ohjatulla tavalla. Aluksi, kun ViT harjoitetaan keskikokoisilla tietojoukoilla, kuten ImageNetillä, ilman vahvaa regularisointia, se saavuttaa tarkkuuden, joka on hieman alle vertailukelpoisen ResNets.

Kirjoittajat paljastavat kuitenkin, että laajamittainen koulutus on ViT:n menestyksen kannalta ratkaisevaa, ja se ylittää tiettyjen induktiivisten harhojen puuttumisen aiheuttamat rajoitukset. Kun ViT on esikoulutettu massiivisiin tietokokonaisuuksiin, se ylittää huippuluokan konvoluutioverkot useissa vertailuissa, mukaan lukien ImageNet, CIFAR-100 ja VTAB. Paperi korostaa skaalauksen vaikutusta merkittävien tulosten saavuttamiseen Transformer-arkkitehtuurien avulla tietokonenäön alalla.

Tärkeimmät näkemykset AI-papereista GenAI-kehittäjille

- Muuntaja Computer Visionissa

Paperi haastaa vallitsevan riippuvuuden konvoluutiohermoverkkoihin (CNN) tietokonenäkötehtävissä. Se osoittaa, että puhdas muuntaja voi saavuttaa erinomaisen suorituskyvyn kuvan luokittelutehtävissä, kun sitä käytetään suoraan kuvapäivityssarjoihin.

- Näön muuntaja (ViT)

Kirjoittajat esittelevät Vision Transformerin (ViT), mallin, joka hyödyntää NLP:n Transformersin kaltaisia itsetarkkailumekanismeja. ViT voi saavuttaa kilpailukykyisiä tuloksia erilaisilla kuvantunnistuksen vertailuarvoilla, mukaan lukien ImageNet, CIFAR-100 ja VTAB.

- Esikoulutus ja siirtooppiminen

Paperi korostaa, että on tärkeää harjoitella esikoulutusta suurille tietomäärille NLP:n tapaan ja siirtää sitten opitut esitykset tiettyihin kuvantunnistustehtäviin. Kun ViT on esikoulutettu massiivisiin tietokokonaisuuksiin, kuten ImageNet-21k tai JFT-300M, se ylittää huippuluokan konvoluutioverkot useissa vertailuissa.

- Laskennallinen tehokkuusViT saavuttaa huomattavia tuloksia huomattavasti pienemmällä laskentaresurssilla koulutuksen aikana kuin huippuluokan konvoluutioverkkoja. Tämä tehokkuus on erityisen merkittävää, kun mallia on esikoulutettu suuressa mittakaavassa.

- Skaalausvaikutus

Paperi korostaa skaalauksen merkitystä ylivertaisen suorituskyvyn saavuttamisessa Transformer-arkkitehtuurien avulla tietokonenäössä. Laajamittainen koulutus miljoonista satoihin miljooniin kuviin sisältävissä tietosarjoissa auttaa ViT:tä voittamaan joidenkin CNN-verkkojen induktiivisten harhojen puutteen.

Paperi 7: AlphaFold2: Erittäin tarkka proteiinirakenne AlphaFoldilla

Linkki: Lue tästä

Paperin yhteenveto

Paperi "AlphaFold2: Erittäin tarkka proteiinirakenne AlphaFoldilla" esittelee AlphaFold2:n, syvän oppimismallin, joka ennustaa tarkasti proteiinirakenteet. AlphaFold2 hyödyntää uutta huomioon perustuvaa arkkitehtuuria ja saavuttaa läpimurron proteiinien laskostuksessa.

Tärkeimmät näkemykset AI-papereista GenAI-kehittäjille

- AlphaFold2 käyttää syvää hermoverkkoa huomiomekanismeineen ennustaakseen proteiinien 3D-rakenteen niiden aminohapposekvensseistä.

- Malli koulutettiin suurelle tietojoukolle tunnettuja proteiinirakenteita, ja se saavutti ennennäkemättömän tarkkuuden 14. proteiinirakenteen ennustamisen kriittisessä arvioinnissa (CASP14) -proteiinin laskostumiskilpailussa.

- AlphaFold2:n tarkat ennusteet voivat mahdollisesti mullistaa lääkekehityksen, proteiinitekniikan ja muut biokemian alueet.

Paperi 8: GAN:t: Generatiiviset vastavuoroiset verkot

Linkki: Lue tästä

Paperin yhteenveto

Paperi käsittelee syvien generatiivisten mallien koulutuksen haasteita ja esittelee innovatiivisen lähestymistavan, jota kutsutaan adversariaaliverkoiksi. Tässä kehyksessä generatiiviset ja erottelevat mallit osallistuvat peliin, jossa generatiivisen mallin tavoitteena on tuottaa näytteitä, joita ei voi erottaa todellisesta tiedosta. Sitä vastoin erotteleva malli erottaa todelliset ja generoidut näytteet. Vastakkainen koulutusprosessi johtaa ainutlaatuiseen ratkaisuun, jossa generatiivinen malli palauttaa tiedon jakelun.

Tärkeimmät näkemykset AI-papereista GenAI-kehittäjille

- Kilpailullinen kehys

Kirjoittajat esittelevät kontradiktorisen kehyksen, jossa kahta mallia opetetaan samanaikaisesti – generatiivisen mallin (G), joka kaappaa tiedon jakautumisen, ja erottelevan mallin (D), joka arvioi todennäköisyyden, että näyte on peräisin koulutustiedoista generatiivisen mallin sijaan.

- Minimax peliHarjoitteluprosessiin kuuluu erottelevan mallin virheen todennäköisyyden maksimointi. Tämä viitekehys on muotoiltu minimax-kahden pelaajan peliksi, jossa generatiivisen mallin tavoitteena on tuottaa näytteitä, joita ei voi erottaa todellisesta tiedosta, ja erotteleva malli pyrkii luokittelemaan, onko näyte todellinen vai oikein generoitu.

- Ainutlaatuinen Ratkaisu

G:n ja D:n mielivaltaisissa funktioissa on ainutlaatuinen ratkaisu, jossa G palauttaa opetusdatan jakauman ja D on yhtä suuri kuin 1/2 kaikkialla. Tämä tasapaino saavutetaan kontradiktorisen harjoittelun kautta.

- Monikerroksiset perceptronit (MLP:t)Kirjoittajat osoittavat, että koko järjestelmää voidaan kouluttaa takaisin leviämisen avulla, kun monikerroksiset perceptronit edustavat G:tä ja D:tä. Tämä eliminoi Markov-ketjujen tai aukirullattujen likimääräisten päättelyverkkojen tarpeen harjoituksen ja näytteiden generoinnin aikana.

- Ei likimääräistä johtopäätöstä

Ehdotetulla viitekehyksellä vältetään vaikeudet, jotka liittyvät vaikeaselkoisten todennäköisyyslaskujen lähentämiseen suurimman todennäköisyyden arvioinnissa. Se myös voittaa haasteet palakohtaisten lineaaristen yksiköiden hyötyjen hyödyntämisessä generatiivisessa kontekstissa.

Paperi 9: RoBERTa: Vankkaasti optimoitu BERT-esikoulutusmenetelmä

Linkki: Lue tästä

Paperin yhteenveto

Paperi käsittelee BERTin alikoulutusongelmaa ja esittelee RoBERTan, optimoidun version, joka ylittää BERT:n suorituskyvyn. RoBERTan koulutusprosessin muutokset ja uuden tietojoukon (CC-NEWS) käyttö edistävät huippuluokan tuloksia useissa luonnollisen kielen käsittelytehtävissä. Tulokset korostavat suunnitteluvalintojen ja koulutusstrategioiden merkitystä kielimallien esikoulutuksen tehokkuudessa. Vapautetut resurssit, mukaan lukien RoBERTa-malli ja koodi, edistävät tutkimusyhteisöä.

Tärkeimmät näkemykset AI-papereista GenAI-kehittäjille

- BERT-koulutus

Kirjoittajat huomaavat sen BERTI, laajalti käytetty kielimalli, oli huomattavasti alikoulutettu. Arvioimalla huolellisesti hyperparametrien virityksen ja harjoitusjoukon koon vaikutusta he osoittavat, että BERT:tä voidaan parantaa vastaamaan tai ylittämään kaikkien sen jälkeen julkaistujen mallien suorituskyvyn.

- Parannettu koulutusresepti (RoBERTa)

Kirjoittajat tekevät muutoksia BERT-koulutusmenettelyyn, jolloin saadaan RoBERTa. Nämä muutokset sisältävät pidennettyjä koulutusjaksoja suuremmilla erillä, seuraavan lauseen ennustustavoitteen poistamisen, pidempien sekvenssien harjoittamisen ja koulutustietojen dynaamisten maskauskuvioiden säädöt.

- Tietojoukon panosPaperi esittelee uuden aineiston nimeltä CC-NEWS, joka on kooltaan verrattavissa muihin yksityisesti käytettyihin tietokokonaisuuksiin. Tämän tietojoukon sisällyttäminen auttaa hallitsemaan paremmin harjoitusjoukon koon vaikutuksia ja parantaa suorituskykyä loppupään tehtävissä.

- Suorituskykysaavutukset

RoBERTa saavuttaa ehdotetuilla muutoksilla huippuluokan tuloksia erilaisissa vertailutehtävissä, mukaan lukien GLUE, RACE ja SQuAD. Se vastaa tai ylittää kaikkien BERT:n jälkeisten menetelmien suorituskyvyn sellaisissa tehtävissä kuin MNLI, QNLI, RTE, STS-B, SQuAD ja RACE.

- Naamiokielimallin esikoulutuksen kilpailukyky

Paperi vahvistaa, että naamioitu kielimallin esikoulutustavoite oikeilla suunnitteluvalinnoilla on kilpailukykyinen muiden äskettäin ehdotettujen koulutustavoitteiden kanssa.

- Julkaistut resurssit

Kirjoittajat julkaisevat RoBERTa-mallinsa sekä PyTorchiin toteutetun esikoulutus- ja hienosäätökoodin, mikä edistää tulosten toistettavuutta ja lisätutkimusta.

Lue myös: Hellävarainen johdatus RoBERTaan

Paperi 10: NeRF: Kohtausten esittäminen hermosäteilykenttinä näkymän synteesiä varten

Linkki: Lue tästä

Paperin yhteenveto

Optimointi sisältää virheen minimoimisen tunnetuilla kameran asennoilla havaittujen kuvien ja jatkuvasta näkymän esityksestä hahmonnettujen näkymien välillä. Paperi käsittelee konvergenssiin ja tehokkuuteen liittyviä haasteita ottamalla käyttöön paikkakoodauksen käsittelemään korkeamman taajuuden toimintoja ja ehdottamalla hierarkkista näytteenottomenettelyä vähentämään riittävän näytteistyksen edellyttämien kyselyiden määrää.

Tärkeimmät näkemykset AI-papereista GenAI-kehittäjille

- Jatkuva kohtauksen esitys

Artikkelissa esitellään menetelmä monimutkaisten kohtausten esittämiseksi 5D-hermosäteilykenttinä käyttämällä perusmonikerroksisia perceptroniverkkoja (MLP).

- Erotettava renderöinti

Ehdotettu renderöintimenettely perustuu klassisiin tilavuusrenderöintitekniikoihin, mikä mahdollistaa gradienttipohjaisen optimoinnin käyttämällä tavallisia RGB-kuvia.

- Hierarkkinen otantastrategia

Hierarkkinen näytteenottostrategia otetaan käyttöön MLP-kapasiteetin optimoimiseksi alueille, joilla on näkyvää kohtaussisältöä, mikä ratkaisee lähentymisongelmia.

- PaikannuskoodausPaikkakoodauksen käyttäminen syötettävien 5D-koordinaattien kartoittamiseen korkeampiulotteiseen tilaan mahdollistaa hermosäteilykenttien onnistuneen optimoinnin korkeataajuista kohtaussisältöä varten.

Ehdotettu menetelmä ylittää nykyaikaiset synteesimenetelmät, mukaan lukien hermosolujen 3D-esitysten sovittaminen ja syvien konvoluutioverkkojen koulutus. Tässä artikkelissa esitellään jatkuva hermokohtausesitys korkearesoluutioisten fotorealististen uusien näkymien renderöimiseksi RGB-kuvista luonnollisissa olosuhteissa, ja lisävertailuja esitellään lisävideossa korostaakseen sen tehokkuutta monimutkaisen kohtauksen geometrian ja ulkonäön käsittelyssä.

Paperi 11: FunSearch: Matemaattisia löytöjä ohjelmahausta suurilla kielimalleilla

Linkki: Lue tästä

Paperin yhteenveto

Paperi esittelee FunSearchin, uudenlaisen lähestymistavan Large Language Models (LLM) hyödyntämiseen monimutkaisten ongelmien ratkaisemiseksi, erityisesti tieteellisessä löydössä. Ensisijainen haaste on konfabulaatioiden (hallusinaatioiden) esiintyminen LLM:issä, jotka johtavat uskottaviin, mutta vääriin lausuntoihin. FunSearch yhdistää valmiiksi koulutetun LLM:n ja systemaattisen arvioijan evoluutioprosessissa tämän rajoituksen voittamiseksi.

Tärkeimmät näkemykset AI-papereista GenAI-kehittäjille

- Ongelmanratkaisu LLM:ien kanssa

Paperi käsittelee kysymystä LLM:istä, jotka sekoittuvat tai eivät pysty luomaan uusia ideoita ja oikeita ratkaisuja monimutkaisiin ongelmiin. Se korostaa uusien, todistetusti oikeiden ideoiden löytämisen tärkeyttä erityisesti matemaattisiin ja tieteellisiin haasteisiin.

- Evoluutioprosessi – FunSearch

FunSearch yhdistää valmiiksi koulutetun LLM:n ja arvioijan evoluutioprosessissa. Se kehittää iteratiivisesti alhaisen pistemäärän saaneita ohjelmia korkean pistemäärän saaviksi ohjelmiksi, mikä varmistaa uuden tiedon löytämisen. Prosessi sisältää parhaan mahdollisen kehotteen, ohjelmarunkojen kehittämisen, ohjelmien monimuotoisuuden ylläpitämisen ja asynkronisen skaalauksen.

- Sovellus Extremal Combinatoriicsiin

Paperi osoittaa FunSearchin tehokkuuden äärimmäisen kombinatoriikan cap-joukkoongelmaan. FunSearch löytää uusia rakennelmia suurikokoisista sarjoista, jotka ylittävät tunnetuimmat tulokset ja tarjoavat suurimman parannuksen 20 vuoteen asymptoottiseen alarajaan.

- Algoritminen ongelma – Online Bin Packing

FunSearchia sovelletaan verkkojätteiden pakkausongelmaan, mikä johtaa uusien algoritmien löytämiseen, jotka toimivat perinteisiä paremmin hyvin tutkituissa kiinnostavissa jakaumissa. Mahdollisia sovelluksia ovat työn ajoitusalgoritmien parantaminen.

- Ohjelmat vs. ratkaisutFunSearch keskittyy luomaan ohjelmia, jotka kuvaavat ongelman ratkaisemista sen sijaan, että tuottaisivat suoraan ratkaisuja. Nämä ohjelmat ovat yleensä paremmin tulkittavissa, helpottavat vuorovaikutusta toimialueen asiantuntijoiden kanssa ja ovat helpompia ottaa käyttöön kuin muun tyyppiset kuvaukset, kuten hermoverkot.

- Tieteidenvälinen vaikutus

FunSearchin metodologia mahdollistaa monenlaisten ongelmien tutkimisen, mikä tekee siitä monipuolisen lähestymistavan monitieteisissä sovelluksissa. Paperi korostaa sen mahdollisuuksia tehdä todennettavia tieteellisiä löytöjä LLM:ien avulla.

Paperi 12: VAE: Auto-Encoding Variational Bayes

Linkki: Lue tästä

Paperin yhteenveto

"Auto-Encoding Variational Bayes" -paperi käsittelee tehokkaan päättelyn ja oppimisen haastetta suunnatuissa todennäköisyysmalleissa, joissa on jatkuvia piileviä muuttujia, varsinkin kun posteriorijakaumat ovat käsittämättömiä ja käsittelevät suuria tietojoukkoja. Kirjoittajat ehdottavat stokastista variaatiopäätelmää ja oppimisalgoritmia, joka skaalautuu hyvin suurille tietojoukoille ja pysyy käyttökelpoisena jopa vaikeaselkoisissa jälkijakaumissa.

Tärkeimmät näkemykset AI-papereista GenAI-kehittäjille

- Variational Lower Boundin uudelleenparametrisointi

Paperi osoittaa vaihtelun alarajan uudelleenparametrisoinnin, mikä johtaa alarajan estimaattoriin. Tämä estimaattori voidaan optimoida käyttämällä tavallisia stokastisia gradienttimenetelmiä, mikä tekee siitä laskennallisesti tehokkaan.

- Tehokas posteriorinen päättely jatkuville piileville muuttujilleKirjoittajat ehdottavat Auto-Encoding VB (AEVB) -algoritmia tietojoukoille, joissa on jatkuvia piileviä muuttujia datapistettä kohti. Tämä algoritmi käyttää SGVB (Stochastic Gradient Variational Bayes) -estimaattoria tunnistusmallin optimointiin, mikä mahdollistaa tehokkaan likimääräisen posteriorisen päättelyn esi-isien näytteenoton avulla. Tämä lähestymistapa välttää kalliit iteratiiviset johtopäätökset, kuten Markov Chain Monte Carlo (MCMC) jokaiselle datapisteelle.

- Teoreettiset edut ja kokeelliset tulokset

Ehdotetun menetelmän teoreettiset edut näkyvät koetuloksissa. Artikkelissa ehdotetaan, että uudelleenparametrointi- ja tunnistusmalli johtaa laskennalliseen tehokkuuteen ja skaalautumiseen, mikä tekee lähestymistavasta soveltuvan suurille tietokokonaisuuksille ja tilanteissa, joissa jälkikäteen on vaikea käsitellä.

Lue myös: Stokastisen olemuksen paljastaminen koneoppimisessa

Paperi 13: PITKÄ LYHYTAIKAINEN MUISTIO

Linkki: Lue tästä

Paperin yhteenveto

Paperi käsittelee haastetta oppia tallentamaan tietoa pitkiä aikavälejä toistuviin hermoverkkoihin. Se esittelee uuden, tehokkaan gradienttipohjaisen menetelmän nimeltä "Long Short-Term Memory" (LSTM), joka ratkaisee riittämättömät ja heikkenevät virheen takaisinvirtausongelmat. LSTM pakottaa jatkuvan virhevirran "jatkuvien virhekarusellien" kautta ja käyttää multiplikatiivisia porttiyksiköitä pääsyn hallintaan. Paikallisella aika-avaruus-kompleksisuudella (O(1) aikaaskelta ja painoa kohti) kokeelliset tulokset osoittavat, että LSTM ylittää olemassa olevat algoritmit oppimisnopeuden ja onnistumisasteen suhteen, erityisesti tehtävissä, joissa on pitkiä viiveitä.

Tärkeimmät näkemykset AI-papereista GenAI-kehittäjille

- Ongelman analysointi

Paperi tarjoaa yksityiskohtaisen analyysin haasteista, jotka liittyvät virheiden takaisinvirtaukseen toistuvissa hermoverkoissa, ja tuovat esiin ongelmat, jotka liittyvät virhesignaalien joko räjähtämiseen tai katoamiseen ajan myötä.

- LSTM:n esittely

Kirjoittajat esittelevät LSTM:n uudenlaisena arkkitehtuurina, joka on suunniteltu käsittelemään katoavien ja räjähtävien virhesignaalien ongelmia. LSTM sisältää jatkuvan virhevirran erikoisyksiköiden läpi ja käyttää multiplikatiivisia porttiyksiköitä säätelemään pääsyä tähän virhevirtaan.

- Kokeelliset tulokset

Keinotekoisilla tiedoilla tehtyjen kokeiden avulla paperi osoittaa, että LSTM ylittää muut toistuvat verkkoalgoritmit, mukaan lukien BPTT, RTRL, toistuva kaskadikorrelaatio, Elman-verkot ja hermosekvenssin chunking. LSTM osoittaa nopeampaa oppimista ja korkeampia onnistumisprosentteja erityisesti monimutkaisten tehtävien ratkaisemisessa pitkillä viiveillä.

- Paikallinen tilassa ja ajassa

LSTM:ää kuvataan paikalliseksi arkkitehtuuriksi avaruudessa ja ajassa, jossa laskennallinen monimutkaisuus aikavaihetta ja painoa kohti on O(1).

- sovellettavuus

Ehdotettu LSTM-arkkitehtuuri ratkaisee tehokkaasti monimutkaisia, keinotekoisia pitkän viiveen tehtäviä, joita aiemmat toistuvat verkkoalgoritmit eivät ole onnistuneet käsittelemään.

- Rajoitukset ja edut

Paperi käsittelee LSTM:n rajoituksia ja etuja ja antaa näkemyksiä ehdotetun arkkitehtuurin käytännön soveltuvuudesta.

Lue myös: Mikä on LSTM? Johdatus pitkäkestoiseen lyhytaikaiseen muistiin

Paperi 14: Siirrettävien visuaalisten mallien oppiminen luonnollisen kielen valvonnasta

Linkki: Lue tästä

Paperin yhteenveto

Paperi tutkii huippuluokan tietokonenäköjärjestelmien koulutusta oppimalla suoraan kuvista käsittelevästä raakatekstistä sen sijaan, että luottaisivat ennalta määrättyjen objektiluokkien kiinteisiin sarjoihin. Kirjoittajat ehdottavat koulutusta edeltävää tehtävää ennustaa, mikä kuvateksti vastaa tiettyä kuvaa käyttämällä 400 miljoonan (kuva, teksti) parin tietojoukkoa, joka on kerätty Internetistä. Tuloksena oleva malli CLIP (Contrastive Language-Image Pre-training) osoittaa tehokkaan ja skaalautuvan kuvaesitysten oppimisen. Esiharjoittelun jälkeen luonnollinen kieli viittaa visuaalisiin käsitteisiin, mikä mahdollistaa nollakuvan siirron erilaisiin jatkotehtäviin. CLIP on benchmark yli 30 tietokonenäkötietojoukossa, jotka osoittavat kilpailukykyisen suorituskyvyn ilman tehtäväkohtaista koulutusta.

Tärkeimmät näkemykset AI-papereista GenAI-kehittäjille

- Tietokonenäön luonnollisen kielen koulutus

Paperi tutkii luonnollisen kielen valvonnan käyttöä tietokonenäkömallien kouluttamisessa perinteisen koulutusmenetelmän sijaan joukkomerkityissä tietojoukoissa, kuten ImageNetissä.

- EsikoulutustehtäväKirjoittajat ehdottavat yksinkertaista esikoulutustehtävää: ennustaa, mikä kuvateksti vastaa tiettyä kuvaa. Tätä tehtävää käytetään uusimpien kuvien esitysten oppimiseen alusta alkaen valtavasta 400 miljoonan (kuva, teksti) parin tietojoukosta, joka on kerätty verkossa.

- Zero-Shot siirto

Esiopetuksen jälkeen mallissa käytetään luonnollista kieltä viittaamaan opittuihin visuaalisiin käsitteisiin tai kuvailemaan uusia. Tämä mahdollistaa mallin nollakuvan siirron loppupään tehtäviin ilman erityistä tietojoukkokoulutusta.

- Vertailuanalyysi eri tehtävistä

Paperi arvioi ehdotetun lähestymistavan suorituskykyä yli 30 eri tietokonenäkötietojoukossa, jotka kattavat tehtäviä, kuten OCR, toimintojen tunnistus videoissa, geolokalisointi ja hienorakeinen objektiluokittelu.

- Kilpailukykyinen suorituskyky

Malli osoittaa kilpailukykyisen suorituskyvyn täysin valvotuilla lähtötasoilla erilaisissa tehtävissä, jotka usein vastaavat tai ylittävät tehtäväkohtaisilla tietojoukoilla koulutettujen mallien tarkkuuden ilman ylimääräistä tietojoukkokohtaista koulutusta.

- Skaalautuvuustutkimus

Kirjoittajat tutkivat lähestymistapansa skaalautuvuutta kouluttamalla kahdeksan mallin sarjaa, joissa on eri tasoisia laskennallisia resursseja. Siirron suorituskyvyn on havaittu olevan sujuvasti ennustettavissa oleva laskennan funktio.

- Mallin kestävyys

Artikkelissa korostetaan, että nollakuvan CLIP-mallit ovat vankempia kuin vastaavan tarkkuuden valvotut ImageNet-mallit, mikä viittaa siihen, että tehtäväagnostisten mallien nollakuvan arviointi tarjoaa edustavamman mittarin mallin kyvystä.

Paperi 15: LORA: SUURIKIELIMALLIEN MATALAKÄYTTÖ

Linkki: Lue tästä

Paperin yhteenveto

Artikkelissa ehdotetaan LoRA:ta tehokkaaksi menetelmäksi suurten esikoulutettujen kielimallien mukauttamiseen tiettyihin tehtäviin ja vastataan niiden kasvavaan kokoon liittyviin käyttöönottohaasteisiin. Menetelmä vähentää huomattavasti koulutettavia parametreja ja grafiikkasuorittimen muistivaatimuksia samalla, kun se säilyttää tai parantaa mallin laatua eri vertailuarvoissa. Avoimen lähdekoodin toteutus helpottaa entisestään LoRA:n käyttöönottoa käytännön sovelluksissa.

Tärkeimmät näkemykset AI-papereista GenAI-kehittäjille

1. Ongelmalausunto

- Laajamittainen esikoulutus, jota seuraa hienosäätö on yleinen lähestymistapa luonnollisen kielen käsittelyyn.

- Hienosäätäminen käy vähemmän mahdolliseksi mallien kasvaessa, erityisesti käytettäessä malleja, joilla on massiiviset parametrit, kuten GPT-3 (175 miljardia parametria).

2. Ehdotettu ratkaisu: Low-Rank Adaptation (LoRA)

- Paperi esittelee LoRA:n, menetelmän, joka jäädyttää esiopetetut mallipainot ja tuo koulutettavat rank-hajotelumatriisit jokaiseen Transformer-arkkitehtuurin kerrokseen.

- LoRA vähentää merkittävästi koulutettavien parametrien määrää loppupään tehtäviin verrattuna täydelliseen hienosäätöön.

3. LoRA:n edut

- Parametrien vähentäminen: Hienosäätöön verrattuna LoRA voi vähentää opetettavien parametrien määrää jopa 10,000 XNUMX kertaa, mikä tekee siitä laskennallisesti tehokkaamman.

- Muistin tehokkuus: LoRA vähentää GPU-muistin vaatimuksia jopa 3 kertaa hienosäätöön verrattuna.

- Mallin laatu: Huolimatta siitä, että LoRA:lla on vähemmän harjoitettavia parametreja, se toimii mallinlaadun osalta samaan aikaan tai paremmin kuin hienosäätö eri malleissa, mukaan lukien RoBERTa, DeBERTa, GPT-2 ja GPT-3.

4. Käyttöönoton haasteiden voittaminen

- Paperi käsittelee useiden parametrien mallien käyttöönoton haastetta ottamalla käyttöön LoRA:n, joka mahdollistaa tehokkaan tehtävien vaihdon ilman koko mallin uudelleenkoulutusta.

5. Tehokkuus ja alhainen päättelyviive

- LoRA helpottaa valmiiksi koulutetun mallin jakamista useiden LoRA-moduulien rakentamiseen eri tehtäviin, mikä vähentää tallennusvaatimuksia ja tehtävien vaihtamisen yleiskustannuksia.

- Koulutus tehostuu ja alentaa laitteiston estettä jopa 3 kertaa adaptiivisia optimoijia käytettäessä.

6. Yhteensopivuus ja integrointi

- LoRA on yhteensopiva useiden aikaisempien menetelmien kanssa ja voidaan yhdistää niihin, kuten etuliitteen viritykseen.

- Ehdotettu lineaarinen rakenne mahdollistaa koulutettavien matriisien yhdistämisen jäädytettyihin painoihin käyttöönoton aikana, mikä ei tuota ylimääräistä päättelyviivettä täysin hienosäädetyihin malleihin verrattuna.

7. Empiirinen tutkimus

- Artikkeli sisältää empiirisen tutkimuksen kielimallien mukauttamisen ranking-puutteista, mikä antaa näkemyksiä LoRA-lähestymistavan tehokkuudesta.

8. Avoimen lähdekoodin toteutus

- Kirjoittajat tarjoavat paketin, joka helpottaa LoRA:n integrointia PyTorch-malleihin ja julkaisutoteutuksiin ja mallien tarkistuspisteisiin RoBERTalle, DeBERTalle ja GPT-2:lle.

Voit myös lukea: Parametritehokas suurten kielimallien hienosäätö LoRA:lla ja QLoRA:lla

Yhteenveto

Yhteenvetona voidaan todeta, että tässä artikkelissa korostettuihin 15 olennaiseen GenAI-kehittäjien tekoälypaperiin tutustuminen ei ole vain suositus, vaan strateginen välttämättömyys kaikille pyrkiville kehittäjille. Nämä tekoälypaperit tarjoavat kattavan matkan tekoälyn monimuotoisen maiseman halki, ja ne kattavat kriittiset osa-alueet, kuten luonnollisen kielen käsittelyn, tietokonenäön ja sen pidemmät. Uppoutumalla näissä papereissa esitettyihin oivalluksiin ja innovaatioihin kehittäjät saavat syvällisen ymmärryksen alan huippuluokan tekniikoista ja algoritmeista.

liittyvä

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- PlatonHealth. Biotekniikan ja kliinisten kokeiden älykkyys. Pääsy tästä.

- Lähde: https://www.analyticsvidhya.com/blog/2024/01/essential-ai-papers-every-gen-ai-developer-must-read/

- :on

- :On

- :ei

- :missä

- $ YLÖS

- 000

- 1

- 10

- 11

- 12

- 13

- 14

- 15%

- 17

- 20

- 20 vuotta

- 2014

- 2017

- 28

- 30

- 3d

- 400

- 41

- 60

- 7

- 8

- 9

- 913

- a

- kyky

- Meistä

- AC

- pääsy

- tarkkuus

- tarkka

- tarkasti

- Saavuttaa

- saavutettu

- päästään

- saavuttamisessa

- poikki

- Toiminta

- sovitus

- mukautuva

- lisä-

- Lisäksi

- osoite

- osoitettu

- osoitteet

- käsitellään

- oikaisut

- Hyväksyminen

- edistysaskeleet

- Etu

- etuja

- kontradiktorisen

- Jälkeen

- eteenpäin

- AI

- tavoitteet

- AL

- algoritmi

- algoritmit

- Kaikki

- sallia

- Salliminen

- mahdollistaa

- pitkin

- Myös

- määrät

- an

- analyysi

- ja

- Kaikki

- sovelletaan

- Hakemus

- sovellukset

- sovellettu

- sovelletaan

- käyttää

- Hakeminen

- lähestymistapa

- lähestymistavat

- lähentää

- arkkitehtuuri

- OVAT

- alueet

- kiistellä

- nousta

- artikkeli

- artikkelit

- keinotekoinen

- tekoäly

- Tekoäly (AI)

- AS

- kunnianhimoinen

- arviointi

- liittyvä

- At

- käydä

- huomio

- Tekijät

- este

- perustua

- perustiedot

- BE

- tulee

- ovat

- alle

- benchmark

- vertailuanalyysi

- Viitearvot

- Hyödyt

- PARAS

- Paremmin

- välillä

- Jälkeen

- harhat

- Miljardi

- BIN

- edistää

- sekä

- sidottu

- läpimurto

- läpimurtoja

- laajempaa

- Rakentaminen

- rakennettu

- mutta

- by

- nimeltään

- tuli

- kamera

- CAN

- ehdokkaat

- korkki

- kyvyt

- valmiudet

- Koko

- kaapata

- kaappaa

- huolellisesti

- vesiputouksia

- luokat

- tietty

- ketju

- kahleet

- haaste

- haasteet

- haastava

- mahdollisuudet

- Muutokset

- valintoja

- luokat

- luokittelu

- luokitella

- CNN

- koodi

- yhdistetty

- yhdistää

- Yhteinen

- yhteisö

- vertailukelpoinen

- verrattuna

- vertailuja

- yhteensopiva

- pätevä

- kilpailu

- Kilpailut

- kilpailukykyinen

- kilpailukykyä

- täysin

- monimutkainen

- monimutkaisuus

- kattava

- laskeminen

- laskennallinen

- laskelmat

- tietokone

- Tietokoneen visio

- tietojenkäsittely

- käsitteet

- huolenaiheet

- johtopäätös

- kytkeä

- kytketty

- Harkita

- harkittu

- muodostuu

- vakio

- pitoisuus

- kilpailu

- tausta

- jatkuu

- jatkuva

- kontrasti

- edistävät

- vaikuttaa omalta

- edistää

- maksut

- ohjaus

- Lähentyminen

- konvoluutiohermoverkko

- korjata

- oikein

- Korrelaatio

- vastaa

- kallis

- kattaa

- päällyste

- kriittinen

- ratkaiseva

- Nykyinen

- käyrä

- leikkaamisreuna

- tiedot

- aineistot

- päivää

- tekemisissä

- päätökset

- vähenee

- syvä

- syvä oppiminen

- syvä hermoverkko

- syvempää

- vaatii

- osoittaa

- osoittaa

- esittelyssä

- riippua

- riippuvuudet

- sijoittaa

- levityspinnalta

- käyttöönotto

- kuvata

- on kuvattu

- kuvailee

- Malli

- suunniteltu

- Huolimatta

- yksityiskohtainen

- Kehittäjä

- kehittäjille

- kehittämällä

- eri

- vaikea

- vaikeudet

- suunnattu

- suoraan

- huomaa

- löytö

- etäisyys

- erottaa

- erotetaan

- jakelu

- Jakaumat

- useat

- Monimuotoisuus

- do

- verkkotunnuksen

- verkkotunnuksia

- Valta-asema

- huume

- lääkekehityksen

- aikana

- dynaaminen

- E&T

- kukin

- helpompaa

- Tehokas

- tehokkaasti

- tehokkuuden

- vaikutukset

- tehokkuus

- tehokkuus

- tehokas

- kahdeksan

- myöskään

- elementtejä

- yksitoista

- eliminoi

- poistamalla

- painottaa

- painottaa

- työnantajat

- työllistää

- mahdollistaa

- mahdollistaa

- mahdollistaa

- koodaus

- sitoutua

- Tekniikka

- Englanti

- parantaa

- parannuksia

- Parantaa

- varmistamalla

- Koko

- täysin

- merkintä

- yhtäläinen

- Tasapaino

- Vastaava

- virhe

- erityisesti

- ydin

- olennainen

- vakiintunut

- laatii

- arviot

- Eetteri (ETH)

- arviointiin

- arviointi

- Jopa

- kaikkialla

- kehittää

- kehittyy

- kehittyvä

- Esimerkit

- ylittää

- ylittää

- erinomainen

- jännittävä

- Näytteillä

- olemassa

- olemassa

- Laajentaa

- kallis

- kokeellinen

- kokeiluja

- asiantuntijat

- tutkimus

- tutkia

- Tutkii

- Tutkiminen

- laajennettu

- Helpottaa

- helpottaminen

- ei ole

- tuttu

- nopeampi

- mahdollinen

- Ominaisuudet

- harvat

- vähemmän

- ala

- Fields

- suodattimet

- lopullinen

- Löytää

- löytäminen

- tulokset

- Etunimi

- asennus

- viisi

- kiinteä

- virtaus

- keskittyy

- tarkennus

- seurannut

- varten

- löytyi

- neljä

- Puitteet

- Taajuus

- alkaen

- jäädytetty

- koko

- täysin

- toiminto

- tehtävät

- edelleen

- Saada

- voitto

- peli

- GAN

- portti

- genai

- tuottaa

- syntyy

- tuottaa

- generatiivinen

- generatiivinen malli

- lempeä

- geometria

- tietty

- Antaminen

- Global

- GPU

- GPU

- kaavio

- kuvaaja hermoverkot

- kaaviot

- Kasvaa

- kahva

- Käsittely

- Palvelimet

- ottaa

- auttaa

- hierarkkinen

- Korkea

- Korkeataajuus

- korkea resoluutio

- korkeampi

- Korostaa

- Korostettu

- korostus

- raidat

- erittäin

- Miten

- Miten

- HTTPS

- ihmisen

- Ihmiset

- Sadat

- satoja miljoonia

- Hyperparametrien viritys

- ideoita

- tunnistaa

- kuva

- Kuvaluokitus

- Kuvan tunnistus

- IMAGEnet

- kuvien

- Vaikutus

- Vaikutukset

- imperatiivi

- täytäntöönpano

- toteutukset

- täytäntöön

- vaikutukset

- merkitys

- tärkeä

- määrätty

- parani

- parannus

- parannuksia

- parantaa

- parantaminen

- in

- sisältää

- sisältää

- Mukaan lukien

- sisällyttää

- sisältää

- Kasvaa

- kasvoi

- lisää

- yhä useammin

- ilmaisee

- tiedot

- tietoa

- ensin

- innovaatiot

- innovatiivinen

- panos

- oivalluksia

- innoittamana

- esimerkki

- sen sijaan

- ohjeet

- integraatio

- Älykkyys

- voimakas

- vuorovaikutus

- vuorovaikutukset

- korko

- Internet

- tulee

- esitellä

- käyttöön

- Esittelee

- käyttöön

- esittely

- tutkimus

- aiheuttaa

- liittyy

- kysymys

- kysymykset

- IT

- SEN

- Job

- Työpaikat

- matka

- jpg

- tuntemus

- tunnettu

- Lack

- lasku

- Landschaft

- Kieli

- suuri

- laaja

- suurempi

- suurin

- Viive

- uusin

- kerros

- kerrokset

- johtava

- Liidit

- OPPIA

- oppinut

- oppiminen

- vähemmän

- tasot

- Vaikutusvalta

- vipusuhteita

- vipuvaikutuksen

- pitää

- todennäköisyys

- rajoitus

- rajoitukset

- rajallinen

- paikallinen

- Pitkät

- pitkä aika

- katso

- Matala

- alentaa

- alentamalla

- kone

- konekäännös

- tehty

- ylläpitäminen

- merkittävä

- tehdä

- Tekeminen

- tapa

- monet

- kartta

- Marginaali

- massiivinen

- ottelu

- tulitikut

- matching

- matemaattinen

- Matriisi

- max-width

- maksimointi

- maksimi

- mitata

- mekanismit

- Muisti

- vain

- sulautuvan

- menetelmä

- menetelmiä

- Metodologia

- menetelmät

- miljoona

- miljoonia

- minimi

- minimointia

- virhe

- malli

- mallit

- Muutokset

- Moduulit

- lisää

- tehokkaampi

- Lisäksi

- eniten

- moninkertainen

- täytyy

- Täytyy lukea

- Luonnollinen

- Luonnollinen kieli

- Luonnollinen kielen käsittely

- luonto

- Tarve

- tarvitaan

- tarpeet

- Nerf

- verkot

- verkko

- verkot

- hermo-

- neuroverkkomallien

- hermoverkkoihin

- NeurIPS

- neuronien

- Uusi

- uutiset

- seuraava

- NLP

- Nro

- solmu

- solmut

- merkittävä

- huomata

- Huomautuksia

- romaani

- numero

- objekti

- tavoite

- tavoitteet

- Havaittu

- esiintyminen

- OCR

- of

- kampanja

- Tarjoukset

- usein

- on

- ONE

- yhdet

- verkossa

- vain

- avoimen lähdekoodin

- toiminta

- Operations

- optimointi

- Optimoida

- optimoitu

- or

- Muut

- suoriutua paremmin kuin

- parempia

- päihittää

- ulostulo

- ulkopuolella

- yli

- Voittaa

- voittaminen

- yleiskatsaus

- paketti

- paria

- Pankaj

- Paperi

- paperit

- Parallel

- parametri

- parametrit

- erityinen

- erityisesti

- Merkit

- Kuvio

- varten

- suorittaa

- suorituskyky

- suorittaa

- aikoja

- fotorealistisia

- Platon

- Platonin tietotieto

- PlatonData

- uskottava

- Kohta

- aiheuttaa

- mahdollinen

- mahdollisesti

- voimakas

- Käytännön

- Käytännön sovellukset

- ennustaa

- Ennustettavissa

- ennustamiseen

- ennustus

- Ennusteet

- ennustaa

- esittää

- esitetty

- lahjat

- edellinen

- ensisijainen

- Aikaisempi

- todennäköisyys

- Ongelma

- ongelmia

- menettelyt

- prosessi

- käsittely

- tuottaa

- syvällinen

- Ohjelma

- Ohjelmat

- hankkeet

- ehdottaa

- ehdotettu

- ehdottaa

- ehdotetaan

- Proteiini

- Proteiinit

- todistettu

- osoittautuu

- toimittaa

- tarjoaa

- tarjoamalla

- julkaistu

- pytorch

- laatu

- kyselyt

- Rotu

- alue

- sijoitus

- Hinnat

- pikemminkin

- raaka

- saavutettu

- Lue

- Lukeminen

- vahvistaa uudelleen

- todellinen

- todellinen maailma

- äskettäinen

- äskettäin

- resepti

- tunnustaminen

- Suositus

- toipumassa

- toistuminen

- toistuva

- Rekursiivinen

- vähentää

- Vähentynyt

- vähentää

- vähentämällä

- vähentäminen

- viite

- viittaukset

- heijastunut

- suhteen

- Säännellä

- liittyvä

- Ihmissuhteet

- vapauta

- julkaistu

- riippuvuus

- luottaen

- jäännökset

- huomattava

- sulatettu

- mallinnus

- edustaa

- edustus

- edustaja

- edustavat

- edellyttää

- vaatimus

- vaatimukset

- tutkimus

- tutkimus yhteisön

- Tutkijat

- Esittelymateriaalit

- vastaavasti

- Saatu ja

- tulokset

- uudelleenkoulutus

- paljastaa

- mullistaa

- RGB

- oikein

- Riski

- luja

- skaalautuvuus

- skaalautuva

- Asteikko

- asteikot

- skaalaus

- skenaariot

- kohtaus

- kohtaukset

- aikataulutus

- järjestelmiä

- tieteellinen

- pisteet

- raapia

- Haku

- tuomita

- Järjestys

- Sarjat

- palvelee

- setti

- Setit

- settings

- useat

- Jaa:

- jakaminen

- Lyhytaikainen

- näyttää

- malliesimerkki

- esittelylle

- näyttää

- Näytä

- signaalit

- merkitys

- merkittävä

- merkittävästi

- samankaltainen

- yhtäläisyyksiä

- Yksinkertainen

- samanaikaisesti

- tilanteita

- Koko

- taitava

- sujuvasti

- yhteiskunnallinen

- Yksin

- ratkaisu

- Ratkaisumme

- SOLVE

- Ratkaisee

- Solving

- jonkin verran

- joskus

- Tila

- Tila ja aika

- jännitys

- erikoistunut

- erityinen

- spektri-

- nopeus

- jakaa

- standardi

- huippu-

- lausuntoja

- pysyä

- Vaihe

- Levytila

- verkkokaupasta

- Strateginen

- strategiat

- Strategia

- vahva

- rakenne

- jäsennelty

- rakenteet

- Kamppailut

- tutkimus

- merkittävä

- merkittävästi

- menestys

- onnistunut

- Onnistuneesti

- niin

- Ehdottaa

- sopiva

- esimies

- valvonta

- ylittää

- verraton

- SVG

- synteesi

- järjestelmä

- järjestelmät

- Tehtävä

- tehtävät

- tekniikat

- taipumus

- ehdot

- testi

- teksti

- kuin

- että

- -

- Kaavio

- heidän

- Niitä

- sitten

- teoreettinen

- Nämä

- ne

- tätä

- tuhansia

- kolmella

- Kautta

- aika

- kertaa

- että

- työkalu

- Aiheet

- kohti

- perinteinen

- Juna

- koulutettu

- koulutus

- siirtää

- Siirtäminen

- muuntaja

- muuntajat

- Kääntäminen

- Käännöslaatu

- Trendit

- oppitunti

- kaksi

- tyypit

- alaviivojen

- ymmärtäminen

- unique

- yksiköt

- toisin kuin

- ennennäkemätön

- päivitetty

- Päivitykset

- käyttää

- käytetty

- käyttötarkoituksiin

- käyttämällä

- hyödyntää

- v1

- arvokas

- eri

- todennettavissa

- monipuolinen

- monipuolisuus

- versio

- Video

- Videoita

- Näytä

- näkymät

- näkyvä

- visio

- visiojärjestelmät

- visuaalinen

- Visuaalinen tunnustaminen

- tilavuus

- vs

- oli

- tavalla

- verkko

- paino

- HYVIN

- kun

- onko

- joka

- vaikka

- leveä

- Laaja valikoima

- laajalti

- laajempi

- Laajempi yhteisö

- wikipedia

- tulee

- with

- sisällä

- ilman

- sanoja

- Referenssit

- toimii

- arvoinen

- kirjallinen

- vuotta

- tuottaen

- te

- Sinun

- zephyrnet