تصویر ایجاد شده توسط ویرایشگر با Midjourney

به نسخه این هفته "این هفته در هوش مصنوعی" در KDnuggets خوش آمدید. هدف این پست هفتگی تنظیم شده این است که شما را در جریان قانع کننده ترین پیشرفت ها در دنیای به سرعت در حال پیشرفت هوش مصنوعی قرار دهد. از سرفصلهای پیشگامانه که درک ما از نقش هوش مصنوعی در جامعه را شکل میدهند تا مقالات تفکر برانگیز، منابع یادگیری روشنگر، و تحقیقات برجسته که مرزهای دانش ما را پیش میبرند، این پست یک نمای کلی از چشمانداز فعلی هوش مصنوعی ارائه میدهد. این به روز رسانی هفتگی به گونه ای طراحی شده است که شما را در این زمینه همیشه در حال تکامل به روز و مطلع نگه دارد. با ما همراه باشید و از خواندن لذت ببرید!

در بخش "سرفصل ها" برترین اخبار و تحولات هفته گذشته در زمینه هوش مصنوعی بحث می شود. این اطلاعات از سیاست های هوش مصنوعی دولتی گرفته تا پیشرفت های تکنولوژیکی و نوآوری های شرکتی در هوش مصنوعی را شامل می شود.

OpenAI به دلیل هزینه های بالای اجرای ChatGPT و سایر خدمات هوش مصنوعی با مشکلات مالی مواجه است. با وجود رشد سریع اولیه، پایگاه کاربران ChatGPT در ماه های اخیر کاهش یافته است. OpenAI در تلاش است تا به طور مؤثر از فناوری خود درآمدزایی کند و درآمد پایدار ایجاد کند. در همین حال، با نرخ هشداردهنده ای به نقدینگی خود ادامه می دهد. با داغ شدن رقابت و کمبود GPU سازمانی که مانع توسعه مدل می شود، OpenAI باید فوراً مسیرهایی برای سودآوری پیدا کند. اگر نتواند این کار را انجام دهد، ممکن است ورشکستگی برای استارتاپ پیشگام هوش مصنوعی در آینده باشد.

💡 Stability AI StableCode را معرفی کرد، دستیار کدنویسی AI برای توسعه دهندگان

Stability AI StableCode را منتشر کرده است، اولین محصول هوش مصنوعی مولد خود که برای توسعه نرم افزار بهینه شده است. StableCode چندین مدل آموزش دیده با بیش از 500 میلیارد کد کد را برای ارائه تکمیل خودکار هوشمند، پاسخ به دستورالعملهای زبان طبیعی و مدیریت بازههای طولانی کد ترکیب میکند. در حالی که هوش مصنوعی مکالمه از قبل می تواند کد بنویسد، StableCode به منظور افزایش بهره وری برنامه نویس با درک ساختار کد و وابستگی ها ساخته شده است. StableCode با آموزشهای تخصصی و مدلهایی که میتوانند زمینههای طولانی را مدیریت کنند، قصد دارد گردش کار توسعهدهندگان را بهبود بخشد و مانع ورود کدنویسهای مشتاق را کاهش دهد. این پرتاب نشان دهنده هجوم Stability AI به ابزارهای کدگذاری به کمک هوش مصنوعی در میان رقابت رو به رشد در فضا است.

💡 معرفی Superalignment توسط OpenAI

OpenAI فعالانه در حال کار برای مقابله با خطرات بالقوه ناشی از هوش مصنوعی فوقهوشمند از طریق تیم جدید Superalignment خود است که از تکنیکهایی مانند یادگیری تقویتی از بازخورد انسانی برای تراز کردن سیستمهای هوش مصنوعی استفاده میکند. اهداف کلیدی توسعه روشهای آموزشی مقیاسپذیر با استفاده از سیستمهای هوش مصنوعی دیگر، اعتبارسنجی استحکام مدل، و تست استرس خط لوله همترازی کامل، حتی با مدلهایی که عمداً ناهماهنگ هستند، است. به طور کلی، OpenAI قصد دارد نشان دهد که یادگیری ماشینی میتواند با روشهای پیشگامانه برای هدایت مسئولانه ابر هوش انجام شود.

💡 هنگام جستجو (و مرور) با استفاده از هوش مصنوعی مولد یاد بگیرید

گوگل چندین بهروزرسانی را برای قابلیتهای هوش مصنوعی نسل موتور جستجو (SGE) خود اعلام میکند، از جمله تعاریف شناور برای موضوعات علمی/تاریخ، برجستهسازی نحوی با کد رنگی برای مرور کلی کد، و آزمایش اولیهای به نام «SGE در حین مرور» که نکات کلیدی را خلاصه میکند و به کاربران کمک میکند. هنگام خواندن محتوای طولانی در وب، صفحات را کاوش کنید. هدف آنها افزایش درک موضوعات پیچیده، بهبود هضم اطلاعات کدگذاری، و کمک به ناوبری و یادگیری در هنگام مرور کاربران است. بهروزرسانیها نشاندهنده تلاشهای مداوم Google برای تکامل تجربه جستجوی هوش مصنوعی بر اساس بازخورد کاربران، با تمرکز بر درک و استخراج جزئیات کلیدی از محتوای پیچیده وب است.

💡 Together.ai Llama2 را به یک پنجره زمینه 32k گسترش می دهد

LLaMA-2-7B-32K یک مدل زبان متن باز و متن باز است که توسط Together Computer توسعه یافته است که طول متن LLaMA-2 متا را به 32 هزار توکن افزایش می دهد. از بهینهسازیهایی مانند FlashAttention-2 برای استنباط و آموزش کارآمدتر استفاده میکند. این مدل با استفاده از ترکیبی از داده ها شامل کتاب، مقاله و داده های آموزشی از قبل آموزش داده شد. نمونههایی برای تنظیم دقیق وظایف QA طولانی و خلاصهسازی ارائه شده است. کاربران می توانند از طریق Hugging Face به مدل دسترسی داشته باشند یا از OpenChatKit برای تنظیم دقیق سفارشی استفاده کنند. مانند همه مدلهای زبان، LLaMA-2-7B-32K میتواند محتوای مغرضانه یا نادرست تولید کند که نیاز به احتیاط در استفاده دارد.

بخش «مقالات» مجموعهای از قطعات تفکر برانگیز در مورد هوش مصنوعی را ارائه میکند. هر مقاله عمیقاً به یک موضوع خاص می پردازد و به خوانندگان بینش هایی در مورد جنبه های مختلف هوش مصنوعی از جمله تکنیک های جدید، رویکردهای انقلابی و ابزارهای نوآورانه ارائه می دهد.

با LangChain، توسعه دهندگان می توانند برنامه های مبتنی بر زبان هوش مصنوعی را بدون اختراع مجدد چرخ بسازند. ساختار قابل ترکیب آن ترکیب و تطبیق اجزایی مانند LLM ها، قالب های سریع، ابزارهای خارجی و حافظه را آسان می کند. این کار نمونه سازی را تسریع می کند و امکان ادغام یکپارچه قابلیت های جدید را در طول زمان فراهم می کند. چه به دنبال ایجاد یک ربات چت، ربات QA یا عامل استدلال چند مرحله ای باشید، LangChain بلوک های ساختمانی را برای جمع آوری سریع هوش مصنوعی پیشرفته فراهم می کند.

📰 نحوه استفاده از ChatGPT برای تبدیل متن به ارائه پاورپوینت

این مقاله یک فرآیند دو مرحلهای برای استفاده از ChatGPT برای تبدیل متن به ارائه پاورپوینت ارائه میکند، ابتدا متن را به عنوان اسلاید و محتوا خلاصه میکند، سپس کد پایتون را برای تبدیل خلاصه به فرمت PPTX با استفاده از کتابخانه python-pptx تولید میکند. این امکان ایجاد سریع ارائه های جذاب از اسناد متنی طولانی را فراهم می کند و بر تلاش های دستی خسته کننده غلبه می کند. دستورالعملهای واضحی در مورد ایجاد اعلانهای ChatGPT و اجرای کد ارائه شده است، که یک راهحل خودکار کارآمد برای نیازهای ارائه ارائه میدهد.

این مقاله مروری بر 10 جهت تحقیقاتی کلیدی برای بهبود مدلهای زبان بزرگ ارائه میکند: کاهش توهم، بهینهسازی طول/ساخت زمینه، ترکیب دادههای چندوجهی، مدلهای شتابدهنده، طراحی معماریهای جدید، توسعه جایگزینهای GPU مانند تراشههای فوتونی، ساخت عوامل قابل استفاده، بهبود یادگیری از بازخورد انسانی، بهبود رابط های چت، و گسترش به زبان های غیر انگلیسی. این مقاله به مقالات مرتبط در این زمینه ها اشاره می کند و به چالش هایی مانند نمایش ترجیحات انسانی برای یادگیری تقویتی و ساخت مدل هایی برای زبان های کم منبع اشاره می کند. نویسنده نتیجه می گیرد که در حالی که برخی از مسائل مانند چند زبانه بودن قابل حل تر هستند، برخی دیگر مانند معماری به پیشرفت های بیشتری نیاز دارند. به طور کلی، هم تخصص فنی و هم غیرفنی بین محققان، شرکتها و جامعه برای هدایت مثبت LLM ضروری است.

📰 چرا شما (احتمالا) نیازی به تنظیم دقیق یک LLM ندارید

این مقاله مروری بر 10 جهت تحقیقاتی کلیدی برای بهبود مدلهای زبان بزرگ ارائه میکند: کاهش توهم، بهینهسازی طول/ساخت زمینه، ترکیب دادههای چندوجهی، مدلهای شتابدهنده، طراحی معماریهای جدید، توسعه جایگزینهای GPU مانند تراشههای فوتونی، ساخت عوامل قابل استفاده، بهبود یادگیری از بازخورد انسانی، بهبود رابط های چت، و گسترش به زبان های غیر انگلیسی. این مقاله به مقالات مرتبط در این زمینه ها اشاره می کند و به چالش هایی مانند نمایش ترجیحات انسانی برای یادگیری تقویتی و ساخت مدل هایی برای زبان های کم منبع اشاره می کند. نویسنده نتیجه می گیرد که در حالی که برخی از مسائل مانند چند زبانه بودن قابل حل تر هستند، برخی دیگر مانند معماری به پیشرفت های بیشتری نیاز دارند. به طور کلی، هم تخصص فنی و هم غیرفنی بین محققان، شرکتها و جامعه برای هدایت مثبت LLM ضروری است.

📰 بهترین روش ها برای استفاده از مدل OpenAI GPT

این مقاله بهترین شیوهها را برای به دست آوردن خروجیهای با کیفیت بالا در هنگام استفاده از مدلهای GPT OpenAI با تکیه بر تجربه جامعه بیان میکند. این پیشنهاد ارائه اعلان های دقیق با مشخصاتی مانند طول و شخصیت را توصیه می کند. دستورالعمل های چند مرحله ای؛ نمونه هایی برای تقلید؛ مراجع و استنادات؛ زمان برای تفکر انتقادی؛ و اجرای کد برای دقت. پیروی از این نکات در مورد آموزش مدل ها، مانند مشخص کردن مراحل و شخصیت ها، می تواند به نتایج دقیق تر، مرتبط تر و قابل تنظیم تر منجر شود. هدف این راهنما کمک به کاربران برای ساختار دهی موثر اعلانها برای استفاده حداکثری از قابلیتهای تولیدی قدرتمند OpenAI است.

📰 همه ما در مورد هوش مصنوعی اشتباه می کنیم

نویسنده استدلال میکند که قابلیتهای هوش مصنوعی فعلی دستکم گرفته میشوند و از مثالهایی مانند خلاقیت، جستجو و شخصیسازی برای مقابله با تصورات غلط رایج استفاده میکنند. او بیان می کند که هوش مصنوعی می تواند با ترکیب مجدد مفاهیم خلاق باشد، نه صرفاً ایجاد ایده های تصادفی. این فقط یک موتور جستجوی سوپرشارژ مانند گوگل نیست. و می تواند روابط شخصی، نه فقط مهارت های عمومی را توسعه دهد. در حالی که مطمئن نیستید کدام برنامهها مفیدتر خواهند بود، نویسنده به جای نادیدهانگاری، ذهنی باز را ترغیب میکند و تاکید میکند که بهترین راه برای تعیین پتانسیل هوش مصنوعی، ادامه کاوش عملی است. او نتیجه می گیرد که تخیل ما در مورد هوش مصنوعی محدود است و استفاده از آن احتمالاً بسیار فراتر از پیش بینی های فعلی است.

بخش «ابزار» برنامهها و اسکریپتهای مفیدی را فهرست میکند که توسط انجمن برای کسانی که میخواهند با برنامههای کاربردی هوش مصنوعی مشغول شوند، ایجاد شده است. در اینجا طیف وسیعی از انواع ابزار را پیدا خواهید کرد، از پایگاه های کد جامع بزرگ تا اسکریپت های کوچک. توجه داشته باشید که ابزارها بدون تایید و بدون هیچ گونه تضمینی به اشتراک گذاشته می شوند. قبل از نصب و استفاده، تکالیف خود را روی هر نرم افزاری انجام دهید!

MetaGPT یک نیاز یک خطی را به عنوان ورودی و خروجی داستان های کاربر / تجزیه و تحلیل رقابتی / الزامات / ساختارهای داده / API / اسناد و غیره می گیرد. در داخل، MetaGPT شامل مدیران محصول / معماران / مدیران پروژه / مهندسان است. این کل فرآیند یک شرکت نرم افزاری را به همراه SOPهایی که به دقت سازماندهی شده اند فراهم می کند.

هدف این پروژه کشف یک خط لوله آزمایشی جدید برای آموزش یک مدل خاص کار با عملکرد بالا است. ما سعی میکنیم همه پیچیدگیها را انتزاع کنیم، بنابراین خروج از ایده -> مدل کاملاً آموزشدیده تا حد ممکن آسان است.

به سادگی شرحی از کار خود را وارد کنید، و سیستم یک مجموعه داده را از ابتدا تولید می کند، آن را در قالب مناسب تجزیه می کند و یک مدل LLaMA 2 را برای شما تنظیم می کند.

DoctorGPT یک مدل زبان بزرگ است که می تواند در آزمون مجوز پزشکی ایالات متحده قبول شود. این یک پروژه منبع باز است که مأموریت دارد پزشک خصوصی خود را برای همه فراهم کند. DoctorGPT نسخهای از مدل زبان بزرگ 2 میلیارد پارامتری Llama7 متا است که بر روی مجموعه دادههای گفتگوی پزشکی تنظیم شد، سپس با استفاده از یادگیری تقویتی و هوش مصنوعی اساسی بهبود یافت. از آنجایی که این مدل تنها 3 گیگابایت اندازه دارد، در هر دستگاه محلی مناسب است، بنابراین برای استفاده از آن نیازی به پرداخت API نیست.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. خودرو / خودروهای الکتریکی، کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

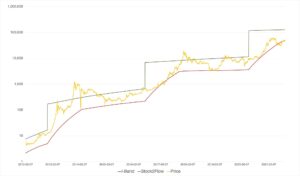

- ChartPrime. بازی معاملاتی خود را با ChartPrime ارتقا دهید. دسترسی به اینجا.

- BlockOffsets. نوسازی مالکیت افست زیست محیطی. دسترسی به اینجا.

- منبع: https://www.kdnuggets.com/2023/08/this-week-ai-2023-08-18.html?utm_source=rss&utm_medium=rss&utm_campaign=this-week-in-ai-august-18-openai-in-financial-trouble-stability-ai-announces-stablecode

- : دارد

- :است

- :نه

- $UP

- 000

- 10

- 11

- 14

- 2024

- 500

- 7

- a

- درباره ما

- چکیده

- تسریع می شود

- تسریع

- دسترسی

- دقیق

- در میان

- نشانی

- پیشرفته

- پیشرفت

- پیشبرد

- عامل

- عاملان

- AI

- خدمات هوش مصنوعی

- سیستم های هوش مصنوعی

- کمک

- هدف

- اهداف

- تراز

- معرفی

- اجازه می دهد تا

- در امتداد

- قبلا

- جایگزین

- در میان

- an

- تحلیل

- و

- اعلام

- اعلام كردن

- هر

- API

- رابط های برنامه کاربردی

- برنامه های کاربردی

- رویکردها

- برنامه های

- معماران

- معماری

- هستند

- مناطق

- استدلال می کند

- دور و بر

- صف

- مقاله

- مقالات

- مصنوعی

- هوش مصنوعی

- AS

- جنبه

- مشتاق

- دستیار

- At

- اوت

- نویسنده

- خودکار

- دور

- ورشکسته

- ورشکستگی

- سد

- پایه

- مستقر

- BE

- بهترین

- بهترین شیوه

- جانبدارانه

- بیلیون

- میلیارد توکن

- بلاک ها

- کتاب

- بالا بردن

- ربات

- هر دو

- مرز

- پیشرفت ها

- مرور

- ساختن

- بنا

- مدل های ساختمانی

- سوختگی

- مشغول

- by

- نام

- CAN

- قابلیت های

- توانا

- Осторожно

- پول دادن و سكس - پول دادن و كس كردن

- احتیاط

- چالش ها

- chatbot

- GPT چت

- چیپس

- واضح

- رمز

- برنامه نویسی

- مشترک

- انجمن

- شرکت

- شرکت

- متقاعد کننده

- رقابت

- رقابتی

- پیچیده

- پیچیدگی

- اجزاء

- جامع

- کامپیوتر

- مفاهیم

- انجام

- محتوا

- زمینه

- زمینه ها

- ادامه داد:

- ادامه

- محاورهای

- هوش مصنوعی محاوره ای

- تبدیل

- شرکت

- هزینه

- مقابله با

- ایجاد

- ایجاد شده

- ایجاد

- خالق

- خلاقیت

- بحرانی

- سرپرستی

- جاری

- سفارشی

- سفارشی

- داده ها

- عمیق

- تعاریف

- وابستگی

- شرح

- طراحی

- طراحی

- با وجود

- دقیق

- جزئیات

- مشخص کردن

- توسعه

- توسعه

- توسعه دهنده

- توسعه دهندگان

- در حال توسعه

- پروژه

- تحولات

- دستگاه

- گفتگو

- جهت ها

- do

- دکتر

- اسناد و مدارک

- آیا

- رسم

- دو

- هر

- در اوایل

- ساده

- چاپ

- سردبیر

- به طور موثر

- موثر

- تلاش

- با تاکید بر

- قادر ساختن

- جذاب

- موتور

- مورد تأیید

- بالا بردن

- افزایش

- سرمایه گذاری

- تمام

- ورود

- و غیره

- اتر (ETH)

- حتی

- هر

- هر کس

- تکامل یابد

- امتحان

- مثال ها

- تجاوز

- اعدام

- گسترش

- تجربه

- تجربه

- تجربی

- تخصص

- اکتشاف

- اکتشاف

- گسترش

- گسترش می یابد

- خارجی

- چهره

- نما

- نتواند

- بسیار

- باز خورد

- رشته

- مالی

- پیدا کردن

- نام خانوادگی

- تمرکز

- پیروی

- برای

- پیش بینی

- قالب

- از جانب

- کامل

- بیشتر

- تولید می کنند

- مولد

- نسل

- مولد

- هوش مصنوعی مولد

- دریافت کنید

- Go

- هدف

- اهداف

- گوگل

- دولتی

- GPU

- زمینی شکستن

- پیشگامانه

- در حال رشد

- رشد

- ضمانت

- راهنمایی

- دسته

- دست

- خوشحال

- he

- عناوین

- کمک

- کمک می کند

- اینجا کلیک نمایید

- زیاد

- با عملکرد بالا

- با کیفیت بالا

- مشخص کردن

- مشق شب

- افق

- در تردید بودن

- HTML

- HTTPS

- انسان

- اندیشه

- ایده ها

- if

- خیال پردازی

- بهبود

- بهبود یافته

- بهبود

- in

- شامل

- از جمله

- شامل

- گنجاندن

- اطلاعات

- اطلاع

- نوآوری

- ورودی

- بصیرت

- بینش

- نصب و راه اندازی

- آموزشی

- دستورالعمل

- ادغام

- اطلاعات

- هوشمند

- از قصد

- رابط

- داخلی

- به

- مسائل

- IT

- ITS

- تنها

- kdnuggets

- نگاه داشتن

- کلید

- دانش

- چشم انداز

- زبان

- زبان ها

- بزرگ

- راه اندازی

- رهبری

- یادگیری

- طول

- اهرم ها

- بهره برداری

- کتابخانه

- صدور مجوز

- پسندیدن

- احتمالا

- محدود شده

- لاین

- لیست

- پشم لاما

- محلی

- طولانی

- به دنبال

- کاهش

- دستگاه

- فراگیری ماشین

- باعث می شود

- مدیریت

- مدیران

- کتابچه راهنمای

- مسابقه

- ممکن است..

- در ضمن

- پزشکی

- حافظه

- صرفا - فقط

- متا

- روش

- ذهن

- تصورات غلط

- ماموریت

- مخلوط

- مخلوط

- مدل

- مدل

- کسب درآمد

- ماه

- بیش

- کارآمدتر

- اکثر

- چندگانه

- طبیعی

- زبان طبیعی

- جهت یابی

- نیاز

- نیازهای

- جدید

- اخبار

- تو رفتگی در دیوار

- نه

- غیر فنی

- یادداشت برداری

- بدست آوردن

- of

- ارائه

- on

- ONE

- فقط

- باز کن

- منبع باز

- OpenAI

- بهینه

- بهینه سازی

- or

- هماهنگ شده

- دیگر

- دیگران

- ما

- خارج

- نمای کلی

- روی

- به طور کلی

- فائق آمدن

- مروری

- خود

- صفحات

- اوراق

- پارامتر

- عبور

- گذشته

- پرداخت

- شخصی

- شخصی

- قطعات

- پیشگام

- خط لوله

- افلاطون

- هوش داده افلاطون

- PlatoData

- نقطه

- سیاست

- ممکن

- پست

- پتانسیل

- قوی

- عملی

- شیوه های

- دقت

- پیش بینی

- تنظیمات

- ارائه

- ارایهها در همایشهای علمی

- هدیه

- قبلا

- خصوصی

- شاید

- روند

- محصول

- بهره وری

- سودبخشی

- برنامهنویس

- پروژه

- نمونه سازی

- ثابت كردن

- ارائه

- ارائه

- فراهم می کند

- ارائه

- هل دادن

- پــایتــون

- پرسش و پاسخ

- تصادفی

- محدوده

- سریع

- سریعا

- نرخ

- نسبتا

- RE

- خوانندگان

- مطالعه

- اخیر

- توصیه می کند

- کاهش

- منابع

- تقویت یادگیری

- روابط

- منتشر شد

- مربوط

- نشان دادن

- نمایندگی

- نشان دهنده

- نیاز

- نیاز

- مورد نیاز

- تحقیق

- محققان

- منابع

- پاسخ

- نتایج

- درامد

- انقلابی

- راست

- خطرات

- نیرومندی

- نقش

- در حال اجرا

- s

- با خیال راحت

- مقیاس پذیر

- خراش

- اسکریپت

- بدون درز

- جستجو

- موتور جستجو

- بخش

- خدمات

- چند

- شکل

- به اشتراک گذاشته شده

- کمبود

- نشان

- پس از

- اندازه

- مهارت ها

- نمایش

- کوچک

- So

- جامعه

- نرم افزار

- توسعه نرم افزار

- راه حل

- برخی از

- فضا

- دهانه ها

- تخصصی

- خاص

- جزئیات

- ثبات

- شروع

- ایالات

- ماندن

- مراحل

- داستان

- فشار

- ساختار

- تلاش

- چنین

- خلاصه

- هوش فوق بشری

- قابل تحمل

- نحو

- سیستم

- سیستم های

- طول می کشد

- کار

- وظایف

- تیم

- فنی

- تکنیک

- فنی

- پیشرفته

- قالب

- تست

- نسبت به

- که

- La

- اطلاعات

- شان

- سپس

- آنجا.

- اینها

- تفکر

- این

- این هفته

- کسانی که

- تأمل برانگیز

- از طریق

- زمان

- نکات

- عناوین

- به

- با هم

- نشانه

- ابزار

- ابزار

- بالا

- موضوع

- تاپیک

- قطار

- آموزش دیده

- آموزش

- زحمت

- امتحان

- انواع

- درک

- بروزرسانی

- به روز شده

- به روز رسانی

- میل

- us

- قابل استفاده

- استفاده کنید

- کاربر

- کاربران

- استفاده

- با استفاده از

- اعتبار سنجی

- مختلف

- نسخه

- از طريق

- می خواهم

- بود

- مسیر..

- we

- وب

- هفته

- هفتگی

- چرخ

- چه زمانی

- چه

- که

- در حین

- WHO

- اراده

- با

- بدون

- گردش کار

- کارگر

- جهان

- نوشتن

- کد بنویس

- اشتباه

- شما

- شما

- زفیرنت