هوش مصنوعی (AI) صنایع مختلف را متحول کرده است و مزایا و فرصت های متعددی را ارائه می دهد. با این حال، نگرانیهایی در مورد پتانسیل هوش مصنوعی برای تداوم تبعیض و تعصبات پدید آمده است. این مقاله موضوع تبعیض هوش مصنوعی را بررسی میکند و چالشهای شناسایی و رسیدگی به سوگیریهای تعبیهشده در سیستمهای هوش مصنوعی را روشن میکند. خودیهای صنعت درباره پیامدهای اخلاقی و اخلاقی هوش مصنوعی با اشاره به نگرانیها در مورد اطلاعات نادرست، سوگیری در الگوریتمها و تولید محتوای گمراهکننده تردید دارند. با تشدید بحث های پیرامون هوش مصنوعی، تقاضای فزاینده ای برای مقررات معنادار برای تضمین شفافیت، پاسخگویی و حمایت از حقوق اساسی وجود دارد.

چالش های صنایع مالی با هوش مصنوعی

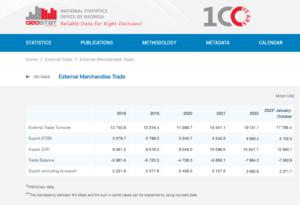

به گفته نبیل منجی، رئیس بخش رمزنگاری و Web3 در Worldpay توسط FIS، اثربخشی محصولات هوش مصنوعی به شدت به کیفیت منبع استفاده شده برای آموزش بستگی دارد. مانجی در مصاحبه ای با CNBC توضیح داد که دو عامل اصلی در عملکرد هوش مصنوعی نقش دارند: داده هایی که به آن دسترسی دارد و قابلیت های مدل زبان بزرگ.

برای نشان دادن اهمیت دادهها، مانجی اشاره کرد که شرکتهایی مانند Reddit بهطور عمومی محدودیتهایی را در مورد جمعآوری دادهها اعلام کردهاند و برای دسترسی نیاز به پرداخت دارند. در بخش خدمات مالی، او چالش سیستم های داده پراکنده در زبان ها و قالب های مختلف را برجسته کرد. این عدم ادغام و هماهنگی، اثربخشی محصولات مبتنی بر هوش مصنوعی را محدود میکند، بهویژه زمانی که با صنایعی با زیرساختهای داده استاندارد و مدرن مقایسه میشود.

به گفته مانجی، استفاده از فناوری بلاک چین یا دفتر کل توزیع شده ممکن است راه حلی بالقوه برای مقابله با این مشکل ارائه دهد. این رویکرد نوآورانه می تواند شفافیت بیشتری را در داده های تکه تکه ذخیره شده در سیستم های پیچیده بانک های معمولی فراهم کند. با این حال، او اذعان کرد که ماهیت بسیار منظم و کند حرکت بانکها ممکن است بر خلاف شرکتهای فنآوری چابکتر مانند مایکروسافت و گوگل که در چند سال گذشته در خط مقدم نوآوری بودهاند، مانع از توانایی آنها در به کارگیری سریع ابزارهای هوش مصنوعی جدید شود. دهه ها

با توجه به این عوامل، بدیهی است که صنعت مالی به دلیل پیچیدگیهای یکپارچهسازی دادهها و ماهیت ذاتی بخش بانکی، با چالشهای منحصربهفردی در اهرم هوش مصنوعی مواجه است.

به گفته رامن چاودری، رئیس سابق اخلاق، شفافیت و مسئولیتپذیری یادگیری ماشین در توییتر، وامدهی نمونه قابلتوجهی از این است که چگونه سوگیری در سیستمهای هوش مصنوعی میتواند بر جوامع به حاشیه رانده شده تأثیر منفی بگذارد. چاودری در یک میزگرد در آمستردام سخنرانی کرد و بر رویه تاریخی "خط قرمز" در شیکاگو در دهه 1930 تاکید کرد. خط قرمز شامل رد کردن وام به محلههای عمدتاً آفریقایی آمریکایی بر اساس جمعیتشناسی نژادی بود.

چاودری توضیح داد که اگرچه الگوریتم های مدرن ممکن است به طور صریح نژاد را به عنوان یک نقطه داده در بر نگیرند، اما سوگیری ها همچنان می توانند به طور ضمنی رمزگذاری شوند. هنگام توسعه الگوریتمهایی برای ارزیابی خطرپذیری مناطق و افراد برای اهداف وامدهی، دادههای تاریخی حاوی سوگیریها میتوانند به طور ناخواسته تبعیض را تداوم بخشند.

آنگل بوش، رویاپرداز پشت زنان سیاهپوست در هوش مصنوعی، اهمیت اذعان به خطرات مرتبط با بازتولید سوگیریهای نهفته در دادههای تاریخی را هنگام استفاده از سیستمهای هوش مصنوعی برای تصمیمگیری تایید وام برجسته کرد. چنین رویهای میتواند منجر به رد خودکار درخواستهای وام از جوامع حاشیهنشین شود و در نتیجه نابرابریهای نژادی یا جنسیتی را تداوم بخشد.

فراست لی، یک توسعهدهنده با تجربه هوش مصنوعی، به چالشهای شخصیسازی در آن اشاره کرد ادغام AI. انتخاب «ویژگیهای اصلی» برای آموزش مدلهای هوش مصنوعی گاهی اوقات میتواند شامل عوامل نامرتبط باشد که ممکن است منجر به نتایج مغرضانه شود. لی مثالی ارائه کرد که چگونه استارتاپهای فینتک که خارجیها را هدف قرار میدهند، ممکن است با معیارهای ارزیابی اعتبار متفاوتی در مقایسه با بانکهای محلی، که بیشتر با مدارس و جوامع محلی آشنا هستند، مواجه شوند.

Niklas Guske، مدیر اجرایی Taktile، استارتآپ متخصص در خودکارسازی تصمیمگیری برای فینتکها، تصریح کرد که هوش مصنوعی مولد معمولاً برای ایجاد امتیاز اعتباری یا امتیازدهی ریسک مصرفکنندگان استفاده نمیشود. برعکس، نقطه قوت آن در پیش پردازش داده های بدون ساختار، مانند فایل های متنی، برای افزایش کیفیت داده ها برای مدل های متعارف پذیره نویسی نهفته است.

به طور خلاصه، استفاده از هوش مصنوعی در وام دهی و خدمات مالی نگرانی هایی را در مورد تعصب و تبعیض ایجاد می کند. سوگیری های تاریخی تعبیه شده در داده ها و انتخاب ویژگی های نامربوط در طول آموزش هوش مصنوعی می تواند منجر به نتایج ناعادلانه شود. برای بانک ها و مؤسسات مالی بسیار مهم است که این مسائل را بشناسند و به آنها رسیدگی کنند تا از تداوم ناخواسته تبعیض در هنگام اجرای راه حل های هوش مصنوعی جلوگیری کنند.

اثبات AI-تبعیض

اثبات تبعیض مبتنی بر هوش مصنوعی می تواند چالش برانگیز باشد، همانطور که با مثال هایی مانند مورد مربوط به اپل و گلدمن ساکس مشخص شده است. وزارت خدمات مالی ایالت نیویورک با استناد به فقدان شواهد مستدل، اتهامات اعمال محدودیت های کمتر برای اپل کارت برای زنان را رد کرد.

کیم اسموتر، مدیر شبکه اروپایی علیه نژادپرستی، اشاره میکند که استقرار انبوه هوش مصنوعی باعث عدم شفافیت در فرآیندهای تصمیمگیری میشود و شناسایی و رسیدگی به تبعیض را برای افراد دشوار میکند.

اسموتر توضیح میدهد که افراد اغلب دانش محدودی در مورد نحوه عملکرد سیستمهای هوش مصنوعی دارند، که تشخیص موارد تبعیض یا سوگیریهای سیستمی را به چالش میکشد. زمانی که تبعیض بخشی از یک موضوع گستردهتر است که افراد متعددی را تحت تأثیر قرار میدهد، پیچیدهتر میشود. اسموتر به رسوایی رفاه کودکان هلند اشاره می کند، جایی که تعداد زیادی از مطالبات مزایا به دلیل سوگیری سازمانی به اشتباه به عنوان جعلی برچسب خورده بودند. کشف چنین اختلالاتی چالش برانگیز است و جبران خسارت می تواند دشوار و زمان بر باشد و منجر به آسیب قابل توجه و گاهی غیرقابل جبران شود.

این مثالها مشکلات ذاتی در اثبات تبعیض مبتنی بر هوش مصنوعی و دستیابی به راهحلهایی را در هنگام وقوع چنین تبعیضی نشان میدهند. پیچیدگی سیستمهای هوش مصنوعی و عدم شفافیت در فرآیندهای تصمیمگیری میتواند تشخیص و رسیدگی مؤثر به موارد تبعیض را برای افراد چالشبرانگیز کند.

به گفته Chowdhury، نیاز مبرمی به یک نهاد نظارتی جهانی مشابه سازمان ملل برای رسیدگی به خطرات مرتبط با هوش مصنوعی وجود دارد. در حالی که هوش مصنوعی نوآوری قابل توجهی از خود نشان داده است، نگرانی هایی توسط فناوران و اخلاق شناسان در مورد پیامدهای اخلاقی و اخلاقی آن مطرح شده است. این نگرانی ها شامل مواردی مانند اطلاعات غلط، تعصبات نژادی و جنسیتی در الگوریتم های هوش مصنوعی و تولید محتوای گمراه کننده توسط ابزارهایی مانند ChatGPT می شود.

Chowdhury ابراز نگرانی می کند که وارد دنیای پسا حقیقت شود که در آن اطلاعات آنلاین از جمله متن، ویدیو و صدا به دلیل هوش مصنوعی غیرقابل اعتماد می شود. این پرسشهایی را در مورد اینکه چگونه میتوانیم از یکپارچگی اطلاعات اطمینان حاصل کنیم و چگونه میتوانیم برای تصمیمگیری آگاهانه به آن تکیه کنیم، ایجاد میکند. با قانون هوش مصنوعی اتحادیه اروپا به عنوان مثال، مقررات معنادار هوش مصنوعی در حال حاضر بسیار مهم است. با این حال، نگرانیهایی در مورد زمانبندی طولانیای که لازم است تا پیشنهادهای نظارتی مؤثر واقع شوند، وجود دارد که احتمالاً اقدامات لازم را به تأخیر میاندازد.

اسموتر بر نیاز به شفافیت و مسئولیت پذیری بیشتر در الگوریتم های هوش مصنوعی تاکید می کند. این شامل درک بیشتر الگوریتمها برای افراد غیرمتخصص، انجام آزمایشها و انتشار نتایج، ایجاد فرآیندهای شکایت مستقل، انجام ممیزیها و گزارشهای دورهای، و مشارکت جوامع نژادپرستانه در طراحی و استقرار فناوری است. پیشبینی میشود که اجرای قانون هوش مصنوعی، که از دیدگاه حقوق اساسی برخوردار است و مفاهیمی مانند جبران خسارت را معرفی میکند، تا حدود دو سال آینده آغاز شود. کاهش این جدول زمانی برای حفظ شفافیت و مسئولیت پذیری به عنوان جنبه های جدایی ناپذیر نوآوری مفید خواهد بود.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. خودرو / خودروهای الکتریکی، کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- BlockOffsets. نوسازی مالکیت افست زیست محیطی. دسترسی به اینجا.

- منبع: https://www.forexnewsnow.com/fintech/the-urgency-of-addressing-ai-discrimination-transparency-accountability-and-regulatory-timelines/

- : دارد

- :است

- :نه

- :جایی که

- a

- توانایی

- درباره ما

- دسترسی

- مسئوليت

- تصدیق شده

- عمل

- اقدامات

- نشانی

- خطاب به

- اتخاذ

- با صرفه

- منفی

- اثر

- افریقایی

- در برابر

- فرز

- AI

- قانون هوش مصنوعی

- سیستم های هوش مصنوعی

- آموزش هوش مصنوعی

- الگوریتم

- اتهامات

- هر چند

- امریکایی

- آمستردام

- an

- و

- پیش بینی

- اپل

- کارت اپل

- برنامه های کاربردی

- روش

- تصویب

- تقریبا

- هستند

- مقاله

- مصنوعی

- هوش مصنوعی

- AS

- جنبه

- ارزیابی کنید

- ارزیابی

- مرتبط است

- At

- سمعی

- ممیزی

- اتوماتیک

- اتوماسیون

- بانکداری

- بخش بانکی

- بانک

- مستقر

- BE

- شدن

- شود

- بوده

- پشت سر

- سود

- مزایای

- تعصب

- جانبدارانه

- تعصبات

- سیاه پوست

- بلاکچین

- بدن

- به ارمغان می آورد

- گسترده تر

- by

- صدا

- CAN

- قابلیت های

- کارت

- مورد

- به چالش

- چالش ها

- به چالش کشیدن

- GPT چت

- شیکاگو

- کودک

- ادعای

- روشن

- CNBC

- جوامع

- شرکت

- مقایسه

- شکایت

- پیچیده

- پیچیدگی ها

- پیچیدگی

- مفاهیم

- نگرانی ها

- انجام

- تثبیت

- مصرف کنندگان

- شامل

- محتوا

- مخالف

- کمک

- معمولی

- COO

- ایجاد

- اعتبار

- ضوابط

- بسیار سخت

- عضو سازمانهای سری ومخفی

- خطرات

- داده ها

- زیرساخت داده

- یکپارچه سازی داده ها

- کیفیت داده

- بحث

- دهه

- تصمیم گیری

- تصمیم گیری

- جمعیت

- بخش

- بستگی دارد

- گسترش

- طرح

- توسعه دهنده

- در حال توسعه

- مختلف

- مشکل

- مشکلات

- مدیر

- کشف

- تبعیض

- گفتگو

- توزیع شده

- لجر توزیع شده است

- تکنولوژی لجستیک توزیع شده

- رانندگی

- دو

- در طی

- هلندی

- موثر

- به طور موثر

- اثر

- جاسازی شده

- ظهور

- تأکید می کند

- شامل

- اجرای

- بالا بردن

- افزایش

- اطمینان حاصل شود

- وارد شدن

- به خصوص

- ایجاد

- اخلاقی

- اصول اخلاق

- اروپایی

- حتی

- مدرک

- واضح است

- مثال

- مثال ها

- با تجربه

- توضیح داده شده

- توضیح می دهد

- کاوش می کند

- صریح

- چهره

- چهره ها

- عوامل

- آشنا

- امکانات

- کمی از

- فایل ها

- مالی

- صنایع مالی

- موسسات مالی

- خدمات مالی

- fintech

- استارت آپ های فین تک

- fintechs

- FIS

- برای

- خط مقدم

- سابق

- تکه تکه

- جعلی

- از جانب

- اساسی

- جنس

- نسل

- مولد

- هوش مصنوعی مولد

- جهانی

- مرد طلایی

- گلدمن ساکس

- گوگل

- بیشتر

- در حال رشد

- صدمه

- آیا

- he

- سر

- به شدت

- برجسته

- خیلی

- تاریخی

- چگونه

- اما

- HTTPS

- شناسایی

- شناسایی

- اجرای

- پیامدهای

- اهمیت

- تحمیل

- in

- شامل

- شامل

- از جمله

- مستقل

- افراد

- لوازم

- صنعت

- نابرابری

- اطلاعات

- اطلاع

- شالوده

- ذاتی

- ابداع

- ابتکاری

- سازمانی

- موسسات

- انتگرال

- ادغام

- تمامیت

- اطلاعات

- مصاحبه

- به

- معرفی می کند

- شامل

- گرفتار

- شامل

- موضوع

- مسائل

- IT

- ITS

- دانش

- عدم

- زبان

- زبان ها

- بزرگ

- رهبری

- برجسته

- یادگیری

- دفتر کل

- امانت دادن

- بهره برداری

- li

- نهفته است

- سبک

- پسندیدن

- محدود شده

- محدودیت

- وام

- وام

- محلی

- بانک های محلی

- کاهش

- دستگاه

- فراگیری ماشین

- اصلی

- ساخت

- ساخت

- توده

- ماده

- ممکن است..

- معنی دار

- ذکر شده

- مایکروسافت

- قدرت

- اطلاعات غلط

- گمراه کننده

- مدل

- مدل

- مدرن

- لحظه

- اخلاقی

- بیش

- چندگانه

- سازمان ملل

- طبیعت

- لازم

- نیاز

- شبکه

- جدید

- نیویورک

- ایالت نیویورک

- وزارت امور خارجه خدمات مالی نیویورک

- غیر متخصص

- قابل توجه

- عدد

- متعدد

- مزایای بیشمار

- بدست آوردن

- of

- ارائه

- ارائه

- غالبا

- on

- آنلاین

- کار

- فرصت ها

- or

- خارج

- نتایج

- تابلو

- میزگرد

- بخش

- گذشته

- پرداخت

- کارایی

- متناوب

- شخصی

- چشم انداز

- افلاطون

- هوش داده افلاطون

- PlatoData

- نقطه

- نقطه

- پتانسیل

- بالقوه

- تمرین

- غالباً

- فشار

- جلوگیری از

- مشکل

- فرآیندهای

- محصولات

- پیشنهادات

- حفاظت

- ارائه

- ارائه

- عمومی

- انتشار

- اهداف

- کیفیت

- سوالات

- نژاد

- نژاد پرستی

- مطرح شده

- افزایش

- شناختن

- ق

- کاهش

- منابع

- با توجه

- تنظیم

- تنظیم

- تنظیم کننده

- تکیه

- قابل توجه

- گزارش

- محدودیت های

- نتایج

- انقلابی

- حقوق

- خطر

- خطرات

- ساکس

- رسوایی

- دانشکده ها

- نمرات

- به ثمر رساندن

- خراش دادن

- بخش

- انتخاب

- انتخاب

- خدمات

- نشان داده شده

- اهمیت

- قابل توجه

- مشابه

- راه حل

- مزایا

- منبع

- صحبت کردن

- متخصص

- شروع

- نوپا

- دولت

- وزارت امور خارجه

- هنوز

- ذخیره شده

- استحکام

- چنین

- خلاصه

- اطراف

- به سرعت

- سیستمیک

- سیستم های

- برخورد با

- طول می کشد

- هدف گذاری

- فن آوری

- شرکت های فن آوری

- تکنسین ها

- پیشرفته

- تست

- که

- La

- منبع

- شان

- آنجا.

- در نتیجه

- اینها

- این

- زمان بر

- جدول زمانی

- جدول زمانی

- به

- ابزار

- موضوع

- آموزش

- شفافیت

- توییتر

- دو

- به طور معمول

- قابل فهم

- تعهد

- غیر منصفانه

- منحصر به فرد

- متحد

- سازمان ملل

- بر خلاف

- حمایت

- ضرورت

- استفاده کنید

- استفاده

- مختلف

- تصویری

- چشم انداز

- we

- Web3

- رفاه

- بود

- چه زمانی

- که

- در حین

- با

- در داخل

- زنان

- جهان

- WorldPay

- نگرانی

- خواهد بود

- سال

- نیویورک

- زفیرنت