یک مقاله فنی با عنوان "WWW: چه، چه زمانی، کجا باید در حافظه محاسبه کرد" توسط محققان دانشگاه پردو منتشر شد.

چکیده:

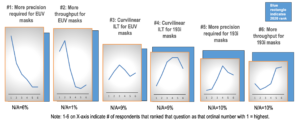

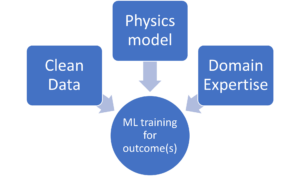

«Compute-in-Memory (CiM) به عنوان یک راه حل قانع کننده برای کاهش هزینه های بالای انتقال داده در ماشین های فون نویمان پدیدار شده است. CiM می تواند عملیات ضرب ماتریس عمومی موازی (GEMM) را در حافظه، محاسبات غالب در استنتاج یادگیری ماشین (ML) انجام دهد. با این حال، استفاده مجدد از حافظه برای محاسبات، سؤالات کلیدی در مورد 1) نوع CiM برای استفاده: با توجه به تعداد زیادی از CiM های آنالوگ و دیجیتال، تعیین مناسب بودن آنها از دیدگاه سیستم مورد نیاز است. 2) زمان استفاده از CiM: استنتاج ML شامل بارهای کاری با انواع حافظه و نیازهای محاسباتی است که تشخیص اینکه چه زمانی CiM سودمندتر از هسته های پردازش استاندارد است را دشوار می کند. 3) محل ادغام CiM: هر سطح حافظه دارای پهنای باند و ظرفیت متفاوتی است که بر حرکت داده ها و مزایای محلی ادغام CiM تأثیر می گذارد.

در این مقاله، پاسخ به این سؤالات در مورد ادغام CiM برای شتاب استنتاج ML را بررسی می کنیم. ما از Timeloop-Accelergy برای ارزیابی اولیه در سطح سیستم نمونههای اولیه CiM، از جمله نمونههای اولیه آنالوگ و دیجیتال استفاده میکنیم. ما CiM را در سطوح مختلف حافظه کش در معماری پایه Nvidia A100 ادغام می کنیم و جریان داده را برای بارهای کاری مختلف ML تنظیم می کنیم. آزمایشهای ما نشان میدهد که معماریهای CiM بازده انرژی را بهبود میبخشد، و با دقت INT-0.12 تا 8 برابر انرژی کمتری نسبت به خط پایه تعیینشده به دست میآورد، و با اضافه کردن وزن و تکثیر، تا 4 برابر افزایش عملکرد دارد. کار پیشنهادی بینشی در مورد نوع CiM برای استفاده، و زمان و مکان بهینه سازی آن در سلسله مراتب کش برای شتاب GEMM ارائه می دهد.

یافتن مقاله فنی اینجا منتشر شده در دسامبر 2023 (پیش چاپ).

شارما، تانوی، مصطفی علی، ایندرانیل چاکرابورتی و کاوشیک روی. "WWW: چه، چه زمانی، کجا در حافظه محاسبه شود." arXiv preprint arXiv:2312.15896 (2023).

خواندن مرتبط

افزایش بهره وری انرژی هوش مصنوعی با محاسبه در حافظه

نحوه پردازش حجم کاری زتا اسکیل و ماندن در بودجه ثابت.

مدلسازی محاسبه در حافظه با کارایی بیولوژیکی

هوش مصنوعی مولد، تراشهسازان را مجبور میکند از منابع محاسباتی هوشمندانهتر استفاده کنند.

SRAM در هوش مصنوعی: آینده حافظه

چرا SRAM به عنوان یک عنصر حیاتی در معماری های محاسباتی جدید و سنتی در نظر گرفته می شود.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- منبع: https://semiengineering.com/cim-integration-for-ml-inference-acceleration/

- : دارد

- :است

- :جایی که

- $UP

- 1

- 2023

- a

- شتاب

- دستیابی به

- AI

- کم کردن

- an

- و

- پاسخ

- معماری

- AS

- At

- پهنای باند

- خط مقدم

- مفید

- مزایای

- هر دو

- بودجه

- by

- نهانگاه

- CAN

- ظرفیت

- متقاعد کننده

- محاسبه

- محاسبه

- هزینه

- بحرانی

- داده ها

- دسامبر

- تعیین

- مختلف

- مشکل

- دیجیتال

- غالب

- هر

- در اوایل

- بهره وری

- عنصر

- ظهور

- انرژی

- صرفه جویی در مصرف انرژی

- تاسیس

- ارزیابی

- آزمایش

- اکتشاف

- ثابت

- برای

- نیروهای

- از جانب

- آینده

- عایدات

- سوالات عمومی

- داده

- اینجا کلیک نمایید

- سلسله مراتب

- زیاد

- اما

- HTTPS

- شناسایی

- بهبود

- in

- شامل

- از جمله

- بینش

- ادغام

- ادغام

- به

- IT

- JPG

- کلید

- یادگیری

- سطح

- سطح

- کاهش

- دستگاه

- فراگیری ماشین

- ماشین آلات

- ساخت

- انبوه

- ماتریس

- حافظه

- ML

- بیش

- جنبش

- بسیاری

- ضروری

- جدید

- کارت گرافیک Nvidia

- of

- on

- باز کن

- عملیات

- ما

- مقاله

- موازی

- انجام دادن

- کارایی

- چشم انداز

- افلاطون

- هوش داده افلاطون

- PlatoData

- به شمار

- قدرت

- دقت

- روند

- در حال پردازش

- پیشنهاد شده

- نمونه

- فراهم می کند

- منتشر شده

- سوالات

- با توجه

- مورد نیاز

- محققان

- منابع

- روی

- نشان

- راه حل

- استاندارد

- ماندن

- مناسب بودن

- سیستم های

- فنی

- نسبت به

- که

- La

- آینده

- شان

- اینها

- این

- با عنوان

- به

- سنتی

- نوع

- دانشگاه

- استفاده کنید

- تنوع

- مختلف

- مشاهده شده

- از

- بود

- we

- وزن

- چی

- چه زمانی

- با

- در داخل

- مهاجرت کاری

- زفیرنت