پیشرفتهای اخیر در توسعه LLMها، استفاده از آنها را برای کارهای متنوع NLP که قبلاً با استفاده از روشهای یادگیری ماشین قدیمیتر انجام میشد، رایج کرده است. مدلهای زبانی بزرگ قادر به حل انواع مشکلات زبانی مانند طبقهبندی، خلاصهسازی، بازیابی اطلاعات، ایجاد محتوا، پاسخگویی به سؤال و حفظ مکالمه هستند - همه فقط با استفاده از یک مدل واحد. اما چگونه بفهمیم که آنها در تمام این وظایف مختلف کار خوبی انجام می دهند؟

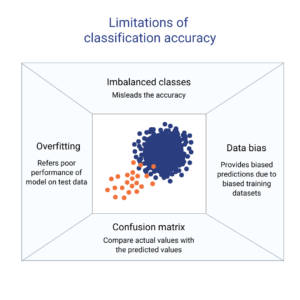

ظهور LLM ها یک مشکل حل نشده را آشکار کرده است: ما استاندارد قابل اعتمادی برای ارزیابی آنها نداریم. چیزی که ارزیابی را سختتر میکند این است که از آنها برای وظایف بسیار متنوع استفاده میشود و ما فاقد تعریف روشنی از پاسخ مناسب برای هر مورد استفاده هستیم.

این مقاله رویکردهای فعلی برای ارزیابی LLMها را مورد بحث قرار میدهد و یک تابلوی امتیازات جدید LLM را با استفاده از ارزیابی انسانی معرفی میکند که تکنیکهای ارزیابی موجود را بهبود میبخشد.

اولین و معمول شکل اولیه ارزیابی، اجرای مدل بر روی چندین مجموعه داده انتخاب شده و بررسی عملکرد آن است. HuggingFace یک تابلوی امتیازات LLM را باز کنید که در آن مدل های بزرگ با دسترسی باز با استفاده از چهار مجموعه داده شناخته شده ارزیابی می شوند (چالش استدلال AI2 , هلاسواگ , MMLU , TruthfulQA). این مربوط به ارزیابی خودکار است و توانایی مدل را برای بدست آوردن حقایق برای برخی سؤالات خاص بررسی می کند.

این نمونه ای از یک سوال از طرف MMLU مجموعه داده

موضوع: کالج_پزشکی

سوال: یک عارضه جانبی مورد انتظار مکمل کراتین است.

- الف) ضعف عضلانی

- ب) افزایش توده بدن

- ج) گرفتگی عضلات

- د) از دست دادن الکترولیت ها

پاسخ: (ب)

امتیاز دادن به مدل در پاسخ به این نوع سؤال، معیار مهمی است و برای بررسی واقعیت به خوبی عمل می کند، اما توانایی تولیدی مدل را آزمایش نمی کند. این احتمالاً بزرگترین نقطه ضعف این روش ارزیابی است زیرا تولید متن آزاد یکی از مهم ترین ویژگی های LLM است.

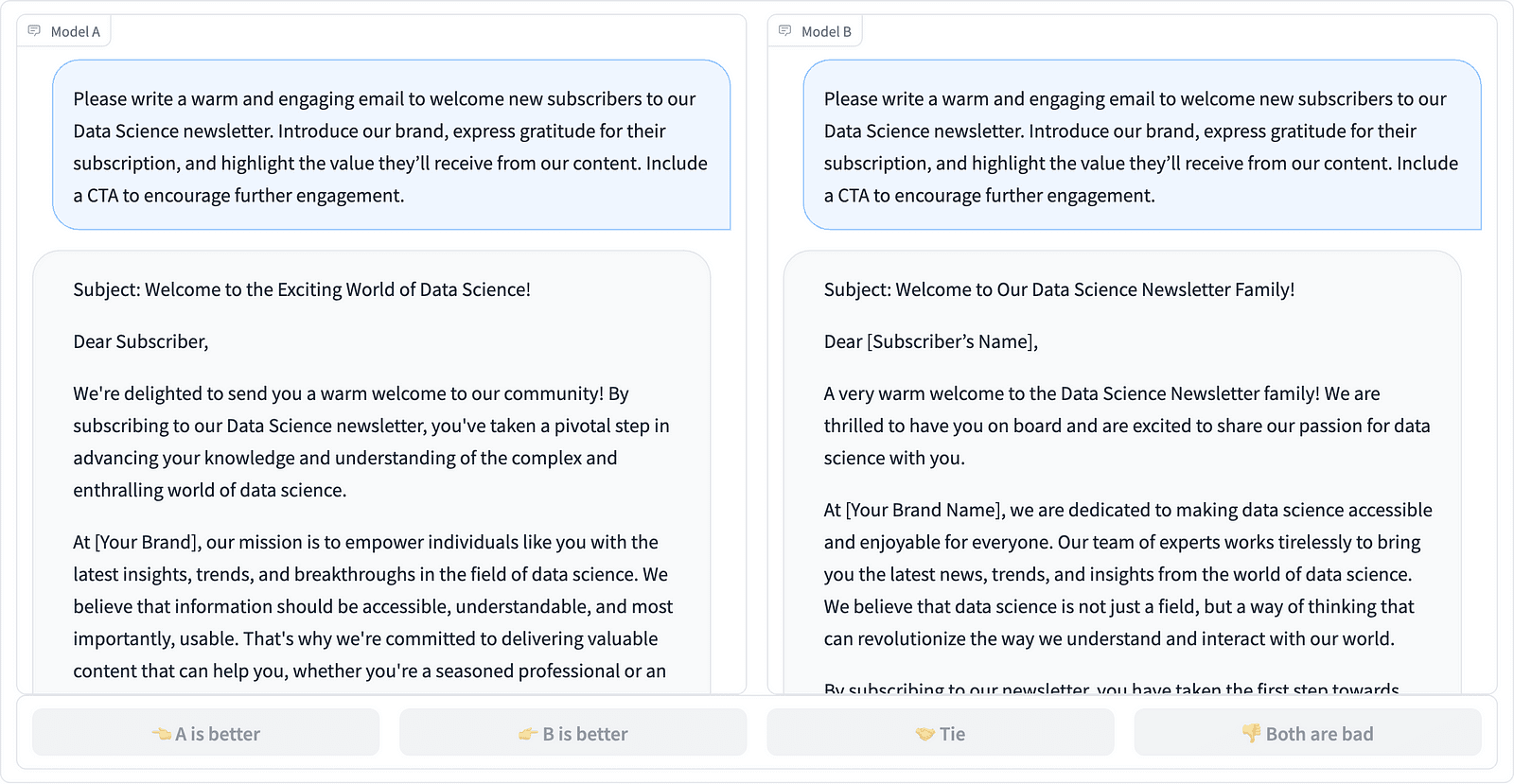

به نظر می رسد در جامعه اتفاق نظر وجود دارد که برای ارزیابی صحیح مدل نیاز به ارزیابی انسانی داریم. این معمولاً با مقایسه پاسخهای مدلهای مختلف انجام میشود.

مقایسه دو تکمیل سریع در پروژه LMSYS - اسکرین شات توسط نویسنده

حاشیه نویس ها تصمیم می گیرند که کدام پاسخ بهتر است، همانطور که در مثال بالا مشاهده می شود، و گاهی اوقات تفاوت در کیفیت تکمیل های سریع را کمیت می کنند. LMSYS Org ایجاد کرده است رهبران که از این نوع ارزیابی انسانی استفاده می کند و 17 مدل مختلف را با هم مقایسه می کند و گزارش می دهد امتیاز الو برای هر مدل

از آنجایی که ارزیابی انسان می تواند مقیاس پذیر باشد، تلاش هایی برای مقیاس بندی و سرعت بخشیدن به فرآیند ارزیابی انجام شده است و این منجر به یک پروژه جالب به نام شد. AlpacaEval. در اینجا هر مدل با یک خط پایه مقایسه می شود (text-davinci-003 ارائه شده توسط GPT-4) و ارزیابی انسانی با قضاوت GPT-4 جایگزین می شود. این در واقع سریع و مقیاس پذیر است، اما آیا می توانیم به مدل در اینجا برای انجام امتیازدهی اعتماد کنیم؟ ما باید از تعصبات مدل آگاه باشیم. این پروژه در واقع نشان داده است که GPT-4 ممکن است به دنبال پاسخ های طولانی تر باشد.

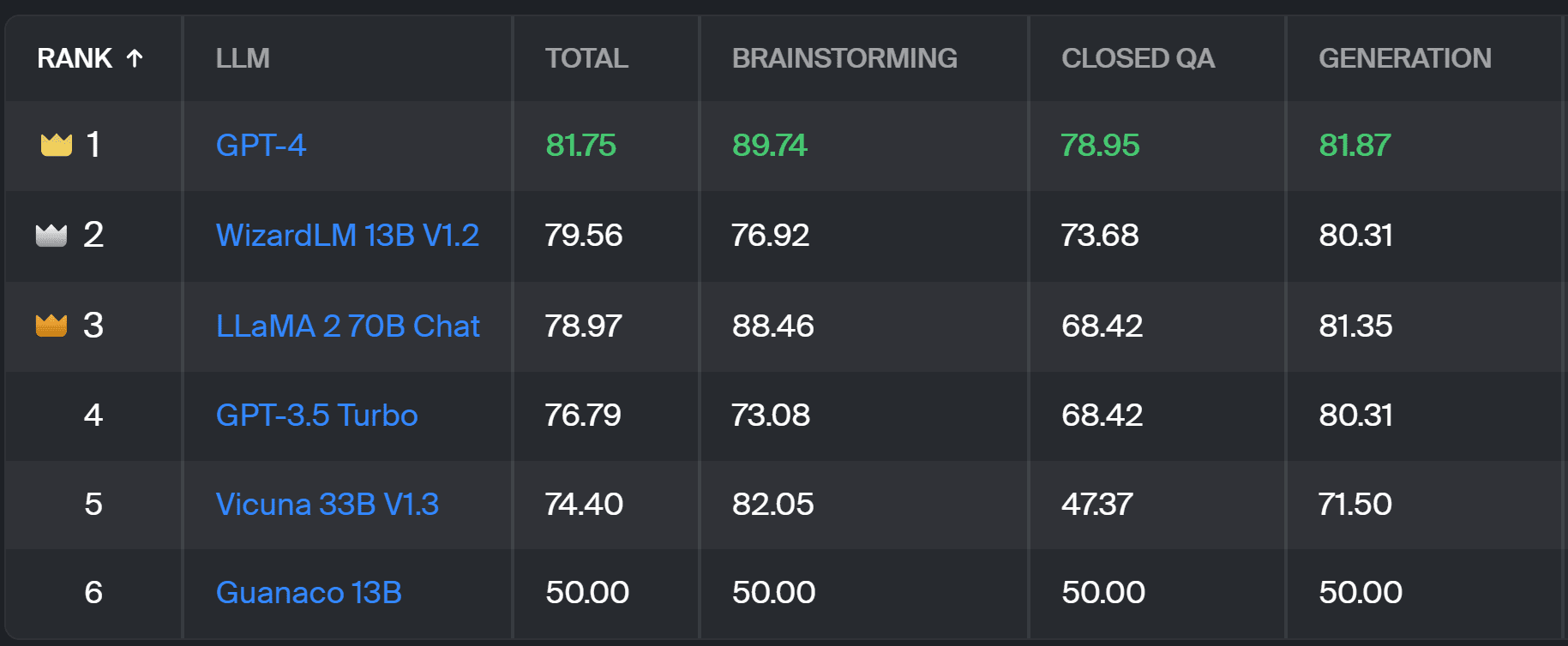

روشهای ارزیابی LLM همچنان که جامعه هوش مصنوعی به دنبال رویکردهای آسان، منصفانه و مقیاسپذیر است، به تکامل خود ادامه میدهد. آخرین پیشرفت از تیم تولوکا با یک جدید است رهبران برای پیشرفت بیشتر استانداردهای ارزیابی فعلی.

جدید رهبران پاسخهای مدل را با درخواستهای کاربر در دنیای واقعی که بر اساس وظایف مفید NLP طبقهبندی میشوند، مقایسه میکند. این مقاله InstructGPT. همچنین میزان برد کلی هر مدل را در همه دسته ها نشان می دهد.

تابلوی امتیازات Toloka - اسکرین شات توسط نویسنده

ارزیابی مورد استفاده برای این پروژه مشابه ارزیابی انجام شده در AlpacaEval است. نمرات در تابلوی امتیازات نشان دهنده نرخ برد مدل مربوطه در مقایسه با گواناکو 13 بی مدل، که در اینجا به عنوان یک مقایسه پایه عمل می کند. انتخاب Guanaco 13B بهبود روش AlpacaEval است که از مدل text-davinci-003 که به زودی منسوخ می شود به عنوان خط پایه استفاده می کند.

ارزیابی واقعی توسط حاشیه نویسان متخصص انسانی در مجموعه ای از اعلان های دنیای واقعی انجام می شود. برای هر درخواست، به حاشیه نویسان دو تکمیل داده می شود و از آنها سوال می شود که کدام یک را ترجیح می دهند. می توانید جزئیات مربوط به روش را بیابید اینجا کلیک نمایید.

این نوع ارزیابی انسانی مفیدتر از هر روش ارزیابی خودکار دیگری است و باید در ارزیابی انسانی مورد استفاده برای آن بهبود یابد جدول امتیازات LMSYS. نقطه ضعف روش LMSYS این است که هر کسی که با پیوند می تواند در ارزیابی شرکت کند و سؤالات جدی در مورد کیفیت داده های جمع آوری شده به این روش ایجاد کند. گروهی بسته از حاشیه نویسان خبره پتانسیل بهتری برای نتایج قابل اعتماد دارند و Toloka از تکنیک های کنترل کیفیت اضافی برای اطمینان از کیفیت داده ها استفاده می کند.

در این مقاله، ما یک راه حل نویدبخش جدید برای ارزیابی LLM ها معرفی کرده ایم - Toloka Leaderboard. این رویکرد نوآورانه است، نقاط قوت روشهای موجود را ترکیب میکند، جزئیات مربوط به کار را اضافه میکند و از تکنیکهای حاشیهنویسی انسانی قابل اعتماد برای مقایسه مدلها استفاده میکند.

هیئت مدیره را بررسی کنید و نظرات و پیشنهادات خود را برای بهبود با ما در میان بگذارید.

ماگدالنا کونکیویچ مبشر داده در Toloka است، یک شرکت جهانی که از توسعه سریع و مقیاس پذیر هوش مصنوعی پشتیبانی می کند. او دارای مدرک کارشناسی ارشد در هوش مصنوعی از دانشگاه ادینبورگ است و به عنوان مهندس NLP، توسعه دهنده و دانشمند داده برای تجارت در اروپا و آمریکا کار کرده است. او همچنین در آموزش و راهنمایی دانشمندان داده شرکت داشته و به طور منظم در انتشارات علم داده و یادگیری ماشین مشارکت دارد.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- منبع: https://www.kdnuggets.com/a-better-way-to-evaluate-llms?utm_source=rss&utm_medium=rss&utm_campaign=a-better-way-to-evaluate-llms

- : دارد

- :است

- :نه

- :جایی که

- $UP

- 17

- a

- توانایی

- درباره ما

- بالاتر

- در میان

- واقعی

- واقعا

- اضافی

- می افزاید:

- پیشرفت

- پیشرفت

- AI

- معرفی

- همچنین

- امریکا

- an

- و

- پاسخ

- پاسخ

- هر

- اعمال میشود

- روش

- رویکردها

- هستند

- عرصه

- مقاله

- مصنوعی

- هوش مصنوعی

- AS

- At

- اتوماتیک

- مطلع

- b

- خط مقدم

- BE

- زیرا

- بوده

- بهتر

- تعصبات

- بزرگترین

- تخته

- بدن

- آورده

- کسب و کار

- اما

- by

- CAN

- توانا

- مورد

- دسته

- به چالش

- چک

- انتخاب

- طبقه بندی

- واضح

- بسته

- ترکیب

- می آید

- انجمن

- شرکت

- مقايسه كردن

- مقایسه

- مقایسه

- مقایسه

- اجماع

- محتوا

- تولید محتوا

- مداوم

- کمک می کند

- کنترل

- گفتگو

- مطابقت دارد

- ایجاد شده

- ایجاد

- جمعیت

- سرپرستی

- جاری

- داده ها

- کیفیت داده

- علم اطلاعات

- دانشمند داده

- مجموعه داده ها

- تصمیم گیری

- تعریف

- درجه

- جزئیات

- توسعه دهنده

- پروژه

- تفاوت

- مختلف

- بی بهره

- مختلف

- do

- میکند

- عمل

- انجام شده

- آیا

- نزولی

- هر

- ساده

- ادینبورگ

- اثر

- تلاش

- الکترولیت ها

- مهندس

- اطمینان حاصل شود

- اروپا

- ارزیابی

- ارزیابی

- ارزیابی

- ارزیابی

- رسوایی

- تکامل یابد

- معاینه کردن

- مثال

- موجود

- انتظار می رود

- کارشناس

- حقایق

- منصفانه

- FAST

- توجه

- امکانات

- پیدا کردن

- نام خانوادگی

- برای

- فرم

- چهار

- رایگان

- از جانب

- بیشتر

- افزایش

- جمع آوری

- مولد

- مولد

- دریافت کنید

- GitHub

- داده

- جهانی

- خوب

- افرین

- سخت

- سخت تر

- آیا

- اینجا کلیک نمایید

- خیلی

- دارای

- چگونه

- HTTPS

- صورت در آغوش گرفته

- انسان

- مهم

- بهبود

- بهبود

- ارتقاء

- را بهبود می بخشد

- in

- اطلاعات

- اول

- ابتکاری

- اطلاعات

- جالب

- معرفی

- معرفی می کند

- گرفتار

- IT

- ITS

- کار

- تنها

- فقط یکی

- kdnuggets

- دانستن

- عدم

- زبان

- بزرگ

- آخرین

- یادگیری

- بهره برداری

- سبک

- دیگر

- خاموش

- دستگاه

- فراگیری ماشین

- نگهداری

- باعث می شود

- روش

- توده

- استاد

- ممکن است..

- آموزش

- روش

- روش شناسی

- روش

- متری

- مدل

- مدل

- بیش

- اکثر

- عضله

- نیاز

- جدید

- راه حل جدید

- nlp

- of

- بزرگتر

- on

- ONE

- باز کن

- دیدگاه ها

- دیگر

- مشخص شده

- به طور کلی

- بخش

- انجام دادن

- کارایی

- انجام

- افلاطون

- هوش داده افلاطون

- PlatoData

- پتانسیل

- ترجیح می دهند

- قبلا

- شاید

- مشکل

- مشکلات

- روند

- پروژه

- امید بخش

- پرسیدن

- به درستی

- ارائه

- انتشارات

- کیفیت

- سوال

- سوالات

- بالا بردن

- نرخ

- دنیای واقعی

- به طور منظم

- قابل اعتماد

- جایگزین

- گزارش

- نشان دادن

- قابل احترام

- پاسخ

- پاسخ

- نتیجه

- نتایج

- طلوع

- دویدن

- s

- مقیاس پذیر

- مقیاس

- علم

- دانشمند

- دانشمندان

- نمرات

- به ثمر رساندن

- جستجو

- به نظر می رسد

- مشاهده گردید

- جدی

- خدمت

- تنظیم

- چند

- اشتراک گذاری

- او

- باید

- نشان داده شده

- نشان می دهد

- طرف

- مشابه

- تنها

- راه حل

- حل کردن

- برخی از

- گاهی

- خاص

- سرعت

- استاندارد

- استانداردهای

- نقاط قوت

- چنین

- حمایت از

- گرفتن

- وظایف

- تعلیم

- تیم

- تکنیک

- آزمون

- متن

- نسبت به

- که

- La

- شان

- آنها

- آنجا.

- اینها

- آنها

- این

- به

- اعتماد

- دو

- نوع

- به طور معمول

- دانشگاه

- بر

- us

- استفاده

- استفاده کنید

- مورد استفاده

- استفاده

- کاربر

- استفاده

- با استفاده از

- معمول

- تنوع

- مسیر..

- we

- ضعف

- خوب

- معروف

- بود

- چی

- چه شده است

- که

- پیروزی

- با

- در داخل

- مشغول به کار

- شما

- شما

- زفیرنت

![نحوه سرعت بخشیدن به پرس و جوهای SQL با استفاده از ایندکس ها [نسخه پایتون] - KDnuggets](https://platoaistream.com/wp-content/uploads/2023/08/how-to-speed-up-sql-queries-using-indexes-python-edition-kdnuggets-300x169.png)