این یک پست مهمان توسط AK Roy از Qualcomm AI است.

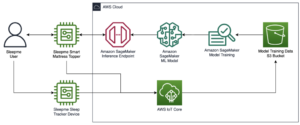

ابر محاسباتی الاستیک آمازون (Amazon EC2) نمونههای DL2q که توسط شتابدهندههای Qualcomm AI 100 Standard ارائه میشوند، میتوانند برای استقرار مقرونبهصرفه بارهای کاری یادگیری عمیق (DL) در فضای ابری استفاده شوند. همچنین میتوان از آنها برای توسعه و اعتبارسنجی عملکرد و دقت بارهای کاری DL که در دستگاههای Qualcomm مستقر میشوند، استفاده کرد. نمونههای DL2q اولین نمونههایی هستند که فناوری هوش مصنوعی (AI) کوالکام را به فضای ابری آوردهاند.

با هشت شتاب دهنده Qualcomm AI 100 Standard و 128 گیگا بایت حافظه کل شتاب دهنده، مشتریان همچنین می توانند از نمونه های DL2q برای اجرای برنامه های کاربردی AI مولد محبوب مانند تولید محتوا، خلاصه سازی متن و دستیارهای مجازی و همچنین برنامه های هوش مصنوعی کلاسیک برای پردازش زبان طبیعی استفاده کنند. و بینایی کامپیوتری علاوه بر این، شتابدهندههای Qualcomm AI 100 از همان فناوری هوش مصنوعی استفاده شده در گوشیهای هوشمند، رانندگی خودکار، رایانههای شخصی و هدستهای واقعیت توسعهیافته بهره میبرند، بنابراین میتوان از نمونههای DL2q برای توسعه و اعتبارسنجی این حجمهای کاری هوش مصنوعی قبل از استقرار استفاده کرد.

نکات برجسته نمونه جدید DL2q

هر نمونه DL2q دارای هشت شتابدهنده Qualcomm Cloud AI100 است، با عملکرد کلی بیش از 2.8 PetaOps عملکرد استنتاج Int8 و 1.4 PetaFlops عملکرد استنتاج FP16. این نمونه دارای مجموع 112 هسته هوش مصنوعی، ظرفیت حافظه شتاب دهنده 128 گیگابایت و پهنای باند حافظه 1.1 ترابایت بر ثانیه است.

هر نمونه DL2q دارای 96 vCPU، ظرفیت حافظه سیستم 768 گیگابایت است و از پهنای باند شبکه 100 گیگابیت بر ثانیه و همچنین پشتیبانی می کند. فروشگاه بلوک الاستیک آمازون (Amazon EBS) ذخیره سازی 19 گیگابیت بر ثانیه

| نام نمونه | vCPU ها | شتاب دهنده های Cloud AI100 | حافظه شتاب دهنده | حافظه شتاب دهنده BW (تجمیع شده) | حافظه نمونه | شبکه سازی نمونه | پهنای باند ذخیره سازی (Amazon EBS). |

| DL2q.24xlarge | 96 | 8 | 128 GB | 1.088 TB / s | 768 GB | 100 Gbps | 19 Gbps |

نوآوری شتاب دهنده Qualcomm Cloud AI100

سیستم روی تراشه شتاب دهنده Cloud AI100 (SoC) یک معماری چند هسته ای مقیاس پذیر و هدفمند است که از طیف گسترده ای از موارد استفاده یادگیری عمیق از مرکز داده تا لبه پشتیبانی می کند. SoC از هستههای محاسباتی اسکالر، برداری، و تانسور با ظرفیت SRAM پیشرو در صنعت 126 مگابایت استفاده میکند. هسته ها با یک شبکه شبکه روی تراشه (NoC) با تاخیر کم با پهنای باند بالا به هم متصل می شوند.

شتاب دهنده AI100 از طیف گسترده و جامعی از مدل ها و موارد استفاده پشتیبانی می کند. جدول زیر دامنه پشتیبانی مدل را نشان می دهد.

| دسته مدل | تعدادی از مدل های | نمونه ها |

| NLP | 157 | BERT، BART، FasterTransformer، T5، Z-code MOE |

| هوش مصنوعی مولد – NLP | 40 | LLaMA، CodeGen، GPT، OPT، BLOOM، Jais، Luminous، StarCoder، XGen |

| هوش مصنوعی مولد - تصویر | 3 | Stable diffusion v1.5 و v2.1، OpenAI CLIP |

| CV - طبقه بندی تصویر | 45 | ViT، ResNet، ResNext، MobileNet، EfficientNet |

| CV - تشخیص شی | 23 | YOLO v2، v3، v4، v5 و v7، SSD-ResNet، RetinaNet |

| CV - سایر موارد | 15 | LPRNet، سوپر رزولوشن/SRGAN، ByteTrack |

| شبکه های خودرویی* | 53 | درک و تشخیص LIDAR، عابر پیاده، خط و چراغ راهنمایی |

| جمع | > 300 | |

* بیشتر شبکه های خودرو، شبکه های ترکیبی هستند که از تلفیقی از شبکه های منفرد تشکیل شده اند.

SRAM بزرگ روی شتاب دهنده DL2q اجرای کارآمد تکنیک های عملکردی پیشرفته مانند دقت میکرو نمای MX6 برای ذخیره وزن ها و دقت میکرو نمای MX9 برای ارتباط شتاب دهنده به شتاب دهنده را امکان پذیر می کند. فناوری ریزنما در اعلامیه صنعتی پروژه محاسبات باز (OCP) زیر توضیح داده شده است: AMD، Arm، Intel، Meta، Microsoft، NVIDIA و Qualcomm فرمتهای دادههای دقیق باریک نسل بعدی را برای هوش مصنوعی استاندارد میکنند » Open Compute Project.

کاربر نمونه می تواند از استراتژی زیر برای به حداکثر رساندن عملکرد به ازای هزینه استفاده کند:

- وزن ها را با استفاده از دقت ریزنما MX6 در حافظه DDR روی شتاب دهنده ذخیره کنید. استفاده از دقت MX6، استفاده از ظرفیت حافظه موجود و پهنای باند حافظه را برای ارائه بهترین توان عملیاتی و تأخیر در کلاس به حداکثر میرساند.

- در FP16 محاسبه کنید تا دقت مورد نیاز مورد نیاز را ارائه کنید، در حالی که از SRAM روی تراشه برتر و TOPهای یدکی روی کارت استفاده میکنید، تا هستههای MX6 با تأخیر پایین با کارایی بالا را در FP16 پیادهسازی کنید.

- با استفاده از SRAM روی تراشه بزرگ موجود برای به حداکثر رساندن استفاده مجدد از وزن ها، در حالی که فعال سازی های روی تراشه را تا حداکثر ممکن حفظ می کنید، از یک استراتژی دسته بندی بهینه و اندازه دسته بالاتر استفاده کنید.

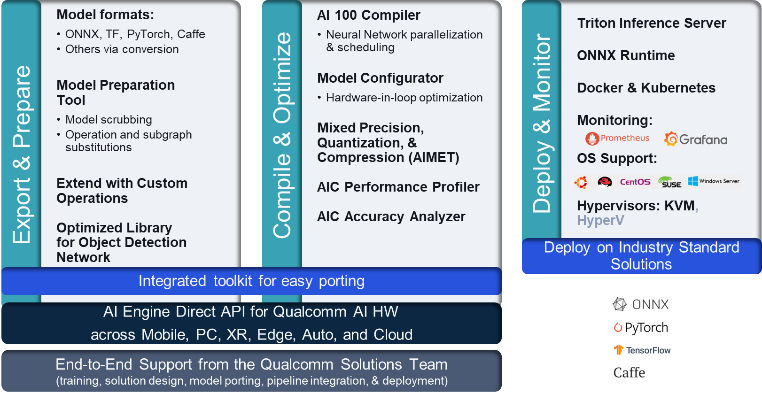

پشته و زنجیره ابزار DL2q AI

نمونه DL2q با Qualcomm AI Stack همراه است که یک تجربه توسعهدهنده ثابت را در سراسر Qualcomm AI در فضای ابری و سایر محصولات Qualcomm ارائه میدهد. همان پشته و فناوری هوش مصنوعی پایه Qualcomm روی نمونههای DL2q و دستگاههای Qualcomm edge اجرا میشود و یک تجربه توسعهدهنده ثابت را با یک API یکپارچه در محیطهای ابر، خودرو، رایانه شخصی، واقعیت توسعهیافته و محیطهای توسعه گوشیهای هوشمند به مشتریان ارائه میدهد.

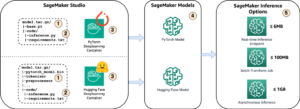

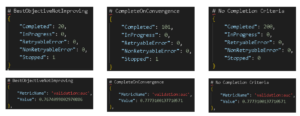

زنجیره ابزار کاربر نمونه را قادر میسازد تا به سرعت مدلی را که قبلاً آموزش دیده است، کامپایل و مدل را برای قابلیتهای نمونه بهینهسازی کند، و متعاقباً مدلهای کامپایلشده را برای موارد استفاده استنتاج تولید در سه مرحله نشانداده شده در شکل زیر استقرار دهد.

برای کسب اطلاعات بیشتر در مورد تنظیم عملکرد یک مدل، به ادامه مطلب مراجعه کنید پارامترهای کلیدی عملکرد Cloud AI 100 مستندات.

با نمونه های DL2q شروع کنید

در این مثال، شما یک از پیش آموزش دیده را کامپایل و مستقر می کنید مدل BERT از جانب در آغوش کشیدن صورت در یک نمونه EC2 DL2q با استفاده از یک DL2q AMI از پیش ساخته شده، در چهار مرحله.

شما می توانید از هر یک از پیش ساخته شده استفاده کنید Qualcomm DLAMI به عنوان مثال یا با آمازون Linux2 AMI شروع کنید و DL2q AMI خود را با پلتفرم Cloud AI 100 و Apps SDK موجود در این بسازید. سرویس ذخیره سازی ساده آمازون (Amazon S3) سطل: s3://ec2-linux-qualcomm-ai100-sdks/latest/.

مراحل بعدی از DL2q AMI از پیش ساخته شده استفاده می کنند. Qualcomm Base AL2 DLAMI.

از SSH برای دسترسی به نمونه DL2q با Qualcomm Base AL2 DLAMI AMI استفاده کنید و مراحل 1 تا 4 را دنبال کنید.

مرحله 1. محیط را تنظیم و بسته های مورد نیاز را نصب کنید

- پایتون 3.8 را نصب کنید.

- محیط مجازی پایتون 3.8 را راه اندازی کنید.

- محیط مجازی پایتون 3.8 را فعال کنید.

- بسته های مورد نیاز را که در نشان داده شده است نصب کنید سند requirement.txt در سایت Github عمومی Qualcomm موجود است.

- کتابخانه های لازم را وارد کنید.

مرحله 2. مدل را وارد کنید

- مدل را وارد و توکن کنید.

- یک ورودی نمونه تعریف کنید و آن را استخراج کنید

inputIdsوattentionMask. - مدل را به ONNX تبدیل کنید، که سپس می تواند به کامپایلر ارسال شود.

- شما مدل را با دقت FP16 اجرا خواهید کرد. بنابراین، باید بررسی کنید که آیا مدل دارای ثابت هایی فراتر از محدوده FP16 است یا خیر. مدل را به

fix_onnx_fp16برای تولید فایل ONNX جدید با اصلاحات مورد نیاز.

مرحله 3. مدل را کامپایل کنید

La qaic-exec ابزار کامپایلر رابط خط فرمان (CLI) برای کامپایل مدل استفاده می شود. ورودی این کامپایلر فایل ONNX تولید شده در مرحله 2 است. کامپایلر یک فایل باینری تولید می کند (به نام QPC، برای ظرف برنامه کوالکام) در مسیری که توسط -aic-binary-dir بحث و جدل.

در دستور کامپایل زیر، شما از چهار هسته محاسباتی هوش مصنوعی و اندازه دسته ای یک برای کامپایل مدل استفاده می کنید.

QPC در تولید می شود bert-base-cased/generatedModels/bert-base-cased_fix_outofrange_fp16_qpc پوشه.

مرحله 4. مدل را اجرا کنید

یک جلسه برای اجرای استنتاج بر روی یک شتاب دهنده Cloud AI100 Qualcomm در نمونه DL2q تنظیم کنید.

کتابخانه Qualcomm qaic Python مجموعهای از API است که از اجرای استنتاج در شتابدهنده Cloud AI100 پشتیبانی میکند.

- از فراخوانی Session API برای ایجاد یک نمونه از session استفاده کنید. فراخوانی Session API نقطه ورود به استفاده از کتابخانه qaic Python است.

- تغییر ساختار داده از بافر خروجی با

output_shapeوoutput_type. - خروجی تولید شده را رمزگشایی کنید.

در اینجا خروجی های جمله ورودی "سگ [ماسک] روی تشک" آمده است.

خودشه. تنها با چند مرحله، یک مدل PyTorch را در یک نمونه Amazon EC2 DL2q کامپایل و اجرا کردید. برای کسب اطلاعات بیشتر در مورد نصب و کامپایل کردن مدلها در نمونه DL2q، به ادامه مطلب مراجعه کنید مستندات آموزشی Cloud AI100.

برای کسب اطلاعات بیشتر در مورد اینکه کدام معماری مدل DL برای نمونه های AWS DL2q و ماتریس پشتیبانی مدل فعلی مناسب هستند، به بخش مراجعه کنید. اسناد Qualcomm Cloud AI100.

اکنون در دسترس

شما می توانید نمونه های DL2q را امروز در مناطق غرب ایالات متحده (اورگان) و اروپا (فرانکفورت) AWS راه اندازی کنید. بر اساس تقاضا, رزرو شدهو موارد نقطه ای، یا به عنوان بخشی از a طرح پس انداز. طبق معمول آمازون EC2، شما فقط برای آنچه استفاده می کنید هزینه می پردازید. برای اطلاعات بیشتر ببین قیمت آمازون EC2.

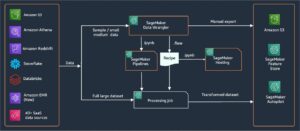

نمونه های DL2q را می توان با استفاده از آن مستقر کرد AMI های یادگیری عمیق AWS (DLAMI)، و تصاویر کانتینر از طریق سرویس های مدیریت شده مانند آمازون SageMaker, Amazon Elastic Kubernetes Service (Amazon EKS), سرویس کانتینر الاستیک آمازون (Amazon ECS)و AWS ParallelCluster.

برای کسب اطلاعات بیشتر، از نمونه آمازون EC2 DL2q صفحه، و ارسال بازخورد به AWS re: ارسال برای EC2 یا از طریق مخاطبین معمولی پشتیبانی AWS شما.

درباره نویسندگان

ای کی روی مدیر مدیریت محصول در Qualcomm برای محصولات و راه حل های Cloud و Datacenter AI است. او بیش از 20 سال تجربه در استراتژی و توسعه محصول، با تمرکز فعلی بر بهترین عملکرد و عملکرد در کلاس / راه حل های انتها به انتها برای استنتاج هوش مصنوعی در فضای ابری، برای طیف وسیعی از موارد استفاده دارد. از جمله GenAI، LLMs، Auto و Hybrid AI.

ای کی روی مدیر مدیریت محصول در Qualcomm برای محصولات و راه حل های Cloud و Datacenter AI است. او بیش از 20 سال تجربه در استراتژی و توسعه محصول، با تمرکز فعلی بر بهترین عملکرد و عملکرد در کلاس / راه حل های انتها به انتها برای استنتاج هوش مصنوعی در فضای ابری، برای طیف وسیعی از موارد استفاده دارد. از جمله GenAI، LLMs، Auto و Hybrid AI.

جیانیینگ لانگ یک معمار اصلی راه حل در سازمان تخصصی جهانی AWS (WWSO) است. او بیش از 15 سال تجربه کاری در زمینه HPC و AI دارد. در AWS، او بر کمک به مشتریان برای استقرار، بهینهسازی و مقیاسبندی حجم کاری AI/ML خود بر روی نمونههای محاسباتی تسریعشده تمرکز میکند. او علاقه زیادی به ترکیب تکنیک ها در زمینه های HPC و AI دارد. جیانینگ دارای مدرک دکترا در فیزیک محاسباتی از دانشگاه کلرادو در بولدر است.

جیانیینگ لانگ یک معمار اصلی راه حل در سازمان تخصصی جهانی AWS (WWSO) است. او بیش از 15 سال تجربه کاری در زمینه HPC و AI دارد. در AWS، او بر کمک به مشتریان برای استقرار، بهینهسازی و مقیاسبندی حجم کاری AI/ML خود بر روی نمونههای محاسباتی تسریعشده تمرکز میکند. او علاقه زیادی به ترکیب تکنیک ها در زمینه های HPC و AI دارد. جیانینگ دارای مدرک دکترا در فیزیک محاسباتی از دانشگاه کلرادو در بولدر است.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- منبع: https://aws.amazon.com/blogs/machine-learning/amazon-ec2-dl2q-instance-for-cost-efficient-high-performance-ai-inference-is-now-generally-available/

- : دارد

- :است

- $UP

- 1

- 1 TB

- 10

- 100

- 11

- 12

- 13

- سال 15

- ٪۱۰۰

- 17

- 19

- 20

- سال 20

- 22

- 23

- 46

- 7

- 75

- 8

- 84

- a

- درباره ما

- بالاتر

- تسریع شد

- شتاب دهنده

- شتاب دهنده ها

- دسترسی

- همراه

- دقت

- در میان

- فعال سازی ها

- علاوه بر این

- پیشرفته

- تجمیع

- AI

- AI / ML

- معرفی

- همچنین

- آمازون

- آمازون EC2

- آمازون خدمات وب

- an

- و

- خبر

- هر

- API

- رابط های برنامه کاربردی

- برنامه های کاربردی

- برنامه های

- معماری

- هستند

- استدلال

- ARM

- مصنوعی

- AS

- دستیاران

- At

- خودکار

- خودرو

- خود مختار

- در دسترس

- AWS

- تبرها

- پهنای باند

- پایه

- دسته

- BE

- قبل از

- در زیر

- خارج از

- BIN

- مسدود کردن

- شکوفه

- به ارمغان بیاورد

- پهن

- بافر

- ساختن

- by

- صدا

- نام

- CAN

- قابلیت های

- ظرفیت

- کارت

- مورد

- بررسی

- کلاسیک

- ابر

- کلرادو

- ترکیب

- ارتباط

- وارد

- جامع

- محاسباتی

- محاسبه

- کامپیوتر

- چشم انداز کامپیوتر

- کامپیوتر

- محاسبه

- استوار

- شامل

- اطلاعات تماس

- ظرف

- شامل

- محتوا

- ایجاد

- جاری

- مشتریان

- داده ها

- مرکز داده

- عمیق

- یادگیری عمیق

- مشخص

- درجه

- ارائه

- ارائه

- گسترش

- مستقر

- گسترش

- شرح داده شده

- توسعه

- توسعه دهنده

- پروژه

- دستگاه

- دستگاه ها

- انتشار

- مدیر

- مستندات

- سگ

- رانندگی

- پویا

- ebs

- لبه

- موثر

- هر دو

- کار می کند

- را قادر می سازد

- پشت سر هم

- ورود

- محیط

- محیط

- اتر (ETH)

- اروپا

- مثال

- تجربه

- واقعیت گسترده

- عصاره

- غلط

- ویژگی

- باز خورد

- کمی از

- رشته

- زمینه

- شکل

- پرونده

- نام خانوادگی

- مناسب

- ثابت

- تمرکز

- تمرکز

- به دنبال

- پیروی

- برای

- یافت

- چهار

- فرانکفورت

- از جانب

- تابع

- ادغام

- عموما

- تولید می کنند

- تولید

- نسل

- مولد

- هوش مصنوعی مولد

- GitHub

- داده

- خوب

- مهمان

- پست مهمان

- he

- هدست

- کمک

- اینجا کلیک نمایید

- عملکرد بالا

- بالاتر

- های لایت

- دارای

- hpc

- HTML

- HTTPS

- ترکیبی

- i

- IDX

- if

- تصویر

- تصاویر

- انجام

- پیاده سازی

- واردات

- in

- از جمله

- شامل

- فرد

- صنعت

- پیشرو در صنعت

- اطلاعات

- ورودی

- نصب

- نمونه

- نمونه ها

- اینتل

- هوشمند

- به هم پیوسته

- رابط

- IT

- JPG

- تنها

- کلید

- کوبرنیتس

- لین

- زبان

- بزرگ

- تاخیر

- راه اندازی

- یاد گرفتن

- یادگیری

- کتابخانه ها

- کتابخانه

- برخورد

- سبک

- لاین

- بارهای

- اداره می شود

- مدیریت

- ماسک

- ماتریس

- حداکثر

- بیشینه ساختن

- به حداکثر می رسد

- بیشترین

- حافظه

- مش

- متا

- مایکروسافت

- دقیقه

- مدل

- مدل

- اصلاح شده

- بیش

- اکثر

- نام

- طبیعی

- زبان طبیعی

- پردازش زبان طبیعی

- لازم

- نیاز

- شبکه

- شبکه

- شبکه

- جدید

- نسل بعدی

- اکنون

- بی حس

- کارت گرافیک Nvidia

- هدف

- of

- on

- پردازنده

- شبانه روزی

- ONE

- فقط

- باز کن

- OpenAI

- بهینه سازی

- بهینه

- or

- اورگان

- کدام سازمان ها

- OS

- دیگر

- خارج

- تولید

- خروجی

- روی

- خود

- بسته

- با ما

- بخش

- عبور

- گذشت

- احساساتی

- مسیر

- پرداخت

- برای

- کارایی

- شخصی

- کامپیوترهای شخصی

- دکترا

- فیزیک

- سکو

- افلاطون

- هوش داده افلاطون

- PlatoData

- نقطه

- محبوب

- ممکن

- پست

- صفحه اصلی

- دقت

- قبلا

- اصلی

- در حال پردازش

- ساخته

- تولید می کند

- محصول

- مدیریت تولید

- تولید

- محصولات

- برنامه

- پروژه

- فراهم می کند

- ارائه

- عمومی

- پــایتــون

- مارماهی

- کوالکام

- به سرعت

- محدوده

- RE

- مطالعه

- واقعیت

- مناطق

- ضروری

- مورد نیاز

- حفظ

- برگشت

- استفاده مجدد

- روی

- دویدن

- در حال اجرا

- اجرا می شود

- همان

- ذخیره

- صرفه جویی کردن

- مقیاس پذیر

- مقیاس

- sdk

- دوم

- دیدن

- ارسال

- جمله

- دنباله

- سرویس

- خدمات

- جلسه

- تنظیم

- او

- نشان داده شده

- ساده

- ساده کردن

- سایت

- اندازه

- گوشی های هوشمند

- گوشی های هوشمند

- So

- مزایا

- تنش

- متخصص

- پشته

- استاندارد

- شروع

- آغاز شده

- گام

- مراحل

- ذخیره سازی

- opbevare

- استراتژی

- متعاقبا

- چنین

- برتر

- پشتیبانی

- حمایت از

- پشتیبانی از

- سیستم

- جدول

- تکنیک

- پیشرفته

- متن

- که

- La

- شان

- سپس

- اینها

- آنها

- این

- سه

- از طریق

- توان

- از طریق

- به

- امروز

- tokenize

- ابزار

- تاپس

- مشعل

- جمع

- ترافیک

- آموزش دیده

- ترانسفورماتور

- درست

- آموزش

- یکپارچه

- دانشگاه

- us

- استفاده کنید

- مورد استفاده

- موارد استفاده

- استفاده

- کاربر

- با استفاده از

- معمول

- v1

- VAL

- تصدیق

- ارزش

- مجازی

- دید

- بازدید

- we

- وب

- خدمات وب

- خوب

- غرب

- چی

- که

- در حین

- وسیع

- دامنه گسترده

- اراده

- با

- کلمه

- کارگر

- در سرتاسر جهان

- سال

- شما

- شما

- زفیرنت