جی دوانی یکی از بنیانگذاران و مدیرعامل در آزمایشگاه لموریان، یک استارتاپ در حال توسعه یک پلت فرم محاسباتی شتابنده که به طور خاص برای برنامه های کاربردی هوش مصنوعی طراحی شده است. این پلتفرم موانع سخت افزاری را می شکند تا توسعه هوش مصنوعی را سریع تر، ارزان تر، پایدارتر و برای بیش از چند شرکت در دسترس قرار دهد.

قبل از تأسیس Lemurian، جی دو شرکت دیگر در فضای هوش مصنوعی تأسیس کرد. او همچنین نویسنده کتاب های دارای رتبه برترریاضیات برای یادگیری عمیق"

جی که متخصص در زمینه هوش مصنوعی، رباتیک و ریاضیات است، بهعنوان مدیر ارشد فناوری BlockPlay، یک شرکت عمومی که یک پلتفرم بازی مبتنی بر بلاک چین را ایجاد میکند، خدمت کرده و بهعنوان مدیر هوش مصنوعی در GEC خدمت کرده است، جایی که او توسعه چندین پروژه مشتری را در حوزههای مختلف رهبری میکند. از خرده فروشی، تجارت الگوریتمی، تاشو پروتئین، ربات های اکتشاف فضایی، سیستم های توصیه و غیره. او همچنین در اوقات فراغت خود مشاور در آزمایشگاه توسعه مرزی ناسا، Spacebit و SiaClassic بوده است.

آخرین باری که ما آزمایشگاههای Lemurian را معرفی کردیم، شما روی رباتیک و هوش مصنوعی لبهای تمرکز داشتید. اکنون روی مرکز داده و زیرساخت ابری متمرکز شده اید. چه اتفاقی افتاد که باعث شد بخواهید پیوت کنید؟

در واقع، ما از تمرکز بر ساختن یک سیستم روی تراشه با کارایی بالا، تأخیر کم، برای برنامههای روباتیک مستقل که میتواند کل حلقه حسی-طرح-عملی را تسریع بخشد، به ساختن یک شتابدهنده دامنه خاص برای هوش مصنوعی با تمرکز بر برنامههای کاربردی در مقیاس مرکز داده انتقال دادیم. . اما این فقط یک محور معمولی نبود. این یک تماس واضح بود که احساس کردیم مسئولیت پاسخگویی به آن را داریم.

در سال 2018، ما روی آموزش یک مدل پارامتری 2.1 میلیارد دلاری کار میکردیم، اما این تلاش را کنار گذاشتیم زیرا هزینه آن به قدری فوقالعاده بالا بود که نمیتوانستیم آن را توجیه کنیم. بنابراین تعجب من را تصور کنید که GPT3، که OpenAI به عنوان ChatGPT در نوامبر 2022 منتشر کرد، یک مدل پارامتری 175 میلیارد دلاری بود. این مدل بیش از 80 برابر بزرگتر از چیزی است که ما فقط 4 سال قبل روی آن کار می کردیم، که هم هیجان انگیز و هم ترسناک است.

هزینه آموزش چنین مدلی دست کم سرسام آور است. بر اساس روند مقیاسبندی فعلی، میتوان انتظار داشت که هزینه آموزش یک مدل هوش مصنوعی مرزی در آینده نه چندان دور از یک میلیارد دلار فراتر رود. در حالی که قابلیت های این مدل ها خیره کننده خواهد بود، هزینه آن به طرز مضحکی بالاست. بر اساس این مسیر، تنها تعداد انگشت شماری از شرکتهای دارای منابع بسیار خوب با مراکز داده خود قادر به آموزش، استقرار و تنظیم دقیق این مدلها خواهند بود. این صرفاً به این دلیل نیست که محاسبات گران است و نیاز به انرژی دارد، بلکه به این دلیل است که پشتههای نرمافزاری که ما به آنها تکیه میکنیم برای این دنیا ساخته نشدهاند.

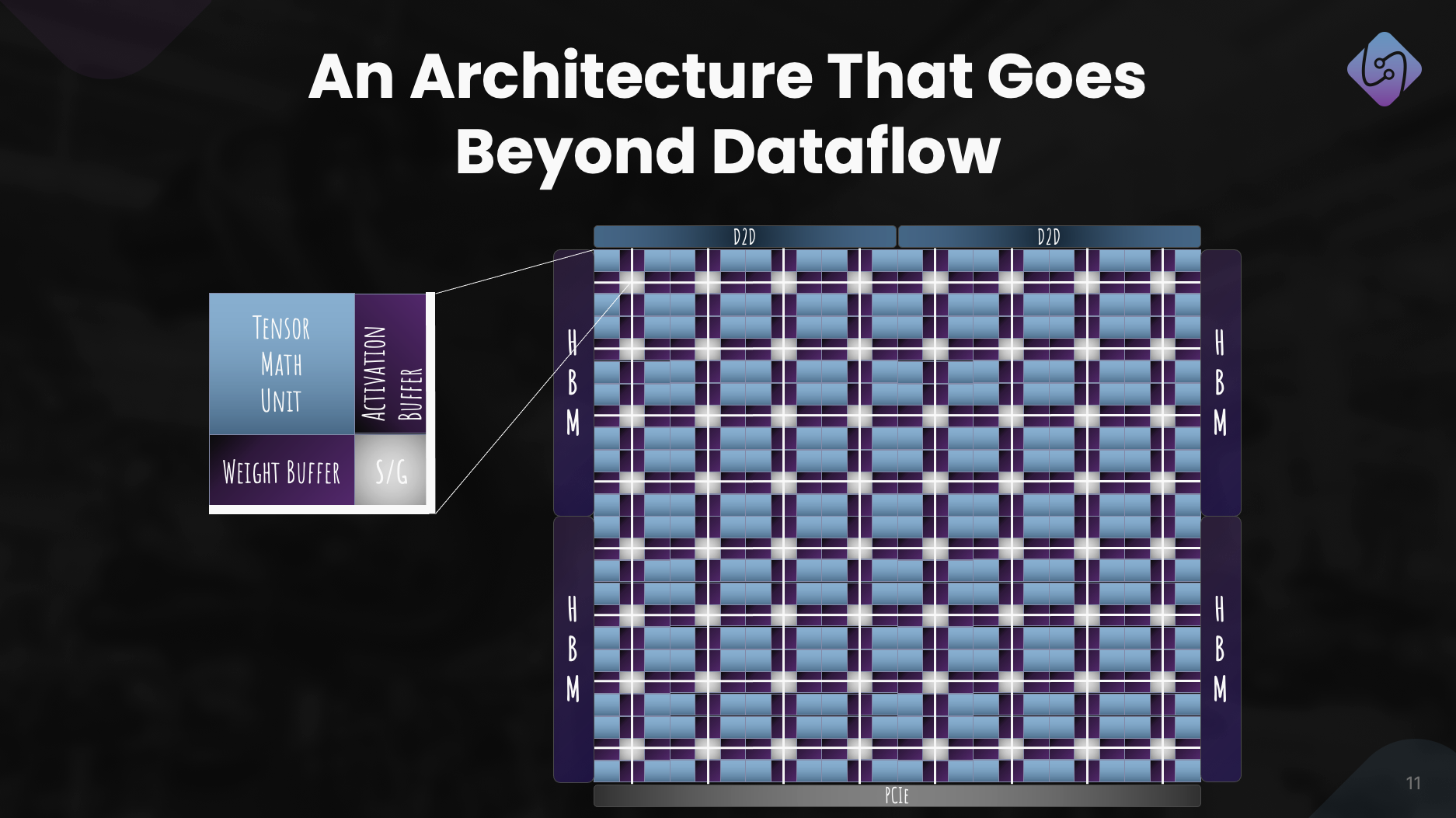

به دلیل محدودیت های جغرافیایی و انرژی، مکان های زیادی برای ساخت دیتاسنتر وجود دارد. برای برآورده کردن نیازهای محاسباتی هوش مصنوعی، باید بتوانیم ماشینهای مقیاس زتا را بدون نیاز به 20 راکتور هستهای برای تامین انرژی آن بسازیم. ما به یک راه حل کاربردی تر، مقیاس پذیرتر و اقتصادی تر نیاز داریم. ما به اطراف نگاه کردیم و کسی را در مسیری برای حل این مشکل ندیدیم. و به این ترتیب، ما به تابلوی طراحی رفتیم تا به صورت کلی به مسئله به عنوان سیستمی از سیستم ها نگاه کنیم و در مورد راه حلی از اصول اولیه استدلال کنیم. ما از خود پرسیدیم، اگر مجبور بودیم روزانه 10 میلیارد جستجوی LLM را به صورت اقتصادی ارائه دهیم، چگونه میتوانیم پشته کامل، از نرمافزار گرفته تا سختافزار را طراحی کنیم. ما تا سال 200 روی یک ماشین مقیاس زتا با توان کمتر از 2028 مگاوات در نظر گرفته ایم.

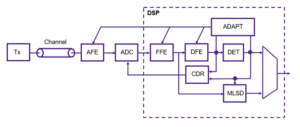

ترفند این است که از نقطه نظر مقیاس نامتناسب به آن نگاه کنید - بخشهای مختلف یک سیستم از قوانین مقیاسبندی متفاوتی پیروی میکنند، بنابراین در برخی مواقع کارها متوقف میشوند، شروع به شکستن میکنند یا اینکه معاوضه با سود هزینه دیگر معنی ندارد. هنگامی که این اتفاق می افتد، تنها گزینه طراحی مجدد سیستم است. ارزیابی و راه حل ما شامل حجم کار، سیستم اعداد، مدل برنامه نویسی، کامپایلر، زمان اجرا و سخت افزار به طور کلی است.

خوشبختانه، سرمایه گذاران فعلی ما و بقیه بازار چشم انداز را می بینند، و ما یک دور اولیه 9 میلیون دلاری جمع آوری کردیم تا قالب شماره خود را توسعه دهیم - PAL، تا فضای طراحی را کاوش کنیم و بر روی یک معماری برای شتاب دهنده خاص دامنه خود همگرایی کنیم، و ما را معمار کنیم. کامپایلر و زمان اجرا در شبیهسازیها، ما توانستهایم به افزایش توان عملیاتی 20 برابری در ردپای انرژی کمتر نسبت به پردازندههای گرافیکی مدرن دست یابیم و پیشبینی میکنیم که بتوانیم منفعت 8 برابری را در عملکرد سیستم برای کل هزینه مالکیت بر روی همان فناوری ترانزیستور ارائه دهیم.

نیازی به گفتن نیست که ما کارهای زیادی در پیش داریم، اما از این که بتوانیم اقتصاد مرکز داده را دوباره تعریف کنیم تا آینده ای را تضمین کنیم که در آن هوش مصنوعی به وفور در دسترس همه باشد، بسیار هیجان زده هستیم.

این مطمئناً هیجان انگیز به نظر می رسد و آن اعداد چشمگیر به نظر می رسند. اما شما سیستمهای عددی، سختافزار، کامپایلرها و زمانهای اجرا را بهعنوان همه مواردی که روی آنها تمرکز کردهاید، ذکر کردهاید – برای هر شرکتی بهنظر میرسد که یکباره آن را به عهده بگیرد. به نظر یک پیشنهاد بسیار خطرناک است. آیا قرار نیست استارتاپ ها تمرکز بیشتری داشته باشند؟

به نظر می رسد تلاش های بسیار متفاوتی باشد، اما در واقع یک تلاش با بسیاری از بخش های به هم پیوسته است. حل تنها یکی از این مؤلفهها جدا از مؤلفههای دیگر، تنها مانع از پتانسیل نوآوری میشود، زیرا منجر به نادیده گرفتن ناکارآمدیها و تنگناهای سیستمی میشود. جنسن هوانگ به بهترین وجه گفت: «برای اینکه یک شرکت محاسباتی شتابدار باشید، باید یک شرکت کامل باشید» و من کاملاً موافقم. آنها به دلایلی رهبر فعلی بازار هستند. اما من این ایده را به چالش می کشم که ما متمرکز نیستیم. تمرکز ما در این است که چگونه به طور کلی درباره مشکل فکر می کنیم و چگونه آن را به بهترین نحو برای مشتریان خود حل کنیم.

انجام این کار نیازمند رویکردی چند رشته ای مانند رویکرد ما است. هر بخش از کار ما به دیگران اطلاع می دهد و از آنها حمایت می کند و ما را قادر می سازد راه حلی ایجاد کنیم که بسیار بیشتر از مجموع اجزای آن باشد. تصور کنید که مجبور به ساخت یک ماشین مسابقه ای هستید. شما خودسرانه یک شاسی را انتخاب نمیکنید، لاستیکهای مسابقه اضافه نمیکنید و قویترین موتوری را که میتوانید پیدا کنید رها نمیکنید و با آن مسابقه نمیدهید، درست است؟ شما می توانید به آیرودینامیک بدنه خودرو برای کاهش درگ و افزایش نیروی رو به پایین، بهینه سازی توزیع وزن برای هندلینگ خوب، طراحی سفارشی موتور برای حداکثر کارایی، دریافت یک سیستم خنک کننده برای جلوگیری از گرمای بیش از حد، تعیین قفس رول برای ایمن نگه داشتن راننده فکر کنید. و غیره. هر یک از این عناصر بر دیگری بنا شده و به دیگری اطلاع می دهد.

با این حال، تلاش برای انجام همه این کارها به یکباره برای هر شرکتی در هر صنعتی خطرناک است. برای مدیریت ریسکها، رویکردی مرحلهای را در پیش گرفتهایم که به ما امکان میدهد فناوری خود را با مشتریان تأیید کرده و استراتژی خود را در صورت نیاز تنظیم کنیم. ما ثابت کردهایم که فرمت اعداد ما کار میکند و این که دارای ناحیه عملکرد بهتری نسبت به انواع ممیز شناور معادل است، در حالی که دارای ویژگیهای عددی بهتری است که کوانتیزه کردن شبکههای عصبی به پهنای بیتهای کوچکتر را آسانتر میکند. ما معماری را طراحی کردهایم که به آن اطمینان داریم و هم برای آموزش و هم برای استنتاج مناسب است. اما مهمتر از همه اینها درست کردن نرم افزار است، و این تمرکز اصلی ماست. ما باید اطمینان حاصل کنیم که تصمیمات درستی را در پشته نرم افزارمان برای جایی که دنیا را یک یا دو سال یا بیشتر از امروز می بینیم، می گیریم.

ساخت یک شرکت سخت افزاری سخت، پرهزینه و زمان زیادی می برد. تمرکز بر نرم افزار ابتدا به تنهایی یک تجارت بسیار قابل دوام به نظر می رسد و به طور بالقوه برای سرمایه گذاران در شرایط فعلی جذاب تر است. چرا با توجه به اینکه بسیاری از شرکتهای دارای بودجه خوب در این فضا درهای خود را میبندند، سختافزاری میکنید، سختافزاری انجام میدهید، و بازیکنان بزرگتر در حال ساخت سختافزار خود هستند؟

شما کاملاً درست میگویید که کسبوکارهای نرمافزاری عموماً توانستهاند خیلی راحتتر از شرکتهای سختافزاری سرمایه جذب کنند، و این سختافزار بسیار سخت است. تمرکز فعلی ما بسیار روی نرم افزار است زیرا مشکل بزرگتر در اینجاست. بگذارید واضح بگویم، مشکل این نیست که آیا میتوانم هستههایی را بر روی یک CPU یا GPU با کارایی بالا اجرا کنم. این یک مشکل طولانی مدت حل شده است مشکل امروز این است که چگونه میتوانیم کارایی بیشتر را برای توسعهدهندگان آسانتر کنیم، بهطور مولد از چندین هزار دسته گره که از محاسبات ناهمگن تشکیل شدهاند، بدون اینکه از آنها بخواهیم گردش کار خود را اصلاح کنند.

این مشکلی است که ما در حال حاضر روی حل آن با یک پشته نرمافزار متمرکز شدهایم که به توسعهدهندگان قدرتهای فوقالعاده میدهد و توانایی کامل رایانههای مقیاس انبار را باز میکند، بنابراین میتوانیم مدلهای هوش مصنوعی را بهطور اقتصادیتر آموزش دهیم و به کار ببریم.

اکنون، در مورد سرمایهگذاری، بله، VCها در نوع شرکتهایی که از آنها حمایت میکنند، گزینشتر هستند، اما این بدان معناست که VCها به دنبال شرکتهایی هستند که پتانسیل ارائه محصولات واقعاً پیشگامانه را داشته باشند که مسیری روشن برای تجاریسازی داشته باشند و در عین حال تأثیر قابلتوجهی داشته باشند. ما از چالش ها و اشتباهات دیگران درس گرفته ایم و به طور فعال مدل کسب و کار و نقشه راه خود را برای مقابله با خطرات طراحی کرده ایم. همچنین مهم است که توجه داشته باشید که آنچه استارتاپ ها را موفق کرده است به ندرت این بوده است که به راحتی می توانند بودجه VC را تامین کنند، بلکه بیشتر به تدبیر، سرسختی و تمرکز بر مشتری مربوط می شود.

و قبل از اینکه بپرسید، ما هنوز روی سخت افزار کار می کنیم، اما در درجه اول در شبیه سازی در حال حاضر. ما قصد نداریم برای مدتی نوار را حذف کنیم. اما می توانیم آن مکالمه را برای زمان دیگری ذخیره کنیم.

این مطمئناً قانعکننده است و رویکرد مرحلهای شما در مقایسه با آنچه که دیگر شرکتهای سختافزاری انجام میدهند بسیار متفاوت است. من مشکلی را که میگویید پشته نرمافزار شما برطرف میکند، درک میکنم، اما نرمافزار شما چگونه از تلاشهای مختلف در بازار متمایز میشود؟

بیشتر شرکتهایی که به آنها اشاره میکنید، با معرفی مدلهای برنامهنویسی مبتنی بر کاشی یا نقشهبرداری وظیفهای برای بهرهمندی بیشتر از GPU، یا ساختن زبانهای برنامهنویسی جدید برای دریافت هستههای با کارایی بالا برنامهریزیشده بر روی مختلف، بر تسهیل برنامهنویسی پردازندههای گرافیکی تمرکز کردهاند. پلتفرم هایی با پشتیبانی از مونتاژ درون خطی. اینها مشکلات مهمی هستند که آنها به آنها رسیدگی می کنند، اما ما مشکلی را که حل می کنیم تقریباً متعامد می بینیم.

بیایید برای لحظه ای به آهنگ انتقال سخت افزار و نرم افزار فکر کنیم. معماریهای تک هستهای از سرعت کلاک و چگالی ترانزیستور کارایی به دست آوردند، اما در نهایت سرعت کلاک به یک فلات رسید. موازی سازی با استفاده از بسیاری از هسته ها این امر را دور زد و سرعت های قابل توجهی را ارائه داد. تقریباً یک دهه طول کشید تا نرمافزار به آن برسد، زیرا مدلهای برنامهنویسی، کامپایلرها و زمانهای اجرا باید تجدید نظر میشد تا به توسعهدهندگان کمک شود تا ارزش این پارادایم را استخراج کنند. سپس، GPU ها دوباره با مدل برنامه نویسی متفاوت، شروع به تبدیل شدن به شتاب دهنده های همه منظوره کردند. باز هم، تقریباً یک دهه طول کشید تا توسعه دهندگان ارزش را در اینجا استخراج کنند.

باز هم، سختافزار در حال ضربه زدن است – قانون مور، محدودیتهای انرژی و حرارتی، تنگناهای حافظه، و تنوع بار کاری به علاوه نیاز به محاسبات بهطور تصاعدی بیشتر، ما را به سمت ساختن معماریهای کامپیوتری ناهمگون فزاینده برای عملکرد بهتر، کارایی و هزینه کل سوق میدهد. این تغییر در سختافزار البته چالشهایی را برای نرمافزار ایجاد میکند، زیرا ما کامپایلر و زمان اجرا مناسبی برای پشتیبانی از تکامل بعدی محاسبات نداریم. با این حال، این بار، ما نباید 10 سال دیگر صبر کنیم تا نرم افزار ارزش معماری های ناهمگن یا خوشه های بزرگ را استخراج کند، به خصوص زمانی که بیش از 80 درصد از آنها استفاده نشده است.

آنچه که ما روی آن تمرکز می کنیم ساختن یک مدل برنامه نویسی آگاه از ناهمگنی با موازی سازی مبتنی بر کار، پرداختن به عملکرد قابل حمل با بهینه سازی های متقابل پردازنده، تلفیقی آگاه از زمینه و تخصیص منابع پویا است. و برای ما فرقی نمی کند که CPU، GPU، TPU، SPU (معماری Lemurian) یا مش از همه آنها باشد. میدانم که به نظر واژههای جالبی میآید، اما چیزی که واقعاً میگوید این است که ما امکان برنامهریزی هر نوع پردازندهای را با یک رویکرد واحد فراهم کردهایم، و میتوانیم کد را از یک نوع پردازنده به دیگری با کمترین هزینه انتقال دهیم. تلاش بدون نیاز به قربانی کردن عملکرد، و برنامهریزی کار به صورت تطبیقی و پویا در سراسر گرهها.

اگر آنچه می گویید درست باشد، ممکن است محاسبات را کاملاً دوباره تعریف کنید. بیایید در مورد بودجه صحبت کنیم. شما در سال گذشته 9 میلیون دلار سرمایه اولیه جذب کردید که نشان دهنده حمایت سرمایه گذار قوی و اعتقاد به چشم انداز شما است. از آن به بعد چه کار کردی؟

در طول سال گذشته، با کمک بودجه بذر، ما گام های مهمی برداشته ایم. با تیم ما که اکنون 20 عضو دارد، ما به طور دقیق به چالش ها پرداختیم، با مشتریان درگیر شدیم و رویکرد خود را اصلاح کردیم.

ما روی تقویت PAL برای آموزش و استنتاج تمرکز کردیم، معماری کامپیوتر را برای شتاب دهنده خود بررسی کردیم و شبیهسازی برای معیارهای عملکرد توسعه دادیم. به طور همزمان، ما پشته نرم افزار خود را برای برنامه های کاربردی مرکز داده، با تاکید بر محاسبات ناهمگن، دوباره تصور کردیم.

این تلاش منجر به معماری کاملاً تعریف شده ای شد که کارایی PAL را برای هوش مصنوعی در مقیاس به نمایش گذاشت. فراتر از پیشرفتهای فناوری، ما به دنبال همکاریها و گسترش دسترسی برای دموکراتیک کردن دسترسی بودیم. این تلاشها آزمایشگاههای Lemurian را برای رسیدگی به چالشهای فوری مشتری، آمادهسازی برای انتشار سیلیکون تولیدی ما قرار میدهند.

برنامه های میان مدت Lemurian Labs در مورد توسعه پشته نرم افزار، همکاری ها و بهبود معماری شتاب دهنده چیست؟

هدف فوری ما ایجاد یک پشته نرم افزاری است که CPU ها، GPU ها و شتاب دهنده های هوش مصنوعی ما را با عملکرد قابل حمل مورد هدف قرار می دهد، که در پایان سال در دسترس شرکای اولیه قرار خواهد گرفت. ما در حال حاضر در حال گفتگو با اکثر شرکت های نیمه هادی پیشرو، ارائه دهندگان خدمات ابری، هایپراسکیلرها و شرکت های هوش مصنوعی هستیم تا به آنها امکان دسترسی به کامپایلر و زمان اجرا را بدهیم. به موازات آن، ما همچنان به کار و بهبود معماری شتاب دهنده خود برای یک سیستم واقعاً مشترک از سخت افزار و نرم افزار ادامه می دهیم. و البته، ما به تازگی شروع به افزایش سری A خود با علاقه شدید جامعه سرمایه گذاران کرده ایم، که به ما امکان می دهد تیم خود را رشد دهیم و به هدف خود برای تحویل محصول نرم افزاری در پایان سال برسیم.

در پایان، چگونه میبینید که آزمایشگاههای Lemurian به تغییر چشمانداز توسعه هوش مصنوعی، دسترسی و برابری در سالهای آینده کمک میکنند؟

ما قصد نداشتیم محاسبات را فقط برای سود تجاری یا برای سرگرمی تعریف کنیم. به عنوان لموریایی ها، نیروی محرکه ما این است که به پتانسیل تحول آفرین هوش مصنوعی اعتقاد داریم و بیش از چند شرکت باید منابعی برای تعریف آینده این فناوری و نحوه استفاده از آن داشته باشند. ما همچنین قابل قبول نمی دانیم که زیرساخت مرکز داده برای هوش مصنوعی در مسیر مصرف 20 درصد انرژی جهان تا سال 2030 باشد. هوش مصنوعی با کاهش چشمگیر هزینه های مرتبط با آن قابل دسترسی تر است، سرعت نوآوری در هوش مصنوعی را تسریع می کند و تأثیر آن را گسترش می دهد. با پرداختن به چالشهای زیرساختهای سختافزاری کنونی، ما به دنبال این هستیم که مسیر را برای توانمندسازی یک میلیارد نفر با قابلیتهای هوش مصنوعی هموار کنیم و از توزیع عادلانه این فناوری پیشرفته اطمینان حاصل کنیم. امیدواریم تعهد ما به راهحلهای محصول محور، همکاری و نوآوری مستمر، ما را به عنوان یک نیروی محرکه در شکلدهی آینده توسعه هوش مصنوعی به یک آینده مثبت تبدیل کند.

همچنین خواندن:

اشتراک گذاری این پست از طریق:

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- منبع: https://semiwiki.com/ceo-interviews/341485-ceo-interview-jay-dawani-of-lemurian-labs-2/

- : دارد

- :است

- :نه

- :جایی که

- 9 میلیون دلار

- $UP

- 1

- 10

- 20

- 2018

- 2022

- 2028

- 2030

- 20x

- 300

- 4

- a

- قادر

- درباره ما

- کاملا

- شتاب دادن

- تسریع شد

- شتاب دهنده

- شتاب دهنده ها

- قابل قبول

- دسترسی

- دسترسی

- در دسترس

- رسیدن

- در میان

- فعالانه

- اضافه کردن

- نشانی

- خطاب

- خطاب به

- تنظیم کردن

- اتخاذ

- پیشرفته

- فن آوری پیشرفته

- پیشرفت

- مشاور

- از نو

- پیش

- AI

- مدل های هوش مصنوعی

- الگوریتمی

- تجارت الگوریتمی

- معرفی

- تخصیص

- اجازه دادن

- تقریبا

- همچنین

- آمازون

- an

- و

- دیگر

- پاسخ

- هر

- هر کس

- جذاب

- برنامه های کاربردی

- روش

- خودسرانه

- معماری

- معماری

- هستند

- مناطق

- دور و بر

- مصنوعی

- هوش مصنوعی

- AS

- پرسیدن

- خواهان

- مجلس

- ارزیابی

- مرتبط است

- عجیب

- At

- نویسنده

- خود مختار

- در دسترس

- به عقب

- موانع

- مستقر

- BE

- زیرا

- تبدیل شدن به

- بوده

- قبل از

- بودن

- باور

- باور

- سود

- بهترین

- بهتر

- خارج از

- بزرگتر

- بیلیون

- مبتنی بر blockchain

- تخته

- بدن

- هر دو

- تنگناها

- شکستن

- می شکند

- گسترده تر

- ساختن

- بنا

- می سازد

- ساخته

- فله

- کسب و کار

- مدل کسب و کار

- کسب و کار

- اما

- by

- آهنگ

- صدا

- آمد

- CAN

- می توانید دریافت کنید

- قابلیت های

- قابلیت

- سرمایه

- کشتی

- مرکز

- مدیر عامل شرکت

- مصاحبه مدیر عامل شرکت

- قطعا

- به چالش

- چالش ها

- متغیر

- شاسی

- GPT چت

- ارزان تر

- واضح

- مشتری

- اقلیم

- ساعت

- بسته

- ابر

- زیرساخت های ابری

- بنیانگذاران

- رمز

- همکاری

- مشارکت

- آینده

- تجاری

- تجاری سازی

- تعهد

- انجمن

- شرکت

- شرکت

- مقایسه

- متقاعد کننده

- کامپایلر

- به طور کامل

- اجزاء

- محاسبه

- کامپیوتر

- کامپیوتر

- محاسبه

- مطمئن

- محدودیت ها

- مصرف

- ادامه دادن

- مداوم

- کمک

- همگرا

- گفتگو

- گفتگو

- سیستم خنک کننده

- اصلاح

- هزینه

- میتوانست

- دوره

- پوشش

- پردازنده

- ایجاد

- صلیب

- CTO

- جاری

- در حال حاضر

- سفارشی

- طراحی دلخواه

- مشتری

- مشتریان

- داده ها

- مرکز داده

- مرکز داده

- روز

- دهه

- تصمیم گیری

- عمیق

- تعريف كردن

- ارائه

- تحویل

- خواسته

- دموکراتیک کردن

- چگالی

- گسترش

- طرح

- طراحی

- توسعه

- توسعه

- توسعه دهندگان

- در حال توسعه

- پروژه

- DID

- مختلف

- تمایز

- مدیر

- دور

- توزیع

- تنوع

- do

- میکند

- نمی کند

- عمل

- دلار

- دامنه

- انجام شده

- آیا

- درب

- به طور چشمگیری

- رسم

- راننده

- رانندگی

- قطره

- پویا

- بطور پویا

- هر

- پیش از آن

- در اوایل

- آسان تر

- به آسانی

- اقتصادی

- اقتصاد (Economics)

- لبه

- اثر

- بهره وری

- تلاش

- تلاش

- عناصر

- با تاکید بر

- توانمندسازی

- قادر ساختن

- را قادر می سازد

- را در بر می گیرد

- پایان

- انرژی

- مشغول

- موتور

- بالا بردن

- افزایش

- اطمینان حاصل شود

- حصول اطمینان از

- تمام

- متساوی

- انصاف

- معادل

- به خصوص

- و غیره

- در نهایت

- هر کس

- تکامل

- تجاوز

- برانگیخته

- مهیج

- موجود

- انتظار

- گران

- کارشناس

- اکتشاف

- اکتشاف

- کشف

- نمایی

- عصاره

- فوق العاده

- واقعیت

- علاقه داشتن به

- بسیار

- سریعتر

- ویژه

- احساس

- خطا

- کمی از

- پیدا کردن

- نام خانوادگی

- شناور

- تمرکز

- متمرکز شده است

- تمرکز

- به دنبال

- رد پا

- برای

- استحکام

- قالب

- به جلو

- تاسیس

- تاسیس

- از جانب

- مرز

- سوخت

- کامل

- پشته کامل

- کاملا

- سرگرمی

- بودجه

- آینده

- آینده هوش مصنوعی

- افزایش

- به دست آورد

- بازی

- پلت فرم بازی

- چرخ دنده

- سوالات عمومی

- عموما

- جغرافیایی

- دریافت کنید

- گرفتن

- دادن

- داده

- می دهد

- هدف

- رفتن

- خوب

- گوگل

- کردم

- GPU

- GPU ها

- پیشگامانه

- شدن

- بود

- مشت

- اداره

- اتفاق افتاده است

- اتفاق می افتد

- سخت افزار

- آیا

- داشتن

- he

- کمک

- اینجا کلیک نمایید

- زیاد

- مانع

- خود را

- اصابت

- ضربه زدن

- امید

- چگونه

- چگونه

- HTTPS

- huang

- گرسنه

- i

- if

- تصور کنید

- فوری

- تأثیر

- مهم

- موثر

- بهبود

- بهبود

- in

- به طور فزاینده

- صنعت

- ناکارآمدی

- اطلاع

- شالوده

- ابداع

- اطلاعات

- قصد

- به هم پیوسته

- علاقه

- مصاحبه

- معرفی

- سرمایه گذاری

- سرمایه گذار

- سرمایه گذاران

- انزوا

- IT

- ITS

- جنسن هوانگ

- JPG

- تنها

- نگاه داشتن

- نوع

- دانستن

- آزمایشگاه

- آزمایشگاه

- چشم انداز

- زبان ها

- بزرگ

- بزرگتر

- نام

- پارسال

- تاخیر

- قانون

- رهبر

- برجسته

- آموخته

- کمترین

- رهبری

- اجازه

- پسندیدن

- لینک

- ll

- llm

- طولانی

- مدت زمان طولانی

- دیگر

- نگاه کنيد

- نگاه

- به دنبال

- خیلی

- کم

- پایین آوردن

- دستگاه

- ماشین آلات

- ساخته

- ساخت

- باعث می شود

- ساخت

- مدیریت

- بسیاری

- بازار

- رهبر بازار

- ریاضیات

- ماده

- حداکثر عرض

- بیشترین

- ممکن است..

- me

- به معنی

- دیدار

- اعضا

- حافظه

- ذکر شده

- صرفا - فقط

- مش

- با دقت

- متریک

- میلیون

- حداقل

- اشتباهات

- مدل

- مدل

- مدرن

- لحظه

- بیش

- اکثر

- بسیار

- چند رشته ای

- my

- ناسا

- نیاز

- ضروری

- نیازمند

- شبکه

- عصبی

- شبکه های عصبی

- جدید

- بعد

- نه

- گره

- گره

- توجه داشته باشید

- ایده

- نوامبر

- اکنون

- هستهای

- عدد

- تعداد

- of

- ارائه

- on

- یک بار

- ONE

- فقط

- OpenAI

- بهینه سازی

- بهینه سازی

- گزینه

- or

- سفارش

- عادی

- دیگر

- دیگران

- ما

- خودمان

- خارج

- توسعه

- روی

- تعمیرات اساسی

- خود

- مالکیت

- سرعت

- نمونه

- موازی

- پارامتر

- بخش

- شرکای

- بخش

- گذشته

- مسیر

- سنگفرش

- مردم

- کارایی

- مرحله به مرحله

- انتخاب کنید

- محور

- اماکن

- برنامه

- سکو

- سیستم عامل

- افلاطون

- هوش داده افلاطون

- PlatoData

- به علاوه

- نقطه

- نقطه مشاهده

- قابل حمل

- موقعیت

- موقعیت

- مثبت

- ممکن

- پست

- پتانسیل

- بالقوه

- قدرت

- قوی

- عملی

- زیبا

- جلوگیری از

- در درجه اول

- از اصول

- مشکل

- مشکلات

- در حال پردازش

- پردازنده

- محصول

- تولید

- محصولات

- برنامه

- برنامه نويسي

- زبانهای برنامه نویسی

- پروژه ها

- املاک

- پیشنهاد

- چشم انداز

- پروتئين

- اثبات شده

- ارائه

- ارائه دهندگان

- عمومی

- صرفا

- هدف

- هل دادن

- نمایش ها

- نژاد

- مسابقه

- بالا بردن

- مطرح شده

- بالا بردن

- به ندرت

- خواندن

- واقعا

- دلیل

- توصیه

- تعریف مجدد

- طراحی مجدد کردن

- كاهش دادن

- اشاره

- پالوده

- با توجه

- دوباره تصور شده

- آزاد

- منتشر شد

- تکیه

- نیاز

- منابع

- منابع

- مسئوليت

- REST

- نتیجه

- نتایج

- خرده فروشی

- راست

- خطرات

- خطرناک

- نقشه راه

- رباتیک

- ربات ها

- نورد

- تقریبا

- دور

- قوانین

- در حال اجرا

- قربانی

- امن

- سعید

- همان

- ذخیره

- گفتن

- گفته

- مقیاس پذیر

- مقیاس

- مقیاس گذاری

- برنامه

- برنامه ریزی

- دیدن

- دانه

- بودجه بذر

- دانه دور

- به دنبال

- به نظر می رسد

- مشاهده گردید

- انتخابی

- نیمه هادی

- حس

- سلسله

- سری A

- خدمت

- خدمت کرده است

- سرویس

- ارائه دهندگان خدمات

- تنظیم

- چند

- شکل دادن

- تغییر

- باید

- نمایشگاه

- مناظر

- قابل توجه

- نشان می دهد

- سیلیکون

- شبیه سازی

- شبیه سازی

- شبیه ساز

- به طور همزمان

- پس از

- تنها

- قابل اندازه

- نمایش

- کوچکتر

- So

- جامعه

- نرم افزار

- راه حل

- مزایا

- حل

- حل شد

- حل کردن

- برخی از

- صدا

- برای تلفن های موبایل

- فضا

- اکتشافات فضایی

- فضایی

- خاص

- به طور خاص

- سرعت

- سرعت

- پشته

- پشته

- سرسام آور

- شروع

- آغاز شده

- شروع

- نوپا

- هنوز

- توقف

- استراتژی

- قدم می گذارد

- قوی

- تلاش

- موفق

- چنین

- مناسب

- مجموع

- پشتیبانی

- پشتیبانی از

- مفروض

- تعجب

- قابل تحمل

- سیستم

- سیستمیک

- سیستم های

- طراحی شده

- گرفتن

- طول می کشد

- مصرف

- صحبت

- نوار

- هدف

- اهداف

- تیم

- فن آوری

- پیشرفته

- نسبت به

- که

- La

- آینده

- منظره

- جهان

- شان

- آنها

- سپس

- آنجا.

- حرارتی

- اینها

- آنها

- اشیاء

- فکر می کنم

- این

- کسانی که

- اگر چه؟

- هزار

- از طریق

- توان

- زمان

- لاستیک

- به

- امروز

- با هم

- هم

- در زمان

- جمع

- سخت

- طرف

- مسیر

- تجارت

- قطار

- آموزش

- مسیر

- دگرگونی

- انتقال

- گذار

- روند

- فوت و فن

- درست

- صادقانه

- امتحان

- دو

- انواع

- زیر

- فهمیدن

- واحد

- باز کردن

- بر

- us

- استفاده کنید

- با استفاده از

- تصدیق

- ارزش

- مختلف

- VC

- تامین مالی VC

- VC

- بسیار

- از طريق

- قابل اعتماد

- چشم انداز

- دید

- صبر کنيد

- می خواهم

- انبار کالا

- بود

- we

- وزن

- خوب

- به خوبی تعریف شده است

- رفت

- بود

- چی

- چه زمانی

- چه

- که

- در حین

- چرا

- اراده

- با

- بدون

- کلمات

- مهاجرت کاری

- گردش کار

- کارگر

- با این نسخهها کار

- جهان

- جهان

- خواهد بود

- سال

- سال

- بله

- شما

- شما

- زفیرنت