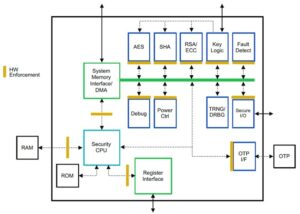

سورش یک مدیر فناوری با تخصص فنی عمیق در نیمه هادی ها، هوش مصنوعی، امنیت سایبری، اینترنت اشیا، سخت افزار، نرم افزار و غیره است. او 20 سال را در این صنعت گذراند و اخیراً به عنوان مدیر اجرایی برای منبع باز zero- اعتماد توسعه تراشه در مؤسسه نوآوری فناوری، ابوظبی و سایر شرکتهای نیمهرسانای فورچون 500 مانند اینتل، کوالکام و مدیاتک در نقشهای رهبری مختلف، جایی که او تحقیق و توسعه با کارایی بالا، کارآمد انرژی، ایمن پس از کوانتومی و ایمن را انجام داد. ریزتراشه ها / سیستم روی تراشه (SoC) / شتاب دهنده ها برای بازارهای مرکز داده، مشتری، تلفن هوشمند، شبکه، اینترنت اشیا و AI/ML. او به Falcon LLM کمک کرد (رتبه 1 در صورت در آغوش گرفتن) و معمار اصلی پلتفرم سخت افزاری سفارشی هوش مصنوعی بود (لغو - اولویت ها تغییر کردند). او دارای 15+ پتنت ایالات متحده است و در بیش از 20 کنفرانس منتشر و ارائه کرده است.

سورش یک مدیر فناوری با تخصص فنی عمیق در نیمه هادی ها، هوش مصنوعی، امنیت سایبری، اینترنت اشیا، سخت افزار، نرم افزار و غیره است. او 20 سال را در این صنعت گذراند و اخیراً به عنوان مدیر اجرایی برای منبع باز zero- اعتماد توسعه تراشه در مؤسسه نوآوری فناوری، ابوظبی و سایر شرکتهای نیمهرسانای فورچون 500 مانند اینتل، کوالکام و مدیاتک در نقشهای رهبری مختلف، جایی که او تحقیق و توسعه با کارایی بالا، کارآمد انرژی، ایمن پس از کوانتومی و ایمن را انجام داد. ریزتراشه ها / سیستم روی تراشه (SoC) / شتاب دهنده ها برای بازارهای مرکز داده، مشتری، تلفن هوشمند، شبکه، اینترنت اشیا و AI/ML. او به Falcon LLM کمک کرد (رتبه 1 در صورت در آغوش گرفتن) و معمار اصلی پلتفرم سخت افزاری سفارشی هوش مصنوعی بود (لغو - اولویت ها تغییر کردند). او دارای 15+ پتنت ایالات متحده است و در بیش از 20 کنفرانس منتشر و ارائه کرده است.

سورش همچنین به طور فعال در یک موقعیت رهبری در RISC-V International خدمت می کند، جایی که او ریاست گروه محاسبات معتمد را برای توسعه قابلیت محاسبات محرمانه RISC-V و ریاست گروه AI/ML برای توسعه شتاب سخت افزاری RISC-V برای بارهای کاری AI/ML را بر عهده دارد. Transformer Large Language Models مورد استفاده در نوع برنامه های ChatGPT. او همچنین به استارتآپها و شرکتهای سرمایهگذاری خطرپذیر در زمینه حمایت از تصمیمگیری سرمایهگذاری، استراتژی محصول، بررسی دقیق فناوری و غیره مشاوره میدهد.

او مدرک MBA را از INSEAD، مدرک کارشناسی ارشد را از موسسه فناوری و علوم بیرلا، گواهی مهندسی سیستم از MIT، گواهی هوش مصنوعی از استانفورد، و گواهینامه ایمنی عملکردی خودرو از TÜV SÜD را دریافت کرد.

در مورد شرکت خود به ما بگویید

"Mastishka AI” (Mastiṣka به معنای مغز در سانسکریت) یک شرکت هوش مصنوعی است که بر ساخت رایانههای مغز مانند برای اجرای مدلهای پایه برای موارد استفاده از هوش مصنوعی مولد در آینده متمرکز است.

چه مشکلاتی را حل می کنید؟

با توجه به مزایای هوش مصنوعی / GenAI، تقاضای آن فقط افزایش می یابد، و همچنین عوارض جانبی آن بر سیاره ما نیز افزایش خواهد یافت. چگونه می توانیم عوارض جانبی هوش مصنوعی را در سیاره خود کاهش یا خنثی کنیم؟ جذب کربن و انرژی هسته ای در مسیر درستی قرار دارند. اما ما باید به طور اساسی در نحوه انجام هوش مصنوعی تجدید نظر کنیم، آیا این روش اشتباهی است که چندین تن ضرب ماتریس را انجام دهیم؟

مغز ما می تواند بسیاری از وظایف را به صورت موازی، در 10 وات و کمتر از آن یاد بگیرد و انجام دهد، اما چرا این سیستم های هوش مصنوعی 10 مگاوات برای آموزش مدل ها مصرف می کنند؟

شاید در آینده معماریهای کم مصرف مانند معماریهای نورومورفیک و ترانسفورماتورهای مبتنی بر شبکه عصبی که نزدیکترین آنها به مغز انسان هستند، باشد، که ممکن است ۱۰۰ تا ۱۰۰۰ برابر انرژی کمتری مصرف کنند، بنابراین هزینه استفاده از هوش مصنوعی کاهش مییابد، در نتیجه آن را دموکراتیک میکند و صرفهجویی میکند. سیاره.

چالشهای کنونی که ما با هوش مصنوعی مواجه هستیم، یعنی الف) در دسترس بودن، ب) دسترسی، ج) مقرون به صرفه بودن، و د) ایمنی محیطی همراه با برخی توصیهها برای مقابله با آنها.

اگر در آینده پیشبینی کنیم، برخی از مفاهیم مفید AGI در فیلم «HER» نشان داده میشود، جایی که شخصیت «سامانتا» - یک عامل مکالمهای که طبیعی است، احساسات را درک میکند، همدلی نشان میدهد، یک خلبان شگفتانگیز در محل کار است - و در حال اجراست. دستگاه های دستی در تمام طول روز، پس ممکن است مجبور باشیم همین الان به چالش های زیر رسیدگی کنیم.

مسئله 1: آموزش یک LLM می تواند از 150 هزار تا 10 میلیون دلار هزینه داشته باشد، و تنها به کسانی که جیب های عمیق تری دارند اجازه می دهد تا هوش مصنوعی را توسعه دهند. علاوه بر این، هزینه های استنباط نیز بسیار زیاد است (هزینه آن 10 برابر بیشتر از جستجوی وب است)

—> ما باید بهره وری انرژی مدل ها/سخت افزارها را بهبود بخشیم تا هوش مصنوعی را به نفع بشریت دموکراتیک کنیم.

مسئله 2: اجرای مدلهای هوش مصنوعی عظیم برای عوامل مکالمه یا سیستمهای توصیهای، از نظر مصرف برق و خنککننده، ضرری بر محیط زیست وارد میکند.

—> ما باید بهره وری انرژی مدل ها/سخت افزارها را بهبود بخشیم تا سیاره خود را برای بچه هایمان نجات دهیم.

مسئله 3: مغز انسان قادر است و می تواند چند کار را انجام دهد، اما به جای مگاوات تنها 10 وات مصرف می کند.

—> شاید ما باید ماشین هایی مانند مغز خود بسازیم و نه ضرب کننده های ماتریس معمولی سریعتر.

بشریت تنها با نوآوری های پایدار می تواند رشد کند و نه با قطع همه جنگل ها و جوشاندن اقیانوس ها به نام نوآوری. ما باید از سیاره خود برای رفاه فرزندانمان و نسل های آینده محافظت کنیم…

چه حوزه های کاربردی قوی ترین هستند؟

آموزش و استنتاج مدلهای پایه مبتنی بر ترانسفورماتور (و معماری عصبی آینده)، با 50 تا 100 برابر انرژی بیشتر در مقایسه با راهحلهای مبتنی بر GPU امروزی.

چه چیزی مشتریان شما را در شب بیدار نگه می دارد؟

مشکلات برای مشتریانی که در حال حاضر از محصولات دیگر استفاده می کنند:

مصرف برق برای آموزش مدلهای زبانی بسیار فراتر از سقف است، به عنوان مثال، آموزش یک پارامتر 13B LLM روی نشانههای متنی 390B روی 200 پردازنده گرافیکی به مدت 7 روز هزینه 151,744 دلاری دارد (منبع: صفحه خدمات کلاستر آموزشی جدید HuggingFace – https://lnkd.in/g6Vc5cz3). و حتی مدل های بزرگتر با پارامترهای 100+B فقط برای آموزش 10+ میلیون دلار هزینه دارند. سپس هر بار که یک درخواست سریع جدید می رسد، برای استنباط پرداخت کنید.

محققان دانشگاه کالیفرنیا، ریورساید، مصرف آب برای خنکسازی را تخمین زدند که تأثیرات زیستمحیطی سرویس ChatGPT مانند را تخمین زدند و میگویند که هر بار که از آن بپرسید 500 میلیلیتر آب (نزدیک به مقدار موجود در یک بطری آب 16 اونسی) مینوشد. مجموعه ای از 5 تا 50 درخواست یا سوال. بسته به محل قرارگیری سرورهای آن و فصل متفاوت است. این برآورد شامل مصرف غیرمستقیم آب است که شرکتها آن را اندازهگیری نمیکنند - مانند خنک کردن نیروگاههایی که برق مراکز داده را تامین میکنند. (منبع: https://lnkd.in/gybcxX8C)

مسائل برای غیر مشتریان محصولات فعلی:

نمی توانم CAPEX برای خرید سخت افزار بپردازم

توان مالی استفاده از خدمات ابری را ندارید

نمیتوان هوش مصنوعی را نوآوری کرد یا از آن استفاده کرد - با مدل خدماتی که هر گونه مزیت رقابتی را از بین میبرد، گیر کرده است

چشم انداز رقابتی چگونه به نظر می رسد و چگونه آن را متمایز می کنید؟

- پردازندههای گرافیکی بر فضای آموزشی تسلط دارند، اگرچه ASICهای تخصصی نیز در این بخش رقابت میکنند

- استنتاج Cloud & Edge گزینه های زیادی در دسترس دارد

دیجیتال، آنالوگ، فوتونیک - شما نام آن را میگذارید که مردم سعی دارند با همین مشکل مقابله کنند.

آیا می توانید نظرات خود را در مورد وضعیت فعلی معماری تراشه برای AI/ML به اشتراک بگذارید، به این معنی که در حال حاضر مهم ترین روندها و فرصت ها را کدام می بینید؟

روندهای زیر:

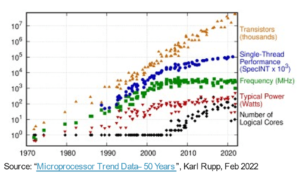

روند 1: 10 سال پیش، یادگیری عمیق مبتنی بر سخت افزار رونق گرفت و اکنون همین سخت افزار مانع از پیشرفت شده است. با توجه به هزینه های هنگفت سخت افزار و هزینه های برق برای اجرای مدل ها، دسترسی به سخت افزار به یک چالش تبدیل شده است. فقط شرکتهایی که جیبهای عمیقی دارند میتوانند این هزینهها را بپردازند و در حال تبدیل شدن به انحصار هستند.

روند 2: اکنون که این مدلها وجود دارند، باید از آنها برای اهداف عملی استفاده کنیم تا بار استنتاج افزایش یابد و به پردازندههای دارای شتابدهندههای هوش مصنوعی اجازه میدهد دوباره مورد توجه قرار گیرند.

روند 3: استارتآپها تلاش میکنند تا با نمایشهای اعداد ممیز شناور جایگزین ارائه کنند که فرمت سنتی IEEE - مانند لگاریتمی و مبتنی بر پوزیتی - خوب است اما کافی نیست. بهینهسازی فضای طراحی PPA$ زمانی منفجر میشود که ما سعی میکنیم یکی را بهینه کنیم و دیگری به دنبال پرتاب میشود.

روند 4: این صنعت در حال دور شدن از مدل مبتنی بر خدمات هوش مصنوعی به میزبانی مدل های خصوصی خود در محل خود است - اما دسترسی به سخت افزار به دلیل کمبود عرضه، تحریم ها و غیره یک چالش است.

وضعیت فعلی:

در دسترس بودن سختافزار و دادهها باعث رشد هوش مصنوعی 10 سال پیش شد، اکنون همان سختافزار به نوعی مانع آن شده است - اجازه دهید توضیح دهم

از زمانی که CPU ها بد کار می کردند و GPU ها برای انجام هوش مصنوعی تغییر کاربری دادند، اتفاقات زیادی افتاد.

شرکتها به 4 بخش AI/ML پرداختهاند که عبارتند از - 1) آموزش ابری، 2) استنتاج ابری، 3) استنتاج لبه، و 4) آموزش لبه (یادگیری فدرال برای برنامههای حساس به حریم خصوصی).

دیجیتال و آنالوگ

سمت آموزشی – مجموعهای از شرکتهایی که پردازندههای گرافیکی انجام میدهند، شتابدهندههای مشتری مبتنی بر RISC-V، تراشههای مقیاس ویفر (850 هزار هسته)، و غیره در جایی که CPUهای سنتی (هدف کلی آنها) فاقد آن هستند. سمت استنتاج - شتاب دهنده های NN از هر سازنده ای، در گوشی های هوشمند، لپ تاپ ها و سایر دستگاه های لبه در دسترس هستند.

معماریهای مبتنی بر ممریستور آنالوگ نیز مدتی پیش ظاهر شدند.

ما معتقدیم که CPU ها می توانند در استنباط بسیار خوب باشند اگر آن را با شتابی مانند پسوندهای ماتریسی تقویت کنیم.

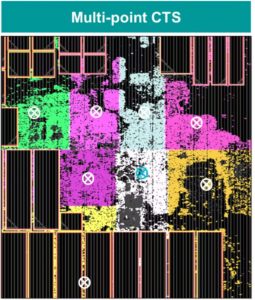

جنبه RISC-V چیزها:

در بخش RISC-V، ما در حال توسعه شتابدهندههایی برای عملیات ماتریسی و سایر عملیاتهای غیرخطی هستیم تا گلوگاههای احتمالی برای بار کاری ترانسفورماتور را از بین ببریم. تنگناهای Von Neumann نیز با معماری خاطرات نزدیک به محاسبات برطرف میشوند و در نهایت CPUهای با شتاب هوش مصنوعی را به انتخاب مناسبی برای استنباط تبدیل میکنند.

فرصت ها:

فرصت های منحصر به فردی برای پر کردن بازار مدل های فونداسیون وجود دارد. مثال – OpenAI اشاره کرده است که قادر به ایمن سازی کافی محاسبات هوش مصنوعی (GPU) برای ادامه دادن به خدمات ChatGPT خود نبوده است... و گزارش های خبری در مورد هزینه برق 10 برابر هزینه جستجوی معمولی اینترنت و 500 میلی لیتر آب برای خنک کردن سیستم ها هستند. برای هر پرس و جو بازاری وجود دارد که باید در اینجا پر شود - این بازاری نیست، بلکه کل بازار است که هوش مصنوعی را برای مقابله با تمام چالش های ذکر شده در بالا دموکراتیک می کند - الف) در دسترس بودن، ب) دسترسی، ج) مقرون به صرفه بودن، و د) ایمنی محیط زیست

روی چه ویژگی ها/فناوری جدید کار می کنید؟

ما در حال ساختن مغزی مانند کامپیوتر با استفاده از تکنیکهای نورومدرفیک و طراحی مدلها برای بهرهگیری از سختافزار کارآمد انرژی، استفاده مجدد از چارچوبهای باز موجود هستیم.

رشد یا تغییر بخش AI/ML در 12 تا 18 ماه آینده را چگونه تصور می کنید؟

از آنجایی که تقاضا برای پردازندههای گرافیکی کاهش یافته است (هزینهای حدود 30 هزار دلار) بهعلاوه برخی از نقاط جهان برای خرید این پردازندههای گرافیکی با تحریمهایی مواجه هستند، برخی از نقاط جهان احساس میکنند که در تحقیق و توسعه هوش مصنوعی بدون دسترسی به پردازندههای گرافیکی متوقف شدهاند. پلتفرمهای سختافزاری جایگزین بازار را تسخیر خواهند کرد.

مدلها احتمالاً شروع به کوچک شدن خواهند کرد - مدلهای سفارشی یا حتی اساساً تراکم اطلاعات افزایش مییابد

همان سوال، اما رشد و تغییر در 3-5 سال آینده چگونه است؟

الف) پردازندههای با پسوند هوش مصنوعی بازار استنباط هوش مصنوعی را به دست خواهند آورد

ب) مدلها زیرک میشوند و با افزایش تراکم اطلاعات از 16 درصد به 90 درصد، پارامترها حذف میشوند.

ج) بهره وری انرژی بهبود می یابد، چاپ پای CO2 کاهش می یابد

د) معماری های جدید به وجود می آیند

ه) هزینههای سختافزار و هزینههای انرژی کاهش مییابد تا مانع ورود شرکتهای کوچکتر برای ایجاد و آموزش مدلها مقرون به صرفه شود.

و) مردم در مورد لحظه قبل از AGI صحبت می کنند، اما معیار من شخصیت سامانتا (هوش مصنوعی مکالمه ای) در فیلم "او" خواهد بود. که با توجه به هزینه های بالای افزایش، شاید بعید باشد.

برخی از چالشهایی که میتواند بر رشد بخش هوش مصنوعی/ML تاثیر بگذارد یا محدود کند چیست؟

الف) دسترسی به سخت افزار

ب) هزینه های انرژی و هزینه های سرمایش و آسیب های زیست محیطی

همچنین خواندن:

مصاحبه مدیر عامل: دیوید مور از Pragmatic

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- منبع: https://semiwiki.com/ceo-interviews/338703-ceo-interview-suresh-sugumar-of-mastiska-ai/

- : دارد

- :است

- :نه

- :جایی که

- $UP

- 1

- 10

- 150

- 20

- سال 20

- 200

- 50

- 500

- 7

- a

- قادر

- درباره ما

- بالاتر

- ابوظبی

- شتاب

- شتاب دهنده ها

- دسترسی

- دسترسی

- فعالانه

- نشانی

- خطاب

- خطاب به

- مزیت - فایده - سود - منفعت

- امور

- از نو

- عامل

- عاملان

- AGI

- پیش

- AI

- مدل های هوش مصنوعی

- تحقیق ai

- سیستم های هوش مصنوعی

- موارد استفاده ai

- AI / ML

- هم راستا

- معرفی

- اجازه دادن

- اجازه می دهد تا

- در امتداد

- همچنین

- جایگزین

- شگفت انگیز

- an

- و

- دیگر

- هر

- هر جا

- کاربرد

- برنامه های کاربردی

- معماری

- هستند

- مناطق

- وارد می شود

- مصنوعی

- هوش مصنوعی

- AS

- ASIC ها

- پرسیدن

- At

- خودرو

- دسترس پذیری

- در دسترس

- دور

- b

- سد

- مستقر

- BE

- شدن

- شود

- تبدیل شدن به

- بوده

- بودن

- باور

- در زیر

- محک

- سود

- مزایای

- میان

- خارج از

- تنگناها

- بسته

- مغز

- مغز

- ساختن

- بنا

- اما

- خرید

- by

- کالیفرنیا

- CAN

- لغو شد

- قابلیت

- توانا

- سرمایه

- گرفتن

- کربن

- کربن ضبط

- موارد

- مراکز

- مدیر عامل شرکت

- مصاحبه مدیر عامل شرکت

- گواهی نامه

- به چالش

- چالش ها

- تغییر دادن

- تغییر

- متغیر

- شخصیت

- GPT چت

- فرزندان

- تراشه

- چیپس

- انتخاب

- چوپرا

- مشتری

- نزدیک

- نزدیک

- ابر

- خوشه

- co2

- بیا

- شرکت

- شرکت

- مقایسه

- رقابت

- رقابتی

- محاسبه

- کامپیوتر

- کامپیوتر

- محاسبه

- مفاهیم

- همایش ها

- مصرف

- مصرف

- ادامه دادن

- کمک

- محاورهای

- هوش مصنوعی محاوره ای

- سرد

- هزینه

- هزینه

- میتوانست

- ایجاد

- جاری

- وضعیت فعلی

- در حال حاضر

- سفارشی

- مشتری

- مشتریان

- برش

- امنیت سایبری

- داده ها

- مرکز دادهها

- مرکز داده

- داود

- روز

- روز

- تصمیم

- عمیق

- یادگیری عمیق

- عمیق تر

- تقاضا

- دموکراتیک کردن

- دموکراتیک کردن

- نشان

- چگالی

- بستگی دارد

- طرح

- توسعه

- توسعه

- در حال توسعه

- پروژه

- دستگاه ها

- ابوظبی

- تمایز

- سخت کوشی

- جهت

- مدیر

- do

- میکند

- عمل

- دلار

- آیا

- پایین

- dr

- قطره

- دو

- به دست آورده

- لبه

- اثرات

- بهره وری

- موثر

- موثر

- برق

- مصرف برق

- از بین بردن

- حذف می شود

- احساسات

- یکدلی

- انرژی

- صرفه جویی در مصرف انرژی

- مهندسی

- بالا بردن

- کافی

- تمام

- ورود

- محیط

- محیطی

- تجسم

- تخمین زدن

- برآورد

- و غیره

- اتر (ETH)

- حتی

- در نهایت

- هر

- مثال

- اجرایی

- مدیر اجرایی

- وجود داشته باشد

- تخصص

- منفجر می شود

- ضمیمهها

- چهره

- نما

- شاهین

- سریعتر

- احساس

- پر کردن

- شرکت ها

- شناور

- متمرکز شده است

- پا

- برای

- پیش بینی

- قالب

- ثروت

- پایه

- چارچوب

- از جانب

- منجمد

- سوخت

- تابعی

- اساساً

- آینده

- سوالات عمومی

- نسل ها

- مولد

- هوش مصنوعی مولد

- داده

- Go

- می رود

- رفتن

- خوب

- GPU ها

- گروه

- در حال رشد

- رشد

- سخت افزار

- آیا

- he

- از این رو

- اینجا کلیک نمایید

- زیاد

- دارای

- میزبانی وب

- چگونه

- HTTPS

- بزرگ

- صورت در آغوش گرفته

- انسان

- بشریت

- IEEE

- if

- تصویر

- تأثیر

- بهبود

- را بهبود می بخشد

- in

- در دیگر

- شامل

- افزایش

- صنعت

- اطلاعات

- نوآوری

- ابداع

- نوآوری

- در عوض

- موسسه

- اینتل

- اطلاعات

- بین المللی

- اینترنت

- مصاحبه

- سرمایه گذاری

- اینترنت اشیا

- IT

- ITS

- تنها

- بچه ها

- نوع

- عدم

- چشم انداز

- زبان

- لپ تاپ

- بزرگ

- بزرگتر

- رهبری

- رهبری

- یاد گرفتن

- یادگیری

- اجازه

- قدرت نفوذ

- بهره برداری

- پسندیدن

- توجه ویژه

- محدود

- لینک

- بار

- واقع شده

- نگاه کنيد

- شبیه

- کاهش

- ماشین آلات

- ساخت

- سازنده

- بسیاری

- بازار

- بازارها

- ماتریس

- حداکثر عرض

- ممکن است..

- شاید

- MBA

- me

- معنی

- به معنی

- اندازه

- خاطرات

- ذکر شده

- قدرت

- میلیون

- میلیون دلار

- MIT

- مدل

- مدل

- لحظه

- انحصارات

- ماه

- بیش

- اکثر

- سینما

- متحرک

- MS

- باید

- my

- نام

- از جمله

- طبیعی

- نیاز

- مبتنی بر شبکه

- شبکه

- عصبی

- جدید

- اخبار

- بعد

- تو رفتگی در دیوار

- شب

- زیرک

- اکنون

- هستهای

- قدرت هسته ای

- عدد

- اقیانوس ها

- of

- on

- ONE

- فقط

- باز کن

- منبع باز

- OpenAI

- عملیات

- فرصت ها

- بهینه سازی

- بهینه سازی

- گزینه

- or

- دیگر

- ما

- خارج

- خود

- با ما

- موازی

- پارامتر

- پارامترهای

- بخش

- اختراعات

- پرداخت

- مردم

- شاید

- سیاره

- گیاهان

- سکو

- سیستم عامل

- افلاطون

- هوش داده افلاطون

- PlatoData

- کثیف

- به علاوه

- جیب

- نقطه

- موقعیت

- ممکن

- قدرت

- نیروگاه

- عملی

- چاپ

- خصوصی

- مشکل

- مشکلات

- محصول

- محصولات

- مشخصات

- پیشرفت

- پرسیدن

- محافظت از

- هدف

- اهداف

- فشار

- قرار می دهد

- کوالکام

- سوال

- سوالات

- محدوده

- رتبه

- خواندن

- تازه

- توصیه

- توصیه

- كاهش دادن

- کاهش

- منظم

- گزارش ها

- درخواست

- تحقیق

- تحقیق و توسعه

- محققان

- راست

- کنار رودخانه

- نقش

- سقف

- دویدن

- در حال اجرا

- اجرا می شود

- امن

- ایمنی

- همان

- تحریم ها

- گودال ماسهبازی

- ذخیره

- صرفه جویی کردن

- گفتن

- مقیاس گذاری

- علم

- جستجو

- فصل

- بخش

- امن

- دیدن

- بخش ها

- نیمه هادی

- نیمه هادی ها

- سلسله

- سرورها

- سرویس

- خدمات

- خدمت

- اشتراک گذاری

- کمبود

- باید

- نشان داد

- نشان می دهد

- طرف

- قابل توجه

- پس از

- کوچکتر

- گوشی های هوشمند

- گوشی های هوشمند

- So

- نرم افزار

- مزایا

- حل کردن

- برخی از

- منبع

- فضا

- تخصصی

- صرف

- استنفورد

- شروع

- نوپا

- دولت

- استراتژی

- قوی ترین

- چنین

- عرضه

- پشتیبانی

- قابل تحمل

- سیستم های

- برخورد با

- مقابله با

- خیاطی

- گرفتن

- صحبت

- وظایف

- فنی

- پیشرفته

- نوآوری فناوری

- قوانین و مقررات

- متن

- نسبت به

- که

- La

- آینده

- اطلاعات

- جهان

- شان

- آنها

- سپس

- آنجا.

- در نتیجه

- اینها

- آنها

- اشیاء

- این

- کسانی که

- اگر چه؟

- رشد

- زمان

- به

- امروز

- نشانه

- فردا

- هم

- بالا

- پرتاب کردن

- سنتی

- قطار

- آموزش

- ترانسفورماتور

- ترانسفورماتور

- روند

- مورد اعتماد

- امتحان

- تلاش

- زیر

- درک می کند

- دانشگاه

- دانشگاه کالیفرنیا

- بعید

- us

- استفاده

- استفاده کنید

- استفاده

- با استفاده از

- مختلف

- ریسک

- سرمایه گذاری

- شرکت های سرمایه گذاری خطرپذیر

- بسیار

- از

- بود

- آب

- مسیر..

- we

- وب

- رفاه

- بود

- چی

- چه زمانی

- که

- WHO

- چرا

- اراده

- با

- بدون

- مهاجرت کاری

- کارگر

- جهان

- خواهد بود

- اشتباه

- سال

- شما

- شما

- زفیرنت