همانطور که وارد سال 2024 می شویم، یک روند به طور برجسته در افق خودنمایی می کند: ظهور مدل های نسل افزوده با بازیابی (RAG) در قلمرو مدل های زبان بزرگ (LLM). در پی چالش های ناشی از توهمات و محدودیت های آموزشی، LLM های مبتنی بر RAG به عنوان یک راه حل امیدوار کننده ظاهر می شوند که می تواند نحوه مدیریت داده ها را تغییر دهد.

افزایش در محبوبیت LLM ها در سال 2023 موجی از احتمالات دگرگون کننده را به همراه داشت، اما بدون موانع نبود. "توهمات" - مواردی که مدل اطلاعات نادرست یا ساختگی تولید می کند - و محدودیت ها در مرحله آموزش باعث ایجاد نگرانی هایی به خصوص در برنامه های داده های سازمانی شده است.

با این حال، ظهور مدلهای RAG نوید کاهش این چالشها را میدهد و راهحلی قوی ارائه میدهد که میتواند دسترسی به دادهها را در سازمانها متحول کند.

مدلهای RAG راهحلی برای مبارزه با چالشهای توهم با ارائه اطلاعات قابل بازرسی و بهروز ارائه میدهند. این مدلها دسترسی به ذخیرهسازی دادههای خارجی را امکانپذیر میکنند و اطمینان میدهند که اطلاعات ارائهشده نه تنها قابلاعتماد، بلکه جاری نیز هستند.

برای مشاغل متکی به بینش های داده محور، پذیرش LLM های مبتنی بر RAG می تواند بازی را تغییر دهد. این مدلها قابلیت اطمینان و ارتباط اطلاعات به دست آمده را افزایش میدهند و دادههای بهروز و قابل ممیزی را فراهم میکنند که برای تصمیمگیری آگاهانه بسیار مهم است.

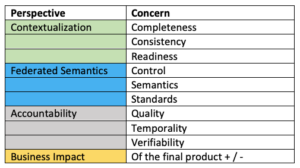

اصل مدلهای RAG در تخصص موضوعی خارج از مدل، اغلب در پایگاههای داده برداری، نمودارهای دانش، یا جداول دادههای ساختاریافته نهفته است. این راهاندازی یک لایه میانی پیچیده و کم تأخیر بین فروشگاههای داده و کاربران نهایی ایجاد میکند. با این حال، همچنین عواقب داده های نادرست را تقویت می کند و به یک چارچوب قابل مشاهده قوی داده نیاز دارد.

همانطور که شرکت ها به طور فزاینده ای به سمت استقرار مدل های RAG در موارد استفاده تولید می روند، نیاز به مشاهده پذیری داده ها نیز بسیار مهم می شود. سازمانها باید سرمایهگذاری بیشتری در فرآیندهای حسابرسی جامع دادهها انجام دهند تا از قابلیت اطمینان اطلاعاتی که توسط LLMهای مبتنی بر RAG ارجاع میشوند، اطمینان حاصل کنند.

یکی از پیشتازان صنعت که بر روی مدل های RAG شرط بندی کرده است Databricks است. علی قدسی، یکی از بنیانگذاران و مدیرعامل Databricks، در یک گفتگوی اخیر در مانی 2020، فاش کرد که مشتریان آنها فعالانه از RAG ها استقبال می کنند و 60 درصد موارد استفاده آنها شامل LLM ها است که بر اساس این معماری ساخته شده اند. این شرکت این فناوری جدید را به عنوان سنگ بنای پیشرفت های آینده در مشاهده پذیری داده ها در LLM ها می بیند.

در سال 2024 و پس از آن، LLM های مبتنی بر RAG به نیروی محرکه ای در تکامل پردازش و تجزیه و تحلیل داده ها تبدیل خواهند شد. برای کسبوکارها ضروری است که نه تنها از این فناوری استقبال کنند، بلکه شیوههای مشاهدهپذیری دادههای خود را نیز تقویت کنند تا از پتانسیل واقعی LLMهای مبتنی بر RAG در چشمانداز همیشه در حال گسترش هوش مصنوعی استفاده کنند.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- منبع: https://www.dataversity.net/the-rise-of-rag-based-llms-in-2024/

- :است

- :نه

- :جایی که

- 2020

- 2023

- 2024

- a

- دسترسی

- دسترسی

- فعالانه

- پیشرفت

- ظهور

- همچنین

- تقویت

- تحلیل

- و

- برنامه های کاربردی

- معماری

- هستند

- مصنوعی

- هوش مصنوعی

- AS

- At

- حسابرسی

- BE

- شدن

- شود

- بودن

- شرط

- میان

- خارج از

- آورده

- ساخته

- کسب و کار

- اما

- by

- موارد

- مدیر عامل شرکت

- چالش ها

- گپ

- بنیانگذاران

- مبارزه با

- شرکت

- جامع

- نگرانی ها

- عواقب

- محدودیت ها

- بنیاد

- میتوانست

- ایجاد

- بسیار سخت

- معما

- جاری

- مشتریان

- داده ها

- پردازش داده ها

- پایگاه های داده

- پایگاه داده

- DATAVERSITY

- تصمیم گیری

- استقرار

- نشات گرفته

- رانندگی

- در طی

- در اغوش گرفتن

- در آغوش گرفتن

- سنگ سنباده

- قادر ساختن

- بالا بردن

- اطمینان حاصل شود

- حصول اطمینان از

- سرمایه گذاری

- شرکت

- تکامل

- تخصص

- خارجی

- تخیلی

- فیس بوک چت

- برای

- استحکام

- استحکام بخشیدن

- چارچوب

- آینده

- تغییر دهنده ی بازی

- تولید می کند

- نسل

- نمودار ها

- دسته

- دهنه

- به شدت

- افق

- مسکن

- چگونه

- اما

- HTTPS

- موانع

- امری ضروری

- in

- نادرست

- به طور فزاینده

- صنعت

- اطلاعات

- اطلاع

- نمونه ها

- اطلاعات

- حد واسط

- به

- سرمایه گذاری

- شامل

- IT

- ITS

- JPG

- دانش

- چشم انداز

- زبان

- بزرگ

- لایه

- رهبران

- نهفته است

- محدودیت

- کاهش

- مدل

- مدل

- پول

- پول 2020

- بیش

- نیاز

- جدید

- of

- ارائه

- ارائه

- غالبا

- on

- ONE

- فقط

- or

- سازمان های

- خارج

- خارج از

- برترین

- ویژه

- فاز

- دادن

- افلاطون

- هوش داده افلاطون

- PlatoData

- مطرح

- فرصت

- پتانسیل

- شیوه های

- فرآیندهای

- در حال پردازش

- تولید

- وعده

- امید بخش

- ارائه

- ارائه

- مطرح شده

- قلمرو

- اخیر

- ربط

- قابلیت اطمینان

- قابل اعتماد

- تکیه بر

- تغییر شکل

- نشان داد

- انقلابی کردن

- طلوع

- تنومند

- می بیند

- برپایی

- تغییر

- قابل توجه

- راه حل

- مصنوعی

- می ایستد

- گام

- پرده

- ساخت یافته

- افزایش

- پیشرفته

- که

- La

- اطلاعات

- شان

- اینها

- این

- به

- طرف

- آموزش

- دگرگونی

- روند

- درست

- در جریان روز

- بر

- استفاده کنید

- بیداری

- موج

- we

- اراده

- با

- در داخل

- بدون

- زفیرنت