معرفی

یادگیری عمیق هنگام کار با تصاویر به عنوان داده بسیار موفق بوده است و در حال حاضر در مرحله ای است که در موارد استفاده متعدد بهتر از انسان عمل می کند. مهمترین مشکلاتی که بشر به حل آنها با بینایی کامپیوتری علاقه مند بوده است طبقه بندی تصویر، تشخیص اشیا و تقسیم بندی به ترتیب افزایش سختی آنها.

در کار ساده قدیمی طبقهبندی تصویر، ما فقط علاقهمندیم که برچسبهای تمام اشیاء موجود در یک تصویر را بدست آوریم. در تشخیص اشیاء، یک قدم جلوتر میرویم و سعی میکنیم به همراه تمام اشیاء موجود در یک تصویر، مکانی که اشیاء در آن حضور دارند را با کمک جعبههای مرزی بدانیم. تقسیم بندی تصویر با تلاش برای کشف دقیق مرز دقیق اشیاء در تصویر، آن را به سطح جدیدی می برد.

در این مقاله به بررسی این مفهوم از تقسیمبندی تصویر میپردازیم، موارد استفاده مربوطه، معماریهای شبکه عصبی مختلف درگیر در دستیابی به نتایج، معیارها و مجموعه دادههای مورد بررسی را مورد بحث قرار میدهیم.

تقسیم بندی تصویر چیست؟

می دانیم که یک تصویر چیزی جز مجموعه ای از پیکسل ها نیست. تقسیم بندی تصویر فرآیند طبقه بندی هر پیکسل در یک تصویر متعلق به یک کلاس خاص است و از این رو می توان آن را به عنوان یک مشکل طبقه بندی در هر پیکسل در نظر گرفت. دو نوع تکنیک تقسیم بندی وجود دارد

- تقسیم بندی معنایی :- تقسیم بندی معنایی فرآیند طبقه بندی هر پیکسل متعلق به یک برچسب خاص است. در نمونه های مختلف یک شی متفاوت نیست. به عنوان مثال، اگر 2 گربه در یک تصویر وجود داشته باشد، تقسیم بندی معنایی یک برچسب را به تمام پیکسل های هر دو گربه می دهد.

- تقسیم بندی نمونه :- تقسیم بندی نمونه با تقسیم بندی معنایی متفاوت است به این معنا که به هر نمونه از یک شی خاص در تصویر یک برچسب منحصر به فرد می دهد. همانطور که در تصویر بالا مشاهده می شود به هر 3 سگ رنگ های مختلف یعنی برچسب های مختلف اختصاص داده شده است. با تقسیم بندی معنایی، همه آنها به یک رنگ اختصاص داده می شدند.

بنابراین اکنون به نقطه ای خواهیم رسید که در آن به این نوع الگوریتم نیاز داریم

موارد استفاده از تقسیم بندی تصویر

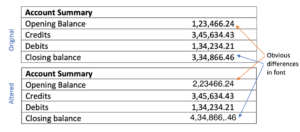

تشخیص دست خط :- Junjo و همه نشان دادند که چگونه از تقسیم بندی معنایی برای استخراج کلمات و خطوط از اسناد دست نویس در آنها استفاده می شود. مقاله پژوهشی 2019 برای تشخیص شخصیت های دست نویس

حالت پرتره گوگل :- موارد استفاده زیادی وجود دارد که جداسازی پیش زمینه از پس زمینه کاملا ضروری است. به عنوان مثال، در حالت پرتره گوگل، میتوانیم پسزمینه را تار ببینیم در حالی که پیشزمینه بدون تغییر باقی میماند تا جلوهای جالب داشته باشد.

داستان های یوتیوب :- گوگل اخیراً ویژگی استوری های یوتیوب را برای سازندگان محتوا منتشر کرده است تا در حین ایجاد داستان، پس زمینه های مختلف را نشان دهند.

آرایش مجازی :- استفاده از استیک مجازی لب با کمک تقسیم بندی تصویر اکنون امکان پذیر است

4. آزمایش مجازی :- امتحان مجازی لباس یکی از ویژگی های جالبی است که در فروشگاه ها با استفاده از سخت افزارهای تخصصی که یک مدل سه بعدی ایجاد می کند موجود بود. اما با یادگیری عمیق و تقسیمبندی تصویر، تنها با استفاده از یک تصویر 3 بعدی، میتوان همین کار را به دست آورد

جستجوی تصویر بصری :- ایده تقسیم بندی لباس ها در الگوریتم های بازیابی تصویر در تجارت الکترونیک نیز استفاده می شود. به عنوان مثال Pinterest/Amazon به شما امکان می دهد با انجام جستجوی تصویر بر اساس تقسیم بندی قسمت پارچه، هر تصویری را آپلود کنید و محصولات مشابه مشابه را دریافت کنید.

ماشین های خود رانندگی : - اتومبیل های خودران به درک کامل محیط اطراف خود تا سطح پیکسل کامل نیاز دارند. از این رو تقسیم بندی تصویر برای شناسایی خطوط و سایر اطلاعات ضروری استفاده می شود

نانوشبکهها به 500 شرکت کمک میکند تا با استفاده از تقسیمبندی معنایی، تجربیات مشتری بهتری را در مقیاس ایجاد کنند.

روش ها و تکنیک ها

قبل از ظهور یادگیری عمیق، تکنیکهای کلاسیک یادگیری ماشین مانند SVM، Random Forest، K-means Clustering برای حل مشکل تقسیمبندی تصویر استفاده میشد. اما مانند بسیاری از بیانیههای مشکل مرتبط با تصویر، یادگیری عمیق به طور جامع بهتر از تکنیکهای موجود عمل کرده است و اکنون در هنگام پرداختن به بخشبندی معنایی به یک هنجار تبدیل شده است. بیایید تکنیک هایی را که برای حل مشکل استفاده می شود مرور کنیم

شبکه کاملا کانولوشن

معماری کلی یک CNN از چند لایه کانولوشن و ادغام تشکیل شده است که به دنبال آن چند لایه کاملاً متصل در انتها وجود دارد. مقاله شبکه کاملاً کانولوشن که در سال 2014 منتشر شد، استدلال میکند که لایه نهایی کاملاً متصل را میتوان بهعنوان انجام یک پیچیدگی 1×1 در نظر گرفت که کل منطقه را پوشش میدهد.

از این رو لایه های متراکم نهایی را می توان با یک لایه پیچشی جایگزین کرد که به همان نتیجه می رسد. اما اکنون مزیت انجام این کار این است که دیگر نیازی به اصلاح اندازه ورودی نیست. هنگامی که لایههای متراکم را در بر میگیرد، اندازه ورودی محدود میشود و از این رو وقتی ورودی با اندازه متفاوت باید ارائه شود، باید اندازه آن تغییر یابد. اما با جایگزینی یک لایه متراکم با کانولوشن، این محدودیت وجود ندارد.

همچنین هنگامی که اندازه بزرگتر تصویر به عنوان ورودی ارائه می شود، خروجی تولید شده یک نقشه ویژگی خواهد بود و نه فقط یک خروجی کلاس مانند یک تصویر با اندازه ورودی معمولی. همچنین رفتار مشاهده شده نقشه ویژگی نهایی نشان دهنده نقشه حرارتی کلاس مورد نیاز است، یعنی موقعیت شی در نقشه ویژگی برجسته شده است. از آنجایی که خروجی نقشه ویژگی یک نقشه حرارتی از شی مورد نیاز است، اطلاعات معتبری برای استفاده ما از تقسیم بندی است.

از آنجایی که نقشه ویژگی بهدستآمده در لایه خروجی به دلیل مجموعه کانولوشنهای انجامشده یک نمونه پایین است، ما میخواهیم آن را با استفاده از تکنیک درونیابی نمونهبرداری کنیم. نمونهبرداری دوخطی کار میکند، اما این مقاله استفاده از نمونهگیری آموختهشده با دکانولوشن را پیشنهاد میکند که حتی میتواند نمونهبرداری غیرخطی را یاد بگیرد.

قسمت نمونه برداری پایین شبکه رمزگذار و قسمت نمونه برداری بالا رمزگشا نامیده می شود. این الگویی است که ما در بسیاری از معماری ها خواهیم دید، یعنی کاهش اندازه با رمزگذار و سپس نمونه برداری با رمزگشا. در دنیای ایدهآل، ما نمیخواهیم نمونه را با استفاده از ادغام پایین بیاوریم و اندازه یکسان را در سرتاسر نگه داریم، اما این منجر به مقدار زیادی پارامتر میشود و از نظر محاسباتی غیرممکن خواهد بود.

اگرچه نتایج خروجی بهدستآمده مناسب بوده است، خروجی مشاهده شده خشن و صاف نیست. دلیل این امر، از دست دادن اطلاعات در لایه ویژگی نهایی به دلیل کاهش 32 برابری با استفاده از لایه های کانولوشن است. اکنون با استفاده از این اطلاعات اندک، انجام نمونهبرداری 32 برابری برای شبکه بسیار دشوار میشود. این معماری FCN-32 نام دارد

برای پرداختن به این موضوع، مقاله 2 معماری دیگر FCN-16، FCN-8 را پیشنهاد کرد. در FCN-16 از اطلاعات لایه ادغام قبلی به همراه نقشه ویژگی نهایی استفاده می شود و از این رو اکنون وظیفه شبکه یادگیری نمونه برداری 16 برابری است که در مقایسه با FCN-32 بهتر است. FCN-8 با گنجاندن اطلاعاتی از یک لایه ادغام قبلی، سعی میکند آن را حتی بهتر کند.

Unet

U-Net بر روی شبکه کاملاً پیچیده از بالا ساخته می شود. این برای اهداف پزشکی برای یافتن تومورها در ریه ها یا مغز ساخته شده است. همچنین از یک رمزگذار تشکیل شده است که تصویر ورودی را به نقشه ویژگی پایین می آورد و رمزگشایی که با استفاده از لایه های دکانولوشن آموخته شده از نقشه ویژگی به اندازه تصویر ورودی نمونه برداری می کند.

سهم اصلی معماری U-Net اتصالات میانبر است. ما در بالا در FCN دیدیم که از آنجایی که یک تصویر را به عنوان بخشی از رمزگذار پایین نمونه برداری می کنیم، اطلاعات زیادی را از دست داده ایم که به راحتی در قسمت رمزگذار قابل بازیابی نیست. FCN سعی می کند با گرفتن اطلاعات از لایه های ادغام قبل از لایه ویژگی نهایی به این موضوع رسیدگی کند.

U-Net یک رویکرد جدید برای حل این مشکل از دست دادن اطلاعات پیشنهاد می کند. این پیشنهاد میکند که اطلاعات را به هر لایه نمونهبرداری بالا در رمزگشا از لایه نمونهبرداری پایین مربوطه در رمزگذار ارسال شود، همانطور که در شکل بالا مشاهده میشود، بنابراین اطلاعات دقیقتری را دریافت میکند و در عین حال محاسبات را پایین نگه میدارد. از آنجایی که لایههای ابتدای رمزگذار اطلاعات بیشتری دارند، عملیات نمونهبرداری رمزگشا را با ارائه جزئیات دقیق مربوط به تصاویر ورودی تقویت میکنند و در نتیجه نتایج را بسیار بهبود میبخشند. این مقاله همچنین استفاده از یک تابع ضرر جدید را پیشنهاد کرد که در زیر به آن خواهیم پرداخت.

DeepLab

Deeplab از گروهی از محققان گوگل، تکنیکهای زیادی را برای بهبود نتایج موجود و دریافت خروجی دقیقتر با هزینههای محاسباتی کمتر پیشنهاد کردهاند. 3 پیشرفت اصلی پیشنهاد شده به عنوان بخشی از تحقیق عبارتند از

1) پیچش های آتروس

2) ادغام هرمی فضایی آتروس

3) استفاده از فیلدهای تصادفی شرطی برای بهبود خروجی نهایی

بیایید در مورد همه اینها بحث کنیم

پیچ خوردگی آتروس

یکی از مشکلات عمده در رویکرد FCN، کوچک سازی بیش از حد به دلیل عملیات ادغام متوالی است. به دلیل یک سری ادغام، تصویر ورودی 32 برابر نمونه برداری می شود که دوباره نمونه برداری می شود تا نتیجه تقسیم بندی به دست آید. کاهش 32 برابری منجر به از دست دادن اطلاعات می شود که برای بدست آوردن خروجی خوب در یک کار تقسیم بندی بسیار مهم است. همچنین دکانولوشن به بالا نمونه با 32x یک عملیات گران قیمت برای محاسبه و حافظه است زیرا پارامترهای اضافی در تشکیل یک نمونه گیری آموخته شده دخیل هستند.

این مقاله استفاده از پیچش آتروس یا پیچیدگی سوراخ یا پیچیدگی گشاد شده را پیشنهاد میکند که به درک زمینه بزرگ با استفاده از همان تعداد پارامتر کمک میکند.

پیچش گشاد شده با افزایش اندازه فیلتر با اضافه کردن صفرها (به نام سوراخ) برای پر کردن شکاف بین پارامترها کار می کند. تعداد حفره ها/صفرهای پر شده بین پارامترهای فیلتر را با نرخ اتساع اصطلاح می گویند. وقتی نرخ برابر با 1 باشد چیزی جز پیچش معمولی نیست. هنگامی که نرخ برابر با 2 است، یک صفر بین هر پارامتر دیگر قرار می گیرد و فیلتر شبیه یک پیچش 5×5 می شود. اکنون ظرفیت آن را دارد که زمینه کانولوشن 5×5 را در حالی که پارامترهای پیچیدگی 3×3 دارد، بدست آورد. به طور مشابه برای نرخ 3، فیلد دریافتی به 7×7 می رود.

در Deeplab آخرین لایههای ادغام جایگزین میشوند تا به جای 1 گام 2 داشته باشند و در نتیجه نرخ نمونهبرداری پایین فقط 8 برابر باشد. سپس مجموعهای از پیچشهای ناخوشایند برای گرفتن زمینه بزرگتر اعمال میشوند. برای آموزش، ماسک با برچسب خروجی 8 برابر برای مقایسه هر پیکسل نمونه برداری می شود. برای استنتاج، از نمونهبرداری دوخطی برای تولید خروجی با اندازه یکسان استفاده میشود که نتایج مناسبی را با هزینههای محاسباتی/حافظه پایینتر به دست میدهد، زیرا نمونهبرداری دوخطی به هیچ پارامتری نیاز ندارد، برخلاف دکانولوشن برای نمونهبرداری بالا.

ASPP

ادغام هرمی فضایی مفهومی است که در SPPNet برای گرفتن اطلاعات چند مقیاسی از نقشه ویژگی معرفی شده است. قبل از معرفی تصاویر ورودی SPP در رزولوشنهای مختلف ارائه میشود و نقشههای ویژگی محاسبهشده با هم برای به دست آوردن اطلاعات چند مقیاسی استفاده میشوند، اما این کار به محاسبات و زمان بیشتری نیاز دارد. با ادغام هرمی فضایی می توان اطلاعات چند مقیاسی را با یک تصویر ورودی دریافت کرد.

با ماژول SPP شبکه 3 خروجی به ابعاد 1×1 (یعنی GAP)، 2×2 و 4×4 تولید می کند. این مقادیر با تبدیل به یک بردار 1 بعدی به هم متصل می شوند و بنابراین اطلاعات را در مقیاس های چندگانه می گیرند. مزیت دیگر استفاده از SPP این است که تصاویر ورودی با هر اندازه ای را می توان ارائه داد.

ASPP مفهوم ادغام اطلاعات را از مقیاس های مختلف می گیرد و آن را در پیچش های Atrous به کار می برد. ورودی با نرخهای اتساع مختلف در هم میپیچد و خروجیهای آنها با هم ترکیب میشوند.

همانطور که مشاهده می شود ورودی با فیلترهای 3×3 با نرخ اتساع 6، 12، 18 و 24 در هم می پیچد و خروجی ها به هم متصل می شوند زیرا اندازه آنها یکسان است. یک خروجی پیچشی 1×1 نیز به خروجی ذوب شده اضافه می شود. همچنین برای ارائه اطلاعات کلی، خروجی GAP نیز پس از نمونه برداری به بالا اضافه می شود. خروجی ذوب شده 3×3 خروجی گشاد شده متنوع، 1×1 و خروجی GAP از پیچیدگی 1×1 عبور داده می شود تا به تعداد کانال مورد نیاز برسد.

از آنجایی که تصویر مورد نیاز برای قطعه بندی می تواند در هر اندازه ای در ورودی باشد، اطلاعات چند مقیاسی از ASPP به بهبود نتایج کمک می کند.

بهبود خروجی با CRF

ادغام عملیاتی است که به کاهش تعداد پارامترها در یک شبکه عصبی کمک می کند، اما یک خاصیت تغییر ناپذیری را نیز به همراه دارد. بی تغییری کیفیت شبکه عصبی است که تحت تأثیر ترجمه های جزئی در ورودی قرار نمی گیرد. با توجه به این خاصیت به دست آمده با ادغام، خروجی تقسیمبندی بهدستآمده توسط یک شبکه عصبی درشت است و مرزها به طور مشخص تعریف نشدهاند.

برای مقابله با این مقاله استفاده از مدل گرافیکی CRF را پیشنهاد میکند. میدان تصادفی شرطی یک مرحله پس از پردازش را اجرا می کند و سعی می کند نتایج تولید شده را برای تعریف مرزهای شکل دهنده بهبود بخشد. این کار با طبقه بندی یک پیکسل نه تنها بر اساس برچسب آن بلکه بر اساس سایر برچسب های پیکسل نیز انجام می شود. همانطور که از شکل بالا مشاهده می شود، مرز درشت تولید شده توسط شبکه عصبی پس از عبور از CRF اصلاح می شود.

Deeplab-v3 نرمال سازی دسته ای را معرفی کرد و نرخ اتساع را در (1,2,4،XNUMX،XNUMX) در داخل هر لایه در یک بلوک Resnet ضرب کرد. همچنین افزودن ویژگیهای سطح تصویر به ماژول ASPP که در بحث بالا در مورد ASPP مورد بحث قرار گرفت، به عنوان بخشی از این مقاله پیشنهاد شد.

Deeplab-v3+ پیشنهاد کرد که به جای نمونه برداری دوخطی 16 برابر، یک رمزگشا داشته باشید. رمزگشا از رمزگشای استفاده شده توسط معماری هایی مانند U-Net که اطلاعات را از لایه های رمزگذار برای بهبود نتایج می گیرد، راهنمایی می گیرد. خروجی رمزگذار 4 برابر با استفاده از نمونهبرداری دوخطی نمونهبرداری میشود و با ویژگیهای رمزگذار الحاق میشود که پس از انجام یک کانولوشن 4×3 دوباره 3 برابر نمونهبرداری میشود. این رویکرد نتایج بهتری نسبت به نمونه گیری مستقیم 16 برابری به همراه دارد. همچنین معماری اصلاح شده Xception پیشنهاد شده است که به جای Resnet به عنوان بخشی از رمزگذار مورد استفاده قرار گیرد و کانولوشن های قابل تفکیک عمیق اکنون در بالای پیچیدگی های Atrous برای کاهش تعداد محاسبات استفاده می شوند.

شبکه جهانی پیچیدگی

تقسیم بندی معنایی شامل انجام دو وظیفه به طور همزمان است

ط) طبقه بندی

ii) بومی سازی

شبکههای طبقهبندی به گونهای ایجاد میشوند که نسبت به ترجمه و چرخش ثابت باشند، بنابراین به اطلاعات مکان اهمیتی نمیدهند، در حالی که محلیسازی شامل دریافت جزئیات دقیق در مکان است. بنابراین ذاتاً این دو وظیفه متضاد هستند. اکثر الگوریتمهای تقسیمبندی اهمیت بیشتری به بومیسازی یعنی دومی در شکل بالا میدهند و در نتیجه چشم انداز کلی را از دست میدهند. در این اثر نویسنده روشی را پیشنهاد میکند که به کار طبقهبندی نیز اهمیت بدهد و در عین حال اطلاعات بومیسازی را از دست ندهد.

نویسنده پیشنهاد میکند که با استفاده از هستههای بزرگ به عنوان بخشی از شبکه به این هدف دست یابد، بنابراین اتصالات متراکم و در نتیجه اطلاعات بیشتر را ممکن میسازد. این امر با کمک یک بلوک GCN همانطور که در شکل بالا مشاهده می شود به دست می آید. بلوک GCN را می توان به عنوان فیلتر پیچشی akxk در نظر گرفت که در آن k می تواند عددی بزرگتر از 3 باشد. برای کاهش تعداد پارامترها، فیلتر akxk بیشتر به بلوک های 1 xk و kx 1، kx1 و 1xk تقسیم می شود که سپس خلاصه می شوند. بنابراین با افزایش مقدار k، زمینه بزرگ تری گرفته می شود.

علاوه بر این، نویسنده یک بلوک اصلاح مرزی را پیشنهاد میکند که شبیه یک بلوک باقیمانده در Resnet است که از یک اتصال میانبر و یک اتصال باقی مانده تشکیل شده است که برای به دست آوردن نتیجه خلاصه میشوند. مشاهده شده است که داشتن یک بلوک پالایش مرزی منجر به بهبود نتایج در مرز تقسیمبندی میشود.

نتایج نشان داد که بلوک GCN دقت طبقهبندی پیکسلهای نزدیکتر به مرکز شی را بهبود میبخشد که نشاندهنده بهبود ناشی از گرفتن زمینه دوربرد است در حالی که بلوک اصلاح مرز به بهبود دقت پیکسلهای نزدیکتر به مرز کمک میکند.

بیشتر از یک بار - KSAC برای Semantic Segmentation را ببینید

خانواده Deeplab از ASPP استفاده میکنند تا چندین فیلد گیرنده اطلاعات را با استفاده از نرخهای پیچش آتروس مختلف ضبط کنند. اگرچه ASPP به طور قابل توجهی در بهبود بخشبندی نتایج مفید بوده است، مشکلات ذاتی ناشی از معماری وجود دارد. هیچ اطلاعاتی در بین لایههای موازی مختلف در ASPP به اشتراک گذاشته نشده است، بنابراین بر قدرت تعمیم هستهها در هر لایه تأثیر میگذارد. همچنین از آنجایی که هر لایه به مجموعههای مختلفی از نمونههای آموزشی پاسخ میدهد (اشیاء کوچکتر به نرخ زگیل کوچکتر و اجسام بزرگتر به نرخ دهی بزرگتر)، مقدار دادهها برای هر لایه موازی کمتر خواهد بود، بنابراین بر تعمیمپذیری کلی تأثیر میگذارد. همچنین تعداد پارامترها در شبکه به صورت خطی با تعداد پارامترها افزایش می یابد و در نتیجه می تواند منجر به بیش از حد برازش شود.

برای رسیدگی به همه این مسائل، نویسنده یک ساختار شبکه جدید به نام کانولوشن آتروس به اشتراک گذاری هسته (KSAC) را پیشنهاد می کند. همانطور که در شکل بالا مشاهده می شود، به جای داشتن یک هسته متفاوت برای هر لایه موازی ASPP، یک هسته واحد در سراسر آن به اشتراک گذاشته می شود و بنابراین قابلیت تعمیم شبکه بهبود می یابد. با استفاده از KSAC به جای ASPP، 62% از پارامترها در صورت استفاده از نرخ اتساع 6,12،18 و XNUMX ذخیره می شود.

مزیت دیگر استفاده از ساختار KSAC این است که تعداد پارامترها مستقل از تعداد نرخ اتساع استفاده شده است. بنابراین ما میتوانیم تا آنجا که ممکن است نرخها را بدون افزایش اندازه مدل اضافه کنیم. ASPP بهترین نتایج را با نرخ های 6,12,18،6,12,18,24،XNUMX می دهد، اما دقت با XNUMX،XNUMX،XNUMX،XNUMX کاهش می یابد که نشان دهنده بیش از حد برازش احتمالی است. اما دقت KSAC هنوز بطور قابل توجهی بهبود می یابد که نشان دهنده قابلیت تعمیم پیشرفته است.

این تکنیک به اشتراک گذاری هسته همچنین می تواند به عنوان یک افزایش در فضای ویژگی دیده شود زیرا همان هسته در نرخ های متعدد اعمال می شود. مشابه اینکه چگونه افزایش ورودی نتایج بهتری به همراه دارد، تقویت ویژگی انجام شده در شبکه باید به بهبود قابلیت نمایش شبکه کمک کند.

تقسیم بندی ویدئو

برای موارد استفاده مانند اتومبیل های خودران، روباتیک و غیره نیاز به تقسیم بندی بلادرنگ در ویدیوی مشاهده شده وجود دارد. معماری های مورد بحث تا کنون تقریباً برای دقت طراحی شده اند و نه برای سرعت. بنابراین اگر آنها بر اساس هر فریم در یک ویدیو اعمال شوند، نتیجه با سرعت بسیار پایین خواهد آمد.

همچنین به طور کلی در یک ویدیو همپوشانی زیادی در صحنه ها در فریم های متوالی وجود دارد که می تواند برای بهبود نتایج و سرعت مورد استفاده قرار گیرد که اگر تجزیه و تحلیل بر اساس هر فریم انجام شود، در تصویر ظاهر نمی شود. با استفاده از این نشانهها، اجازه دهید در مورد معماریهایی که بهطور خاص برای ویدیوها طراحی شدهاند بحث کنیم

STFCN

Spatio-Temporal FCN پیشنهاد می کند از FCN همراه با LSTM برای انجام بخش بندی ویدیو استفاده شود. ما قبلاً از نحوه استفاده از FCN برای استخراج ویژگی های بخش بندی یک تصویر آگاه هستیم. LSTM نوعی شبکه عصبی است که می تواند اطلاعات متوالی را در طول زمان ضبط کند. STFCN قدرت FCN را با LSTM ترکیب می کند تا هم اطلاعات مکانی و هم اطلاعات زمانی را بگیرد.

همانطور که از شکل بالا مشاهده می شود STFCN متشکل از یک FCN، ماژول فضایی-زمانی است که توسط دکانولوشن دنبال می شود. نقشه ویژگی تولید شده توسط یک FCN به ماژول فضایی-زمانی فرستاده می شود که همچنین دارای ورودی از ماژول فریم قبلی است. ماژول مبتنی بر هر دو این ورودیها، اطلاعات زمانی را علاوه بر اطلاعات مکانی میگیرد و با استفاده از دکانولوشن مشابه نحوه انجام آن در FCN، آنها را به اندازه اصلی تصویر میفرستد.

از آنجایی که هر دو FCN و LSTM به عنوان بخشی از STFCN با هم کار می کنند، شبکه از انتها به پایان قابل آموزش است و از رویکردهای تقسیم بندی تک فریم بهتر عمل می کند. رویکردهای مشابهی وجود دارد که در آن LSTM با GRU جایگزین می شود، اما مفهوم همان گرفتن اطلاعات مکانی و زمانی است.

CNN های ویدیویی معنایی از طریق تاب برداشتن نمایش

این مقاله استفاده از جریان نوری در فریم های مجاور را به عنوان ورودی اضافی برای بهبود نتایج تقسیم بندی پیشنهاد می کند.

رویکرد پیشنهادی می تواند به هر معماری استاندارد به عنوان یک افزونه متصل شود. عنصر کلیدی که در بازی است ماژول NetWarp است. برای محاسبه نقشه تقسیمبندی، جریان نوری بین فریم فعلی و فریم قبلی محاسبه میشود، یعنی Ft و از یک FlowCNN عبور میکند تا Λ(Ft) به دست آید. این فرآیند تبدیل جریان نامیده می شود. این مقدار از طریق یک ماژول Warp که نقشه ویژگی یک لایه میانی محاسبه شده با عبور از شبکه را نیز به عنوان ورودی می گیرد. این یک نقشه ویژگی تاب خورده را می دهد که سپس با نقشه ویژگی میانی لایه فعلی ترکیب می شود و کل شبکه از انتها به انتها آموزش داده می شود. این معماری به نتایج SOTA در مجموعه دادههای معیار ویدیوی CamVid و Cityscapes دست یافت.

Clockwork Convnets برای تقسیم بندی معنایی ویدیویی

این مقاله با بهرهگیری از این واقعیت که اطلاعات معنایی در یک ویدیو در مقایسه با اطلاعات سطح پیکسل به کندی تغییر میکند، سرعت اجرای یک شبکه عصبی را برای کار تقسیمبندی روی ویدیوها بهبود میبخشد. بنابراین اطلاعات در لایه های نهایی با سرعت بسیار کمتری نسبت به لایه های ابتدایی تغییر می کند. مقاله زمان های مختلفی را پیشنهاد می کند

شکل بالا نشان دهنده نرخ مقایسه تغییرات برای استخر لایه میانی 4 و لایه عمیق fc7 است. در سمت چپ می بینیم که از آنجایی که تغییرات زیادی در فریم ها وجود دارد، هر دو لایه تغییر نشان می دهند اما تغییر برای pool4 بیشتر است. در سمت راست می بینیم که تغییر زیادی در فریم ها وجود ندارد. بنابراین pool4 تغییر حاشیه ای را نشان می دهد در حالی که fc7 تغییر تقریباً صفر را نشان می دهد.

این تحقیق از این مفهوم استفاده میکند و پیشنهاد میکند که در مواردی که تغییر زیادی در فریمها وجود ندارد، نیازی به محاسبه مجدد ویژگیها/خروجیها نیست و میتوان از مقادیر کش شده از فریم قبلی استفاده کرد. از آنجایی که نرخ تغییر با لایهها متفاوت است، میتوان ساعتهای مختلفی را برای مجموعههای مختلف لایه تنظیم کرد. هنگامی که ساعت تیک می زند، خروجی های جدید محاسبه می شود، در غیر این صورت از نتایج ذخیره شده استفاده می شود. نرخ تیک ساعت را می توان به صورت ایستا ثابت کرد یا به صورت پویا یاد گرفت

تقسیم بندی معنایی ویدیو با تأخیر کم

این مقاله در بالای بحث بالا با انتخاب تطبیقی فریم ها برای محاسبه نقشه تقسیم بندی یا استفاده از نتیجه ذخیره شده به جای استفاده از یک تایمر ثابت یا یک اکتشافی، بهبود می یابد.

این مقاله پیشنهاد میکند که شبکه را به دو بخش، ویژگیهای سطح پایین و ویژگیهای سطح بالا تقسیم کند. هزینه محاسبه ویژگی های سطح پایین در یک شبکه در مقایسه با ویژگی های بالاتر بسیار کمتر است. این تحقیق استفاده از ویژگی های شبکه سطح پایین را به عنوان شاخصی برای تغییر در نقشه تقسیم بندی پیشنهاد می کند. آنها در مشاهدات خود همبستگی قوی بین تغییر ویژگی های سطح پایین و تغییر نقشه تقسیم بندی پیدا کردند. بنابراین برای درک اینکه آیا نیاز به محاسبه در صورت نیاز به محاسبه ویژگیهای بالاتر وجود دارد، تفاوت ویژگیهای کمتر در 2 فریم پیدا میشود و اگر از یک آستانه خاص عبور کند با هم مقایسه میشود. کل این فرآیند توسط یک شبکه عصبی کوچک خودکار می شود که وظیفه آن گرفتن ویژگی های پایین تر از دو فریم و پیش بینی این است که آیا ویژگی های بالاتر باید محاسبه شوند یا خیر. از آنجایی که تصمیم شبکه مبتنی بر فریم های ورودی است، تصمیم اتخاذ شده در مقایسه با رویکرد فوق پویا است.

تقسیم بندی برای ابرهای نقطه ای

داده های دریافتی از حسگرهایی مانند لیدار در قالبی به نام Point Cloud ذخیره می شوند. ابر نقطه چیزی نیست جز مجموعه ای از مجموعه نامرتب از نقاط داده سه بعدی (یا هر بعد). این یک نمایش پراکنده از صحنه به صورت سه بعدی است و CNN نمی تواند مستقیماً در چنین موردی اعمال شود. همچنین هر معماری طراحی شده برای مقابله با ابرهای نقطه ای باید در نظر داشته باشد که مجموعه ای نامرتب است و از این رو می تواند جایگشت های احتمالی زیادی داشته باشد. بنابراین شبکه باید جایگشت ثابت باشد. همچنین نقاط تعریف شده در ابر نقطه را می توان با فاصله بین آنها توصیف کرد. بنابراین به طور کلی نقاط نزدیکتر حاوی اطلاعات مفیدی هستند که برای وظایف تقسیم بندی مفید است

PointNet

پوینت نت یک مقاله مهم در تاریخچه تحقیقات در مورد ابرهای نقطه با استفاده از یادگیری عمیق برای حل وظایف طبقه بندی و تقسیم بندی است. بیایید معماری Pointnet را مطالعه کنیم

ورودی شبکه برای n نقطه یک ماتریس nx 3 است. ماتریس nx 3 با استفاده از یک لایه چند پرسپترون مشترک (شبکه کاملاً متصل) به nx 64 نگاشت می شود که سپس به nx 64 و سپس به nx 128 و nx 1024 نگاشت می شود. Max pooling برای بدست آوردن بردار 1024 اعمال می شود که به k تبدیل می شود. خروجی با عبور از MLP با اندازه های 512، 256 و k. در نهایت خروجی های کلاس k مشابه هر شبکه طبقه بندی تولید می شوند.

طبقه بندی فقط با ویژگی های جهانی سروکار دارد، اما تقسیم بندی به ویژگی های محلی نیز نیاز دارد. بنابراین ویژگیهای محلی از لایه میانی در nx 64 با ویژگیهای سراسری الحاق میشود تا ماتریس anx 1088 به دست آید که از طریق mlp 512 و 256 برای رسیدن به nx 256 ارسال میشود و سپس با وجود MLPهای 128 و m برای دادن کلاسهای خروجی m برای هر نقطه در ابر نقطه

همچنین شبکه شامل یک تبدیل ورودی و تبدیل ویژگی به عنوان بخشی از شبکه است که وظیفه آن تغییر شکل ورودی نیست، بلکه اضافه کردن تغییر ناپذیری به تبدیلهای وابسته مانند ترجمه، چرخش و غیره است.

A-CNN

A-CNN استفاده از پیچش حلقوی را برای گرفتن اطلاعات مکانی پیشنهاد می کند. ما از CNN می دانیم که عملیات کانولوشن اطلاعات محلی را که برای درک تصویر ضروری است، ضبط می کند. A-CNN پیچیدگی جدیدی به نام پیچش حلقوی ابداع کرد که در نقاط همسایگی در یک نقطه-ابر اعمال می شود.

معماری به عنوان ورودی nx 3 نقطه می گیرد و نرمال هایی را برای آنها پیدا می کند که برای ترتیب نقاط استفاده می شود. یک نمونه فرعی از نقاط با استفاده از الگوریتم FPS گرفته می شود که نتیجه آن nix 3 است. بر روی این پیچش حلقوی برای افزایش به 128 بعد اعمال می شود. پیچیدگی حلقوی بر روی نقاط همسایگی که با استفاده از الگوریتم KNN تعیین میشوند، انجام میشود.

مجموعه دیگری از عملیات فوق برای افزایش ابعاد به 256 انجام می شود. سپس یک mlp برای تغییر ابعاد به 1024 اعمال می شود و برای بدست آوردن یک بردار جهانی 1024 مشابه نقطه-ابر، از ادغام استفاده می شود. کل این بخش رمزگذار در نظر گرفته می شود. برای طبقه بندی، خروجی سراسری رمزگذار از طریق mlp عبور داده می شود تا خروجی های کلاس c به دست آید. برای وظیفه تقسیم بندی، هر دو ویژگی جهانی و محلی مشابه PointCNN در نظر گرفته می شوند و سپس از طریق یک MLP عبور می کنند تا خروجی های کلاس m برای هر نقطه بدست آید.

متریک

بیایید در مورد معیارهایی بحث کنیم که معمولاً برای درک و ارزیابی نتایج یک مدل استفاده میشوند.

دقت پیکسل

دقت پیکسل اساسی ترین معیاری است که می تواند برای اعتبارسنجی نتایج استفاده شود. دقت با در نظر گرفتن نسبت پیکسلهای طبقهبندی شده درست در مجموع پیکسلها به دست میآید

دقت = (TP+TN)/(TP+TN+FP+FN)

عیب اصلی استفاده از چنین تکنیکی این است که اگر یک کلاس بر دیگری غلبه کند، نتیجه ممکن است خوب به نظر برسد. مثلاً بگویید کلاس پسزمینه 90 درصد از تصویر ورودی را پوشش میدهد، ما میتوانیم با طبقهبندی هر پیکسل به عنوان پسزمینه دقت 90 درصدی به دست آوریم.

تقاطع روی اتحاد

IOU به عنوان نسبت تقاطع حقیقت زمین و خروجی های تقسیم بندی پیش بینی شده بر روی اتحادیه آنها تعریف می شود. اگر برای چندین کلاس محاسبه کنیم، IOU هر کلاس محاسبه شده و میانگین آنها گرفته می شود. این یک متریک بهتر در مقایسه با دقت پیکسل است، زیرا اگر هر پیکسل به عنوان پسزمینه در ورودی کلاس 2 داده میشود، مقدار IOU (90/100+0/100)/2 است، یعنی 45٪ IOU که در مقایسه با 90 نمایش بهتری ارائه میدهد. ٪ دقت.

IOU با وزن فرکانس

این گسترشی است بر میانگین IOU که در مورد آن بحث کردیم و برای مبارزه با عدم تعادل طبقاتی استفاده می شود. اگر یک کلاس بر بیشتر قسمتهای تصاویر یک مجموعه داده مانند پسزمینه غالب باشد، باید در مقایسه با کلاسهای دیگر وزن شود. بنابراین به جای در نظر گرفتن میانگین تمام نتایج کلاس، یک میانگین وزنی بر اساس فراوانی منطقه کلاس در مجموعه داده گرفته می شود.

امتیاز F1

معیاری که معمولاً در طبقه بندی امتیاز F1 استفاده می شود، می تواند برای کار تقسیم بندی و همچنین برای مقابله با عدم تعادل کلاس استفاده شود.

دقت متوسط

ناحیه زیر منحنی دقت – یادآوری برای یک میانگین آستانه انتخاب شده IOU در کلاسهای مختلف برای اعتبارسنجی نتایج استفاده میشود.

توابع از دست دادن

تابع Loss برای هدایت شبکه عصبی به سمت بهینه سازی استفاده می شود. بیایید چند توابع از دست دادن محبوب را برای کار تقسیم بندی معنایی مورد بحث قرار دهیم.

از دست دادن آنتروپی متقاطع

میانگین ساده از دست دادن طبقه بندی متقابل آنتروپی برای هر پیکسل در تصویر می تواند به عنوان یک تابع کلی استفاده شود. اما این دوباره به دلیل عدم تعادل طبقاتی که FCN پیشنهاد می کند با استفاده از وزن کلاس اصلاح شود، آسیب می بیند

UNet سعی میکند با دادن وزن بیشتر به پیکسلهای نزدیک مرز که بخشی از مرز هستند در مقایسه با پیکسلهای داخلی، این موضوع را بهبود بخشد، زیرا این باعث میشود شبکه بیشتر بر روی شناسایی مرزها تمرکز کند و خروجی درشتی ارائه ندهد.

از دست دادن کانونی

از دست دادن کانونی برای تمرکز شبکه بر روی نمونه های سخت با دادن وزن بیشتر و همچنین برای مقابله با عدم تعادل طبقه شدید مشاهده شده در آشکارسازهای شی تک مرحله ای طراحی شده است. همین امر می تواند در وظایف تقسیم بندی معنایی نیز اعمال شود

از دست دادن تاس

عملکرد تاس چیزی جز امتیاز F1 نیست. این تابع ضرر مستقیماً سعی می کند امتیاز F1 را بهینه کند. به طور مشابه از امتیاز IOU مستقیم می توان برای اجرای بهینه سازی نیز استفاده کرد

باخت تورسکی

این یک نوع از دست دادن تاس است که سن متفاوتی را به FN و FP می دهد

فاصله هاسدورف

این تکنیکی است که برای اندازه گیری شباهت بین مرزهای حقیقت پایه و پیش بینی شده استفاده می شود. با یافتن حداکثر فاصله از هر نقطه در یک مرز تا نزدیکترین نقطه در مرز دیگر محاسبه می شود. کاهش مستقیم تابع از دست دادن مرز یک روند اخیر است و نشان داده شده است که نتایج بهتری به خصوص در موارد استفاده مانند تقسیمبندی تصویر پزشکی که در آن شناسایی مرز دقیق نقش کلیدی دارد، میدهد.

مزیت استفاده از از دست دادن مرز در مقایسه با از دست دادن مبتنی بر منطقه مانند IOU یا Dice Loss این است که تحت تأثیر عدم تعادل کلاس قرار نمی گیرد زیرا کل منطقه برای بهینه سازی در نظر گرفته نمی شود، فقط مرز در نظر گرفته می شود.

دو عبارت در نظر گرفته شده در اینجا برای دو مرز یعنی حقیقت پایه و پیش بینی خروجی هستند.

LabelMe :-

ابزار حاشیه نویسی تصویر نوشته شده در پایتون.

از حاشیه نویسی چند ضلعی پشتیبانی می کند.

متن باز و رایگان.

روی ویندوز، مک، اوبونتو یا از طریق Anaconda، Docker اجرا می شود

ارتباط دادن :- https://github.com/wkentaro/labelme

ابزار حاشیه نویسی بینایی کامپیوتر:-

ابزار حاشیه نویسی ویدئو و تصویر که توسط اینتل توسعه یافته است

رایگان و آنلاین در دسترس است

قابل اجرا بر روی ویندوز، مک و اوبونتو

ارتباط دادن :- https://github.com/opencv/cvat

حاشیه نویس تصویر Vgg:-

ابزار رایگان حاشیه نویسی تصویر منبع باز

صفحه html ساده < 200 کیلوبایت و می تواند به صورت آفلاین اجرا شود

از حاشیه نویسی چند ضلعی و نقاط پشتیبانی می کند.

ارتباط دادن :- https://github.com/ox-vgg/via

Rect Label: -

ابزار حاشیه نویسی پولی برای مک

می توانید از مدل های اصلی ML برای حاشیه نویسی اولیه تصاویر استفاده کنید

از چند ضلعی، مکعبی، خطوط و نقاط پشتیبانی می کند

ارتباط دادن :- https://github.com/ryouchinsa/Rectlabel-support

جعبه برچسب: -

ابزار حاشیه نویسی پولی

از ابزار قلم برای حاشیه نویسی سریعتر و دقیقتر پشتیبانی می کند

ارتباط دادن :- https://labelbox.com/product/image-segmentation

مجموعه داده ها

به عنوان بخشی از این بخش، بیایید در مورد مجموعه دادههای محبوب و متنوع موجود در عموم صحبت کنیم که میتوان از آنها برای شروع آموزش استفاده کرد.

زمینه پاسکال

این مجموعه داده گسترش مجموعه داده پاسکال VOC 2010 است و با ارائه حاشیه نویسی برای کل صحنه فراتر از مجموعه داده اصلی است و دارای بیش از 400 کلاس از داده های دنیای واقعی است.

ارتباط دادن :- https://cs.stanford.edu/~roozbeh/pascal-context/

مجموعه داده COCO

مجموعه داده COCO دارای 164 هزار تصویر از مجموعه داده اصلی COCO با حاشیه نویسی در سطح پیکسل است و یک مجموعه داده معیار رایج است. این 172 کلاس را پوشش می دهد: 80 کلاس چیز، 91 کلاس چیزها و 1 کلاس "بدون برچسب"

ارتباط دادن :- http://cocodataset.org/

مجموعه داده های Cityscapes

این مجموعه داده شامل حقایق زمینی تقسیم بندی برای جاده ها، خطوط، وسایل نقلیه و اشیاء در جاده است. مجموعه داده شامل 30 کلاس و 50 شهر است که در شرایط مختلف محیطی و آب و هوایی جمع آوری شده اند. همچنین دارای یک مجموعه داده ویدیویی از تصاویر با حاشیه نویسی ظریف است که می تواند برای تقسیم بندی ویدیو استفاده شود. کیتی و CamVid انواع مشابهی از مجموعه داده ها هستند که می توانند برای آموزش ماشین های خودران استفاده شوند.

ارتباط دادن :- https://www.cityscapes-dataset.com/

مجموعه داده Lits

مجموعه داده به عنوان بخشی از چالشی برای شناسایی ضایعات تومور از سی تی اسکن کبد ایجاد شد. مجموعه داده شامل 130 سی تی اسکن داده های آموزشی و 70 سی تی اسکن داده های آزمایشی است.

ارتباط دادن :- https://competitions.codalab.org/competitions/17094

مجموعه داده CCP

Cloth Co-Parsing مجموعه داده ای است که به عنوان بخشی از مقاله تحقیقاتی Clothing Co-Parsing توسط Joint Image Segmentation and Labeling ایجاد شده است. مجموعه داده شامل بیش از 1000 تصویر با حاشیه نویسی سطح پیکسل برای مجموع 59 برچسب است.

منبع:- https://github.com/bearpaw/clothing-co-parsing

مجموعه داده Pratheepan

مجموعه داده ای که برای وظیفه تقسیم بندی پوست بر اساس تصاویر گوگل شامل 32 عکس چهره و 46 عکس خانوادگی ایجاد شده است.

ارتباط دادن :- http://cs-chan.com/downloads_skin_dataset.html

برچسب گذاری تصویر هوایی اینریا

مجموعه داده ای از نقشه های تقسیم بندی هوایی ایجاد شده از تصاویر حوزه عمومی. دارای 810 کیلومتر مربع مساحت و دارای 2 کلاس ساختمانی و غیر ساختمانی.

ارتباط دادن :- https://project.inria.fr/aerialimagelabeling/

S3DIS

این مجموعه داده شامل ابرهای نقطه ای از شش قسمت داخلی در مقیاس بزرگ در 3 ساختمان با بیش از 70000 تصویر است.

ارتباط دادن :- http://buildingparser.stanford.edu/dataset.html

خلاصه

ما یک طبقهبندی از الگوریتمهای مختلف را مورد بحث قرار دادهایم که میتواند برای حل موارد استفاده از تقسیمبندی معنایی در تصاویر، ویدیوها یا ابرهای نقطه و همچنین مشارکتها و محدودیتهای آنها استفاده شود. ما همچنین راه های ارزیابی نتایج و مجموعه داده ها را برای شروع بررسی کردیم. این باید درک جامعی از تقسیم بندی معنایی به عنوان یک موضوع به طور کلی ارائه دهد.

برای دریافت لیستی از منابع بیشتر برای تقسیم بندی معنایی، با آن شروع کنید https://github.com/mrgloom/awesome-semantic-segmentation.

برای مطالعه بیشتر

ممکن است به آخرین پست های ما در این زمینه علاقه مند باشید:

به روز رسانی:

مطالب خواندنی بیشتر اضافه شد.

منبع: https://nanonets.com/blog/semantic-image-segmentation-2020/

- 2021

- 3d

- اضافی

- مزیت - فایده - سود - منفعت

- الگوریتم

- الگوریتم

- معرفی

- تحلیل

- معماری

- مقاله

- خودکار

- محک

- بهترین

- مرز

- بنا

- ظرفیت

- اتومبیل

- موارد

- گربه ها

- ایجاد می شود

- به چالش

- تغییر دادن

- کانال

- شهرستانها

- طبقه بندی

- نزدیک

- تن پوش

- ابر

- CNN

- آینده

- مشترک

- شرکت

- محاسبه

- چشم انداز کامپیوتر

- محاسبه

- اتصالات

- محتوا

- هزینه

- ایجاد

- سی تی اسکن

- جاری

- منحنی

- داده ها

- مقدار

- معامله

- معاملات

- یادگیری عمیق

- کشف

- بعد

- فاصله

- اسناد و مدارک

- سگ

- کوچک سازی

- رانندگی

- تجارت الکترونیک

- محیطی

- و غیره

- اعدام

- تجارب

- چهره

- خانواده

- ویژگی

- امکانات

- زمینه

- شکل

- فیلترها برای تصفیه آب

- سرانجام

- پیدا می کند

- پایان

- جریان

- تمرکز

- قالب

- رایگان

- تابع

- شکاف

- سوالات عمومی

- GIF

- دادن

- جهانی

- خوب

- گوگل

- گروه

- راهنمایی

- سخت افزار

- اینجا کلیک نمایید

- زیاد

- برجسته

- تاریخ

- چگونه

- HTTPS

- بزرگ

- انسان

- اندیشه

- شناسایی

- تصویر

- تقسیم بندی تصویر

- از جمله

- افزایش

- اطلاعات

- اینریا

- گرفتار

- مسائل

- IT

- نگهداری

- کلید

- برچسب

- برچسب ها

- بزرگ

- آخرین

- رهبری

- یاد گرفتن

- آموخته

- یادگیری

- سطح

- برخورد

- فهرست

- محلی

- بومی سازی

- محل

- طولانی

- نگاه

- شش

- مک

- فراگیری ماشین

- تکنیک های یادگیری ماشین

- عمده

- ساخت

- نقشه

- نقشه ها

- ماسک

- اندازه

- پزشکی

- متریک

- ML

- مدل

- نزدیک

- شبکه

- شبکه

- عصبی

- شبکه های عصبی

- شبکه های عصبی

- تشخیص شی

- باز کن

- منبع باز

- عملیات

- سفارش

- دیگر

- مقاله

- الگو

- تصویر

- پیکسل

- محبوب

- پست ها

- قدرت

- دقت

- پیش گویی

- در حال حاضر

- ساخته

- محصولات

- ویژگی

- عمومی

- پــایتــون

- کیفیت

- محدوده

- نرخ

- مطالعه

- زمان واقعی

- كاهش دادن

- تحقیق

- منابع

- نتایج

- این فایل نقد می نویسید:

- جاده ها

- رباتیک

- دویدن

- مقیاس

- جستجو

- ماشین های خودران

- خود رانندگی

- حس

- سلسله

- تنظیم

- به اشتراک گذاشته شده

- شش

- اندازه

- پوست

- کوچک

- So

- حل

- فضا

- فضایی

- سرعت

- انشعاب

- صحنه

- استنفورد

- آغاز شده

- پرده

- داستان

- گام های بلند برداشتن

- مهاجرت تحصیلی

- موفق

- تست

- زمان

- بالا

- آموزش

- دگرگونی

- ترجمه

- ترجمه

- اوبونتو

- اتحادیه

- موارد استفاده

- ارزش

- وسایل نقلیه

- تصویری

- فیلم های

- مجازی

- دید

- VOC

- W

- ویکیپدیا

- پنجره

- کلمات

- مهاجرت کاری

- با این نسخهها کار

- جهان

- X

- یوتیوب

- صفر