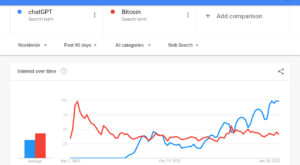

بحث جهانی هوش مصنوعی (AI) به نقطه حساسی رسیده است. اعلامیه های اخیر از سوی صاحبان وزن صنعت حاکی از اختلاف فاحش نظرات است. Yann LeCun، دانشمند ارشد هوش مصنوعی متا، در یک انتها ایستاده است و ایمنی هوش مصنوعی را در شکل فعلی آن تایید می کند.

برعکس، دکتر جفری هینتون، که با محبت "پدرخوانده هوش مصنوعی" خوانده می شود، از گوگل استعفا داد تا نگرانی های مبرم خود را روشن کند.

🔥 به روز رسانی روزانه Ai!

🤖 تهدید آی برای بشریت

• Yann LeCun، دانشمند ارشد هوش مصنوعی متا، می گوید که نگرانی ها در مورد خطرات وجودی هوش مصنوعی "نابهنگام" است.

• LeCun هشدار می دهد که مقررات زودهنگام هوش مصنوعی، تسلط Big Tech را تقویت می کند و رقابت را خفه می کند.

• او از رگولاتورها انتقاد می کند،… pic.twitter.com/PAvds4MRp5

- Hotep Jesus (@HotepJesus) اکتبر 20، 2023

بحث بزرگ هوش مصنوعی

در خود مصاحبه با فایننشال تایمز، لکان حرفی نزد. او نگرانیها در مورد خطر وجودی هوش مصنوعی را «بیموقع» خواند. او همچنین توضیح داد که این ایده که هوش مصنوعی میتواند بشریت را از بین ببرد «احمقانه» است. با این حال، این دیدگاه باعث می شود که بحث فعلی در مورد هوش مصنوعی بسیار جذاب باشد.

او بر محدودیتهای فعلی هوش مصنوعی تأکید میکند: «بحث در مورد ریسک وجودی بسیار زودرس است تا زمانی که ما طراحی سیستمی داشته باشیم که بتواند از نظر تواناییهای یادگیری با گربه رقابت کند، چیزی که در حال حاضر نداریم.» علاوه بر این، LeCun تاکید کرد که مدلهای فعلی هوش مصنوعی ما باید پیچیدگیهای دنیای ما را درک کنند. آنها نمی توانند واقعاً برنامه ریزی یا استدلال کنند.

با این حال، چنین خوش بینی در خارج از جامعه هوش مصنوعی مشترک است. دکتر هینتون عزیمت، خروج از سوی گوگل و توضیحات بعدی بر این واگرایی تاکید دارد. نگرانی های فوری او شامل پتانسیل هوش مصنوعی است سوء استفاده در پلتفرم های آنلاین او می ترسد که هوش مصنوعی اینترنت را با عکس ها، فیلم ها و متن های جعلی پر کند و تمایز بین محتوای واقعی و تولید شده توسط هوش مصنوعی را به طور فزاینده ای پیچیده کند.

دکتر هینتون گفت که او شغل خود را در گوگل رها کرده است، جایی که بیش از یک دهه در آن کار کرده و به یکی از معتبرترین صداها در این زمینه تبدیل شده است، بنابراین می تواند آزادانه درباره خطرات هوش مصنوعی صحبت کند. او گفت که بخشی از او اکنون از کار زندگی خود پشیمان است.

«من خودم را با…

— Lior⚡ (@AlphaSignalAI) ممکن است 4، 2023

فراتر از این پیامدهای مستقیم، ترسهای گستردهتر هینتون حول تأثیرات اجتماعی هوش مصنوعی، به ویژه از دست دادن شغل بالقوه و رقابت تسلیحاتی در حال تشدید هوش مصنوعی میچرخد. این نگرانی اخیر به صراحت بر توسعه سیستم های تسلیحاتی خود مختار مرگبار (LAWS) می پردازد.

اشتباهات و استفاده نادرست هوش مصنوعی

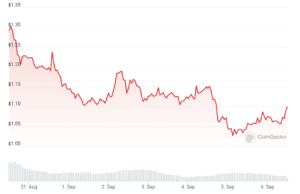

یکی دیگر از ابعاد مکالمه هوش مصنوعی، سوء استفاده احتمالی آن است. به عنوان مثال، پلتفرم ارزهای دیجیتال مشهور جهانی بایننس خود را در میان یک کمپین افشاگری ایجاد شده توسط هوش مصنوعی یافت. هوش مصنوعی به طور نادرستی مدیر عامل خود، Changpeng "CZ" Zhao را با یک سازمان جوانان حزب کمونیست چین مرتبط کرد.

علاوه بر این، ابزارهای هوش مصنوعی پتانسیل تولید اخبار جعلی را نشان داده اند که باعث نگرانی های قابل توجهی در چشم انداز رسانه ها شده است. به عنوان مثال، دیلی میل در انتشار داستانی بر اساس اطلاعات تولید شده توسط هوش مصنوعی گمراه شد که بعداً آن را پس گرفت. این موارد بر ترس هایی تأکید می کند که کارشناسانی مانند دکتر هینتون از آن دفاع کرده اند.

احتیاط جهانی را فرا می خواند

در حالی که صداهای فردی ضروری است، قدردانی های جمعی حتی گویاتر است. چندین متخصص هوش مصنوعی، از جمله کسانی که در راس سازمانهایی مانند OpenAI و Google DeepMind هستند، به طور مشترک نگرانیهای خود را ابراز کردهاند. بیانیه مشترک آنها، مختصر و در عین حال قدرتمند، میگوید: «کاهش خطر انقراض ناشی از هوش مصنوعی باید در کنار سایر خطرات اجتماعی مانند همهگیریها و جنگ هستهای، یک اولویت جهانی باشد.»

با این حال، مسیر رو به جلو می تواند حتی در این فراخوان جمعی برای احتیاط آشکارتر باشد. مدیر عامل OpenAI، سم آلتمن، نگاهی اجمالی به این روایت پیچیده ارائه کرد. در حالی که او قبل از الف ظاهر شد جلسه دادگاه سنا برای بحث در مورد مقررات هوش مصنوعی، او بر اهمیت کنترل و تعادل بدون توقف نوآوری تأکید کرد.

جلسه استماع کمیته فرعی سنای ایالات متحده در خصوص حریم خصوصی، فناوری و قانون برای بحث در مورد تنظیم الگوریتم های هوش مصنوعی برگزار شد. مدیر عامل شرکت سام آلتمن اظهار داشت: "اگر این فناوری اشتباه کند، ممکن است کاملاً اشتباه شود." https://t.co/WlVjJtdahf

جورج شماره 8، "ظهور روزنامه نگاران شهروند"،…

— مجله George® (@GeorgeOnlineLLC) ممکن است 26، 2023

حرکت رو به جلو با هوش مصنوعی

پیمایش در این بحثها از آنجایی که جامعه عمیقتر به دوران تحت سلطه هوش مصنوعی میپردازد، بسیار مهم خواهد بود. در حالی که رهبران صنعت مانند LeCun به مسیر مثبت هوش مصنوعی ابراز اطمینان می کنند، صداهای احتیاطی مانند هینتون ما را به یاد چالش های پیش رو می اندازد.

ایجاد تعادل ظریف بین نوآوری و مقررات بسیار مهم خواهد بود. گفتمان جاری پیرامون خطرات و فرصتهای بالقوه هوش مصنوعی بیش از آکادمیک است، زیرا نقش تعیینکنندهای در نحوه استفاده بشر از این فناوری تحولآفرین خواهد داشت.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- منبع: https://metanews.com/metas-chief-ai-scientist-dismisses-existential-threat-of-ai/

- : دارد

- :است

- :جایی که

- ٪۱۰۰

- 16

- 20

- 26

- 8

- a

- درباره ما

- دانشگاهی

- علاوه بر این

- حمایت از

- در برابر

- پیش

- AI

- مدل های هوش مصنوعی

- مقررات هوش مصنوعی

- الگوریتم

- در کنار

- در میان

- an

- و

- ظاهر

- به نظر می رسد

- هستند

- اسلحه

- دور و بر

- مصنوعی

- هوش مصنوعی

- هوش مصنوعی (AI)

- AS

- ادعا

- مرتبط است

- At

- خود مختار

- برج میزان

- تعادل

- مستقر

- BE

- شد

- بوده

- قبل از

- میان

- بزرگ

- فناوری بزرگ

- بنیان

- گسترده تر

- by

- صدا

- کمپین بین المللی حقوق بشر

- CAN

- قابلیت های

- CAT

- باعث می شود

- احتیاط

- مدیر عامل شرکت

- چالش ها

- Changpeng

- چک

- رئیس

- چینی

- حزب کمونیست چینی

- شهروند

- Collective - Dubai Hills Estate

- انجمن

- پیچیده

- نگرانی

- نگرانی ها

- اعتماد به نفس

- کنسول

- محتوا

- گفتگو

- میتوانست

- بحرانی

- انتقاد می کند

- کریپتو کارنسی (رمز ارزها )

- جاری

- روزانه

- خطرات

- مناظره

- بحث

- دهه

- عمیق تر

- Deepmind

- تعریف کردن

- طرح

- در حال توسعه

- تمایز

- بعد

- مستقیم

- گفتگو

- بحث و تبادل نظر

- واگرایی

- تسلط

- آیا

- dr

- توسعه یافته

- از بین بردن

- اهمیت دادن

- تأکید می کند

- پایان

- عصر

- ضروری است

- اتر (ETH)

- حتی

- مثال

- وجودی

- کارشناسان

- صریح

- بیان

- انقراض

- جعلی

- اخبار جعلی

- ترس

- رشته

- مالی

- فایننشال تایمز

- سیل

- برای

- فرم

- به جلو

- یافت

- از جانب

- FT

- بیشتر

- مولد

- نظر اجمالی

- جهانی

- Go

- می رود

- گوگل

- بزرگ

- آیا

- he

- سنگین وزن

- برگزار شد

- برجسته

- او را

- خود را

- چگونه

- اما

- HTTPS

- بشریت

- اندیشه

- if

- فوری

- تأثیر

- پیامدهای

- اهمیت

- in

- شامل

- از جمله

- به طور فزاینده

- فرد

- صنعت

- اطلاعات

- ابداع

- نمونه

- نمونه ها

- اطلاعات

- اینترنت

- به

- پیچیدگی ها

- موضوع

- IT

- ITS

- خود

- کار

- مشترک

- روزنامه نگاران

- چشم انداز

- بعد

- قانون

- قوانین

- رهبران

- یادگیری

- سبک

- پسندیدن

- محدودیت

- تلفات

- مجله

- باعث می شود

- ساخت

- رسانه ها

- متا

- سوء استفاده

- مدل

- لحظه

- بیش

- اکثر

- yo mismo

- روایت

- نیاز

- اخبار

- نه

- به ویژه

- اکنون

- هستهای

- of

- on

- ONE

- مداوم

- آنلاین

- سیستم عامل های آنلاین

- OpenAI

- دیدگاه ها

- فرصت ها

- خوشبینی

- or

- کدام سازمان ها

- سازمان های

- دیگر

- ما

- خارج

- خارج از

- روی

- بیماری همه گیر

- بخش

- حزب

- مسیر

- چشم انداز

- عکس

- محوری

- برنامه

- سکو

- سیستم عامل

- افلاطون

- هوش داده افلاطون

- PlatoData

- بازی

- مثبت

- قوی

- پتانسیل

- زودرس

- در حال حاضر

- فشار

- اولویت

- خلوت

- ارائه

- انتشار

- کاملا

- نژاد

- رسیده

- واقعی

- دلیل

- اخیر

- تاسف

- تنظیم

- رگولاتور

- استعفا داد

- احترام

- طلوع

- خطر

- خطرات

- رقیب

- نقش

- s

- ایمنی

- سعید

- سام

- می گوید:

- دانشمند

- مجلس سنا

- چند

- به اشتراک گذاشته شده

- ریختن

- باید

- نشان داده شده

- قابل توجه

- پس از

- So

- اجتماعی

- جامعه

- استحکام بخشیدن

- سخن گفتن

- می ایستد

- کامل

- اظهار داشت:

- بیانیه

- داستان

- کمیته فرعی

- متعاقب

- چنین

- نشان می دهد

- سیستم

- سیستم های

- فن آوری

- پیشرفته

- گفتن

- قوانین و مقررات

- متن

- نسبت به

- که

- La

- فایننشال تایمز

- قانون

- شان

- اینها

- آنها

- این

- کسانی که

- تهدید

- بار

- به

- ابزار

- کلید

- مسیر

- دگرگونی

- درست

- توییتر

- ما

- تاکید

- فهمیدن

- تا

- us

- بسیار

- فیلم های

- صداها

- جنگ

- هشدارها

- بود

- we

- تسلیحات

- که

- در حین

- اراده

- با

- در داخل

- بدون

- کلمات

- مهاجرت کاری

- مشغول به کار

- جهان

- مشهور جهان

- اشتباه

- هنوز

- جوانان

- زفیرنت

- ژائو