با تأمل در 15 ماه گذشته، پیشرفت در هوش مصنوعی مولد و مدلهای زبان بزرگ (LLM) پس از معرفی و در دسترس بودن ChatGPT برای عموم، بر سرفصلهای خبرها غالب شده است.

بلوک سازنده این پیشرفت، معماری مدل ترانسفورماتور بود که توسط تیمی از محققان گوگل در مقاله ای با عنوان "توجه تنها چیزی است که نیاز دارید" همانطور که از عنوان پیداست، یکی از ویژگی های کلیدی تمام مدل های ترانسفورماتور مکانیسم توجه است که در مقاله به شرح زیر تعریف شده است:

"یک تابع توجه را می توان به عنوان نگاشت یک پرس و جو و مجموعه ای از جفت های کلید-مقدار به یک خروجی توصیف کرد، جایی که پرس و جو، کلیدها، مقادیر و خروجی همه بردار هستند. خروجی به عنوان مجموع وزنی مقادیر محاسبه می شود، جایی که وزن اختصاص داده شده به هر مقدار توسط تابع سازگاری پرس و جو با کلید مربوطه محاسبه می شود.

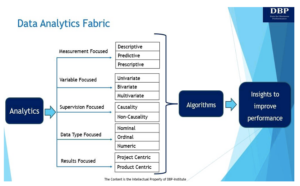

یکی از ویژگیهای مدلهای هوش مصنوعی تولیدی، مصرف انبوه ورودیهای داده است که میتواند شامل متن، تصاویر، فایلهای صوتی، فایلهای ویدیویی یا هر ترکیبی از ورودیها باشد (موردی که معمولاً به آن «چند وجهی» میگویند). از منظر کپی رایت، یک سوال مهم (از بسیاری از سؤالات مهم) این است که آیا مواد آموزشی در آن حفظ می شود یا خیر مدل زبان بزرگ (LLM) تولید شده توسط فروشندگان مختلف LLM. برای کمک به پاسخ به این سوال، باید بدانیم که مواد متنی چگونه پردازش می شوند. با تمرکز بر متن، آنچه در ادامه میآید شرح مختصری و غیر فنی دقیقاً همان جنبه آموزش LLM است.

انسان ها با قرار دادن کلمات در توالی به زبان طبیعی ارتباط برقرار می کنند. قوانین مربوط به ترتیب و شکل خاص یک کلمه توسط زبان خاص (مثلاً انگلیسی) دیکته می شود. بخش اساسی معماری برای همه سیستمهای نرمافزاری که متن را پردازش میکنند (و بنابراین برای همه سیستمهای هوش مصنوعی که این کار را انجام میدهند) این است که چگونه آن متن را نشان دهیم تا عملکردهای سیستم به بهترین نحو انجام شود. بنابراین، یک مرحله کلیدی در پردازش یک ورودی متنی در مدلهای زبان، تقسیم ورودی کاربر به «کلمات» ویژهای است که سیستم هوش مصنوعی میتواند آن را درک کند. به این کلمات خاص «نشان» می گویند. مؤلفه ای که مسئول آن است «توکنایزر» نامیده می شود. انواع مختلفی از توکن سازها وجود دارد. به عنوان مثال، OpenAI و Azure OpenAI از یک روش رمزگذاری زیرکلمه به نام «Byte-Pair Encoding (BPE)» برای مدلهای مبتنی بر ترانسفورماتور پیشآموزشی (GPT) خود استفاده میکنند. BPE روشی است که متداولترین جفت کاراکترها یا بایتها را در یک توکن ادغام میکند تا زمانی که به تعداد معینی نشانه یا اندازه واژگان برسد. هر چه اندازه واژگان بزرگتر باشد، متن هایی که مدل می تواند تولید کند متنوع تر و گویاتر است.

هنگامی که سیستم هوش مصنوعی متن ورودی را به توکنها نگاشت، نشانهها را به اعداد رمزگذاری میکند و توالیهایی را که پردازش میکند به عنوان بردارهایی تبدیل میکند که به آنها «جاسازی کلمه» گفته میشود. بردار مجموعه ای مرتب از اعداد است - می توانید آن را به عنوان یک ردیف یا ستون در یک جدول در نظر بگیرید. این بردارها نمایش هایی از نشانه هایی هستند که نمایش زبان طبیعی اصلی خود را که به عنوان متن ارائه شده است حفظ می کنند. درک نقش جاسازی کلمات در مورد کپی رایت بسیار مهم است زیرا جاسازی ها نمایش (یا رمزگذاری) کل جملات یا حتی پاراگراف ها را تشکیل می دهند و بنابراین، در ترکیب های برداری، حتی کل اسناد را در یک فضای برداری با ابعاد بالا تشکیل می دهند. از طریق این تعبیهها است که سیستم هوش مصنوعی معنی و روابط کلمات را از زبان طبیعی ضبط و ذخیره میکند.

جاسازی ها عملاً در هر کاری که یک سیستم هوش مصنوعی مولد انجام می دهد استفاده می شود (به عنوان مثال، تولید متن، خلاصه سازی متن، طبقه بندی متن، ترجمه متن، تولید تصویر، تولید کد و غیره). تعبیههای کلمه معمولاً در پایگاههای داده برداری ذخیره میشوند، اما شرح دقیق همه رویکردهای ذخیرهسازی خارج از محدوده این پست است زیرا طیف گستردهای از فروشندگان، فرآیندها و شیوههای در حال استفاده وجود دارد.

همانطور که گفته شد، تقریباً تمام LLM ها بر اساس معماری Transformer هستند که مکانیسم توجه را فراخوانی می کند. دومی به فناوری هوش مصنوعی اجازه میدهد تا کل جملات و حتی پاراگرافها را بهجای دنبالهای از شخصیتها، بهعنوان یک کل ببیند. این به نرمافزار اجازه میدهد تا زمینههای مختلفی را که در آن یک کلمه میتواند رخ دهد، ضبط کند، و از آنجایی که این زمینهها توسط آثار مورد استفاده در آموزش، از جمله آثار دارای حق چاپ، ارائه میشوند، دلخواه نیستند. به این ترتیب، استفاده اصلی از کلمات، بیان اثر اصلی، در سیستم هوش مصنوعی حفظ می شود. می توان آن را بازتولید و تجزیه و تحلیل کرد و می تواند مبنای عبارات جدیدی باشد (که بسته به شرایط خاص، ممکن است در اصطلاح کپی رایت به عنوان "کار مشتق" شناخته شود).

LLM ها عبارات آثار اصلی را که بر روی آنها آموزش دیده اند حفظ می کنند. آنها نمایش های داخلی متن را در فضاهای برداری هدفمند تشکیل می دهند و با توجه به ورودی مناسب به عنوان یک ماشه، می توانند آثار اصلی را که در آموزش آنها استفاده شده است، بازتولید کنند. سیستمهای هوش مصنوعی از محتوا، از جمله محتوای دارای حق نسخهبرداری، که برای آموزش LLMهایی که بر اساس آنها هستند، استفاده میشود، مزایای همیشگی دارند. LLM ها زمینه کلمات را بر اساس بیان کلمات در اثر اصلی تشخیص می دهند. و این زمینه به طور انباشته به سیستم هوش مصنوعی در هزاران یا میلیونها اثر دارای حق چاپ که در آموزش استفاده میشوند، سود میرساند. این آثار اصلی را میتوان توسط سیستم هوش مصنوعی دوباره ایجاد کرد، زیرا آنها در بردارها - نمایشهای فضای برداری نشانههایی که بازنمایی زبان طبیعی اصلی خود را حفظ میکنند - از اثر دارای حق چاپ ذخیره میشوند. از منظر کپی رایت، تعیین اینکه آیا مواد آموزشی در LLM حفظ می شود یا خیر، در مرکز موضوع است، و واضح است که پاسخ به این سوال مثبت است.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- منبع: https://www.dataversity.net/heart-of-the-matter-demystifying-copying-in-the-training-of-llms/

- : دارد

- :است

- :نه

- :جایی که

- ٪۱۰۰

- a

- درباره ما

- در میان

- Ad

- AI

- مدل های هوش مصنوعی

- سیستم های هوش مصنوعی

- معرفی

- اجازه می دهد تا

- تقریبا

- an

- تجزیه و تحلیل

- و

- پاسخ

- هر

- رویکردها

- مناسب

- دلخواه

- معماری

- هستند

- AS

- پرسیدن

- ظاهر

- اختصاص داده

- At

- توجه

- سمعی

- دسترس پذیری

- لاجوردی

- مستقر

- اساس

- BE

- زیرا

- بوده

- مزایای

- خارج از

- مسدود کردن

- بنا

- اما

- by

- نام

- CAN

- گرفتن

- جلب

- مورد

- معین

- مشخصه

- مشخص شده است

- کاراکتر

- GPT چت

- موقعیت

- طبقه بندی

- واضح

- رمز

- ستون

- ترکیب

- ترکیب

- می آید

- ارتباط

- سازگاری

- جزء

- محاسبه شده

- مصرف

- محتوا

- زمینه

- زمینه ها

- کپی برداری

- حق چاپ

- متناظر

- میتوانست

- داده ها

- پایگاه های داده

- DATAVERSITY

- مشخص

- بستگی دارد

- استخراج

- شرح داده شده

- شرح

- دقیق

- تعیین

- دیکته شده

- مختلف

- DM

- do

- اسناد و مدارک

- تحت سلطه

- e

- هر

- موثر

- پشتیبانی می کند

- انگلیسی

- تمام

- محق

- ضروری است

- اتر (ETH)

- حتی

- واقعه

- هر

- کاملا

- مثال

- بیان

- اصطلاحات

- رسا

- ویژگی

- فایل ها

- تمرکز

- پیروی

- به دنبال آن است

- برای

- فرم

- غالبا

- از جانب

- تابع

- توابع

- تولید می کنند

- نسل

- مولد

- هوش مصنوعی مولد

- داده

- گوگل

- آیا

- عناوین

- قلب

- کمک

- چگونه

- چگونه

- HTTPS

- تصویر

- تولید تصویر

- تصاویر

- مهم

- in

- از جمله

- ورودی

- ورودی

- داخلی

- به

- معرفی

- فراخوانی میکند

- IT

- کلید

- کلید

- زبان

- بزرگ

- بزرگتر

- llm

- ساخته

- بسیاری

- نقشه برداری

- عظیم

- مصالح

- ماده

- ممکن است..

- معنی

- مکانیزم

- ذکر شده

- تولید گزارشات تاریخی

- ادغام می شود

- روش

- میلیون ها نفر

- مدل

- مدل

- ماه

- بیش

- اکثر

- طبیعی

- زبان طبیعی

- نیاز

- NeurIPS

- جدید

- عضویت در خبرنامه

- غیر فنی

- عدد

- تعداد

- رخ می دهد

- اتفاق می افتد

- of

- on

- OpenAI

- or

- اصلی

- مشخص شده

- تولید

- جفت

- مقاله

- بخش

- گذشته

- انجام

- انجام می دهد

- همیشگی

- چشم انداز

- دادن

- افلاطون

- هوش داده افلاطون

- PlatoData

- پست

- عملا

- شیوه های

- حفظ شده است

- روند

- پردازش

- فرآیندهای

- در حال پردازش

- ساخته

- پیشرفت

- ارائه

- عمومی

- پرس و جو

- سوال

- سوالات

- نسبتا

- رسیده

- شناختن

- اشاره

- روابط

- نشان دادن

- نمایندگی

- محققان

- مسئوليت

- نگه داشتن

- حفظ شده است

- نقش

- ROW

- قوانین

- حوزه

- ترتیب دهی

- تنظیم

- تنها

- اندازه

- So

- نرم افزار

- فضا

- فضاها

- ویژه

- خاص

- گام

- ذخیره سازی

- ذخیره شده

- پرده

- حاکی از

- مجموع

- سیستم

- سیستم های

- جدول

- کار

- تیم

- پیشرفته

- متن

- طبقه بندی متن

- تولید متن

- متن

- نسبت به

- که

- La

- شان

- آنجا.

- از این رو

- اینها

- آنها

- فکر می کنم

- این

- کسانی که

- هزاران نفر

- از طریق

- عنوان

- به

- رمز

- از Tokenization

- نشانه

- قطار

- آموزش دیده

- آموزش

- ترانسفورماتور

- ترجمه

- ماشه

- انواع

- فهمیدن

- تا

- بر

- استفاده کنید

- استفاده

- کاربر

- معمولا

- ارزش

- ارزشها

- تنوع

- مختلف

- فروشندگان

- تصویری

- چشم انداز

- مشاهده شده

- بود

- مسیر..

- we

- هفتگی

- وزن

- بود

- چی

- چه زمانی

- چه

- که

- تمام

- وسیع

- با

- در داخل

- کلمه

- کلمات

- مهاجرت کاری

- با این نسخهها کار

- بله

- شما

- زفیرنت