استرالیا در اقدامی برای مقابله با چالش های ناشی از هوش مصنوعی، این کار را انجام داده است اعلام کرد تشکیل هیئت مشورتی جدید

کل «اجازه دهید هر کاری را که میخواهید انجام دهد - شما بیرون هستید، میتوانید بدون مرز نوآوری کنید» - من فکر میکنم که ما از آن گذشتهایم. آن روزها رفتند.» - اد هوسیک، وزیر *علم* استرالیا در مورد آنچه که می خواهد در مورد هوش مصنوعی و فناوری به طور کلی انجام دهد. pic.twitter.com/fn13FzZjg8

- برت هال (@ToKTeacher) ژانویه 17، 2024

این ابتکار، همانطور که توسط دولت فاش شده است، نشان دهنده تلاش های شدید استرالیا برای تنظیم فناوری های هوش مصنوعی است. تأسیس این نهاد بر تمرکز این کشور بر پیمایش چشمانداز پیچیده هوش مصنوعی، متعادل کردن منافع اقتصادی آن در برابر خطرات احتمالی تأکید میکند.

درک چشم انداز هوش مصنوعی

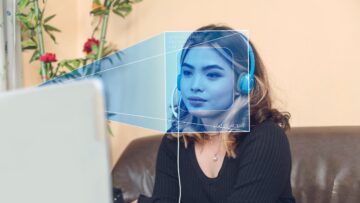

هوش مصنوعی به سرعت در حال تسخیر صنایع است که نشانگر میزان رشد اقتصادی است. اد هوسیک وزیر علوم و صنعت تاکید کرد که هوش مصنوعی چگونه پتانسیل رشد اقتصاد را دارد. با این حال، او همچنین به کاربرد ناهموار هوش مصنوعی در تجارت اشاره کرد که نشان دهنده نیاز به یکپارچگی گسترده تر و سازگارتر است. در حالی که پتانسیل بالایی دارد، در مورد فناوری هوش مصنوعی تردید وجود دارد. مسائل مربوط به اعتماد مربوط به فناوری هوش مصنوعی به موضوعی تبدیل شده است که مانع پذیرش این فناوری می شود. Husic این اعتماد کم را به عنوان بخشی از دلیل مانع از جذب فناوری های سودمند هوش مصنوعی معرفی کرد.

همچنین یک مسئله اعتماد در اطراف خود فناوری وجود دارد و این اعتماد کم به ترمز دستی در برابر جذب فناوری تبدیل می شود و این چیزی است که ما باید با آن مقابله کنیم.

با این حال، اقدام پیشگیرانه استرالیا با مقررات هوش مصنوعی کاملاً جدید نیست. در سال 2015، این کشور مسیری را برای ایجاد اولین کمیسیون امنیت الکترونیکی در جهان ایجاد کرد. با این حال، استرالیا نسبت به سایر کشورهایی که تلاش می کنند به هوش مصنوعی برسند، دیرتر عمل کرده است. تأسیس این نهاد مشورتی مطابق با هنجارهای جهانی به ویژه اتحادیه اروپا است که قبلاً مقررات اجباری در زمینه هوش مصنوعی برای شرکت های فناوری دارد. با این حال، اولین مجموعه دستورالعمل های استرالیا داوطلبانه خواهد بود، که منعکس کننده یک رویکرد محتاطانه به حاکمیت هوش مصنوعی است.

به سوی آینده ای امن تر هوش مصنوعی

در پاسخ به اهمیت روزافزون هوش مصنوعی، استرالیا سال گذشته مشاوره ای را آغاز کرد که بیش از 500 پاسخ دریافت کرد. این امر نشان دهنده علاقه و نگرانی بالای مردم و سهامداران صنعت است. دولت به دنبال محدود کردن برنامه های کاربردی هوش مصنوعی به "خطر کم" و آنهایی که "خطر بالا" دارند، است. به عنوان مثال، استفاده از هوش مصنوعی برای فیلتر کردن ایمیلهای اسپم کم خطر در نظر گرفته میشود، در حالی که ایجاد محتوای دستکاری شده مانند «جعلی عمیق» پرخطر محسوب میشود. پاسخ کامل دولت به این مشاوره که در اواخر سال جاری برگزار می شود، بسیار پیش بینی شده است و احتمالاً جهت آینده سیاست هوش مصنوعی در استرالیا را شکل خواهد داد.

علاوه بر این، دولت استرالیا قصد دارد با نهادهای صنعتی دست به دست هم دهد و مجموعهای از این موارد را ارائه کند دستورالعمل های هوش مصنوعی. این دستورالعملها شرکتهای فناوری را تشویق میکند تا شیوههایی مانند برچسبگذاری و واترمارک کردن محتوای تولید شده توسط هوش مصنوعی را اتخاذ کنند. چنین مراحلی در افزایش شفافیت و اعتماد با برنامههای هوش مصنوعی حیاتی هستند و سهولت در تمایز را تسهیل میکنند.محتوای جعلی عمیق ایجاد شده توسط هوش مصنوعی از آنچه انسان ها می سازند.

تعادل نوآوری و ایمنی

ایجاد هیئت مشاوره و دستورالعمل های پیشنهادی نشان دهنده تلاشی برای ایجاد تعادل ظریف بین تقویت نوآوری و تضمین ایمنی است. ماهیت داوطلبانه دستورالعمل های اولیه نشان دهنده تمایل به تشویق به انطباق بدون سرکوب نوآوری است. این رویکرد ممکن است با تغییر چشمانداز هوش مصنوعی تکامل یابد و دولت را ملزم کند تا استراتژیهای خود را با پیشرفتها و چالشهای جدید در هوش مصنوعی تطبیق دهد.

از آنجایی که دولت آماده می شود تا پاسخ کامل خود را به مشاوره هوش مصنوعی در اواخر سال جاری منتشر کند، پیش بینی های زیادی در مورد آینده مقررات هوش مصنوعی در استرالیا وجود دارد. این پاسخ احتمالاً مشخص خواهد کرد که چگونه استرالیا از تعامل پیچیده بین پیشرفت فناوری و ملاحظات اخلاقی عبور می کند.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- منبع: https://metanews.com/australia-sets-up-an-advisory-body-to-address-ai-risk-concerns/

- : دارد

- :است

- $UP

- 10

- 17

- 2015

- 500

- 8

- a

- درباره ما

- وفق دادن

- نشانی

- اتخاذ

- اتخاذ

- پیشرفت

- مشاوره

- در برابر

- AI

- حکمرانی هوش مصنوعی

- هوش مصنوعی در تجارت

- مقررات هوش مصنوعی

- قبلا

- همچنین

- در میان

- an

- و

- پیش بینی

- پیش بینی

- کاربرد

- برنامه های کاربردی

- روش

- هستند

- دور و بر

- مصنوعی

- هوش مصنوعی

- AS

- کوشش

- استرالیا

- استرالیا

- برج میزان

- موازنه

- BE

- شدن

- تبدیل شدن به

- بوده

- مفید

- مزایای

- میان

- شعله ور

- بدن

- بدن

- گسترده تر

- گسترده

- کسب و کار

- by

- CAN

- کشتی

- محتاط

- چالش ها

- تبادل

- COM

- مامور عالی رتبه دولت

- شرکت

- کامل

- پیچیده

- انطباق

- نگرانی

- نگرانی ها

- ملاحظات

- در نظر گرفته

- استوار

- مشاوره

- محتوا

- کشور

- ایجاد شده

- ایجاد

- ایجاد

- بحرانی

- روز

- تعريف كردن

- میل

- تحولات

- جهت

- do

- دو

- سهولت

- اقتصادی

- رشد اقتصادی

- اقتصاد

- ed

- تلاش

- ایمیل

- تاکید

- تشویق

- حصول اطمینان از

- به طور کامل

- به خصوص

- ایجاد

- استقرار

- اخلاقی

- اروپایی

- اتحادیه اروپا

- تکامل یابد

- مثال

- حد

- تسهیل کننده

- FAST

- فیلتر

- شرکت ها

- نام خانوادگی

- تمرکز

- برای

- تشکیل

- به جلو

- پرورش دادن

- از جانب

- کامل

- آینده

- آینده هوش مصنوعی

- جهانی

- رفته

- کردم

- حکومت

- دولت

- بزرگ

- شدن

- در حال رشد

- رشد

- دستورالعمل ها

- سالن

- دست ها

- آیا

- he

- زیاد

- ریسک بالا

- خیلی

- دارای

- چگونه

- اما

- HTTPS

- انسان

- i

- شناسایی

- اهمیت

- in

- افزایش

- نشان می دهد

- شاخص

- لوازم

- صنعت

- اول

- ابتکار عمل

- نوآوری

- ابداع

- ادغام

- اطلاعات

- تشدید شد

- علاقه

- موضوع

- مسائل

- IT

- ITS

- خود

- پیوستن

- برچسب

- چشم انداز

- نام

- پارسال

- بعد

- پسندیدن

- احتمالا

- لاین

- کم

- ریسک کم

- ساخت

- دستکاری شده

- قدرت

- وزیر

- بیش

- حرکت

- بسیار

- ملت

- سازمان ملل

- طبیعت

- هدایت می کند

- پیمایش

- نیاز

- جدید

- نه

- هنجارها

- of

- on

- باز

- دیگر

- خارج

- روی

- بخش

- گذشته

- برنامه

- افلاطون

- هوش داده افلاطون

- PlatoData

- سیاست

- مطرح

- پتانسیل

- شیوه های

- آماده می کند

- پیشنهاد شده

- عمومی

- قرار دادن

- دلیل

- اخذ شده

- بازتاب

- بازتاب

- تنظیم کردن

- تنظیم

- مقررات

- مربوط

- آزاد

- پاسخ

- پاسخ

- محدود کردن

- خطر

- خطرات

- امن تر

- ایمنی

- علم

- جستجو می کند

- تنظیم

- مجموعه

- شکل

- دلالت می کند

- سوگواری

- چیزی

- اسپم

- سهامداران

- مراحل

- استراتژی ها

- ضربه

- چنین

- حاکی از

- اطراف

- برخورد با

- مصرف

- فن آوری

- فنی

- فن آوری

- پیشرفته

- شرکتهای فناوری

- نسبت به

- که

- La

- آینده

- آنجا.

- اینها

- فکر می کنم

- این

- در این سال

- کسانی که

- اگر چه؟

- به

- دنباله

- شفافیت

- درست

- اعتماد

- تلاش

- توییتر

- اتحادیه

- جذب

- با استفاده از

- داوطلبانه

- می خواهم

- میخواهم

- بود

- علامت گذاری به عنوان

- چی

- در حالیکه

- که

- در حین

- تمام

- اراده

- با

- بدون

- جهان

- سال

- شما

- زفیرنت