حمایت مالی در طول دو دهه گذشته، شرکت ها مدیریت مرکز داده را به یک هنر زیبا تبدیل کرده اند. استانداردسازی و اتوماسیون به معنای بهبود بهره وری، هم از نظر محاسبه خام و هم از نظر مصرف انرژی است. فنآوریهایی مانند مجازیسازی و کانتینریسازی به این معناست که کاربران و توسعهدهندگان میتوانند از منابع کارآمدتر استفاده کنند تا جایی که امکان استقرار سلفسرویس را فراهم کنند.

با این حال، معماریهای x86 با هدف کلی که به مراکز داده مدرن انرژی میدهند، برای اجرای بارهای کاری هوش مصنوعی مناسب نیستند. محققان هوش مصنوعی با استفاده مجدد از فناوری GPU برای سرعت بخشیدن به عملیات هوش مصنوعی این موضوع را برطرف کردند و این همان چیزی است که به نوآوری سرسام آور در یادگیری ماشین در دهه گذشته دامن زده است.

با این حال، این یک مشکل برای شرکت هایی است که می خواهند بارهای کاری هوش مصنوعی را اجرا کنند. به طور معمول، رویکرد میزبان و شتاب دهنده CPU به معنای خرید یک جعبه واحد است که پردازندههای گرافیکی و محاسبات میزبان مبتنی بر x86 را ادغام میکند. این می تواند زنگ خطر را برای تیم های زیرساخت سازمانی به صدا درآورد. اگرچه چنین سیستمهایی ممکن است از نظر تئوری پلاگین و بازی باشند، اما میتوانند فضای رک زیادی را اشغال کنند و ممکن است نیازهای برق و سرمایش متفاوتی را به محاسبات اصلی تحمیل کنند. آنها همچنین میتوانند انعطافناپذیر باشند، با ثابت بودن نسبت محاسبه به شتابدهنده GPU، که انعطافپذیری را هنگام انجام بارهای کاری متعدد با نیازهای محاسباتی میزبان متفاوت محدود میکند.

از آنجایی که محققان و دانشمندان داده با مدلها و مجموعههای داده بزرگتر کار میکنند - ما اکنون با خیال راحت در محدوده پارامترهای تریلیون به اضافه هستیم - همگامسازی با افزایش قدرت هوش مصنوعی به مسئله خرید یک سیستم جدید دیگر تبدیل میشود. سپس دیگری. و یکی دیگر. اما این امر برای رفع عدم تعادل بین محاسبه میزبان و شتاب هوش مصنوعی کمک چندانی نمی کند.

و بقیه دیتاسنتر بسیار تنظیم شده شما؟ خوب، وقتی همه ابرهای کاری هوش مصنوعی در یک سیلو قرار می گیرند، واقعاً نمی توانید از آن استفاده کنید. این امر باعث میشود که CIOهای با تجربه و مدیران زیرساخت بهطور قابلتوجهی نسبت به چشمانداز کیت بسیار تخصصی و متمرکز بر هوش مصنوعی که به سیلوهایی از منابع رها شده در مقابل چشمانشان تبدیل میشود، عصبی شوند.

جعبه گشایی هوش مصنوعی

بنابراین، در حالی که Ola Tørudbakken، سیستمهای SVP در Graphcore، میگوید هوش مصنوعی یا هوش ماشینی، ناگزیر به ستون چهارم مرکز داده در کنار محاسبات، شبکه و ذخیرهسازی (سنتی) تبدیل میشود، او همچنین میگوید که این نباید به شکل سیاه باشد. سیستم های جعبه ای

در عوض، سازنده سیستمهای هوش مصنوعی مستقر در بریتانیا استدلال میکند که قدرت شلیک AI باید از محاسبات میزبان جدا شود و به شکلی بستهبندی شود که نه تنها به راحتی در مراکز داده مدرن جا بیفتد، بلکه از مزایای کامل آن نیز استفاده کند.

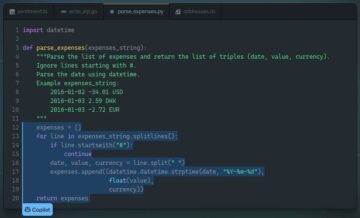

اینجا جایی است که خانواده سیستم های IPU-POD وارد می شود. IPU-POD خانواده ای از پیکربندی های سیستمی مبتنی بر IPU-M2000 است، یک تیغه 1U که 1 پتافلاپ محاسبات AI را ارائه می دهد. هر دستگاه شامل چهار واحد پردازش هوشمند GC200، Mk2 Colossus یا IPU است که هر کدام دارای 1472 هسته یا کاشی مستقل هستند که هر کدام می توانند شش رشته همزمان را اجرا کنند و 900 مگابایت حافظه درون پردازنده را روی یک سیلیکون به اشتراک می گذارند.

نقطه شروع برای CIO/CTO که به دنبال تجهیز دیتاسنتر خود به منابع محاسباتی هوش مصنوعی است که با نحوه عملکرد دیتاسنتر آنها مطابقت دارد، IPU-POD16 و IPU-POD64 است.

IPU-POD64 از شانزده IPU-M2000، داده ها و سوئیچ های مدیریتی و انتخابی از 1 یا 4 سرور میزبان که تفکیک شده اند تشکیل شده است. توان محاسباتی 16 petaFLOPS FP16.16 را ارائه می دهد و تقریباً 20 RU از فضای رک را اشغال می کند که بسته به تخصیص سرور در یک یا چند رک پخش می شود. IPU-POD16 یک محصول مقدماتی تر برای کسانی است که می خواهند کاوش کنند و سفر نوآوری خود را با این فناوری آغاز کنند. IPU-POD16 در دو رنگ عرضه می شود، اتصال مستقیم که یک سیستم plug-and-play از پیش پیکربندی شده است و جایگزینی که از سوئیچ ها استفاده می کند. هر دو نوع از یک سرور میزبان استفاده می کنند و 4 پتافلاپ FP16.16 عضله محاسباتی را ارائه می دهند.

Scaleout در هر IPU-M2000 با تراشه Gateway داخلی طراحی شده توسط Graphcore ساخته شده است. این دستگاه از ارتباطات 100 گیگابیت بر ثانیه در هر جهت به صورت جانبی با رک های IPU-POD مجاور پشتیبانی می کند. به عنوان بخشی از اتصال IPU-Fabric، این اتصالات می توانند مستقیم یا از طریق سوئیچ ها برای انعطاف پذیری بیشتر و کاهش خطاها باشند. مبنای مقیاسبندی، IPU Fabric Graphcore با پهنای باند کل 2.8 ترابیت بر ثانیه است. شانزده دستگاه M2000 در یک قفسه بزرگ شده و یک IPU-POD64 ایجاد می کند. برای ارتباط بین رک، IPU Fabric را می توان در یک توپولوژی سوئیچ 3 بعدی توروس پیکربندی کرد تا از هزاران IPU و حداکثر 1024 IPU-M2000 پشتیبانی کند و یک سیستم موازی عظیم ایجاد کند که 16 Exaflops محاسباتی را ارائه می دهد.

این رویکرد تفکیکشده به تمایل هم مقیاسکنندهها و هم شرکتها برای به حداقل رساندن تعداد SKUهای سروری که نیاز به پشتیبانی دارند، کمک میکند. Tørudbakken می گوید، سیستم های Graphcore به طور موثر "به شبکه متصل هستند". مشتریان به سادگی نرم افزار Graphcore's Poplar را - که از چارچوب های یادگیری ماشین استاندارد صنعتی پشتیبانی می کند - روی سرورهای دلخواه خود نصب می کنند تا محاسبات میزبان را برای سیستم مبتنی بر IPU فراهم کنند. مهمتر از همه، ظرفیت سرور را می توان به صورت تدریجی، با توجه به حجم کاری هوش مصنوعی مورد بحث، افزایش یا کاهش داد. بنابراین، در حالی که بارهای کاری نوع NLP معمولاً به نسبت کمتری از محاسبات میزبان و IO نیاز دارند، بارهای کاری بینایی رایانه معمولاً بارهای بیشتری را به میزبان تحمیل می کنند.

Tørudbakken می گوید، تفکیک از نظر انعطاف پذیری نیز مزایایی دارد. «اگر مشکل دارید – و سرورها، درست است – می توانید از پروتکل های failover استاندارد ارائه شده توسط یک پشته شبکه استفاده کنید. بنابراین، اگر یک سرور یا یک ماشین مجازی از کار بیفتد، می توانید آن را به سرور دیگر یا ماشین مجازی آماده به کار انتقال دهید.

IPU Fabric برای پشتیبانی از ارتباطات و مقیاس عظیم طراحی شده است. هنگامی که دانشمندان داده کد خود را با استفاده از Poplar جمعآوری میکنند، مدل آنها در سراسر سیستم IPU-POD بهعنوان یک منبع IPU به هم پیوسته نقشهبرداری میشود، اساساً انگار یک IPU غولپیکر است، تا هستههای جداگانه روی پردازندهها، و الگوی comms بهینه را برای پشتیبانی از مدل یادگیری ماشینی در دسترس است، چه در یک IPU یا مقیاس پذیری تا 1000 ثانیه. Graphcore میگوید که نتیجه، ارتباطات قطعی و بدون لرزش است، حتی زمانی که سیستم تا حد زیادی کوچک شده است.

اما طبق گفته Tørudbakken، کاربر "اصلاً به سخت افزار یا سیستم ها اهمیت نمی دهد - آنها اساساً یک پلت فرم بسیار مقیاس پذیر می خواهند که بتوانند کد خود را روی آن اجرا کنند."

در مورد سرعت اجرای کد، آخرین بنچمارک های Graphcore نشان می دهد که زمان آموزش در BERT-Large را می توان با استفاده از یک سیستم IPU-POD در مقایسه با یک سیستم مبتنی بر GPU DGX A100، با بیش از سه برابر توان عملیاتی بالاتر برای استنباط، بیش از نصف کرد. کمترین تاخیر در حجم کاری Markov Chain Monte Carlo، IPU-M2000 یک کار آموزشی را در کمتر از سه ساعت انجام داد، در مقایسه با 48 ساعت برای GPU A100.

با مدلهای مدرنتر، پیشرفتها بارزتر میشوند. IPU-M2000 افزایش ده برابری در توان عملیاتی آموزش در EfficientNet-B4 و 18 برابری با پیکربندی بهینه شده IPU ارائه کرد. بر اساس استنباط، IPU-M2000 در مقایسه با یک سیستم GPU، 60 برابر افزایش در توان و 16 برابر کاهش تأخیر ارائه کرد. این بدون شک دانشمندان داده را خشنود خواهد کرد، اما همکاران زیرساخت آنها ممکن است نگرانیهای بسیار جدیتری داشته باشند، که با سؤالاتی مانند "آیا سیستم بهطور بهینه کار میکند و آیا احتمال شکست آن وجود دارد؟" سیستم های IPU-POD به طور کامل توسط یک مجموعه نرم افزار مدیریت پشتیبانی می شوند که امکان مدیریت و مشاهده سیستم ها را فراهم می کند.

متشکل از ابزارهای سازمانی استاندارد و منبع باز مانند OpenBMC، RedFish DTMF، Prometheus و Grafana، آنها با APIهای مستند و باز برای یکپارچه سازی سیستم های مدیریت ارائه شده اند. یک هشدار در مورد آن در اوایل،” Tørudbakken می گوید. بنابراین، میتوانید یک کارمند پشتیبانی بفرستید تا آن را جایگزین کند یا اگر DIMM دارید که در شرف از بین رفتن است، همان چیزی است.

و تیمهای زیرساخت نیز بسیار نگران خواهند بود که از سرمایهگذاری خود در تجهیزات هوش مصنوعی خود بیشترین بهره را ببرند، به این معنی که تا آنجا که ممکن است از حجم کاری، شغل و تیم بیشتری پشتیبانی میکند.

هوش مصنوعی برای کسی؟

همانطور که Tørudbakken می گوید، اگرچه معماری IPU-POD را می توان به ده ها هزار IPU بزرگ کرد، اما یک بوم وسوسه انگیز برای دانشمندان داده ایجاد می کند تا مدل های خود را بر روی آن اجرا کنند، واقعیت این است که موارد کمی وجود دارد که یک کاربر تنها همه چیز را در اختیار بگیرد. ظرفیت محاسباتی هوش مصنوعی: "به طور معمول شما چندین کاربر خواهید داشت و چندین مستاجر خواهید داشت که فقط از سیستم استفاده می کنند." این بدان معناست که مدیریت منابع قوی مورد نیاز است. پشته نرم افزار Graphcore اجازه می دهد تا "IPU های مجازی" را ایجاد کنیم و "این به ما امکان می دهد اساساً غلاف را به چند غلاف مجازی که کاملاً ایزوله هستند تقسیم کنیم. یک IPU یا سیستم در یک پاد مجازی نمی تواند با هیچ IPU دیگری در یک پاد مجاور صحبت کند.

این با پشتیبانی از ابزارهای استاندارد سازماندهی صنعتی مانند SLURM و Kubernetes همراه است، به طوری که ماشینهای مجازی یا کانتینرهای در حال اجرا بر روی هاست میتوانند با VPOD در سیستم IPU مرتبط شوند. همانطور که Tørudbakken می گوید، چه در سطح فرامقیاس صحبت کنیم و چه در یک رک، در حالی که دانشمند داده روی داشتن حداکثر قدرت ممکن برای اجرای یک مدل متمرکز است، مدیر یا شرکت آنها اطمینان می خواهد که «این منبع مال من است و فقط مال من است. "

این به این انتظار میرود که بسیاری از سازمانها ممکن است اولین تجربه خود را از IPU از طریق hyperscaler یا خدمات ابر فلزی بدون پوشش Graphcore، Graphcloud، که در ژانویه راهاندازی شد، داشته باشند. با این حال، Tørudbakken انتظار دارد که بسیاری در نهایت بخواهند هوش ماشینی را به صورت اولیه ارائه کنند، دقیقاً به دلایل حفظ حریم خصوصی، محرمانه بودن و تأخیر. در انجام این کار، آنها از طریق برخی معادلات بسیار سنتی در مورد هزینه کل مالکیت کار کرده اند. او میگوید یکی از سؤالات اوپکس این است که «برای اجرای، مثلاً، یک شغل BERT واقعاً چقدر انرژی مصرف میکنید؟ برای یک سال؟ وقتی هم به سطح جعبه و هم در سطح سیستم نگاه کنید، راه حل بسیار جذاب است.»

از نقطه نظر capex، معادله حتی ساده تر است. تنها مؤلفه جدیدی که آنها واقعاً باید به آن اضافه کنند، سیستم IPU-POD مبتنی بر IPU-M2000 است. بقیه - شبکه و فضای ذخیره سازی - چیزی است که بسیاری از مردم قبلاً دارند.

و این مسلماً در هنگام وارد کردن هوش ماشینی به دیتاسنتر خود تا حدی که میتوانید خللکننده نباشید.

توسط Graphcore حمایت می شود