Pilt autorilt

Selles postituses uurime uut nüüdisaegset avatud lähtekoodiga mudelit nimega Mixtral 8x7b. Samuti õpime, kuidas sellele juurde pääseda LLaMA C++ teegi abil ja kuidas käivitada suuri keelemudeleid vähendatud andmetöötluse ja mäluga.

Mixtral 8x7b on Mistral AI poolt loodud kõrgekvaliteediline avatud raskustega ekspertsegude (SMoE) mudel. See on litsentsitud Apache 2.0 alusel ja ületab enamiku võrdlusaluste puhul Llama 2 70B, tehes samas kuus korda kiirema järelduse. Mixtral sobib või ületab GPT6 enamiku standardsete võrdlusnäitajate puhul ja on kulude ja jõudluse osas parim avatud kaaluga mudel.

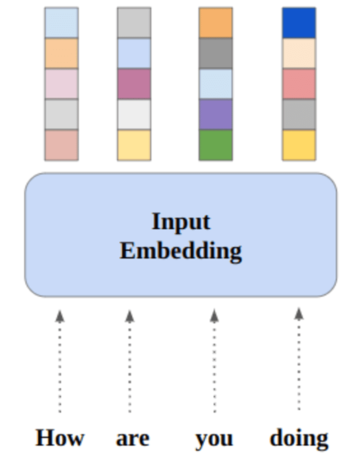

Pilt Ekspertide segu

Mixtral 8x7B kasutab ainult dekoodri hõredat ekspertide seguvõrku. See hõlmab edasisuunamisplokki, mis valib 8 parameetrirühma hulgast, kusjuures ruuterivõrk valib iga märgi jaoks kaks neist rühmadest, kombineerides nende väljundeid aditiivselt. See meetod suurendab mudeli parameetrite arvu, haldades samal ajal kulusid ja latentsust, muutes selle sama tõhusaks kui 12.9 B mudel, hoolimata sellest, et sellel on 46.7 B koguparameetreid.

Mixtral 8x7B mudel paistab silma 32 XNUMX žetoonide laia konteksti haldamisel ja toetab mitut keelt, sealhulgas inglise, prantsuse, itaalia, saksa ja hispaania keelt. See demonstreerib tugevat jõudlust koodi genereerimisel ja seda saab peenhäälestada juhiseid järgivaks mudeliks, saavutades kõrgeid tulemusi sellistel võrdlusalustel nagu MT-Bench.

LLaMA.cpp on C/C++ teek, mis pakub suure jõudlusega liidest suurte keelemudelite (LLM) jaoks, mis põhinevad Facebooki LLM-i arhitektuuril. See on kerge ja tõhus raamatukogu, mida saab kasutada mitmesuguste ülesannete jaoks, sealhulgas teksti genereerimiseks, tõlkimiseks ja küsimustele vastamiseks. LLaMA.cpp toetab laia valikut LLM-e, sealhulgas LLaMA, LLaMA 2, Falcon, Alpaca, Mistral 7B, Mixtral 8x7B ja GPT4ALL. See ühildub kõigi operatsioonisüsteemidega ja võib töötada nii protsessoritel kui ka GPU-del.

Selles jaotises käitame Colabis veebirakendust llama.cpp. Kirjutades mõne koodirea, saate kogeda uue tipptasemel mudeli jõudlust oma arvutis või Google Colabis.

Alustamine

Esiteks laadime alloleva käsurea abil alla GitHubi hoidla llama.cpp:

!git clone --depth 1 https://github.com/ggerganov/llama.cpp.gitPärast seda muudame kataloogi hoidlasse ja installime llama.cpp, kasutades käsku "make". Installime faili llama.cpp NVidia GPU-le, kus on installitud CUDA.

%cd llama.cpp

!make LLAMA_CUBLAS=1Laadige mudel alla

Mudeli saame alla laadida Hugging Face Hubist, valides .gguf mudelifaili sobiva versiooni. Lisateavet erinevate versioonide kohta leiate aadressilt TheBloke/Mixtral-8x7B-Instruct-v0.1-GGUF.

Pilt TheBloke/Mixtral-8x7B-Instruct-v0.1-GGUF

Mudeli praegusesse kataloogi allalaadimiseks saate kasutada käsku "wget".

!wget https://huggingface.co/TheBloke/Mixtral-8x7B-Instruct-v0.1-GGUF/resolve/main/mixtral-8x7b-instruct-v0.1.Q2_K.ggufLLaMA serveri välisaadress

Kui käitame LLaMA serverit, annab see meile kohaliku hosti IP-aadressi, mis on meie jaoks Colabis kasutu. Vajame ühendust kohaliku hosti puhverserveriga, kasutades Colabi tuuma puhverserveri porti.

Pärast alloleva koodi käivitamist saate globaalse hüperlingi. Kasutame seda linki oma veebirakendusele hiljem juurdepääsuks.

from google.colab.output import eval_js

print(eval_js("google.colab.kernel.proxyPort(6589)"))

https://8fx1nbkv1c8-496ff2e9c6d22116-6589-colab.googleusercontent.com/Serveri käitamine

LLaMA C++ serveri käitamiseks peate andma serverikäsule mudelifaili asukoha ja õige pordi numbri. Oluline on veenduda, et pordi number ühtiks puhverserveri pordi eelmises etapis algatatud numbriga.

%cd /content/llama.cpp

!./server -m mixtral-8x7b-instruct-v0.1.Q2_K.gguf -ngl 27 -c 2048 --port 6589

Vestluse veebirakendusele pääseb juurde, klõpsates eelmises etapis puhverserveri pordi hüperlingil, kuna server ei tööta kohapeal.

LLaMA C++ veebirakendus

Enne kui hakkame vestlusrobotit kasutama, peame seda kohandama. Asendage “LLaMA” oma mudeli nimega viipade jaotises. Lisaks muutke loodud vastuste eristamiseks kasutajanime ja roboti nime.

Alustage vestlust, kerides alla ja tippides vestluse jaotisesse. Küsige julgelt tehnilisi küsimusi, millele teised avatud lähtekoodiga mudelid pole korralikult vastanud.

Kui teil tekib rakendusega probleeme, võite proovida seda oma Google Colabi abil ise käivitada: https://colab.research.google.com/drive/1gQ1lpSH-BhbKN-DdBmq5r8-8Rw8q1p9r?usp=sharing

See õpetus sisaldab põhjalikku juhendit selle kohta, kuidas käitada täiustatud avatud lähtekoodiga mudelit Mixtral 8x7b teenuses Google Colab, kasutades LLaMA C++ teeki. Võrreldes teiste mudelitega pakub Mixtral 8x7b suurepärast jõudlust ja tõhusust, muutes selle suurepäraseks lahenduseks neile, kes soovivad katsetada suurte keelemudelitega, kuid kellel ei ole ulatuslikke arvutusressursse. Saate seda hõlpsalt käitada sülearvutis või tasuta pilvandmetöötluses. See on kasutajasõbralik ja saate isegi oma vestlusrakenduse teistele kasutamiseks ja katsetamiseks juurutada.

Loodan, et see lihtne lahendus suure mudeli käitamiseks oli teile kasulik. Otsin alati lihtsaid ja paremaid võimalusi. Kui teil on veelgi parem lahendus, andke mulle sellest teada ja ma räägin sellest järgmisel korral.

Abid Ali Awan (@1abidaliawan) on sertifitseeritud andmeteadlase professionaal, kes armastab masinõppemudelite loomist. Praegu keskendub ta sisu loomisele ning tehniliste ajaveebide kirjutamisele masinõppe ja andmeteaduse tehnoloogiate kohta. Abid on omandanud magistrikraadi tehnoloogiajuhtimises ja bakalaureusekraadi telekommunikatsioonitehnikas. Tema visioon on luua graafilise närvivõrgu abil tehisintellekti toode vaimuhaigustega võitlevatele õpilastele.

- SEO-põhise sisu ja PR-levi. Võimenduge juba täna.

- PlatoData.Network Vertikaalne generatiivne Ai. Jõustage ennast. Juurdepääs siia.

- PlatoAiStream. Web3 luure. Täiustatud teadmised. Juurdepääs siia.

- PlatoESG. Süsinik, CleanTech, Energia, Keskkond päikeseenergia, Jäätmekäitluse. Juurdepääs siia.

- PlatoTervis. Biotehnoloogia ja kliiniliste uuringute luureandmed. Juurdepääs siia.

- Allikas: https://www.kdnuggets.com/running-mixtral-8x7b-on-google-colab-for-free?utm_source=rss&utm_medium=rss&utm_campaign=running-mixtral-8x7b-on-google-colab-for-free

- :on

- :mitte

- 1

- 12

- 27

- 46

- 7

- 8

- a

- Võimalik

- juurdepääs

- pääses

- saavutamisel

- Lisaks

- aadress

- edasijõudnud

- AI

- Materjal: BPA ja flataatide vaba plastik

- Ka

- alati

- am

- an

- ja

- vastus

- Apache

- app

- taotlus

- asjakohane

- arhitektuur

- OLEME

- AS

- küsima

- põhineb

- BE

- alustama

- alla

- kriteeriumid

- BEST

- Parem

- vahel

- Blokeerima

- blogid

- Bot

- mõlemad

- ehitama

- Ehitus

- kuid

- by

- C + +

- kutsutud

- CAN

- atesteeritud

- muutma

- vestlus

- chatbot

- jututoas

- valimine

- Cloud

- kood

- kombineerimine

- võrreldes

- kokkusobiv

- terviklik

- arvutuslik

- Arvutama

- arvutustehnika

- ühendus

- sisu

- sisu loomine

- kontekst

- parandada

- Maksma

- cover

- loodud

- loomine

- Praegune

- Praegu

- kohandada

- andmed

- andmeteadus

- andmeteadlane

- Kraad

- annab

- näitab

- juurutada

- Vaatamata

- eristama

- do

- alla

- lae alla

- iga

- kergesti

- efektiivsus

- tõhus

- kohtumine

- Inseneriteadus

- Inglise

- Parandab

- Isegi

- suurepärane

- kogemus

- eksperiment

- ekspertide

- uurima

- ulatuslik

- nägu

- Ebaõnnestunud

- pistrik

- kiiremini

- tundma

- vähe

- fail

- keskendumine

- eest

- avastatud

- tasuta

- prantsuse

- Alates

- funktsioon

- loodud

- põlvkond

- saksa

- saama

- GitHub

- Andma

- Globaalne

- GPU

- GPU

- graafik

- Graafiline närvivõrk

- Grupi omad

- suunata

- Käsitsemine

- Olema

- võttes

- he

- kasulik

- Suur

- suur jõudlus

- kvaliteetne

- tema

- omab

- lootus

- Kuidas

- Kuidas

- HTTPS

- Keskus

- i

- if

- haigus

- import

- oluline

- in

- Kaasa arvatud

- info

- algatatud

- paigaldama

- paigaldamine

- Interface

- sisse

- hõlmab

- IP

- küsimustes

- IT

- itaalia

- KDnuggets

- Teadma

- keel

- Keeled

- sülearvuti

- suur

- Hilinemine

- pärast

- Õppida

- õppimine

- laskma

- Raamatukogu

- Litsentseeritud

- kerge

- nagu

- joon

- liinid

- LINK

- Laama

- kohapeal

- liising

- otsin

- armastab

- masin

- masinõpe

- tegema

- Tegemine

- juhtimine

- juhtiv

- meister

- tikud

- me

- Mälu

- vaimne

- Vaimuhaigus

- meetod

- segu

- mudel

- mudelid

- muutma

- rohkem

- kõige

- mitmekordne

- my

- nimi

- Vajadus

- võrk

- Neural

- Närvivõrgus

- Uus

- järgmine

- number

- Nvidia

- of

- on

- ONE

- avatud

- avatud lähtekoodiga

- tegutsevad

- operatsioonisüsteemid

- Valikud

- or

- Muu

- teised

- meie

- Ületab tulemusi

- väljund

- väljundid

- enda

- parameeter

- parameetrid

- PC

- jõudlus

- Platon

- Platoni andmete intelligentsus

- PlatoData

- palun

- post

- eelmine

- Toode

- professionaalne

- korralikult

- anda

- annab

- volikiri

- küsimus

- Küsimused

- valik

- Lühendatud

- kohta

- asendama

- Hoidla

- teadustöö

- Vahendid

- vastuste

- ruuter

- jooks

- jooksmine

- s

- teadus

- teadlane

- hinded

- kerimine

- Osa

- valides

- server

- lihtne

- alates

- lahendus

- allikas

- hispaania

- standard

- modernne

- Samm

- tugev

- Võitlemine

- Õpilased

- parem

- Toetab

- kindel

- süsteemid

- ülesanded

- Tehniline

- Tehnoloogiad

- Tehnoloogia

- elekterside

- tekst

- teksti genereerimine

- et

- .

- oma

- Need

- see

- need

- aeg

- et

- sümboolne

- märgid

- Summa

- Tõlge

- püüdma

- juhendaja

- kaks

- all

- us

- kasutama

- Kasutatud

- Kasutaja

- kasutajasõbralik

- kasutusalad

- kasutamine

- sort

- eri

- versioon

- nägemus

- tahan

- we

- web

- Veebirakendus

- mis

- kuigi

- WHO

- lai

- Lai valik

- will

- koos

- kirjutamine

- sa

- Sinu

- sephyrnet