Suresh on tehnoloogiajuht, kellel on sügavad tehnilised teadmised pooljuhtide, tehisintellekti, küberturvalisuse, asjade interneti, riistvara, tarkvara jne vallas. Ta veetis selles valdkonnas 20 aastat, viimati töötas ta avatud lähtekoodiga null- usaldada kiibi väljatöötamist Abu Dhabis Technology Innovation Institute'is ja teistes Fortune 500 pooljuhtettevõtetes, nagu Intel, Qualcomm ja MediaTek erinevates juhtivatel rollidel, kus ta uuris ja arendas suure jõudlusega, energiatõhusaid, kvantijärgseid turvalisi ja ohutuid lahendusi. mikrokiibid / süsteem-kiibid (SoC) / kiirendid andmekeskuse, kliendi, nutitelefoni, võrgunduse, asjade Interneti ja AI/ML turgude jaoks. Ta aitas kaasa Falcon LLM-ile (huggingface'i edetabel #1) ja oli kohandatud tehisintellekti riistvaraplatvormi juhtiv arhitekt (tühistatud – prioriteedid muudetud). Tal on 15+ USA patenti ning ta on avaldanud/esinenud enam kui 20+ konverentsil.

Suresh on tehnoloogiajuht, kellel on sügavad tehnilised teadmised pooljuhtide, tehisintellekti, küberturvalisuse, asjade interneti, riistvara, tarkvara jne vallas. Ta veetis selles valdkonnas 20 aastat, viimati töötas ta avatud lähtekoodiga null- usaldada kiibi väljatöötamist Abu Dhabis Technology Innovation Institute'is ja teistes Fortune 500 pooljuhtettevõtetes, nagu Intel, Qualcomm ja MediaTek erinevates juhtivatel rollidel, kus ta uuris ja arendas suure jõudlusega, energiatõhusaid, kvantijärgseid turvalisi ja ohutuid lahendusi. mikrokiibid / süsteem-kiibid (SoC) / kiirendid andmekeskuse, kliendi, nutitelefoni, võrgunduse, asjade Interneti ja AI/ML turgude jaoks. Ta aitas kaasa Falcon LLM-ile (huggingface'i edetabel #1) ja oli kohandatud tehisintellekti riistvaraplatvormi juhtiv arhitekt (tühistatud – prioriteedid muudetud). Tal on 15+ USA patenti ning ta on avaldanud/esinenud enam kui 20+ konverentsil.

Suresh töötab ka aktiivselt juhtival positsioonil RISC-V Internationalis, kus ta juhib Trusted Computing Groupi, et arendada RISC-V konfidentsiaalset andmetöötlusvõimet, ja juhib AI/ML Groupi, et arendada RISC-V riistvarakiirendust AI/ML töökoormuste jaoks, nagu näiteks Transformer Large Language mudelid, mida kasutatakse ChatGPT tüüpi rakendustes. Samuti nõustab ta idufirmasid ja riskikapitalifirmasid investeerimisotsuste toetamise, tootestrateegia, tehnoloogia hoolsusuuringu jms küsimustes.

Ta omandas MBA kraadi INSEADist, magistrikraadi Birla Tehnoloogia- ja Teadusinstituudist Pilani, Systems Engineeringi sertifikaadi MIT-st, tehisintellekti sertifikaadi Stanfordist ja autotööstuse funktsionaalse ohutuse sertifikaadi TÜV SÜD-ist.

Rääkige meile oma ettevõttest

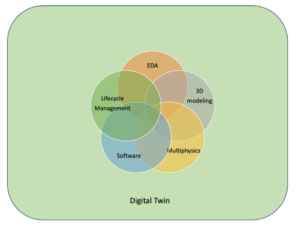

"Mastiṣka AI” (Mastiṣka tähendab sanskriti keeles aju) on tehisintellekti ettevõte, mis on keskendunud ajulaadsete arvutite ehitamisele, et käivitada tõhusamalt alusmudeleid tulevaste generatiivsete tehisintellekti kasutusjuhtude jaoks.

Milliseid probleeme te lahendate?

Arvestades tehisintellekti/GenAI eeliseid, suureneb selle nõudlus ja ka selle kõrvalmõjud meie planeedile. Kuidas saame vähendada või neutraliseerida tehisintellekti kõrvalmõjusid meie planeedil? Süsinikdioksiidi kogumine ja tuumaenergia on õiges suunas. Kuid me peame põhjalikult ümber mõtlema viisi, kuidas me tehisintellekti teeme, kas see on vale viis tonnide kaupa maatriksikorrutamiseks?

Meie aju saab õppida ja teha paljusid ülesandeid paralleelselt, 10 W ja alla selle, kuid miks tarbivad need AI-süsteemid mudelite koolitamiseks 10 megavatti?

Võib-olla ootab tulevik energiatõhusaid arhitektuure, nagu neuromorfsed arhitektuurid ja närvivõrgupõhised trafod, mis on inimajule kõige lähemal ja mis võivad tarbida 100–1000 korda vähem energiat, vähendades seega tehisintellekti kasutamise kulusid, muutes selle demokratiseerimiseks ja säästes meie planeet.

Praegused väljakutsed, millega tehisintellektiga silmitsi seisame, nimelt a) kättesaadavus, b) juurdepääsetavus, c) taskukohasus ja d) keskkonnaohutus ning mõned soovitused nende lahendamiseks.

Kui me näeme tulevikku ette, siis mõnda kasulikku AGI kontseptsiooni demonstreeritakse filmis “HER”, kus tegelane Samantha – vestlusagent, kes on loomulik, mõistab emotsioone, näitab üles empaatiat, on suurepärane kaaspiloot tööl – ja jookseb edasi. pihuseadmeid terve päeva, siis peame võib-olla juba praegu tegelema alltoodud väljakutsetega.

Probleem 1: LLM-i koolitamine võib maksta 150 10 kuni 10+ miljonit dollarit ja see võimaldab AI-d arendada ainult neil, kellel on sügavamad taskud. Lisaks on järelduste tegemise kulud suured (maksab XNUMX korda rohkem kui veebiotsing)

—> Peame parandama mudelite/riistvara energiatõhusust, et AI demokratiseerida inimkonna hüvanguks.

2. probleem: vestlusagentide või soovitussüsteemide tohutute AI-mudelite käitamine kahjustab keskkonda elektritarbimise ja jahutuse osas.

—> Peame parandama mudelite/riistvara energiatõhusust, et päästa meie planeet meie laste eest.

Probleem 3: Inimese aju on võimeline ja suudab mitut toimingut teha, kuid tarbib megavattide asemel vaid 10 vatti.

—> Võib-olla peaksime ehitama selliseid masinaid nagu meie aju, mitte tavalisi maatriksikordajaid kiiremini.

Inimkond saab areneda ainult jätkusuutlike uuendustega, mitte aga innovatsiooni nimel kõiki metsi maha raiudes ja ookeane keetes. Peame kaitsma oma planeeti meie laste ja tulevaste põlvkondade heaolu nimel…

Millised rakendusvaldkonnad on teie tugevamad?

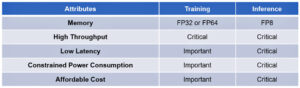

Trafol (ja tulevasel närviarhitektuuril) põhinevate vundamendimudelite väljaõpe ja järelduste tegemine 50–100 korda energiasäästlikumalt võrreldes tänapäevaste GPU-põhiste lahendustega.

Mis hoiab teie kliente öösel üleval?

Probleemid klientidele, kes kasutavad praegu teisi tooteid:

Huunglike keelemudelite koolitamiseks kulub elektrit üle jõu, näiteks 13B parameetriga LLM-i treenimine 390B tekstimärgistel 200 GPU-l 7 päeva jooksul maksab 151,744 XNUMX dollarit (Allikas: HuggingFace uue koolitusklastri teenuse leht – https://lnkd.in/g6Vc5cz3). Ja isegi suuremad mudelid 100+B parameetriga maksavad 10+M $ ainult treenimiseks. Seejärel makske järelduste tegemise eest iga kord, kui saabub uus viippäring.

Veekulu jahutamiseks, hindasid California ülikooli Riverside'i teadlased ChatGPT-laadse teenuse keskkonnamõju ja väidavad, et see ahmib iga kord, kui seda küsite, 500 milliliitrit vett (ligikaudu 16-untsises veepudelis). 5–50 viipast või küsimusest koosnev seeria. Vahemik varieerub sõltuvalt serverite asukohast ja hooajast. Hinnangus on kaudne veekasutus, mida ettevõtted ei mõõda – näiteks andmekeskusi elektriga varustavate elektrijaamade jahutamiseks. (Allikas: https://lnkd.in/gybcxX8C)

Probleemid praeguste toodete mitteklientidele:

Ei saa endale lubada CAPEX-i riistvara ostmiseks

Ei saa endale lubada pilveteenuste kasutamist

Ei saa teha uuendusi ega kasutada tehisintellekti – on kinni teenuste mudelist, mis välistab igasuguse konkurentsieelise

Kuidas konkurentsimaastik välja näeb ja kuidas eristute?

- GPU-d domineerivad treeningruumis, kuigi selles segmendis konkureerivad ka spetsiaalsed ASIC-id

- Cloud & Edge järeldusel on liiga palju valikuid

Digitaalne, analoog, fotooniline – ütlete, et inimesed üritavad sama probleemiga toime tulla.

Kas saate jagada oma mõtteid AI/ML-i kiibiarhitektuuri hetkeseisust, mis tähendab, millised on teie arvates praegu kõige olulisemad suundumused ja võimalused?

Järgmised suundumused:

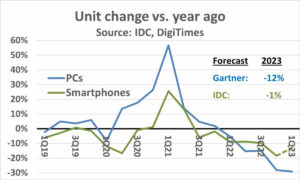

1. trend: 10 aastat tagasi õitses riistvarapõhine süvaõpe ja nüüd pärsib sama riistvara edasiminekut. Mudelite käitamise suurte riistvara- ja elektrikulude tõttu on riistvarale juurdepääsemine muutunud väljakutseks. Ainult sügavate taskutega ettevõtted saavad seda endale lubada ja on muutumas monopolideks.

2. trend: Nüüd, kui need mudelid on olemas, peame neid kasutama praktilistel eesmärkidel, et järeldamiskoormus suureneks, võimaldades tehisintellekti kiirenditega protsessoritel taas rambivalgusesse tõusta.

3. trend: Idufirmad üritavad välja pakkuda alternatiivseid ujukomaarvude esitusi, et traditsiooniline IEEE-vorming – näiteks logaritmiline ja positsioonipõhine – on küll hea, kuid mitte piisav. PPA$ disainiruumi optimeerimine läheb plahvatuslikuks, kui proovime üht optimeerida ja teine läheb viskama.

4. trend: Tööstus on eemaldumas AI teenusepõhisest mudelist, et majutada oma privaatseid mudeleid oma ruumides, kuid juurdepääs riistvarale on väljakutse tarnepuuduse, sanktsioonide jms tõttu.

Asjade hetkeseis:

Riistvara ja andmete kättesaadavus soodustas AI kasvu 10 aastat tagasi, nüüd pärsib seda sama riistvara - lubage mul selgitada

Sellest ajast peale, kui protsessoritel läks viletsalt ja GPU-d hakati tehisintellekti tegema, juhtus palju asju

Ettevõtted on tegelenud nelja AI/ML segmendiga, nimelt – 4) pilvekoolitus, 1) pilvepõhised järeldused, 2) äärejäreldamine ja 3) servakoolitus (liitõpe privaatsustundlike rakenduste jaoks).

Digitaalne ja analoog

Koolituslik pool – suur hulk ettevõtteid, kes tegelevad GPU-dega, RISC-V-l põhinevate klientide kiirenditega, vahvliskaala kiipidega (850 XNUMX südamikku) ja nii edasi, kus traditsioonilistel protsessoritel puudub (nende üldeesmärk). Järelduskülg – NN kiirendid on saadaval igalt tootjalt, nutitelefonides, sülearvutites ja muudes servaseadmetes.

Analoogmälupõhised arhitektuurid ilmusid ka mõni aeg tagasi.

Usume, et protsessorid võivad olla väga head järelduste tegemisel, kui täiustame seda kiirendusega, näiteks maatriksilaienditega

Asja RISC-V pool:

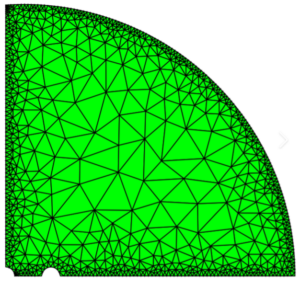

Asjade RISC-V poolelt arendame maatriksoperatsioonide ja muude mittelineaarsete operatsioonide kiirendeid, et kõrvaldada trafo töökoormuse võimalikud kitsaskohad. Von Neumanni kitsaskohtadega tegeletakse ka andmetöötlusele lähemal asuvate mälude kujundamisega, muutes lõpuks tehisintellekti kiirendusega protsessorid järelduste tegemiseks õigeks valikuks.

Võimalused:

Vundamendimudelite turu täitmiseks on ainulaadsed võimalused. Näide – OpenAI on maininud, et nad ei suutnud tagada piisavalt AI-arvutusi (GPU-sid), et jätkata oma ChatGPT-teenuste pakkumist… iga päringu jaoks. Siin on täita turg – see ei ole nišš, vaid kogu turg, mis demokratiseerib tehisintellekti, lahendades kõik ülalmainitud väljakutsed – a) kättesaadavus, b) juurdepääsetavus, c) taskukohasus ja d) keskkonnaohutus.

Milliste uute funktsioonide/tehnoloogiaga te töötate?

Ehitame aju nagu arvuti, kasutades neuromodrfilisi tehnikaid ja kohandades mudeleid, et kasutada ära energiatõhusat riistvara, kasutades taaskasutades olemasolevaid avatud raamistikke

Millisena kujutate ette AI/ML sektori kasvu või muutumist järgmise 12–18 kuu jooksul?

Kuna nõudlus GPU-de järele on hapuks läinud (maksab umbes 30 XNUMX dollarit) ning mõnel pool maailmas ähvardatakse nende GPU-de ostmise eest sanktsioone, tunnevad mõned maailma osad, et tehisintellekti uurimis- ja arendustegevus on külmunud, ilma GPU-dele juurdepääsuta. Turgu vallutavad alternatiivsed riistvaraplatvormid.

Võib-olla hakkavad mudelid kahanema – kohandatud mudelid või isegi põhimõtteliselt teabetihedus kasvaks

Sama küsimus, aga kuidas on lood järgmise 3-5 aasta kasvu ja muutustega?

a) AI-laiendustega protsessorid haaraksid tehisintellekti järelduste turu

b) Mudelid muutuvad kobedaks ja parameetrid langevad välja, kui infotihedus paraneb 16%-lt 90%-le

c) Energiatõhusus paraneb, CO2 jalajälg väheneb

d) Tekivad uued arhitektuurid

e) riistvara- ja energiakulud vähenevad, nii et mudelite loomise ja koolitamise barjäär väiksematele ettevõtetele muutub taskukohaseks

f) inimesed räägivad AGI-eelsest hetkest, kuid minu etaloniks oleks tegelaskuju Samantha (vestlusvõimeline tehisintellekt) filmis "tema". See võib olla ebatõenäoline, arvestades suurendamise kõrgeid kulusid.

Millised on mõned väljakutsed, mis võivad AI/ML sektori kasvu mõjutada või piirata?

a) Juurdepääs riistvarale

b) Energiakulud ja jahutuskulud ning keskkonnakahjud

Samuti loe:

Intervjuu tegevjuhiga: David Moore ettevõttest Pragmatic

Intervjuu tegevjuhiga: Sandbox Semiconductori dr Meghali Chopra

- SEO-põhise sisu ja PR-levi. Võimenduge juba täna.

- PlatoData.Network Vertikaalne generatiivne Ai. Jõustage ennast. Juurdepääs siia.

- PlatoAiStream. Web3 luure. Täiustatud teadmised. Juurdepääs siia.

- PlatoESG. Süsinik, CleanTech, Energia, Keskkond päikeseenergia, Jäätmekäitluse. Juurdepääs siia.

- PlatoTervis. Biotehnoloogia ja kliiniliste uuringute luureandmed. Juurdepääs siia.

- Allikas: https://semiwiki.com/ceo-interviews/338703-ceo-interview-suresh-sugumar-of-mastiska-ai/

- :on

- :on

- :mitte

- : kus

- $ UP

- 1

- 10

- 150

- 20

- 20 aastat

- 200

- 50

- 500

- 7

- a

- Võimalik

- MEIST

- üle

- Abu Dhabi

- kiirendus

- kiirendid

- juurdepääs

- kättesaadavus

- aktiivselt

- aadress

- adresseeritud

- adresseerimine

- ADEelis

- Asjad

- jälle

- Agent

- ained

- AGI

- tagasi

- AI

- AI mudelid

- ai uuringud

- Tehisintellekti süsteemid

- ai kasutusjuhtumeid

- AI / ML

- joondatud

- Materjal: BPA ja flataatide vaba plastik

- Lubades

- võimaldab

- mööda

- Ka

- alternatiiv

- hämmastav

- an

- ja

- Teine

- mistahes

- kuskil

- taotlus

- rakendused

- arhitektuur

- OLEME

- valdkondades

- Saabuvad

- kunstlik

- tehisintellekti

- AS

- Asics

- küsima

- At

- auto

- kättesaadavus

- saadaval

- ära

- b

- tõke

- põhineb

- BE

- muutuma

- muutub

- saada

- olnud

- on

- Uskuma

- alla

- võrrelda

- kasu

- Kasu

- vahel

- Peale

- kitsaskohti

- seotud

- Aju

- aju

- ehitama

- Ehitus

- kuid

- ostma

- by

- California

- CAN

- tühistatud

- võime

- võimeline

- kapital

- lüüa

- süsinik

- süsinikdioksiidi kogumise

- juhtudel

- Centers

- tegevjuht

- Tegevjuhi intervjuu

- sertifikaat

- väljakutse

- väljakutseid

- muutma

- muutunud

- muutuv

- iseloom

- ChatGPT

- Lapsed

- kiip

- laastud

- valik

- Chopra

- klient

- lähedal

- lähemale

- Cloud

- Cluster

- co2

- Tulema

- Ettevõtted

- ettevõte

- võrreldes

- võistlema

- konkurentsivõimeline

- Arvutama

- arvuti

- arvutid

- arvutustehnika

- mõisted

- konverentsid

- tarbima

- tarbimine

- jätkama

- Aitas

- jutukas

- jutukas AI

- jahe

- Maksma

- kulud

- võiks

- looma

- Praegune

- Praegune olek

- Praegu

- tava

- klient

- Kliendid

- lõikamine

- Küberturvalisus

- andmed

- andmekeskuste

- Datacenter

- David

- päev

- Päeva

- otsus

- sügav

- sügav õpe

- sügavam

- Nõudlus

- demokratiseerima

- Demokraatlik

- Näidatud

- Tihedus

- Olenevalt

- Disain

- arendama

- arenenud

- arenev

- & Tarkvaraarendus

- seadmed

- Dhabi

- eristada

- hoolsus

- suund

- Juhataja

- do

- ei

- teeme

- dollarit

- Ära

- alla

- dr

- Drop

- kaks

- teenitud

- serv

- mõju

- efektiivsus

- tõhus

- tõhusalt

- elekter

- elektritarbimine

- kõrvaldama

- kõrvaldab

- emotsioone

- Empaatia

- energia

- energiatõhusus

- Inseneriteadus

- suurendama

- piisavalt

- Kogu

- kanne

- keskkond

- keskkonna-

- kujutlusvõime

- hinnata

- Hinnanguliselt

- jms

- Eeter (ETH)

- Isegi

- lõpuks

- Iga

- näide

- täidesaatev

- Tegevdirektor

- eksisteerima

- teadmised

- Plahvatab

- laiendused

- nägu

- ees

- pistrik

- kiiremini

- tunne

- täitma

- ettevõtetele

- ujuv

- keskendunud

- jalg

- eest

- ette näha

- formaat

- heaolu

- Sihtasutus

- raamistikud

- Alates

- külmutatud

- Küttega

- funktsionaalne

- põhimõtteliselt

- tulevik

- Üldine

- Põlvkonnad

- generatiivne

- Generatiivne AI

- antud

- Go

- Goes

- läheb

- hea

- GPU

- Grupp

- Kasvavad

- Kasv

- riistvara

- Olema

- he

- sellest tulenevalt

- siin

- Suur

- omab

- Hosting

- Kuidas

- HTTPS

- tohutu

- Kallistav Nägu

- inim-

- Inimkond

- IEEE

- if

- pilt

- mõju

- parandama

- parandab

- in

- Teistes

- hõlmab

- Suurendama

- tööstus

- info

- uuendama

- Innovatsioon

- uuendusi

- selle asemel

- Instituut

- Intel

- Intelligentsus

- rahvusvaheliselt

- Internet

- Intervjuu

- investeering

- asjade Interneti

- IT

- ITS

- lihtsalt

- lapsed

- Laps

- puudus

- maastik

- keel

- sülearvutid

- suur

- suurem

- viima

- Juhtimine

- Õppida

- õppimine

- laskma

- Finantsvõimendus

- võimendav

- nagu

- rambivalgustus

- LIMIT

- koormus

- asub

- Vaata

- näeb välja

- vähendada

- masinad

- Tegemine

- Tootja

- palju

- Turg

- turud

- maatriks

- max laiuse

- mai..

- võib olla

- MBA

- me

- tähendus

- vahendid

- mõõtma

- Mälestused

- mainitud

- võib

- miljon

- miljonit dollarit

- MIT

- mudel

- mudelid

- hetk

- monopolid

- kuu

- rohkem

- kõige

- film

- liikuv

- MS

- peab

- my

- nimi

- nimelt

- Natural

- Vajadus

- võrgupõhine

- võrgustike loomine

- Neural

- Uus

- uudised

- järgmine

- nišš

- öö

- krapsakas

- nüüd

- tuuma-

- Tuumaenergia

- number

- ookeanide

- of

- on

- ONE

- ainult

- avatud

- avatud lähtekoodiga

- OpenAI

- Operations

- Võimalused

- optimeerimine

- optimeerima

- Valikud

- or

- Muu

- meie

- välja

- enda

- lehekülg

- Parallel

- parameeter

- parameetrid

- osad

- Patendi

- Maksma

- Inimesed

- ehk

- planeet

- taimed

- inimesele

- Platvormid

- Platon

- Platoni andmete intelligentsus

- PlatoData

- arvukus

- pluss

- taskud

- Punkt

- positsioon

- võimalik

- võim

- Elektrijaamad

- Praktiline

- trükk

- era-

- Probleem

- probleeme

- Toode

- Toodet

- profiil

- Edu

- küsib

- kaitsma

- eesmärk

- eesmärkidel

- Lükkama

- Paneb

- qualcomm

- küsimus

- Küsimused

- valik

- reastatud

- Lugenud

- hiljuti

- Soovitus

- soovitused

- vähendama

- vähendamine

- regulaarne

- Aruanded

- taotleda

- teadustöö

- teadus-ja arendustegevus

- Teadlased

- õige

- Jõeäär

- rollid

- katus

- jooks

- jooksmine

- jookseb

- ohutu

- ohutus

- sama

- Sanktsioonid

- liivakast

- Säästa

- säästmine

- ütlema

- ketendamine

- teadus

- Otsing

- hooaeg

- sektor

- kindlustama

- vaata

- segmendid

- pooljuht

- Pooljuhid

- Seeria

- serverid

- teenus

- Teenused

- teenindavad

- Jaga

- puudus

- peaks

- näitas

- Näitused

- külg

- märkimisväärne

- alates

- väiksem

- nutikas telefon

- nutitelefonid

- So

- tarkvara

- Lahendused

- Lahendamine

- mõned

- allikas

- Ruum

- spetsialiseeritud

- kasutatud

- Stanford

- algus

- Alustavatel

- riik

- Strateegia

- tugevaim

- selline

- varustama

- toetama

- jätkusuutlik

- süsteemid

- lahendada

- tegelemine

- kohandamine

- Võtma

- rääkima

- ülesanded

- Tehniline

- Tehnoloogia

- tehnoloogiauuendus

- tingimused

- tekst

- kui

- et

- .

- Tulevik

- teave

- maailm

- oma

- Neile

- SIIS

- Seal.

- sellega

- Need

- nad

- asjad

- see

- need

- kuigi?

- Elab

- aeg

- et

- tänane

- märgid

- homme

- liiga

- ülemine

- viskama

- traditsiooniline

- Rong

- koolitus

- trafo

- trafod

- Trends

- Usaldatud

- püüdma

- üritab

- all

- mõistab

- Ülikool

- California Ülikool

- Ebatõenäoline

- us

- Kasutus

- kasutama

- Kasutatud

- kasutamine

- eri

- ettevõtmine

- riskikapitali

- riskikapitali ettevõtted

- väga

- kohta

- oli

- Vesi

- Tee..

- we

- web

- Heaolu

- olid

- M

- millal

- mis

- WHO

- miks

- will

- koos

- ilma

- Töö

- töö

- maailm

- oleks

- Vale

- aastat

- sa

- Sinu

- sephyrnet