Investigadores de la Universidad Purdue publicaron un artículo técnico titulado "WWW: Qué, cuándo, dónde calcular en memoria".

Abstracto:

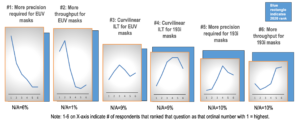

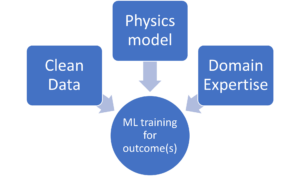

“La computación en memoria (CiM) ha surgido como una solución convincente para aliviar los altos costos de movimiento de datos en las máquinas von Neumann. CiM puede realizar operaciones masivamente paralelas de multiplicación de matrices generales (GEMM) en la memoria, el cálculo dominante en la inferencia de aprendizaje automático (ML). Sin embargo, reutilizar la memoria para computación plantea preguntas clave sobre 1) Qué tipo de CiM usar: Dada una multitud de CiM analógicos y digitales, es necesario determinar su idoneidad desde la perspectiva de los sistemas. 2) Cuándo utilizar CiM: la inferencia de ML incluye cargas de trabajo con una variedad de requisitos de memoria y computación, lo que dificulta identificar cuándo CiM es más beneficioso que los núcleos de procesamiento estándar. 3) Dónde integrar CiM: cada nivel de memoria tiene un ancho de banda y una capacidad diferentes, lo que afecta el movimiento de datos y los beneficios de localidad de la integración de CiM.

En este artículo, exploramos las respuestas a estas preguntas sobre la integración de CiM para la aceleración de la inferencia de ML. Utilizamos Timeloop-Accelergy para la evaluación temprana a nivel de sistema de prototipos de CiM, incluidas primitivas analógicas y digitales. Integramos CiM en diferentes niveles de memoria caché en una arquitectura básica similar a Nvidia A100 y adaptamos el flujo de datos para diversas cargas de trabajo de aprendizaje automático. Nuestros experimentos muestran que las arquitecturas CiM mejoran la eficiencia energética, logrando hasta 0.12 veces menos energía que la línea de base establecida con precisión INT-8 y ganancias de rendimiento de hasta 4 veces con entrelazado y duplicación de peso. El trabajo propuesto proporciona información sobre qué tipo de CiM usar y cuándo y dónde integrarlo de manera óptima en la jerarquía de caché para la aceleración GEMM”.

Encuentra los documento técnico aquí. Publicado en diciembre de 2023 (preimpresión).

Sharma, Tanvi, Mustafa Ali, Indranil Chakraborty y Kaushik Roy. "WWW: qué, cuándo y dónde calcular en memoria". Preimpresión de arXiv arXiv:2312.15896 (2023).

Lectura relacionada

Aumento de la eficiencia energética de la IA con computación en memoria

Cómo procesar cargas de trabajo en escala zetta y mantenerse dentro de un presupuesto de energía fijo.

Modelado de computación en memoria con eficiencia biológica

La IA generativa obliga a los fabricantes de chips a utilizar los recursos informáticos de forma más inteligente.

SRAM en IA: el futuro de la memoria

Por qué la SRAM se considera un elemento crítico en las arquitecturas informáticas nuevas y tradicionales.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://semiengineering.com/cim-integration-for-ml-inference-acceleration/

- :posee

- :es

- :dónde

- $ UP

- 1

- 2023

- a

- aceleración

- el logro de

- AI

- aliviar

- an

- y

- respuestas

- arquitectura

- AS

- At

- Ancho de banda

- Base

- beneficioso

- beneficios

- ambas

- presupuesto

- by

- cache

- PUEDEN

- Capacidad

- irresistible

- cálculo

- Calcular

- Precio

- crítico

- datos

- Diciembre

- determinar

- una experiencia diferente

- difícil

- digital

- dominante

- cada una

- Temprano en la

- eficiencia

- elementos

- surgido

- energía

- eficiencia energética

- se establece

- evaluación

- experimentos

- explorar

- fijas

- Fuerzas

- Desde

- futuras

- Ganancias

- General

- dado

- esta página

- jerarquía

- Alta

- Sin embargo

- HTTPS

- Identifique

- mejorar

- in

- incluye

- Incluye

- Insights

- integrar

- integración

- dentro

- IT

- jpg

- Clave

- aprendizaje

- Nivel

- inferior

- máquina

- máquina de aprendizaje

- Máquinas

- Realizar

- macizamente

- Matrix

- Salud Cerebral

- ML

- más,

- movimiento

- multitud

- Nuevo

- Nvidia

- of

- on

- habiertos

- Operaciones

- nuestros

- Papel

- Paralelo

- realizar

- actuación

- la perspectiva

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- plantea

- industria

- Precisión

- tratamiento

- propuesto

- prototipos

- proporciona un

- publicado

- Preguntas

- con respecto a

- Requisitos

- investigadores

- Recursos

- roy

- Mostrar

- a medida

- estándar

- quedarse

- idoneidad

- Todas las funciones a su disposición

- Técnico

- que

- esa

- La

- El futuro de las

- su

- Estas

- así

- titulada

- a

- tradicional

- tipo

- universidad

- utilizan el

- variedad

- diversos

- visto

- de

- fue

- we

- peso

- ¿

- cuando

- dentro de

- Actividades:

- zephyrnet