Introducción

La generación aumentada de recuperación, o RAG, es un mecanismo que ayuda a los modelos de lenguaje grandes (LLM, por sus siglas en inglés) como GPT a volverse más útiles y conocedores al extraer información de un almacén de datos útiles, de manera muy similar a buscar un libro de una biblioteca. Así es como RAG hace magia con flujos de trabajo simples de IA:

- Base de conocimientos (entrada): Piense en esto como una gran biblioteca llena de cosas útiles: preguntas frecuentes, manuales, documentos, etc. Cuando surge una pregunta, aquí es donde el sistema busca respuestas.

- Activador/Consulta (Entrada): Este es el punto de partida. Por lo general, es una pregunta o solicitud de un usuario que le dice al sistema: "¡Oye, necesito que hagas algo!".

- Tarea/Acción (Salida): Una vez que el sistema aprieta el gatillo, entra en acción. Si es una pregunta, busca una respuesta. Si es una solicitud para hacer algo, lo hace.

Ahora, analicemos el mecanismo RAG en pasos simples:

- Recuperación: En primer lugar, cuando llega una pregunta o solicitud, RAG busca en la base de conocimientos para encontrar información relevante.

- aumentar: A continuación, toma esta información y la mezcla con la pregunta o solicitud original. Esto es como agregar más detalles a la solicitud básica para asegurarse de que el sistema la comprenda completamente.

- Generación: Por último, con toda esta rica información a mano, la introduce en un modelo de lenguaje grande que luego elabora una respuesta bien informada o realiza la acción requerida.

Entonces, en pocas palabras, RAG es como tener un asistente inteligente que primero busca información útil, la combina con la pregunta en cuestión y luego da una respuesta completa o realiza una tarea según sea necesario. De esta manera, con RAG, tu sistema de IA no se limita a disparar en la oscuridad; tiene una base sólida de información sobre la cual trabajar, lo que lo hace más confiable y útil.

¿Qué problema resuelven?

Cerrar la brecha del conocimiento

La IA generativa, impulsada por LLM, es competente para generar respuestas de texto basadas en una cantidad colosal de datos con los que fue entrenada. Si bien esta capacitación permite la creación de texto legible y detallado, la naturaleza estática de los datos de capacitación es una limitación crítica. La información dentro del modelo queda obsoleta con el tiempo y, en un escenario dinámico como un chatbot corporativo, la ausencia de datos en tiempo real o específicos de la organización puede generar respuestas incorrectas o engañosas. Este escenario es perjudicial ya que socava la confianza del usuario en la tecnología, lo que plantea un desafío importante, especialmente en aplicaciones centradas en el cliente o de misión crítica.

La solución RAG

RAG viene al rescate combinando las capacidades generativas de los LLM con la recuperación de información específica en tiempo real, sin alterar el modelo subyacente. Esta fusión permite que el sistema de IA brinde respuestas que no solo son contextualmente adecuadas sino que también se basan en los datos más actuales. Por ejemplo, en un escenario de liga deportiva, mientras que un LLM podría proporcionar información genérica sobre el deporte o los equipos, RAG permite a la IA ofrecer actualizaciones en tiempo real sobre juegos recientes o lesiones de jugadores accediendo a fuentes de datos externas como bases de datos, fuentes de noticias o incluso los propios repositorios de datos de la liga.

Datos que se mantienen actualizados

La esencia de RAG radica en su capacidad para complementar el LLM con datos nuevos y específicos del dominio. La actualización continua del repositorio de conocimientos en RAG es una forma rentable de garantizar que la IA generativa se mantenga actualizada. Además, proporciona una capa de contexto de la que carece un LLM generalizado, mejorando así la calidad de las respuestas. La capacidad de identificar, corregir o eliminar información incorrecta dentro del depósito de conocimientos del RAG aumenta aún más su atractivo, asegurando un mecanismo de autocorrección para una recuperación de información más precisa.

Ejemplos de flujos de trabajo RAG

En el ámbito en evolución de la inteligencia artificial, la generación aumentada de recuperación (RAG) está teniendo un impacto sustancial en varios sectores comerciales al mejorar significativamente las capacidades de los modelos de lenguajes grandes (LLM). Veamos algunos ejemplos para tener una idea de cómo los flujos de trabajo de RAG automatizan las tareas:

- Recuperación e intercambio de conocimientos del equipo interno:

- Escenario: Una corporación multinacional con una cartera diversificada de proyectos a menudo enfrenta desafíos a la hora de compartir conocimientos y perspectivas de manera eficiente entre sus equipos. Para aliviar esto, la empresa implementa una plataforma aumentada por RAG para agilizar la recuperación e intercambio de conocimientos internos.

- Flujo de trabajo:

- Recuperación:

- Consulta de ejemplo: un director de proyecto pregunta: "¿Hemos trabajado en algún proyecto relacionado con la energía renovable en los últimos tres años?"

- El mecanismo RAG busca instantáneamente en las bases de datos internas, informes de proyectos anteriores y cualquier otro repositorio relevante para recuperar información sobre la participación de la empresa en proyectos de energía renovable durante el período especificado.

- aumentar:

- Los datos recuperados incluyen títulos de proyectos, personal clave, entregables finales y resultados de cada proyecto.

- También puede recuperar enlaces a comunicaciones, presentaciones o documentos relevantes que se compartieron internamente durante el curso de estos proyectos.

- Generación:

- Respuesta de ejemplo: El sistema genera una respuesta integral:

“Sí, en los últimos tres años hemos participado en tres importantes proyectos de energía renovable. El proyecto 'Solar Innovations' fue dirigido por Sarah Johnson del Equipo de Sostenibilidad y concluyó en diciembre de 2021 con el desarrollo de un prototipo de estación de carga alimentada por energía solar. El proyecto 'Eficiencia de la energía eólica', encabezado por Mark D'Souza, tenía como objetivo mejorar la eficiencia de las turbinas eólicas y se completó en junio de 2022. Por último, la 'Promoción de la política de energías renovables' fue una iniciativa interdepartamental que concluyó en septiembre de 2022, creando una propuesta de política. para promover la adopción de energías renovables dentro de las comunidades locales. Se puede acceder a documentos, informes y presentaciones relevantes a través de los enlaces proporcionados”.

- Respuesta de ejemplo: El sistema genera una respuesta integral:

- Recuperación:

- Campañas de marketing automatizadas:

- Guión: Una agencia de marketing digital implementa RAG para automatizar la creación y el despliegue de campañas de marketing basadas en las tendencias del mercado y el comportamiento del consumidor en tiempo real.

- Flujo de trabajo:

- Recuperación: Cada vez que ingresa un nuevo cliente potencial al sistema, el mecanismo RAG obtiene detalles relevantes del cliente potencial y su organización y activa el inicio del flujo de trabajo.

- aumentar: Combina estos datos con los objetivos de marketing del cliente, las pautas de marca y los datos demográficos objetivo.

- Ejecución de tareas: El sistema diseña e implementa de forma autónoma una campaña de marketing personalizada en varios canales digitales para capitalizar la tendencia identificada, rastreando el desempeño de la campaña en tiempo real para posibles ajustes.

- Investigación jurídica y preparación de casos:

- Guión: Un despacho de abogados integra RAG para agilizar la investigación jurídica y la preparación de casos.

- Flujo de trabajo:

- Recuperación: Al recibir información sobre un nuevo caso, extrae precedentes legales, estatutos y sentencias recientes relevantes.

- aumentar: Correlaciona estos datos con los detalles del caso.

- Generación: El sistema redacta un escrito preliminar del caso, lo que reduce significativamente el tiempo que los abogados dedican a la investigación preliminar.

- Mejora del servicio al cliente:

- Guión: Una empresa de telecomunicaciones implementa un chatbot mejorado con RAG para atender las consultas de los clientes sobre los detalles del plan, la facturación y la resolución de problemas comunes.

- Flujo de trabajo:

- Recuperación: Al recibir una consulta sobre la asignación de datos de un plan específico, el sistema referencia los últimos planes y ofertas de su base de datos.

- aumentar: combina esta información recuperada con los detalles del plan actual del cliente (del perfil del cliente) y la consulta original.

- Generación: El sistema genera una respuesta personalizada, explicando las diferencias de asignación de datos entre el plan actual del cliente y el plan consultado.

- Gestión de inventario y reordenamiento:

- Escenario: Una empresa de comercio electrónico emplea un sistema aumentado por RAG para gestionar el inventario y reordenar productos automáticamente cuando los niveles de existencias caen por debajo de un umbral predeterminado.

- Flujo de trabajo:

- Recuperación: Cuando el stock de un producto alcanza un nivel bajo, el sistema verifica el historial de ventas, las fluctuaciones estacionales de la demanda y las tendencias actuales del mercado en su base de datos.

- Aumento: Al combinar los datos recuperados con la frecuencia de reordenamiento del producto, los plazos de entrega y los detalles del proveedor, se determina la cantidad óptima para reordenar.

- Ejecución de tareas: Luego, el sistema interactúa con el software de adquisiciones de la empresa para realizar automáticamente una orden de compra con el proveedor, lo que garantiza que la plataforma de comercio electrónico nunca se quede sin productos populares.

- Incorporación de empleados y configuración de TI:

- Escenario: Una corporación multinacional utiliza un sistema impulsado por RAG para agilizar el proceso de incorporación de nuevos empleados, garantizando que todos los requisitos de TI estén configurados antes del primer día del empleado.

- Flujo de trabajo:

- Recuperación: Al recibir los detalles de una nueva contratación, el sistema consulta la base de datos de Recursos Humanos para determinar la función, el departamento y la ubicación del empleado.

- Aumento: Correlaciona esta información con las políticas de TI de la empresa, determinando el software, el hardware y los permisos de acceso que necesitará el nuevo empleado.

- Ejecución de tareas: Luego, el sistema se comunica con el sistema de tickets del departamento de TI, generando tickets automáticamente para configurar una nueva estación de trabajo, instalar el software necesario y otorgar el acceso adecuado al sistema. Esto garantiza que cuando el nuevo empleado comience, su estación de trabajo esté lista y pueda sumergirse inmediatamente en sus responsabilidades.

Estos ejemplos subrayan la versatilidad y los beneficios prácticos de emplear flujos de trabajo RAG para abordar desafíos comerciales complejos y en tiempo real en una gran variedad de dominios.

Conecte sus datos y aplicaciones con Nanonets AI Assistant para chatear con datos, implementar chatbots y agentes personalizados y crear flujos de trabajo RAG.

¿Cómo crear tus propios flujos de trabajo RAG?

Proceso de creación de un flujo de trabajo RAG

El proceso de creación de un flujo de trabajo de generación aumentada de recuperación (RAG) se puede dividir en varios pasos clave. Estos pasos se pueden clasificar en tres procesos principales: ingestión, recuperacióny generación de AHSS, así como alguna preparación adicional:

1. Preparación:

- Preparación de la base de conocimientos: Prepare un repositorio de datos o una base de conocimientos ingiriendo datos de diversas fuentes: aplicaciones, documentos, bases de datos. Estos datos deben formatearse para permitir una capacidad de búsqueda eficiente, lo que básicamente significa que estos datos deben formatearse en una representación de objeto 'Documento' unificada.

2. Proceso de ingestión:

- Configuración de la base de datos de vectores: Utilice bases de datos vectoriales como bases de conocimiento, empleando varios algoritmos de indexación para organizar vectores de alta dimensión, lo que permite una capacidad de consulta rápida y sólida.

- Extracción de datos: Extraer datos de estos documentos.

- Fragmentación de datos: Divida los documentos en fragmentos de secciones de datos.

- Incrustación de datos: Transforme estos fragmentos en incrustaciones utilizando un modelo de incrustaciones como el proporcionado por OpenAI.

- Desarrolle un mecanismo para incorporar su consulta de usuario. Puede ser una interfaz de usuario o un flujo de trabajo basado en API.

3. Proceso de recuperación:

- Incrustación de consultas: Obtenga la incorporación de datos para la consulta del usuario.

- Recuperación de fragmentos: Realice una búsqueda híbrida para encontrar los fragmentos almacenados más relevantes en la base de datos de vectores en función de la incorporación de consultas.

- Extracción de contenido: Introduzca el contenido más relevante de su base de conocimientos en su mensaje como contexto.

4. Proceso de Generación:

- Generación inmediata: Combine la información recuperada con la consulta original para formar un mensaje. Ahora puedes realizar –

- Generación de respuesta: Envíe el texto del mensaje combinado al LLM (modelo de lenguaje grande) para generar una respuesta bien informada.

- Ejecución de tareas: Envíe el texto del mensaje combinado a su agente de datos de LLM, quien inferirá la tarea correcta a realizar en función de su consulta y la realizará. Por ejemplo, puedes crear un agente de datos de Gmail y luego pedirle que "envíe correos electrónicos promocionales a clientes potenciales recientes de Hubspot" y el agente de datos:

- Obtenga clientes potenciales recientes de Hubspot.

- Utilice su base de conocimientos para obtener información relevante sobre clientes potenciales. Su base de conocimientos puede ingerir datos de múltiples fuentes de datos: LinkedIn, API de enriquecimiento de clientes potenciales, etc.

- seleccione correos electrónicos promocionales personalizados para cada cliente potencial.

- envíe estos correos electrónicos utilizando su proveedor de correo electrónico/administrador de campañas de correo electrónico.

5. Configuración y optimización:

- Personalización: Personalice el flujo de trabajo para que se ajuste a requisitos específicos, lo que podría incluir ajustar el flujo de ingesta, como el preprocesamiento, la fragmentación y la selección del modelo de incrustación.

- Mejoramiento: Implementar estrategias de optimización para mejorar la calidad de la recuperación y reducir el recuento de tokens a procesar, lo que podría conducir a la optimización del rendimiento y los costos a escala.

Implementando uno usted mismo

La implementación de un flujo de trabajo de generación aumentada de recuperación (RAG) es una tarea compleja que implica numerosos pasos y una buena comprensión de los algoritmos y sistemas subyacentes. A continuación se detallan los desafíos destacados y los pasos para superarlos para aquellos que buscan implementar un flujo de trabajo RAG:

Desafíos al crear su propio flujo de trabajo RAG:

- Novedad y falta de prácticas establecidas: RAG es una tecnología relativamente nueva, propuesta por primera vez en 2020, y los desarrolladores aún están descubriendo las mejores prácticas para implementar sus mecanismos de recuperación de información en la IA generativa.

- Costo: Implementar RAG será más costoso que usar solo un modelo de lenguaje grande (LLM). Sin embargo, es menos costoso que volver a capacitar al LLM con frecuencia.

- Estructuración de datos: Determinar cómo modelar mejor los datos estructurados y no estructurados dentro de la biblioteca de conocimientos y la base de datos vectorial es un desafío clave.

- Alimentación de datos incremental: Es crucial desarrollar procesos para introducir datos de forma incremental en el sistema RAG.

- Manejo de imprecisiones: Es necesario implementar procesos para manejar informes de inexactitudes y corregir o eliminar esas fuentes de información en el sistema RAG.

Conecte sus datos y aplicaciones con Nanonets AI Assistant para chatear con datos, implementar chatbots y agentes personalizados y crear flujos de trabajo RAG.

Cómo empezar a crear su propio flujo de trabajo RAG:

La implementación de un flujo de trabajo RAG requiere una combinación de conocimiento técnico, las herramientas adecuadas y aprendizaje y optimización continuos para garantizar su efectividad y eficiencia en el cumplimiento de sus objetivos. Para aquellos que buscan implementar flujos de trabajo RAG ellos mismos, hemos seleccionado una lista de guías prácticas integrales que lo guiarán a través de los procesos de implementación en detalle:

Cada uno de los tutoriales viene con un enfoque o plataforma única para lograr la implementación deseada en los temas especificados.

Si está buscando profundizar en la creación de sus propios flujos de trabajo RAG, le recomendamos consultar todos los artículos enumerados anteriormente para obtener una idea holística necesaria para comenzar su viaje.

Implemente flujos de trabajo RAG utilizando plataformas ML

Si bien el atractivo de construir un flujo de trabajo de generación aumentada de recuperación (RAG) desde cero ofrece una cierta sensación de logro y personalización, es innegable que es una tarea compleja. Al reconocer las complejidades y los desafíos, varias empresas han dado un paso adelante y ofrecen plataformas y servicios especializados para simplificar este proceso. Aprovechar estas plataformas no sólo puede ahorrar tiempo y recursos valiosos, sino también garantizar que la implementación se base en las mejores prácticas de la industria y esté optimizada para el rendimiento.

Para organizaciones o individuos que quizás no tengan el ancho de banda o la experiencia para construir un sistema RAG desde cero, estas plataformas de ML presentan una solución viable. Al optar por estas plataformas, se puede:

- Evite las complejidades técnicas: Evite los intrincados pasos de los procesos de estructuración, incrustación y recuperación de datos. Estas plataformas suelen venir con soluciones y marcos prediseñados adaptados a los flujos de trabajo de RAG.

- Aprovechar la experiencia: Benefíciese de la experiencia de profesionales que tienen un profundo conocimiento de los sistemas RAG y ya han abordado muchos de los desafíos asociados con su implementación.

- Escalabilidad: Estas plataformas a menudo se diseñan teniendo en cuenta la escalabilidad, lo que garantiza que a medida que sus datos crezcan o sus requisitos cambien, el sistema pueda adaptarse sin una revisión completa.

- Rentabilidad: Si bien existe un costo asociado con el uso de una plataforma, podría resultar más rentable a largo plazo, especialmente si se consideran los costos de resolución de problemas, optimización y posibles reimplementaciones.

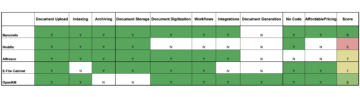

Echemos un vistazo a las plataformas que ofrecen capacidades de creación de flujos de trabajo RAG.

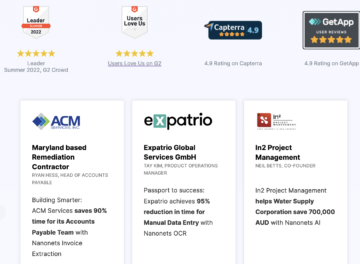

Nanonetas

Nanonets ofrece asistentes de IA, chatbots y flujos de trabajo RAG seguros impulsados por los datos de su empresa. Permite la sincronización de datos en tiempo real entre varias fuentes de datos, lo que facilita la recuperación completa de información para los equipos. La plataforma permite la creación de chatbots junto con la implementación de flujos de trabajo complejos a través de lenguaje natural, impulsados por modelos de lenguaje grande (LLM). También proporciona conectores de datos para leer y escribir datos en sus aplicaciones y la capacidad de utilizar agentes LLM para realizar acciones directamente en aplicaciones externas.

Página del producto Asistente de IA de Nanonets

IA generativa de AWS

AWS ofrece una variedad de servicios y herramientas bajo su paraguas de IA generativa para satisfacer diferentes necesidades comerciales. Proporciona acceso a una amplia gama de modelos de cimentación líderes en la industria de varios proveedores a través de Amazon Bedrock. Los usuarios pueden personalizar estos modelos básicos con sus propios datos para crear experiencias más personalizadas y diferenciadas. AWS enfatiza la seguridad y la privacidad, garantizando la protección de datos al personalizar los modelos básicos. También destaca la infraestructura rentable para escalar la IA generativa, con opciones como AWS Trainium, AWS Inferentia y GPU NVIDIA para lograr el mejor rendimiento en términos de precio. Además, AWS facilita la creación, la capacitación y la implementación de modelos básicos en Amazon SageMaker, ampliando el poder de los modelos básicos a los casos de uso específicos de un usuario.

Página del producto de IA generativa de AWS

IA generativa en Google Cloud

La IA generativa de Google Cloud proporciona un sólido conjunto de herramientas para desarrollar modelos de IA, mejorar la búsqueda y permitir conversaciones impulsadas por IA. Destaca en análisis de sentimientos, procesamiento del lenguaje, tecnologías del habla y gestión automatizada de documentos. Además, puede crear flujos de trabajo RAG y agentes LLM, atendiendo a diversos requisitos comerciales con un enfoque multilingüe, lo que la convierte en una solución integral para diversas necesidades empresariales.

IA generativa de Oracle

La IA generativa de Oracle (OCI Generative AI) está diseñada para empresas y ofrece modelos superiores combinados con una excelente gestión de datos, infraestructura de IA y aplicaciones comerciales. Permite refinar modelos utilizando los propios datos del usuario sin compartirlos con grandes proveedores de modelos lingüísticos u otros clientes, garantizando así la seguridad y la privacidad. La plataforma permite la implementación de modelos en clústeres de IA dedicados para lograr un rendimiento y precios predecibles. OCI Generative AI proporciona varios casos de uso, como resumen de texto, generación de copias, creación de chatbot, conversión estilística, clasificación de texto y búsqueda de datos, abordando un espectro de necesidades empresariales. Procesa la entrada del usuario, que puede incluir lenguaje natural, ejemplos de entrada/salida e instrucciones, para generar, resumir, transformar, extraer información o clasificar texto en función de las solicitudes del usuario, enviando una respuesta en el formato especificado.

Cloudera

En el ámbito de la IA generativa, Cloudera emerge como un aliado confiable para las empresas. Su lago de datos abiertos, accesible tanto en nubes públicas como privadas, es una piedra angular. Ofrecen una gama de servicios de datos que ayudan en todo el ciclo de vida de los datos, desde el borde hasta la IA. Sus capacidades se extienden a la transmisión de datos en tiempo real, el almacenamiento y análisis de datos en lagos abiertos y la implementación y monitoreo de modelos de aprendizaje automático a través de Cloudera Data Platform. Es importante destacar que Cloudera permite la creación de flujos de trabajo de generación aumentada de recuperación, fusionando una poderosa combinación de capacidades de recuperación y generación para aplicaciones de IA mejoradas.

Glean

Glean emplea IA para mejorar la búsqueda en el lugar de trabajo y el descubrimiento de conocimientos. Aprovecha la búsqueda vectorial y los grandes modelos de lenguaje basados en aprendizaje profundo para la comprensión semántica de las consultas, mejorando continuamente la relevancia de la búsqueda. También ofrece un asistente de IA generativa para responder consultas y resumir información en documentos, tickets y más. La plataforma proporciona resultados de búsqueda personalizados y sugiere información basada en la actividad y las tendencias del usuario, además de facilitar una fácil configuración e integración con más de 100 conectores a varias aplicaciones.

robot terrestre

Landbot ofrece un conjunto de herramientas para crear experiencias conversacionales. Facilita la generación de clientes potenciales, la participación del cliente y el soporte a través de chatbots en sitios web o WhatsApp. Los usuarios pueden diseñar, implementar y escalar chatbots con un creador sin código e integrarlos con plataformas populares como Slack y Messenger. También proporciona varias plantillas para diferentes casos de uso, como generación de oportunidades de venta, atención al cliente y promoción de productos.

Página de inicio de Landbot.io

Base de chat

Chatbase proporciona una plataforma para personalizar ChatGPT para alinearlo con la personalidad de una marca y la apariencia del sitio web. Permite la recopilación de clientes potenciales, resúmenes de conversaciones diarias y la integración con otras herramientas como Zapier, Slack y Messenger. La plataforma está diseñada para ofrecer una experiencia de chatbot personalizada para empresas.

Escala AI

Scale AI aborda el cuello de botella de datos en el desarrollo de aplicaciones de IA al ofrecer ajustes y RLHF para adaptar los modelos básicos a necesidades comerciales específicas. Se integra o se asocia con modelos líderes de IA, lo que permite a las empresas incorporar sus datos para una diferenciación estratégica. Junto con la capacidad de crear flujos de trabajo RAG y agentes LLM, Scale AI proporciona una plataforma de IA generativa completa para el desarrollo acelerado de aplicaciones de IA.

Escalar la página de inicio de IA

Shakudo - Soluciones LLM

Shakudo ofrece una solución unificada para implementar modelos de lenguajes grandes (LLM), administrar bases de datos vectoriales y establecer canales de datos sólidos. Agiliza la transición de demostraciones locales a servicios LLM de nivel de producción con monitoreo en tiempo real y orquestación automatizada. La plataforma admite operaciones flexibles de IA generativa, bases de datos vectoriales de alto rendimiento y proporciona una variedad de herramientas LLMOps especializadas, lo que mejora la riqueza funcional de las pilas de tecnología existentes.

Página del producto Shakundo RAG Workflows

Cada plataforma/negocio mencionado tiene su propio conjunto de características y capacidades únicas, y podrían explorarse más a fondo para comprender cómo podrían aprovecharse para conectar datos empresariales e implementar flujos de trabajo RAG.

Conecte sus datos y aplicaciones con Nanonets AI Assistant para chatear con datos, implementar chatbots y agentes personalizados y crear flujos de trabajo RAG.

Flujos de trabajo RAG con nanoredes

En el ámbito del aumento de los modelos de lenguaje para ofrecer respuestas más precisas y reveladoras, la Generación Aumentada de Recuperación (RAG) se erige como un mecanismo fundamental. Este intrincado proceso eleva la confiabilidad y utilidad de los sistemas de IA, garantizando que no funcionen simplemente en un vacío de información.

En el centro de esto, Nanonets AI Assistant surge como un compañero de IA seguro y multifuncional diseñado para cerrar la brecha entre su conocimiento organizacional y los modelos de lenguajes grandes (LLM), todo dentro de una interfaz fácil de usar.

A continuación se ofrece un vistazo a la perfecta integración y mejora del flujo de trabajo que ofrecen las capacidades RAG de Nanonets:

Conectividad de datos:

Nanonets facilita conexiones perfectas a más de 100 aplicaciones de espacios de trabajo populares, incluidas Slack, Notion, Google Suite, Salesforce y Zendesk, entre otras. Es competente en el manejo de un amplio espectro de tipos de datos, ya sean no estructurados como archivos PDF, TXT, imágenes, audio y video, o datos estructurados como CSV, hojas de cálculo, MongoDB y bases de datos SQL. Esta conectividad de datos de amplio espectro garantiza una sólida base de conocimientos de la que puede beneficiarse el mecanismo RAG.

Agentes desencadenantes y de acción:

Con Nanonets, configurar agentes de activación/acción es muy sencillo. Estos agentes están atentos a los eventos en las aplicaciones de su espacio de trabajo e inician acciones según sea necesario. Por ejemplo, establezca un flujo de trabajo para monitorear nuevos correos electrónicos en soporte@tu_empresa.com, utilice su documentación y conversaciones de correo electrónico pasadas como base de conocimientos, redacte una respuesta de correo electrónico detallada y envíela, todo ello orquestado a la perfección.

Ingestión e indexación de datos optimizadas:

La ingesta e indexación de datos optimizadas son parte del paquete, lo que garantiza un procesamiento de datos fluido que es manejado en segundo plano por el Asistente de IA de Nanonets. Esta optimización es crucial para la sincronización en tiempo real con las fuentes de datos, lo que garantiza que el mecanismo RAG tenga la información más reciente con la que trabajar.

Para comenzar, puede llamar a uno de nuestros expertos en IA y podemos brindarle una demostración y prueba personalizadas del Asistente de IA de Nanonets según su caso de uso.

Una vez configurado, puede utilizar su Asistente de IA de Nanonets para:

Crear flujos de trabajo de chat RAG

Capacite a sus equipos con información completa y en tiempo real de todas sus fuentes de datos.

Crear flujos de trabajo del agente RAG

Utilice lenguaje natural para crear y ejecutar flujos de trabajo complejos impulsados por LLM que interactúan con todas sus aplicaciones y datos.

Implementar chatbots basados en RAG

Cree e implemente chatbots de IA personalizados listos para usar que lo conozcan en cuestión de minutos.

Impulse la eficiencia de su equipo

Con Nanonets AI, no solo estás integrando datos; estás potenciando las capacidades de tu equipo. Al automatizar tareas mundanas y brindar respuestas interesantes, sus equipos pueden reasignar su enfoque a iniciativas estratégicas.

El Asistente de IA impulsado por RAG de Nanonets es más que una simple herramienta; es un catalizador que agiliza las operaciones, mejora la accesibilidad a los datos e impulsa a su organización hacia un futuro de automatización y toma de decisiones informadas.

Conecte sus datos y aplicaciones con Nanonets AI Assistant para chatear con datos, implementar chatbots y agentes personalizados y crear flujos de trabajo RAG.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://nanonets.com/blog/retrieval-augmented-generation/

- :posee

- :es

- :no

- :dónde

- $ UP

- 100

- 2020

- 2021

- 2022

- a

- capacidad

- Nuestra Empresa

- arriba

- acelerado

- de la máquina

- visitada

- accesibilidad

- accesible

- el acceso

- preciso

- Lograr

- a través de

- la columna Acción

- acciones

- actividad

- adaptar

- la adición de

- Adicionales

- Adicionalmente

- dirigido

- direcciones

- direccionamiento

- Añade

- el ajuste

- ajustes

- Adopción

- defensa

- Agente

- agentes

- AI

- Asistente de inteligencia

- Modelos AI

- Plataforma de IA

- Sistemas de IA

- Dirigido

- algoritmos

- alinear

- Todos

- aliviar

- permitir

- permite

- atractivo

- Ally

- solo

- a lo largo de

- ya haya utilizado

- también

- Amazon

- Amazon SageMaker

- entre

- cantidad

- an

- análisis

- y

- https://www.youtube.com/watch?v=xB-eutXNUMXJtA&feature=youtu.be

- respuestas

- cualquier

- API

- apelar

- Aplicación

- Desarrollo de aplicaciones

- aplicaciones

- enfoque

- adecuado

- aplicaciones

- APT

- somos

- artificial

- inteligencia artificial

- AS

- Legal

- asistentes

- asociado

- At

- audio

- aumentar

- aumentado

- automatizado

- Confirmación de Viaje

- automáticamente

- automatizar

- Automatización

- autónomamente

- evitar

- AWS

- Inferencia de AWS

- Atrás

- fondo

- Ancho de banda

- bases

- basado

- básica

- Básicamente

- BE

- a las que has recomendado

- se convierte en

- antes

- comportamiento

- a continuación

- es el beneficio

- beneficios

- además de

- MEJOR

- y las mejores prácticas

- entre

- Big

- facturación

- Blend

- combina

- Blog

- primer libro

- ambas

- marca

- Descanso

- PUENTE

- Roto

- build

- constructor

- Construir la

- Aplicaciones empresariales

- negocios

- pero

- by

- llamar al

- Campaña

- Campañas

- PUEDEN

- Puede conseguir

- capacidades

- capitalizar

- case

- cases

- Catalizador

- abastecer

- a ciertos

- Reto

- retos

- el cambio

- canales

- cargando

- chatterbot

- Chatbots

- ChatGPT

- comprobación

- Cheques

- clasificación

- clasificar

- Soluciones

- Cloudera

- --

- COM

- combinación

- combinar

- combinado

- combina

- combinar

- cómo

- proviene

- Algunos

- Comunicaciónes

- Comunidades

- compañero

- compañía

- completar

- Completado

- integraciones

- exhaustivo

- Concluido

- Conectándote

- Conexiones

- Conectividad

- en vista de

- construcción

- consumidor

- comportamiento del consumidor

- contenido

- contexto

- continuo

- continuamente

- Conversación

- conversacional

- conversaciones

- Conversión

- piedra angular

- Sector empresarial

- CORPORACIÓN

- correcta

- Cost

- rentable

- costoso

- Precio

- podría

- acoplado

- curso

- Para crear

- Creamos

- creación

- crítico

- crucial

- comisariada

- Current

- personalizado

- cliente

- para los principales clientes de comunicaciones europeas

- Atención al cliente

- Clientes

- personalización

- personalizan

- todos los días

- Oscuro

- datos

- datos de gestión

- Plataforma de datos

- proceso de datos

- protección de datos

- almacenamiento de datos

- Base de datos

- bases de datos

- día

- Diciembre

- diciembre 2021

- Toma de Decisiones

- a dedicados

- profundo

- entregamos

- ahondar

- Demanda

- De demostración

- Demografía

- Demos

- Departamento

- desplegar

- Desplegando

- despliegue

- despliega

- Diseño

- diseñado

- diseños

- deseado

- detalle

- detallado

- detalles

- Determinar

- determina

- determinar

- perjudicial

- desarrolladores

- el desarrollo

- Desarrollo

- diferencias

- una experiencia diferente

- diferenciado

- digital

- marketing digital

- directamente

- descubrimiento

- inmersión

- diverso

- diversificado

- cartera diversificada

- do

- documento

- gestión de documentos

- documentación

- documentos

- dominios

- hecho

- DE INSCRIPCIÓN

- borrador

- durante

- lugar de trabajo dinámico

- comercio electrónico

- cada una

- de forma sencilla

- Southern Implants

- eficacia

- eficiencia

- eficiente

- eficiente.

- ya sea

- eleva

- correo

- incrustación

- emerge

- enfatiza

- Nuestros

- personas

- empleando

- emplea

- empodera

- permite

- permitiendo

- limpia

- energía

- eficiencia energética

- proyectos energéticos

- comprometido

- de su negocio.

- mejorar

- mejorado

- Estrategias orientadas

- Mejora

- mejorar

- garantizar

- asegura

- asegurando que

- Empresa

- empresas

- Todo

- especialmente

- esencia

- establecer

- se establece

- el establecimiento

- etc.

- Éter (ETH)

- Incluso

- Eventos

- evolución

- ejemplo

- ejemplos

- excelente,

- ejecución

- existente

- acelerar

- costoso

- experience

- Experiencias

- Experiencia

- expertos

- explicando

- explorado

- ampliar

- extensión

- externo

- extraerlos

- Extracción

- caras

- facilita

- facilitando

- Otoño

- RÁPIDO

- Caracteristicas

- alimentación

- pocos

- archivos

- final

- Encuentre

- Firme

- Nombre

- cómodo

- flexible

- de tus señales

- fluctuaciones del mercado.

- Focus

- formulario

- formato

- adelante

- Fundación

- marcos

- Frecuencia

- frecuentemente

- fresco

- Desde

- ser completados

- completamente

- funcional

- promover

- fusión

- futuras

- Juegos

- brecha

- generar

- genera

- la generación de

- generación de AHSS

- generativo

- IA generativa

- obtener

- gif

- Donar

- da

- Vislumbrar

- gmail

- candidato

- GPU

- conceder

- Polo a Tierra

- crece

- orientaciones

- Guías

- mano

- encargarse de

- Manejo

- emprendedor

- Materiales

- Tienen

- es

- encabezada

- Corazón

- serviciales

- ayuda

- Destacado

- destacados

- alquiler

- historia

- holístico

- Cómo

- Como Hacer

- Sin embargo

- hr

- HTTPS

- HubSpot

- Híbrido

- i

- no haber aun identificado una solucion para el problema

- Identifique

- if

- imágenes

- inmediatamente

- Impacto

- implementar

- implementación

- implementación

- implementos

- mejorar

- la mejora de

- in

- incluir

- incluye

- Incluye

- incorporar

- individuos

- energético

- líderes en la industria

- info

- información

- informó

- EN LA MINA

- iniciando

- Iniciativa

- iniciativas

- innovaciones

- Las opciones de entrada

- perspicaz

- Insights

- instalar

- ejemplo

- instantáneamente

- Instrucciones

- integrar

- Integra

- Integración

- integración

- Intelligence

- interactuar

- Interfaz

- las interfaces

- interno

- internamente

- dentro

- complejidades

- intrincado

- Introducción

- inventario

- la participación de

- implica

- cuestiones

- IT

- SUS

- Johnson

- junio

- solo

- Clave

- Saber

- especialistas

- Falta

- idioma

- large

- Finalmente

- más reciente

- de derecho criminal

- bufete de abogados

- .

- Lead

- líder

- Prospectos

- Liga

- aprendizaje

- LED

- Legal

- menos

- dejar

- Nivel

- apalancado

- apalancamientos

- aprovechando

- Biblioteca

- se encuentra

- ciclo de vida

- como

- la limitación

- Etiqueta LinkedIn

- enlaces

- Lista

- Listado

- local

- Ubicación

- Largo

- Mira

- mirando

- MIRADAS

- Baja

- máquina

- máquina de aprendizaje

- magic

- Inicio

- gran

- para lograr

- HACE

- Realizar

- gestionan

- Management

- gerente

- administrar

- muchos

- marca

- Mercado

- Tendencias del mercado

- Marketing

- agencia de marketing

- Campañas de mercadeo

- Puede..

- significa

- mecanismo

- los mecanismos de

- reunión

- mencionado

- simplemente

- Messenger

- podría

- mente

- minutos

- engañoso

- mezcla

- ML

- modelo

- modelos

- MongoDB

- Monitorear

- monitoreo

- más,

- Por otra parte

- MEJOR DE TU

- mucho más

- multinacional

- múltiples

- miríada

- Natural

- Lenguaje natural

- Naturaleza

- necesario

- ¿ Necesita ayuda

- nunca

- Nuevo

- noticias

- Next

- Noción

- ahora

- numeroso

- Cáscara de nuez

- Nvidia

- objeto

- ,

- of

- off

- LANZAMIENTO

- Ofrecido

- que ofrece

- Ofertas

- a menudo

- on

- Inmersión

- una vez

- ONE

- , solamente

- habiertos

- datos abiertos

- OpenAI

- funcionamiento

- Operaciones

- óptimo

- optimización

- optimizado

- Opciones

- or

- oráculo

- orquestado

- orquestación

- solicite

- organización

- organizativo

- para las fiestas.

- reconocida por

- Otro

- Otros

- nuestros

- salir

- resultados

- salida

- Más de

- Superar

- Revisar

- EL DESARROLLADOR

- paquete

- parte

- socios

- pasado

- realizar

- actuación

- realiza

- período

- permisos

- Personalidad

- Personalizado

- Personal

- esencial

- Colocar

- plan

- jubilación

- plataforma

- Plataformas

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- jugador

- punto

- políticas

- política

- Pops

- Popular

- portafolio

- posible

- posible

- industria

- alimentado

- poderoso

- Metodología

- prácticas

- necesidad

- Previsible

- preliminar

- preparación

- Preparar

- presente

- Presentations

- precio

- cotización

- política de privacidad

- privada

- Problema

- en costes

- tratamiento

- obtención

- Producto

- Productos

- profesionales

- Mi Perfil

- proyecto

- proyecta

- Promoción

- promocional

- propuesta

- propuesto

- Protección

- prototipo

- Demostrar.

- proporcionar

- previsto

- proveedor

- los proveedores

- proporciona un

- proporcionando

- público

- tracción

- Tira

- comprar

- orden de compra

- Poniendo

- calidad

- la cantidad

- consultas

- pregunta

- distancia

- RE

- alcances

- Leer

- ready

- en tiempo real

- datos en tiempo real

- reino

- aprovecha

- reciente

- reconociendo

- recomiendan

- reducir

- la reducción de

- referencias

- refinación

- con respecto a

- relacionado

- relativamente

- la relevancia

- fiabilidad

- confianza

- permanece

- Renovables

- energía renovable

- Informes

- repositorio

- representación

- solicita

- solicitudes

- Requisitos

- Requisitos

- requiere

- rescatar

- la investigación

- Recursos

- respuesta

- respuestas

- responsabilidades

- Resultados

- reentrenamiento

- Rico

- Derecho

- robusto

- Función

- Ejecutar

- corre

- s

- sabio

- ventas

- fuerza de ventas

- Guardar

- Escalabilidad

- Escala

- escala ia

- la ampliación

- guión

- rayar

- sin costura

- sin problemas

- Buscar

- Búsquedas

- búsqueda

- estacional

- (secciones)

- Sectores

- seguro

- EN LINEA

- seleccionar

- envío

- enviando

- sentido

- sentimiento

- Septiembre

- de coches

- Servicios

- set

- pólipo

- Configure

- Varios

- compartido

- compartir

- disparo

- tienes

- importante

- significativamente

- sencillos

- simplificar

- flojo

- inteligente

- sencillo.

- So

- Software

- solar

- funciona con energía solar

- sólido

- a medida

- Soluciones

- RESOLVER

- algo

- algo

- Fuentes

- especializado

- soluciones y

- especificado

- Spectrum

- habla

- pasar

- Deportes

- Deportes

- SQL

- Stacks

- es la

- comienzo

- fundó

- Comience a

- comienza

- estación

- pasos

- Sin embargo

- en stock

- STORAGE

- tienda

- almacenados

- Estratégico

- estrategias

- en streaming

- aerodinamizar

- estructurado

- datos estructurados y no estructurados

- estructurando

- sustancial

- tal

- Sugiere

- suite

- resumir

- sobrealimentado

- superior

- proveedor

- SOPORTE

- soportes

- seguro

- Sostenibilidad

- Columpios

- sincronización

- te

- Todas las funciones a su disposición

- adaptado

- ¡Prepárate!

- toma

- Target

- afectados

- Tarea

- tareas

- equipo

- equipos

- tecnología

- Técnico

- Tecnologías

- Tecnología

- telecomunicaciones

- decirles

- plantillas

- texto

- Clasificación de texto

- que

- esa

- La

- la información

- su

- Les

- sí mismos

- luego

- Ahí.

- de este modo

- Estas

- ellos

- cosa

- pensar

- así

- aquellos

- Tres

- umbral

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- Así

- venta de entradas

- entradas

- equipo

- veces

- títulos

- a

- ficha

- del IRS

- Temas

- hacia

- Seguimiento

- entrenado

- Formación

- Transformar

- transición

- Tendencia

- Tendencias

- juicio

- detonante

- Confía en

- digno de confianza

- turbina

- Tutoriales

- tipos

- paraguas

- innegablemente

- bajo

- subyacente

- guion bajo

- entender

- comprensión

- entiende

- unificado

- único

- características unicas

- Actualizaciones

- actualización

- a

- us

- utilizan el

- caso de uso

- Usuario

- Interfaz de usuario

- fácil de utilizar

- usuarios

- usos

- usando

- generalmente

- utilizar

- Aspiradora

- Valioso

- variedad

- diversos

- versatilidad

- vía

- y

- Video

- caminar

- fue

- Camino..

- we

- Página web

- sitios web

- WELL

- tuvieron

- cuando

- cuando

- que

- mientras

- QUIENES

- amplio

- Amplia gama

- seguirá

- viento

- energía eólica

- aerogenerador

- dentro de

- sin

- Actividades:

- trabajado

- flujo de trabajo

- flujos de trabajo

- Trabajo

- puesto de trabajo

- escribir

- años

- si

- Usted

- tú

- Zendesk

- zephyrnet