Generado con Midjourney

Las empresas de todas las industrias y rincones del mundo se apresuran a integrar el poder de los modelos de lenguaje extenso (LLM) como ChatGPT de OpenAI, Claude de Anthropic y Jurassic de AI12Lab para aumentar el rendimiento en una amplia gama de aplicaciones comerciales, como investigación de mercado, servicio al cliente y generación de contenidos.

Sin embargo, la creación de una aplicación LLM a escala empresarial requiere un conjunto de herramientas y una comprensión diferentes a los de la creación de aplicaciones tradicionales de aprendizaje automático (ML). Los líderes empresariales y los ejecutivos que desean preservar la voz de la marca y la calidad del servicio confiable deben desarrollar una comprensión más profunda de cómo funcionan los LLM y los pros y los contras de varias herramientas en una pila de aplicaciones LLM.

En este artículo, le brindaremos una introducción esencial a la estrategia y las herramientas de alto nivel que necesitará para crear y ejecutar una aplicación LLM para su negocio.

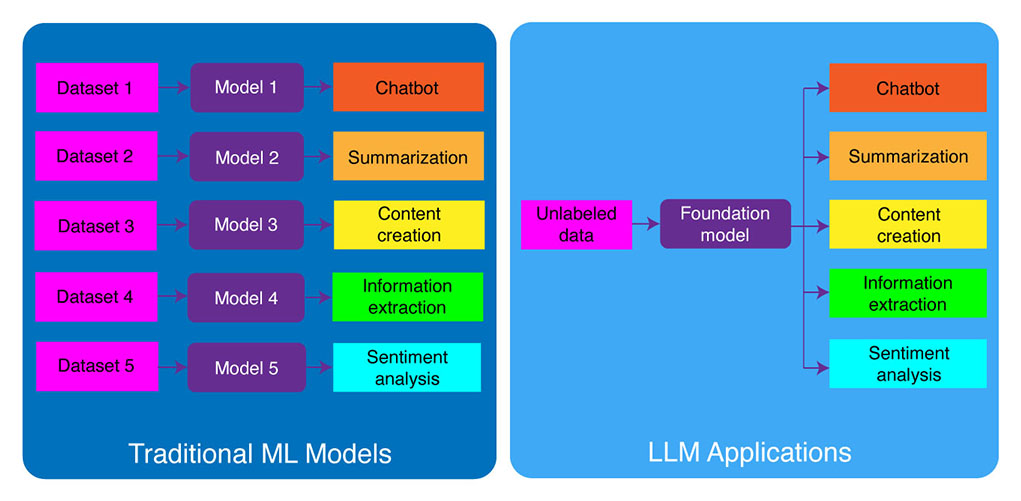

Desarrollo de ML tradicional frente a aplicaciones LLM

Los modelos de aprendizaje automático tradicionales eran específicos de la tarea, lo que significa que necesitaba crear un modelo separado para cada tarea diferente. Por ejemplo, si quisiera analizar el sentimiento del cliente, necesitaría construir un modelo, y si quisiera construir un chatbot de atención al cliente, necesitaría construir otro modelo.

Este proceso de creación y entrenamiento de modelos de ML específicos de tareas lleva mucho tiempo y requiere una gran cantidad de datos. El tipo de conjuntos de datos necesarios para entrenar estos diferentes modelos de ML también variaría según la tarea. Para entrenar un modelo para analizar la opinión del cliente, necesitaría un conjunto de datos de reseñas de clientes que se hayan etiquetado con una opinión correspondiente (positiva, negativa, neutral). Para entrenar un modelo para construir un chatbot de atención al cliente, necesitaría un conjunto de datos de conversaciones entre los clientes y el soporte técnico.

Los grandes modelos de lenguaje han cambiado esto. Los LLM están pre-entrenados en un conjunto de datos masivo de texto y código, lo que les permite desempeñarse bien en una amplia gama de tareas listas para usar, que incluyen:

- Resumen de texto

- Creación de contenido

- Traducción

- Extraccion de informacion

- Respuesta a la pregunta

- Análisis de los sentimientos

- Servicio al cliente

- Soporte de ventas

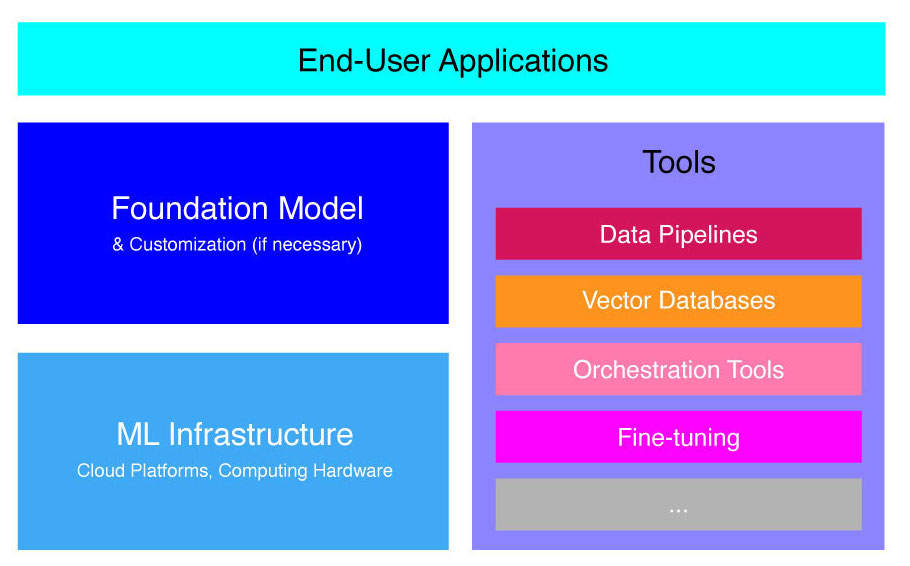

El proceso de desarrollo de aplicaciones LLM se puede dividir en cuatro pasos esenciales:

- Elija un modelo de base apropiado. Es un componente clave que define el rendimiento de su aplicación LLM.

- Personaliza el modelo, si es necesario. Es posible que deba ajustar el modelo o aumentarlo con la base de conocimientos adicional para satisfacer sus necesidades específicas.

- Configure la infraestructura de ML. Esto incluye el hardware y el software necesarios para ejecutar su aplicación (es decir, semiconductores, chips, alojamiento en la nube, inferencia e implementación).

- Aumente su aplicación con herramientas adicionales. Estas herramientas pueden ayudar a mejorar la eficiencia, el rendimiento y la seguridad de su aplicación.

Ahora, echemos un vistazo a la pila de tecnología correspondiente.

Si este contenido educativo en profundidad es útil para usted, suscríbase a nuestra lista de correo de IA ser alertado cuando lancemos nuevo material.

Pila de aplicaciones LLM de alto nivel

Las aplicaciones LLM se basan en varios componentes clave, que incluyen:

- Un modelo de base, que puede requerir personalización en casos de uso específicos.

- Infraestructura de AA de recursos informáticos suficientes a través de plataformas en la nube o hardware propio de la empresa.

- Otras aplicaciones, como canalizaciones de datos, bases de datos vectoriales, herramientas de orquestación, plataformas de ML de ajuste fino, herramientas de supervisión del rendimiento del modelo, etc.

Lo guiaremos brevemente a través de estos componentes para que pueda comprender mejor el conjunto de herramientas necesario para crear e implementar una aplicación LLM.

¿Qué son los modelos de base?

El uso de un único LLM preentrenado puede ahorrarle mucho tiempo y recursos. Sin embargo, capacitar un modelo de este tipo desde cero es un proceso oportuno y costoso que está más allá de las capacidades de la mayoría de las empresas, excepto para una élite de líderes tecnológicos.

Varias empresas y equipos de investigación han entrenado estos modelos y permiten que otras empresas los utilicen. Los principales ejemplos incluyen ChatGPT, Claude, Llama, Jurassic y T5. Estos modelos de cara al público se denominan modelos básicos. Algunos de ellos son propietarios y se puede acceder a ellos a través de llamadas a la API por una tarifa. Otros son de código abierto y se pueden usar de forma gratuita. Estos modelos se entrenan previamente en un conjunto de datos masivo de datos textuales sin etiquetar, lo que les permite realizar una amplia gama de tareas, desde generar copias creativas de anuncios hasta comunicarse con sus clientes en su idioma nativo en nombre de la empresa.

Hay dos tipos principales de modelos básicos: propietarios y de código abierto.

Modelos propietarios son propiedad de una sola empresa u organización y, por lo general, solo están disponibles mediante el pago de una tarifa. Algunos de los ejemplos más populares de modelos propietarios incluyen modelos GPT de OpenAI, modelos Claude de Anthropic y modelos Jurassic de AI21 Labs.

Modelos de código abierto suelen estar disponibles de forma gratuita para cualquiera que quiera utilizarlos. Sin embargo, algunos modelos de código abierto tienen limitaciones en su uso, tales como: (1) solo están disponibles para fines de investigación, (2) solo están disponibles para uso comercial por parte de empresas de cierto tamaño. La comunidad de código abierto afirma que poner tales restricciones no permite que un modelo califique como "código abierto". Aún así, los ejemplos más destacados de modelos de lenguaje que se pueden usar de forma gratuita incluyen los modelos Llama de Meta, los modelos Falcon del Instituto de Innovación Tecnológica en Abu Dhabi y los modelos StableLM de Stability AI. Obtenga más información sobre los modelos de código abierto y los riesgos asociados esta página.

Ahora analicemos varios factores a considerar al elegir un modelo básico para su aplicación LLM.

Elija un modelo de base

Seleccionar el mejor modelo de base para su aplicación LLM puede ser un proceso desafiante, pero básicamente podemos dividirlo en tres pasos:

- Elija entre modelos propietarios y de código abierto. Los modelos patentados suelen ser más grandes y más capaces que los modelos de código abierto, pero pueden ser más costosos de usar y menos flexibles. Además, el código no es tan transparente, lo que dificulta la depuración o la resolución de problemas con el rendimiento de los modelos propietarios. Los modelos de código abierto, por otro lado, generalmente reciben menos actualizaciones y menos soporte de los desarrolladores.

- Elige la talla del modelo. Los modelos más grandes suelen ser mejores para realizar tareas que requieren mucho conocimiento, como responder preguntas o generar texto creativo. Sin embargo, los modelos más grandes también son computacionalmente más costosos de usar. Puede comenzar experimentando con modelos más grandes y luego pasar a modelos más pequeños, siempre que el rendimiento de un modelo sea satisfactorio para su caso de uso.

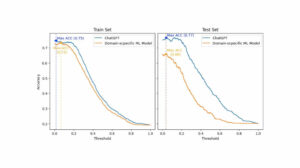

- Seleccione un modelo específico. Puede comenzar revisando los puntos de referencia generales para preseleccionar los modelos para la prueba. Luego, proceda a probar diferentes modelos para las tareas específicas de su aplicación. Para la evaluación comparativa personalizada, considere calcular Puntuaciones BLEU y ROUGE, las métricas que ayudan a cuantificar la cantidad de correcciones que son necesarias para el texto generado por IA antes de publicar el resultado para las aplicaciones human-in-the-loop.

Para comprender mejor las diferencias entre varios modelos de lenguaje, consulte nuestra descripción general del lenguaje más poderoso (LLM) y los modelos de lenguaje visual (VLM).

Una vez que haya elegido un modelo base para su aplicación, puede considerar si necesita personalizar el modelo para un rendimiento aún mejor.

Personalizar un modelo de base

En algunos casos, es posible que desee personalizar un modelo de lenguaje básico para obtener un mejor rendimiento en su caso de uso específico. Por ejemplo, es posible que desee optimizar para un cierto:

- Dominio. Si opera en dominios específicos, como legal, financiero o de atención médica, es posible que desee enriquecer el vocabulario del modelo en este dominio para que pueda comprender y responder mejor a las consultas de los usuarios finales.

- Tarea. Por ejemplo, si desea que el modelo genere campañas de marketing, puede proporcionarle ejemplos específicos de contenido de marketing de marca. Esto ayudará al modelo a aprender los patrones y estilos apropiados para su empresa y audiencia.

- Tono de voz. Si necesita que el modelo use un tono de voz específico, puede personalizar el modelo en un conjunto de datos que incluye ejemplos de sus muestras lingüísticas de destino.

Hay tres formas posibles de personalizar un modelo de lenguaje base:

- Sintonia FINA: proporciona al modelo un conjunto de datos etiquetados de dominio específico de aproximadamente 100-500 registros. Los pesos del modelo se actualizan, lo que debería dar como resultado un mejor rendimiento en las tareas representadas por este conjunto de datos.

- Adaptación de dominio: proporciona al modelo un conjunto de datos sin etiquetar específico del dominio que contiene un gran corpus de datos del dominio correspondiente. Los pesos del modelo también se actualizan en este caso.

- Recuperación de información: aumenta el modelo base con conocimiento de dominio cerrado. El modelo no se vuelve a entrenar y los pesos del modelo siguen siendo los mismos. Sin embargo, el modelo puede recuperar información de una base de datos vectorial que contiene datos relevantes.

Los primeros dos enfoques requieren recursos informáticos significativos para volver a entrenar el modelo, lo que generalmente solo es factible para grandes empresas con el talento técnico adecuado para administrar la personalización. Las empresas más pequeñas suelen utilizar el enfoque más común de aumentar el modelo con conocimiento del dominio a través de una base de datos vectorial, que detallamos más adelante en este artículo en la sección sobre herramientas LLM.

Configurar la infraestructura de ML

El componente de infraestructura de ML del panorama LLMOps incluye las plataformas en la nube, el hardware informático y otros recursos que se necesitan para implementar y ejecutar LLM. Este componente es especialmente relevante si elige usar un modelo de código abierto o personalizar el modelo para su aplicación. En este caso, es posible que necesite importantes recursos informáticos para ajustar el modelo, si es necesario, y ejecutarlo.

Hay una serie de plataformas en la nube que ofrecen servicios para implementar LLM, incluidas Google Cloud Platform, Amazon Web Services y Microsoft Azure. Estas plataformas brindan una serie de características que facilitan la implementación y ejecución de LLM, que incluyen:

- Modelos preentrenados que se pueden ajustar para su aplicación específica

- Infraestructura gestionada que se ocupa del hardware y el software subyacentes

- Herramientas y servicios para monitorear y depurar sus LLM

La cantidad de recursos informáticos que necesita dependerá del tamaño y la complejidad de su modelo, las tareas que desea que realice y la escala de la actividad empresarial en la que desea implementar este modelo.

Aumentar con herramientas

Se pueden usar herramientas adyacentes adicionales de LLM para mejorar aún más el rendimiento de su aplicación LLM.

Canalizaciones de datos

Si necesita usar sus datos en su producto LLM, la canalización de preprocesamiento de datos será un pilar esencial de su nueva pila tecnológica, al igual que en la pila de IA empresarial tradicional. Estas herramientas incluyen conectores para ingerir datos de cualquier fuente, una capa de transformación de datos y conectores descendentes. Los principales proveedores de canalización de datos, como Databricks y Snowflake, y los nuevos jugadores, como Unstructured, facilitan a los desarrolladores señalar corpus grandes y muy heterogéneos de datos en lenguaje natural (por ejemplo, miles de PDF, presentaciones de PowerPoint, registros de chat, HTML extraído, etc.) a un único punto de acceso o incluso a un único documento que puede ser utilizado por las aplicaciones LLM.

Bases de datos vectoriales

Los modelos de idiomas grandes se limitan a procesar unos pocos miles de palabras a la vez, por lo que no pueden procesar documentos grandes de manera efectiva por sí solos. Para aprovechar el poder de los documentos grandes, las empresas necesitan usar bases de datos vectoriales.

Las bases de datos vectoriales son sistemas de almacenamiento que transforman documentos grandes que reciben a través de canalizaciones de datos en vectores manejables o incrustaciones. Las aplicaciones LLM pueden luego consultar estas bases de datos para identificar los vectores correctos, extrayendo solo las pepitas de información necesarias.

Algunas de las bases de datos de vectores más destacadas actualmente disponibles son Pinecone, Chroma y Weaviate.

Herramientas de orquestación

Cuando un usuario envía una consulta a su aplicación LLM, como una pregunta para el servicio al cliente, la aplicación debe generar una serie de indicaciones antes de enviar esta consulta al modelo de lenguaje. La solicitud final al modelo de lenguaje generalmente se compone de una plantilla de solicitud codificada por el desarrollador, ejemplos de resultados válidos llamados ejemplos de pocas tomas, cualquier información necesaria recuperada de API externas y un conjunto de documentos relevantes recuperados de la base de datos vectorial. . Las herramientas de orquestación de empresas como LangChain o LlamaIndex pueden ayudar a agilizar este proceso al proporcionar marcos listos para usar para administrar y ejecutar avisos.

Sintonia FINA

Los modelos de lenguaje grandes entrenados en conjuntos de datos masivos pueden producir texto gramaticalmente correcto y fluido. Sin embargo, pueden carecer de precisión en ciertas áreas, como la medicina o el derecho. Ajustar estos modelos en conjuntos de datos específicos de dominio les permite internalizar las características únicas de esas áreas, mejorando su capacidad para generar texto relevante.

Ajustar un LLM puede ser un proceso costoso para las pequeñas empresas. Sin embargo, las soluciones de empresas como Weights & Biases y OctoML pueden ayudar con un ajuste fino optimizado y eficiente. Estas soluciones brindan una plataforma para que las empresas ajusten los LLM sin tener que invertir en su propia infraestructura.

Otras herramientas

Hay muchas otras herramientas que pueden ser útiles para crear y ejecutar aplicaciones LLM. Por ejemplo, es posible que necesite herramientas de etiquetado si desea ajustar el modelo con sus muestras de datos específicas. También es posible que desee implementar herramientas específicas para monitorear el rendimiento de su aplicación, ya que incluso los cambios menores en el modelo básico o las solicitudes de los clientes pueden afectar significativamente el rendimiento de las solicitudes. Finalmente, existen herramientas que monitorean la seguridad del modelo para ayudarlo a evitar la promoción de contenido odioso, recomendaciones peligrosas o sesgos. La necesidad y la importancia de estas diferentes herramientas dependerán de su caso de uso específico.

¿Qué sigue en el desarrollo de aplicaciones LLM?

Los cuatro pasos para el desarrollo de productos LLM que discutimos aquí son una base esencial de la estrategia de IA generativa de cualquier empresa que aprovecha modelos de lenguaje grandes. Es importante que los líderes empresariales no técnicos los entiendan, incluso si tiene un equipo técnico que implementa los detalles. Publicaremos tutoriales más detallados en el futuro sobre cómo aprovechar la amplia gama de herramientas de IA generativa en el mercado. Por ahora, puedes suscribirse a nuestro boletín para obtener las últimas actualizaciones.

¿Disfrutas de este artículo? Regístrese para obtener más actualizaciones de IA empresarial.

Le informaremos cuando publiquemos más artículos de resumen como este.

Relacionado:

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Automoción / vehículos eléctricos, Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- Desplazamientos de bloque. Modernización de la propiedad de compensaciones ambientales. Accede Aquí.

- Fuente: https://www.topbots.com/llm-product-development-technology-stack/

- :es

- :no

- :dónde

- $ UP

- 1

- a

- capacidad

- Nuestra Empresa

- abu dhabi

- de la máquina

- visitada

- actividad

- Ad

- Adicionales

- Adicionalmente

- adyacente

- AI

- Estrategia de IA

- permitir

- permitido

- permite

- también

- Amazon

- Amazon Web Services

- cantidad

- an

- analizar

- y

- Otra

- Antrópico

- cualquier

- nadie

- abejas

- API

- Aplicación

- Desarrollo de aplicaciones

- aplicaciones

- enfoque

- enfoques

- adecuado

- somos

- áreas

- artículo

- AS

- asociado

- At

- las ventas

- Hoy Disponibles

- evitar

- Azure

- bases

- Básicamente

- BE

- esto

- antes

- favor

- "Ser"

- evaluación comparativa

- los puntos de referencia

- MEJOR

- mejores

- entre

- Más allá de

- los prejuicios

- empujón

- Box

- marca

- calificada

- Descanso

- brevemente

- Roto

- build

- Construir la

- construido

- Aplicaciones empresariales

- Líderes del negocio

- negocios

- pero

- by

- el cálculo de

- , que son

- Calls

- Campañas

- PUEDEN

- capacidades

- capaz

- servicios sociales

- case

- cases

- a ciertos

- desafiante

- cambiado

- Cambios

- chatterbot

- ChatGPT

- comprobar

- Papas fritas

- Elige

- la elección de

- elegido

- reclamaciones

- Soluciones

- cloud Hosting

- Plataforma en la nube

- código

- completo

- Algunos

- comunicado

- vibrante e inclusiva

- Empresas

- compañía

- De la empresa

- complejidad

- componente

- componentes

- compuesto

- informática

- Desventajas

- Considerar

- construir

- contiene

- contenido

- conversaciones

- copias

- Esquina

- correcta

- correcciones

- Correspondiente

- costoso

- Estudio

- En la actualidad

- personalizado

- cliente

- Servicio al Cliente

- Atención al cliente

- Clientes

- personalización

- personalizan

- peligroso

- datos

- Base de datos

- bases de datos

- Databricks

- conjuntos de datos

- más profundo

- definir

- Dependiente

- desplegar

- Desplegando

- despliegue

- detalle

- detallado

- detalles

- desarrollar

- Developer

- desarrolladores

- el desarrollo

- Desarrollo

- Dhabi

- diferencias

- una experiencia diferente

- difícil

- discutir

- discutido

- documento

- documentos

- No

- dominio

- dominios

- DE INSCRIPCIÓN

- e

- cada una

- de forma sencilla

- educativo

- de manera eficaz

- eficiencia

- eficiente

- élite

- permitiendo

- mejorar

- mejorar

- enriquecer

- Empresa

- especialmente

- esencial

- etc.

- Éter (ETH)

- Incluso

- Cada

- ejemplo

- ejemplos

- Excepto

- ejecución

- ejecutivos.

- costoso

- externo

- factores importantes

- halcón

- factible

- Caracteristicas

- cuota

- pocos

- menos

- final

- Finalmente

- financiero

- Nombre

- flexible

- Fundación

- Digital XNUMXk

- marcos

- Gratuito

- Desde

- promover

- futuras

- General

- generar

- la generación de

- generación de AHSS

- generativo

- IA generativa

- obtener

- Donar

- globo

- Go

- va

- Google Cloud

- Google Cloud Platform

- Polo a Tierra

- mano

- Materiales

- aprovechar

- Tienen

- es

- la salud

- ayuda

- esta página

- de alto nivel

- altamente

- hosting

- Cómo

- Como Hacer

- Sin embargo

- HTML

- HTTPS

- i

- if

- Impacto

- implementación

- importancia

- importante

- mejorar

- in

- a fondo

- incluir

- incluye

- Incluye

- energético

- información

- EN LA MINA

- Innovation

- Innovadora

- integrar

- dentro

- Introducción

- Invertir

- IT

- jpg

- solo

- Clave

- Tipo

- Saber

- especialistas

- etiquetado

- labs

- Falta

- paisaje

- idioma

- large

- mayores

- luego

- más reciente

- Las últimas novedades

- de derecho criminal

- .

- los líderes

- líder

- APRENDE:

- aprendizaje

- Legal

- menos

- Apalancamiento

- apalancamientos

- como

- limitaciones

- Limitada

- Llama

- Largo

- Mira

- Lote

- máquina

- máquina de aprendizaje

- Inicio

- para lograr

- HACE

- gestionan

- administrar

- muchos

- Mercado

- encuestas de mercado

- Marketing

- Campañas de mercadeo

- mercado

- masivo

- materiales

- max-ancho

- Puede..

- sentido

- medicina

- Conoce a

- Meta

- Métrica

- Microsoft

- microsoft Azure

- podría

- menor de edad

- ML

- modelo

- modelos

- Monitorear

- monitoreo

- más,

- MEJOR DE TU

- Más popular

- nativo

- Natural

- Lenguaje natural

- necesario

- ¿ Necesita ayuda

- negativas

- Neutro

- Nuevo

- Nueva tecnología

- Newsletter

- Next

- no técnico

- ahora

- número

- of

- LANZAMIENTO

- on

- ONE

- las

- , solamente

- de código abierto

- OpenAI

- funcionar

- Optimización

- or

- orquestación

- organización

- Otro

- Otros

- nuestros

- salir

- salida

- visión de conjunto

- EL DESARROLLADOR

- propiedad

- .

- realizar

- actuación

- realizar

- Pillar

- industrial

- plataforma

- Plataformas

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- players

- punto

- Popular

- positivo

- posible

- industria

- poderoso

- Precisión

- Presentations

- problemas

- tratamiento

- producir

- Producto

- desarrollo de productos

- destacado

- Promoción

- propietario

- PROS

- proporcionar

- los proveedores

- proporciona un

- proporcionando

- publicar

- fines

- Poniendo

- calificar

- calidad

- consultas

- pregunta

- Preguntas

- distancia

- Leer

- recepción

- recomendaciones

- archivos

- ,

- la liberación de

- confianza

- representado

- solicita

- solicitudes

- exigir

- requiere

- la investigación

- Recursos

- Responder

- restricciones

- resultado

- la revisión

- Reseñas

- Derecho

- riesgos

- Ejecutar

- correr

- Safety

- mismo

- Guardar

- Escala

- Sección

- EN LINEA

- Semiconductores

- sentimiento

- separado

- Serie

- de coches

- Servicios

- set

- Varios

- tienes

- firmar

- importante

- significativamente

- soltero

- Tamaño

- chica

- menores

- So

- Software

- Soluciones

- algo

- Fuente

- soluciones y

- Estabilidad

- montón

- comienzo

- quedarse

- pasos

- Sin embargo

- STORAGE

- Estrategia

- aerodinamizar

- racionalizado

- estilos

- tal

- suficiente

- RESUMEN

- SOPORTE

- Todas las funciones a su disposición

- ¡Prepárate!

- toma

- Talent

- Target

- Tarea

- tareas

- equipo

- equipos

- tecnología

- Técnico

- soporte técnico

- Tecnología

- innovación tecnológica

- plantilla

- Pruebas

- que

- esa

- La

- El futuro de las

- su

- Les

- luego

- Ahí.

- Estas

- ellos

- así

- aquellos

- miles

- Tres

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- equipo

- prolongado

- a

- TONO

- El tono de voz

- caja de herramientas

- parte superior

- TOPBOTS

- tradicional

- Entrenar

- entrenado

- Formación

- Transformar

- transparente

- Tutoriales

- dos

- tipos

- típicamente

- subyacente

- entender

- comprensión

- único

- características unicas

- actualizado

- Actualizaciones

- utilizan el

- caso de uso

- usado

- Usuario

- generalmente

- diversos

- vía

- Voz

- vs

- quieres

- deseado

- quiere

- formas

- we

- web

- servicios web

- WELL

- tuvieron

- cuando

- sean

- que

- QUIENES

- amplio

- Amplia gama

- seguirá

- sin

- palabras

- Actividades:

- se

- Usted

- tú

- zephyrnet