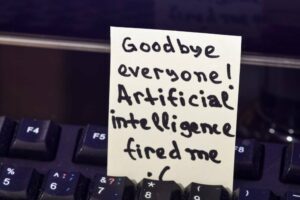

Meta ha lanzado otro tipo de modelo de aprendizaje automático abierto, esta vez optimizado para generar código fuente de software.

Código Llama es una familia de grandes modelos de lenguaje (de ahí la ocasional utilización de mayúsculas “LLaMA”), basada en el modelo Llama 2 liberado en julio. Ha sido afinado y entrenado para distribuir y discutir el código fuente en respuesta a indicaciones de texto, en lugar de prosa como su progenitor.

Como ocurre con toda la tecnología de vanguardia, Code Llama conlleva riesgos

"Code Llama tiene el potencial de usarse como una herramienta educativa y de productividad para ayudar a los programadores a escribir software más sólido y bien documentado", afirmó Meta en un anuncio Jueves.

Si le pides a Code Llama que escriba una función que produzca la secuencia de Fibonacci, el modelo generará código y lenguaje natural que explique la fuente, dice Meta. Y el modelo de IA puede hacerlo en Python, C++, Java, PHP, Typescript (Javascript), C#, Bash y otros lenguajes.

Sin embargo, se indica a los usuarios que se dirijan a Code Llama en inglés, ya que el modelo no ha sido sometido a pruebas de seguridad en otros idiomas y podría decir algo horrible si se les pregunta en un fuera del ámbito idioma.

"Como ocurre con toda la tecnología de vanguardia, Code Llama conlleva riesgos", explica Meta, señalando que durante las pruebas de su propio equipo rojo para solicitar la creación de código malicioso, Code Llama respondió con respuestas más seguras que ChatGPT (GPT3.5 Turbo).

Según Meta, Code Llama supera a los LLM de código abierto y específicos y a su propio padre Llama 2 en dos puntos de referencia: evaluación humana y programación Python principalmente básica (MBPP) – y coincide con el rendimiento de ChatGPT de OpenAI.

Code Llama viene en tres tamaños (parámetros 7B, 13B y 34B) y cada variante fue entrenada con 500 mil millones de tokens de código y datos relacionados con el código. Un token tiene aproximadamente cuatro caracteres en inglés. La versión más grande del Codex de OpenAI, cuando se lanzó, tenía Parámetros 12B.

Los dos modelos más pequeños de Code Llama, dice Meta, han sido entrenados para completar la fuente faltante, lo que permite usarlos para completar el código sin realizar más ajustes. Se dice que la versión 34B proporciona los mejores resultados, pero las dos más pequeñas responden más rápido, lo que las hace mejores para tareas como completar código donde la latencia es notable.

También hay dos variantes: Code Llama – Python y Code Llama – Instruct. El primero proviene del ajuste fino de Code Llama con 100 mil millones de tokens adicionales de código Python. Este último se ha ajustado para cumplir con los patrones de entrada y salida, lo que lo hace más adecuado para la generación de código.

Fiabilidad, ¿alguien?

Los LLM a menudo proporcionan incorrecto respuestas a indicaciones de programación, aunque muchos desarrolladores los utilizan para recordar patrones de memoria y parámetros API, o evitar consultas de búsqueda y comprobaciones de documentación.

Uno de los puntos de venta de Code Llama es que puede manejar la entrada y salida de secuencias de código que constan de hasta 100,000 tokens. Es decir, puede solicitar al modelo muchas líneas de código y obtener una respuesta detallada.

"Además de ser un requisito previo para generar programas más largos, tener secuencias de entrada más largas abre nuevos e interesantes casos de uso para un LLM de código", explicó Meta. “Por ejemplo, los usuarios pueden proporcionar al modelo más contexto desde su código base para que las generaciones sean más relevantes. También ayuda en escenarios de depuración en bases de código más grandes, donde estar al tanto de todo el código relacionado con un problema concreto puede ser un desafío para los desarrolladores”.

Los usuarios pueden proporcionar al modelo más contexto desde su código base para que las generaciones sean más relevantes.

Code Llama se une a un campo creciente de modelos relacionados con el código inicialmente sembrados por el Codex de OpenAI y los asociados de GitHub. gravado por litigios Servicio de sugerencias de programación Copilot (2021). Los modelos de programación positiva que siguieron incluyen el de DeepMind. código alfa (2022), GPT-4 de OpenAI (2023), Amazon Susurrador de códigos (2023) y Bard de Google (2023), sintonizados en abril para generar código fuente.

Además, ha habido varios LLM de código abierto (o algo así como abiertos) como codificador estrella y XGen, por nombrar dos.

Meta ha lanzado Code Llama bajo el mismo licencia comunitaria como Llama 2, citando la creencia de la megacorporación en “un enfoque abierto hacia la IA” como la mejor manera de desarrollar herramientas que sean innovadoras, seguras y responsables.

Pero como se observó ampliamente con Llama 2, la licencia comunitaria es no es una licencia de código abierto. El "enfoque abierto" de Meta hacia la IA está cerrado a la competencia: la licencia prohíbe explícitamente el uso del software "para mejorar cualquier otro modelo de lenguaje grande".

Y si bien la licencia comunitaria de Meta permite el uso comercial de sus diversas llamas, marca la línea en servicios con "más de 700 millones de usuarios activos mensuales".

Eso más bien selecciona grupo de megaservicios (YouTube, WeChat, TikTok, LinkedIn, Telegram, Snapchat y Douyin, entre plataformas de redes sociales que aún no están administradas por Meta, y presumiblemente compañías que ejecutan plataformas basadas en sistemas operativos como Apple, Google y Microsoft) “deben solicitar una licencia de Meta, que Meta puede otorgarle a su exclusivo criterio…” ®

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Automoción / vehículos eléctricos, Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- ChartPrime. Eleve su juego comercial con ChartPrime. Accede Aquí.

- Desplazamientos de bloque. Modernización de la propiedad de compensaciones ambientales. Accede Aquí.

- Fuente: https://go.theregister.com/feed/www.theregister.com/2023/08/25/meta_lets_code_llama_run/

- :posee

- :es

- :no

- :dónde

- $ UP

- 000

- 100

- 2021

- 2022

- 2023

- 700

- a

- lector activo

- adición

- dirección

- adherirse

- AI

- Todos

- permite

- ya haya utilizado

- también

- Amazon

- entre

- an

- y

- Otra

- respuestas

- cualquier

- nadie

- abejas

- Apple

- enfoque

- Abril

- somos

- AS

- asociado

- At

- evitar

- basado

- golpear

- básica

- BE

- esto

- "Ser"

- creencia

- los puntos de referencia

- MEJOR

- mejores

- ambas

- pero

- by

- C + +

- PUEDEN

- capitalización

- cases

- desafiante

- personajes

- ChatGPT

- Cheques

- afirmó

- cerrado

- CO

- código

- Base de código

- proviene

- completo

- vibrante e inclusiva

- Empresas

- competencia

- terminación

- contexto

- creación

- corte

- datos

- Mente profunda

- desarrollar

- desarrolladores

- HIZO

- discutir

- do

- documentación

- douyin

- dibujos

- durante

- cada una

- Southern Implants

- educativo

- Inglés

- Éter (ETH)

- ejemplo

- emocionante

- explicado

- explicando

- Explica

- extra

- familia

- más rápida

- FB

- Fibonacci

- campo

- llenar

- en fin

- seguido

- Ex

- Digital XNUMXk

- Desde

- función

- promover

- generar

- la generación de

- generación de AHSS

- generaciones

- obtener

- GitHub

- conceder

- mayor

- Creciendo

- tenido

- encargarse de

- Tienen

- es

- ayuda

- ayuda

- por lo tanto

- Sin embargo

- HTTPS

- if

- mejorar

- in

- En otra

- incluir

- posiblemente

- originales

- Las opciones de entrada

- IT

- SUS

- Java

- JavaScript

- Une

- jpg

- Julio

- solo

- idioma

- Idiomas

- large

- mayores

- mayor

- Estado latente

- aprendizaje

- Permíteme

- Licencia

- como

- línea

- líneas

- Etiqueta LinkedIn

- Llama

- por más tiempo

- máquina

- máquina de aprendizaje

- para lograr

- Realizar

- muchos

- Puede..

- Medios

- Meta

- Microsoft

- podría

- millones

- que falta

- modelo

- modelos

- mensual

- más,

- cuales son las que reflejan

- debe

- nombre

- Natural

- Lenguaje natural

- Nuevo

- señaló

- señalando

- ocasional

- of

- a menudo

- on

- ONE

- habiertos

- de código abierto

- OpenAI

- funcionamiento

- or

- Otro

- Supera

- salida

- EL DESARROLLADOR

- parámetros

- .

- actuación

- PHP

- Plataformas

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- puntos

- posible

- produce

- productividad

- progenitor

- Programador

- Programación

- Programas

- proporcionar

- poner

- Python

- consultas

- más bien

- RE

- Rojo

- relacionado

- liberado

- solicita

- Responder

- respuesta

- responsable

- Resultados

- Alboroto

- riesgos

- robusto

- aproximadamente

- Ejecutar

- correr

- s

- ambiente seguro

- Safer

- Safety

- Said

- mismo

- dices

- dice

- escenarios

- Buscar

- vender

- Secuencia

- de coches

- Servicios

- tamaños

- menores

- snapchat

- So

- Social

- redes sociales

- plataformas de redes sociales

- Software

- algo

- Fuente

- código fuente

- T

- tareas

- equipo

- Tecnología

- Telegram

- términos

- Pruebas

- que

- esa

- La

- La Fuente

- su

- Les

- Ahí.

- ellos

- así

- ¿aunque?

- Tres

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- jueves

- TikTok

- equipo

- a

- ficha

- Tokens

- del IRS

- parte superior

- entrenado

- dos

- Mecanografiado

- bajo

- desbloquea

- utilizan el

- usado

- usuarios

- usando

- Variante

- diversos

- versión

- fue

- Camino..

- cuando

- que

- mientras

- extensamente

- Wikipedia

- seguirá

- sin

- escribir

- aún

- Usted

- Youtube

- zephyrnet