La velocidad de rendimiento de la memoria y la baja latencia son fundamentales a medida que la inferencia pasa del centro de datos al borde de la red.

AI/ML está evolucionando a un ritmo vertiginoso. No pasa una semana sin algunos desarrollos nuevos y emocionantes en el campo, y aplicaciones como ChatGPT han puesto las capacidades de IA generativa firmemente en el primer plano de la atención del público.

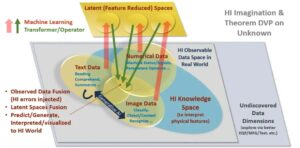

AI/ML son en realidad dos aplicaciones: entrenamiento e inferencia. Cada uno depende del rendimiento de la memoria y cada uno tiene un conjunto único de requisitos que impulsan la elección de la mejor solución de memoria.

Con capacitación, el ancho de banda y la capacidad de la memoria son requisitos críticos. Esto es particularmente cierto dado el tamaño y la complejidad de los modelos de datos de redes neuronales que han crecido a un ritmo diez veces mayor por año. La precisión de la red neuronal depende de la calidad y cantidad de ejemplos en el conjunto de datos de entrenamiento, lo que se traduce en la necesidad de enormes cantidades de datos y, por lo tanto, de ancho de banda y capacidad de memoria.

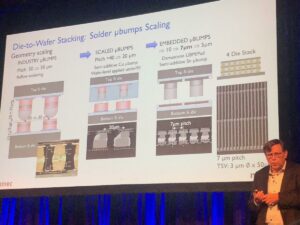

Dado el valor creado a través de la capacitación, existe un poderoso incentivo para completar las ejecuciones de capacitación lo más rápido posible. A medida que las aplicaciones de capacitación se ejecutan en centros de datos cada vez más limitados en cuanto a energía y espacio, se prefieren las soluciones que ofrecen eficiencia energética y un tamaño más pequeño. Teniendo en cuenta todos estos requisitos, HBM3 es una solución de memoria ideal para hardware de entrenamiento de IA. Proporciona excelentes capacidades de ancho de banda y capacidad.

El resultado del entrenamiento de redes neuronales es un modelo de inferencia que se puede implementar ampliamente. Con este modelo, un dispositivo de inferencia puede procesar e interpretar entradas fuera de los límites de los datos de entrenamiento. Por inferencia, la velocidad de rendimiento de la memoria y la baja latencia son fundamentales, especialmente cuando se necesita acción en tiempo real. Dado que cada vez más inferencias de IA se desplazan desde el corazón del centro de datos al borde de la red, estas características de la memoria se están volviendo aún más críticas.

Los diseñadores tienen varias opciones de memoria para la inferencia de IA/ML, pero en el parámetro crítico del ancho de banda, la memoria GDDR6 realmente brilla. Con una velocidad de datos de 24 Gigabits por segundo (Gb/s) y una interfaz de 32 bits de ancho, un dispositivo GDDR6 puede ofrecer 96 Gigabytes por segundo (GB/s) de ancho de banda de memoria, más del doble que cualquier DDR o alternativa. Soluciones LPDDR. La memoria GDDR6 ofrece una excelente combinación de velocidad, ancho de banda y rendimiento de latencia para la inferencia de IA/ML, en particular para la inferencia en el borde.

El subsistema de interfaz de memoria Rambus GDDR6 ofrece un rendimiento de 24 Gb/s y está construido sobre una base de más de 30 años de experiencia en integridad de señal de alta velocidad e integridad de energía (SI/PI), fundamentales para operar GDDR6 a altas velocidades. Consta de una PHY y un controlador digital, lo que proporciona un subsistema de interfaz de memoria GDDR6 completo.

Únase a mí en el seminario web de Rambus este mes sobre "Inferencia AI/ML de alto rendimiento con memoria GDDR24 de 6G”para descubrir cómo GDDR6 admite los requisitos de memoria y rendimiento de las cargas de trabajo de inferencia AI/ML y conocer algunas de las consideraciones clave de diseño e implementación de los subsistemas de interfaz de memoria GDDR6.

Fuentes:

franco ferro

(todos los mensajes)

Frank Ferro es director sénior de marketing de productos para núcleos IP en Rambus.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoAiStream. Inteligencia de datos Web3. Conocimiento amplificado. Accede Aquí.

- Acuñando el futuro con Adryenn Ashley. Accede Aquí.

- Compra y Vende Acciones en Empresas PRE-IPO con PREIPO®. Accede Aquí.

- Fuente: https://semiengineering.com/gddr6-delivers-the-performance-for-ai-ml-inference/

- :posee

- :es

- :no

- 24

- 26

- 27

- 30

- 8

- a

- Nuestra Empresa

- la exactitud

- la columna Acción

- AI

- Entrenamiento de IA

- AI / ML

- Todos

- Todos los Artículos

- alternativa

- cantidades

- an

- y

- cualquier

- aplicaciones

- somos

- AS

- At

- Ancho de banda

- BE

- cada vez

- esto

- MEJOR

- en general

- Traído

- construido

- pero

- by

- PUEDEN

- capacidades

- Capacidad

- Reubicación

- Centros

- ChatGPT

- manera?

- opciones

- combinación

- completar

- complejidad

- consideraciones

- controlador

- creado

- crítico

- datos

- Data Center

- los centros de datos

- conjunto de datos

- entregamos

- entrega

- depende

- desplegado

- Diseño

- desarrollos

- dispositivo

- digital

- Director

- descrubrir

- doble

- el lado de la transmisión

- cada una

- Southern Implants

- eficiencia

- enorme

- especialmente

- Incluso

- evolución

- ejemplos

- excelente,

- emocionante

- Experiencia

- Caracteristicas

- campo

- firmemente

- primer plano

- Fundación

- Desde

- generativo

- IA generativa

- dado

- Va

- maravillosa

- Creciendo

- Materiales

- Tienen

- Corazón

- por lo tanto

- Alta

- Cómo

- HTTPS

- ideal

- implementación

- in

- Compensación

- cada vez más

- entradas

- integridad

- Interfaz

- dentro

- IP

- IT

- jpg

- Clave

- Estado latente

- APRENDE:

- relámpago

- como

- Baja

- Marketing

- Salud Cerebral

- modelo

- modelos

- Mes

- más,

- necesidad

- del sistema,

- Datos de red

- Neural

- red neural

- Nuevo

- ahora

- número

- of

- LANZAMIENTO

- Ofertas

- on

- funcionamiento

- or

- salida

- afuera

- Más de

- Paz

- parámetro

- particular

- particularmente

- actuación

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- popularidad

- posible

- Artículos

- industria

- poderoso

- Producto

- proporciona un

- proporcionando

- público

- calidad

- la cantidad

- con rapidez

- Rate

- en tiempo real

- realmente

- Requisitos

- Derecho

- FILA

- Ejecutar

- Segundo

- mayor

- set

- CAMBIANDO

- Turnos

- Signal

- Tamaño

- menores

- So

- a medida

- Soluciones

- algo

- Espacio

- velocidad

- velocidades

- soportes

- que

- esa

- La

- Ahí.

- Estas

- así

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- rendimiento

- uña del pulgar

- a

- Formación

- dos

- único

- propuesta de

- Webinar

- semana

- cuando

- que

- amplio

- sin

- año

- años

- zephyrnet