Contenido patrocinado

ChatGPT y herramientas similares basadas en modelos de lenguaje grandes (LLM) son increíbles. Pero no son herramientas para todo uso.

Es como elegir otras herramientas para construir y crear. Debe elegir el adecuado para el trabajo. No intentarías apretar un perno con un martillo ni darle la vuelta a una hamburguesa con un batidor. El proceso sería incómodo y resultaría en un fracaso estrepitoso.

Los modelos de lenguaje como los LLM constituyen solo una parte del conjunto de herramientas de aprendizaje automático más amplio, que abarca tanto la IA generativa como la IA predictiva. Seleccionar el tipo correcto de modelo de aprendizaje automático es crucial para alinearse con los requisitos de su tarea.

Profundicemos en por qué los LLM son más adecuados para ayudarle a redactar un texto o generar ideas para regalos que para abordar las tareas de modelado predictivo más críticas de su empresa. Todavía existe un papel vital para los modelos “tradicionales” de aprendizaje automático que precedieron a los LLM y que han demostrado repetidamente su valor en las empresas. También exploraremos un enfoque pionero para utilizar estas herramientas juntas, un desarrollo emocionante que en Pecan llamamos GenIA predictiva.

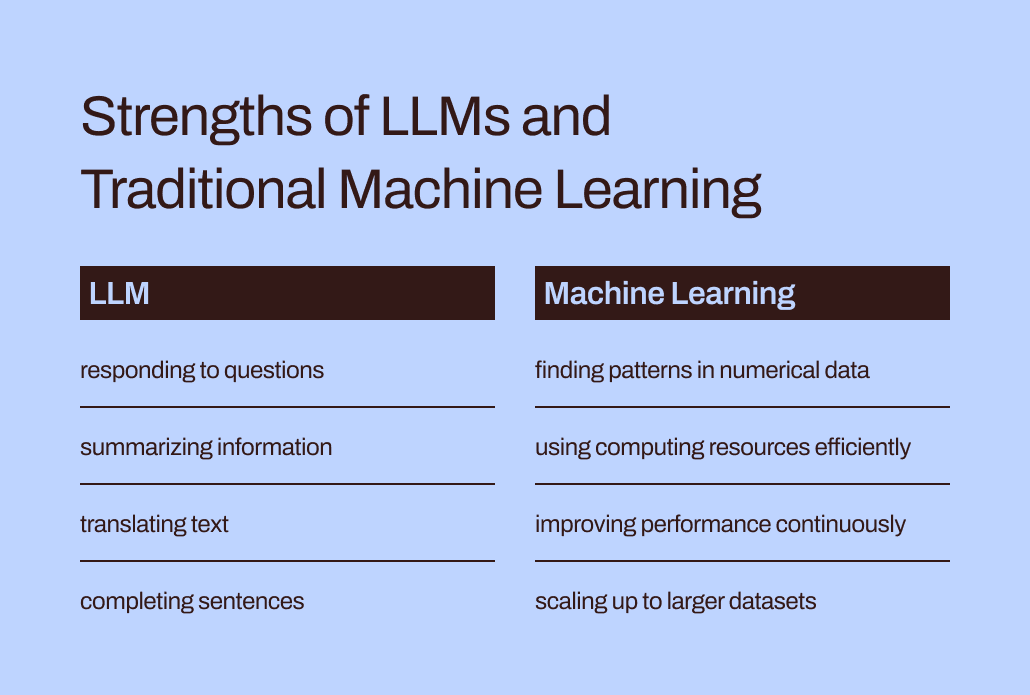

Los LLM están diseñados para palabras, no para números

En el aprendizaje automático, se utilizan diferentes métodos matemáticos para analizar lo que se conoce como “datos de entrenamiento”, un conjunto de datos inicial que representa el problema que un analista o científico de datos espera resolver.

No se puede subestimar la importancia de los datos de entrenamiento. Contiene los patrones y relaciones que un modelo de aprendizaje automático “aprenderá” a predecir resultados cuando luego se le proporcionen datos nuevos e invisibles.

Entonces, ¿qué es específicamente un LLM? Los modelos de lenguaje grandes, o LLM, se incluyen en el ámbito del aprendizaje automático. Se originan a partir del aprendizaje profundo y su estructura está desarrollada específicamente para el procesamiento del lenguaje natural.

Se podría decir que están construidos sobre una base de palabras. Su objetivo es simplemente predecir qué palabra será la siguiente en una secuencia de palabras. Por ejemplo, la función de autocorrección de los iPhone en iOS 17 ahora utiliza un LLM para predecir mejor qué palabra probablemente intentará escribir a continuación.

Ahora, imagina que eres un modelo de aprendizaje automático. (Ten paciencia con nosotros, sabemos que es exagerado). Te han entrenado para predecir palabras. Ha leído y estudiado millones de palabras de una amplia gama de fuentes sobre todo tipo de temas. Tus mentores (también conocidos como desarrolladores) te han ayudado a aprender las mejores formas de predecir palabras y crear texto nuevo que se ajuste a la solicitud de un usuario.

Pero aquí hay un giro. Un usuario ahora le proporciona una hoja de cálculo masiva de datos de clientes y transacciones, con millones de filas de números, y le pide que prediga números relacionados con estos datos existentes.

¿Cómo crees que resultarían tus predicciones? En primer lugar, probablemente le molestará que esta tarea no coincida con lo que tanto le costó aprender. (Afortunadamente, hasta donde sabemos, los LLM aún no tienen sentimientos). Más importante aún, se le pide que realice una tarea que no coincide con lo que ha aprendido a hacer. Y probablemente no lo harás tan bien.

La brecha entre la capacitación y la tarea ayuda a explicar por qué los LLM no son adecuados para tareas predictivas que involucran datos numéricos y tabulares, el formato de datos principal que recopilan la mayoría de las empresas. En cambio, un modelo de aprendizaje automático diseñado y ajustado específicamente para manejar este tipo de datos es más efectivo. Literalmente ha sido entrenado para esto.

Los desafíos de eficiencia y optimización de los LLM

Además de adaptarse mejor a los datos numéricos, los métodos tradicionales de aprendizaje automático son mucho más eficientes y fáciles de optimizar para obtener un mejor rendimiento que los LLM.

Volvamos a su experiencia al hacerse pasar por un LLM. Leer todas esas palabras y estudiar su estilo y secuencia suena como mucho trabajo, ¿verdad? Se necesitaría mucho esfuerzo para internalizar toda esa información.

De manera similar, la compleja formación de los LLM puede dar como resultado modelos con miles de millones de parámetros. Esa complejidad permite que estos modelos comprendan y respondan a los complicados matices del lenguaje humano. Sin embargo, la formación intensa conlleva exigencias computacionales intensas cuando los LLM generan respuestas. Los algoritmos de aprendizaje automático “tradicionales” orientados numéricamente, como los árboles de decisión o las redes neuronales, probablemente necesitarán muchos menos recursos informáticos. Y este no es un caso de "cuanto más grande, mejor". Incluso si los LLM pudieran manejar datos numéricos, esta diferencia significaría que los métodos tradicionales de aprendizaje automático seguirían siendo más rápidos, más eficientes, más sostenibles ambientalmente y más rentables.

Además, ¿alguna vez le has preguntado a ChatGPT cómo supo dar una respuesta particular? Su respuesta probablemente será un poco vaga:

Genero respuestas basadas en una combinación de datos autorizados, datos creados por entrenadores humanos y datos disponibles públicamente. Mi formación también involucró conjuntos de datos a gran escala obtenidos de una variedad de fuentes, incluidos libros, sitios web y otros textos, para desarrollar una comprensión amplia del lenguaje humano. El proceso de capacitación implica ejecutar cálculos en miles de GPU durante semanas o meses, pero los detalles y escalas de tiempo exactos son propiedad de OpenAI.

¿Cuánto del “conocimiento” reflejado en esa respuesta provino de los capacitadores humanos versus los datos públicos versus los libros? Incluso el propio ChatGPT no está seguro: "Se desconocen las proporciones relativas de estas fuentes y no tengo una visibilidad detallada de qué documentos específicos formaron parte de mi conjunto de capacitación".

Es un poco desconcertante que ChatGPT proporcione respuestas tan seguras a sus preguntas pero no pueda rastrear sus respuestas hasta fuentes específicas. La interpretabilidad y explicabilidad limitadas de los LLM también plantean desafíos a la hora de optimizarlos para necesidades comerciales particulares. Puede resultar difícil comprender el fundamento de su información o predicciones. Para complicar aún más las cosas, ciertas empresas enfrentan exigencias regulatorias que significan que deben poder explicar los factores que influyen en las predicciones de un modelo. En general, estos desafíos muestran que los modelos tradicionales de aprendizaje automático (generalmente más interpretables y explicables) probablemente sean más adecuados para casos de uso empresarial.

El lugar adecuado para los LLM en el conjunto de herramientas predictivas de las empresas

Entonces, ¿deberíamos dejar a los LLM con sus tareas relacionadas con palabras y olvidarnos de ellos para los casos de uso predictivos? Ahora podría parecer que, después de todo, no pueden ayudar a predecir la pérdida de clientes o el valor de vida del cliente.

Aquí está la cuestión: si bien decir "modelos tradicionales de aprendizaje automático" hace que esas técnicas parezcan ampliamente entendidas y fáciles de usar, sabemos por nuestra experiencia en Pecan que las empresas todavía tienen dificultades para adoptar incluso estas formas más familiares de IA.

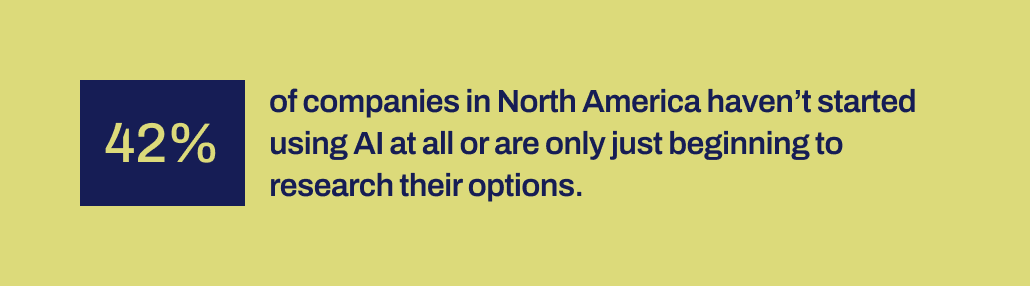

Una investigación reciente de Workday revela que el 42% de las empresas en América del Norte no han iniciado el uso de la IA o se encuentran apenas en las primeras etapas de exploración de sus opciones. Y ha pasado más de una década desde que las herramientas de aprendizaje automático se volvieron más accesibles para las empresas. Han tenido tiempo y hay varias herramientas disponibles.

Por alguna razón, las implementaciones exitosas de IA han sido sorprendentemente raras a pesar del gran revuelo en torno a la ciencia de datos y la IA, y su reconocido potencial para un impacto empresarial significativo. Falta algún mecanismo importante para ayudar a cerrar la brecha entre las promesas hechas por la IA y la capacidad de implementarla de manera productiva.

Y ahí es precisamente donde creemos que los LLM pueden desempeñar ahora un papel vital de enlace. Los LLM pueden ayudar a los usuarios empresariales a cruzar el abismo entre identificar un problema empresarial para resolver y desarrollar un modelo predictivo.

Con los LLM ahora en escena, los equipos de negocios y de datos que no tienen la capacidad o la capacidad para codificar manualmente modelos de aprendizaje automático ahora pueden traducir mejor sus necesidades en modelos. Pueden “usar sus palabras”, como les gusta decir a los padres, para iniciar el proceso de modelado.

Fusionar LLM con técnicas de aprendizaje automático diseñadas para sobresalir en datos comerciales

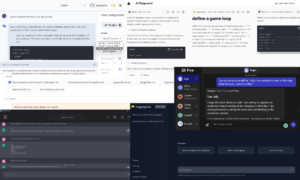

Esa capacidad ahora ha llegado a Predictive GenAI de Pecan, que está fusionando las fortalezas de los LLM con nuestra plataforma de aprendizaje automático ya altamente refinada y automatizada. Nuestro chat predictivo basado en LLM recopila información de un usuario empresarial para guiar la definición y el desarrollo de una pregunta predictiva: el problema específico que el usuario desea resolver con un modelo.

Luego, utilizando GenAI, nuestra plataforma genera un Cuaderno Predictivo para facilitar aún más el siguiente paso hacia el modelado. Nuevamente, aprovechando las capacidades de LLM, el cuaderno contiene consultas SQL precargadas para seleccionar los datos de entrenamiento para el modelo predictivo. Las capacidades automatizadas de preparación de datos, ingeniería de características, creación de modelos e implementación de Pecan pueden llevar a cabo el resto del proceso en un tiempo récord, más rápido que cualquier otra solución de modelado predictivo.

En resumen, Predictive GenAI de Pecan utiliza las incomparables habilidades lingüísticas de los LLM para hacer que nuestra plataforma de modelado predictivo, la mejor de su clase, sea mucho más accesible y amigable para los usuarios comerciales. Nos entusiasma ver cómo este enfoque ayudará a muchas más empresas a tener éxito con la IA.

Entonces, mientras que los LLM solo no son adecuados para manejar todas sus necesidades predictivas, pueden desempeñar un papel poderoso en el avance de sus proyectos de IA. Al interpretar su caso de uso y brindarle una ventaja con el código SQL generado automáticamente, Predictive GenAI de Pecan está liderando el camino en la unión de estas tecnologías. Puede compruébalo ahora con una prueba gratuita.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://www.kdnuggets.com/2024/01/pecan-llms-used-alone-cant-address-companys-predictive-needs?utm_source=rss&utm_medium=rss&utm_campaign=why-llms-used-alone-cant-address-your-companys-predictive-needs

- :posee

- :es

- :no

- :dónde

- 15%

- 17

- a

- capacidad

- Poder

- Nuestra Empresa

- accesible

- reconoció

- adición

- dirección

- adoptar

- Después

- de nuevo

- AI

- aka

- algoritmos

- alinear

- Todos

- permite

- solo

- ya haya utilizado

- también

- las increíbles ofertas de

- America

- an

- analista

- analizar

- y

- https://www.youtube.com/watch?v=xB-eutXNUMXJtA&feature=youtu.be

- respuestas

- cualquier

- enfoque

- somos

- en torno a

- llegado

- AS

- ayudar

- At

- Confirmación de Viaje

- aprendizaje automático

- automáticamente

- Hoy Disponibles

- Atrás

- basado

- BE

- Tenga

- se convirtió en

- esto

- Comienzo

- detrás de

- "Ser"

- CREEMOS

- MEJOR

- mejores

- entre

- miles de millones

- Poco

- Bolt

- Libros

- ambas

- una lluvia de ideas

- PUENTE

- puente

- más amplio

- Construir la

- construido

- impacto de negocios

- negocios

- pero

- by

- llamar al

- llegó

- PUEDEN

- capacidades

- capacidad

- Capacidad

- llevar

- case

- cases

- a ciertos

- retos

- abismo

- chat

- ChatGPT

- la elección de

- código

- recoger

- proviene

- Empresas

- De la empresa

- integraciones

- complejidad

- computational

- computaciones

- informática

- seguros

- constituir

- contiene

- correcta

- rentable

- podría

- Elaborado

- Para crear

- creado

- Creamos

- crítico

- Cruz

- crucial

- cliente

- datos

- analista de datos

- Preparación de datos

- Ciencia de los datos

- científico de datos

- conjuntos de datos

- década

- Koops

- profundo

- deep learning

- más profundo

- definición

- demandas

- despliegue

- diseñado

- A pesar de las

- detallado

- detalles

- desarrollar

- desarrollado

- desarrolladores

- el desarrollo

- Desarrollo

- un cambio

- una experiencia diferente

- DIG

- do

- documentos

- No

- don

- No

- borrador

- dibujo

- Temprano en la

- más fácil

- de forma sencilla

- Eficaz

- eficiencia

- eficiente

- esfuerzo

- ya sea

- que abarca

- Ingeniería

- ambientalmente

- Éter (ETH)

- Incluso

- NUNCA

- ejemplo

- Excel

- excitado

- emocionante

- existente

- experience

- Explicar

- Explicabilidad

- explorar

- Explorar

- factores importantes

- Fracaso

- Otoño

- familiar

- muchos

- más rápida

- Feature

- sentimientos

- menos

- Nombre

- cómodo

- Dar la vuelta

- formato

- Formularios

- Afortunadamente

- adelante

- Fundación

- Gratuito

- amigable

- Desde

- promover

- fusionando

- brecha

- Génai

- en general

- generar

- generado

- genera

- generativo

- IA generativa

- donación

- dado

- da

- Diezmos y Ofrendas

- Go

- objetivo

- GPU

- guía

- tenido

- martillo

- encargarse de

- Manejo

- Difícil

- Tienen

- refugio

- cabeza

- para trabajo pesado

- ayuda

- ayudado

- ayudando

- ayuda

- altamente

- mantiene

- espera

- Cómo

- Sin embargo

- HTTPS

- humana

- i

- ideas

- identificar

- if

- imagen

- Impacto

- implementar

- implementaciones

- importante

- en tono rimbombante

- in

- Incluye

- influenciando

- información

- inicial

- iniciado

- Las opciones de entrada

- la intención de

- dentro

- involucra

- implica

- que implica

- iOS

- IT

- SUS

- sí mismo

- Trabajos

- solo

- nuggets

- Saber

- conocido

- idioma

- large

- Gran escala

- principalmente

- luego

- líder

- APRENDE:

- aprendido

- aprendizaje

- Abandonar

- Con licencia

- momentos involvidables

- como

- que otros

- Limitada

- Lote

- máquina

- máquina de aprendizaje

- Técnicas de aprendizaje automático

- hecho

- para lograr

- HACE

- muchos

- masivo

- Match

- matemático

- personalizado

- mecanismo

- mentores

- métodos

- podría

- millones

- que falta

- mezcla

- modelo

- modelado

- modelos

- meses

- más,

- más eficiente

- MEJOR DE TU

- emocionante

- mucho más

- debe

- my

- Natural

- Lenguaje natural

- Procesamiento natural del lenguaje

- ¿ Necesita ayuda

- telecomunicaciones

- Neural

- redes neuronales

- Nuevo

- Next

- North

- América del Norte

- cuaderno

- ahora

- matices

- números

- obtenido

- of

- on

- ONE

- , solamente

- OpenAI

- optimización

- Optimización

- optimizando

- Opciones

- or

- Otro

- nuestros

- salir

- resultados

- Más de

- exagerado

- parámetros

- padres.

- parte

- particular

- .

- realizar

- actuación

- recoger

- imagen

- Pioneros

- Colocar

- plataforma

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- Jugar

- posible

- poderoso

- precisamente

- predecir

- predecir

- Predicciones

- profético

- preparación

- primario

- probablemente

- Problema

- tratamiento

- proyecta

- Promete

- propietario

- probado

- proporcionar

- público

- en público

- consultas

- pregunta

- Preguntas

- distancia

- RARO

- razón fundamental

- Leer

- Reading

- razón

- grabar

- refinado

- refleja

- regulador

- relacionado

- Relaciones

- relativo

- REPETIDAMENTE

- que representa

- solicita

- Requisitos

- la investigación

- Recursos

- Responder

- respuesta

- respuestas

- RESTO

- resultado

- resultante

- Revela

- Derecho

- Función

- correr

- s

- dices

- decir

- Ciencia:

- Científico

- ver

- parecer

- selecciona

- seleccionar

- Secuencia

- set

- En Corto

- tienes

- Mostrar

- significado

- importante

- similares

- simplemente

- desde

- habilidades

- So

- a medida

- RESOLVER

- algo

- Aislamiento de Sonido

- suena

- Fuentes

- soluciones y

- específicamente

- Hoja de cálculo

- SQL

- etapas

- comienzo

- fundó

- paso

- Sin embargo

- fortalezas

- estructura

- Luchando

- estudiado

- Estudiando

- papa

- tener éxito

- exitosos

- tal

- seguro

- sostenible,

- T

- abordando

- ¡Prepárate!

- Tarea

- tareas

- equipos

- técnicas

- Tecnologías

- texto

- que

- esa

- El

- su

- Les

- Estas

- ellos

- cosa

- cosas

- pensar

- así

- aquellos

- miles

- apretar

- equipo

- a

- juntos

- tonelada

- caja de herramientas

- Temas

- hacia

- rastrear

- tradicional

- entrenado

- Formación

- transaccional

- la traducción

- Los árboles

- try

- GIRO

- torcedura

- tipo

- paraguas

- bajo

- entender

- comprensión

- entendido

- uniendo

- desconocido

- incomparable

- us

- utilizan el

- caso de uso

- usado

- Usuario

- usuarios

- usos

- usando

- propuesta de

- variedad

- diversos

- Vasto

- la visibilidad

- vital

- vs

- quiere

- Camino..

- formas

- we

- sitios web

- Semanas

- WELL

- tuvieron

- ¿

- Que es

- cuando

- que

- mientras

- porque

- extensamente

- seguirá

- dentro de

- Palabra

- palabras

- Actividades:

- trabajado

- valor

- se

- aún

- Usted

- tú

- zephyrnet